Sistem kecerdasan buatan (AI) yang baru dibuat berdasarkan pembelajaran penguatan mendalam (DRL) dapat bereaksi terhadap penyerang dalam lingkungan simulasi dan memblokir 95% serangan dunia maya sebelum meningkat.

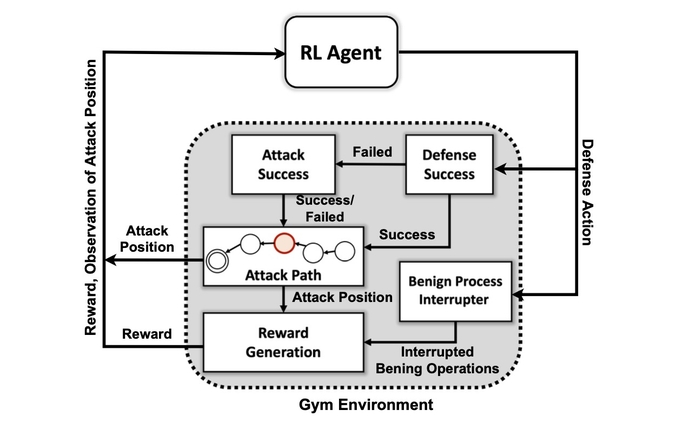

Itu menurut para peneliti dari Laboratorium Nasional Barat Laut Pasifik Departemen Energi yang membangun simulasi abstrak dari konflik digital antara penyerang dan pembela dalam jaringan dan melatih empat jaringan saraf DRL yang berbeda untuk memaksimalkan imbalan berdasarkan pencegahan kompromi dan meminimalkan gangguan jaringan.

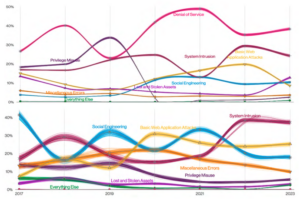

Penyerang yang disimulasikan menggunakan serangkaian taktik berdasarkan MITRE ATT & CK klasifikasi framework untuk beralih dari fase akses dan pengintaian awal ke fase serangan lainnya hingga mereka mencapai tujuannya: fase dampak dan eksfiltrasi.

Keberhasilan pelatihan sistem AI pada lingkungan serangan yang disederhanakan menunjukkan bahwa respons defensif terhadap serangan secara real time dapat ditangani oleh model AI, kata Samrat Chatterjee, ilmuwan data yang mempresentasikan hasil kerja tim pada pertemuan tahunan Asosiasi untuk Kemajuan Kecerdasan Buatan di Washington, DC pada 14 Februari.

“Anda tidak ingin beralih ke arsitektur yang lebih kompleks jika Anda bahkan tidak dapat menunjukkan janji dari teknik ini,” katanya. “Kami pertama-tama ingin menunjukkan bahwa kami benar-benar dapat melatih DRL dengan sukses dan menunjukkan beberapa hasil pengujian yang baik, sebelum bergerak maju.”

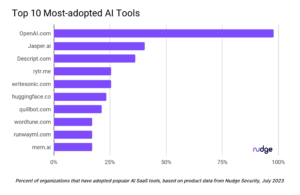

Penerapan teknik pembelajaran mesin dan kecerdasan buatan ke berbagai bidang dalam keamanan siber telah menjadi tren panas selama dekade terakhir, mulai dari integrasi awal pembelajaran mesin di gateway keamanan email di 2010 awal untuk upaya yang lebih baru untuk gunakan ChatGPT untuk menganalisis kode atau melakukan analisis forensik. Sekarang, sebagian besar produk keamanan miliki — atau mengklaim memiliki — beberapa fitur yang didukung oleh algoritme pembelajaran mesin yang dilatih pada kumpulan data besar.

Namun, menciptakan sistem AI yang mampu melakukan pertahanan proaktif terus bersifat aspiratif, bukan praktis. Sementara berbagai rintangan tetap ada bagi para peneliti, penelitian PNNL menunjukkan bahwa pembela AI dapat dilakukan di masa depan.

“Mengevaluasi beberapa algoritme DRL yang dilatih di bawah pengaturan permusuhan yang beragam merupakan langkah penting menuju solusi pertahanan dunia maya otonom yang praktis,” tim peneliti PNNL dinyatakan dalam makalah mereka. “Eksperimen kami menunjukkan bahwa algoritme DRL bebas model dapat dilatih secara efektif di bawah profil serangan multi-tahap dengan tingkat keterampilan dan kegigihan yang berbeda, menghasilkan hasil pertahanan yang menguntungkan dalam pengaturan yang diperebutkan.”

Bagaimana Sistem Menggunakan MITRE ATT&CK

Tujuan pertama tim peneliti adalah untuk membuat lingkungan simulasi khusus berdasarkan perangkat sumber terbuka yang dikenal sebagai Buka AI Gym. Dengan menggunakan lingkungan itu, para peneliti menciptakan entitas penyerang dengan tingkat keterampilan dan kegigihan yang berbeda dengan kemampuan untuk menggunakan subset dari 7 taktik dan 15 teknik dari kerangka MITRE ATT&CK.

Tujuan agen penyerang adalah bergerak melalui tujuh langkah rantai serangan, dari akses awal hingga eksekusi, dari persistensi hingga perintah dan kontrol, dan dari pengumpulan hingga dampak.

Bagi penyerang, menyesuaikan taktik mereka dengan keadaan lingkungan dan tindakan pembela saat ini bisa jadi rumit, kata Chatterjee dari PNNL.

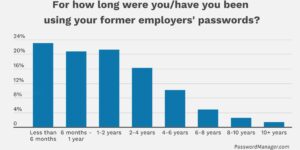

“Musuh harus menavigasi jalan mereka dari keadaan pengintaian awal sampai ke keadaan eksfiltrasi atau tumbukan,” katanya. “Kami tidak mencoba membuat semacam model untuk menghentikan musuh sebelum mereka masuk ke dalam lingkungan — kami berasumsi bahwa sistem sudah disusupi.”

Para peneliti menggunakan empat pendekatan jaringan saraf berdasarkan pembelajaran penguatan. Reinforcement learning (RL) adalah pendekatan pembelajaran mesin yang meniru sistem penghargaan otak manusia. Jaringan saraf belajar dengan memperkuat atau melemahkan parameter tertentu untuk neuron individu untuk memberikan solusi yang lebih baik, yang diukur dengan skor yang menunjukkan seberapa baik kinerja sistem.

Pembelajaran penguatan pada dasarnya memungkinkan komputer untuk menciptakan pendekatan yang baik, tetapi tidak sempurna, untuk masalah yang ada, kata Mahantesh Halappanavar, seorang peneliti PNNL dan penulis makalah.

“Tanpa menggunakan pembelajaran penguatan, kita masih bisa melakukannya, tapi itu akan menjadi masalah yang sangat besar yang tidak akan memiliki cukup waktu untuk benar-benar menghasilkan mekanisme yang baik,” katanya. "Penelitian kami ... memberi kami mekanisme ini di mana pembelajaran penguatan mendalam meniru beberapa perilaku manusia itu sendiri, sampai batas tertentu, dan itu dapat menjelajahi ruang yang sangat luas ini dengan sangat efisien."

Belum Siap untuk Prime Time

Eksperimen menemukan bahwa metode pembelajaran penguatan khusus, yang dikenal sebagai Deep Q Network, menciptakan solusi yang kuat untuk masalah pertahanan, menangkap 97% penyerang dalam kumpulan data pengujian. Namun penelitian ini hanyalah permulaan. Profesional keamanan sebaiknya tidak mencari pendamping AI untuk membantu mereka melakukan respons insiden dan forensik dalam waktu dekat.

Di antara banyak masalah yang masih harus dipecahkan adalah mendapatkan pembelajaran penguatan dan jaringan saraf yang dalam untuk menjelaskan faktor-faktor yang memengaruhi keputusan mereka, bidang penelitian yang disebut pembelajaran penguatan yang dapat dijelaskan (XRL).

Selain itu, ketangguhan algoritme AI dan menemukan cara yang efisien untuk melatih jaringan saraf merupakan masalah yang perlu dipecahkan, kata Chatterjee dari PNNL.

“Menciptakan produk—itu bukan motivasi utama untuk penelitian ini,” katanya. “Ini lebih tentang eksperimen ilmiah dan penemuan algoritmik.”

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Sumber: https://www.darkreading.com/emerging-tech/researchers-create-ai-cyber-defender-that-reacts-to-attackers

- 7

- 95%

- a

- kemampuan

- Tentang Kami

- ABSTRAK

- mengakses

- Menurut

- tindakan

- sebenarnya

- tambahan

- kemajuan

- permusuhan

- agen

- AI

- Bertenaga AI

- algoritmik

- algoritma

- Semua

- memungkinkan

- sudah

- analisis

- menganalisa

- dan

- tahunan

- Aplikasi

- pendekatan

- pendekatan

- DAERAH

- buatan

- kecerdasan buatan

- Kecerdasan buatan (AI)

- Asosiasi

- menyerang

- Serangan

- penulis

- otonom

- berdasarkan

- menjadi

- sebelum

- Lebih baik

- antara

- Besar

- Memblokir

- Otak

- dibangun di

- bernama

- tidak bisa

- mampu

- tertentu

- rantai

- ChatGPT

- klaim

- klasifikasi

- koleksi

- bagaimana

- kompleks

- Dikompromikan

- komputer

- Mengadakan

- konflik

- terus

- kontrol

- bisa

- membuat

- dibuat

- membuat

- terbaru

- adat

- maya

- cyberattacks

- Keamanan cyber

- data

- ilmuwan data

- kumpulan data

- kumpulan data

- dc

- dasawarsa

- keputusan

- keputusan

- mendalam

- Pembela

- Pertahanan

- defensif

- mendemonstrasikan

- menunjukkan

- Departemen

- berbeda

- digital

- penemuan

- Gangguan

- beberapa

- Awal

- efektif

- efisien

- efisien

- upaya

- keamanan email

- energi

- cukup

- entitas

- Lingkungan Hidup

- dasarnya

- mengevaluasi

- Bahkan

- eksekusi

- pengelupasan kulit

- Menjelaskan

- menyelidiki

- faktor

- Fitur

- beberapa

- Fields

- temuan

- Pertama

- aliran

- Forensik

- forensik

- Depan

- ditemukan

- Kerangka

- dari

- masa depan

- mendapatkan

- mendapatkan

- memberikan

- tujuan

- Anda

- baik

- tangan

- membantu

- PANAS

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTTPS

- manusia

- Lari gawang

- Dampak

- penting

- in

- insiden

- respon insiden

- sendiri-sendiri

- terpengaruh

- mulanya

- integrasi

- Intelijen

- IT

- Diri

- Jenis

- dikenal

- laboratorium

- besar

- pengetahuan

- adalah ide yang bagus

- melihat

- mesin

- Mesin belajar

- Utama

- banyak

- max-width

- Maksimalkan

- mekanisme

- pertemuan

- metode

- meminimalkan

- model

- lebih

- Motivasi

- pindah

- bergerak

- beberapa

- nasional

- Arahkan

- Perlu

- jaringan

- jaringan

- saraf jaringan

- jaringan saraf

- Neuron

- Buka

- open source

- Lainnya

- Pasifik

- kertas

- parameter

- lalu

- sempurna

- melakukan

- ketekunan

- tahap

- plato

- Kecerdasan Data Plato

- Data Plato

- mungkin

- didukung

- Praktis

- disajikan

- mencegah

- Perdana

- Proaktif

- Masalah

- masalah

- Produk

- profesional

- profil

- janji

- RE

- tercapai

- Bereaksi

- bereaksi

- siap

- nyata

- real-time

- baru

- tinggal

- penelitian

- peneliti

- peneliti

- tanggapan

- Pahala

- Hadiah

- kesegaran

- mengatakan

- ilmiah

- ilmuwan

- keamanan

- Seri

- set

- pengaturan

- tujuh

- harus

- Menunjukkan

- Pertunjukkan

- disederhanakan

- simulasi

- ketrampilan

- larutan

- Solusi

- beberapa

- sumber

- Space

- tertentu

- awal

- Negara

- Langkah

- Tangga

- Masih

- berhenti

- penguatan

- kuat

- sukses

- berhasil

- sistem

- taktik

- tim

- teknik

- pengujian

- Grafik

- Negara

- mereka

- Melalui

- waktu

- untuk

- toolkit

- terhadap

- Pelatihan VE

- terlatih

- Pelatihan

- kecenderungan

- bawah

- us

- menggunakan

- variasi

- Luas

- ingin

- Washington

- cara

- sementara

- SIAPA

- akan

- dalam

- tanpa

- Kerja

- akan

- penurut

- Kamu

- zephyrnet.dll