Oggi siamo lieti di annunciare che i modelli di fondotinta Llama 2 sviluppati da Meta sono disponibili per i clienti tramite JumpStart di Amazon SageMaker. La famiglia Llama 2 di modelli linguistici di grandi dimensioni (LLM) è una raccolta di modelli di testo generativi preaddestrati e ottimizzati che vanno da 7 miliardi a 70 miliardi di parametri. Gli LLM ottimizzati, chiamati Llama-2-chat, sono ottimizzati per i casi d'uso del dialogo. Puoi provare facilmente questi modelli e utilizzarli con SageMaker JumpStart, un hub di machine learning (ML) che fornisce accesso ad algoritmi, modelli e soluzioni ML in modo da poter iniziare rapidamente con il ML.

In questo post, spieghiamo come utilizzare i modelli Llama 2 tramite SageMaker JumpStart.

Cos'è Lama 2

Llama 2 è un modello linguistico autoregressivo che utilizza un'architettura di trasformatore ottimizzata. Llama 2 è destinato all'uso commerciale e di ricerca in inglese. È disponibile in una gamma di dimensioni dei parametri: 7 miliardi, 13 miliardi e 70 miliardi, nonché in varianti pre-addestrate e ottimizzate. Secondo Meta, le versioni ottimizzate utilizzano la messa a punto supervisionata (SFT) e l’apprendimento di rinforzo con feedback umano (RLHF) per allinearsi alle preferenze umane in termini di disponibilità e sicurezza. Llama 2 è stato pre-addestrato su 2 trilioni di token di dati provenienti da fonti disponibili al pubblico. I modelli ottimizzati sono destinati a chat simili a quelle di un assistente, mentre i modelli preaddestrati possono essere adattati per una varietà di attività di generazione del linguaggio naturale. Indipendentemente dalla versione del modello utilizzata dallo sviluppatore, il file guida all'uso responsabile di Meta può aiutare a guidare ulteriori messe a punto che potrebbero essere necessarie per personalizzare e ottimizzare i modelli con adeguate attenuazioni della sicurezza.

Cos'è SageMaker JumpStart

Con SageMaker JumpStart, i professionisti del machine learning possono scegliere tra un'ampia selezione di modelli di base open source. I professionisti del machine learning possono distribuire modelli di base a progetti dedicati Amazon Sage Maker istanze da un ambiente isolato dalla rete e personalizza i modelli utilizzando SageMaker per l'addestramento e la distribuzione dei modelli.

Ora puoi scoprire e distribuire Llama 2 con pochi clic Amazon Sage Maker Studio o a livello di programmazione tramite SageMaker Python SDK, consentendoti di derivare le prestazioni del modello e i controlli MLOps con funzionalità SageMaker come Pipeline di Amazon SageMaker, Debugger di Amazon SageMakero log del contenitore. Il modello viene distribuito in un ambiente sicuro AWS e sotto i controlli VPC, contribuendo a garantire la sicurezza dei dati. I modelli Llama 2 sono disponibili oggi in Amazon SageMaker Studio, inizialmente in us-east 1 ed us-west 2 regioni.

Scopri i modelli

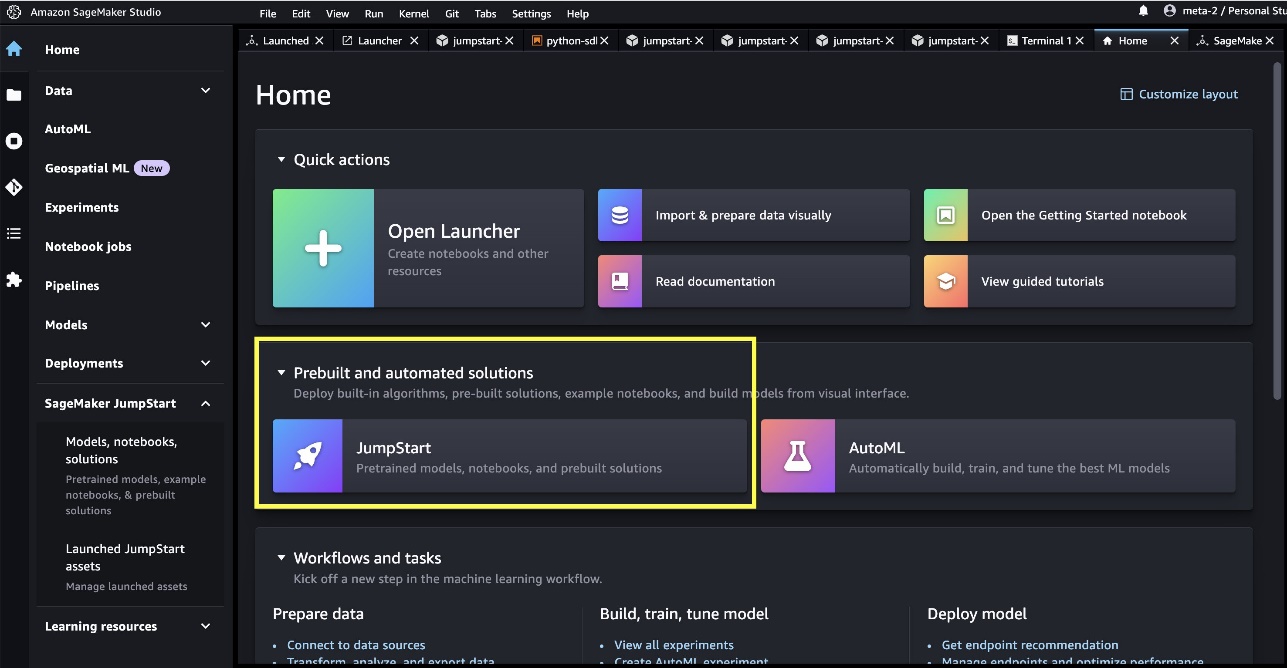

Puoi accedere ai modelli di base tramite SageMaker JumpStart nell'interfaccia utente di SageMaker Studio e SageMaker Python SDK. In questa sezione, esamineremo come scoprire i modelli in SageMaker Studio.

SageMaker Studio è un ambiente di sviluppo integrato (IDE) che fornisce un'unica interfaccia visiva basata sul Web in cui è possibile accedere a strumenti specifici per eseguire tutte le fasi di sviluppo ML, dalla preparazione dei dati alla creazione, formazione e distribuzione dei modelli ML. Per ulteriori dettagli su come iniziare e configurare SageMaker Studio, fare riferimento a Amazon Sage Maker Studio.

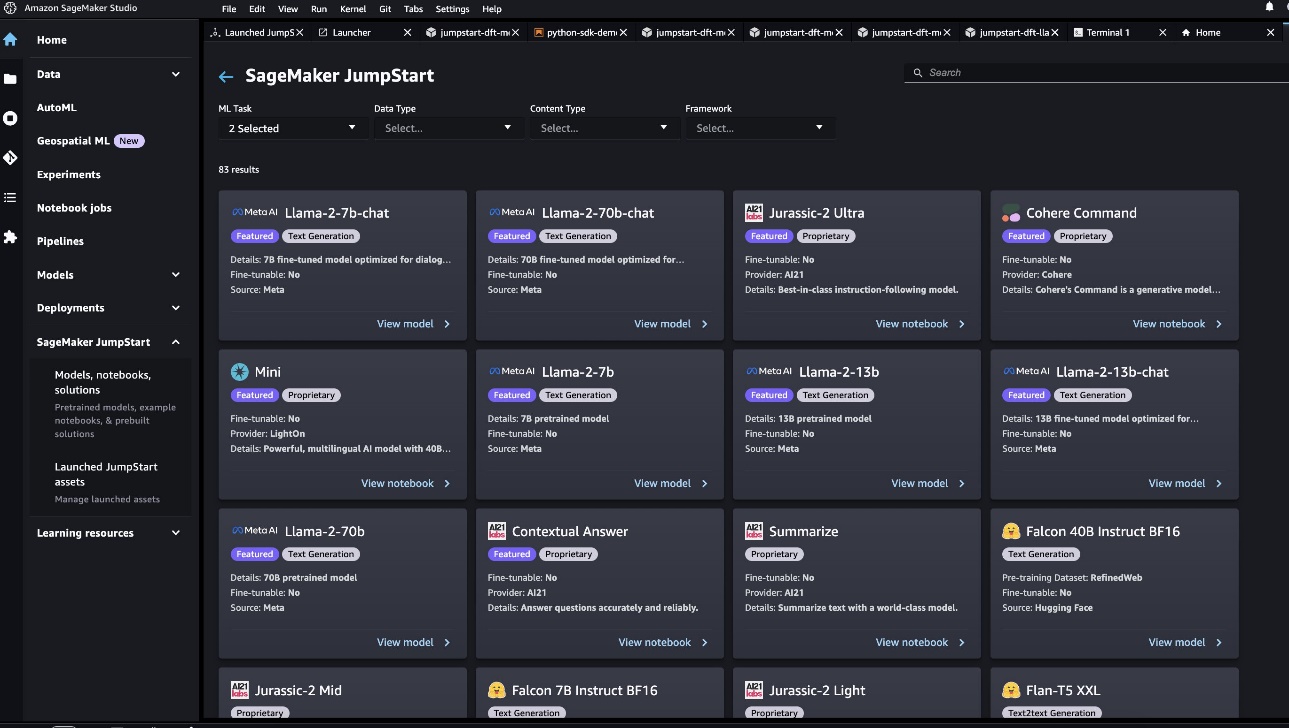

Una volta entrato in SageMaker Studio, puoi accedere a SageMaker JumpStart, che contiene modelli pre-addestrati, notebook e soluzioni predefinite, in Soluzioni predefinite e automatizzate.

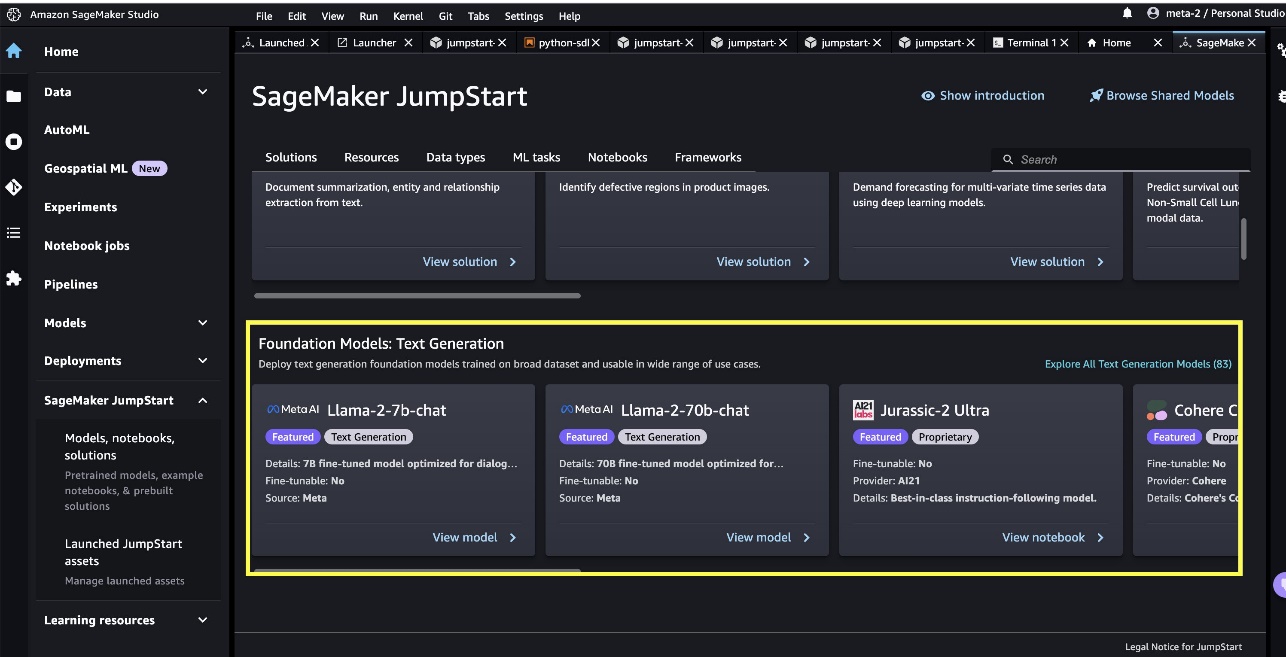

Dalla pagina di destinazione JumpStart di SageMaker è possibile cercare soluzioni, modelli, notebook e altre risorse. Puoi trovare due modelli di punta Llama 2 in Modelli di fondazione: Generazione di testo giostra. Se non vedi i modelli Llama 2, aggiorna la versione di SageMaker Studio spegnendo e riavviando. Per ulteriori informazioni sugli aggiornamenti della versione, fare riferimento a Chiudi e aggiorna le app di Studio.

Puoi trovare anche altre quattro varianti di modello scegliendo Esplora tutti i modelli di generazione di testo o cercando llama nella casella di ricerca.

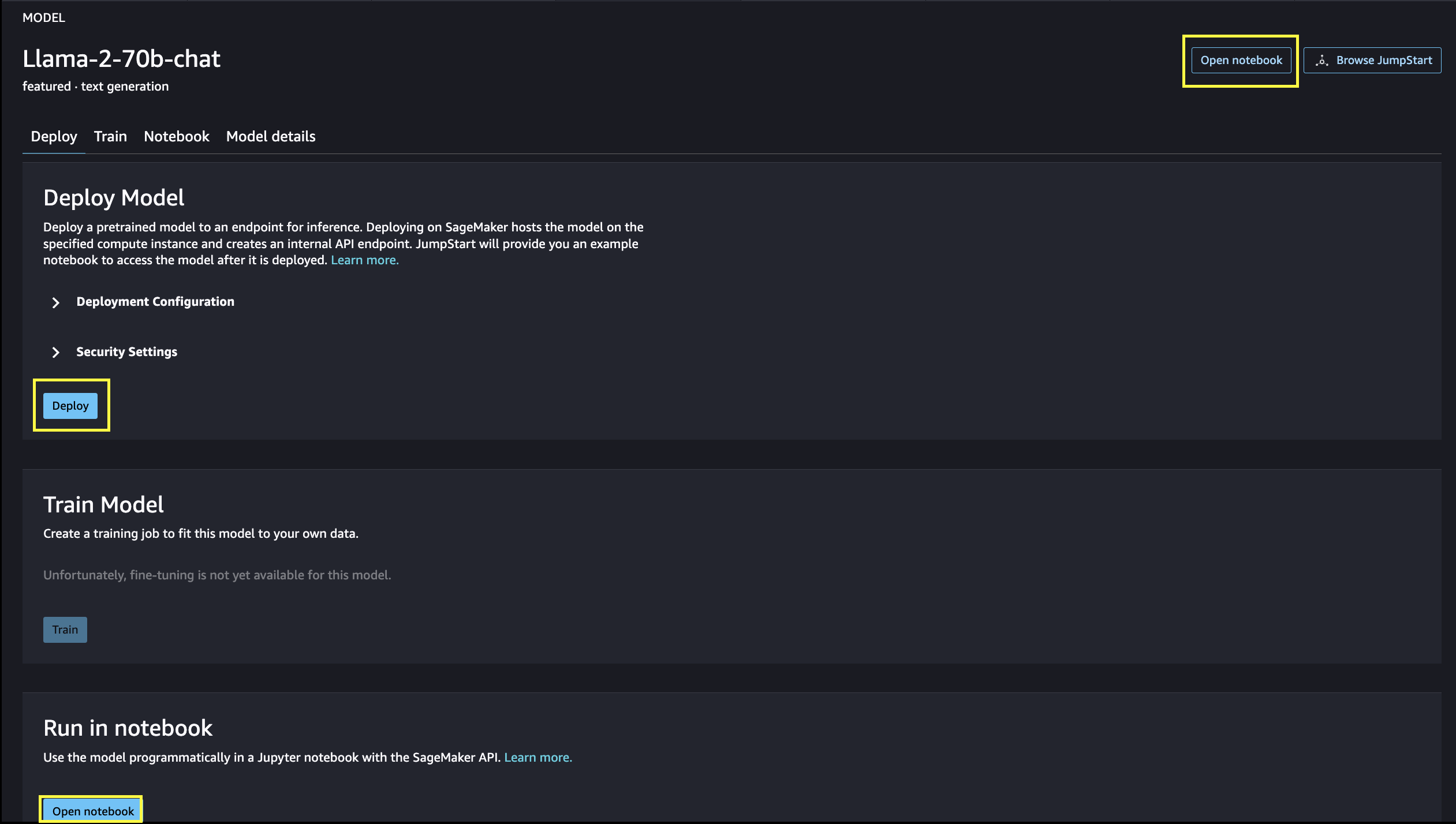

Puoi scegliere la scheda del modello per visualizzare i dettagli sul modello come licenza, dati utilizzati per l'addestramento e modalità di utilizzo. Puoi anche trovare due pulsanti, Schierare ed Apri taccuino, che ti aiutano a utilizzare il modello.

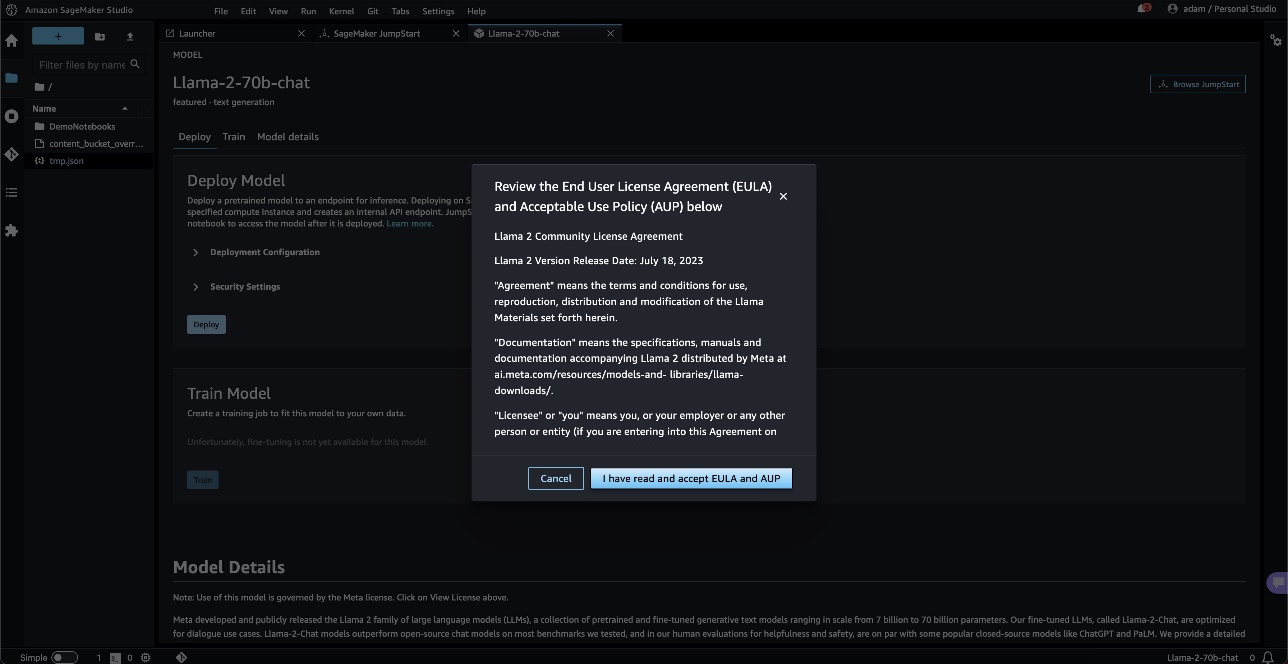

Quando scegli uno dei pulsanti, un popup mostrerà il contratto di licenza con l'utente finale e la politica di utilizzo accettabile che dovrai riconoscere.

Dopo aver confermato, si procederà al passaggio successivo per utilizzare il modello.

Distribuisci un modello

Quando si sceglie Schierare e si accettano i termini, verrà avviata la distribuzione del modello. In alternativa, è possibile eseguire la distribuzione tramite il notebook di esempio visualizzato scegliendo Apri taccuino. Il notebook di esempio fornisce indicazioni end-to-end su come distribuire il modello per l'inferenza e pulire le risorse.

Per eseguire la distribuzione utilizzando un notebook, iniziamo selezionando un modello appropriato, specificato dal model_id. Puoi distribuire uno qualsiasi dei modelli selezionati su SageMaker con il seguente codice:

Questo distribuisce il modello su SageMaker con configurazioni predefinite, inclusi il tipo di istanza predefinito e le configurazioni VPC predefinite. È possibile modificare queste configurazioni specificando valori non predefiniti in Modello JumpStart. Dopo la distribuzione, puoi eseguire l'inferenza sull'endpoint distribuito tramite il predittore SageMaker:

I modelli di chat ottimizzati (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) accettano una cronologia della chat tra l'utente e l'assistente di chat e generano la chat successiva. I modelli pre-addestrati (Llama-2-7b, Llama-2-13b, Llama-2-70b) richiedono un prompt di stringa ed eseguono il completamento del testo sul prompt fornito. Vedere il seguente codice:

Si noti che per impostazione predefinita, accept_eula è impostato su falso. È necessario impostare accept_eula=true per richiamare l'endpoint con successo. In tal modo, accetti il contratto di licenza utente e la politica di utilizzo accettabile come menzionato in precedenza. Puoi anche scaricare il contratto di licenza.

Custom_attributes utilizzati per passare l'EULA sono coppie chiave/valore. La chiave e il valore sono separati da = e le coppie sono separate da ;. Se l'utente passa la stessa chiave più di una volta, l'ultimo valore viene mantenuto e passato al gestore dello script (cioè, in questo caso, utilizzato per la logica condizionale). Ad esempio, se accept_eula=false; accept_eula=true viene passato al server, quindi accept_eula=true viene mantenuto e passato al gestore dello script.

I parametri di inferenza controllano il processo di generazione del testo all'endpoint. Il controllo massimo di nuovi token si riferisce alla dimensione dell'output generato dal modello. Tieni presente che questo non è lo stesso numero di parole perché il vocabolario del modello non è lo stesso del vocabolario della lingua inglese e ogni token potrebbe non essere una parola della lingua inglese. La temperatura controlla la casualità nell'output. Una temperatura più elevata si traduce in risultati più creativi e allucinati. Tutti i parametri di inferenza sono facoltativi.

La tabella seguente elenca tutti i modelli Llama disponibili in SageMaker JumpStart insieme a model_ids, i tipi di istanza predefiniti e il numero massimo di token totali (somma del numero di token di input e numero di token generati) supportati per ciascuno di questi modelli.

| Nome del modello | ID modello | Gettoni totali massimi | Tipo di istanza predefinito |

| Lama-2-7b | meta-testogenerazione-llama-2-7b | 4096 | ml.g5.2xgrande |

| Lama-2-7b-chat | meta-testogenerazione-llama-2-7b-f | 4096 | ml.g5.2xgrande |

| Lama-2-13b | meta-testogenerazione-llama-2-13b | 4096 | ml.g5.12xgrande |

| Lama-2-13b-chat | meta-testogenerazione-llama-2-13b-f | 4096 | ml.g5.12xgrande |

| Lama-2-70b | meta-testogenerazione-llama-2-70b | 4096 | ml.g5.48xgrande |

| Lama-2-70b-chat | meta-testogenerazione-llama-2-70b-f | 4096 | ml.g5.48xgrande |

Tieni presente che gli endpoint SageMaker hanno un limite di timeout di 60 secondi. Pertanto, anche se il modello potrebbe essere in grado di generare 4096 token, se la generazione del testo richiede più di 60 secondi, la richiesta fallirà. Per i modelli 7B, 13B e 70B si consiglia di impostare max_new_tokens non superiori rispettivamente a 1500, 1000 e 500, mantenendo il numero totale di token inferiore a 4K.

Inferenza e suggerimenti di esempio per Llama-2-70b

Puoi utilizzare i modelli Llama per il completamento del testo per qualsiasi parte di testo. Attraverso la generazione del testo, puoi eseguire una serie di attività, come rispondere a domande, tradurre la lingua, analizzare il sentiment e molto altro. Il carico utile di input per l'endpoint è simile al seguente codice:

Di seguito sono riportati alcuni esempi di prompt e il testo generato dal modello. Tutti gli output sono generati con parametri di inferenza {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

Nell'esempio successivo, mostriamo come utilizzare i modelli Llama con l'apprendimento in contesto con poche riprese, in cui forniamo campioni di formazione disponibili per il modello. Tieni presente che facciamo solo inferenze sul modello distribuito e durante questo processo i pesi del modello non cambiano.

Inferenza e suggerimenti di esempio per Llama-2-70b-chat

Con i modelli Llama-2-Chat, ottimizzati per i casi d'uso del dialogo, l'input agli endpoint del modello di chat è la cronologia precedente tra l'assistente chat e l'utente. Puoi porre domande contestuali alla conversazione avvenuta finora. Puoi anche fornire la configurazione del sistema, ad esempio i personaggi che definiscono il comportamento dell'assistente chat. Il payload di input per l'endpoint è simile al seguente codice:

Di seguito sono riportati alcuni esempi di prompt e il testo generato dal modello. Tutti gli output sono generati con i parametri di inferenza {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

Nell'esempio seguente, l'utente ha avuto una conversazione con l'assistente sui siti turistici di Parigi. Successivamente, l'utente chiede quale sia la prima opzione consigliata dall'assistente chat.

Negli esempi seguenti impostiamo la configurazione del sistema:

ripulire

Dopo aver terminato l'esecuzione del notebook, assicurati di eliminare tutte le risorse in modo che tutte le risorse create nel processo vengano eliminate e la fatturazione venga interrotta:

Conclusione

In questo post ti abbiamo mostrato come iniziare con i modelli Llama 2 in SageMaker Studio. Con questo, hai accesso a sei modelli di base Llama 2 che contengono miliardi di parametri. Poiché i modelli di base sono pre-addestrati, possono anche contribuire a ridurre i costi di formazione e infrastruttura e consentire la personalizzazione per il tuo caso d'uso. Per iniziare con SageMaker JumpStart, visita le seguenti risorse:

Circa gli autori

Giugno vinto è un product manager con SageMaker JumpStart. Il suo obiettivo è rendere i modelli di base facilmente individuabili e utilizzabili per aiutare i clienti a creare applicazioni di intelligenza artificiale generativa. La sua esperienza in Amazon include anche applicazioni per lo shopping mobile e consegna dell'ultimo miglio.

Giugno vinto è un product manager con SageMaker JumpStart. Il suo obiettivo è rendere i modelli di base facilmente individuabili e utilizzabili per aiutare i clienti a creare applicazioni di intelligenza artificiale generativa. La sua esperienza in Amazon include anche applicazioni per lo shopping mobile e consegna dell'ultimo miglio.

Dott. Vivek Madan è uno scienziato applicato con il team Amazon SageMaker JumpStart. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois a Urbana-Champaign ed è stato ricercatore post-dottorato presso la Georgia Tech. È un ricercatore attivo nell'apprendimento automatico e nella progettazione di algoritmi e ha pubblicato articoli in conferenze EMNLP, ICLR, COLT, FOCS e SODA.

Dott. Vivek Madan è uno scienziato applicato con il team Amazon SageMaker JumpStart. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois a Urbana-Champaign ed è stato ricercatore post-dottorato presso la Georgia Tech. È un ricercatore attivo nell'apprendimento automatico e nella progettazione di algoritmi e ha pubblicato articoli in conferenze EMNLP, ICLR, COLT, FOCS e SODA.  Dottor Kyle Ulrich è uno scienziato applicato del team JumpStart di Amazon SageMaker. I suoi interessi di ricerca includono algoritmi scalabili di apprendimento automatico, visione artificiale, serie temporali, parametri bayesiani non parametrici e processi gaussiani. Ha conseguito il dottorato di ricerca presso la Duke University e ha pubblicato articoli su NeurIPS, Cell e Neuron.

Dottor Kyle Ulrich è uno scienziato applicato del team JumpStart di Amazon SageMaker. I suoi interessi di ricerca includono algoritmi scalabili di apprendimento automatico, visione artificiale, serie temporali, parametri bayesiani non parametrici e processi gaussiani. Ha conseguito il dottorato di ricerca presso la Duke University e ha pubblicato articoli su NeurIPS, Cell e Neuron.  Dottor Ashish Khetan è uno scienziato applicato senior presso Amazon SageMaker JumpStart e aiuta a sviluppare algoritmi di apprendimento automatico. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nel campo dell'apprendimento automatico e dell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dottor Ashish Khetan è uno scienziato applicato senior presso Amazon SageMaker JumpStart e aiuta a sviluppare algoritmi di apprendimento automatico. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nel campo dell'apprendimento automatico e dell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.  Sundar Ranganathan è il responsabile globale degli specialisti GenAI/Frameworks GTM presso AWS. Si concentra sullo sviluppo di una strategia GTM per modelli linguistici di grandi dimensioni, GenAI e carichi di lavoro ML su larga scala attraverso servizi AWS come Amazon EC2, EKS, EFA, AWS Batch e Amazon SageMaker. La sua esperienza include ruoli di leadership nella gestione e nello sviluppo del prodotto presso NetApp, Micron Technology, Qualcomm e Mentor Graphics.

Sundar Ranganathan è il responsabile globale degli specialisti GenAI/Frameworks GTM presso AWS. Si concentra sullo sviluppo di una strategia GTM per modelli linguistici di grandi dimensioni, GenAI e carichi di lavoro ML su larga scala attraverso servizi AWS come Amazon EC2, EKS, EFA, AWS Batch e Amazon SageMaker. La sua esperienza include ruoli di leadership nella gestione e nello sviluppo del prodotto presso NetApp, Micron Technology, Qualcomm e Mentor Graphics.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :ha

- :È

- :non

- :Dove

- $ SU

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360 gradi

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- capace

- WRI

- Accetta

- accettabile

- accesso

- accessibilità

- accessibile

- Secondo

- riconoscere

- operanti in

- attivo

- aggiungere

- l'aggiunta di

- aggiuntivo

- indirizzo

- Dopo shavasana, sedersi in silenzio; saluti;

- ancora

- contro

- Accordo

- AI

- algoritmo

- Algoritmi

- allineare

- Tutti

- consentire

- lungo

- anche

- sempre

- am

- Amazon

- Amazon EC2

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Sage Maker Studio

- Amazon Web Services

- americano

- an

- .

- ed

- e infrastruttura

- Annunciare

- Un altro

- rispondere

- in qualsiasi

- chiunque

- Applicazioni

- applicazioni

- applicato

- apprezzare

- opportuno

- Arco

- architettura

- SONO

- Arte

- AS

- assistere

- Assistant

- At

- Atmosfera

- attrazioni

- Automatizzata

- disponibile

- AWS

- Banana

- basic

- Battaglia

- bayesiano

- BE

- bellissimo

- Bellezza ed estetica

- è diventato

- perché

- diventare

- stato

- birra

- prima

- comportamento

- Beijing

- CREDIAMO

- creduto

- MIGLIORE

- fra

- fatturazione

- Miliardo

- miliardi

- Nero

- Scatola

- Rompere

- mozzafiato

- ampio

- costruire

- Costruzione

- costruito

- ma

- pulsante

- by

- detto

- Materiale

- capitale

- auto

- carta

- carosello

- Custodie

- casi

- CAT

- il cambiamento

- Cioccolato

- Scegli

- la scelta

- Città

- classico

- codice

- collezione

- combinato

- combina

- viene

- arrivo

- azienda

- completamento

- computer

- Visione computerizzata

- conferenze

- fiducioso

- Configurazione

- considerato

- costante

- costruzione

- contenere

- Contenitore

- contiene

- contenuto

- contestuale

- continua

- continuamente

- di controllo

- controlli

- Comodo

- Conversazione

- Costi

- nazione

- coraggio

- coprire

- creare

- creato

- Creative

- la cultura della

- Cultura

- Coppa

- Clienti

- personalizzazione

- personalizzare

- dati

- la sicurezza dei dati

- dedicato

- dedizione

- Predefinito

- definire

- consegna

- schierare

- schierato

- distribuzione

- deployment

- Distribuisce

- Design

- progettato

- desiderato

- destinazione

- Destinazioni

- dettagli

- sviluppare

- sviluppato

- Costruttori

- in via di sviluppo

- Mercato

- Dialogo

- differenza

- diverso

- difficile

- scopri

- distintivo

- do

- documentari

- fare

- fatto

- Dont

- raddoppiato

- giù

- Duca

- Università del Duca

- durante

- e

- ogni

- In precedenza

- facilmente

- facile

- Edward

- einstein

- o

- enable

- consentendo

- fine

- da un capo all'altro

- endpoint

- Ingegneria

- Inglese

- godere

- abbastanza

- garantire

- Ambiente

- usate

- etere

- Anche

- eventi

- tutti

- esempio

- Esempi

- eccitato

- esperienza

- esperimento

- esperimenti

- esprimere

- FAIL

- fallito

- fiera

- falso

- famiglia

- famoso

- lontano

- impresa

- In primo piano

- Caratteristiche

- feedback

- Piedi

- pochi

- attraverso

- finale

- Infine

- Trovate

- Nome

- nave ammiraglia

- galleggiante

- flussi

- si concentra

- i seguenti

- Nel

- Avanti

- essere trovato

- Fondazione

- quattro

- Francia

- Francese

- da

- completamente

- ulteriormente

- futuro

- Generale

- generare

- generato

- ELETTRICA

- generativo

- AI generativa

- Georgia

- ottenere

- Dare

- vetro.

- globali

- Go

- andando

- grafiche

- grande

- maggiore

- innovativo

- Crescere

- guida

- guida

- ha avuto

- Maniglie

- successo

- contento

- Hard

- fatica

- Avere

- avendo

- he

- capo

- Aiuto

- aiutare

- aiuta

- qui

- hi

- Alta

- superiore

- il suo

- storico

- storia

- alloggiamento

- Come

- Tutorial

- HTML

- HTTPS

- Hub

- umano

- i

- iconico

- idea

- if

- ii

- Illinois

- Impact

- importare

- importante

- impressionante

- in

- includere

- inclusi

- Compreso

- Incorporated

- informazioni

- Infrastruttura

- inizialmente

- ingresso

- fonte di ispirazione

- ispiratore

- esempio

- immediatamente

- istruzioni

- integrato

- destinato

- interessi

- Interfaccia

- ai miglioramenti

- isolato

- IT

- SUO

- viaggio

- jpg

- ad appena

- conservazione

- tenere

- Le

- Genere

- Sapere

- conosciuto

- atterraggio

- punto di riferimento

- Lingua

- grandi

- larga scala

- maggiore

- Cognome

- In ritardo

- lanciare

- Legislazione

- Leadership

- IMPARARE

- Impara e cresci

- apprendimento

- meno

- meno

- livelli

- Licenza

- Vita

- leggera

- piace

- LIMITE

- elenchi

- letteratura

- ll

- Lama

- logica

- Lunghi

- a lungo

- cerca

- SEMBRA

- amore

- amato

- inferiore

- macchina

- machine learning

- fatto

- make

- FA

- Fare

- gestione

- direttore

- molti

- meraviglia

- Importanza

- massimo

- Maggio..

- significato

- misurare

- Media

- medie

- menzionato

- messaggio

- Meta

- micron

- minuto

- Minuti

- miscela

- ML

- MLOp

- Mobile

- modello

- modelli

- momento

- mese

- Scopri di più

- maggior parte

- Più popolare

- movimento

- film

- molti

- Museo di Capodimonte

- Musei

- Musica

- Nome

- Naturale

- necessaria

- Bisogno

- di applicazione

- Rete

- New

- New York

- GENERAZIONE

- no

- taccuino

- adesso

- numero

- numerose

- NY

- of

- offrire

- offerta

- Offerte

- Olio

- on

- una volta

- ONE

- esclusivamente

- aprire

- open source

- OTTIMIZZA

- ottimizzati

- Opzione

- or

- Altro

- Altri

- altrimenti

- nostro

- su

- produzione

- ancora

- complessivo

- pagina

- coppie

- Carta

- documenti

- parametro

- parametri

- Parigi

- parte

- passare

- Passato

- Passi

- passato

- pace

- Eseguire

- performance

- permanente

- telefono

- fotografie

- Fisica

- pezzo

- Pizza

- plastica

- Platone

- Platone Data Intelligence

- PlatoneDati

- giocato

- politica

- pop-up

- Popolare

- Post

- postale

- Predictor

- preferenze

- preparazione

- presenti

- precedente

- processi

- i processi

- Prodotto

- sviluppo del prodotto

- gestione del prodotto

- product manager

- proposte

- orgoglioso

- fornire

- purché

- fornisce

- fornitura

- la percezione

- mezzi di trasporto pubblico

- pubblicamente

- pubblicato

- scopo

- metti

- Python

- Qualcomm

- Domande

- Presto

- rapidamente

- Rampe

- casualità

- gamma

- che vanno

- pronto

- motivi

- ricevere

- ricetta

- raccomandare

- raccomandato

- si riferisce

- Indipendentemente

- regioni

- parente

- relatività

- ripetuto

- rappresentare

- richiesta

- richiede

- riparazioni

- ricercatore

- Risorse

- rispettivamente

- Rispondere

- REST

- colpevole

- Risultati

- fiume

- Ruolo

- ruoli

- Correre

- running

- s

- Sicurezza

- sagemaker

- sale

- stesso

- scalabile

- Scala

- Scienziato

- scienziati

- sdk

- MARE

- Cerca

- ricerca

- Sezione

- sicuro

- problemi di

- vedere

- vedendo

- sembrava

- selezionato

- Selezione

- prodotti

- inviare

- anziano

- sentimento

- Serie

- Servizi

- servizio

- set

- regolazione

- Forma

- Squalo

- Shopping

- dovrebbero

- mostrare attraverso le sue creazioni

- ha mostrato

- Spettacoli

- chiudendo

- significato

- significativa

- Un'espansione

- semplicemente

- singolo

- site

- Siti

- SIX

- Taglia

- Lentamente

- piccole

- So

- finora

- Social

- Social Media

- Soluzioni

- alcuni

- Fonte

- fonti

- la nostra speciale

- specialisti

- specificato

- velocità

- si

- inizia a

- iniziato

- Regione / Stato

- stati

- statistiche

- step

- Passi

- fermato

- Strategia

- Corda

- La struttura

- studio

- Stupendo

- soggetto

- successivo

- il successo

- Con successo

- tale

- supportato

- sicuro

- simbolo

- sistema

- tavolo

- Fai

- prende

- task

- chiavi

- team

- Tech

- Tecnologia

- temporaneo

- condizioni

- di

- Grazie

- che

- Il

- La capitale

- Il futuro

- L’ORIGINE

- il mondo

- loro

- Li

- teoria

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- think

- questo

- anche se?

- Attraverso

- Tigre

- tempo

- Serie storiche

- volte

- Titolo

- a

- oggi

- insieme

- token

- Tokens

- strumenti

- top

- Totale

- Torre

- Treni

- Training

- trasformatore

- tradurre

- Traduzione

- trasporti

- Trilione

- prova

- seconda

- Digitare

- Tipi di

- ui

- per

- su misura!

- unico

- Università

- fino a quando

- Aggiornanento

- Aggiornamenti

- utilizzabile

- uso

- caso d'uso

- utilizzato

- Utente

- utenti

- usa

- utilizzando

- APPREZZIAMO

- Valori

- varietà

- versione

- versioni

- molto

- via

- Visualizza

- visualizzazioni

- visione

- Visita

- visitatori

- volume

- ricercato

- guerra

- Prima

- we

- sito web

- servizi web

- Web-basata

- Sito web

- WELL

- Balena

- Che

- Che cosa è l'

- quando

- mentre

- quale

- while

- perché

- volere

- finestre

- con

- Word

- parole

- Lavora

- lavori

- mondo

- di fama mondiale

- avvolgere

- anni

- York

- Tu

- Trasferimento da aeroporto a Sharm

- te stesso

- zefiro

- Codice postale