Amazon Sage Maker Introduce l'ottimizzazione automatica del modello Iperbanda, una tecnica multi-fedeltà per ottimizzare gli iperparametri come modo più rapido ed efficiente per trovare un modello ottimale. In questo post, mostriamo come l'ottimizzazione automatica del modello con Hyperband può fornire un'ottimizzazione degli iperparametri più rapida, fino a tre volte più veloce.

I vantaggi dell'iperbanda

L'iperbanda presenta due vantaggi rispetto alle strategie di ottimizzazione della scatola nera esistenti: un utilizzo efficiente delle risorse e un migliore time-to-convergence.

I modelli di machine learning (ML) richiedono sempre più training, coinvolgono modelli complessi e set di dati di grandi dimensioni e richiedono molto impegno e risorse per trovare gli iperparametri ottimali. Le tradizionali strategie di ricerca black-box, come bayesiana, random search o grid search, tendono a scalare linearmente con la complessità del problema ML in questione, richiedendo tempi di addestramento più lunghi.

Per accelerare l'ottimizzazione degli iperparametri e ottimizzare i costi di formazione, utilizza Hyperband Algoritmo di dimezzamento successivo asincrono (ASHA), una strategia che parallelizza in modo massiccio l'ottimizzazione degli iperparametri e interrompe automaticamente i lavori di formazione in anticipo utilizzando configurazioni valutate in precedenza per prevedere se un candidato specifico è promettente o meno.

Come dimostreremo in questo post, Hyperband converge alla metrica obiettivo ottimale più velocemente della maggior parte delle strategie black-box e quindi consente di risparmiare tempo di formazione. Ciò consente di ottimizzare modelli su larga scala in cui la valutazione di ogni configurazione di iperparametro richiede l'esecuzione di un costoso ciclo di addestramento, ad esempio in visione computerizzata e applicazioni di elaborazione del linguaggio naturale (PNL). Se sei interessato a trovare i modelli più accurati, Hyperband ti consente anche di eseguire i tuoi lavori di ottimizzazione con più risorse e convergere verso una soluzione migliore.

Iperbanda con SageMaker

Il nuovo approccio Hyperband implementato per l'ottimizzazione degli iperparametri ha alcuni nuovi elementi di dati modificati tramite le chiamate API di AWS. Attuazione tramite il Console di gestione AWS non è disponibile in questo momento. Diamo un'occhiata ad alcuni elementi di dati introdotti per Hyperband:

- Strategia – Questo definisce l'approccio iperparametrico che si desidera scegliere. Con questa modifica viene introdotto un nuovo valore per Hyperband. I valori validi sono bayesiano, casuale e iperbanda.

- MinResource – Definisce il numero minimo di epoche o iterazioni da utilizzare per un processo di formazione prima che venga presa la decisione di interrompere la formazione.

- Risorsa massima – Specifica il numero massimo di epoche o iterazioni da utilizzare per un processo di addestramento per raggiungere l'obiettivo. Questo parametro non è richiesto se nel processo di ottimizzazione sono presenti numeri di epoche di addestramento definiti come iperparametro.

Implementazione

Il codice di esempio seguente mostra la configurazione del processo di ottimizzazione e la definizione del processo di addestramento:

Il codice precedente definisce strategy come Hyperband e definisce anche i limiti delle risorse limite inferiore e superiore all'interno della configurazione della strategia utilizzando HyperbandStrategyConfig, che funge da leva per controllare il runtime dell'allenamento. Per maggiori dettagli su come configurare ed eseguire l'ottimizzazione automatica del modello, fare riferimento a Specificare le impostazioni del lavoro di ottimizzazione degli iperparametri.

Iperbanda rispetto alla ricerca black-box

In questa sezione, eseguiamo due esperimenti per confrontare Hyperband con una ricerca black-box.

Primo esperimento

Nel primo esperimento, dato un compito di classificazione binaria, miriamo a ottimizzare una rete a tre strati completamente connessa su un set di dati sintetico, che contiene 5000 punti dati. Gli iperparametri per la rete includono il numero di unità per livello, la velocità di apprendimento dell'ottimizzatore Adam, il parametro di regolarizzazione L2 e la dimensione del batch. L'intervallo di questi parametri è:

- Numero di unità per livello – 10 a 1e3

- Tasso di apprendimento – 1e-4 a 0.1

- Parametro di regolarizzazione L2 – 1e-6 a 2

- Dimensione del lotto - 10-200

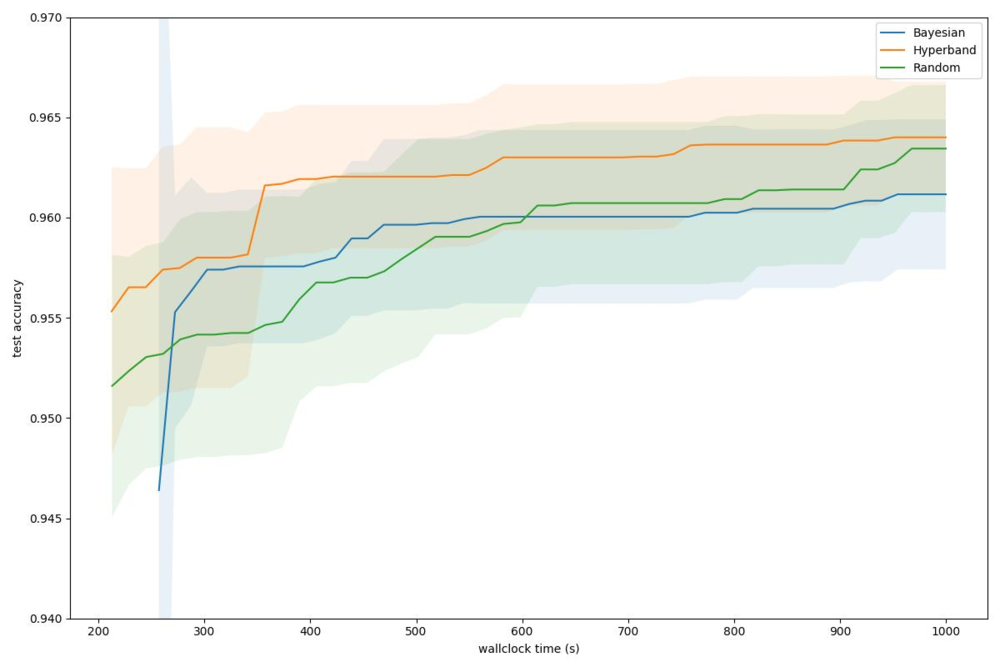

Il grafico seguente mostra i nostri risultati.

Confrontando Hyperband con altre strategie, data una precisione dell'obiettivo del 96%, Hyperband può raggiungere questo obiettivo in 357 secondi, mentre il bayesiano richiede 560 secondi e la ricerca casuale richiede 614 secondi. Hyperband trova costantemente una soluzione più ottimale a qualsiasi budget di tempo da parete. Ciò mostra un chiaro vantaggio di un algoritmo di ottimizzazione multi-fedeltà.

Secondo esperimento

In questo secondo esperimento, consideriamo il Cifar10 set di dati e addestrare ResNet-20, una popolare architettura di rete per attività di visione artificiale. Eseguiamo tutti gli esperimenti su istanze ml.g4dn.xlarge e ottimizziamo la rete neurale tramite SGD. Applichiamo anche l'aumento dell'immagine standard, inclusi capovolgimento casuale e ritaglio casuale. Lo spazio di ricerca contiene i seguenti parametri:

- Dimensione mini-batch: un numero intero da 4 a 512

- Tasso di apprendimento di SGD: un float da 1e-6 a 1e-1

- Momentum di SGD: un float da 0.01 a 0.99

- Decadimento del peso: un galleggiante da 1e-5 a 1

Il grafico seguente illustra i nostri risultati.

Data una precisione di convalida target di 0.87, Hyperband può raggiungerla in meno di 2000 secondi mentre Random e Bayesian richiedono rispettivamente 10000 e quasi 9000 secondi. Ciò equivale a un fattore di accelerazione di ~ 5x e ~ 4.5x per Hyperband in questa attività rispetto alle strategie casuali e bayesiane. Ciò mostra un chiaro vantaggio per l'algoritmo di ottimizzazione multi-fedeltà, che riduce significativamente il tempo necessario per ottimizzare i modelli di deep learning.

Conclusione

SageMaker Automatic Model Tuning consente di ridurre i tempi di messa a punto di un modello ricercando automaticamente la migliore configurazione dell'iperparametro all'interno degli intervalli specificati. Puoi trovare la versione migliore del tuo modello eseguendo processi di training sul tuo set di dati con diverse strategie di ricerca, come strategie black-box o multi-fedeltà.

In questo post, abbiamo discusso di come ora puoi utilizzare una strategia multi-fedeltà chiamata Iperbanda in SageMaker per trovare il modello migliore. Il supporto per Hyperband consente a SageMaker Automatic Model Tuning di mettere a punto modelli su larga scala in cui la valutazione di ogni configurazione di iperparametro richiede l'esecuzione di un costoso ciclo di formazione, come nelle applicazioni di visione artificiale e NLP.

Infine, abbiamo visto come Hyperband ottimizza ulteriormente il runtime rispetto alle strategie black-box con arresto anticipato utilizzando configurazioni valutate in precedenza per prevedere se un candidato specifico è promettente e, in caso contrario, interrompere la valutazione per ridurre i tempi complessivi e i costi di calcolo. L'utilizzo di Hyperband in SageMaker consente anche di specificare la risorsa minima e massima nel file HyperbandStrategyConfig parametro per ulteriori controlli di runtime.

Per ulteriori informazioni, visitare il sito Esegui l'ottimizzazione automatica del modello con SageMaker.

Circa gli autori

Doug Mbaya è un Senior Partner Solution architect con un focus su dati e analisi. Doug lavora a stretto contatto con i partner AWS, aiutandoli a integrare soluzioni di dati e analisi nel cloud.

Doug Mbaya è un Senior Partner Solution architect con un focus su dati e analisi. Doug lavora a stretto contatto con i partner AWS, aiutandoli a integrare soluzioni di dati e analisi nel cloud.

Gopi Mudiyala è un Senior Technical Account Manager presso AWS. Aiuta i clienti del settore dei servizi finanziari con le loro operazioni in AWS. In qualità di specialista dell'apprendimento automatico, Gopi lavora per aiutare i clienti ad avere successo nel loro percorso di machine learning.

Gopi Mudiyala è un Senior Technical Account Manager presso AWS. Aiuta i clienti del settore dei servizi finanziari con le loro operazioni in AWS. In qualità di specialista dell'apprendimento automatico, Gopi lavora per aiutare i clienti ad avere successo nel loro percorso di machine learning.

Xingchen Ma è uno scienziato applicato presso AWS. Lavora nel team proprietario del servizio SageMaker Automatic Model Tuning.

Xingchen Ma è uno scienziato applicato presso AWS. Lavora nel team proprietario del servizio SageMaker Automatic Model Tuning.

- AI

- oh arte

- generatore d'arte

- un robot

- Amazon Sage Maker

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- Apprendimento automatico di AWS

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- zefiro