1Istituto Max Planck per la Scienza della Luce, Erlangen, Germania

2Dipartimento di Fisica, Friedrich-Alexander Universität Erlangen-Nürnberg, Germania

3Univ Lyon, ENS de Lyon, CNRS, Laboratoire de Physique,F-69342 Lione, Francia

Trovi questo documento interessante o vuoi discuterne? Scrivi o lascia un commento su SciRate.

Astratto

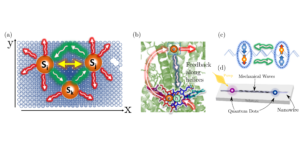

Il controllo quantistico è stato di crescente interesse negli ultimi anni, ad esempio per compiti come l'inizializzazione e la stabilizzazione dello stato. Le strategie basate sul feedback sono particolarmente potenti, ma anche difficili da trovare, a causa dello spazio di ricerca aumentato esponenzialmente. L'apprendimento per rinforzo profondo è molto promettente in questo senso. Può fornire nuove risposte a domande difficili, ad esempio se le misurazioni non lineari possono compensare un controllo lineare e vincolato. Qui mostriamo che l'apprendimento per rinforzo può scoprire con successo tali strategie di feedback, senza una conoscenza preliminare. Illustriamo questo per la preparazione dello stato in una cavità soggetta al rilevamento quantistico di non demolizione del numero di fotoni, con un semplice azionamento lineare come controllo. Gli stati di Fock possono essere prodotti e stabilizzati ad altissima fedeltà. È anche possibile raggiungere stati di sovrapposizione, a condizione che sia possibile controllare anche le velocità di misurazione per diversi stati Fock.

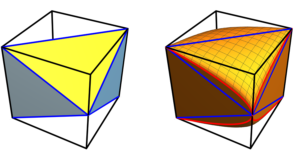

Immagine di primo piano: schemi dell'algoritmo RL. L'agente RL può applicare solo un semplice controllo lineare, nel nostro caso lo spostamento, a uno stato quantistico in una cavità. La misurazione debole non lineare consente all'agente di guidare il sistema verso sovrapposizioni complesse. Qui viene mostrata la funzione Wigner di $frac{|1rangle+|3rangle}{sqrt{2}}$. L'agente RL è modellato con una rete neurale feed-forward.

Riepilogo popolare

► dati BibTeX

► Riferimenti

, Navin Khaneja, Timo Reiss, Cindie Kehlet, Thomas Schulte-Herbrüggen e Steffen J. Glaser. "Controllo ottimale della dinamica di spin accoppiato: progettazione di sequenze di impulsi NMR mediante algoritmi di gradiente di salita". Journal of Magnetic Resonance 172, 296–305 (2005).

https: / / doi.org/ 10.1016 / j.jmr.2004.11.004

, P. de Fouquieres, SG Schirmer, SJ Glaser e Ilya Kuprov. "Ingegneria dell'impulso di salita del gradiente di secondo ordine". Journal of Magnetic Resonance 212, 412–417 (2011).

https: / / doi.org/ 10.1016 / j.jmr.2011.07.023

, AC Doherty e K. Jacobs. "Controllo del feedback dei sistemi quantistici utilizzando la stima dello stato continuo". Phys. Rev. A 60, 2700–2711 (1999).

https: / / doi.org/ 10.1103 / PhysRevA.60.2700

, Pavel Bushev, Daniel Rotter, Alex Wilson, François Dubin, Christoph Becher, Jürgen Eschner, Rainer Blatt, Viktor Steixner, Peter Rabl e Peter Zoller. "Raffreddamento del feedback di un singolo ione intrappolato". Phys. Rev. Lett. 96, 043003 (2006).

https: / / doi.org/ 10.1103 / physrevlett.96.043003

, Howard M. Wiseman e Gerard J. Milburn. "Misurazione e controllo quantistico". Cambridge University Press. Cambridge (2009).

https: / / doi.org/ 10.1017 / CBO9780511813948

, GG Gillett, RB Dalton, BP Lanyon, MP Almeida, M. Barbieri, GJ Pryde, JL O'Brien, KJ Resch, SD Bartlett e AG White. "Controllo sperimentale del feedback dei sistemi quantistici utilizzando misurazioni deboli". Phys. Rev. Lett. 104, 080503 (2010).

https: / / doi.org/ 10.1103 / physrevlett.104.080503

, Clément Sayrin, Igor Dotsenko, Xingxing Zhou, Bruno Peaudecerf, Théo Rybarczyk, Sébastien Gleyzes, Pierre Rouchon, Mazyar Mirrahimi, Hadis Amini, Michel Brune, Jean-Michel Raimond e Serge Haroche. "Il feedback quantistico in tempo reale prepara e stabilizza gli stati dei numeri di fotoni". Natura 477, 73–77 (2011).

https: / / doi.org/ 10.1038 / nature10376

, P. Campagne-Ibarcq, E. Flurin, N. Roch, D. Darson, P. Morfin, M. Mirrahimi, MH Devoret, F. Mallet e B. Huard. "Controllo persistente di un qubit superconduttore mediante feedback di misurazione stroboscopica". Phys. Rev. X 3, 021008 (2013).

https: / / doi.org/ 10.1103 / physrevx.3.021008

, Nissim Ofek, Andrei Petrenko, Reinier Heeres, Philip Reinhold, Zaki Leghtas, Brian Vlastakis, Yehan Liu, Luigi Frunzio, SM Girvin, L. Jiang, Mazyar Mirrahimi, MH Devoret e RJ Schoelkopf. "Allungare la vita di un bit quantistico con la correzione degli errori nei circuiti superconduttori". Natura 536, 441–445 (2016).

https: / / doi.org/ 10.1038 / nature18949

, Massimiliano Rossi, David Mason, Junxin Chen, Yeghishe Tsaturyan e Albert Schliesser. "Controllo quantistico basato sulla misurazione del movimento meccanico". Natura 563, 53–58 (2018).

https://doi.org/10.1038/s41586-018-0643-8

, Shay Hacohen-Gourgy e Leigh S. Martin. "Misure continue per il controllo di circuiti quantistici superconduttori". Avanzamenti in fisica: X 5, 1813626 (2020). arXiv:2009.07297.

https: / / doi.org/ 10.1080 / 23746149.2020.1813626 mila

arXiv: 2009.07297

, Alessio Fallani, Matteo AC Rossi, Dario Tamascelli, e Marco G. Genoni. "Apprendere le strategie di controllo del feedback per la metrologia quantistica". PRX Quantum 3, 020310 (2022).

https: / / doi.org/ 10.1103 / PRXQuantum.3.020310

, Richard S. Sutton e Andrew G. Barto. "Reinforcement Learning, seconda edizione: un'introduzione". MIT stampa. (2018). URL: http://incompleteideas.net/book/the-book.html.

http:///incompleteideas.net/book/the-book.html

, Volodymyr Mnih, Koray Kavukcuoglu, David Silver, Andrei A. Rusu, Joel Veness, Marc G. Bellemare, Alex Graves, Martin Riedmiller, Andreas K. Fidjeland, Georg Ostrovski, Stig Petersen, Charles Beattie, Amir Sadik, Ioannis Antonoglou, Helen King , Dharshan Kumaran, Daan Wierstra, Shane Legg e Demis Hassabis. "Controllo a livello umano attraverso l'apprendimento per rinforzo profondo". Natura 518, 529–533 (2015).

https: / / doi.org/ 10.1038 / nature14236

, Tuomas Haarnoja, Sehoon Ha, Aurick Zhou, Jie Tan, George Tucker e Sergey Levine. "Imparare a camminare tramite l'apprendimento per rinforzo profondo" (2019). arXiv:1812.11103.

arXiv: 1812.11103

, Thomas Fösel, Petru Tighineanu, Talitha Weiss e Florian Marquardt. "Apprendimento per rinforzo con reti neurali per feedback quantistico". Phys. Rev. X 8, 031084 (2018).

https: / / doi.org/ 10.1103 / physrevx.8.031084

, Chunlin Chen, Daoyi Dong, Han-Xiong Li, Jian Chu e Tzyh-Jong Tarn. "Apprendimento probabilistico basato sulla fedeltà per il controllo dei sistemi quantistici". Transazioni IEEE su reti neurali e sistemi di apprendimento 25, 920–933 (2014).

https:///doi.org/10.1109/tnnls.2013.2283574

, Moritz August e José Miguel Hernández-Lobato. "Prendere i gradienti attraverso gli esperimenti: LSTM e ottimizzazione della politica prossimale della memoria per il controllo quantistico della scatola nera". A Rio Yokota, Michèle Weiland, John Shalf e Sadaf Alam, editori, High Performance Computing. Pagine 591–613. Appunti delle lezioni in InformaticaCham (2018). Editoria internazionale Springer.

https://doi.org/10.1007/978-3-030-02465-9_43

, Marin Bukov, Alexandre GR Day, Dries Sels, Phillip Weinberg, Anatoli Polkovnikov e Pankaj Mehta. "Apprendimento per rinforzo in diverse fasi del controllo quantistico". Phys. Rev. X 8, 031086 (2018). arXiv:1705.00565.

https: / / doi.org/ 10.1103 / physrevx.8.031086

arXiv: 1705.00565

, Riccardo Porotti, Dario Tamascelli, Marcello Restelli, Enrico Prati. "Trasporto coerente di stati quantistici mediante apprendimento per rinforzo profondo". Commun Phys 2, 1–9 (2019).

https: / / doi.org/ 10.1038 / s42005-019-0169-x

, Murphy Yuezhen Niu, Sergio Boixo, Vadim N. Smelyanskiy e Hartmut Neven. "Controllo quantistico universale attraverso l'apprendimento per rinforzo profondo". npj Informazioni quantistiche 5, 1–8 (2019).

https://doi.org/10.1038/s41534-019-0141-3

, Zheng An e DL Zhou. "Apprendimento per rinforzo profondo per il controllo del gate quantistico". EPL 126, 60002 (2019).

https://doi.org/10.1209/0295-5075/126/60002

, Han Xu, Junning Li, Liqiang Liu, Yu Wang, Haidong Yuan e Xin Wang. "Controllo generalizzabile per la stima dei parametri quantistici attraverso l'apprendimento per rinforzo". npj Quantum Inf 5, 1–8 (2019).

https: / / doi.org/ 10.1038 / s41534-019-0198-z

, Juan Miguel Arrazola, Thomas R. Bromley, Josh Izaac, Casey R. Myers, Kamil Brádler e Nathan Killoran. "Metodo di apprendimento automatico per la preparazione dello stato e la sintesi di gate su computer quantistici fotonici". Scienza quantistica. Tecno. 4, 024004 (2019).

https: / / doi.org/ 10.1088 / 2058-9565 / aaf59e

, L. O'Driscoll, R. Nichols e PA Knott. "Un algoritmo di apprendimento automatico ibrido per la progettazione di esperimenti quantistici". Quantum Mach. Intel. 1, 5–15 (2019).

https://doi.org/10.1007/s42484-019-00003-8

, Thomas Fösel, Stefan Krastanov, Florian Marquardt e Liang Jiang. “Efficiente controllo della cavità con i cancelli SNAP” (2020). arXiv:2004.14256.

arXiv: 2004.14256

, Mogens Dalgaard, Felix Motzoi, Jens Jakob Sørensen e Jacob Sherson. "Ottimizzazione globale della dinamica quantistica con l'esplorazione profonda di AlphaZero". npj Quantum Inf 6, 6 (2020).

https://doi.org/10.1038/s41534-019-0241-0

, Hailan Ma, Daoyi Dong, Steven X. Ding e Chunlin Chen. "Apprendimento per rinforzo profondo basato sul curriculum per il controllo quantistico" (2021). arXiv:2012.15427.

arXiv: 2012.15427

, Zheng An, Hai-Jing Song, Qi-Kai He e DL Zhou. "Controllo quantistico ottimale di sistemi quantistici dissipativi multilivello con apprendimento per rinforzo". Phys. Rev. A 103, 012404 (2021).

https: / / doi.org/ 10.1103 / physreva.103.012404

, Yuval Baum, Mirko Amico, Sean Howell, Michael Hush, Maggie Liuzzi, Pranav Mundada, Thomas Merkh, Andre RR Carvalho e Michael J. Biercuk. "Apprendimento sperimentale di rinforzo profondo per la progettazione di scenografie di gate resistenti agli errori su un computer quantistico superconduttore". PRX Quantico 2, 040324 (2021).

https: / / doi.org/ 10.1103 / PRXQuantum.2.040324

, Thomas Fosel, Murphy Yuezhen Niu, Florian Marquardt e Li Li. "Ottimizzazione quantistica del circuito con apprendimento per rinforzo profondo" (2021). arXiv:2103.07585.

arXiv: 2103.07585

, E. Flurin, LS Martin, S. Hacohen-Gourgy e I. Siddiqi. "Utilizzo di una rete neurale ricorrente per ricostruire la dinamica quantistica di un Qubit superconduttore da osservazioni fisiche". Revisione fisica X 10 (2020).

https: / / doi.org/ 10.1103 / physrevx.10.011006

, DT Lennon, H. Moon, LC Camenzind, Liuqi Yu, DM Zumbühl, G. a. D. Briggs, MA Osborne, EA Laird e N. Ares. "Misurare in modo efficiente un dispositivo quantistico utilizzando l'apprendimento automatico". npj Informazioni quantistiche 5, 1–8 (2019).

https://doi.org/10.1038/s41534-019-0193-4

, Kyunghoon Jung, MH Abobeih, Jiwon Yun, Gyeonghun Kim, Hyunseok Oh, Ang Henry, TH Taminiau e Dohun Kim. "Il deep learning ha migliorato il rilevamento individuale dello spin nucleare". npj Quantum Inf 7, 1–9 (2021).

https://doi.org/10.1038/s41534-021-00377-3

, V Nguyen. "Apprendimento per rinforzo profondo per una misurazione efficiente dei dispositivi quantistici". npj Informazioni quantistiche Pagina 9 (2021).

https: / / doi.org/ 10.1038 / s41534-021-00434-x

, Alexander Hentschel e Barry C. Sanders. "Apprendimento automatico per misurazioni quantistiche precise". Phys. Rev. Lett. 104, 063603 (2010).

https: / / doi.org/ 10.1103 / physrevlett.104.063603

, M. Tiersch, EJ Ganahl e HJ Briegel. "Calcolo quantistico adattivo in ambienti mutevoli utilizzando la simulazione proiettiva". Rappresentazione sciistica 5, 12874 (2015).

https: / / doi.org/ 10.1038 / srep12874

, Pantita Palittapongarnpim, Peter Wittek, Ehsan Zahedinejad, Shakib Vedaie e Barry C. Sanders. "Apprendimento nel controllo quantistico: ottimizzazione globale ad alta dimensione per la dinamica quantistica rumorosa". Neuroinformatica 268, 116–126 (2017).

https:///doi.org/10.1016/j.neucom.2016.12.087

, Jelena Mackeprang, Durga B. Rao Dasari e Jörg Wrachtrup. "Un approccio di apprendimento per rinforzo per l'ingegneria dello stato quantistico". Quantum Mach. Intel. 2, 5 (2020).

https://doi.org/10.1007/s42484-020-00016-8

, Christian Sommer, Muhammad Asjad e Claudiu Genes. "Prospettive di apprendimento per rinforzo per lo smorzamento simultaneo di molti modi meccanici". Rappresentazione sciistica 10, 2623 (2020).

https: / / doi.org/ 10.1038 / s41598-020-59435-z

, Zhikang T. Wang, Yuto Ashida e Masahito Ueda. "Controllo dell'apprendimento del rinforzo profondo dei cartpoli quantistici". Phys. Rev. Lett. 125, 100401 (2020).

https: / / doi.org/ 10.1103 / PhysRevLett.125.100401

, Sangkha Borah, Bijita Sarma, Michael Kewming, Gerard J. Milburn e Jason Twamley. "Controllo quantico di feedback basato sulla misurazione con apprendimento per rinforzo profondo per un potenziale non lineare a doppio pozzo". Phys. Rev. Lett. 127, 190403 (2021).

https: / / doi.org/ 10.1103 / PhysRevLett.127.190403

, VV Sivak, A. Eickbusch, H. Liu, B. Royer, I. Tsioutsios e MH Devoret. "Controllo quantistico senza modelli con apprendimento per rinforzo". Phys. Rev. X 12, 011059 (2022).

https: / / doi.org/ 10.1103 / PhysRevX.12.011059

, Antoine Essig, Quentin Ficheux, Théau Peronnin, Nathanaël Cottet, Raphaël Lescanne, Alain Sarlette, Pierre Rouchon, Zaki Leghtas e Benjamin Huard. "Misurazione del numero di fotoni multiplex". Phys. Rev. X 11, 031045 (2021).

https: / / doi.org/ 10.1103 / PhysRevX.11.031045

, B. Peaudecerf, C. Sayrin, X. Zhou, T. Rybarczyk, S. Gleyzes, I. Dotsenko, JM Raimond, M. Brune e S. Haroche. "Esperimenti di feedback quantistico che stabilizzano gli stati di luce di Fock in una cavità". Phys. Rev. A 87, 042320 (2013).

https: / / doi.org/ 10.1103 / physreva.87.042320

, X. Zhou, I. Dotsenko, B. Peaudecerf, T. Rybarczyk, C. Sayrin, S. Gleyzes, JM Raimond, M. Brune e S. Haroche. "Campo bloccato su uno stato Fock dal feedback quantistico con correzioni di fotoni singoli". Phys. Rev. Lett. 108, 243602 (2012).

https: / / doi.org/ 10.1103 / physrevlett.108.243602

, Jacob C. Curtis, Connor T. Hann, Salvatore S. Elder, Christopher S. Wang, Luigi Frunzio, Liang Jiang e Robert J. Schoelkopf. "Rilevamento a colpo singolo risolto di fotoni a microonde con mitigazione degli errori". Phys. Rev. A 103, 023705 (2021).

https: / / doi.org/ 10.1103 / physreva.103.023705

, Christine Guerlin, Julien Bernu, Samuel Deléglise, Clément Sayrin, Sébastien Gleyzes, Stefan Kuhr, Michel Brune, Jean-Michel Raimond e Serge Haroche. "Crollo progressivo dello stato di campo e conteggio quantistico di fotoni non demolitori". Natura 448, 889–893 (2007).

https: / / doi.org/ 10.1038 / nature06057

, BR Johnson, MD Reed, AA Houck, DI Schuster, Lev S. Bishop, E. Ginossar, JM Gambetta, L. DiCarlo, L. Frunzio, SM Girvin e RJ Schoelkopf. "Rilevamento quantistico di non demolizione di singoli fotoni a microonde in un circuito". Natura Phys 6, 663–667 (2010).

https: / / doi.org/ 10.1038 / nphys1710

, B. Peaudecerf, T. Rybarczyk, S. Gerlich, S. Gleyzes, JM Raimond, S. Haroche, I. Dotsenko e M. Brune. "Misurazione quantistica adattativa non demolizione di un numero di fotoni". Phys. Rev. Lett. 112, 080401 (2014).

https: / / doi.org/ 10.1103 / physrevlett.112.080401

, Crispin Gardiner e Peter Zoller. "Rumore quantistico: un manuale di metodi stocastici quantistici markoviani e non markoviani con applicazioni all'ottica quantistica". Serie Springer in Synergetics. Springer-Verlag. Berlino Heidelberg (2004). Terza edizione. URL: link.springer.com/book/9783540223016.

https:///link.springer.com/book/9783540223016

, John Schulman, Filip Wolski, Prafulla Dhariwal, Alec Radford e Oleg Klimov. "Algoritmi di ottimizzazione delle politiche prossimali" (2017). arXiv:1707.06347.

arXiv: 1707.06347

, John Schulman, Sergey Levine, Philipp Moritz, Michael I. Jordan e Pieter Abbeel. "Ottimizzazione delle politiche della regione fiduciaria" (2017). arXiv:1502.05477.

arXiv: 1502.05477

, Ashley Hill, Antonin Raffin, Maximilian Ernestus, Adam Gleave, Anssi Kanervisto, Rene Traore, Prafulla Dhariwal, Christopher Hesse, Oleg Klimov, Alex Nichol, Matthias Plappert, Alec Radford, John Schulman, Szymon Sidor e Yuhuai Wu. "Linee di base stabili". URL: github.com/hill-a/stable-baselines.

https:///github.com/hill-a/stable-baselines

, Weizhou Cai, Yuwei Ma, Weiting Wang, Chang-Ling Zou e Luyan Sun. "Codici di correzione degli errori quantistici bosonici nei circuiti quantistici superconduttori". Ricerca fondamentale 1, 50–67 (2021).

https:///doi.org/10.1016/j.fmre.2020.12.006

, FAM de Oliveira, MS Kim, PL Knight e V. Buek. “Proprietà degli stati numerici sfollati”. Revisione fisica A 41, 2645–2652 (1990).

https: / / doi.org/ 10.1103 / physreva.41.2645

, Michael Martin Nieto. "Stati numerici spostati e compressi". Lettere di fisica A 229, 135–143 (1997). arXiv:quant-ph/9612050.

https://doi.org/10.1016/s0375-9601(97)00183-7

arXiv: Quant-ph / 9612050

Citato da

[1] Anna Dawid, Julian Arnold, Borja Requena, Alexander Gresch, Marcin Płodzień, Kaelan Donatella, Kim A. Nicoli, Paolo Stornati, Rouven Koch, Miriam Büttner, Robert Okuła, Gorka Muñoz-Gil, Rodrigo A. Vargas-Hernández, Alba Cervera-Lierta, Juan Carrasquilla, Vedran Dunjko, Marylou Gabrié, Patrick Huembeli, Evert van Nieuwenburg, Filippo Vicentini, Lei Wang, Sebastian J. Wetzel, Giuseppe Carleo, Eliška Greplová, Roman Krems, Florian Marquardt, Michał Tomza, Maciej Lewenstein, e Alexandre Dauphin, "Applicazioni moderne dell'apprendimento automatico nelle scienze quantistiche", arXiv: 2204.04198.

[2] Riccardo Porotti, Vittorio Peano e Florian Marquardt, “Gradient Ascent Pulse Engineering with Feedback”, arXiv: 2203.04271.

[3] Luigi Giannelli, Pierpaolo Sgroi, Jonathon Brown, Gheorghe Sorin Paraoanu, Mauro Paternostro, Elisabetta Paladino, e Giuseppe Falci, “Un tutorial on ottimali control e metodi di apprendimento per rinforzo per le tecnologie quantistiche”, Lettere di fisica A 434, 128054 (2022).

[4] Björn Annby-Andersson, Faraj Bakhshinezhad, Debankur Bhattacharyya, Guilherme De Sousa, Christopher Jarzynski, Peter Samuelsson e Patrick P. Potts, "Quantum Fokker-Planck master equazione per il controllo del feedback continuo", arXiv: 2110.09159.

[5] Alessio Fallani, Matteo AC Rossi, Dario Tamascelli e Marco G. Genoni, “Learning Feedback Control Strategies for Quantum Metrology”, PRX Quantico 3 2, 020310 (2022).

[6] Paolo Andrea Erdman e Frank Noé, "Guidare macchine termiche quantistiche a scatola nera con ottimi rapporti potenza/efficienza usando l'apprendimento per rinforzo", arXiv: 2204.04785.

[7] David A. Herrera-Martí, "Approccio del gradiente politico alla compilazione di circuiti quantistici variazionali", arXiv: 2111.10227.

Le citazioni sopra sono di ANNUNCI SAO / NASA (ultimo aggiornamento riuscito 2022-07-22 01:21:35). L'elenco potrebbe essere incompleto poiché non tutti gli editori forniscono dati di citazione adeguati e completi.

On Il servizio citato da Crossref non sono stati trovati dati su citazioni (ultimo tentativo 2022-07-22 01:21:34).

Questo documento è pubblicato in Quantum sotto il Creative Commons Attribuzione 4.0 Internazionale (CC BY 4.0) licenza. Il copyright rimane dei detentori del copyright originali come gli autori o le loro istituzioni.