Parla con quasi chiunque – chiunque sia umano, cioè – e la tua conversazione incontrerà cosa Malihe Alikhani chiama "sane attriti", momenti in cui il tuo obiettivo nella conversazione si scontra con quello del tuo partner, momenti che richiedono chiarimenti, producono confusione o portano a disaccordo.

Non è così con i modelli linguistici di grandi dimensioni.

Alikhani, professore assistente al Khoury College of Computer Sciences della Northeastern University, afferma che i modelli linguistici di grandi dimensioni come ChatGPT hanno un serio problema di certezza.

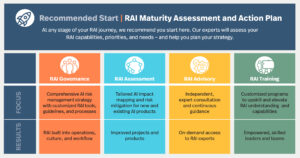

Il nuovo progetto di Alikhani, chiamato Friction for Accountability in Conversational Transactions (FACT), è una collaborazione tra la Northeastern University, l'Università dell'Illinois Urbana-Champaign e l'Università della California del Sud.

Finanziato attraverso una sovvenzione per l’esplorazione dell’intelligenza artificiale attraverso la Defense Advanced Research Project Agency, il progetto FACT mira a sviluppare strumenti di intelligenza artificiale più trasparenti ed equi.

“Una delle cose che rende la comunicazione umana uno strumento fruttuoso”, afferma Alikhani, “è il fatto che rappresentiamo la nostra incertezza nel nostro modo di parlare, nel nostro tono. Lo mettiamo nella nostra espressione facciale.

I salutari attriti che derivano dall’incertezza nella comunicazione da uomo a uomo aiutano a mantenere una diversità di opinioni e punti di vista, continua.

Ma i modelli linguistici di grandi dimensioni (o LLM) non sono interessati a esprimere la loro incertezza, risultando in ciò che Alikhani chiama “comportamenti adulatori”. I modelli linguistici di grandi dimensioni “vogliono massimizzare la soddisfazione” dei loro utenti, dice, e “non introdurre mai alcun attrito nella conversazione, indipendentemente dal fatto che [il modello sia] sicuro” delle sue affermazioni o meno.

Ulteriori problemi sorgono con i modelli linguistici di grandi dimensioni a causa della loro tendenza ad avere allucinazioni. Gli LLM “inventano fatti. Sono molto bravi a persuadere le persone con fatti inventati”.

Nonostante questi problemi, Alikhani afferma anche che gli esseri umani sono inclini a fare eccessivo affidamento sui “fatti” generati da questi modelli di intelligenza artificiale, che “potrebbero inventare fatti per renderti felice”.

Parte di ciò che contribuisce all’eccessiva dipendenza degli utenti dai LLM sono i loro “comportamenti umani”, afferma. “Ciò manipolerà la nostra cognizione”.

Anche i modelli linguistici di grandi dimensioni sembrano produrre le loro risposte istantaneamente, un altro fattore che fa presumere che gli utenti siano corretti. “È difficile per noi scienziati dell'intelligenza artificiale dire alla gente: 'Sì, è coerente'. Sì, è veloce. Sì, si sta sintonizzando con il tuo stile. Ma ha allucinazioni'”, dice Alikhani.

Con la loro nuova sovvenzione, Alikhani e il suo team progetteranno strumenti che dimostreranno i livelli di certezza che un LLM ha su una dichiarazione che fa e introdurranno salutari attriti nelle conversazioni uomo-intelligenza artificiale.

“Come possiamo prevedere e verbalizzare la fiducia del sistema?” chiede Alikhani. Se un modello di intelligenza artificiale è “solo il 2% sicuro di sé, dovrebbe esternalizzarlo”.

"Uno degli obiettivi principali della ricerca è modellare l'incertezza, esternalizzarla" e insegnare agli LLM come rappresentare tale incertezza all'interno di una conversazione uomo-intelligenza artificiale. Questo potrebbe apparire nell'interfaccia di un utente come un punteggio percentile della certezza del modello, oppure il modello potrebbe riflettere l'incertezza nelle sue risposte in un modo più umano.

Ad esempio, Alikhani immagina una situazione in cui un paziente potrebbe porre a un modello linguistico di grandi dimensioni una domanda sulla sua salute. L’attuale generazione di LLM cercherà di fornire una risposta, anche se tale risposta potrebbe rivelarsi pericolosa. Alikhani spera di costruire modelli che possano dire: “Non lo so. Dovresti chiamare la tua infermiera.'”

“La robustezza è fondamentale per la responsabilità nell’intelligenza artificiale”, afferma Alikhani. Al momento, è normale che un LLM risponda con una risposta a una domanda al momento della domanda e una risposta completamente diversa pochi minuti dopo.

Quando si tratta di progettare un’intelligenza artificiale che sia sicura e responsabile, i precedenti sistemi di intelligenza artificiale che potevano aiutare con compiti semplici “non avevano accesso a una serie di altri set di dati”, afferma Alikhani, “e non potevano dire cose che potrebbero essere pericolose”. , perché non era nei loro dati."

Ciò che esattamente questi set di dati includono - o escludono - è fondamentale per superare i pregiudizi che gli LLM mostrano nei confronti del "genere, ma anche pregiudizi più sottili, come gruppi interni rispetto a gruppi esterni e diversi pregiudizi cognitivi che si riflettono nei modelli [del linguaggio di grandi dimensioni]".

Ora, Alikhani spera di progettare modelli che servano le persone con “diverse possibilità e preferenze”, dice.

“Non vogliamo continuare a costruire sistemi per la popolazione per la quale disponiamo di dati, ma pensiamo a chi stiamo lasciando indietro e a come possiamo fermare questo enorme divario di disuguaglianza invece di peggiorarlo?” lei chiede. “L’obiettivo del mio laboratorio è andare verso quella direzione”.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.mtlc.co/large-language-models-can-lie-to-you-this-professor-wants-you-to-know-when-they-do/

- :È

- :non

- :Dove

- $ SU

- 2%

- a

- Chi siamo

- accesso

- responsabilità

- responsabile

- Avanzate

- contro

- agenzia

- AI

- Sistemi di intelligenza artificiale

- mira

- quasi

- anche

- an

- ed

- Un altro

- rispondere

- in qualsiasi

- chiunque

- apparire

- SONO

- sorgere

- artificiale

- intelligenza artificiale

- AS

- chiedere

- chiedendo

- Assistant

- assumere

- At

- BE

- perché

- comportamenti

- dietro

- fra

- pregiudizi

- entrambi

- costruire

- Costruzione

- Mazzo

- ma

- by

- California

- chiamata

- detto

- Bandi

- Materiale

- certezza

- ChatGPT

- cognizione

- conoscitivo

- COERENTE

- collaborazione

- College

- viene

- Uncommon

- Comunicazione

- completamente

- computer

- fiducia

- fiducioso

- confusione

- continua

- contribuisce

- Conversazione

- discorsivo

- Conversazioni

- Consiglio

- Corrente

- Pericoloso

- dati

- dataset

- Difesa

- dimostrare

- Design

- progettazione

- sviluppare

- diverso

- direzione

- Dsiplay

- Diversità

- do

- Dont

- incontrare

- equo

- Anche

- esplorazione

- esprimendo

- espressione

- Facciale

- fatto

- fattore

- fatti

- FAST

- pochi

- Nel

- attrito

- da

- fecondo

- divario

- generato

- ELETTRICA

- scopo

- Obiettivi

- buono

- concedere

- contento

- Hard

- Avere

- Salute e benessere

- sano

- Aiuto

- suo

- detiene

- spera

- Come

- Tutorial

- HTTPS

- Enorme

- umano

- Gli esseri umani

- if

- Illinois

- immagina

- in

- includere

- disuguaglianza

- esempio

- istantaneamente

- invece

- Intelligence

- interessato

- Interfaccia

- ai miglioramenti

- introdurre

- sicurezza

- IT

- SUO

- ad appena

- mantenere

- Le

- Sapere

- laboratorio

- Lingua

- grandi

- dopo

- portare

- Leadership

- partenza

- livelli

- Bugia

- piace

- LLM

- fatto

- Principale

- mantenere

- make

- FA

- Fare

- Massa

- Massimizzare

- forza

- Minuti

- modello

- modelli

- momento

- Moments

- Scopri di più

- cambiano

- my

- New

- Northeastern University

- of

- on

- ONE

- Opinioni

- or

- Altro

- nostro

- su

- ancora

- superamento

- paziente

- Persone

- Platone

- Platone Data Intelligence

- PlatoneDati

- popolazione

- predire

- preferenze

- precedente

- Problema

- problemi

- produrre

- Insegnante

- progetto

- fornire

- metti

- domanda

- domanda

- riflettere

- riflette

- basandosi

- rappresentare

- richiedere

- riparazioni

- Rispondere

- risposte

- risultante

- sicura

- dire

- dice

- SCIENZE

- scienziati

- Punto

- sembrare

- grave

- servizio

- lei

- dovrebbero

- Un'espansione

- situazione

- So

- Meridionale

- discorso

- dichiarazione

- dichiarazioni

- Fermare

- style

- tale

- sistema

- SISTEMI DI TRATTAMENTO

- task

- team

- Tech

- dire

- tendenza

- che

- I

- loro

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- think

- questo

- quelli

- Attraverso

- tempo

- a

- TONE

- strumenti

- verso

- verso

- Le transazioni

- trasparente

- prova

- sintonia

- TURNO

- Incertezza

- Università

- us

- Utente

- utenti

- contro

- molto

- punti di vista

- volere

- vuole

- Prima

- Modo..

- we

- Che

- quando

- se

- quale

- OMS

- volere

- con

- entro

- peggio

- sì

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro