La perdita della vista si presenta in varie forme. Per alcuni è dalla nascita, per altri è una lenta discesa nel tempo che arriva con molte date di scadenza: il giorno in cui non puoi vedere le foto, riconoscere te stesso o i volti dei tuoi cari o persino leggere la tua posta. Nel nostro precedente post sul blog Consenti ai non vedenti di ascoltare i documenti utilizzando Amazon Textract e Amazon Polly, ti abbiamo mostrato la nostra applicazione Text to Speech chiamata "Leggi per me". L'accessibilità ha fatto molta strada, ma per quanto riguarda le immagini?

Alla conferenza AWS re:Invent del 2022 a Las Vegas, abbiamo dimostrato “Descrivimi” all'AWS Builders' Fair, un sito Web che aiuta i non vedenti a comprendere le immagini attraverso didascalie delle immagini, riconoscimento facciale e sintesi vocale, una tecnologia che chiamiamo "Image to Speech". Attraverso l'uso di più servizi AI/ML, "Descrivi per me" genera una didascalia di un'immagine di input e la rileggerà con una voce chiara e naturale in una varietà di lingue e dialetti.

In questo post del blog ti guidiamo attraverso l'architettura della soluzione alla base di "Describe For Me" e le considerazioni di progettazione della nostra soluzione.

Panoramica della soluzione

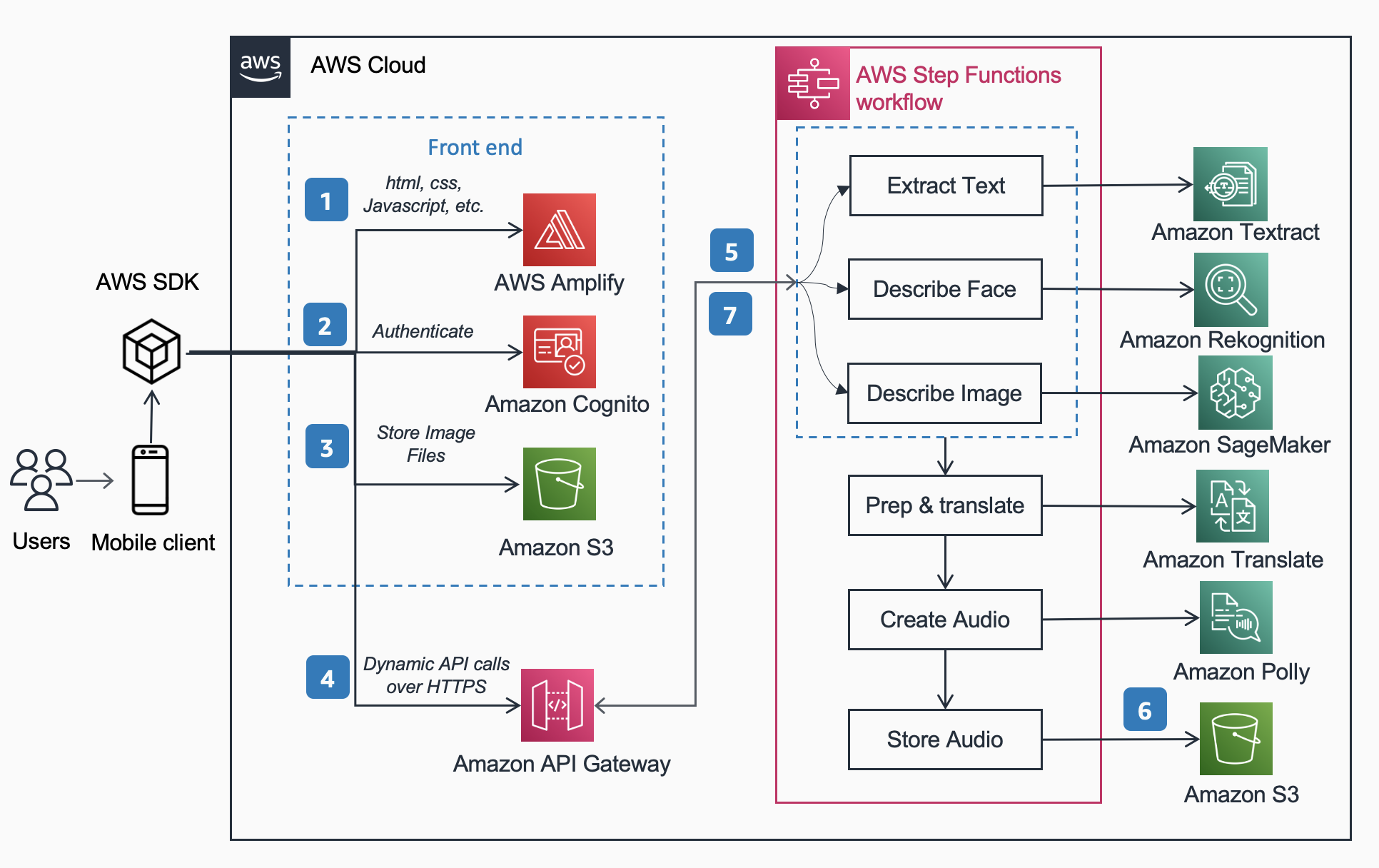

La seguente architettura di riferimento mostra il flusso di lavoro di un utente che scatta una foto con un telefono e riproduce un MP3 della didascalia dell'immagine.

Il flusso di lavoro include i passaggi seguenti,

- AWS Amplifica distribuisce l'app Web DescribeForMe composta da HTML, JavaScript e CSS ai dispositivi mobili degli utenti finali.

- Il Amazzonia Cognito Il pool di identità concede l'accesso temporaneo a Amazon S3 secchio.

- L'utente carica un file immagine nel file Amazon S3 secchio usando SDK AWS attraverso l'app web.

- L'app Web DescribeForMe richiama i servizi AI di back-end inviando il file Amazon S3 object Digitare il payload in Gateway API Amazon

- Gateway API Amazon istanzia e Funzioni AWS Step flusso di lavoro. La macchina a stati orchestra i servizi di Intelligenza Artificiale/Machine Learning (AI/ML). Rekognition di Amazon, Amazon Sage Maker, Testo Amazon, Amazon Traduttore, ed Amazon Polly utilizzando AWS lambda funzioni.

- Il Funzioni AWS Step il flusso di lavoro crea un file audio come output e lo memorizza in Amazon S3 in formato MP3.

- Un URL prefirmato con la posizione del file audio memorizzato in Amazon S3 viene rispedito al browser dell'utente tramite Gateway API Amazon. Il dispositivo mobile dell'utente riproduce il file audio utilizzando l'URL prefirmato.

Procedura dettagliata della soluzione

In questa sezione, ci concentriamo sulle considerazioni di progettazione per cui abbiamo scelto

- elaborazione parallela all'interno di un Funzioni AWS Step flusso di lavoro

- modello di apprendimento automatico pre-addestrato sequenza-sequenza unificato OFA (One For All) da Abbracciare il viso a Amazon Sage Maker per la didascalia dell'immagine

- Rekognition di Amazon per il riconoscimento facciale

Per una panoramica più dettagliata del motivo per cui abbiamo scelto un'architettura serverless, un flusso di lavoro sincrono, un flusso di lavoro con funzioni rapide, un'architettura headless e i vantaggi ottenuti, leggi il nostro precedente post sul blog Consenti ai non vedenti di ascoltare i documenti utilizzando Amazon Textract e Amazon Polly.

Elaborazione parallela

L'utilizzo dell'elaborazione parallela all'interno del flusso di lavoro di Step Functions ha ridotto i tempi di elaborazione fino al 48%. Dopo che l'utente ha caricato l'immagine nel bucket S3, Amazon API Gateway crea un'istanza di un flusso di lavoro AWS Step Functions. Quindi le tre funzioni Lambda seguenti elaborano l'immagine all'interno del flusso di lavoro Step Functions in parallelo.

- La prima funzione Lambda chiamata

describe_imageanalizza l'immagine utilizzando il Modello OFA_IMAGE_CAPTION ospitato su un endpoint SageMaker in tempo reale per fornire la didascalia dell'immagine. - La seconda funzione Lambda chiamata

describe_facesprima controlla se ci sono volti che usano Amazon Rekognition API Rileva voltie, se true, chiama l'API Compare Faces. La ragione di ciò è che Confronta volti genererà un errore se non ci sono volti trovati nell'immagine. Inoltre, chiamare prima Rileva volti è più veloce rispetto alla semplice esecuzione di Confronta volti e alla gestione degli errori, quindi per le immagini prive di volti, il tempo di elaborazione sarà più rapido. - La terza funzione Lambda chiamata

extract_textgestisce la sintesi vocale utilizzando Amazon Textract e Amazon Comprehend.

L'esecuzione delle funzioni Lambda in successione è adatta, ma il modo più rapido ed efficiente per farlo è attraverso l'elaborazione parallela. La tabella seguente mostra il tempo di calcolo risparmiato per tre immagini di esempio.

| Immagine | Persone | Tempo sequenziale | Tempo parallelo | Risparmio di tempo (%) | Didascalia |

|

0 | 1869ms | 1702ms | 8% | Un gatto soriano rannicchiato in un soffice letto bianco. |

|

1 | 4277ms | 2197ms | 48% | Una donna con una camicetta verde e un cardigan nero sorride alla telecamera. Riconosco una persona: Kanbo. |

|

4 | 6603ms | 3904ms | 40% | Persone in piedi davanti alle sfere amazzoniche. Riconosco 3 persone: Kanbo, Jack e Ayman. |

Didascalia immagine

Hugging Face è una community open source e una piattaforma di data science che consente agli utenti di condividere, creare, addestrare e distribuire modelli di machine learning. Dopo aver esplorato i modelli disponibili nell'hub del modello Hugging Face, abbiamo scelto di utilizzare il Modello OFA perché, come descritto dagli autori, è "un framework indipendente dal compito e dalla modalità che supporta la completezza del compito".

OFA è un passo verso "One For All", in quanto è un modello pre-addestrato multimodale unificato che può essere trasferito efficacemente a una serie di compiti a valle. Mentre il modello OFA supporta molte attività tra cui la base visiva, la comprensione del linguaggio e la generazione di immagini, abbiamo utilizzato il Modello OFA per la didascalia delle immagini nel progetto Describe For Me per eseguire la parte da immagine a testo dell'applicazione. Consulta il repository ufficiale di OFA (ICML 2022), carta per conoscere le architetture, i compiti e le modalità unificanti dell'OFA attraverso un semplice framework di apprendimento da sequenza a sequenza.

Per integrare OFA nella nostra applicazione, abbiamo clonato il repository da Hugging Face e containerizzato il modello per distribuirlo a un endpoint SageMaker. IL notebook in questo repository è un'ottima guida per distribuire il modello di grandi dimensioni OFA in un notebook Jupyter in SageMaker. Dopo aver containerizzato lo script di inferenza, il modello è pronto per essere distribuito dietro un endpoint SageMaker come descritto nel SageMaker documentazione. Una volta distribuito il modello, crea un endpoint HTTPS che può essere integrato con la funzione lambda "describe_image" che analizza l'immagine per creare la didascalia dell'immagine. Abbiamo implementato il modello minuscolo OFA perché è un modello più piccolo e può essere implementato in un periodo di tempo più breve ottenendo prestazioni simili.

Di seguito sono riportati esempi di contenuti da immagine a voce generati da "Descrivi per me":

L'aurora boreale, o aurora boreale, riempie il cielo notturno sopra la sagoma di una casa..

Un cane dorme su una coperta rossa su un pavimento di legno duro, accanto a una valigia aperta piena di giocattoli..

Un gatto soriano rannicchiato in un soffice letto bianco.

Riconoscimento facciale

Amazon Rekognition Image fornisce il Rileva Facce operazione che cerca caratteristiche facciali chiave come occhi, naso e bocca per rilevare i volti in un'immagine di input. Nella nostra soluzione sfruttiamo questa funzionalità per rilevare qualsiasi persona nell'immagine di input. Se viene rilevata una persona, allora usiamo il ConfrontaFaces operazione per confrontare il volto nell'immagine di input con i volti con cui "Descrivi per me" è stato addestrato e descrivere la persona per nome. Abbiamo scelto di utilizzare Rekognition per il rilevamento facciale a causa dell'elevata precisione e della semplicità di integrazione nella nostra applicazione con le funzionalità predefinite.

Un gruppo di persone in posa per una foto in una stanza. Riconosco 4 persone: Jack, Kanbo, Alak e Trac. C'era anche del testo trovato nell'immagine. Si legge: AWS re: Invent

Casi di potenziale utilizzo

Generazione di testo alternativo per immagini web

Tutte le immagini su un sito Web devono avere un testo alternativo in modo che gli screen reader possano parlarle ai non vedenti. È anche utile per l'ottimizzazione dei motori di ricerca (SEO). La creazione di didascalie alternative può richiedere molto tempo poiché un copywriter ha il compito di fornirle all'interno di un documento di progettazione. L'API Describe For Me potrebbe generare automaticamente testo alternativo per le immagini. Potrebbe anche essere utilizzato come plug-in del browser per aggiungere automaticamente didascalie alle immagini mancanti di testo alternativo su qualsiasi sito Web.

Descrizione audio per video

La descrizione audio fornisce una traccia narrativa per i contenuti video per aiutare i non vedenti a seguire i film. Man mano che la didascalia delle immagini diventa più solida e accurata, potrebbe essere possibile un flusso di lavoro che prevede la creazione di una traccia audio basata sulle descrizioni delle parti chiave di una scena. Amazon Rekognition è già in grado di rilevare cambi di scena, loghi, sequenze di crediti e rilevamento di celebrità. Una futura versione di describe consentirebbe di automatizzare questa funzione chiave per film e video.

Conclusione

In questo post, abbiamo discusso su come utilizzare i servizi AWS, inclusi servizi AI e serverless, per aiutare i non vedenti a vedere le immagini. Puoi saperne di più sul progetto Descrivi per me e usarlo visitando descriptionforme.com. Ulteriori informazioni sulle caratteristiche uniche di Amazon Sage Maker, Riconoscimento Amazon e la Partnership AWS con Hugging Face.

Dichiarazione di non responsabilità del modello ML di terze parti per la guida

Questa guida è solo a scopo informativo. Dovresti comunque eseguire la tua valutazione indipendente e adottare misure per assicurarti di rispettare le tue specifiche pratiche e standard di controllo della qualità e le norme, le leggi, i regolamenti, le licenze e i termini di utilizzo locali che si applicano a te, ai tuoi contenuti e il modello di Machine Learning di terze parti a cui si fa riferimento in questa guida. AWS non ha alcun controllo o autorità sul modello di Machine Learning di terze parti a cui si fa riferimento in questa guida e non rilascia alcuna dichiarazione o garanzia che il modello di Machine Learning di terze parti sia sicuro, privo di virus, operativo o compatibile con l'ambiente di produzione e standard. AWS non rilascia alcuna dichiarazione o garanzia che qualsiasi informazione contenuta in questa guida si tradurrà in un particolare risultato o risultato.

Informazioni sugli autori

Jack Marchetti è un architetto di soluzioni senior presso AWS focalizzato sull'aiutare i clienti a modernizzare e implementare architetture serverless basate su eventi. Jack è legalmente cieco e risiede a Chicago con la moglie Erin e il gatto Minou. È anche sceneggiatore e regista con un focus principale sui film natalizi e sull'orrore. Guarda la filmografia di Jack da lui Pagina di IMDb.

Jack Marchetti è un architetto di soluzioni senior presso AWS focalizzato sull'aiutare i clienti a modernizzare e implementare architetture serverless basate su eventi. Jack è legalmente cieco e risiede a Chicago con la moglie Erin e il gatto Minou. È anche sceneggiatore e regista con un focus principale sui film natalizi e sull'orrore. Guarda la filmografia di Jack da lui Pagina di IMDb.

Alak Eswaradass è Senior Solutions Architect presso AWS con sede a Chicago, Illinois. È appassionata di aiutare i clienti a progettare architetture cloud utilizzando i servizi AWS per risolvere le sfide aziendali. Alak è entusiasta di utilizzare SageMaker per risolvere una varietà di casi d'uso di ML per i clienti AWS. Quando non lavora, ad Alak piace passare il tempo con le sue figlie ed esplorare la vita all'aria aperta con i suoi cani.

Alak Eswaradass è Senior Solutions Architect presso AWS con sede a Chicago, Illinois. È appassionata di aiutare i clienti a progettare architetture cloud utilizzando i servizi AWS per risolvere le sfide aziendali. Alak è entusiasta di utilizzare SageMaker per risolvere una varietà di casi d'uso di ML per i clienti AWS. Quando non lavora, ad Alak piace passare il tempo con le sue figlie ed esplorare la vita all'aria aperta con i suoi cani.

Kandyce Bohannon è un Senior Solutions Architect con sede a Minneapolis, MN. In questo ruolo, Kandyce lavora come consulente tecnico per i clienti AWS mentre modernizzano le strategie tecnologiche in particolare relative ai dati e DevOps per implementare le migliori pratiche in AWS. Inoltre, Kandyce è appassionata di fare da mentore alle future generazioni di tecnologi e di mostrare le donne nella tecnologia attraverso il programma AWS She Builds Tech Skills.

Kandyce Bohannon è un Senior Solutions Architect con sede a Minneapolis, MN. In questo ruolo, Kandyce lavora come consulente tecnico per i clienti AWS mentre modernizzano le strategie tecnologiche in particolare relative ai dati e DevOps per implementare le migliori pratiche in AWS. Inoltre, Kandyce è appassionata di fare da mentore alle future generazioni di tecnologi e di mostrare le donne nella tecnologia attraverso il programma AWS She Builds Tech Skills.

Trac Do è un architetto di soluzioni presso AWS. Nel suo ruolo, Trac lavora con i clienti aziendali per supportare le loro migrazioni al cloud e le iniziative di modernizzazione delle applicazioni. È appassionato di apprendere le sfide dei clienti e risolverle con soluzioni robuste e scalabili utilizzando i servizi AWS. Trac attualmente vive a Chicago con sua moglie e 3 figli. È un grande appassionato di aviazione e sta completando la sua licenza di pilota privato.

Trac Do è un architetto di soluzioni presso AWS. Nel suo ruolo, Trac lavora con i clienti aziendali per supportare le loro migrazioni al cloud e le iniziative di modernizzazione delle applicazioni. È appassionato di apprendere le sfide dei clienti e risolverle con soluzioni robuste e scalabili utilizzando i servizi AWS. Trac attualmente vive a Chicago con sua moglie e 3 figli. È un grande appassionato di aviazione e sta completando la sua licenza di pilota privato.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Acquista e vendi azioni in società PRE-IPO con PREIPO®. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/introducing-an-image-to-speech-generative-ai-application-using-amazon-sagemaker-and-hugging-face/

- :ha

- :È

- :non

- $ SU

- 100

- 2022

- 7

- a

- WRI

- sopra

- accesso

- precisione

- preciso

- il raggiungimento

- aggiungere

- Inoltre

- consulente

- Dopo shavasana, sedersi in silenzio; saluti;

- AI

- Servizi di intelligenza artificiale

- AI / ML

- aiuto

- Tutti

- consentire

- consente

- lungo

- già

- anche

- alternativa

- Amazon

- Gateway API Amazon

- Amazon Comprehend

- Rekognition di Amazon

- Amazon Sage Maker

- Testo Amazon

- Amazon Web Services

- an

- analisi

- ed

- in qualsiasi

- api

- App

- Applicazioni

- APPLICA

- architettura

- SONO

- artificiale

- intelligenza artificiale

- AS

- valutazione

- At

- Audio

- Aurora

- autorità

- gli autori

- automaticamente

- Automatizzare

- disponibile

- aviazione

- AWS

- Funzioni AWS Step

- precedente

- BACKEND

- basato

- BE

- perché

- diventa

- stato

- dietro

- sotto

- vantaggi

- MIGLIORE

- best practice

- Big

- Nero

- Blog

- Scatola

- del browser

- costruire

- costruisce

- affari

- ma

- by

- detto

- chiamata

- Bandi

- stanza

- Materiale

- funzionalità

- didascalie

- casi

- CAT

- Celebrità

- sfide

- Modifiche

- dai un'occhiata

- Controlli

- Chicago

- ha scelto

- Natale

- pulire campo

- Cloud

- Venire

- viene

- comunità

- confrontare

- compatibile

- completando

- comprendere

- Calcolare

- Convegno

- Considerazioni

- Consistente

- contenuto

- di controllo

- controlli

- potuto

- creare

- crea

- Creazione

- creazione

- credito

- CSS

- Attualmente

- Clienti

- dati

- scienza dei dati

- Date

- giorno

- dimostrato

- schierare

- schierato

- descrivere

- descritta

- descrizione

- Design

- dettagliati

- rilevato

- rivelazione

- dispositivo

- dispositivi

- Direttore

- discusso

- do

- documento

- documenti

- effettua

- Cane

- fare

- in maniera efficace

- efficiente

- fine

- endpoint

- motore

- garantire

- Impresa

- appassionato

- entusiasta

- Ambiente

- errore

- errori

- particolarmente

- Anche

- eccellente

- scadenza

- Esplorare

- esprimere

- Occhi

- Faccia

- facce

- Facciale

- riconoscimento facciale

- fiera

- più veloce

- caratteristica

- Caratteristiche

- Compila il

- riempire

- pieno

- Nome

- Pavimento

- Focus

- concentrato

- seguire

- i seguenti

- Nel

- formato

- forme

- essere trovato

- Contesto

- da

- anteriore

- function

- funzionalità

- funzioni

- futuro

- porta

- generare

- generato

- genera

- ELETTRICA

- generazioni

- generativo

- AI generativa

- buono

- borse di studio

- Green

- Gruppo

- garanzie

- guida

- guida

- Maniglie

- Manovrabilità

- Avere

- he

- sentire

- Aiuto

- aiutare

- aiuta

- suo

- Alta

- il suo

- orrore

- ospitato

- Casa

- Come

- Tutorial

- HTML

- HTTPS

- Hub

- i

- if

- Illinois

- Immagine

- immagini

- realizzare

- in

- inclusi

- Compreso

- studente indipendente

- informazioni

- Informativo

- iniziative

- ingresso

- integrare

- integrato

- Intelligence

- ai miglioramenti

- l'introduzione di

- invoca

- coinvolgendo

- IT

- martinetto

- JavaScript

- jpg

- Le

- Lingua

- Le Lingue

- grandi

- LAS

- Las Vegas

- Legislazione

- IMPARARE

- apprendimento

- Leva

- Licenza

- licenze

- Lives

- locale

- località

- Lunghi

- SEMBRA

- spento

- amato

- macchina

- machine learning

- make

- molti

- analisi

- mentoring

- mancante

- ML

- Mobile

- dispositivo mobile

- dispositivi mobili

- modello

- modelli

- modernizzare

- Scopri di più

- più efficiente

- bocca

- Film

- multiplo

- Nome

- GENERAZIONE

- notte

- no

- naso

- taccuino

- numero

- of

- ufficiale

- on

- una volta

- ONE

- quelli

- esclusivamente

- aprire

- open source

- operazione

- operativa

- ottimizzazione

- or

- Altri

- nostro

- su

- Risultato

- all'aperto

- produzione

- ancora

- panoramica

- proprio

- Parallel

- particolare

- Partnership

- Ricambi

- partito

- appassionato

- Persone

- Eseguire

- performance

- periodo

- persona

- telefono

- immagine

- Immagini

- pilota

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- gioco

- gioca

- per favore

- plug-in

- pool

- porzione

- possibile

- Post

- pratiche

- precedente

- primario

- un bagno

- processi

- lavorazione

- Produzione

- Programma

- progetto

- fornire

- fornisce

- fornitura

- fini

- qualità

- RE

- Leggi

- lettori

- pronto

- tempo reale

- ragione

- riconoscimento

- riconoscere

- Rosso

- Ridotto

- normativa

- relazionato

- deposito

- necessario

- colpevole

- robusto

- Ruolo

- Prenotazione sale

- norme

- running

- sagemaker

- Risparmio

- scalabile

- scena

- Scienze

- allo

- lettori di schermo

- sdk

- Cerca

- motore di ricerca

- Secondo

- Sezione

- sicuro

- vedere

- invio

- anziano

- inviato

- SEO

- serverless

- Servizi

- Condividi

- lei

- dovrebbero

- vetrina

- ha mostrato

- mostrato

- Spettacoli

- simile

- Un'espansione

- semplicemente

- site

- abilità

- Cielo

- rallentare

- inferiore

- So

- soluzione

- Soluzioni

- RISOLVERE

- Soluzione

- alcuni

- parlare

- specifico

- discorso

- Spendere

- standard

- Regione / Stato

- step

- Passi

- Ancora

- memorizzati

- negozi

- strategie

- tale

- adatto

- supporto

- supporti

- soriano

- tavolo

- Fai

- presa

- Task

- task

- Tech

- Consulenza

- tecnologi

- Tecnologia

- temporaneo

- condizioni

- Text-to-Speech

- di

- che

- Il

- Lo Stato

- loro

- Li

- poi

- Là.

- di

- Terza

- di parti terze standard

- questo

- tre

- Attraverso

- tempo

- a

- verso

- pista

- Treni

- allenato

- trasferimento

- vero

- capire

- e una comprensione reciproca

- unificato

- unico

- su

- URL

- uso

- utilizzato

- Utente

- utenti

- utilizzando

- utilizzati

- Utilizzando

- varietà

- vario

- VEGAS

- versione

- Video

- Video

- Visualizza

- Voce

- Prima

- Modo..

- we

- sito web

- servizi web

- Sito web

- WELL

- Che

- quando

- quale

- while

- bianca

- perché

- moglie

- volere

- con

- entro

- senza

- donna

- Donna

- donne nella tecnologia

- lavoro

- lavori

- sarebbe

- Tu

- Trasferimento da aeroporto a Sharm

- te stesso

- zefiro