Introduzione

Che film descrivono questi emoji?

Quella richiesta era una delle 204 attività scelte l'anno scorso per testare la capacità di vari modelli di linguaggio di grandi dimensioni (LLM), i motori computazionali dietro i chatbot AI come ChatGPT. I più semplici LLM hanno prodotto risposte surreali. "Il film è un film su un uomo che è un uomo che è un uomo", ha iniziato uno. I modelli di media complessità si sono avvicinati, indovinando Il film Emoji. Ma il modello più complesso lo ha inchiodato in una sola ipotesi: Alla ricerca di Nemo.

"Nonostante provi ad aspettarmi sorprese, sono sorpreso dalle cose che questi modelli possono fare", ha detto Ethan Dyer, un informatico di Google Research che ha contribuito a organizzare il test. È sorprendente perché questi modelli presumibilmente hanno una direttiva: accettare una stringa di testo come input e prevedere cosa verrà dopo, ancora e ancora, basandosi esclusivamente su statistiche. Gli informatici prevedevano che il ridimensionamento avrebbe migliorato le prestazioni su attività note, ma non si aspettavano che i modelli ne gestissero improvvisamente così tante nuove e imprevedibili.

Recenti indagini come quella su cui ha lavorato Dyer hanno rivelato che i LLM possono produrre centinaia di abilità "emergenti" - compiti che i grandi modelli possono completare che i modelli più piccoli non possono, molti dei quali sembrano avere poco a che fare con l'analisi del testo. Si va dalla moltiplicazione alla generazione di codice eseguibile per computer fino, apparentemente, alla decodifica di film basati su emoji. Nuove analisi suggeriscono che per alcune attività e alcuni modelli esiste una soglia di complessità oltre la quale la funzionalità del modello sale alle stelle. (Suggeriscono anche un rovescio oscuro: man mano che aumentano di complessità, alcuni modelli rivelano nuovi pregiudizi e imprecisioni nelle loro risposte.)

"Che i modelli linguistici possano fare questo genere di cose non è mai stato discusso in nessuna letteratura di cui sono a conoscenza", ha detto Rishi Bommasani, un informatico della Stanford University. L'anno scorso, ha aiutato a compilare una lista di dozzine di comportamenti emergenti, inclusi diversi identificati nel progetto di Dyer. Quella lista continua a crescere.

Ora, i ricercatori stanno correndo non solo per identificare ulteriori abilità emergenti, ma anche per capire perché e come si verificano, in sostanza, per cercare di prevedere l'imprevedibilità. Comprendere l'emergenza potrebbe rivelare risposte a domande profonde sull'intelligenza artificiale e sull'apprendimento automatico in generale, ad esempio se i modelli complessi stanno davvero facendo qualcosa di nuovo o stanno semplicemente diventando davvero bravi nelle statistiche. Potrebbe anche aiutare i ricercatori a sfruttare i potenziali benefici e ridurre i rischi emergenti.

"Non sappiamo come dire in quale tipo di applicazione si verificherà la capacità di danno, in modo regolare o imprevedibile", ha affermato Profondo Ganguli, un informatico della startup AI Anthropic.

L'emergere dell'emergere

Biologi, fisici, ecologi e altri scienziati usano il termine "emergente" per descrivere comportamenti collettivi auto-organizzanti che compaiono quando un vasto insieme di cose agisce come una cosa sola. Combinazioni di atomi senza vita danno origine a cellule viventi; le molecole d'acqua creano onde; mormorii di storni piombano nel cielo in schemi mutevoli ma identificabili; le cellule fanno muovere i muscoli e battere il cuore. Fondamentalmente, le abilità emergenti si manifestano in sistemi che coinvolgono molte singole parti. Ma solo di recente i ricercatori sono stati in grado di documentare queste capacità negli LLM poiché quei modelli sono cresciuti fino a raggiungere dimensioni enormi.

Introduzione

I modelli linguistici esistono da decenni. Fino a circa cinque anni fa, i più potenti erano basati su quella che viene chiamata una rete neurale ricorrente. Questi essenzialmente prendono una stringa di testo e prevedono quale sarà la parola successiva. Ciò che rende un modello "ricorrente" è che apprende dal proprio output: le sue previsioni alimentano la rete per migliorare le prestazioni future.

Nel 2017, i ricercatori di Google Brain hanno introdotto un nuovo tipo di architettura chiamata a trasformatore. Mentre una rete ricorrente analizza una frase parola per parola, il trasformatore elabora tutte le parole contemporaneamente. Ciò significa che i trasformatori possono elaborare grandi quantità di testo in parallelo.

I trasformatori hanno consentito un rapido aumento della complessità dei modelli linguistici aumentando il numero di parametri nel modello, oltre ad altri fattori. I parametri possono essere pensati come connessioni tra parole e i modelli migliorano regolando queste connessioni mentre si muovono nel testo durante l'addestramento. Maggiore è il numero di parametri in un modello, più accuratamente può effettuare connessioni e più si avvicina a imitare passabilmente il linguaggio umano. Come previsto, un 2020 . dei ricercatori di OpenAI ha scoperto che i modelli migliorano in termini di accuratezza e capacità man mano che crescono.

Ma il debutto degli LLM ha portato anche qualcosa di veramente inaspettato. Un sacco di cose. Con l'avvento di modelli come GPT-3, che ha 175 miliardi di parametri, o PaLM di Google, che può essere scalato fino a 540 miliardi, gli utenti hanno iniziato a descrivere comportamenti sempre più emergenti. Addirittura un ingegnere di DeepMind segnalati riuscire a convincere ChatGPT che si trattava di un terminale Linux e fargli eseguire un semplice codice matematico per calcolare i primi 10 numeri primi. Sorprendentemente, potrebbe completare l'attività più velocemente dello stesso codice in esecuzione su una vera macchina Linux.

Come per il compito emoji del film, i ricercatori non avevano motivo di pensare che un modello linguistico costruito per prevedere il testo avrebbe imitato in modo convincente un terminale di computer. Molti di questi comportamenti emergenti illustrano l'apprendimento “zero-shot” o “pochi-shot”, che descrive la capacità di un LLM di risolvere problemi che non ha mai – o raramente – visto prima. Questo è stato un obiettivo di lunga data nella ricerca sull'intelligenza artificiale, ha affermato Ganguli. Dimostrare che GPT-3 potrebbe risolvere i problemi senza alcun dato di addestramento esplicito in un'impostazione zero-shot, ha detto, "mi ha portato ad abbandonare quello che stavo facendo e ad essere più coinvolto".

Non era solo. Una serie di ricercatori, rilevando i primi indizi che i LLM potrebbero andare oltre i vincoli dei loro dati di addestramento, si stanno sforzando di comprendere meglio che aspetto abbia l'emergenza e come avvenga. Il primo passo è stato quello di documentarlo accuratamente.

Introduzione

Oltre l'imitazione

Nel 2020, Dyer e altri di Google Research hanno previsto che gli LLM avrebbero avuto effetti trasformativi, ma quali sarebbero stati questi effetti è rimasta una questione aperta. Quindi hanno chiesto alla comunità di ricerca di fornire esempi di compiti difficili e diversificati per tracciare i limiti esterni di ciò che un LLM potrebbe fare. Questo sforzo è stato chiamato il progetto Beyond the Imitation Game Benchmark (BIG-bench), rifacendosi al nome del "gioco di imitazione" di Alan Turing, un test per verificare se un computer potesse rispondere alle domande in modo convincentemente umano. (Questo sarebbe poi diventato noto come il test di Turing.) Il gruppo era particolarmente interessato agli esempi in cui i LLM hanno improvvisamente raggiunto nuove abilità che prima erano completamente assenti.

"Il modo in cui comprendiamo queste transizioni nette è una grande domanda di ricerca", ha detto Dyer.

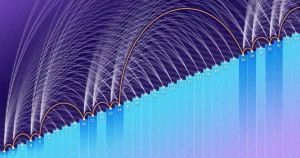

Come ci si aspetterebbe, in alcune attività le prestazioni di un modello sono migliorate in modo fluido e prevedibile con l'aumentare della complessità. E su altre attività, l'aumento del numero di parametri non ha prodotto alcun miglioramento. Ma per circa il 5% delle attività, i ricercatori hanno trovato ciò che hanno chiamato "scoperte": salti rapidi e drammatici delle prestazioni a una certa soglia. Tale soglia variava in base all'attività e al modello.

Ad esempio, i modelli con relativamente pochi parametri - solo pochi milioni - non potevano completare con successo problemi di addizione a tre cifre o moltiplicazione a due cifre, ma per decine di miliardi di parametri, la precisione aumentava in alcuni modelli. Salti simili si sono verificati per altri compiti, tra cui la decodifica dell'alfabeto fonetico internazionale, la decodifica delle lettere di una parola, l'identificazione di contenuti offensivi nei paragrafi di Hinglish (una combinazione di hindi e inglese) e la generazione di un equivalente inglese simile dei proverbi kiswahili.

Introduzione

Ma i ricercatori si sono presto resi conto che la complessità di un modello non era l'unico fattore trainante. Alcune abilità inaspettate potrebbero essere ricavate da modelli più piccoli con meno parametri - o addestrate su set di dati più piccoli - se i dati fossero di qualità sufficientemente elevata. Inoltre, il modo in cui è stata formulata una query ha influenzato l'accuratezza della risposta del modello. Ad esempio, quando Dyer e i suoi colleghi hanno posto il compito delle emoji del film utilizzando un formato a scelta multipla, il miglioramento della precisione è stato meno di un salto improvviso e più di un aumento graduale con una maggiore complessità. E l'anno scorso, in a documento presentato al NeurIPS, l'incontro di punta del settore, i ricercatori di Google Brain hanno mostrato come un modello spinto a spiegare se stesso (una capacità chiamata ragionamento a catena di pensieri) potrebbe risolvere correttamente un problema di parole matematiche, mentre lo stesso modello senza quel suggerimento non potrebbe farlo.

YiTai, uno scienziato di Google Brain che ha lavorato all'indagine sistematica delle scoperte, indica un recente lavoro che suggerisce che il suggerimento della catena di pensiero cambia le curve di scala e quindi il punto in cui si verifica l'emergenza. Nel loro documento NeurIPS, i ricercatori di Google hanno dimostrato che l'utilizzo di suggerimenti della catena di pensiero potrebbe suscitare comportamenti emergenti non identificati nello studio BIG-bench. Tali suggerimenti, che chiedono al modello di spiegare il suo ragionamento, possono aiutare i ricercatori a iniziare a indagare sul motivo per cui si verifica l'emergenza.

Recenti scoperte come queste suggeriscono almeno due possibilità per cui si verifica l'emergenza, ha detto Ellie Pavlick, un informatico della Brown University che studia i modelli computazionali del linguaggio. Uno è che, come suggerito dai confronti con i sistemi biologici, i modelli più grandi acquisiscono davvero nuove abilità spontaneamente. "Può darsi benissimo che il modello abbia imparato qualcosa di fondamentalmente nuovo e diverso che non aveva in una taglia più piccola", ha detto. "Questo è quello che tutti speriamo sia il caso, che ci sia un cambiamento fondamentale che si verifica quando i modelli vengono ingranditi".

L'altra possibilità, meno sensazionale, ha affermato, è che ciò che sembra emergere possa invece essere il culmine di un processo interno, guidato dalle statistiche, che funziona attraverso un ragionamento di tipo catena di pensiero. I grandi LLM potrebbero semplicemente apprendere euristiche che sono fuori portata per coloro che hanno meno parametri o dati di qualità inferiore.

Ma, ha detto, scoprire quale di queste spiegazioni è più probabile dipende da una migliore comprensione di come funzionano gli LLM. "Dal momento che non sappiamo come funzionano sotto il cofano, non possiamo dire quale di queste cose stia accadendo".

Poteri imprevedibili e trabocchetti

C'è un ovvio problema nel chiedere a questi modelli di spiegarsi: sono notoriamente bugiardi. “Facciamo sempre più affidamento su questi modelli per svolgere il lavoro di base”, ha affermato Ganguli, “ma non mi fido solo di questi. Controllo il loro lavoro. Come uno dei tanti esempi divertenti, a febbraio Google ha introdotto il suo chatbot AI, Bard. Il post sul blog che annuncia il nuovo strumento mostra Bard commettendo un errore di fatto.

L'emergenza porta all'imprevedibilità e l'imprevedibilità - che sembra aumentare con il ridimensionamento - rende difficile per i ricercatori anticipare le conseguenze di un uso diffuso.

"È difficile sapere in anticipo come verranno utilizzati o distribuiti questi modelli", ha affermato Ganguli. "E per studiare i fenomeni emergenti, devi avere un caso in mente, e non saprai fino a quando non studi l'influenza della scala quali capacità o limitazioni potrebbero sorgere."

In un analisi dei LLM pubblicato lo scorso giugno, i ricercatori di Anthropic hanno esaminato se i modelli avrebbero mostrato determinati tipi di pregiudizi razziali o sociali, non diversamente quelli precedentemente segnalati in algoritmi non basati su LLM utilizzati per prevedere quali ex criminali potrebbero commettere un altro crimine. Quello studio è stato ispirato da un apparente paradosso legato direttamente all'emergenza: man mano che i modelli migliorano le loro prestazioni durante il ridimensionamento, possono anche aumentare la probabilità di fenomeni imprevedibili, compresi quelli che potrebbero potenzialmente portare a pregiudizi o danni.

"Alcuni comportamenti dannosi si presentano improvvisamente in alcuni modelli", ha detto Ganguli. Indica una recente analisi di LLM, noto come benchmark BBQ, che ha dimostrato che il pregiudizio sociale emerge con un numero enorme di parametri. "I modelli più grandi diventano improvvisamente più distorti". L'incapacità di affrontare tale rischio, ha affermato, potrebbe mettere a repentaglio i soggetti di questi modelli.

Ma offre un contrappunto: quando i ricercatori hanno semplicemente detto al modello di non fare affidamento su stereotipi o pregiudizi sociali - letteralmente digitando quelle istruzioni - il modello era meno distorto nelle sue previsioni e risposte. Ciò suggerisce che alcune proprietà emergenti potrebbero anche essere utilizzate per ridurre i pregiudizi. In un giornale rilasciato a febbraio, il team di Anthropic ha riferito di una nuova modalità di "autocorrezione morale", in cui l'utente richiede al programma di essere utile, onesto e innocuo.

L'emergenza, ha detto Ganguli, rivela sia un potenziale sorprendente che un rischio imprevedibile. Le applicazioni di questi grandi LLM stanno già proliferando, quindi una migliore comprensione di tale interazione aiuterà a sfruttare la diversità delle capacità dei modelli linguistici.

"Stiamo studiando come le persone utilizzano effettivamente questi sistemi", ha detto Ganguli. Ma anche quegli utenti stanno armeggiando, costantemente. "Passiamo molto tempo a chiacchierare con i nostri modelli", ha detto, "ed è proprio qui che inizi ad avere una buona intuizione sulla fiducia, o sulla sua mancanza".

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.quantamagazine.org/the-unpredictable-abilities-emerging-from-large-ai-models-20230316/

- :È

- ][P

- $ SU

- 10

- 2017

- 2020

- a

- abilità

- capacità

- capace

- WRI

- improvvisamente

- assente

- Accetta

- precisione

- con precisione

- ACM

- atti

- effettivamente

- aggiunta

- aggiuntivo

- indirizzo

- avanzare

- Avvento

- AI

- AI chatbot

- Algoritmi

- Tutti

- da solo

- Alfabeto

- già

- Analisi

- analisi

- l'analisi

- ed

- annunciando

- Un altro

- risposte

- anticipare

- Anticipato

- apparente

- apparire

- Applicazioni

- applicazioni

- architettura

- SONO

- in giro

- artificiale

- intelligenza artificiale

- AS

- At

- precedente

- basato

- basic

- BE

- perché

- diventare

- prima

- ha iniziato

- iniziare

- dietro

- essendo

- Segno di riferimento

- vantaggi

- Meglio

- fra

- Al di là di

- pregiudizio

- Big

- Miliardo

- miliardi

- Blog

- Incremento

- Cervello

- innovazioni

- portato

- costruito

- by

- detto

- Materiale

- funzionalità

- Ultra-Grande

- Custodie

- Celle

- certo

- Modifiche

- cambiando

- Grafico

- chatbot

- chatbots

- ChatGPT

- chat

- dai un'occhiata

- scelto

- più vicino

- codice

- colleghi

- collezione

- Collective

- combinazione

- combinazioni

- Venire

- commettere

- comunità

- completamento di una

- completamente

- complesso

- complessità

- Calcolare

- computer

- Connessioni

- Conseguenze

- costantemente

- vincoli

- contenuto

- continua

- convincere

- potuto

- contrappunto

- creare

- crimine

- criminali

- Scuro

- dati

- set di dati

- debutto

- decenni

- Decodifica

- deep

- DeepMind

- schierato

- descrivere

- DID

- diverso

- difficile

- direttamente

- discusso

- paesaggio differenziato

- Diversità

- documento

- fare

- Dont

- decine

- drammaticamente

- guida

- Cadere

- durante

- effetti

- sforzo

- o

- emersione

- emerge

- emergenti del mondo

- abilitato

- ingegnere

- Motori

- Inglese

- enorme

- Equivalente

- particolarmente

- essenza

- essenzialmente

- Anche

- esempio

- Esempi

- attenderti

- previsto

- Spiegare

- Fattori

- Fallimento

- più veloce

- Febbraio

- pochi

- figura

- ricerca

- finire

- Nome

- nave ammiraglia

- Capovolgere

- Nel

- formato

- Ex

- essere trovato

- da

- funzionalità

- fondamentale

- fondamentalmente

- futuro

- Guadagno

- gioco

- Generale

- la generazione di

- ottenere

- ottenere

- Dare

- scopo

- andando

- buono

- graduale

- afferrala

- grande

- Gruppo

- cresciuto

- maniglia

- Happening

- accade

- Hard

- dannoso

- cintura da arrampicata

- Avere

- Aiuto

- aiutato

- utile

- Alta

- suggerimenti

- cappuccio

- sperando

- Come

- Tutorial

- HTTPS

- umano

- centinaia

- i

- identificato

- identificare

- identificazione

- competenze

- migliorata

- miglioramento

- in

- Compreso

- Aumento

- è aumentato

- crescente

- sempre più

- individuale

- influenza

- influenzato

- ingresso

- fonte di ispirazione

- invece

- istruzioni

- Intelligence

- interessato

- interno

- Internazionale

- introdotto

- indagare

- indagine

- Indagini

- coinvolgere

- coinvolto

- IT

- SUO

- stessa

- Mettere a repentaglio

- saltare

- salti

- Genere

- Sapere

- conosciuto

- Dipingere

- Lingua

- grandi

- superiore, se assunto singolarmente.

- Cognome

- L'anno scorso

- portare

- Leads

- imparato

- apprendimento

- piace

- probabile

- limiti

- limiti

- linux

- Lista

- letteratura

- piccolo

- vita

- LLM

- guardò

- SEMBRA

- lotto

- macchina

- machine learning

- make

- FA

- uomo

- molti

- matematica

- matematico

- si intende

- incontro

- forza

- milione

- mente

- Moda

- modello

- modelli

- Scopri di più

- maggior parte

- cambiano

- film

- Film

- Nome

- Rete

- rete neurale

- New

- GENERAZIONE

- famigerato

- numero

- numeri

- ovvio

- si è verificato

- of

- offensivo

- Offerte

- on

- ONE

- aprire

- OpenAI

- Altro

- Altri

- produzione

- proprio

- palma

- Carta

- Paradosso

- Parallel

- parametri

- Ricambi

- modelli

- Persone

- performance

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- punti

- possibilità

- possibilità

- Post

- potenziale

- potenzialmente

- potente

- potenze

- predire

- previsto

- Previsioni

- presentata

- in precedenza

- premio

- Problema

- problemi

- processi

- i processi

- produrre

- Prodotto

- Programma

- progetto

- proprietà

- fornire

- puramente

- qualità

- Quantamagazine

- domanda

- Domande

- rapidamente

- pneumatici

- gamma

- veloce

- raggiungere

- di rose

- realizzato

- ragione

- recente

- recentemente

- ridurre

- relativamente

- rilasciato

- è rimasta

- Segnalati

- riparazioni

- ricercatori

- Rispondere

- risposta

- rivelare

- Rivelato

- Rivela

- Aumento

- Rischio

- rischi

- Correre

- running

- Suddetto

- stesso

- Scala

- scala

- Scienziato

- scienziati

- sembra

- condanna

- Set

- regolazione

- alcuni

- affilato

- spostamento

- mostrare attraverso le sue creazioni

- Spettacoli

- lato

- simile

- Un'espansione

- semplicemente

- Taglia

- Dimensioni

- Cielo

- sale alle stelle

- inferiore

- liscio

- So

- Social

- RISOLVERE

- alcuni

- qualcosa

- spendere

- Università di Stanford

- inizia a

- startup

- statistica

- step

- studi

- Studio

- Studiando

- Con successo

- tale

- improvviso

- suggerisce

- sorpreso

- sorprese

- sorprendente

- SISTEMI DI TRATTAMENTO

- Fai

- Task

- task

- team

- terminal

- test

- che

- Il

- loro

- si

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- cose

- a fondo

- pensiero

- soglia

- Attraverso

- Legato

- tempo

- a

- allenato

- Training

- trasformativa

- trasformatori

- transizioni

- Affidati ad

- Turing

- Tipi di

- per

- capire

- e una comprensione reciproca

- Inaspettato

- Università

- imprevedibile

- uso

- Utente

- utenti

- vario

- Water

- onde

- Modo..

- WebP

- WELL

- Che

- se

- quale

- while

- OMS

- molto diffuso

- volere

- con

- senza

- Word

- parole

- Lavora

- lavorato

- lavori

- sarebbe

- anno

- anni

- dare la precedenza

- Tu

- zefiro