Commento La definizione di Microsoft di cosa costituisce e cosa non costituisce un PC AI sta prendendo forma. Con l'ultima versione di Windows, una chiave Copilot dedicata e una NPU capace di almeno 40 trilioni di operazioni al secondo, sarai presto in grado di eseguire Microsoft Copilot localmente, più o meno, sul tuo computer.

di Redmond requisiti per il suo modello AI su Windows sono stati ufficializzati da Intel, una delle più forti sostenitrici della categoria PC AI, durante l'evento del colosso dei chip Vertice AI a Taipei questa settimana.

L'esecuzione di un modello linguistico di grandi dimensioni (LLM) a livello locale presenta alcuni vantaggi intrinseci. Gli utenti finali dovrebbero avere una latenza inferiore e quindi tempi di risposta migliori, poiché le query non devono essere inviate da e verso un data center remoto, oltre a una maggiore privacy, in teoria. Per Microsoft, nel frattempo, spostare una parte maggiore del carico di lavoro dell’intelligenza artificiale sui dispositivi dei clienti libera le proprie risorse per altre attività, come aiutare ad addestrare il prossimo modello OpenAI o offrirlo come API cloud.

Microsoft spera di eseguire il suo Copilot LLM interamente sulle NPU, o unità di elaborazione neurale, nei PC Windows AI delle persone, a giudicare da commenti a quanto pare realizzato dai dirigenti Intel al vertice. Possiamo immaginare il gigante x86 spingersi oltre per convincere tutti che il suo silicio è abbastanza potente da far funzionare le cose di Redmond a casa o in ufficio.

Sebbene l'idea di slegare Copilot dal cordone ombelicale di Azure possa essere attraente per alcuni, non tutti sembrano essere fan di Clippy incarnato e almeno una parte dell'elaborazione verrà quasi certamente eseguita nel cloud nel prossimo futuro.

I dirigenti di Intel lo hanno affermato: un hardware più veloce consentirà l'esecuzione locale di più "elementi" di Copilot. In altre parole, continuerai a fare affidamento su una connessione di rete per almeno alcune funzionalità e il resto sarà gestito dal PC AI.

Il motivo non dovrebbe sorprendere così tanto. Questi PC AI dispongono di risorse limitate e il modello che alimenta Copilot, il GPT-4 di OpenAI, è enorme. Non sappiamo esattamente quanto sia grande la versione utilizzata da Microsoft, ma stime collocare l'intero modello GPT-4 a circa 1.7 trilioni di parametri. Anche con la quantizzazione o con l'esecuzione del modello su INT4, sarebbero necessari circa 900 GB di memoria.

Come pensiamo che funzionerà

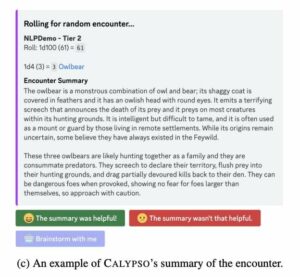

GPT-4 è un cosiddetto modello misto di esperti. In poche parole, ciò significa che è effettivamente assemblato da una serie di modelli pre-addestrati più piccoli e specializzati a cui vengono instradate le query. Disponendo di più modelli ottimizzati per la generazione di testo, il riepilogo, la creazione di codice e così via, è possibile migliorare le prestazioni di inferenza poiché non è necessario eseguire l'intero modello per completare un'attività.

L'uso da parte di Intel del termine "elementi" per descrivere l'esecuzione locale delle funzionalità di Copilot suggerisce che alcuni di questi esperti potrebbero essere sostituiti con modelli più piccoli e agili in grado di funzionare su hardware laptop. Come abbiamo esplorato in precedenza, l'hardware personale esistente è più che in grado di eseguire modelli di intelligenza artificiale più piccoli come Mistral o Meta.

Per coincidenza, Microsoft di recente pompato 15 milioni di euro (16.3 milioni di dollari) nel costruttore francese di minimodelli Mistral AI, con l'intenzione di rendere il suo lavoro disponibile ai clienti Azure. Con una dimensione di soli 7 miliardi di parametri, il Mistral-7B è certamente abbastanza piccolo da adattarsi comodamente alla memoria di un PC AI, richiedendo circa 4 GB di memoria quando si utilizza la quantizzazione a 4 bit.

E questo è per un modello di uso generale. In teoria, potresti cavartela con modelli ancora più piccoli ottimizzati per la generazione di codice sorgente che vengono caricati in memoria solo quando l'applicazione, ad esempio Visual Studio Code, viene avviata e viene rilevato un abbonamento Github Copilot attivo. Ricorda, Copilot è molto più di un semplice chatbot; è una suite di funzionalità AI che vengono integrate nel sistema operativo e nella libreria software di Microsoft.

Redmond non ha detto quanta memoria richieda le specifiche del suo PC AI, ma, secondo la nostra esperienza LLM locali, 16GB di veloce DDR5 dovrebbero essere sufficienti.

Qualunque sia il percorso intrapreso da Microsoft, la combinazione di modelli locali e remoti potrebbe portare a comportamenti interessanti. Non sappiamo ancora in quali circostanze questi modelli locali prenderanno il sopravvento, ma il vicepresidente aziendale di Microsoft per i dispositivi Windows, Pavan Davuluri, ha suggerito che il mix potrebbe essere dinamico.

"Vogliamo essere in grado di trasferire il carico tra il cloud e il client per fornire il meglio dell'elaborazione in entrambi i mondi", ha affermato sul palco durante l'Advancing AI di AMD evento in dicembre. "Riunisce i vantaggi del calcolo locale, aspetti come privacy, reattività e latenza migliorate con la potenza del cloud, modelli ad alte prestazioni, set di dati di grandi dimensioni e inferenza multipiattaforma."

Pertanto, possiamo vedere un paio di scenari in cui Microsoft potrebbe utilizzare l'intelligenza artificiale locale. Il primo è scaricare il lavoro dai server Microsoft e migliorare i tempi di risposta. Con il miglioramento dell'hardware, più funzionalità di Copilot potrebbero essere trasferite fuori dal cloud e sui dispositivi degli utenti.

La seconda sarebbe quella di averlo come ripiego in caso di interruzioni della rete. Puoi immaginare che il tuo PC AI diventi più stupido anziché fermarsi del tutto quando viene tagliato fuori dalla rete.

Vincoli hardware

Prima che tu sia troppo entusiasta dei PC AI dal cervello diviso che redigono manifesti off-grid, al momento non ci sono macchine là fuori che soddisfano i requisiti hardware, e non è per la mancanza di una chiave Copilot.

Il problema è che le NPU sono ancora relativamente nuove nel silicio x86 e ciò che esiste non è abbastanza potente. AMD è stata tra le prime ad aggiungere una NPU ai suoi processori mobili all'inizio del 2023 con il lancio del suo Ryzen 7040 chip di serie.

Quella formazione ha ricevuto un aumento di clock a dicembre durante l'evento Advancing AI della House of Zen. AMD ha portato le sue NPU anche sui desktop con il lancio dei suoi APU 8000G al CES nel gennaio di quest'anno.

Intel ha lanciato i suoi blocchi acceleratori AI dedicati con il lancio del suo Lago di meteore parti del microprocessore a fine dicembre. Questi chip Core Ultra sono dotati di una NPU derivata dall'unità di elaborazione visiva (VPU) Movidius di Intel, che Intel demoed eseguendo una varietà di carichi di lavoro durante il suo evento sull'innovazione dello scorso anno.

Sfortunatamente, i chip sono in grado di eseguire solo da 10 a 16 trilioni (tipicamente INT4) di operazioni al secondo, molto al di sotto delle specifiche 40 TOPS di Microsoft. Ciò significa che la maggior parte dei cosiddetti PC AI sul mercato non soddisferanno i requisiti, non senza appoggiarsi alla GPU per compensare la differenza.

Sia Intel che AMD hanno chip più capaci forniti rispettivamente con silicio Lunar Lake e Strix Point. Tuttavia, nel breve termine, sembra che Qualcomm avrà il mercato con le spalle al muro.

Notebook dotati di Snapdragon X Elite di Qualcomm processori mobili usciranno a metà del 2024 e presenteranno una NPU capace di 45 TOPS. In combinazione con una GPU Adreno capace di 4.6 teraFLOPS di prestazioni FP32, Qualcomm afferma che il componente sarà in grado di eseguire modelli AI fino a 13 miliardi di parametri interamente sul dispositivo e generare 30 token al secondo durante l'esecuzione di LLM più piccoli da 7 miliardi di parametri.

Con l'arrivo di PC con NPU a prestazioni più elevate e archivi di memoria più grandi e modelli piccoli che diventano più capaci, sospettiamo che Microsoft inizierà a scaricare più funzionalità sui dispositivi locali, una volta che l'hardware sarà in grado di gestirle. ®

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://go.theregister.com/feed/www.theregister.com/2024/03/31/microsoft_copilot_hardware/

- :ha

- :È

- :non

- $ SU

- 1

- 10

- 13

- 16

- 2023

- 30

- 40

- 7

- a

- capace

- WRI

- acceleratore

- operanti in

- attivo

- effettivamente

- aggiungere

- adeguato

- avanzando

- AI

- Modelli AI

- quasi

- anche

- AMD

- tra

- quantità

- an

- ed

- in qualsiasi

- api

- Applicazioni

- SONO

- in giro

- AS

- assemblato

- At

- attraente

- disponibile

- azzurro

- precedente

- BE

- iniziare

- comportamento

- sotto

- vantaggi

- MIGLIORE

- fra

- Big

- Miliardo

- Blocchi

- entrambi

- Porta

- portato

- costruttore

- ma

- by

- Bandi

- Materiale

- capace

- Custodie

- Categoria

- certamente

- Questi

- chatbot

- patata fritta

- Chips

- condizioni

- cliente

- Orologio

- Cloud

- CO

- codice

- combinazione

- combinato

- Venire

- arrivo

- completamento di una

- Calcolare

- informatica

- veloce

- costituire

- convincere

- Nucleo

- le spalle al muro

- Aziende

- potuto

- Coppia

- creazione

- Cross

- Attualmente

- cliente

- Clienti

- taglio

- dati

- set di dati

- Datacenter

- Dicembre

- dedicato

- definizione

- derivato

- descrivere

- tavolo

- rilevato

- dispositivo

- dispositivi

- differenza

- interruzioni

- effettua

- doesn

- don

- fatto

- dovuto

- durante

- dinamico

- Presto

- elementi

- elite

- enable

- fine

- finisce

- migliorata

- enorme

- abbastanza

- Intero

- interamente

- Anche

- Evento

- alla fine

- tutti

- di preciso

- eccitato

- execs

- dirigenti

- esistere

- esistente

- esperienza

- esperti

- Esplorazione

- Autunno

- fan

- lontano

- più veloce

- caratteristica

- Caratteristiche

- Nome

- in forma

- Nel

- prevedibile

- Francese

- da

- pieno

- funzionalità

- futuro

- Generale

- generare

- ELETTRICA

- ottenere

- ottenere

- gigante

- GitHub

- andando

- GPU

- Crescere

- maniglia

- Hardware

- Avere

- avendo

- he

- aiutare

- Alta

- superiore

- Casa

- spera

- Casa

- Come

- Tuttavia

- HTTPS

- idea

- immagine

- competenze

- migliorata

- migliora

- in

- In altre

- Innovazione

- Intel

- interessante

- ai miglioramenti

- intrinseco

- ISN

- problema

- IT

- SUO

- stessa

- Gennaio

- jpg

- ad appena

- Le

- Sapere

- Discografica

- Dipingere

- lago

- Lingua

- laptop

- grandi

- superiore, se assunto singolarmente.

- Cognome

- L'anno scorso

- In ritardo

- Latenza

- con i più recenti

- lanciare

- lanciato

- portare

- meno

- Biblioteca

- piace

- piace

- linea

- allineare

- ll

- LLM

- caricare

- locale

- a livello locale

- SEMBRA

- inferiore

- Lunare

- macchina

- macchine

- fatto

- make

- Rappresentanza

- Maggio..

- si intende

- Nel frattempo

- Soddisfare

- Memorie

- Meta

- Microsoft

- forza

- milione

- scelta

- Mobile

- modello

- modelli

- Scopri di più

- maggior parte

- molti

- multiplo

- Vicino

- quasi

- Bisogno

- rete

- Rete

- neurale

- New

- GENERAZIONE

- adesso

- numero

- guscio di noce

- of

- MENO

- offerta

- Office

- ufficiale

- on

- una volta

- ONE

- esclusivamente

- su

- OpenAI

- Operazioni

- ottimizzati

- or

- OS

- Altro

- nostro

- su

- ancora

- proprio

- parametri

- parte

- Ricambi

- PC

- PC

- Persone

- per

- performance

- cronologia

- piani

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- più

- punto

- energia

- potente

- Accensione

- in precedenza

- Privacy

- lavorazione

- processori

- fornire

- scopo

- spinto

- spingendo

- metti

- Qualcomm

- query

- piuttosto

- RE

- ragione

- ricevuto

- recentemente

- relativamente

- ricorda

- a distanza

- Requisiti

- Risorse

- rispettivamente

- risposta

- REST

- Arrotolato

- strada

- indirizzato

- Correre

- running

- s

- Suddetto

- dire

- dice

- Scenari

- Secondo

- vedere

- sembra

- inviato

- Serie

- Server

- Set

- Forma

- spostamento

- MUTEVOLE

- dovrebbero

- Silicio

- da

- Taglia

- piccole

- inferiore

- bocca di leone

- So

- Software

- alcuni

- presto

- Fonte

- codice sorgente

- specializzata

- sportivo

- Stage

- Ancora

- sosta

- negozi

- più forte

- studio

- sottoscrizione

- tale

- suggerisce

- suite

- Vertice

- sorpresa

- Fai

- presa

- Task

- task

- termine

- di

- che

- Il

- teoria

- Là.

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- cose

- think

- questo

- questa settimana

- quest'anno

- quelli

- volte

- a

- insieme

- Tokens

- pure

- Tops, Cardigan & Pullover

- Treni

- Trilione

- sintonizzato

- tipicamente

- Ultra

- per

- unità

- unità

- uso

- Utente

- utenti

- utilizzando

- varietà

- Ve

- versione

- visione

- visivo

- Prima

- we

- settimana

- sono stati

- Che

- quando

- quale

- perché

- volere

- finestre

- con

- senza

- Ha vinto

- parole

- Lavora

- Il mondo di

- sarebbe

- X

- anno

- ancora

- Tu

- Trasferimento da aeroporto a Sharm

- youtube

- zen

- zefiro