Amazon Sage Maker Studio fornisce una soluzione completamente gestita che consente ai data scientist di creare, addestrare e distribuire in modo interattivo modelli di machine learning (ML). Lavori notebook Amazon SageMaker consentire ai data scientist di eseguire i propri notebook su richiesta o in base a una pianificazione con pochi clic in SageMaker Studio. Con questo lancio, puoi eseguire i notebook a livello di codice come processi utilizzando le API fornite da Pipeline di Amazon SageMaker, la funzionalità di orchestrazione del flusso di lavoro ML di Amazon Sage Maker. Inoltre, puoi creare un flusso di lavoro ML in più fasi con più notebook dipendenti utilizzando queste API.

SageMaker Pipelines è uno strumento nativo di orchestrazione del flusso di lavoro per la creazione di pipeline ML che sfruttano l'integrazione diretta di SageMaker. Ogni pipeline SageMaker è composta da passi, che corrispondono a compiti individuali come l'elaborazione, la formazione o l'utilizzo dell'elaborazione dei dati Amazon EMR. I processi notebook SageMaker sono ora disponibili come tipo di passaggio integrato nelle pipeline SageMaker. È possibile utilizzare questo passaggio del processo notebook per eseguire facilmente i notebook come processi con solo poche righe di codice utilizzando il file SDK Python di Amazon SageMaker. Inoltre, è possibile unire più taccuini dipendenti insieme per creare un flusso di lavoro sotto forma di grafici aciclici diretti (DAG). È quindi possibile eseguire questi processi di notebook o DAG e gestirli e visualizzarli utilizzando SageMaker Studio.

I data scientist attualmente utilizzano SageMaker Studio per sviluppare in modo interattivo i propri notebook Jupyter e quindi utilizzano i processi notebook SageMaker per eseguire questi notebook come processi pianificati. Questi lavori possono essere eseguiti immediatamente o secondo una pianificazione temporale ricorrente senza la necessità che i dataworker eseguano il refactoring del codice come moduli Python. Alcuni casi d'uso comuni per eseguire questa operazione includono:

- Esecuzione di notebook di lunga durata in background

- Eseguire regolarmente l'inferenza del modello per generare report

- Passare dalla preparazione di piccoli set di dati campione all'utilizzo di big data su scala petabyte

- Riqualificazione e distribuzione dei modelli con una certa cadenza

- Pianificazione dei lavori per la qualità del modello o il monitoraggio della deriva dei dati

- Esplorare lo spazio dei parametri per modelli migliori

Sebbene questa funzionalità renda semplice per gli operatori dei dati automatizzare i notebook autonomi, i flussi di lavoro ML sono spesso costituiti da diversi notebook, ciascuno dei quali esegue un'attività specifica con dipendenze complesse. Ad esempio, un notebook che monitora la deriva dei dati del modello dovrebbe avere una fase preliminare che consenta l'estrazione, la trasformazione e il caricamento (ETL) e l'elaborazione di nuovi dati e una fase successiva di aggiornamento e addestramento del modello nel caso in cui si noti una deriva significativa . Inoltre, i data scientist potrebbero voler attivare l’intero flusso di lavoro secondo una pianificazione ricorrente per aggiornare il modello in base a nuovi dati. Per consentirti di automatizzare facilmente i tuoi notebook e creare flussi di lavoro così complessi, i processi notebook SageMaker sono ora disponibili come passaggio in SageMaker Pipelines. In questo post mostriamo come risolvere i seguenti casi d'uso con poche righe di codice:

- Esegui a livello di programmazione un notebook autonomo immediatamente o secondo una pianificazione ricorrente

- Crea flussi di lavoro in più fasi di notebook come DAG per scopi di integrazione continua e distribuzione continua (CI/CD) che possono essere gestiti tramite l'interfaccia utente di SageMaker Studio

Panoramica della soluzione

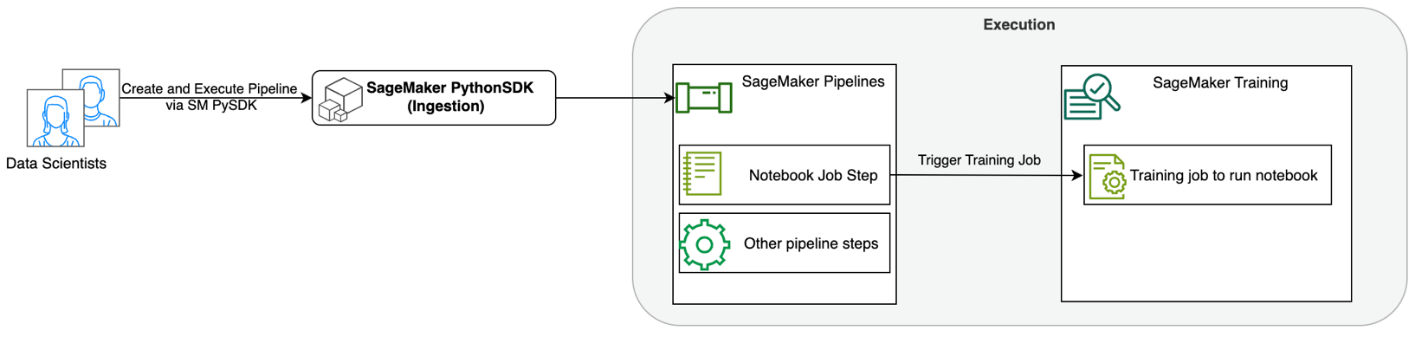

Il diagramma seguente illustra l'architettura della nostra soluzione. Puoi utilizzare SageMaker Python SDK per eseguire un singolo processo notebook o un flusso di lavoro. Questa funzionalità crea un processo di formazione SageMaker per eseguire il notebook.

Nelle sezioni seguenti, esaminiamo un caso d'uso di ML di esempio e mostriamo i passaggi per creare un flusso di lavoro di processi notebook, passando parametri tra diversi passaggi notebook, pianificando il flusso di lavoro e monitorandolo tramite SageMaker Studio.

Per il nostro problema ML in questo esempio, stiamo costruendo un modello di analisi del sentiment, che è un tipo di attività di classificazione del testo. Le applicazioni più comuni dell'analisi del sentiment includono il monitoraggio dei social media, la gestione dell'assistenza clienti e l'analisi del feedback dei clienti. Il set di dati utilizzato in questo esempio è il set di dati Stanford Sentiment Treebank (SST2), che consiste di recensioni di film insieme a un numero intero (0 o 1) che indica il sentimento positivo o negativo della recensione.

Quello che segue è un esempio di a data.csv file corrispondente al set di dati SST2 e mostra i valori nelle prime due colonne. Tieni presente che il file non dovrebbe avere alcuna intestazione.

| Colonna 1 | Colonna 2 |

| 0 | nascondere nuove secrezioni alle unità genitoriali |

| 0 | non contiene spirito, solo gag elaborate |

| 1 | che ama i suoi personaggi e comunica qualcosa di piuttosto bello sulla natura umana |

| 0 | rimane assolutamente soddisfatto di rimanere lo stesso per tutto il tempo |

| 0 | sui peggiori cliché sulla vendetta dei nerd che i cineasti potrebbero tirar fuori |

| 0 | è troppo tragico per meritare un trattamento così superficiale |

| 1 | dimostra che il regista di blockbuster hollywoodiani come Patriot Games può ancora realizzare un piccolo film personale con un forte impatto emotivo. |

In questo esempio di ML, dobbiamo eseguire diverse attività:

- Esegui l'ingegneria delle funzionalità per preparare questo set di dati in un formato che il nostro modello possa comprendere.

- Dopo la progettazione delle funzionalità, esegui un passaggio di formazione che utilizza Transformers.

- Configura l'inferenza batch con il modello ottimizzato per aiutare a prevedere il sentiment per le nuove recensioni in arrivo.

- Configurare una fase di monitoraggio dei dati in modo da poter monitorare regolarmente i nostri nuovi dati per eventuali variazioni di qualità che potrebbero richiedere una riqualificazione dei pesi del modello.

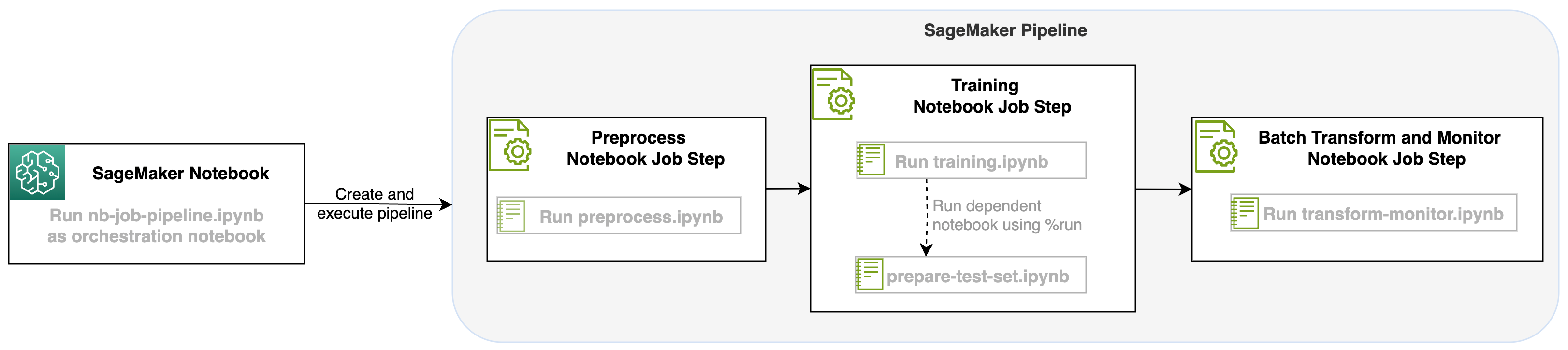

Con questo lancio di un lavoro notebook come passaggio nelle pipeline SageMaker, possiamo orchestrare questo flusso di lavoro, che consiste in tre passaggi distinti. Ogni fase del flusso di lavoro viene sviluppata in un notebook diverso, che viene poi convertito in fasi di lavoro del notebook indipendenti e collegate come una pipeline:

- Pre-elaborazione – Scarica il set di dati SST2 pubblico da Servizio di archiviazione semplice Amazon (Amazon S3) e creare un file CSV per il notebook nel passaggio 2 da eseguire. Il set di dati SST2 è un set di dati di classificazione del testo con due etichette (0 e 1) e una colonna di testo da classificare.

- Training – Prendi il file CSV sagomato ed esegui la messa a punto con BERT per la classificazione del testo utilizzando le librerie Transformers. Come parte di questo passaggio utilizziamo un notebook per la preparazione dei dati di test, che costituisce una dipendenza per il passaggio di perfezionamento e inferenza batch. Una volta completata l'ottimizzazione, questo notebook viene eseguito utilizzando Run Magic e prepara un set di dati di test per l'inferenza di esempio con il modello ottimizzato.

- Trasformare e monitorare – Eseguire l'inferenza batch e impostare la qualità dei dati con il monitoraggio del modello per ottenere un suggerimento sul set di dati di base.

Esegui i quaderni

Il codice di esempio per questa soluzione è disponibile su GitHub.

La creazione di una fase di lavoro del notebook SageMaker è simile alla creazione di altre fasi della pipeline SageMaker. In questo esempio di notebook utilizziamo SageMaker Python SDK per orchestrare il flusso di lavoro. Per creare un passaggio del notebook in SageMaker Pipelines, è possibile definire i seguenti parametri:

- Taccuino di input – Il nome del notebook che verrà orchestrato da questo passaggio del notebook. Qui puoi passare il percorso locale al notebook di input. Facoltativamente, se questo notebook ha altri notebook in esecuzione, puoi passarli nel file

AdditionalDependenciesparametro per la fase di lavoro del notebook. - URI dell'immagine – L'immagine Docker dietro la fase di lavoro del notebook. Possono trattarsi delle immagini predefinite fornite già da SageMaker o di un'immagine personalizzata che hai definito e a cui hai inviato il push Registro dei contenitori Amazon Elastic (Amazon ECR). Fare riferimento alla sezione Considerazioni alla fine di questo post per le immagini supportate.

- Nome del kernel – Il nome del kernel che stai utilizzando su SageMaker Studio. Questa specifica del kernel è registrata nell'immagine che hai fornito.

- Tipo di istanza (facoltativo) - L' Cloud di calcolo elastico di Amazon (Amazon EC2) dietro il processo notebook che hai definito e che verrà eseguito.

- Parametri (facoltativo) – I parametri che puoi passare saranno accessibili per il tuo notebook. Questi possono essere definiti in coppie chiave-valore. Inoltre, questi parametri possono essere modificati tra varie esecuzioni di processi notebook o esecuzioni di pipeline.

Il nostro esempio ha un totale di cinque taccuini:

- nb-job-pipeline.ipynb – Questo è il nostro taccuino principale in cui definiamo la nostra pipeline e il flusso di lavoro.

- preprocess.ipynb – Questo notebook è il primo passaggio nel nostro flusso di lavoro e contiene il codice che estrarrà il set di dati AWS pubblico e ne creerà un file CSV.

- training.ipynb – Questo notebook è il secondo passaggio del nostro flusso di lavoro e contiene il codice per prendere il CSV dal passaggio precedente e condurre formazione e perfezionamento locali. Questo passaggio ha anche una dipendenza da

prepare-test-set.ipynbnotebook per estrarre un set di dati di test per l'inferenza del campione con il modello ottimizzato. - preparare-test-set.ipynb – Questo notebook crea un set di dati di test che il nostro notebook di formazione utilizzerà nella seconda fase della pipeline e utilizzerà per l'inferenza del campione con il modello ottimizzato.

- trasforma-monitor.ipynb – Questo notebook è il terzo passaggio del nostro flusso di lavoro e prende il modello BERT di base ed esegue un processo di trasformazione batch SageMaker, configurando anche la qualità dei dati con il monitoraggio del modello.

Successivamente, esaminiamo il taccuino principale nb-job-pipeline.ipynb, che combina tutti i sub-notebook in una pipeline ed esegue il flusso di lavoro end-to-end. Tieni presente che sebbene l'esempio seguente esegua il notebook solo una volta, puoi anche pianificare la pipeline per eseguire il notebook ripetutamente. Fare riferimento a Documentazione di SageMaker per le istruzioni dettagliate.

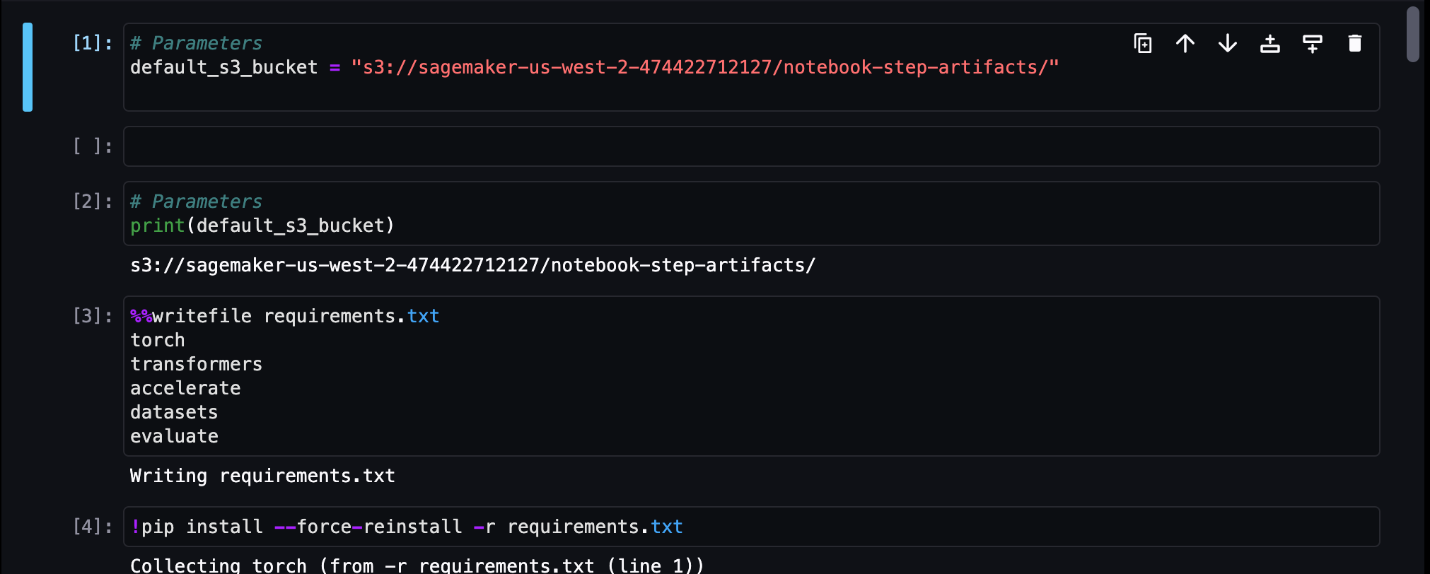

Per la prima fase del processo notebook, passiamo un parametro con un bucket S3 predefinito. Possiamo utilizzare questo bucket per scaricare tutti gli artefatti che vogliamo disponibili per gli altri passaggi della pipeline. Per il primo taccuino (preprocess.ipynb), eliminiamo il set di dati del treno SST2 pubblico AWS e ne creiamo un file CSV di addestramento che inviamo a questo bucket S3. Vedere il seguente codice:

Possiamo quindi convertire questo taccuino in un file NotebookJobStep con il seguente codice nel nostro taccuino principale:

Ora che abbiamo un file CSV di esempio, possiamo iniziare ad addestrare il nostro modello nel nostro taccuino di formazione. Il nostro notebook di addestramento accetta lo stesso parametro del bucket S3 ed estrae il set di dati di addestramento da quella posizione. Quindi eseguiamo la messa a punto utilizzando l'oggetto trainer Transformers con il seguente snippet di codice:

Dopo la messa a punto, vogliamo eseguire alcune inferenze batch per vedere come si comporta il modello. Questo viene fatto utilizzando un taccuino separato (prepare-test-set.ipynb) nello stesso percorso locale che crea un set di dati di test per eseguire l'inferenza sull'utilizzo del nostro modello addestrato. Possiamo eseguire il taccuino aggiuntivo nel nostro taccuino di formazione con la seguente cella magica:

Definiamo questa dipendenza extra dal notebook nel file AdditionalDependencies parametro nel nostro secondo passaggio di lavoro del notebook:

Dobbiamo inoltre specificare che lo step di lavoro del notebook di training (Step 2) dipende dallo step di lavoro del notebook Preprocess (Step 1) utilizzando il comando add_depends_on Chiamata API come segue:

Il nostro ultimo passaggio prevede che il modello BERT esegua una trasformazione batch SageMaker, configurando al tempo stesso l'acquisizione e la qualità dei dati tramite SageMaker Model Monitor. Tieni presente che questo è diverso dall'utilizzo del built-in Trasformare or Catturare passaggi tramite pipeline. Il nostro notebook per questo passaggio eseguirà le stesse API, ma verrà monitorato come passaggio di lavoro del notebook. Questo passaggio dipende dal Training Job Step che abbiamo definito in precedenza, quindi catturiamo anche quello con il flag depend_on.

Dopo aver definito i vari passaggi del nostro flusso di lavoro, possiamo creare ed eseguire la pipeline end-to-end:

Monitorare le esecuzioni della pipeline

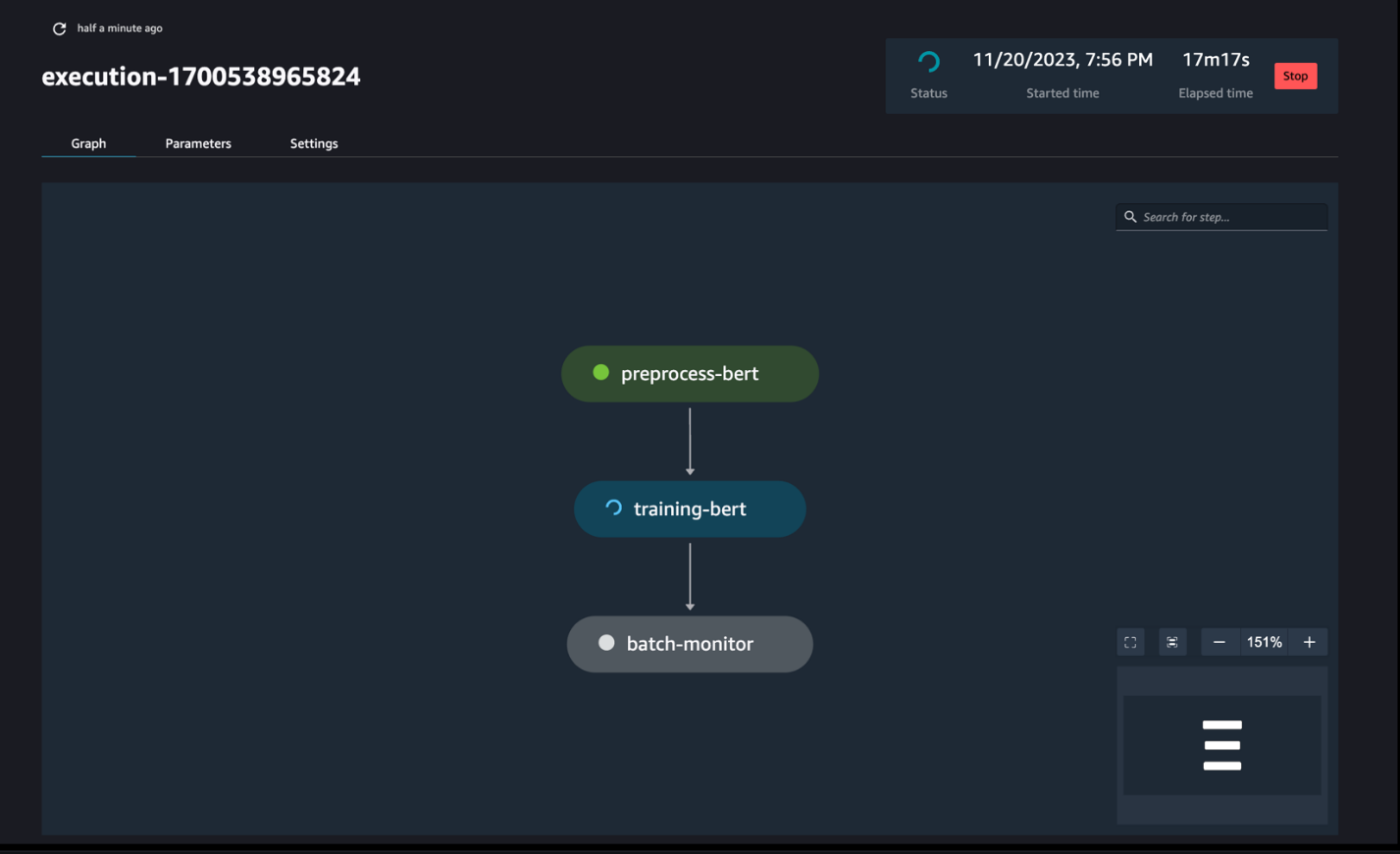

È possibile tenere traccia e monitorare le esecuzioni dei passaggi del notebook tramite il DAG SageMaker Pipelines, come mostrato nello screenshot seguente.

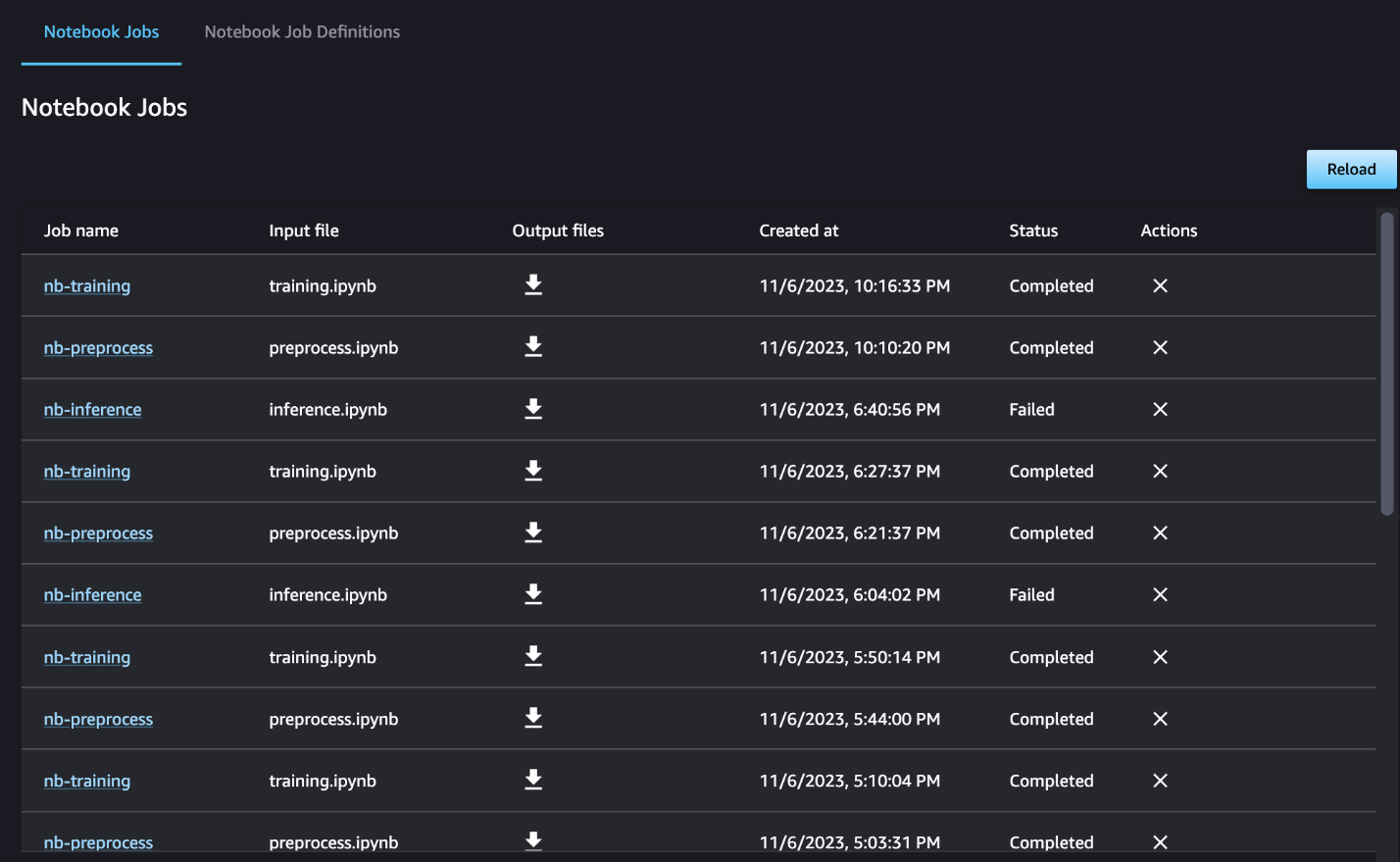

Facoltativamente, puoi anche monitorare le singole esecuzioni del notebook sul dashboard dei lavori del notebook e attivare/disattivare i file di output che sono stati creati tramite l'interfaccia utente di SageMaker Studio. Quando si utilizza questa funzionalità al di fuori di SageMaker Studio, è possibile definire gli utenti che possono tenere traccia dello stato di esecuzione sul dashboard del lavoro del notebook utilizzando i tag. Per ulteriori dettagli sui tag da includere, vedere Visualizza i processi del tuo notebook e scarica gli output nel dashboard dell'interfaccia utente di Studio.

Per questo esempio, inviamo i lavori del notebook risultanti in una directory chiamata outputs nel percorso locale con il codice di esecuzione della pipeline. Come mostrato nello screenshot seguente, qui puoi vedere l'output del tuo notebook di input e anche tutti i parametri che hai definito per quel passaggio.

ripulire

Se hai seguito il nostro esempio, assicurati di eliminare la pipeline creata, i processi del notebook e i dati s3 scaricati dai notebook di esempio.

Considerazioni

Di seguito sono riportate alcune considerazioni importanti su questa funzionalità:

- Vincoli dell'SDK – La fase di lavoro del notebook può essere creata solo tramite SageMaker Python SDK.

- Vincoli di immagine –La fase di lavoro del notebook supporta le seguenti immagini:

Conclusione

Con questo lancio, gli operatori dei dati possono ora eseguire i propri notebook a livello di programmazione con poche righe di codice utilizzando il SDK Python di SageMaker. Inoltre, puoi creare flussi di lavoro complessi in più fasi utilizzando i tuoi notebook, riducendo significativamente il tempo necessario per passare da un notebook a una pipeline CI/CD. Dopo aver creato la pipeline, puoi utilizzare SageMaker Studio per visualizzare ed eseguire DAG per le tue pipeline e gestire e confrontare le esecuzioni. Che tu stia pianificando flussi di lavoro ML end-to-end o parte di essi, ti invitiamo a provare flussi di lavoro basati su notebook.

Circa gli autori

Anchit Gupta è un Senior Product Manager per Amazon SageMaker Studio. Si concentra sull'abilitazione di flussi di lavoro interattivi di scienza dei dati e ingegneria dei dati dall'IDE di SageMaker Studio. Nel tempo libero le piace cucinare, giocare a giochi da tavolo/di carte e leggere.

Anchit Gupta è un Senior Product Manager per Amazon SageMaker Studio. Si concentra sull'abilitazione di flussi di lavoro interattivi di scienza dei dati e ingegneria dei dati dall'IDE di SageMaker Studio. Nel tempo libero le piace cucinare, giocare a giochi da tavolo/di carte e leggere.

Ram Vegiraju è un ML Architect con il team SageMaker Service. Si concentra sull'aiutare i clienti a creare e ottimizzare le loro soluzioni AI/ML su Amazon SageMaker. Nel tempo libero ama viaggiare e scrivere.

Ram Vegiraju è un ML Architect con il team SageMaker Service. Si concentra sull'aiutare i clienti a creare e ottimizzare le loro soluzioni AI/ML su Amazon SageMaker. Nel tempo libero ama viaggiare e scrivere.

Edoardo Sole è un Senior SDE che lavora per SageMaker Studio presso Amazon Web Services. Si concentra sulla creazione di soluzioni ML interattive e sulla semplificazione dell'esperienza del cliente per integrare SageMaker Studio con le tecnologie più diffuse nell'ingegneria dei dati e nell'ecosistema ML. Nel suo tempo libero, Edward è un grande fan del campeggio, delle escursioni e della pesca e si diverte a passare il tempo con la sua famiglia.

Edoardo Sole è un Senior SDE che lavora per SageMaker Studio presso Amazon Web Services. Si concentra sulla creazione di soluzioni ML interattive e sulla semplificazione dell'esperienza del cliente per integrare SageMaker Studio con le tecnologie più diffuse nell'ingegneria dei dati e nell'ecosistema ML. Nel suo tempo libero, Edward è un grande fan del campeggio, delle escursioni e della pesca e si diverte a passare il tempo con la sua famiglia.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/schedule-amazon-sagemaker-notebook-jobs-and-manage-multi-step-notebook-workflows-using-apis/

- :ha

- :È

- :Dove

- $ SU

- 1

- 100

- 116

- 125

- 15%

- 17

- 20

- 500

- 7

- 8

- a

- WRI

- accessibile

- aciclico

- aggiuntivo

- Inoltre

- Vantaggio

- Dopo shavasana, sedersi in silenzio; saluti;

- AI / ML

- Tutti

- consente

- lungo

- già

- anche

- Sebbene il

- Amazon

- Amazon EC2

- Amazon Sage Maker

- Amazon Sage Maker Studio

- Amazon Web Services

- an

- .

- l'analisi

- ed

- in qualsiasi

- api

- API

- applicazioni

- architettura

- SONO

- AS

- At

- automatizzare

- disponibile

- AWS

- base

- basato

- Linea di base

- BE

- bellissimo

- stato

- dietro

- essendo

- Meglio

- fra

- Big

- costruire

- Costruzione

- incassato

- ma

- by

- chiamata

- detto

- Materiale

- catturare

- Custodie

- casi

- caratteri

- classificazione

- codice

- Colonna

- colonne

- combina

- Venire

- Uncommon

- confrontare

- completamento di una

- complesso

- composto

- Compreso

- Calcolare

- Segui il codice di Condotta

- collegato

- Considerazioni

- consiste

- Contenitore

- contiene

- continuo

- convertire

- convertito

- Corrispondente

- potuto

- creare

- creato

- crea

- Creazione

- Attualmente

- costume

- cliente

- esperienza del cliente

- Assistenza clienti

- Clienti

- GIORNO

- cruscotto

- dati

- Preparazione dei dati

- elaborazione dati

- scienza dei dati

- dataset

- Predefinito

- definire

- definito

- consegna

- Richiesta

- dipendenze

- Dipendenza

- dipendente

- dipende

- schierare

- distribuzione

- dettagliati

- dettagli

- sviluppare

- sviluppato

- diverso

- dirette

- indirizzato

- Direttore

- distinto

- docker

- fare

- fatto

- giù

- scaricare

- cumulo di rifiuti

- ogni

- facilmente

- ecosistema

- Edward

- enable

- consentendo

- incoraggiare

- fine

- da un capo all'altro

- Ingegneria

- Intero

- epoca

- esempio

- eseguire

- esecuzione

- esperienza

- extra

- estratto

- famiglia

- fan

- lontano

- caratteristica

- feedback

- pochi

- Compila il

- File

- Film

- registi

- Nome

- Pesca

- cinque

- concentrato

- si concentra

- seguito

- i seguenti

- segue

- Nel

- modulo

- formato

- da

- completamente

- funzionalità

- Inoltre

- Giochi

- generare

- grafici

- Avere

- he

- Aiuto

- aiutare

- suo

- qui

- il suo

- Hollywood

- Come

- HTML

- http

- HTTPS

- umano

- if

- illustra

- Immagine

- immagini

- subito

- importare

- importante

- in

- includere

- studente indipendente

- indica

- individuale

- ingresso

- esempio

- istruzioni

- integrare

- integrazione

- interattivo

- ai miglioramenti

- IT

- SUO

- Lavoro

- Offerte di lavoro

- jpg

- ad appena

- Discografica

- per il tuo brand

- Cognome

- lanciare

- apprendimento

- biblioteche

- linea

- Linee

- caricare

- locale

- località

- Lunghi

- ama

- macchina

- machine learning

- magia

- Principale

- FA

- gestire

- gestito

- gestione

- direttore

- Media

- Merito

- forza

- ML

- modello

- modelli

- modificato

- moduli

- Monitorare

- monitoraggio

- monitor

- Scopri di più

- maggior parte

- cambiano

- film

- multiplo

- devono obbligatoriamente:

- Nome

- nativo

- Bisogno

- di applicazione

- negativo.

- New

- no

- Nota

- taccuino

- adesso

- oggetto

- of

- di frequente

- on

- ONE

- esclusivamente

- OTTIMIZZA

- or

- orchestrazione

- Altro

- nostro

- su

- produzione

- uscite

- al di fuori

- coppie

- parametro

- parametri

- parte

- passare

- Di passaggio

- sentiero

- Eseguire

- esecuzione

- cronologia

- conduttura

- Platone

- Platone Data Intelligence

- PlatoneDati

- gioco

- Popolare

- positivo

- Post

- predire

- preparazione

- Preparare

- prepara

- preparazione

- precedente

- in precedenza

- Problema

- lavorazione

- Prodotto

- product manager

- fornire

- purché

- fornisce

- la percezione

- Maglioni

- fini

- Spingi

- spinto

- Python

- qualità

- più veloce

- R

- piuttosto

- Leggi

- Lettura

- ricorrenti

- riducendo

- Refactoring

- riferimento

- registrato

- regolarmente

- rimanere

- RIPETUTAMENTE

- richiedere

- risultante

- recensioni

- Recensioni

- Correre

- running

- corre

- sagemaker

- Pipeline SageMaker

- stesso

- soddisfatte

- programma

- in programma

- Lavori pianificati

- programmazione

- Scienze

- scienziati

- sdk

- Secondo

- Sezione

- sezioni

- vedere

- visto

- anziano

- sentimento

- separato

- servizio

- Servizi

- Sessione

- set

- regolazione

- alcuni

- a forma di

- lei

- dovrebbero

- mostrare attraverso le sue creazioni

- vetrina

- mostrato

- Spettacoli

- significativa

- significativamente

- simile

- Un'espansione

- semplificando

- singolo

- piccole

- inferiore

- frammento

- So

- Social

- Social Media

- soluzione

- Soluzioni

- RISOLVERE

- alcuni

- qualcosa

- lo spazio

- specifico

- Spendere

- standalone

- stanford

- inizia a

- Stato dei servizi

- step

- Passi

- Ancora

- conservazione

- lineare

- studio

- tale

- Dom.

- supporto

- supportato

- supporti

- sicuro

- Fai

- prende

- Task

- task

- team

- Tecnologie

- test

- testo

- Classificazione del testo

- che

- Il

- loro

- Li

- poi

- Strumenti Bowman per analizzare le seguenti finiture:

- Terza

- questo

- quelli

- tre

- Attraverso

- tempo

- a

- insieme

- pure

- Totale

- pista

- Treni

- allenato

- Training

- Trasformare

- trasformatori

- Di viaggio

- innescare

- TURNO

- seconda

- Digitare

- ui

- capire

- Aggiornanento

- us

- uso

- caso d'uso

- utilizzato

- utenti

- usa

- utilizzando

- Utilizzando

- Valori

- vario

- via

- Visualizza

- visualizzare

- camminare

- volere

- we

- sito web

- servizi web

- quando

- se

- quale

- while

- OMS

- volere

- con

- entro

- senza

- lavoratori

- flusso di lavoro

- flussi di lavoro

- lavoro

- Salsiccia di assorbimento

- scrittura

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro