L'intelligenza artificiale è in lacrime. Le macchine possono parlare, scrivere, giocare e generare immagini, video e musica originali. Ma man mano che le capacità dell'IA sono cresciute, anche i suoi algoritmi sono cresciuti.

Un decennio fa, algoritmi di apprendimento automatico faceva affidamento su decine di milioni di connessioni interne, o parametri. Gli algoritmi odierni raggiungono regolarmente centinaia di miliardi e anche trilioni di parametri. I ricercatori affermano che il ridimensionamento produce ancora miglioramenti delle prestazioni e modelli con decine di trilioni di parametri potrebbero arrivare in breve tempo.

Per addestrare modelli così grandi, hai bisogno di computer potenti. Mentre l'intelligenza artificiale nei primi anni 2010 funzionava su una manciata di unità di elaborazione grafica, chip per computer che eccellono nell'elaborazione parallela cruciale per le esigenze di elaborazione dell'IA sono cresciuti in modo esponenzialee i modelli di punta ora ne richiedono centinaia o migliaia. OpenAI, Microsoft, Meta, e altri stanno costruendo supercomputer dedicati per gestire il compito, e dicono che queste macchine AI sono tra le più veloci del pianeta.

Ma anche se le GPU sono state fondamentali per il ridimensionamento dell'IA (l'A100 di Nvidia, ad esempio, è ancora uno dei chip più veloci e più comunemente usati nei cluster AI), negli ultimi anni sono spuntate alternative più strane progettate specificamente per l'IA.

Cerebras offre una di queste alternative.

Fare un pasto di AI

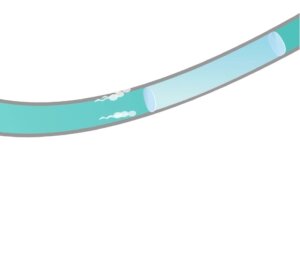

Le dimensioni di un piatto da portata - circa 8.5 pollici di lato - il Wafer Scale Engine dell'azienda è il il chip di silicio più grande del mondo, che vanta 2.6 trilioni di transistor e 850,000 core incisi su un singolo wafer di silicio. Ogni Wafer Scale Engine funge da cuore del computer CS-2 dell'azienda.

Da solo, il CS-2 è una bestia, ma l'anno scorso Cerebras ha svelato un piano per collegare i CS-2 insieme a un sistema di memoria esterno chiamato MemoryX e un sistema per collegare i CS-2 chiamato SwarmX. La società ha affermato che la nuova tecnologia potrebbe collegare fino a 192 chip e addestrare modelli due ordini di grandezza più grandi delle IA più grandi e avanzate di oggi.

"L'industria sta superando i modelli da 1 trilione di parametri e stiamo estendendo tale limite di due ordini di grandezza, abilitando reti neurali su scala cerebrale con 120 trilioni di parametri", ha affermato Andrew Feldman, CEO e cofondatore di Cerebras.

A quel tempo, tutto questo era teorico. Ma la scorsa settimana, il società annunciata avevano collegato 16 CS-2 insieme in un supercomputer AI di livello mondiale.

Incontra Andromeda

La nuova macchina, chiamata Andromeda, ha 13.5 milioni di core in grado di raggiungere velocità superiori a un exaflop (un quintilione di operazioni al secondo) con una precisione dimezzata a 16 bit. A causa del chip unico al suo interno, Andromeda non è facilmente paragonabile ai supercomputer in esecuzione su CPU e GPU più tradizionali, ma Feldman ha detto filo HPC Andromeda è più o meno equivalente al supercomputer Polaris dell'Argonne National Laboratory, che si classifica 17 ° più veloce al mondo, secondo l'ultimo elenco Top500.

Oltre alle prestazioni, i tempi di costruzione rapidi, i costi e l'ingombro di Andromeda sono notevoli. Argonne ha iniziato a installare Polaris nell'estate del 2021 e il supercomputer è andato in diretta circa un anno dopo. Occupa 40 rack, le custodie simili a schedari che ospitano componenti di supercomputer. In confronto, Andromeda è costata 35 milioni di dollari, un prezzo modesto per una macchina della sua potenza solo tre giorni per il montaggioe utilizza solo 16 rack.

Cerebras ha testato il sistema addestrando cinque versioni del modello di linguaggio di grandi dimensioni GPT-3 di OpenAI, nonché GPT-J e GPT-NeoX open source di Eleuther AI. E secondo Cerebras, forse la scoperta più importante è che Andromeda ha dimostrato quello che chiamano "ridimensionamento lineare quasi perfetto" dei carichi di lavoro AI per modelli di linguaggio di grandi dimensioni. In breve, ciò significa che man mano che vengono aggiunti ulteriori CS-2, i tempi di addestramento diminuiscono proporzionalmente.

In genere, ha affermato la società, man mano che si aggiungono più chip, i guadagni in termini di prestazioni diminuiscono. Il chip WSE di Cerebras, d'altra parte, potrebbe rivelarsi scalabile in modo più efficiente perché i suoi 850,000 core sono collegati tra loro sullo stesso pezzo di silicio. Inoltre, ogni core ha un modulo di memoria proprio accanto. Nel complesso, il chip riduce drasticamente la quantità di tempo impiegato per trasferire i dati tra i core e la memoria.

“Il ridimensionamento lineare significa che quando si passa da uno a due sistemi, il completamento del lavoro richiede la metà del tempo. Questa è una proprietà molto insolita nell'informatica", ha detto Feldman filo HPC. E, ha detto, può scalare oltre 16 sistemi connessi.

Oltre ai test di Cerebras, i risultati del ridimensionamento lineare sono stati dimostrati anche durante il lavoro presso l'Argonne National Laboratory, dove i ricercatori hanno utilizzato Andromeda per addestrare l'algoritmo del linguaggio di grandi dimensioni GPT-3-XL su lunghe sequenze del genoma di Covid-19.

Ovviamente, sebbene il sistema possa scalare oltre i 16 CS-2, resta da vedere fino a che punto il ridimensionamento lineare persiste. Inoltre, non sappiamo ancora come si comporta Cerebras nei confronti di altri chip IA. I produttori di chip AI come Nvidia e Intel hanno iniziato partecipare a regolari benchmarking di terze parti da artisti del calibro di MLperf. Cerebras deve ancora partecipare.

Spazio da risparmiare

Tuttavia, l'approccio sembra ritagliarsi una propria nicchia nel mondo del supercalcolo e il continuo ridimensionamento nell'IA di linguaggi di grandi dimensioni è un caso d'uso privilegiato. Infatti, Feldmann detto cablato l'anno scorso che la società stava già parlando con gli ingegneri di OpenAI, leader nei modelli di linguaggio di grandi dimensioni. (Il fondatore di OpenAI, Sam Altman, è anche un investitore in Cerebras.)

Alla sua uscita nel 2020, il modello di linguaggio di grandi dimensioni GPT-3 di OpenAI ha cambiato il gioco sia in termini di prestazioni che di dimensioni. Con un peso di 175 miliardi di parametri, era il più grande modello di intelligenza artificiale dell'epoca e sorprese i ricercatori con le sue capacità. Da allora, i modelli linguistici hanno raggiunto i trilioni di parametri e potrebbero essere in arrivo modelli più grandi. Ci sono voci- solo questo, finora - che OpenAI rilascerà GPT-4 in un futuro non troppo lontano e sarà un altro salto da GPT-3. (Dovremo aspettare e vedere su quel conteggio.)

Detto questo, nonostante le loro capacità, i grandi modelli linguistici non sono né perfetti né universalmente adorati. I loro difetti includono output che possono essere falsi, prevenuti e offensivi. Il Galactica di Meta, addestrato sui testi scientifici, lo è un esempio recente. Nonostante un set di dati che si potrebbe presumere sia meno soggetto a tossicità rispetto all'addestramento su Internet aperto, il modello è stato facilmente indotto a generare testo dannoso e impreciso e ritirato in soli tre giorni. Resta incerto se i ricercatori possano risolvere le carenze dell'intelligenza artificiale del linguaggio.

Ma sembra probabile che il ridimensionamento continuerà fino a quando non si verificheranno rendimenti decrescenti. Il prossimo salto potrebbe essere proprio dietro l'angolo e potremmo già avere l'hardware per realizzarlo.

Immagine di credito: Cerebras