1IRIF, CNRS – Université Paris Cité, Francia

2QC Ware, Palo Alto, Stati Uniti e Parigi, Francia

3Scuola di Informatica, Università di Edimburgo, Scozia, Regno Unito

4F. Hoffman La Roche AG

Trovi questo documento interessante o vuoi discuterne? Scrivi o lascia un commento su SciRate.

Astratto

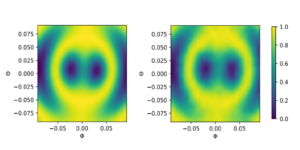

In questo lavoro, i trasformatori quantistici sono progettati e analizzati in dettaglio estendendo le architetture di rete neurale dei trasformatori classici all'avanguardia note per essere molto performanti nell'elaborazione del linguaggio naturale e nell'analisi delle immagini. Basandosi sul lavoro precedente, che utilizza circuiti quantistici parametrizzati per il caricamento dei dati e strati neurali ortogonali, introduciamo tre tipi di trasformatori quantistici per l'addestramento e l'inferenza, incluso un trasformatore quantistico basato su matrici composte, che garantisce un vantaggio teorico del meccanismo di attenzione quantistica rispetto alla loro controparte classica sia in termini di tempo di esecuzione asintotico che di numero di parametri del modello. Queste architetture quantistiche possono essere costruite utilizzando circuiti quantistici superficiali e producono modelli di classificazione qualitativamente diversi. I tre strati di attenzione quantistica proposti variano nello spettro tra seguire da vicino i trasformatori classici e mostrare più caratteristiche quantistiche. Come elementi costitutivi del trasformatore quantistico, proponiamo un nuovo metodo per caricare una matrice come stati quantistici, nonché due nuovi strati ortogonali quantistici addestrabili adattabili a diversi livelli di connettività e qualità dei computer quantistici. Abbiamo eseguito simulazioni approfondite dei trasformatori quantistici su set di dati di immagini mediche standard che hanno mostrato prestazioni competitive e talvolta migliori rispetto ai parametri di riferimento classici, inclusi i migliori trasformatori di visione classici della categoria. I trasformatori quantistici che abbiamo addestrato su questi set di dati su piccola scala richiedono meno parametri rispetto ai parametri di riferimento classici standard. Infine, abbiamo implementato i nostri trasformatori quantistici su computer quantistici superconduttori e ottenuto risultati incoraggianti per esperimenti fino a sei qubit.

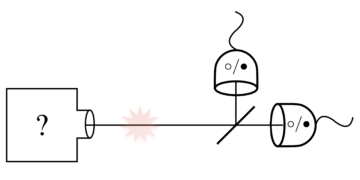

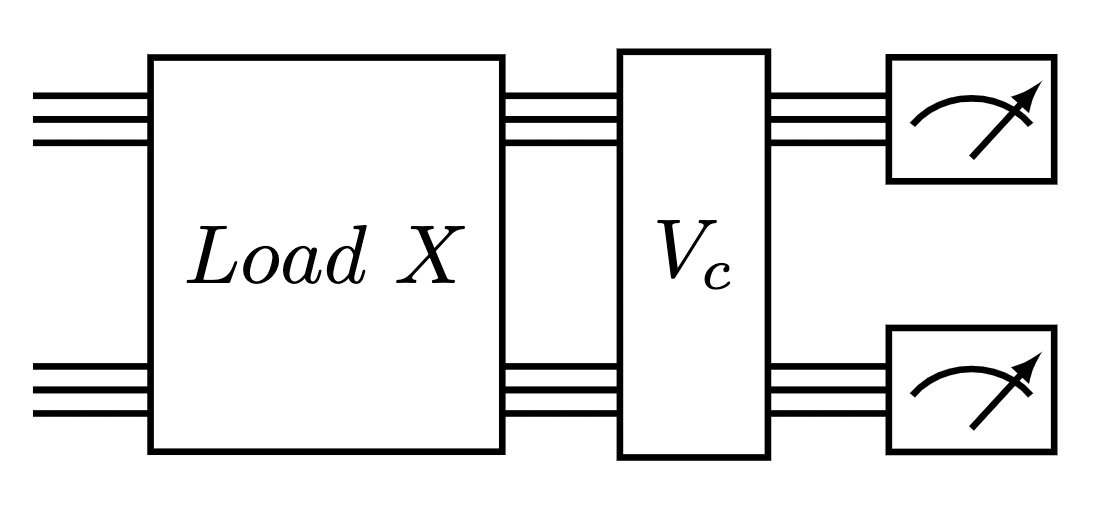

Immagine in primo piano: circuito quantistico per eseguire uno strato di attenzione del trasformatore composto. Un caricatore di dati a matrice seguito da uno strato quantico ortogonale.

Riepilogo popolare

► dati BibTeX

► Riferimenti

, Jacob Biamonte, Peter Wittek, Nicola Pancotti, Patrick Rebentrost, Nathan Wiebe e Seth Lloyd. "Apprendimento automatico quantistico". Natura 549, 195–202 (2017).

https: / / doi.org/ 10.1038 / nature23474

, Iris Cong, Soonwon Choi e Mikhail D Lukin. "Reti neurali convoluzionali quantistiche". Fisica della natura 15, 1273–1278 (2019).

https://doi.org/10.1038/s41567-019-0648-8

, Kishor Bharti, Alba Cervera-Lierta, Thi Ha Kyaw, Tobias Haug, Sumner Alperin-Lea, Abhinav Anand, Matthias Degroote, Hermanni Heimonen, Jakob S Kottmann, Tim Menke, et al. "Algoritmi quantistici rumorosi su scala intermedia". Recensioni di Fisica Moderna 94, 015004 (2022).

https: / / doi.org/ 10.1103 / RevModPhys.94.015004

, Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. "Algoritmi quantistici variazionali". Recensioni sulla natura Fisica 3, 625–644 (2021).

https://doi.org/10.1038/s42254-021-00348-9

, Jonas Landman, Natansh Mathur, Yun Yvonna Li, Martin Strahm, Skander Kazdaghli, Anupam Prakash e Iordanis Kerenidis. “Metodi quantistici per reti neurali e applicazioni alla classificazione delle immagini mediche”. Quantico 6, 881 (2022).

https://doi.org/10.22331/q-2022-12-22-881

, Bobak Kiani, Randall Balestriero, Yann LeCun e Seth Lloyd. “projunn: metodo efficiente per l'addestramento di reti profonde con matrici unitarie”. Progressi nei sistemi di elaborazione delle informazioni neurali 35, 14448–14463 (2022).

, Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser e Illia Polosukhin. "L'attenzione è tutto ciò di cui hai bisogno". Progressi nei sistemi di elaborazione delle informazioni neurali 30 (2017).

, Jacob Devlin, Ming-Wei Chang, Kenton Lee e Kristina Toutanova. “Bert: Pre-formazione di trasformatori bidirezionali profondi per la comprensione del linguaggio” (2018).

, Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit e Neil Houlsby. “Un’immagine vale 16×16 parole: trasformatori per il riconoscimento delle immagini su larga scala”. Conferenza internazionale sulle rappresentazioni dell'apprendimento (2021). URL: openreview.net/forum?id=YicbFdNTTy.

https:///openreview.net/forum?id=YicbFdNTTy

, Yi Tay, Mostafa Dehghani, Dara Bahri e Donald Metzler. “Trasformatori efficienti: un’indagine”. ACM Computing Surveys (CSUR) (2020).

https: / / doi.org/ 10.1145 / 3530811 mila

, Dzmitry Bahdanau, Kyunghyun Cho e Yoshua Bengio. “Traduzione automatica neurale imparando congiuntamente ad allineare e tradurre” (2016). arXiv:1409.0473 [cs, stat].

arXiv: 1409.0473

, J. Schmidhuber. "Riduzione del rapporto tra complessità dell'apprendimento e numero di variabili variabili nel tempo in reti completamente ricorrenti". In Stan Gielen e Bert Kappen, redattori, ICANN '93. Pagine 460–463. Londra (1993). Springer.

https://doi.org/10.1007/978-1-4471-2063-6_110

, Jürgen Schmidhuber. "Imparare a controllare le memorie a peso veloce: un'alternativa alle reti ricorrenti dinamiche". Calcolo neurale 4, 131–139 (1992).

https: / / doi.org/ 10.1162 / neco.1992.4.1.131

, Peter Cha, Paul Ginsparg, Felix Wu, Juan Carrasquilla, Peter L McMahon e Eun-Ah Kim. “Tomografia quantistica basata sull’attenzione”. Apprendimento automatico: scienza e tecnologia 3, 01LT01 (2021).

https:///doi.org/10.1088/2632-2153/ac362b

, Riccardo Di Sipio, Jia-Hong Huang, Samuel Yen-Chi Chen, Stefano Mangini e Marcel Worring. “L’alba dell’elaborazione quantistica del linguaggio naturale”. In ICASSP 2022-2022 Conferenza internazionale IEEE sull'acustica, il parlato e l'elaborazione dei segnali (ICASSP). Pagine 8612–8616. IEEE (2022).

https:///doi.org/10.1109/ICASSP43922.2022.9747675

, Guangxi Li, Xuanqiang Zhao e Xin Wang. “Reti neurali quantistiche di autoattenzione per la classificazione del testo” (2022).

, Fabio Sanches, Sean Weinberg, Takanori Ide e Kazumitsu Kamiya. “Circuiti quantistici corti nelle politiche di apprendimento per rinforzo per il problema del percorso dei veicoli”. Revisione fisica A 105, 062403 (2022).

https: / / doi.org/ 10.1103 / PhysRevA.105.062403

, YuanFu Yang e Min Sun. "Rilevamento dei difetti dei semiconduttori mediante deep learning ibrido classico-quantistico". CVPRPagine 2313–2322 (2022).

https:///doi.org/10.1109/CVPR52688.2022.00236

, Maxwell Henderson, Samriddhi Shakya, Shashindra Pradhan e Tristan Cook. "Reti neurali quanvoluzionali: potenziare il riconoscimento delle immagini con circuiti quantistici". Intelligenza meccanica quantistica 2, 1–9 (2020).

https: / / doi.org/ 10.1007 / s42484-020-00012-y

, Edward Farhi e Hartmut Neven. "Classificazione con reti neurali quantistiche su processori a breve termine" (2018). url: doi.org/10.48550/arXiv.1802.06002.

https:///doi.org/10.48550/arXiv.1802.06002

, Kosuke Mitarai, Makoto Negoro, Masahiro Kitagawa e Keisuke Fujii. "Apprendimento del circuito quantistico". Revisione fisica A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / PhysRevA.98.032309

, Kui Jia, Shuai Li, Yuxin Wen, Tongliang Liu e Dacheng Tao. "Reti neurali profonde ortogonali". Transazioni IEEE su analisi dei modelli e intelligenza artificiale (2019).

https: / / doi.org/ 10.1109 / TPAMI.2019.2948352

, Roger A Horn e Charles R Johnson. “Analisi della matrice”. Stampa universitaria di Cambridge. (2012).

https: / / doi.org/ 10.1017 / CBO9780511810817

, Iordanis Kerenidis e Anupam Prakash. “Apprendimento automatico quantistico con stati subspaziali” (2022).

, Brooks Foxen, Charles Neill, Andrew Dunsworth, Pedram Roushan, Ben Chiaro, Anthony Megrant, Julian Kelly, Zijun Chen, Kevin Satzinger, Rami Barends et al. "Dimostrazione di un insieme continuo di porte a due qubit per algoritmi quantistici a breve termine". Lettere di revisione fisica 125, 120504 (2020).

https: / / doi.org/ 10.1103 / PhysRevLett.125.120504

, Sonika Johri, Shantanu Debnath, Avinash Mocherla, Alexandros Singk, Anupam Prakash, Jungsang Kim e Iordanis Kerenidis. "Classificazione del centroide più vicino su un computer quantistico a ioni intrappolati". npj Informazioni quantistiche 7, 122 (2021).

https://doi.org/10.1038/s41534-021-00456-5

, James W. Cooley e John W. Tukey. “Un algoritmo per il calcolo automatico di serie complesse di Fourier”. Matematica del calcolo 19, 297–301 (1965).

https://doi.org/10.1090/S0025-5718-1965-0178586-1

, Li Jing, Yichen Shen, Tena Dubcek, John Peurifoy, Scott A. Skirlo, Yann LeCun, Max Tegmark e Marin Soljacic. "Reti neurali unitarie efficienti sintonizzabili (eunn) e loro applicazione alle rnns". Nella conferenza internazionale sull'apprendimento automatico. (2016). URL: api.semanticscholar.org/CorpusID:5287947.

https:///api.semanticscholar.org/CorpusID:5287947

, Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla e Elham Kashefi. “Addestrabilità ed espressività di circuiti quantistici che preservano il peso di hamming per l'apprendimento automatico” (2023). arXiv:2309.15547.

arXiv: 2309.15547

, Enrico Fontana, Dylan Herman, Shouvanik Chakrabarti, Niraj Kumar, Romina Yalovetzky, Jamie Heredge, Shree Hari Sureshbabu e Marco Pistoia. “L’adjoint è tutto ciò di cui hai bisogno: Caratterizzazione degli altipiani sterili in quantum ansätze” (2023). arXiv:2309.07902.

arXiv: 2309.07902

, Michael Ragone, Bojko N. Bakalov, Frédéric Sauvage, Alexander F. Kemper, Carlos Ortiz Marrero, Martin Larocca e M. Cerezo. "Una teoria unificata di altipiani aridi per circuiti quantistici parametrizzati profondi" (2023). arXiv:2309.09342.

arXiv: 2309.09342

, Xuchen You e Xiaodi Wu. “Esponenzialmente molti minimi locali nelle reti neurali quantistiche”. Nella conferenza internazionale sull'apprendimento automatico. Pagine 12144–12155. PMLR (2021).

, Eric R. Anschuetz e Bobak Toussi Kiani. “Gli algoritmi variazionali quantistici sono sommersi di trappole”. Comunicazioni sulla natura 13 (2022).

https://doi.org/10.1038/s41467-022-35364-5

, Ilya O. Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Daniel Keysers, Jakob Uszkoreit, Mario Lucic e Alexey Dosovitskiy. "Mlp-mixer: un'architettura all-mlp per la visione". In NeurIPS. (2021).

, Jiancheng Yang, Rui Shi e Bingbing Ni. "Decathlon della classificazione Medmnist: un punto di riferimento automatico leggero per l'analisi delle immagini mediche" (2020).

https:///doi.org/10.1109/ISBI48211.2021.9434062

, Jiancheng Yang, Rui Shi, Donglai Wei, Zequan Liu, Lin Zhao, Bilian Ke, Hanspeter Pfister e Bingbing Ni. "Medmnist v2: un punto di riferimento leggero su larga scala per la classificazione di immagini biomediche 2D e 3D". Dati scientifici 10, 41 (2023).

https://doi.org/10.1038/s41597-022-01721-8

, Angelos Katharopoulos, Apoorv Vyas, Nikolaos Pappas e François Fleuret. “I trasformatori sono rnns: trasformatori autoregressivi veloci con attenzione lineare”. Nella conferenza internazionale sull'apprendimento automatico. Pagine 5156–5165. PMLR (2020).

, James Bradbury, Roy Frostig, Peter Hawkins, Matthew James Johnson, Chris Leary, Dougal Maclaurin, George Necula, Adam Paszke, Jake VanderPlas, Skye Wanderman-Milne e Qiao Zhang. “JAX: trasformazioni componibili di programmi Python+NumPy”. Github (2018). URL: http:///github.com/google/jax.

http: / / github.com/ google / jax

, Diederik P. Kingma e Jimmy Ba. "Adam: un metodo per l'ottimizzazione stocastica". CoRR abs/1412.6980 (2015).

, Hyeonwoo Noh, Tackgeun You, Jonghwan Mun e Bohyung Han. "Regolarizzazione delle reti neurali profonde mediante rumore: sua interpretazione e ottimizzazione". NeuroIPS (2017).

, Xue Ying. "Una panoramica dell'overfitting e delle sue soluzioni". Nel Journal of Physics: serie di conferenze. Volume 1168, pagina 022022. Pubblicazione IOP (2019).

https://doi.org/10.1088/1742-6596/1168/2/022022

Citato da

[1] David Peral García, Juan Cruz-Benito e Francisco José García-Peñalvo, "Revisione sistematica della letteratura: apprendimento automatico quantistico e sue applicazioni", arXiv: 2201.04093, (2022).

[2] El Amine Cherrat, Snehal Raj, Iordanis Kerenidis, Abhishek Shekhar, Ben Wood, Jon Dee, Shouvanik Chakrabarti, Richard Chen, Dylan Herman, Shaohan Hu, Pierre Minssen, Ruslan Shaydulin, Yue Sun, Romina Yalovetzky e Marco Pistoia, “Copertura quantistica profonda”, Quantico 7, 1191 (2023).

[3] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla e Elham Kashefi, "Trainability and Expressivity of Hamming-Weight Preserving Quantum Circuits for Machine Learning", arXiv: 2309.15547, (2023).

[4] Sohum Thakkar, Skander Kazdaghli, Natansh Mathur, Iordanis Kerenidis, André J. Ferreira-Martins e Samurai Brito, "Previsione finanziaria migliorata tramite l'apprendimento automatico quantistico", arXiv: 2306.12965, (2023).

[5] Jason Iaconis e Sonika Johri, "Caricamento efficiente di dati quantistici basato su rete di tensori", arXiv: 2310.05897, (2023).

[6] Nishant Jain, Jonas Landman, Natansh Mathur e Iordanis Kerenidis, "Reti quantistiche di Fourier per la risoluzione di PDE parametriche", arXiv: 2306.15415, (2023).

[7] Daniel Mastropietro, Georgios Korpas, Vyacheslav Kungurtsev e Jakub Marecek, "Fleming-Viot aiuta ad accelerare gli algoritmi quantistici variazionali in presenza di altipiani aridi", arXiv: 2311.18090, (2023).

[8] Aliza U. Siddiqui, Kaitlin Gili e Chris Ballance, "Sottolineare l'hardware quantistico moderno: approfondimenti sulla valutazione delle prestazioni e sull'esecuzione", arXiv: 2401.13793, (2024).

Le citazioni sopra sono di ANNUNCI SAO / NASA (ultimo aggiornamento riuscito 2024-02-22 13:37:43). L'elenco potrebbe essere incompleto poiché non tutti gli editori forniscono dati di citazione adeguati e completi.

Impossibile recuperare Crossref citato da dati durante l'ultimo tentativo 2024-02-22 13:37:41: Impossibile recuperare i dati citati per 10.22331 / q-2024-02-22-1265 da Crossref. Questo è normale se il DOI è stato registrato di recente.

Questo documento è pubblicato in Quantum sotto il Creative Commons Attribuzione 4.0 Internazionale (CC BY 4.0) licenza. Il copyright rimane dei detentori del copyright originali come gli autori o le loro istituzioni.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://quantum-journal.org/papers/q-2024-02-22-1265/

- :È

- :non

- ][P

- $ SU

- 1

- 10

- 11

- 12

- 125

- 13

- 14

- 15%

- 16

- 17

- 19

- 20

- 2012

- 2015

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 2024

- 22

- 23

- 24

- 25

- 26%

- 27

- 28

- 29

- 2D

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 3d

- 40

- 41

- 43

- 7

- 8

- 9

- 98

- a

- sopra

- ABSTRACT

- accesso

- ACM

- Adam

- Inoltre

- avanzamenti

- Vantaggio

- vantaggi

- affiliazioni

- AL

- alex

- Alexander

- algoritmo

- Algoritmi

- allineare

- Tutti

- alternativa

- an

- .

- ed

- Andrea

- Anthony

- api

- Applicazioni

- applicazioni

- architettura

- architetture

- SONO

- AS

- ipotesi

- At

- tentativo

- attenzione

- autore

- gli autori

- AutoML

- sterile

- basato

- BE

- Ben

- Segno di riferimento

- parametri di riferimento

- benzoino

- Meglio

- fra

- bidirezionale

- biomedico

- Blocchi

- entrambi

- Rompere

- Costruzione

- costruito

- by

- calcolo

- cambridge

- Materiale

- funzionalità

- carlos

- cha

- chang

- caratteristiche

- Charles

- chen

- CHO

- chris

- classificazione

- strettamente

- commento

- Popolo

- Comunicazioni

- rispetto

- competitivo

- completamento di una

- complesso

- complessità

- componibile

- Compound

- calcolo

- computer

- computer

- informatica

- Convegno

- Connettività

- continuo

- di controllo

- copyright

- potuto

- Controparte

- omologhi

- creare

- Daniel

- dati

- dataset

- David

- deep

- apprendimento profondo

- dimostrare

- progettato

- dettaglio

- rivelazione

- diverso

- discutere

- donald

- durante

- dinamico

- E&T

- redattori

- Edward

- efficacia

- efficiente

- el

- incoraggiando

- accrescere

- eric

- valutazione

- Anche

- eseguire

- esecuzione

- esporre

- esperimenti

- esplora

- estendendo

- estensivo

- FAST

- Febbraio

- meno

- Infine

- finanziario

- messa a fuoco

- seguito

- i seguenti

- Nel

- Francisco

- da

- completamente

- Gates

- George

- GitHub

- Gomez

- garanzie

- Hardware

- harvard

- copertura

- Aiuto

- aiuta

- titolari

- http

- HTTPS

- huang

- IBRIDO

- IEEE

- if

- Illia

- Immagine

- Classificazione delle immagini

- Riconoscimento dell'immagine

- immagini

- implementato

- migliorata

- in

- Compreso

- informazioni

- intuizioni

- istituzioni

- Intelligence

- interessante

- Internazionale

- interpretazione

- introdurre

- SUO

- Giacobbe

- Giacomo

- Jamie

- JavaScript

- piede di porco

- John

- Johnson

- jon

- Jones

- rivista

- Giovanni

- Kim

- conosciuto

- Kumar

- Lingua

- larga scala

- Cognome

- strato

- galline ovaiole

- apprendimento

- Lasciare

- sottovento

- livelli

- leveraging

- Li

- Licenza

- leggero

- piace

- lin

- lineare

- Lista

- letteratura

- caricatore

- Caricamento in corso

- locale

- Londra

- macchina

- machine learning

- molti

- Marco

- mario

- martyn

- matematica

- Matrice

- matthew

- max

- max-width

- Maxwell

- Maggio..

- McClean

- meccanismo

- medicale

- memorie

- metodo

- metodi

- Michael

- Mikhail

- verbale

- modello

- modelli

- moderno

- Mese

- Scopri di più

- Naturale

- Elaborazione del linguaggio naturale

- Natura

- Vicino

- Bisogno

- Nets

- Rete

- reti

- neurale

- rete neurale

- reti neurali

- New

- Rumore

- normale

- romanzo

- numero

- ottenuto

- of

- on

- ONE

- aprire

- ottimizzazione

- or

- i

- nostro

- su

- ancora

- panoramica

- pagina

- pagine

- palo Alto

- Carta

- parametri

- Parigi

- patrick

- Cartamodello

- Paul

- performance

- eseguita

- Peter

- Fisico

- Fisica

- Pierre

- Platone

- Platone Data Intelligence

- PlatoneDati

- Termini e Condizioni

- polosukhin

- potenziale

- Accensione

- Prakash

- presenza

- presenti

- preservare

- stampa

- precedente

- Problema

- lavorazione

- processori

- produrre

- Programmi

- promettente

- offre

- proposto

- fornire

- pubblicato

- editore

- editori

- editoriale

- qualità

- Quantistico

- algoritmi quantistici

- Computer quantistico

- computer quantistici

- calcolo quantistico

- informazione quantistica

- apprendimento automatico quantistico

- qubit

- R

- RAMINO

- rapporto

- recentemente

- riconoscimento

- ricorrente

- Riferimenti

- registrato

- resti

- richiedere

- Risultati

- recensioni

- Recensioni

- Richard

- roccia

- romain

- instradamento

- roy

- Correre

- runtime

- Ryan

- s

- Scala

- Scienze

- Scienza e Tecnologia

- scientifico

- Scott

- Sean

- Serie

- set

- superficiale

- ha mostrato

- Signal

- Simon

- simulazioni

- SIX

- Soluzioni

- Soluzione

- alcuni

- Spettro

- discorso

- velocità

- Standard

- state-of-the-art

- stati

- Studio

- Con successo

- tale

- adatto

- Dom.

- superconduttore

- Indagine

- SISTEMI DI TRATTAMENTO

- task

- tay

- Tecnologia

- termine

- condizioni

- testo

- Classificazione del testo

- che

- Il

- loro

- teorico

- teoria

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- Tommaso

- tre

- Tim

- tempo

- volte

- Titolo

- a

- allenato

- Training

- Le transazioni

- trasformazioni

- trasformatore

- trasformatori

- tradurre

- Traduzione

- intrappolati

- trappole

- seconda

- Tipi di

- per

- e una comprensione reciproca

- unificato

- unico

- Università

- aggiornato

- su

- URL

- USA

- usa

- utilizzando

- variare

- variando

- veicolo

- molto

- via

- visione

- volume

- W

- wang

- volere

- Prima

- we

- WELL

- quale

- con

- legno

- parole

- Lavora

- valore

- wu

- xiao

- anno

- dare la precedenza

- YING

- Tu

- Yuan

- zefiro

- Zhao