“Invece di concentrarsi sul codice, le aziende dovrebbero concentrarsi sullo sviluppo di pratiche ingegneristiche sistematiche per migliorare i dati in modo affidabile, efficiente e sistematico. In altre parole, le aziende devono passare da un approccio incentrato sui modelli a un approccio incentrato sui dati". – Andrew Ng

Un approccio AI incentrato sui dati comporta la creazione di sistemi di intelligenza artificiale con dati di qualità che coinvolgono la preparazione dei dati e l'ingegnerizzazione delle funzionalità. Questo può essere un compito noioso che coinvolge la raccolta dei dati, la scoperta, la profilazione, la pulizia, la strutturazione, la trasformazione, l'arricchimento, la convalida e l'archiviazione sicura dei dati.

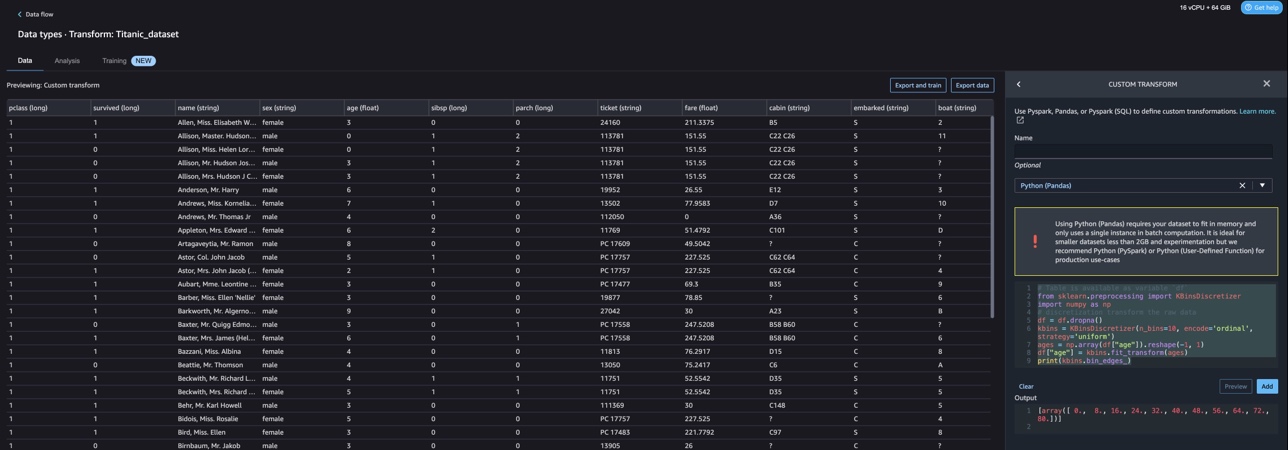

Gestore di dati di Amazon SageMaker è un servizio in Amazon Sage Maker Studio che fornisce una soluzione end-to-end per importare, preparare, trasformare, caratterizzare e analizzare i dati utilizzando poca o nessuna codifica. Puoi integrare un flusso di preparazione dei dati di Data Wrangler nei tuoi flussi di lavoro di machine learning (ML) per semplificare la pre-elaborazione dei dati e l'ingegnerizzazione delle funzionalità, portando la preparazione dei dati alla produzione più velocemente senza la necessità di creare codice PySpark, installare Apache Spark o avviare cluster.

Per gli scenari in cui è necessario aggiungere i propri script personalizzati per le trasformazioni dei dati, è possibile scrivere la logica di trasformazione in Pandas, PySpark, PySpark SQL. Data Wrangler ora supporta le librerie NLTK e SciPy per la creazione di trasformazioni personalizzate per preparare i dati di testo per ML ed eseguire l'ottimizzazione dei vincoli.

Potresti imbatterti in scenari in cui devi aggiungere i tuoi script personalizzati per la trasformazione dei dati. Con la funzionalità di trasformazione personalizzata di Data Wrangler, puoi scrivere la tua logica di trasformazione in Pandas, PySpark, PySpark SQL.

In questo post, discutiamo di come puoi scrivere la tua trasformazione personalizzata in NLTK per preparare i dati di testo per ML. Condivideremo anche alcuni esempi di trasformazione del codice personalizzato utilizzando altri framework comuni come NLTK, NumPy, SciPy e scikit-learn, nonché AWS AI Services. Per lo scopo di questo esercizio, utilizziamo il Set di dati Titanic, un set di dati popolare nella comunità ML, che ora è stato aggiunto come a set di dati di esempio all'interno di Data Wrangler.

Panoramica della soluzione

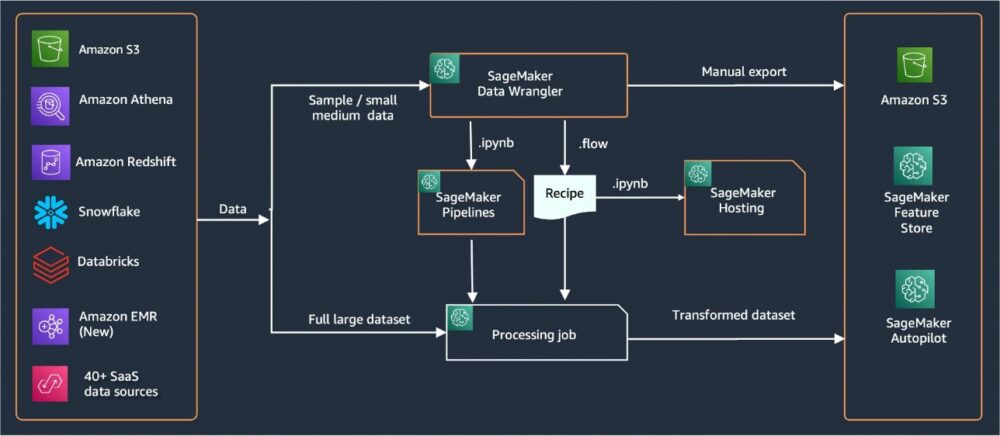

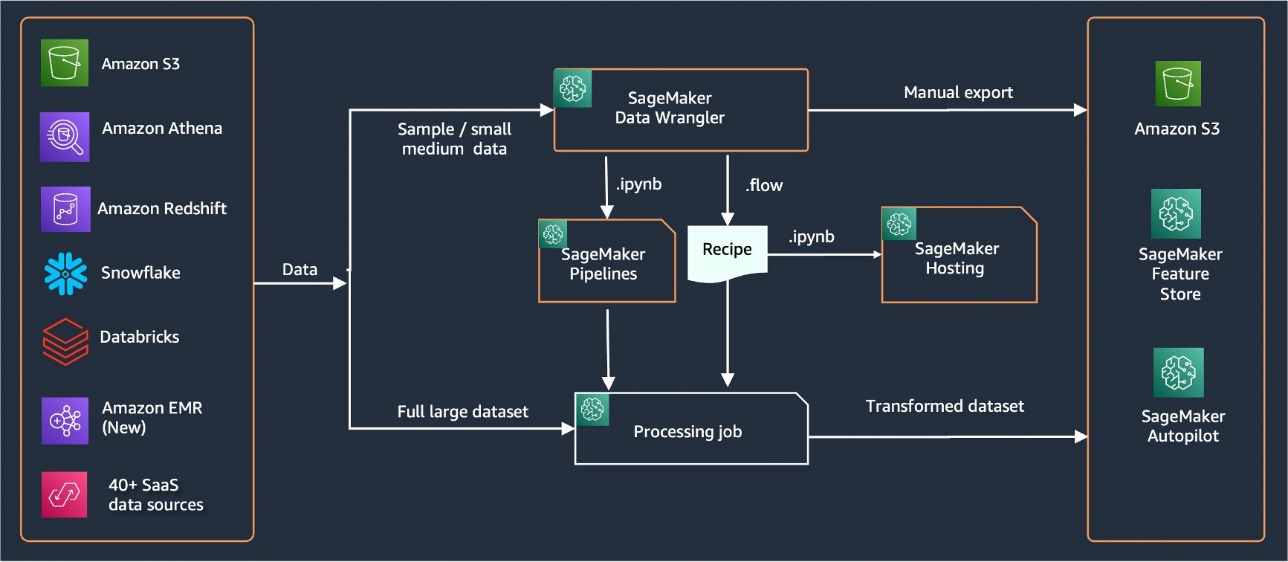

Data Wrangler fornisce oltre 40 connettori integrati per l'importazione dei dati. Dopo l'importazione dei dati, puoi creare l'analisi e le trasformazioni dei dati utilizzando oltre 300 trasformazioni integrate. È quindi possibile generare pipeline industrializzate a cui inviare le funzionalità Servizio di archiviazione semplice Amazon (Amazon S3) o Negozio di funzionalità Amazon SageMaker. Il diagramma seguente mostra l'architettura di alto livello end-to-end.

Prerequisiti

Data Wrangler è una funzionalità di SageMaker disponibile all'interno Amazon Sage Maker Studio. Puoi seguire il processo di onboarding di Studio per potenziare l'ambiente Studio e i notebook. Sebbene sia possibile scegliere tra alcuni metodi di autenticazione, il modo più semplice per creare un dominio di Studio è seguire il Istruzioni di avvio rapido. Il Quick start utilizza le stesse impostazioni predefinite della configurazione standard di Studio. Puoi anche scegliere di utilizzare l'onboarding Centro di identità AWS IAM (successore di AWS Single Sign-On) per l'autenticazione (vedi Integrazione nel dominio Amazon SageMaker utilizzando IAM Identity Center).

Importa il set di dati Titanic

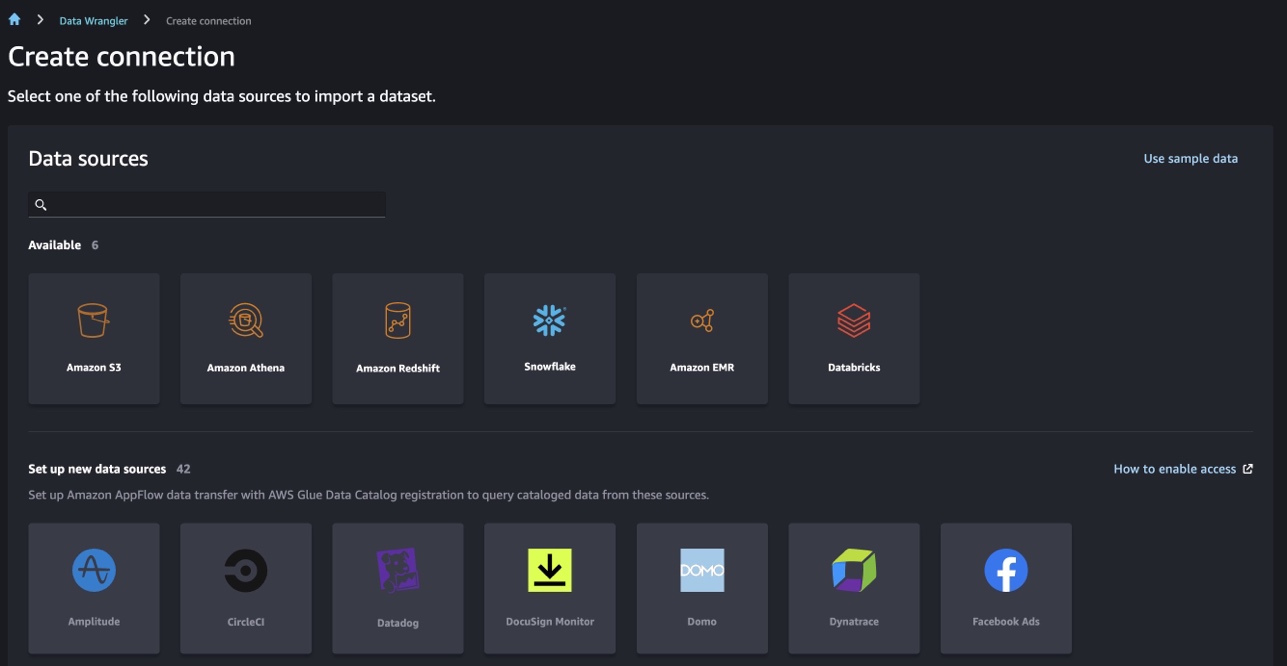

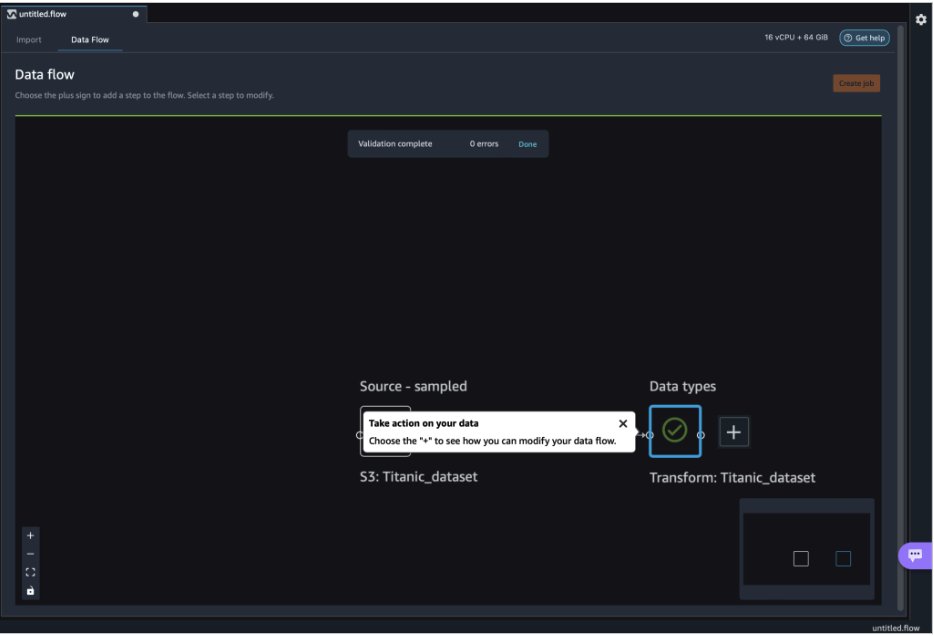

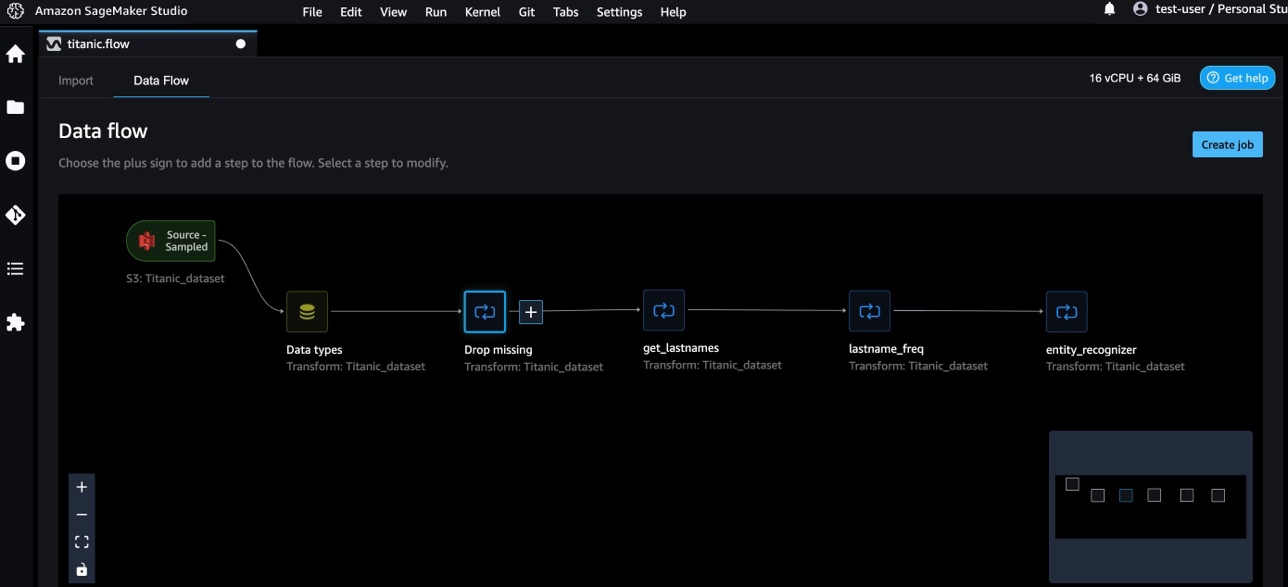

Avvia il tuo ambiente Studio e creane uno nuovo Flusso di Data Wrangler. Puoi importare il tuo set di dati o utilizzare un set di dati di esempio (Titanic) come mostrato nello screenshot seguente. Data Wrangler ti consente di importare set di dati da diverse fonti di dati. Per il nostro caso d'uso, importiamo il set di dati di esempio da un bucket S3.

Una volta importato, vedrai due nodi (il nodo di origine e il nodo del tipo di dati) nel flusso di dati. Data Wrangler identifica automaticamente il tipo di dati per tutte le colonne nel set di dati.

Trasformazioni personalizzate con NLTK

Per la preparazione dei dati e l'ingegnerizzazione delle funzionalità con Data Wrangler, puoi utilizzare oltre 300 trasformazioni integrate o creare le tue trasformazioni personalizzate. Trasformazioni personalizzate possono essere scritti come passaggi separati all'interno di Data Wrangler. Diventano parte del file .flow all'interno di Data Wrangler. La funzione di trasformazione personalizzata supporta Python, PySpark e SQL come diversi passaggi nei frammenti di codice. Dopo che i file notebook (.ipynb) sono stati generati dal file .flow o il file .flow è stato utilizzato come ricette, i frammenti di codice di trasformazione personalizzati persistono senza richiedere alcuna modifica. Questa progettazione di Data Wrangler consente alle trasformazioni personalizzate di diventare parte di un processo di elaborazione SageMaker per l'elaborazione di enormi set di dati con trasformazioni personalizzate.

Il set di dati Titanic ha un paio di funzionalità (nome e home.dest) che contengono informazioni di testo. Noi usiamo NLTK per dividere la colonna del nome ed estrarre il cognome e stampare la frequenza dei cognomi. NLTK è una piattaforma leader per la creazione di programmi Python per lavorare con i dati del linguaggio umano. Fornisce interfacce facili da usare per oltre 50 corpora e risorse lessicali come WordNet, insieme a una suite di librerie di elaborazione del testo per classificazione, tokenizzazione, stemming, tagging, analisi e ragionamento semantico e wrapper per librerie di elaborazione del linguaggio naturale (NLP) di livello industriale.

Per aggiungere una nuova trasformazione, completare i seguenti passaggi:

- Scegli il segno più e scegli Aggiungi trasformazione.

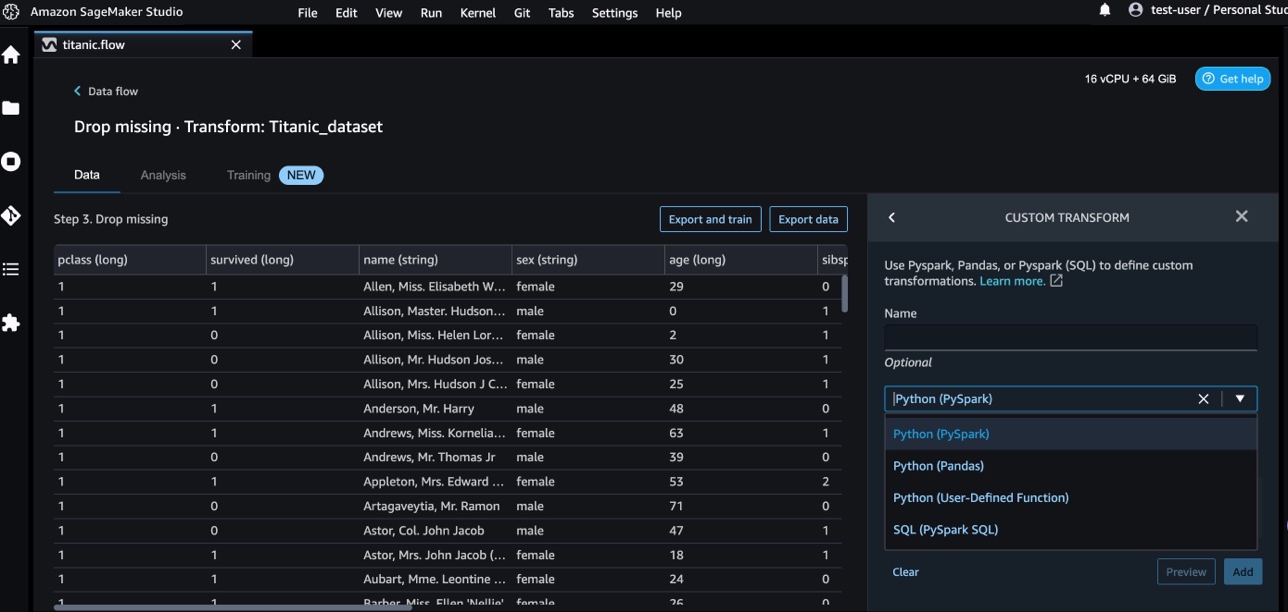

- Scegli Aggiungi passaggio e scegli Trasformazione personalizzata.

Puoi creare una trasformazione personalizzata usando Pandas, PySpark, funzioni Python definite dall'utente e SQL PySpark.

- Scegli Python (Panda) e aggiungi il seguente codice per estrarre il cognome dalla colonna del nome:

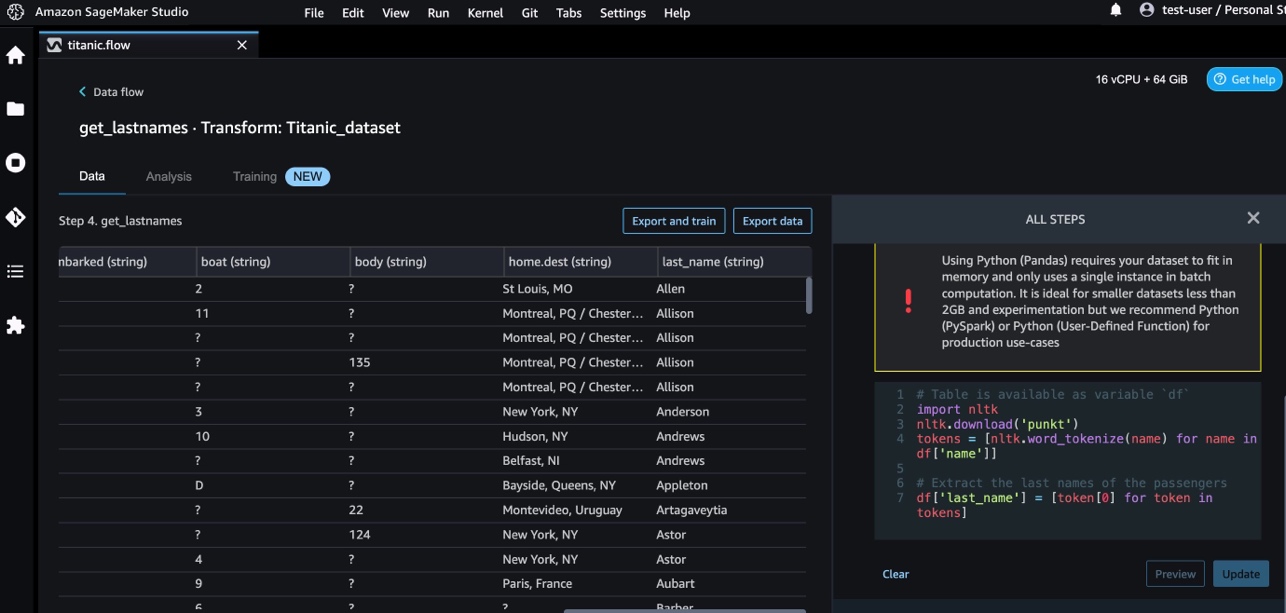

- Scegli Anteprima per esaminare i risultati.

La seguente schermata mostra il last_name colonna estratta.

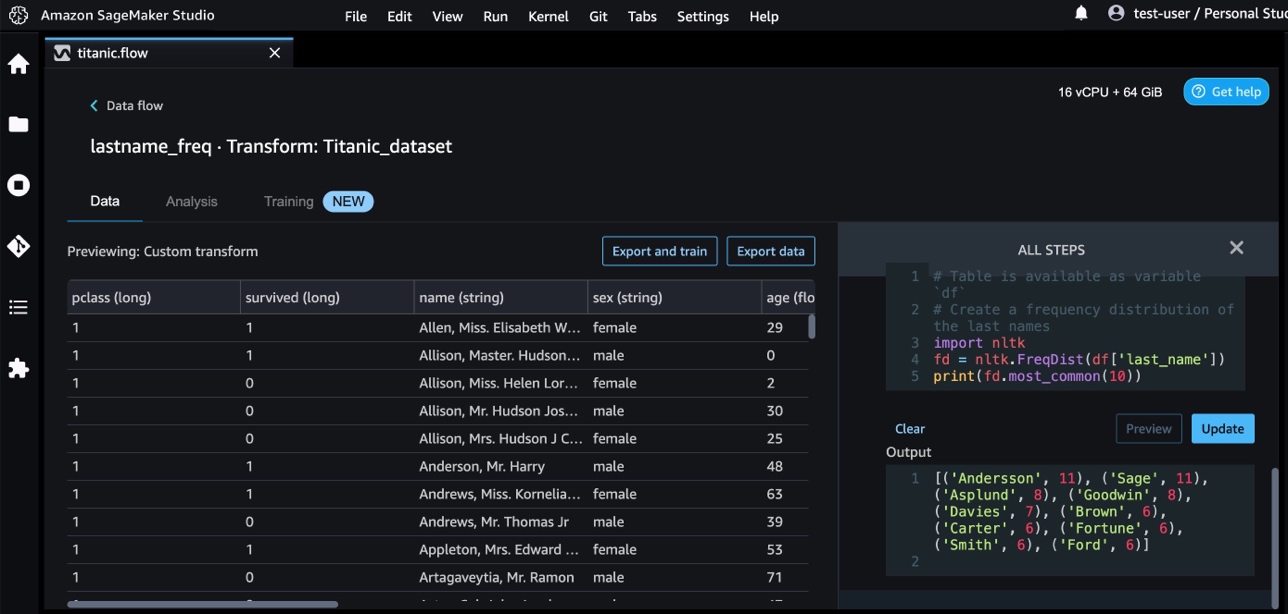

- Aggiungi un altro passaggio di trasformazione personalizzato per identificare la distribuzione di frequenza dei cognomi, utilizzando il seguente codice:

- Scegli Anteprima rivedere i risultati della frequenza.

Trasformazioni personalizzate con i servizi AWS AI

I servizi di intelligenza artificiale preaddestrati di AWS forniscono informazioni già pronte per le tue applicazioni e i tuoi flussi di lavoro. I servizi AWS AI si integrano facilmente con le tue applicazioni per affrontare molti casi d'uso comuni. Ora puoi utilizzare le funzionalità per i servizi AWS AI come fase di trasformazione personalizzata in Data Wrangler.

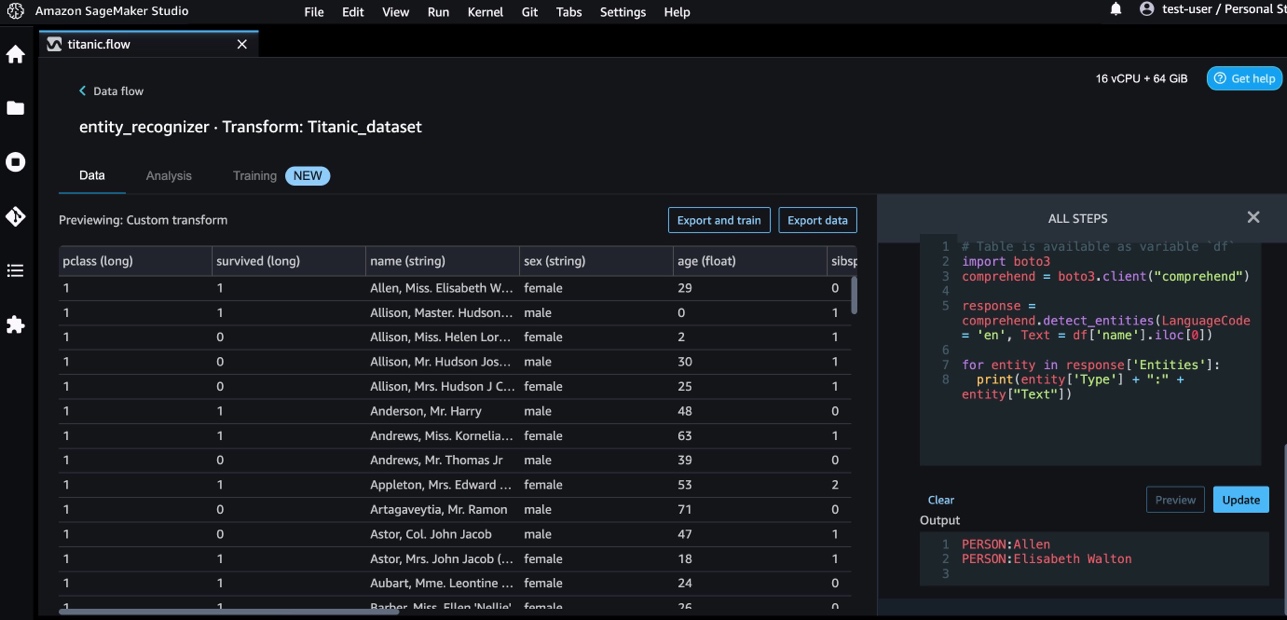

Amazon Comprehend utilizza la PNL per estrarre informazioni sul contenuto dei documenti. Sviluppa intuizioni riconoscendo le entità, le frasi chiave, il linguaggio, i sentimenti e altri elementi comuni in un documento.

Utilizziamo Amazon Comprehend per estrarre le entità dalla colonna del nome. Completa i seguenti passaggi:

- Aggiungi un passaggio di trasformazione personalizzato.

- Scegli Python (Panda).

- Immettere il seguente codice per estrarre le entità:

- Scegli Anteprima e visualizzare i risultati.

Ora abbiamo aggiunto tre trasformazioni personalizzate in Data Wrangler.

- Scegli Flusso di dati per visualizzare il flusso di dati end-to-end.

Trasformazioni personalizzate con NumPy e SciPy

NumPy è una libreria open source per Python che offre funzioni matematiche complete, generatori di numeri casuali, routine di algebra lineare, trasformate di Fourier e altro ancora. SciPy è una libreria Python open source utilizzata per il calcolo scientifico e il calcolo tecnico, contenente moduli per ottimizzazione, algebra lineare, integrazione, interpolazione, funzioni speciali, trasformata di Fourier veloce (FFT), elaborazione di segnali e immagini, risolutori e altro ancora.

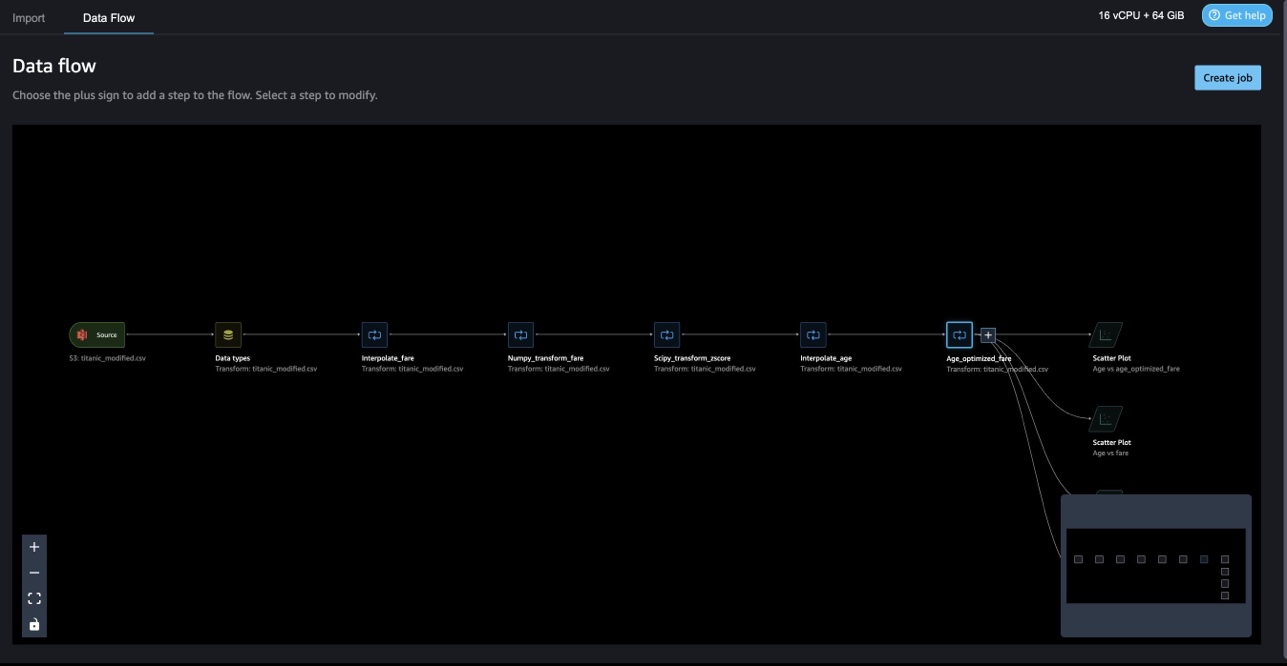

Le trasformazioni personalizzate di Data Wrangler consentono di combinare Python, PySpark e SQL in passaggi diversi. Nel seguente flusso di Data Wrangler, diverse funzioni dei pacchetti Python, NumPy e SciPy vengono applicate al set di dati Titanic in più passaggi.

Trasformazioni NumPy

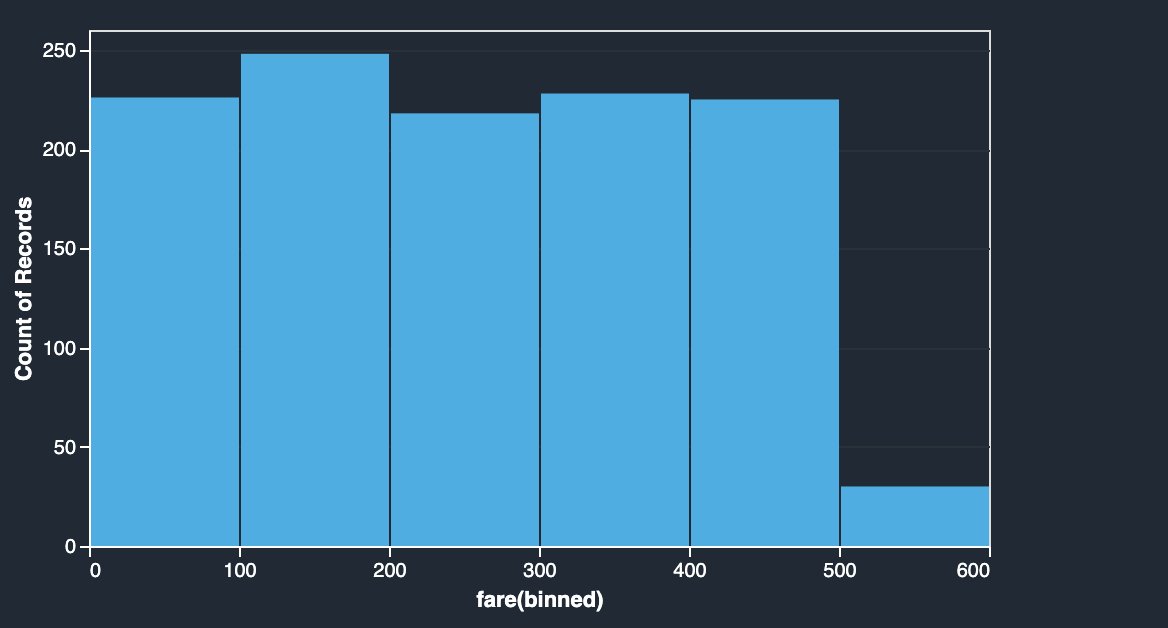

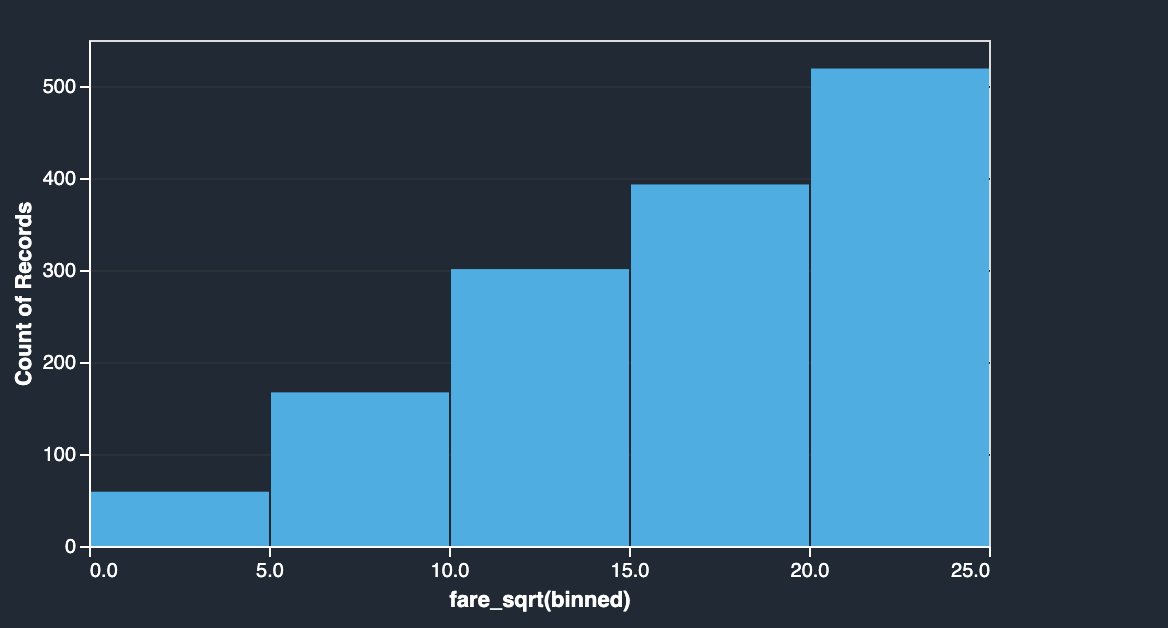

La colonna delle tariffe del set di dati del Titanic contiene le tariffe di imbarco di diversi passeggeri. L'istogramma della colonna tariffa mostra una distribuzione uniforme, ad eccezione dell'ultimo bin. Applicando trasformazioni NumPy come logaritmo o radice quadrata, possiamo modificare la distribuzione (come mostrato dalla trasformazione radice quadrata).

|

|

Vedi il seguente codice:

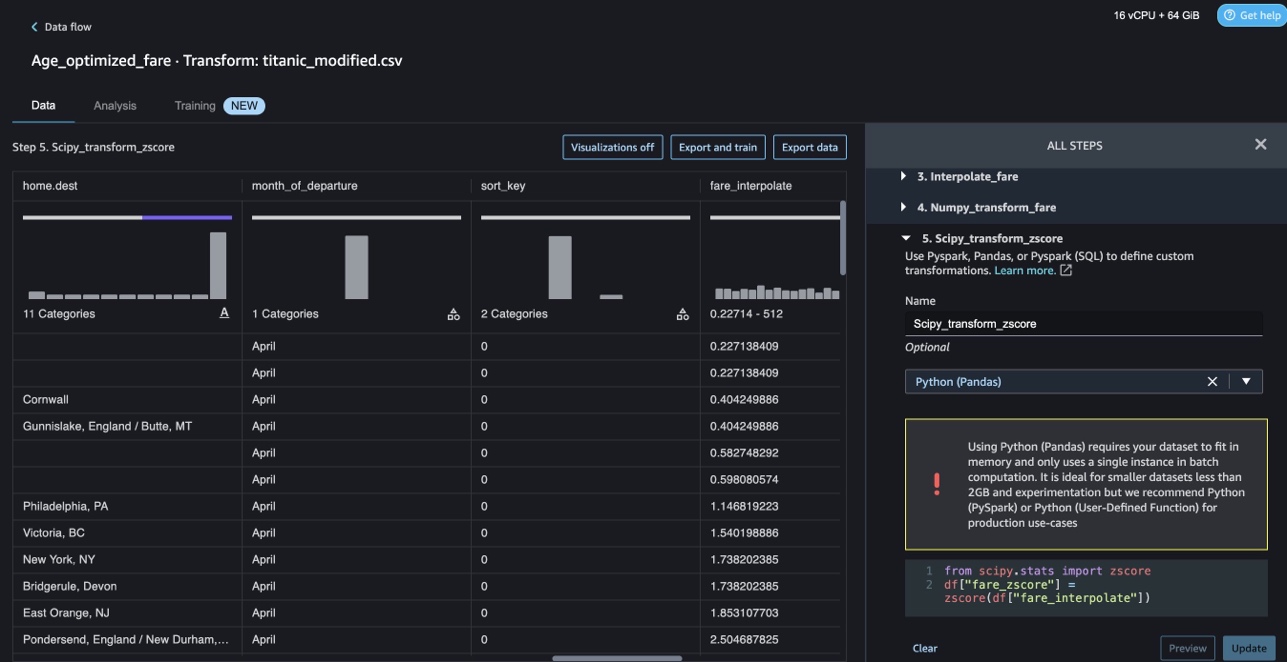

Trasformazioni SciPy

Le funzioni SciPy come z-score vengono applicate come parte della trasformazione personalizzata per standardizzare la distribuzione tariffaria con media e deviazione standard.

Vedi il seguente codice:

Ottimizzazione dei vincoli con NumPy e SciPy

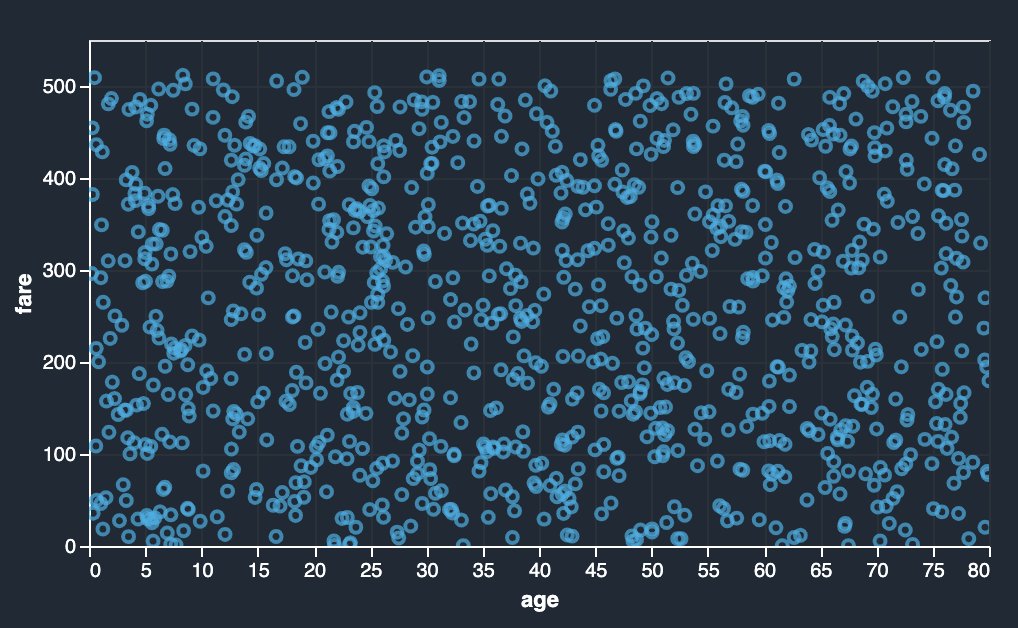

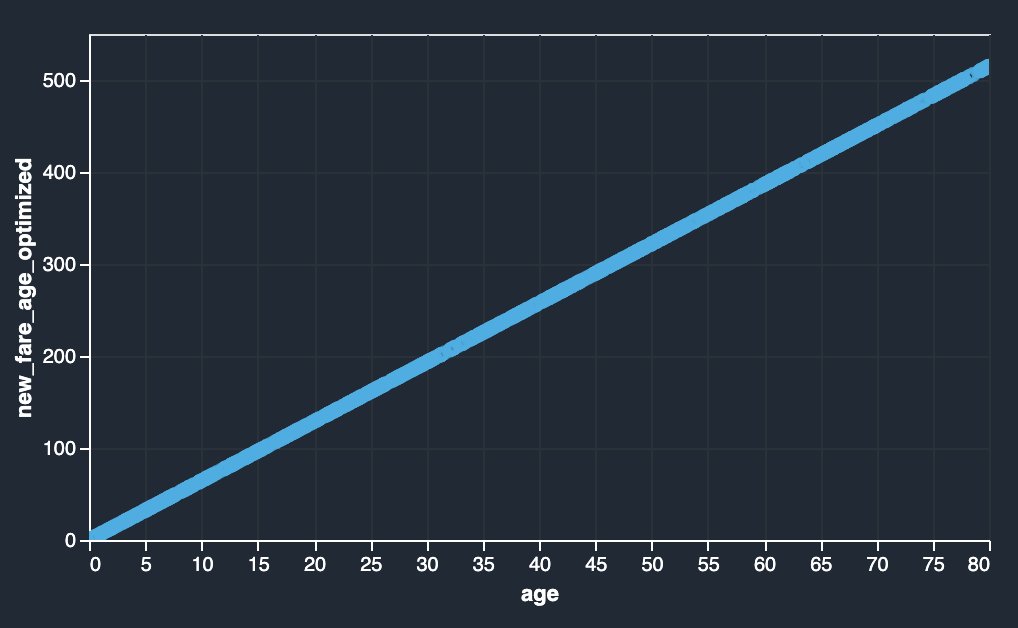

Le trasformazioni personalizzate di Data Wrangler possono gestire trasformazioni avanzate come l'ottimizzazione dei vincoli applicando le funzioni di ottimizzazione di SciPy e combinando SciPy con NumPy. Nell'esempio seguente, la tariffa in funzione dell'età non mostra alcuna tendenza osservabile. Tuttavia, l'ottimizzazione dei vincoli può trasformare la tariffa in funzione dell'età. La condizione di vincolo in questo caso è che la nuova tariffa totale rimanga la stessa della vecchia tariffa totale. Le trasformazioni personalizzate di Data Wrangler consentono di eseguire la funzione di ottimizzazione di SciPy per determinare il coefficiente ottimale che può trasformare la tariffa in funzione dell'età in condizioni di vincolo.

|

|

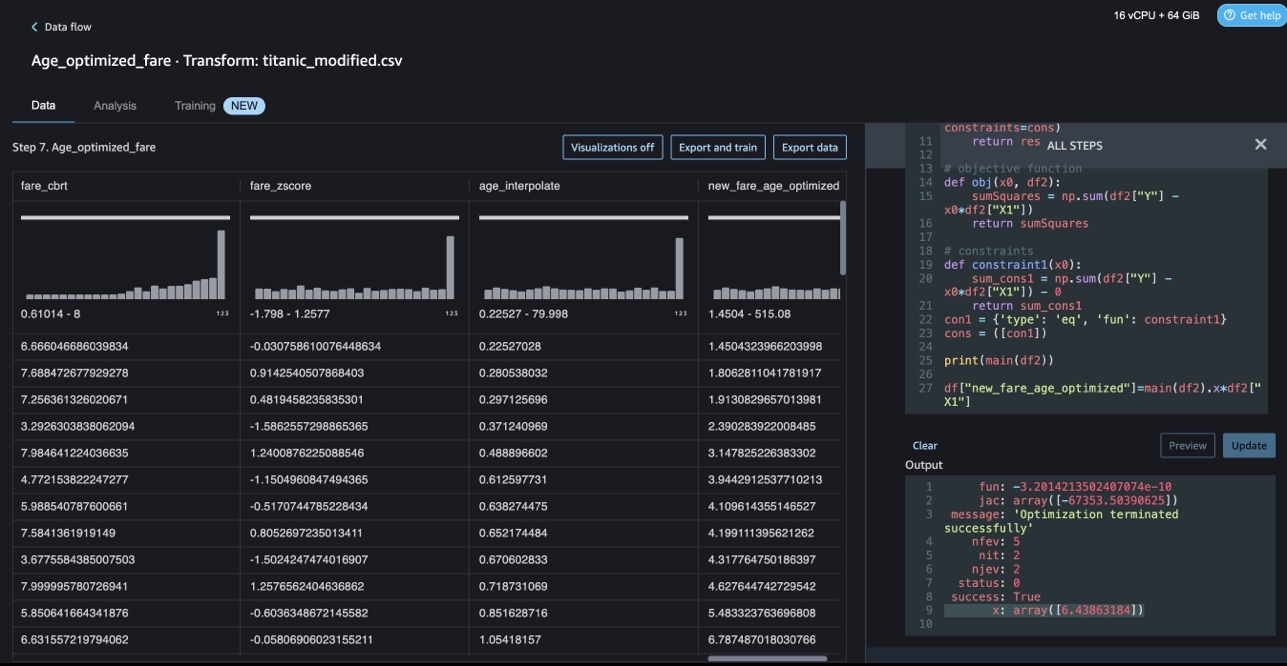

La definizione dell'ottimizzazione, la definizione dell'obiettivo e più vincoli possono essere menzionati come funzioni diverse durante la formulazione dell'ottimizzazione del vincolo in una trasformazione personalizzata di Data Wrangler usando SciPy e NumPy. Le trasformazioni personalizzate possono anche portare diversi metodi di risoluzione disponibili come parte del pacchetto di ottimizzazione di SciPy. Una nuova variabile trasformata può essere generata moltiplicando il coefficiente ottimale con la colonna originale e aggiunta alle colonne esistenti di Data Wrangler. Vedere il seguente codice:

La funzione di trasformazione personalizzata di Data Wrangler ha la capacità dell'interfaccia utente di mostrare i risultati delle funzioni di ottimizzazione di SciPy come il valore del coefficiente ottimale (o più coefficienti).

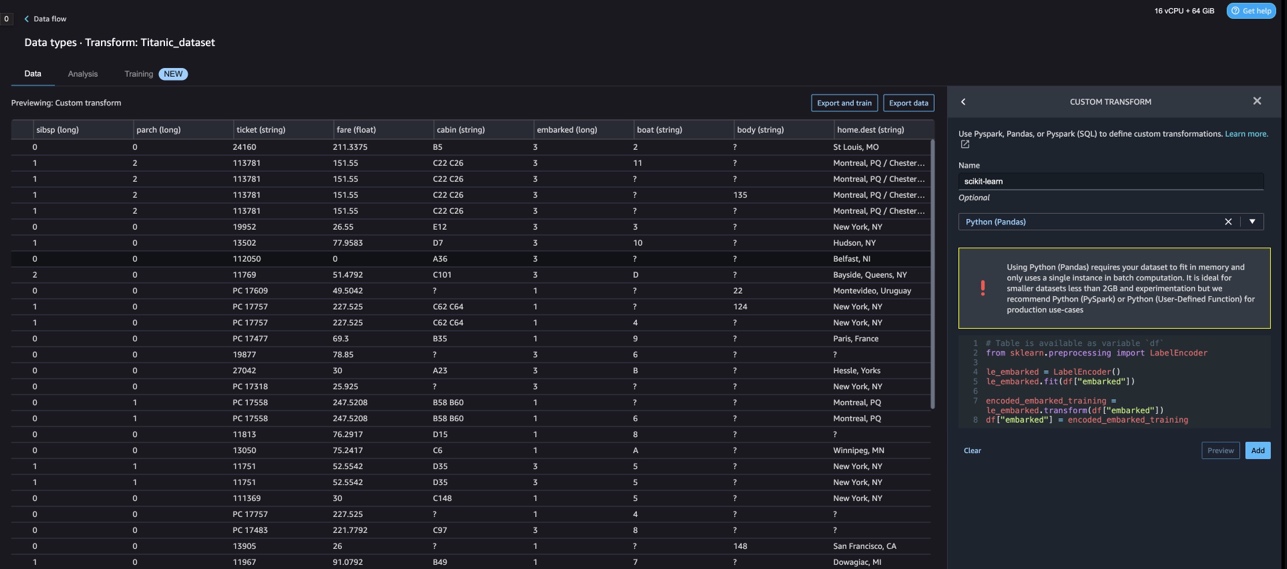

Trasformazioni personalizzate con scikit-learn

scikit-impara è un modulo Python per l'apprendimento automatico basato su SciPy. È una libreria ML open source che supporta l'apprendimento supervisionato e non supervisionato. Fornisce inoltre vari strumenti per l'adattamento del modello, la preelaborazione dei dati, la selezione del modello, la valutazione del modello e molte altre utilità.

Discretizzazione

Discretizzazione (altrimenti noto come quantizzazione or cestinare) fornisce un modo per suddividere le funzionalità continue in valori discreti. Alcuni set di dati con funzionalità continue possono trarre vantaggio dalla discretizzazione, poiché la discretizzazione può trasformare il set di dati di attributi continui in uno con solo attributi nominali. Le funzionalità discretizzate codificate one-hot possono rendere un modello più espressivo, pur mantenendo l'interpretabilità. Ad esempio, la preelaborazione con un discretizzatore può introdurre non linearità nei modelli lineari.

Nel codice seguente, usiamo KBinsDiscretizer per discretizzare la colonna dell'età in 10 contenitori:

Puoi vedere i bordi del cestino stampati nella seguente schermata.

Codifica one-hot

I valori nelle colonne Imbarcato sono valori categoriali. Pertanto, dobbiamo rappresentare queste stringhe come valori numerici per eseguire la nostra classificazione con il nostro modello. Potremmo anche farlo usando una trasformazione di codifica one-hot.

Ci sono tre valori per Embarked: S, C e Q. Li rappresentiamo con dei numeri. Vedere il seguente codice:

ripulire

Quando non utilizzi Data Wrangler, è importante chiudere l'istanza su cui viene eseguito per evitare costi aggiuntivi.

Data Wrangler salva automaticamente il flusso di dati ogni 60 secondi. Per evitare di perdere lavoro, salva il flusso di dati prima di chiudere Data Wrangler.

- Per salvare il flusso di dati in Studio, scegli Compila il , Quindi scegliere Salva il flusso di Wrangler dei dati.

- Per chiudere l'istanza di Data Wrangler, in Studio, scegli Esecuzione di istanze e kernel.

- Sotto APP IN ESECUZIONE, scegli l'icona di spegnimento accanto all'app sagemaker-data-wrangler-1.0.

- Scegli Chiudi tutto per confermare.

Data Wrangler viene eseguito su un'istanza ml.m5.4xlarge. Questa istanza scompare da ISTANZE DI CORSA quando chiudi l'app Data Wrangler.

Dopo aver chiuso l'app Data Wrangler, deve essere riavviata la prossima volta che apri un file di flusso Data Wrangler. Questo può richiedere alcuni minuti.

Conclusione

In questo post, abbiamo dimostrato come utilizzare le trasformazioni personalizzate in Data Wrangler. Abbiamo utilizzato le librerie e il framework all'interno del contenitore Data Wrangler per estendere le funzionalità di trasformazione dei dati integrate. Gli esempi in questo post rappresentano un sottoinsieme dei framework utilizzati. Le trasformazioni nel flusso Data Wrangler possono ora essere ridimensionate in una pipeline per DataOps.

Per ulteriori informazioni sull'utilizzo dei flussi di dati con Data Wrangler, fare riferimento a Creare e utilizzare un flusso di Data Wrangler ed Prezzi di Amazon SageMaker. Per iniziare con Data Wrangler, vedere Prepara i dati ML con Amazon SageMaker Data Wrangler. Per ulteriori informazioni su Autopilot e AutoML su SageMaker, visitare Automatizza lo sviluppo del modello con Amazon SageMaker Autopilot.

Circa gli autori

Meenakshisundaram Tandavarayan è uno specialista senior di AI/ML con AWS. Aiuta gli account strategici hi-tech nel loro viaggio di AI e ML. È molto appassionato di IA basata sui dati.

Meenakshisundaram Tandavarayan è uno specialista senior di AI/ML con AWS. Aiuta gli account strategici hi-tech nel loro viaggio di AI e ML. È molto appassionato di IA basata sui dati.

Sovik Kumar Nath è un architetto di soluzioni AI/ML con AWS. Ha una vasta esperienza in progetti e soluzioni end-to-end per il machine learning; analisi aziendale nell'ambito dell'analisi finanziaria, operativa e di marketing; assistenza sanitaria; catena di fornitura; e IoT. Al di fuori del lavoro, Sovik ama viaggiare e guardare film.

Sovik Kumar Nath è un architetto di soluzioni AI/ML con AWS. Ha una vasta esperienza in progetti e soluzioni end-to-end per il machine learning; analisi aziendale nell'ambito dell'analisi finanziaria, operativa e di marketing; assistenza sanitaria; catena di fornitura; e IoT. Al di fuori del lavoro, Sovik ama viaggiare e guardare film.

Abigail è un ingegnere di sviluppo software presso Amazon SageMaker. È appassionata di aiutare i clienti a preparare i propri dati in DataWrangler e creare sistemi di machine learning distribuiti. Nel tempo libero, Abigail ama viaggiare, fare escursioni, sciare e cucinare.

Abigail è un ingegnere di sviluppo software presso Amazon SageMaker. È appassionata di aiutare i clienti a preparare i propri dati in DataWrangler e creare sistemi di machine learning distribuiti. Nel tempo libero, Abigail ama viaggiare, fare escursioni, sciare e cucinare.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/authoring-custom-transformations-in-amazon-sagemaker-data-wrangler-using-nltk-and-scipy/

- :ha

- :È

- $ SU

- 1

- 10

- 100

- 7

- 8

- 9

- a

- WRI

- conti

- aggiunto

- aggiuntivo

- indirizzo

- Avanzate

- Dopo shavasana, sedersi in silenzio; saluti;

- Ages

- AI

- Servizi di intelligenza artificiale

- AI / ML

- Tutti

- consente

- lungo

- Sebbene il

- Amazon

- Amazon Comprehend

- Amazon Sage Maker

- Gestore di dati di Amazon SageMaker

- .

- analitica

- analizzare

- ed

- Andrea

- Un altro

- in qualsiasi

- Apache

- App

- applicazioni

- applicato

- AMMISSIONE

- approccio

- architettura

- SONO

- AS

- At

- gli attributi

- Autenticazione

- autore

- autore

- automaticamente

- AutoML

- disponibile

- AWS

- BE

- perché

- diventare

- stato

- prima

- beneficio

- BIN

- imbarco

- portare

- costruire

- Costruzione

- costruito

- incassato

- affari

- by

- Materiale

- funzionalità

- Custodie

- casi

- certo

- catena

- il cambiamento

- Modifiche

- Scegli

- classificazione

- codice

- codifica

- collezione

- Colonna

- colonne

- combinare

- combinando

- Uncommon

- comunità

- Aziende

- completamento di una

- comprendere

- globale

- informatica

- condizione

- condizioni

- Confermare

- Svantaggi

- vincoli

- contenere

- Contenitore

- contenuto

- continuo

- potuto

- Coppia

- creare

- costume

- Clienti

- dati

- analisi dei dati

- Preparazione dei dati

- data-driven

- dataset

- Predefinito

- dimostrato

- Design

- disegni

- Determinare

- in via di sviluppo

- Mercato

- sviluppa

- deviazione

- diverso

- scoperta

- discutere

- distribuito

- distribuzione

- documento

- documenti

- non

- dominio

- giù

- facilmente

- facile da usare

- efficiente

- o

- elementi

- da un capo all'altro

- ingegnere

- Ingegneria

- arricchendo

- entità

- entità

- Ambiente

- valutazione

- Ogni

- esempio

- Esempi

- Tranne

- Esercitare

- esistente

- esperienza

- espressivo

- estendere

- estensivo

- Conclamata Esperienza

- estratto

- FAST

- più veloce

- caratteristica

- Caratteristiche

- Costi

- pochi

- Compila il

- File

- finanziario

- adatto

- flusso

- flussi

- Focus

- messa a fuoco

- seguire

- i seguenti

- Nel

- formulando

- Contesto

- quadri

- Gratis

- Frequenza

- da

- ti divertirai

- function

- funzioni

- generare

- generato

- Generatori

- ottenere

- maniglia

- Avere

- he

- assistenza sanitaria

- aiutare

- aiuta

- hi-tech

- alto livello

- Casa

- Come

- Tuttavia

- HTML

- http

- HTTPS

- umano

- ICON

- identifica

- identificare

- Identità

- Immagine

- importare

- importante

- importazione

- miglioramento

- in

- In altre

- informazioni

- intuizioni

- install

- esempio

- integrare

- integrazione

- Intelligence

- interfacce

- introdurre

- IoT

- IT

- Lavoro

- viaggio

- jpg

- Le

- conosciuto

- Lingua

- Cognome

- principale

- IMPARARE

- apprendimento

- biblioteche

- Biblioteca

- piace

- piccolo

- a

- macchina

- machine learning

- Mantenere

- make

- molti

- Marketing

- massiccio

- matematico

- Maggio..

- menzionato

- metodi

- forza

- Minuti

- ML

- modello

- modelli

- Moduli

- moduli

- Scopri di più

- cambiano

- Film

- multiplo

- moltiplicando

- Nome

- nomi

- Naturale

- Elaborazione del linguaggio naturale

- Bisogno

- New

- GENERAZIONE

- nlp

- nodo

- nodi

- taccuino

- numero

- numeri

- numpy

- obiettivo

- of

- offerta

- Vecchio

- on

- Onboard

- Procedura di Onboarding

- ONE

- aprire

- open source

- operativa

- ottimale

- ottimizzazione

- OTTIMIZZA

- minimo

- i

- Altro

- altrimenti

- nostro

- al di fuori

- ancora

- proprio

- pacchetto

- Packages

- panda

- parte

- appassionato

- Eseguire

- Frasi

- conduttura

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- più

- Popolare

- Post

- pratiche

- Preparare

- Stampa

- lavorazione

- Produzione

- profiling

- Programmi

- fornire

- fornisce

- scopo

- Spingi

- Python

- qualità

- Presto

- casuale

- Crudo

- affidabile

- resti

- rappresentare

- risposta

- Risultati

- ritorno

- recensioni

- radice

- Correre

- s

- sagemaker

- stesso

- Set di dati di esempio

- Risparmi

- Scenari

- scientifico

- scikit-impara

- script

- secondo

- in modo sicuro

- prodotti

- anziano

- separato

- servizio

- Servizi

- impostazioni

- flessibile.

- Condividi

- dovrebbero

- mostrare attraverso le sue creazioni

- mostrato

- Spettacoli

- fermare

- chiusura

- segno

- Signal

- Un'espansione

- semplificare

- singolo

- Software

- lo sviluppo del software

- soluzione

- Soluzioni

- alcuni

- Fonte

- fonti

- Scintilla

- la nostra speciale

- specialista

- Spin

- dividere

- quadrato

- Standard

- inizia a

- iniziato

- stats

- step

- Passi

- conservazione

- memorizzare

- Strategico

- strutturazione

- studio

- tale

- suite

- fornire

- supply chain

- supporti

- SISTEMI DI TRATTAMENTO

- tavolo

- Fai

- presa

- Task

- Consulenza

- che

- Il

- L’ORIGINE

- loro

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- tre

- tempo

- a

- token

- tokenizzazione

- Tokens

- strumenti

- top

- Totale

- Trasformare

- Trasformazione

- trasformazioni

- trasformato

- trasformazione

- Di viaggio

- Trend

- ui

- per

- uso

- caso d'uso

- utilizzato

- utilità

- APPREZZIAMO

- Valori

- vario

- Visita

- guardare

- Modo..

- modi

- WELL

- quale

- while

- volere

- con

- entro

- senza

- parole

- Lavora

- flussi di lavoro

- scrivere

- scritto

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro