Gestore di dati di Amazon SageMaker ti aiuta a comprendere, aggregare, trasformare e preparare i dati per il machine learning (ML) da un'unica interfaccia visiva. Contiene oltre 300 trasformazioni di dati integrate in modo da poter normalizzare, trasformare e combinare rapidamente le funzionalità senza dover scrivere alcun codice.

I professionisti della scienza dei dati generano, osservano ed elaborano i dati per risolvere i problemi aziendali in cui devono trasformare ed estrarre funzionalità dai set di dati. Le trasformazioni come la codifica ordinale o la codifica one-hot apprendono le codifiche nel set di dati. Questi output codificati sono indicati come parametri addestrati. Poiché i set di dati cambiano nel tempo, potrebbe essere necessario riadattare le codifiche su dati mai visti prima per mantenere il flusso di trasformazione pertinente ai tuoi dati.

Siamo lieti di annunciare la funzione di riadattamento dei parametri addestrati, che consente di utilizzare i parametri precedentemente addestrati e riadattarli come desiderato. In questo post, dimostriamo come utilizzare questa funzione.

Panoramica della funzione di ripristino di Data Wrangler

Illustriamo come funziona questa funzione con l'esempio seguente, prima di approfondire le specifiche della funzione dei parametri addestrati per il refit.

Supponiamo che il set di dati del cliente abbia una caratteristica categorica per country rappresentato come stringhe come Australia ed Singapore. Gli algoritmi ML richiedono input numerici; pertanto, questi valori categorici devono essere codificati in valori numerici. La codifica dei dati categorici è il processo di creazione di una rappresentazione numerica per le categorie. Ad esempio, se la tua categoria country ha dei valori Australia ed Singapore, puoi codificare queste informazioni in due vettori: [1, 0] da rappresentare Australia e [0, 1] per rappresentare Singapore. La trasformazione utilizzata qui è la codifica one-hot e il nuovo output codificato riflette i parametri addestrati.

Dopo aver addestrato il modello, nel tempo i tuoi clienti potrebbero aumentare e avrai valori più distinti nell'elenco dei paesi. Il nuovo set di dati potrebbe contenere un'altra categoria, India, che non faceva parte del set di dati originale, il che può influire sulla precisione del modello. Pertanto, è necessario riqualificare il proprio modello con i nuovi dati che sono stati raccolti nel tempo.

Per superare questo problema, è necessario aggiornare la codifica per includere la nuova categoria e aggiornare la rappresentazione vettoriale in base all'ultimo set di dati. Nel nostro esempio, la codifica dovrebbe riflettere la nuova categoria per il country, Che ha India. Ci riferiamo comunemente a questo processo di aggiornamento di una codifica come a un'operazione di refit. Dopo aver eseguito l'operazione di refit, ottieni la nuova codifica: Australia: [1, 0, 0], Singapore: [0, 1, 0] e India: [0, 0, 1]. Il riadattamento della codifica one-hot e quindi il riaddestramento del modello sul nuovo set di dati si traduce in previsioni di qualità migliore.

La funzione di refit dei parametri addestrati di Data Wrangler è utile nei seguenti casi:

- Nuovi dati vengono aggiunti al set di dati – La riqualificazione del modello ML è necessaria quando il set di dati viene arricchito con nuovi dati. Per ottenere risultati ottimali, dobbiamo riadattare i parametri addestrati sul nuovo set di dati.

- Addestramento su un set di dati completo dopo aver eseguito la progettazione delle funzionalità sui dati di esempio – Per un set di dati di grandi dimensioni, viene preso in considerazione un campione del set di dati per l'apprendimento dei parametri addestrati, che potrebbero non rappresentare l'intero set di dati. Abbiamo bisogno di imparare di nuovo i parametri addestrati sul set di dati completo.

Di seguito sono elencate alcune delle trasformazioni di Data Wrangler più comuni eseguite sul set di dati che traggono vantaggio dall'opzione del parametro addestrato refit:

Per ulteriori informazioni sulle trasformazioni in Data Wrangler, fare riferimento a Trasforma i dati.

In questo post, mostriamo come elaborare questi parametri addestrati su set di dati utilizzando Data Wrangler. Puoi utilizzare i flussi di Data Wrangler nei processi di produzione per rielaborare i tuoi dati man mano che crescono e cambiano.

Panoramica della soluzione

Per questo post, dimostriamo come utilizzare la funzione dei parametri addestrati per il refit di Data Wrangler con il set di dati pubblicamente disponibile su Kaggle: Dati sugli alloggi negli Stati Uniti da Zillow, proprietà in vendita negli Stati Uniti. Ha i prezzi di vendita delle case in varie distribuzioni geografiche delle case.

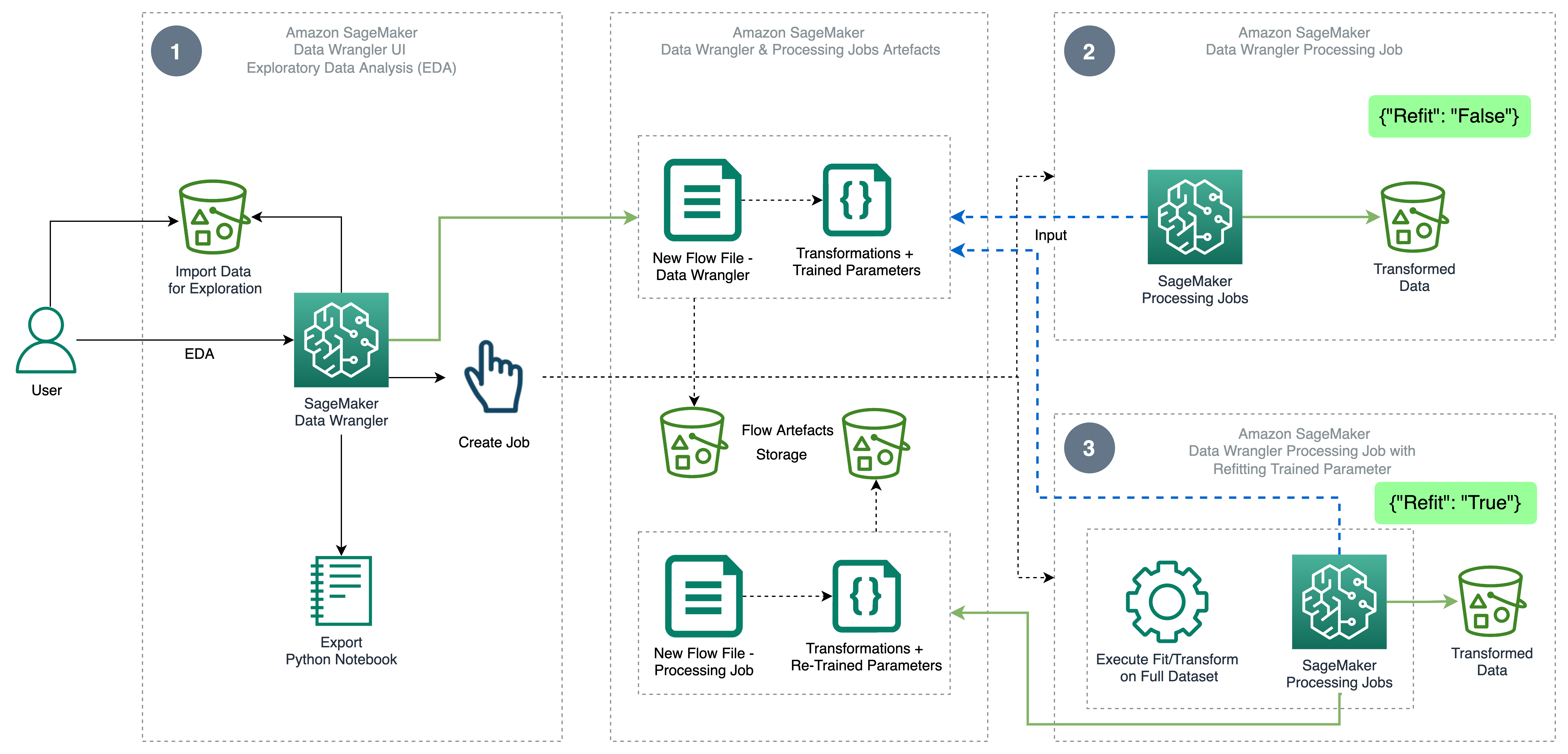

Il diagramma seguente illustra l'architettura di alto livello di Data Wrangler utilizzando la funzione di refit del parametro addestrato. Mostriamo anche l'effetto sulla qualità dei dati senza il parametro addestrato di refit e contrapponiamo i risultati alla fine.

Il flusso di lavoro include i seguenti passaggi:

- Eseguire analisi esplorative dei dati – Creare un nuovo flusso su Data Wrangler per avviare l'analisi esplorativa dei dati (EDA). Importa i dati aziendali per comprendere, pulire, aggregare, trasformare e preparare i tuoi dati per l'addestramento. Fare riferimento a Esplora le funzionalità di Amazon SageMaker Data Wrangler con set di dati di esempio per maggiori dettagli sull'esecuzione di EDA con Data Wrangler.

- Creare un processo di elaborazione dati – Questo passaggio esporta tutte le trasformazioni apportate al set di dati come file di flusso archiviato nel file configurato Servizio di archiviazione semplice Amazon (Amazon S3) posizione. Il processo di elaborazione dei dati con il file di flusso generato da Data Wrangler applica le trasformazioni e i parametri addestrati appresi nel set di dati. Al termine del processo di elaborazione dei dati, i file di output vengono caricati nella posizione Amazon S3 configurata nel nodo di destinazione. Si noti che l'opzione di riadattamento è disattivata per impostazione predefinita. In alternativa all'esecuzione istantanea del lavoro di elaborazione, puoi anche pianificare un lavoro di elaborazione in pochi clic utilizzando Data Wrangler – Create Job da eseguire in orari specifici.

- Creare un processo di elaborazione dati con la funzione di riadattamento dei parametri addestrati – Selezionare la nuova funzione di riadattamento dei parametri addestrati durante la creazione del lavoro per imporre il riapprendimento dei parametri addestrati sul set di dati completo o rinforzato. In base alla configurazione della posizione Amazon S3 per l'archiviazione del file di flusso, il processo di elaborazione dati crea o aggiorna il nuovo file di flusso. Se configuri la stessa posizione Amazon S3 come nel passaggio 2, il processo di elaborazione dei dati aggiorna il file di flusso generato nel passaggio 2, che può essere utilizzato per mantenere il flusso pertinente ai tuoi dati. Al termine del processo di elaborazione, i file di output vengono caricati nel bucket S3 configurato per il nodo di destinazione. Puoi utilizzare il flusso aggiornato sull'intero set di dati per un flusso di lavoro di produzione.

Prerequisiti

Prima di iniziare, carica il set di dati in un bucket S3, quindi importalo in Data Wrangler. Per istruzioni, fare riferimento a Importa dati da Amazon S3.

Esaminiamo ora i passaggi menzionati nel diagramma dell'architettura.

Esegui EDA in Data Wrangler

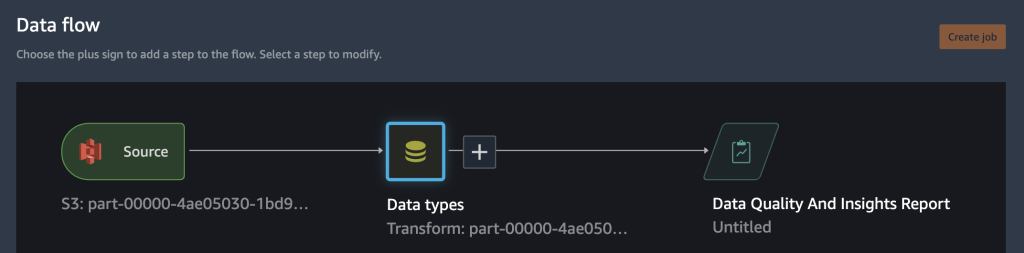

Per provare la funzione di riadattamento dei parametri addestrati, impostare la seguente analisi e trasformazione in Data Wrangler. Al termine della configurazione di EDA, Data Wrangler crea un file di flusso acquisito con parametri addestrati dal set di dati.

- Crea un nuovo flusso in Amazon SageMaker Data Wrangler per l'analisi esplorativa dei dati.

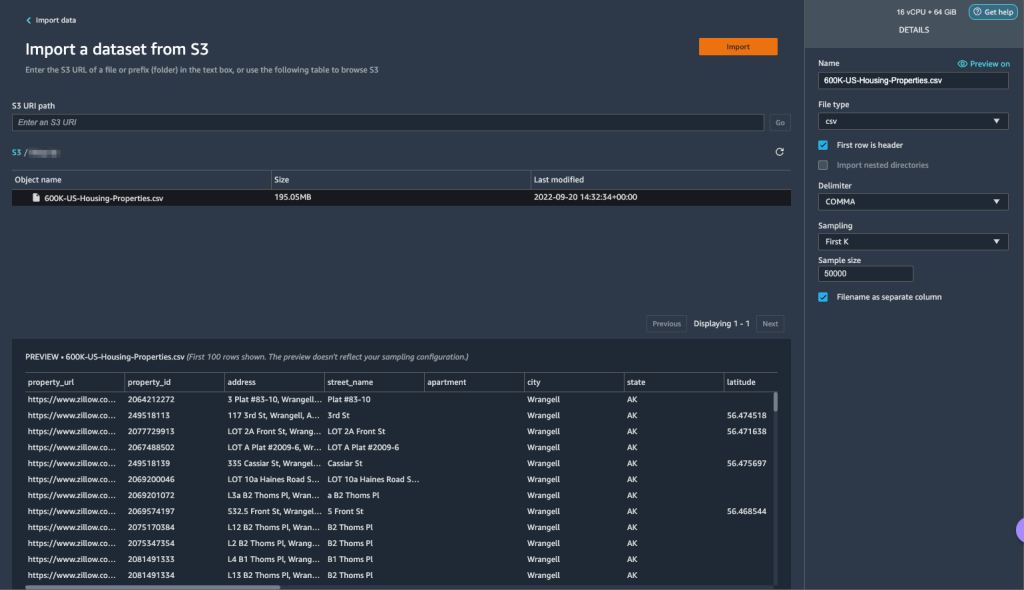

- Importa i dati aziendali che hai caricato su Amazon S3.

- È possibile visualizzare in anteprima i dati e le opzioni per la scelta del tipo di file, del delimitatore, del campionamento e così via. Per questo esempio, utilizziamo il Primo K opzione di campionamento fornita da Data Wrangler per importare i primi 50,000 record dal set di dati.

- Scegli Importare.

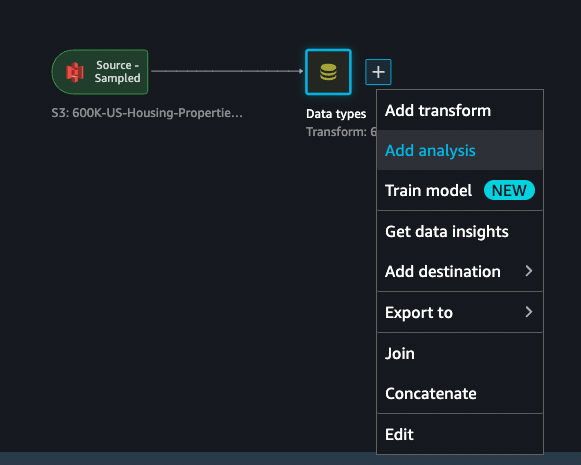

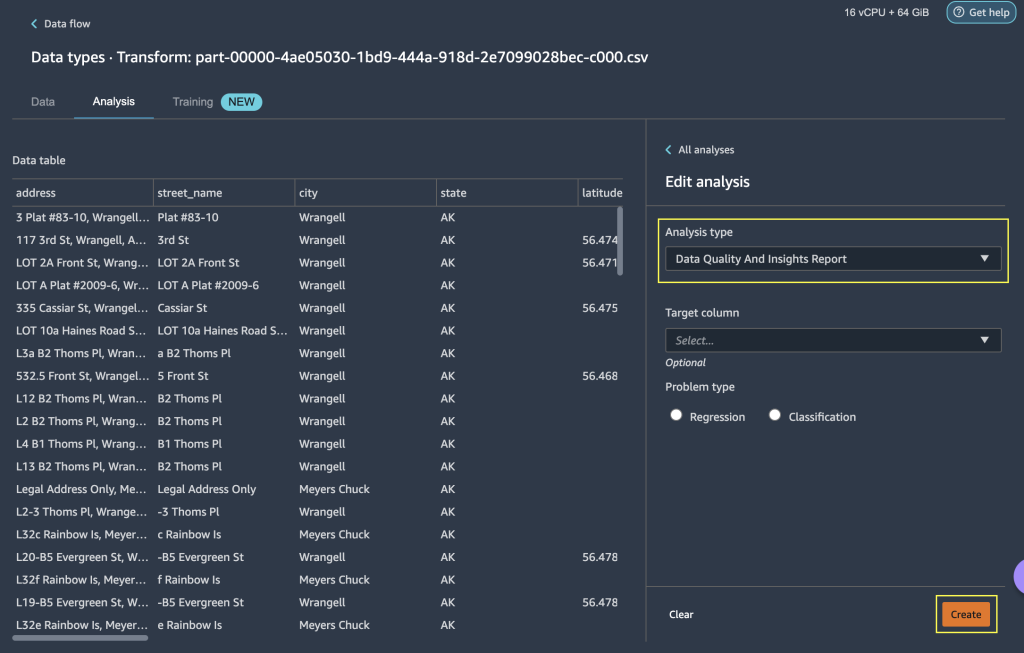

- Dopo aver controllato la corrispondenza del tipo di dati applicata da Data Wrangler, aggiungi una nuova analisi.

- Nel Tipo di analisiscegli Rapporto sulla qualità dei dati e sugli approfondimenti.

- Scegli Creare.

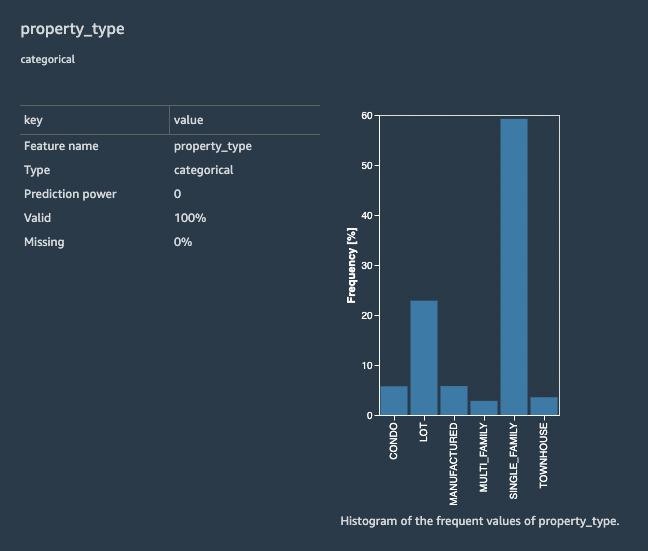

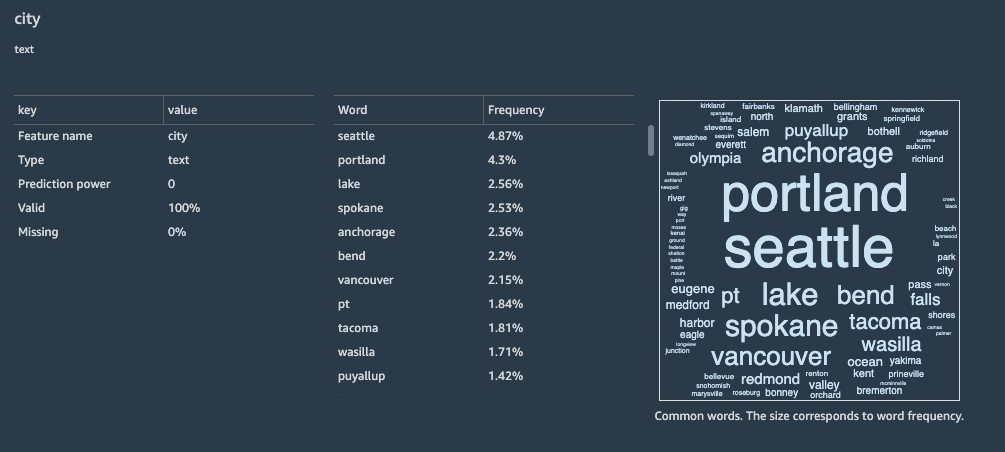

Con il rapporto sulla qualità dei dati e le informazioni dettagliate, ottieni un breve riepilogo del set di dati con informazioni generali come valori mancanti, valori non validi, tipi di funzionalità, conteggi anomali e altro ancora. Puoi scegliere le caratteristiche property_type ed city per applicare le trasformazioni al set di dati per comprendere la funzionalità del parametro addestrato di refit.

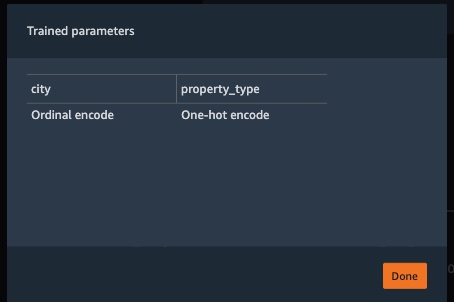

Concentriamoci sulla caratteristica property_type dal set di dati. Nel rapporto Caratteristica Dettagli sezione, puoi vedere il property_type, che è una caratteristica di categoria, e sei valori univoci derivati dal set di dati campionato di 50,000 da Data Wrangler. Il set di dati completo può avere più categorie per la funzione property_type. Per una funzione con molti valori univoci, potresti preferire la codifica ordinale. Se la funzione ha alcuni valori univoci, è possibile utilizzare un approccio di codifica one-hot. Per questo esempio, optiamo per la codifica one-hot attiva property_type.

Allo stesso modo, per city feature, che è un tipo di dati di testo con un numero elevato di valori univoci, applichiamo la codifica ordinale a questa funzione.

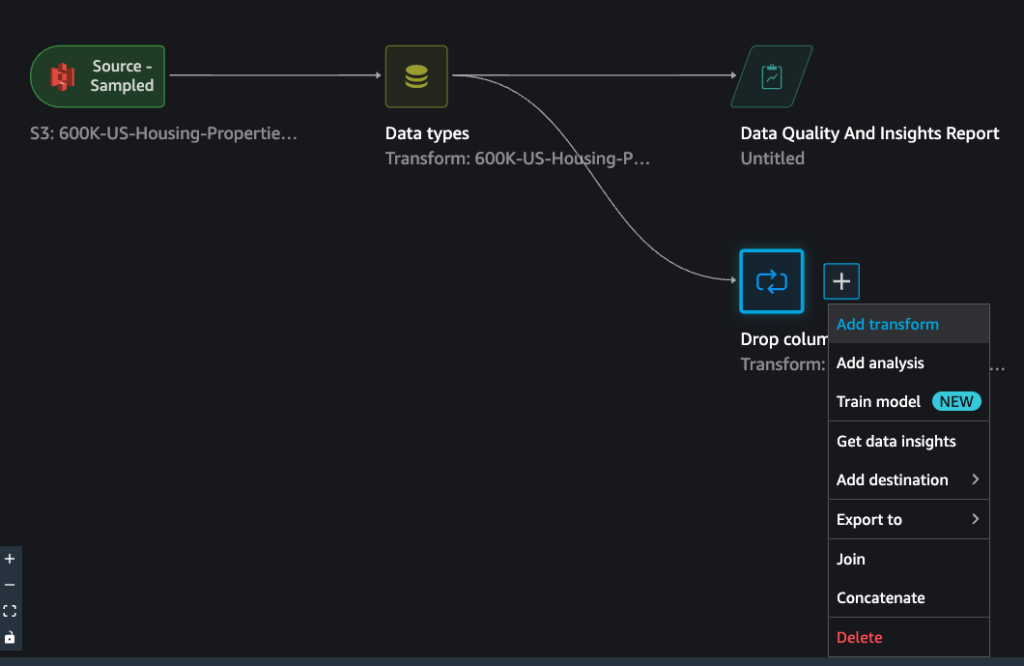

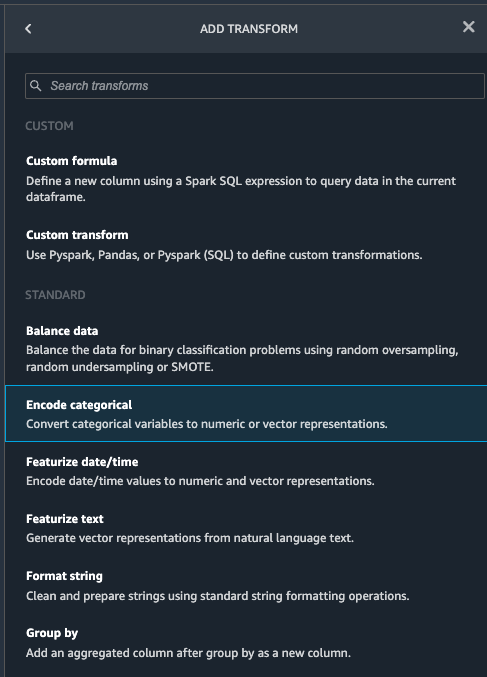

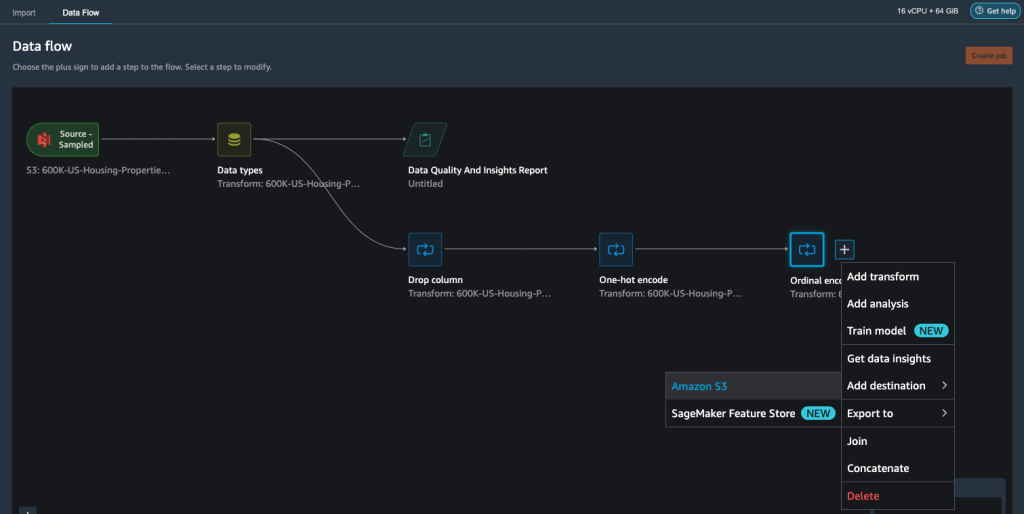

- Passa al flusso di Data Wrangler, scegli il segno più e scegli Aggiungi trasformazione.

- Scegliere il Codifica categoriale opzione per trasformare le caratteristiche categoriche.

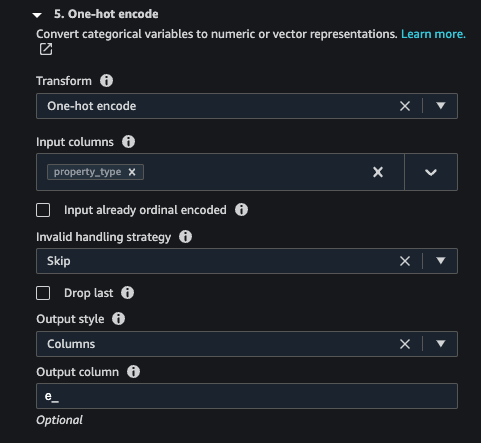

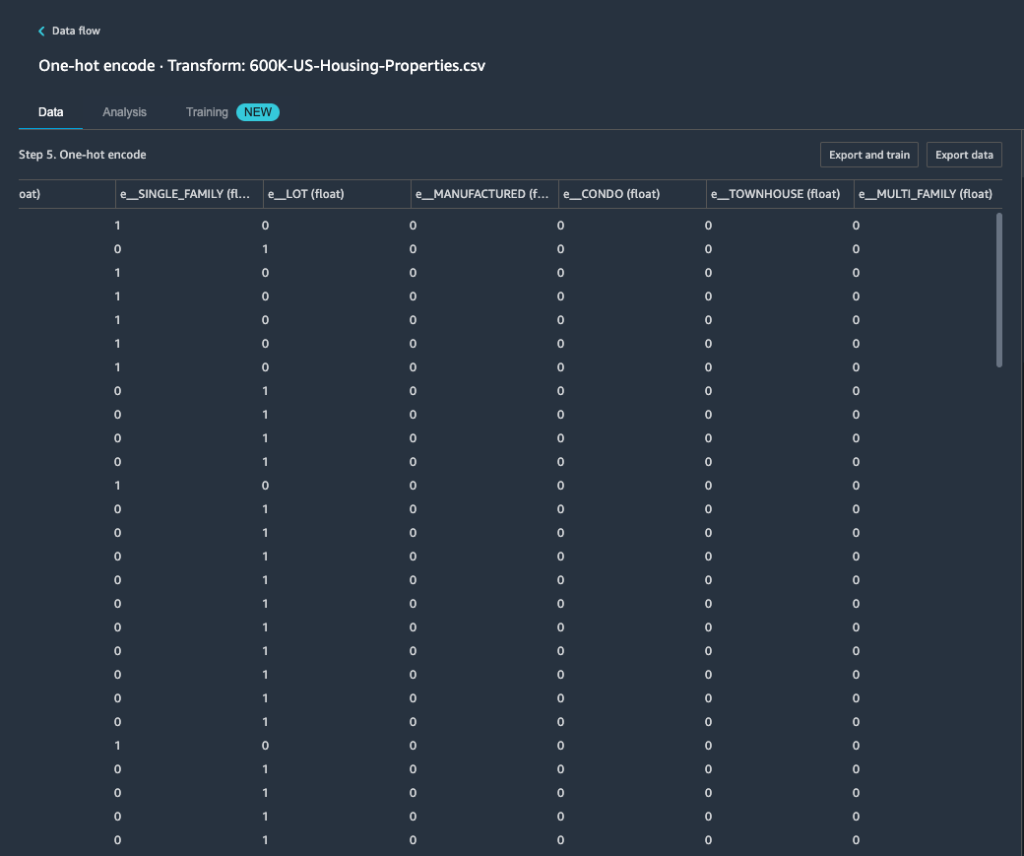

Dal rapporto Data Quality and Insights, feature property_type mostra sei categorie uniche: CONDO, LOT, MANUFACTURED, SINGLE_FAMILY, MULTI_FAMILYe TOWNHOUSE.

- Nel Trasformarescegli Codifica a caldo.

Dopo aver applicato la codifica one-hot su feature property_type, puoi visualizzare in anteprima tutte e sei le categorie come funzioni separate aggiunte come nuove colonne. Tieni presente che sono stati campionati 50,000 record dal tuo set di dati per generare questa anteprima. Durante l'esecuzione di un processo di elaborazione di Data Wrangler con questo flusso, queste trasformazioni vengono applicate all'intero set di dati.

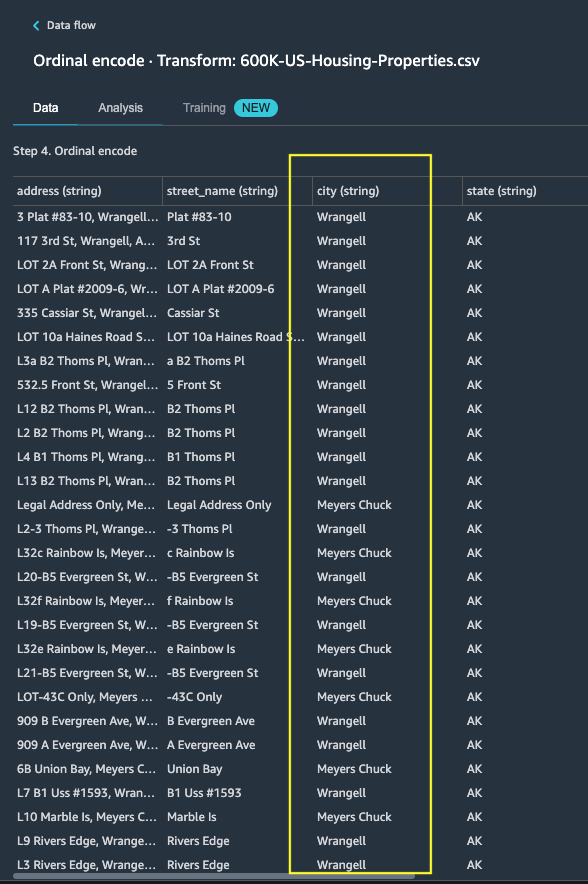

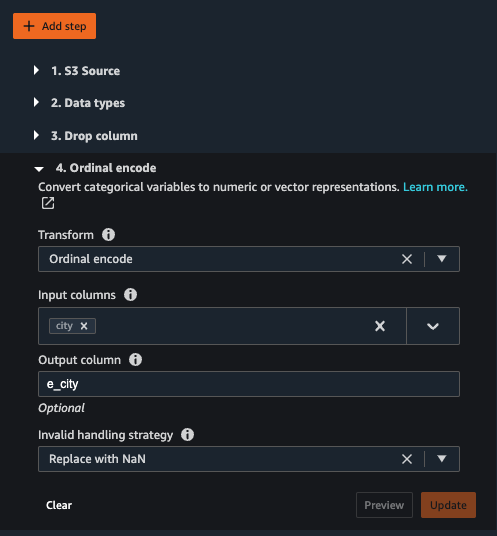

- Aggiungi una nuova trasformazione e scegli Codifica categoriale per applicare una trasformazione alla funzione

city, che ha un numero maggiore di valori di testo categoriali univoci. - Per codificare questa funzione in una rappresentazione numerica, scegliere Codifica ordinale per Trasformare.

- Scegli Anteprima su questa trasformazione.

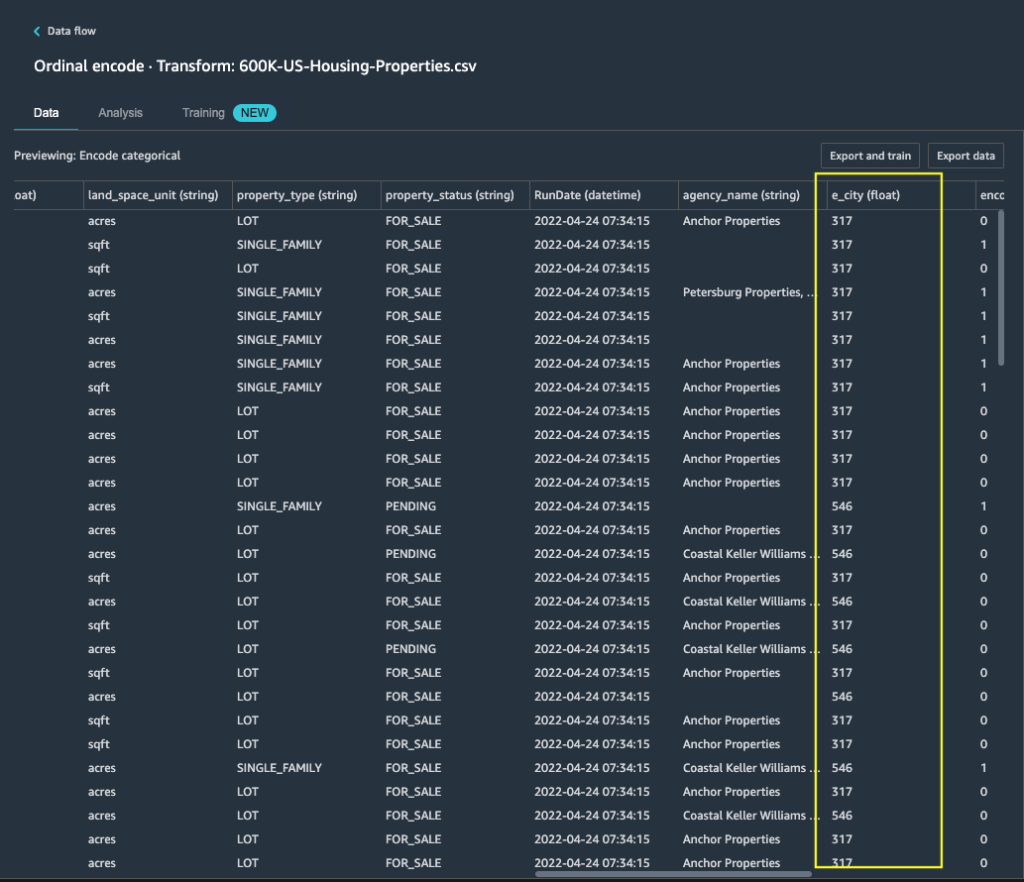

Puoi vedere che la caratteristica categorica city viene mappato ai valori ordinali nella colonna di output e_city.

- Aggiungi questo passaggio scegliendo Aggiornanento.

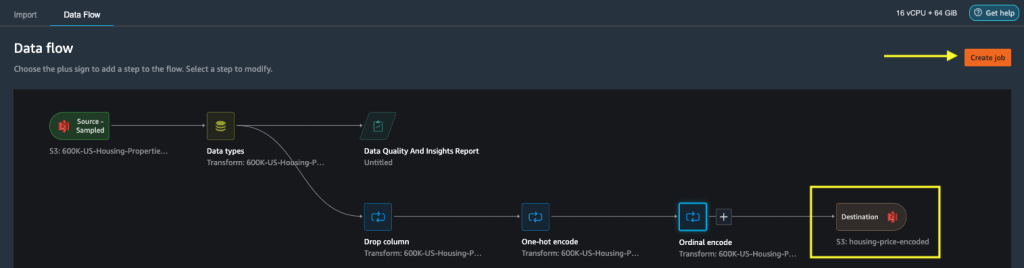

- Puoi impostare la destinazione su Amazon S3 per archiviare le trasformazioni applicate nel set di dati per generare l'output come file CSV.

Data Wrangler archivia il flusso di lavoro definito nell'interfaccia utente come un file di flusso e lo carica nella posizione Amazon S3 del processo di elaborazione dati configurato. Questo file di flusso viene utilizzato quando si creano lavori di elaborazione di Data Wrangler per applicare le trasformazioni a insiemi di dati più grandi o per trasformare nuovi dati di armatura per riqualificare il modello.

Avvia un processo di elaborazione dati Data Wrangler senza refit abilitato

Ora puoi vedere come l'opzione refit utilizza i parametri addestrati su nuovi set di dati. Per questa dimostrazione, definiamo due processi di elaborazione Data Wrangler che operano sugli stessi dati. Il primo processo di elaborazione non consentirà il ripristino; per il secondo lavoro di elaborazione, utilizziamo refit. Confrontiamo gli effetti alla fine.

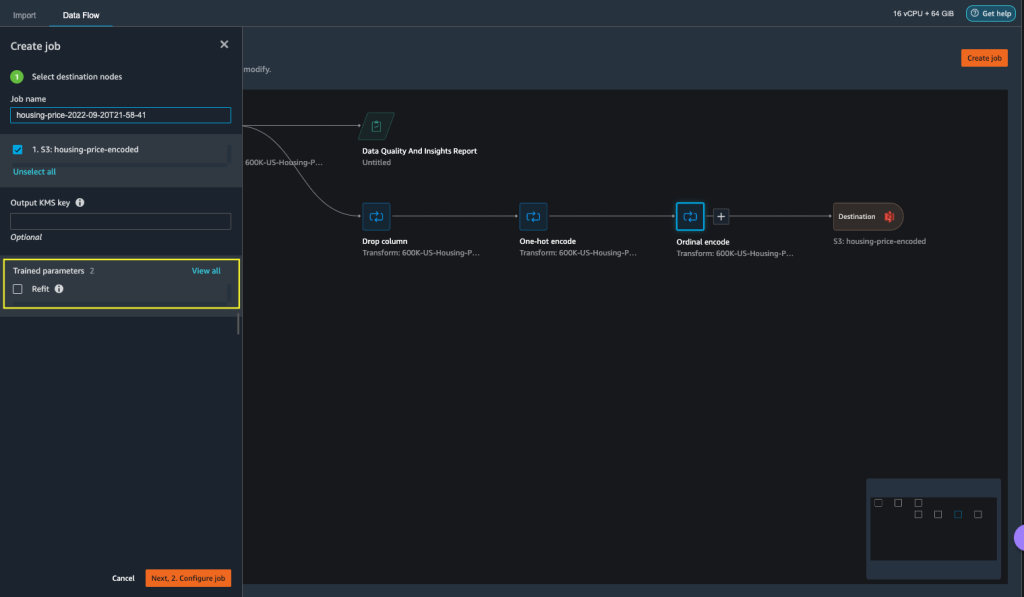

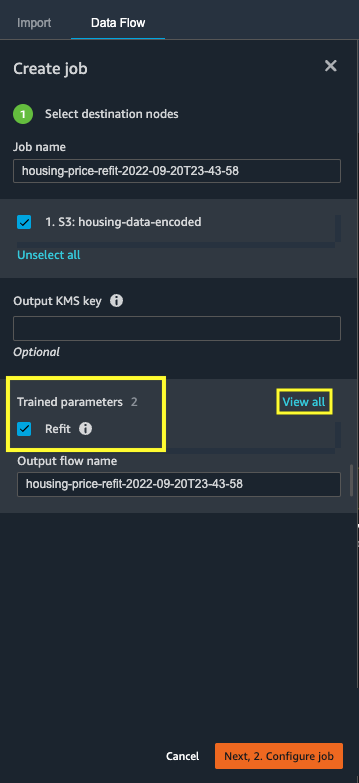

- Scegli Crea lavoro per avviare un processo di elaborazione dati con Data Wrangler.

- Nel Nome del lavoro, inserisci un nome.

- Sotto Parametri addestrati, non selezionare Rimontare.

- Scegli Configura lavoro.

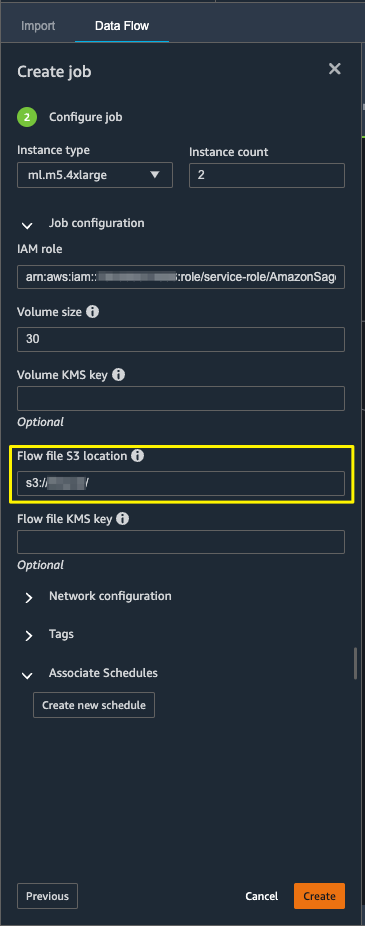

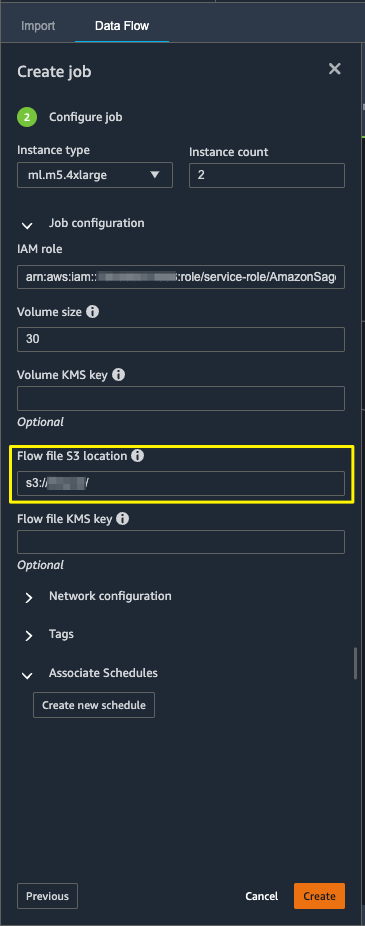

- Configura i parametri del processo come i tipi di istanza, le dimensioni del volume e la posizione Amazon S3 per l'archiviazione del file di flusso di output.

- Data Wrangler crea un file di flusso nella posizione S3 del file di flusso. Il flusso utilizza le trasformazioni per addestrare i parametri e in seguito utilizziamo l'opzione refit per riaddestrare questi parametri.

- Scegli Creare.

Attendi il completamento del processo di elaborazione dei dati per visualizzare i dati trasformati nel bucket S3 configurato nel nodo di destinazione.

Avvia un processo di elaborazione dei dati di Data Wrangler con il refit abilitato

Creiamo un altro processo di elaborazione abilitato con la funzione di parametro addestrato refit abilitata. Questa opzione applica i parametri appresi di nuovo all'intero set di dati. Al termine di questo processo di elaborazione dei dati, viene creato o aggiornato un file di flusso nella posizione Amazon S3 configurata.

- Scegli Crea lavoro.

- Nel Nome del lavoro, inserisci un nome.

- Nel Parametri addestrati, selezionare Rimontare.

- Se si sceglie Vedi tutto, puoi rivedere tutti i parametri addestrati.

- Scegli Configura lavoro.

- Inserisci il percorso del file di flusso Amazon S3.

- Scegli Creare.

Attendere il completamento del processo di elaborazione dei dati.

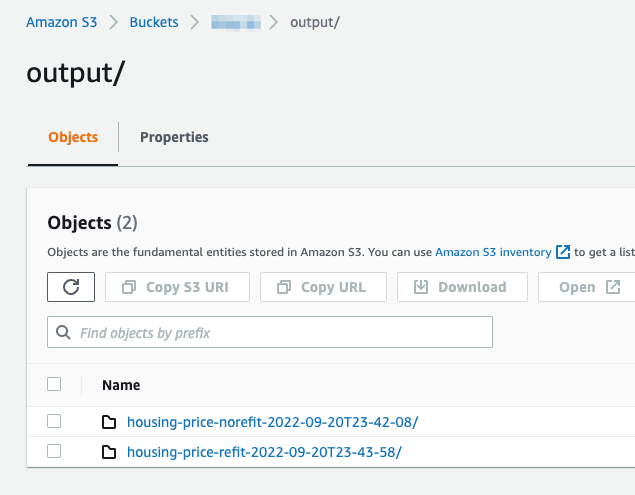

Fare riferimento al bucket S3 configurato nel nodo di destinazione per visualizzare i dati generati dal processo di elaborazione dati che esegue le trasformazioni definite.

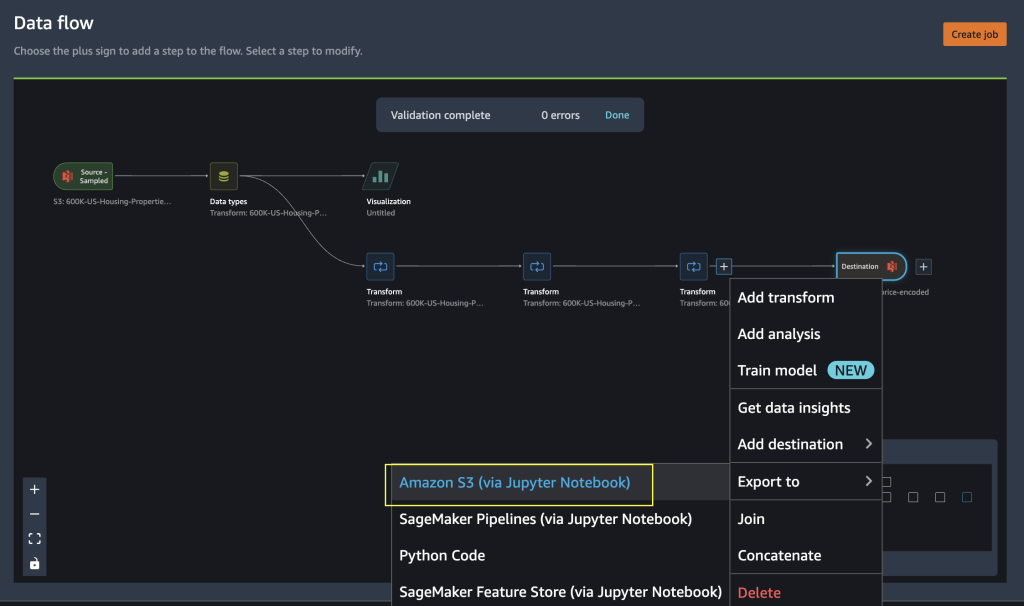

Esporta in codice Python per eseguire lavori di elaborazione di Data Wrangler

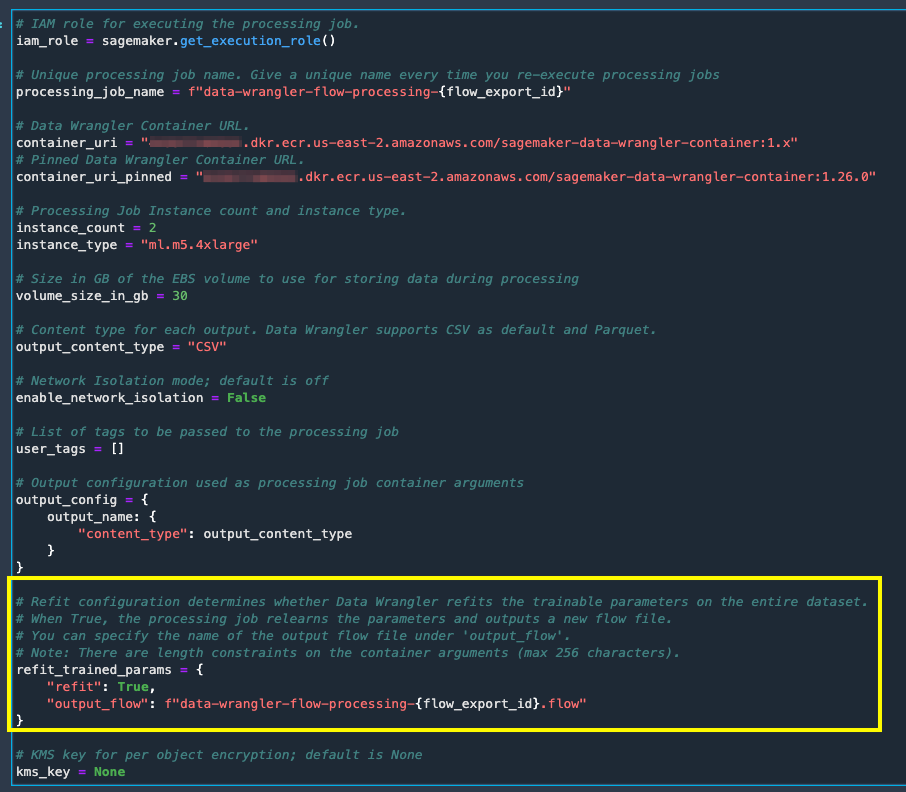

In alternativa all'avvio dei processi di elaborazione utilizzando l'opzione Crea processo in Data Wrangler, puoi attivare i processi di elaborazione dati esportando il flusso di Data Wrangler in un notebook Jupyter. Data Wrangler genera un notebook Jupyter con input, output, elaborazione delle configurazioni dei processi e codice per i controlli dello stato dei processi. È possibile modificare o aggiornare i parametri in base ai requisiti di trasformazione dei dati.

- Scegli il segno più accanto alla finale Trasformare nodo.

- Scegli Esportare ae Amazon S3 (tramite notebook Jupyter).

È possibile visualizzare un notebook Jupyter aperto con input, output, elaborazione delle configurazioni dei processi e codice per i controlli dello stato dei processi.

- Per applicare l'opzione di riadattamento dei parametri addestrati tramite codice, impostare il file

refitparametroTrue.

Confronta i risultati del lavoro di elaborazione dei dati

Confronta i risultati del lavoro di elaborazione dei dati

Dopo che i lavori di elaborazione di Data Wrangler sono stati completati, devi creare due nuovi flussi di Data Wrangler con l'output generato dai lavori di elaborazione dati archiviati nella destinazione Amazon S3 configurata.

Puoi fare riferimento alla posizione configurata nella cartella di destinazione di Amazon S3 per esaminare gli output dei processi di elaborazione dei dati.

Per ispezionare i risultati del processo di elaborazione, crea due nuovi flussi Data Wrangler utilizzando il report Data Quality and Insights per confrontare i risultati della trasformazione.

- Crea un nuovo flusso in Amazon SageMaker Data Wrangler.

- Importa il processo di elaborazione dati senza ripristinare il file di output abilitato da Amazon S3.

- Aggiungi una nuova analisi.

- Nel Tipo di analisiscegli Rapporto sulla qualità dei dati e sugli approfondimenti.

- Scegli Creare.

Ripetere i passaggi precedenti e creare un nuovo flusso di data wrangler per analizzare l'output del lavoro di elaborazione dati con refit abilitato.

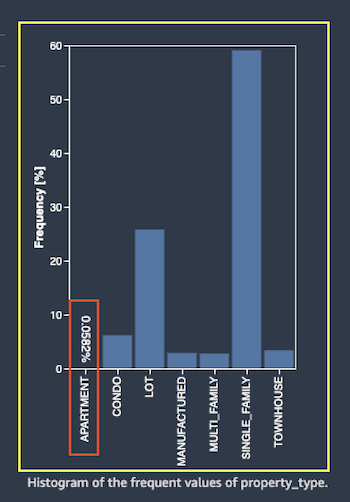

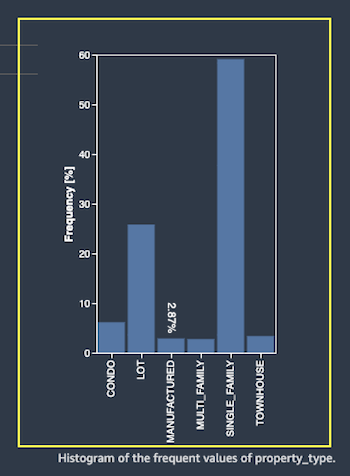

Ora diamo un'occhiata agli output dell'elaborazione dei lavori per la funzione property_type utilizzando i report Data Quality e Insights. Scorri fino ai dettagli della funzione nell'elenco dei rapporti sui dati e approfondimenti feature_type.

Il processo di elaborazione dei parametri addestrati refit ha riadattato i parametri addestrati sull'intero set di dati e ha codificato il nuovo valore APARTMENT con sette valori distinti sul set di dati completo.

Il normale processo di elaborazione ha applicato i parametri addestrati del set di dati di esempio, che hanno solo sei valori distinti per il property_type caratteristica. Per i dati con feature_type APARTMENT, le strategia di gestione non valida Ignora viene applicato e il processo di elaborazione dati non apprende questa nuova categoria. La codifica one-hot ha saltato questa nuova categoria presente sui nuovi dati e la codifica salta la categoria APARTMENT.

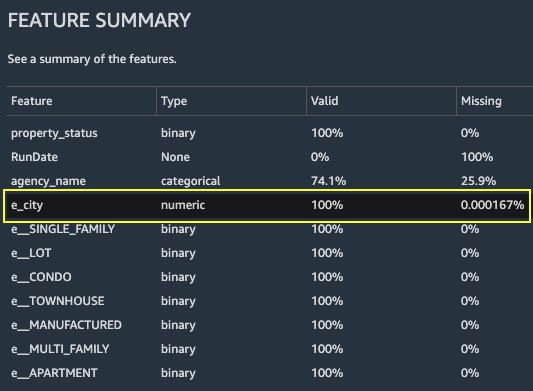

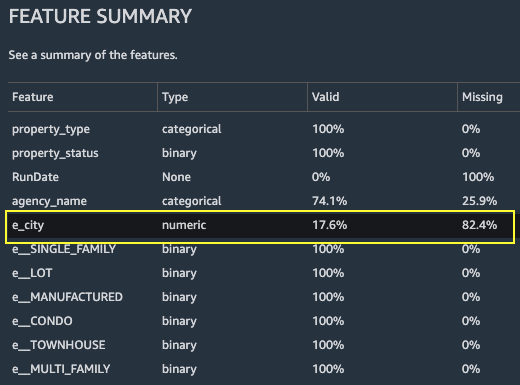

Concentriamoci ora su un'altra caratteristica, city. Il processo di elaborazione del parametro addestrato refit ha riappreso tutti i valori disponibili per il city caratteristica, considerando i nuovi dati.

Come mostrato in Riepilogo delle funzionalità sezione del rapporto, la nuova colonna delle caratteristiche codificate e_city dispone di parametri validi al 100% utilizzando la funzione di refit dei parametri addestrati.

Al contrario, il normale processo di elaborazione ha l'82.4% dei valori mancanti nella nuova colonna della funzione codificata e_city. Questo fenomeno è dovuto al fatto che solo il set campione di parametri addestrati appresi viene applicato al set di dati completo e non viene applicato alcun refitting dal processo di elaborazione dei dati.

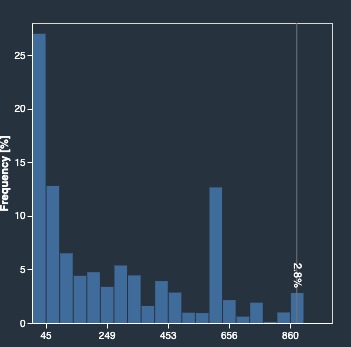

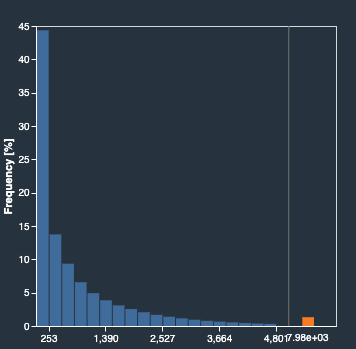

I seguenti istogrammi descrivono la caratteristica codificata ordinale e_city. Il primo istogramma è della caratteristica trasformata con l'opzione refit.

L'istogramma successivo è dell'elemento trasformato senza l'opzione di refit. La colonna arancione mostra i valori mancanti (NaN) nel rapporto sulla qualità dei dati e sugli approfondimenti. I nuovi valori non appresi dal set di dati di esempio vengono sostituiti come Not a Number (NaN) come configurato nell'interfaccia utente di Data Wrangler strategia di gestione non valida.

Il lavoro di elaborazione dati con il parametro addestrato refit ha riappreso il file property_type ed city caratteristiche considerando i nuovi valori dell'intero set di dati. Senza il parametro addestrato refit, il processo di elaborazione dati utilizza solo i parametri addestrati pre-appresi del set di dati campionato. Quindi li applica ai nuovi dati, ma i nuovi valori non vengono considerati per la codifica. Ciò avrà implicazioni sulla precisione del modello.

ripulire

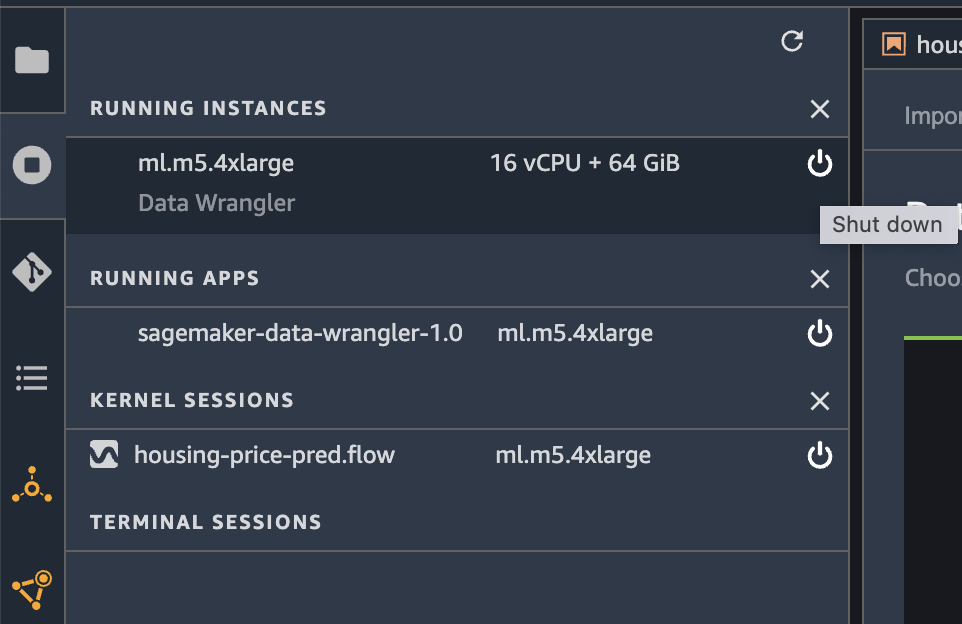

Quando non utilizzi Data Wrangler, è importante chiudere l'istanza su cui viene eseguito per evitare costi aggiuntivi.

Per evitare di perdere il lavoro, salva il flusso di dati prima di spegnere Data Wrangler.

- Per salvare il flusso di dati in Amazon Sage Maker Studioscegli Compila il , Quindi scegliere Salva il flusso di Wrangler dei dati. Data Wrangler salva automaticamente il flusso di dati ogni 60 secondi.

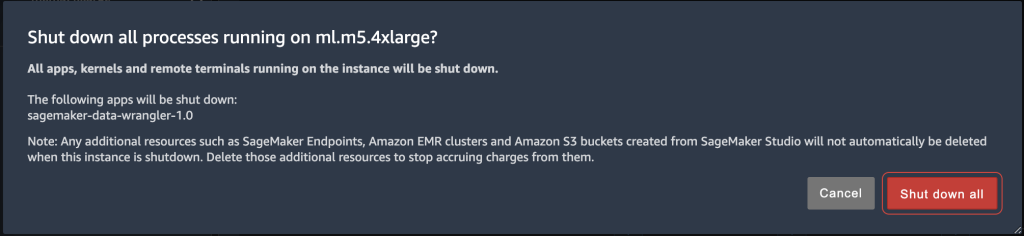

- Per chiudere l'istanza di Data Wrangler, in Studio, scegli Esecuzione di istanze e kernel.

- Sotto APP IN ESECUZIONE, scegli l'icona di spegnimento accanto all'app sagemaker-data-wrangler-1.0.

- Scegli Chiudi tutto per confermare.

Data Wrangler viene eseguito su un'istanza ml.m5.4xlarge. Questa istanza scompare da ISTANZE DI CORSA quando chiudi l'app Data Wrangler.

Dopo aver chiuso l'app Data Wrangler, deve essere riavviata la prossima volta che apri un file di flusso Data Wrangler. Questo può richiedere alcuni minuti.

Conclusione

In questo post, abbiamo fornito una panoramica della funzionalità dei parametri addestrati per il refit in Data Wrangler. Con questa nuova funzionalità, puoi archiviare i parametri addestrati nel flusso Data Wrangler e i processi di elaborazione dei dati utilizzano i parametri addestrati per applicare le trasformazioni apprese su set di dati di grandi dimensioni o set di dati di rinforzo. È possibile applicare questa opzione alla vettorializzazione delle caratteristiche del testo, ai dati numerici e alla gestione dei valori anomali.

La conservazione dei parametri addestrati durante l'elaborazione dei dati del ciclo di vita di ML semplifica e riduce le fasi di elaborazione dei dati, supporta una solida progettazione delle funzionalità e supporta l'addestramento del modello e l'addestramento di rinforzo sui nuovi dati.

Ti invitiamo a provare questa nuova funzionalità per i tuoi requisiti di elaborazione dei dati.

Circa gli autori

Hariharan Suresh è Senior Solutions Architect presso AWS. È appassionato di database, machine learning e progettazione di soluzioni innovative. Prima di entrare in AWS, Hariharan è stato architetto di prodotti, specialista dell'implementazione di core banking e sviluppatore e ha lavorato con organizzazioni BFSI per oltre 11 anni. Al di fuori della tecnologia, ama il parapendio e il ciclismo.

Hariharan Suresh è Senior Solutions Architect presso AWS. È appassionato di database, machine learning e progettazione di soluzioni innovative. Prima di entrare in AWS, Hariharan è stato architetto di prodotti, specialista dell'implementazione di core banking e sviluppatore e ha lavorato con organizzazioni BFSI per oltre 11 anni. Al di fuori della tecnologia, ama il parapendio e il ciclismo.

Santosh Kulkarni è un Enterprise Solutions Architect presso Amazon Web Services che lavora con clienti sportivi in Australia. È appassionato di creazione di applicazioni distribuite su larga scala per risolvere problemi aziendali utilizzando le sue conoscenze in AI/ML, big data e sviluppo software.

Santosh Kulkarni è un Enterprise Solutions Architect presso Amazon Web Services che lavora con clienti sportivi in Australia. È appassionato di creazione di applicazioni distribuite su larga scala per risolvere problemi aziendali utilizzando le sue conoscenze in AI/ML, big data e sviluppo software.

Vishaal Kapoor è un Senior Applied Scientist con AWS AI. È appassionato di aiutare i clienti a comprendere i loro dati in Data Wrangler. Nel tempo libero va in mountain bike, fa snowboard e trascorre il tempo con la sua famiglia.

Vishaal Kapoor è un Senior Applied Scientist con AWS AI. È appassionato di aiutare i clienti a comprendere i loro dati in Data Wrangler. Nel tempo libero va in mountain bike, fa snowboard e trascorre il tempo con la sua famiglia.

Aniketh Manjunath è un ingegnere di sviluppo software presso Amazon SageMaker. Aiuta a supportare Amazon SageMaker Data Wrangler ed è appassionato di sistemi di machine learning distribuiti. Al di fuori del lavoro, ama fare escursioni, guardare film e giocare a cricket.

Aniketh Manjunath è un ingegnere di sviluppo software presso Amazon SageMaker. Aiuta a supportare Amazon SageMaker Data Wrangler ed è appassionato di sistemi di machine learning distribuiti. Al di fuori del lavoro, ama fare escursioni, guardare film e giocare a cricket.

- AI

- oh arte

- generatore d'arte

- un robot

- Amazon Sage Maker

- Gestore di dati di Amazon SageMaker

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- Apprendimento automatico di AWS

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- Intermedio (200)

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- zefiro