AI generativa I modelli hanno il potenziale per rivoluzionare le operazioni aziendali, ma le aziende devono considerare attentamente come sfruttare il proprio potere superando sfide come la salvaguardia dei dati e la garanzia della qualità dei contenuti generati dall’intelligenza artificiale.

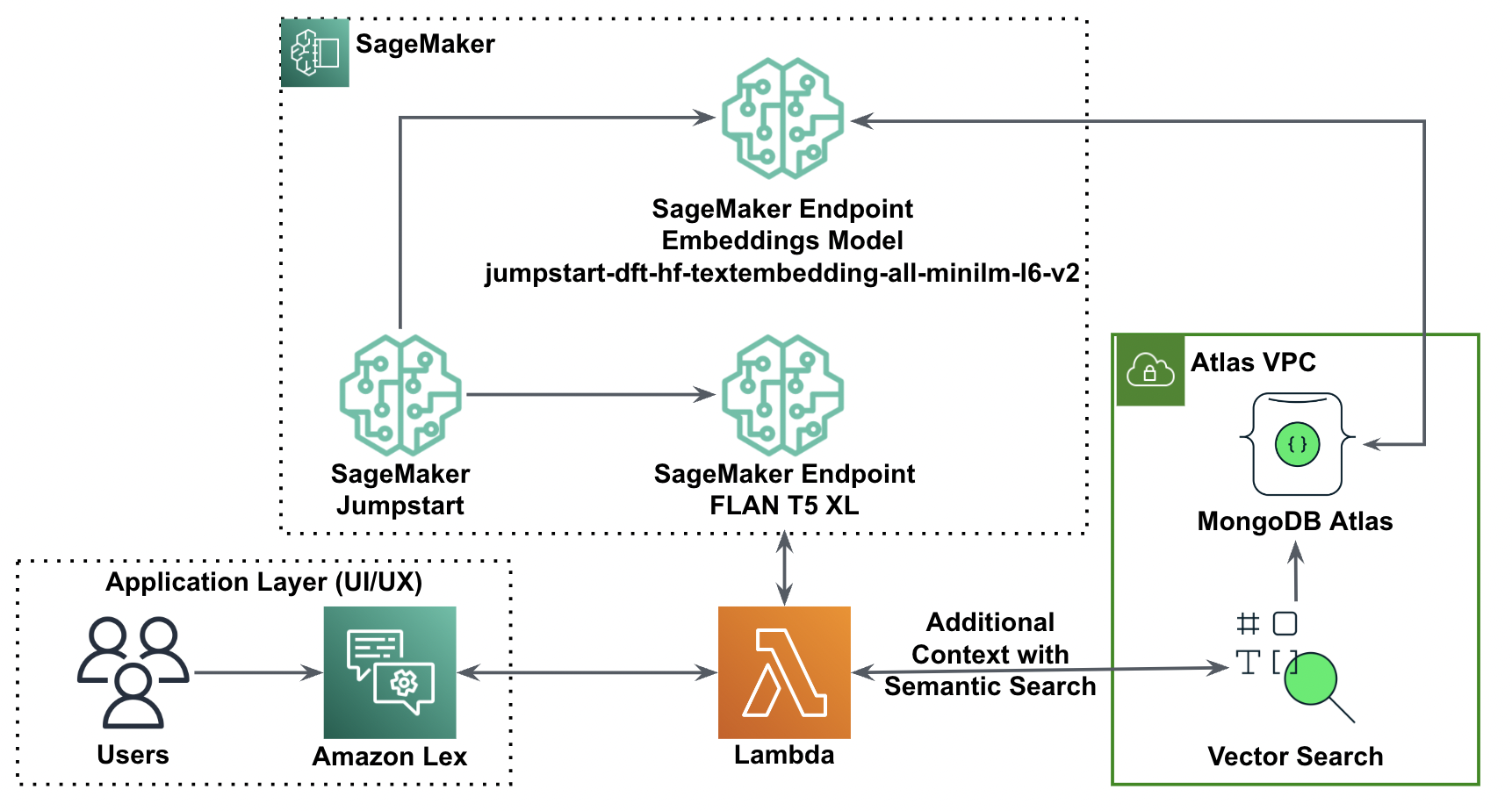

Il framework RAG (Retrieval-Augmented Generation) integra i prompt con dati esterni provenienti da più fonti, come repository di documenti, database o API, per rendere efficaci i modelli di base per attività specifiche del dominio. Questo post presenta le funzionalità del modello RAG ed evidenzia il potenziale di trasformazione di MongoDB Atlas con la sua funzionalità di ricerca vettoriale.

Atlante MongoDB è una suite integrata di servizi dati che accelera e semplifica lo sviluppo di applicazioni basate sui dati. Il suo archivio di dati vettoriali si integra perfettamente con l'archiviazione dei dati operativi, eliminando la necessità di un database separato. Questa integrazione consente potenti funzionalità di ricerca semantica attraverso Ricerca vettoriale, un modo rapido per creare ricerca semantica e applicazioni basate sull'intelligenza artificiale.

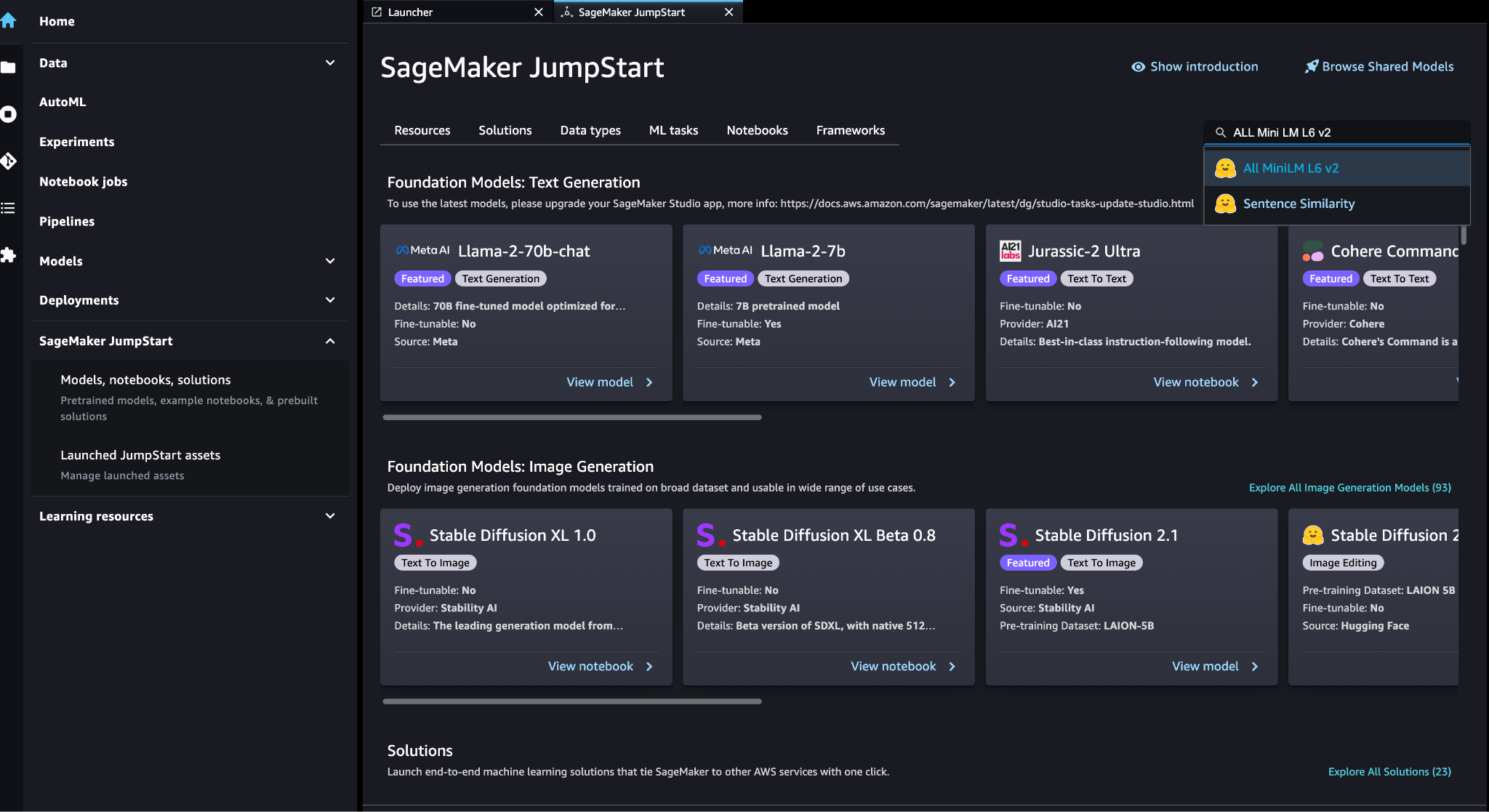

Amazon Sage Maker consente alle aziende di creare, addestrare e distribuire modelli di machine learning (ML). JumpStart di Amazon SageMaker fornisce modelli e dati preaddestrati per aiutarti a iniziare con il machine learning. Puoi accedere, personalizzare e distribuire modelli e dati pre-addestrati tramite la pagina di destinazione JumpStart di SageMaker in Amazon Sage Maker Studio con pochi clic.

Amazon-Lex è un'interfaccia conversazionale che aiuta le aziende a creare chatbot e bot vocali che si impegnano in interazioni naturali e realistiche. Integrando Amazon Lex con l'intelligenza artificiale generativa, le aziende possono creare un ecosistema olistico in cui l'input degli utenti si trasforma senza problemi in risposte coerenti e contestualmente rilevanti.

Panoramica della soluzione

Il diagramma seguente illustra l'architettura della soluzione.

Nelle sezioni seguenti vengono illustrati i passaggi per implementare questa soluzione e i suoi componenti.

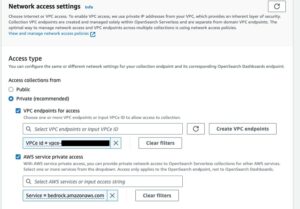

Configura un cluster MongoDB

Per creare un cluster MongoDB Atlas di livello gratuito, seguire le istruzioni in Crea un cluster. Configura il database accesso e rete accesso.

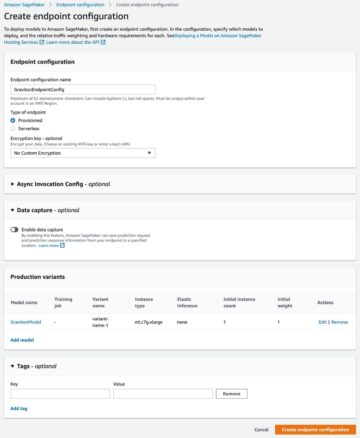

Distribuisci il modello di incorporamento SageMaker

È possibile scegliere il modello di incorporamento (TUTTI MiniLM L6 v2) sul SageMaker JumpStart Modelli, notebook, soluzioni .

Scegli Schierare per distribuire il modello.

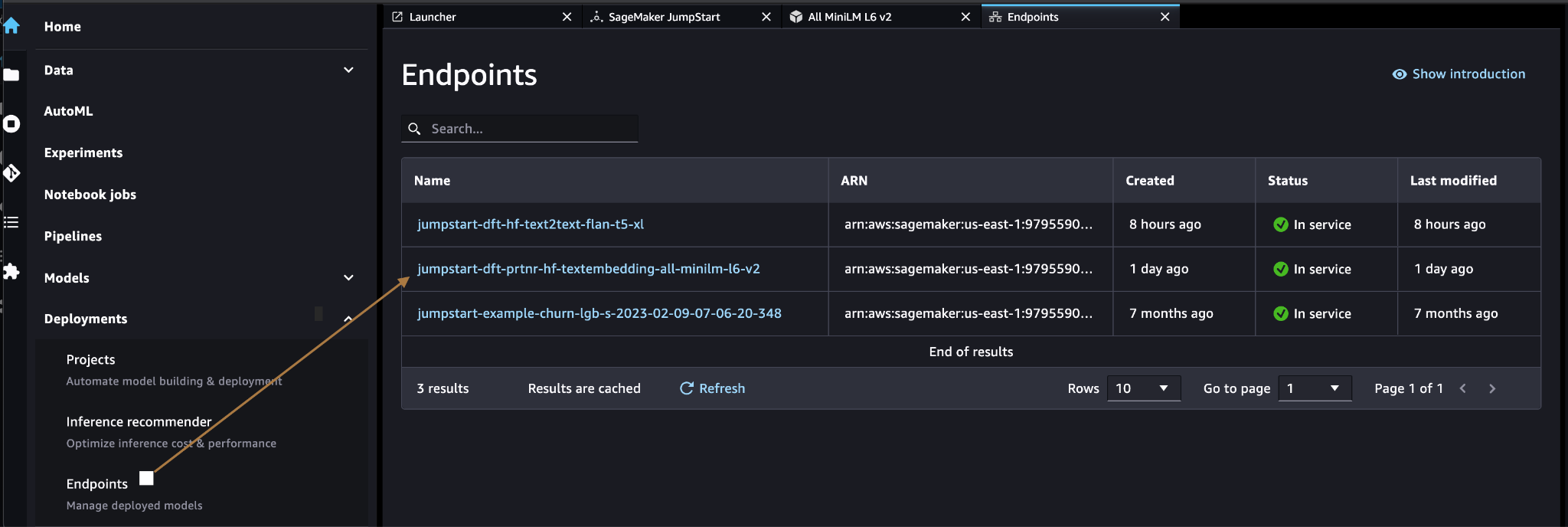

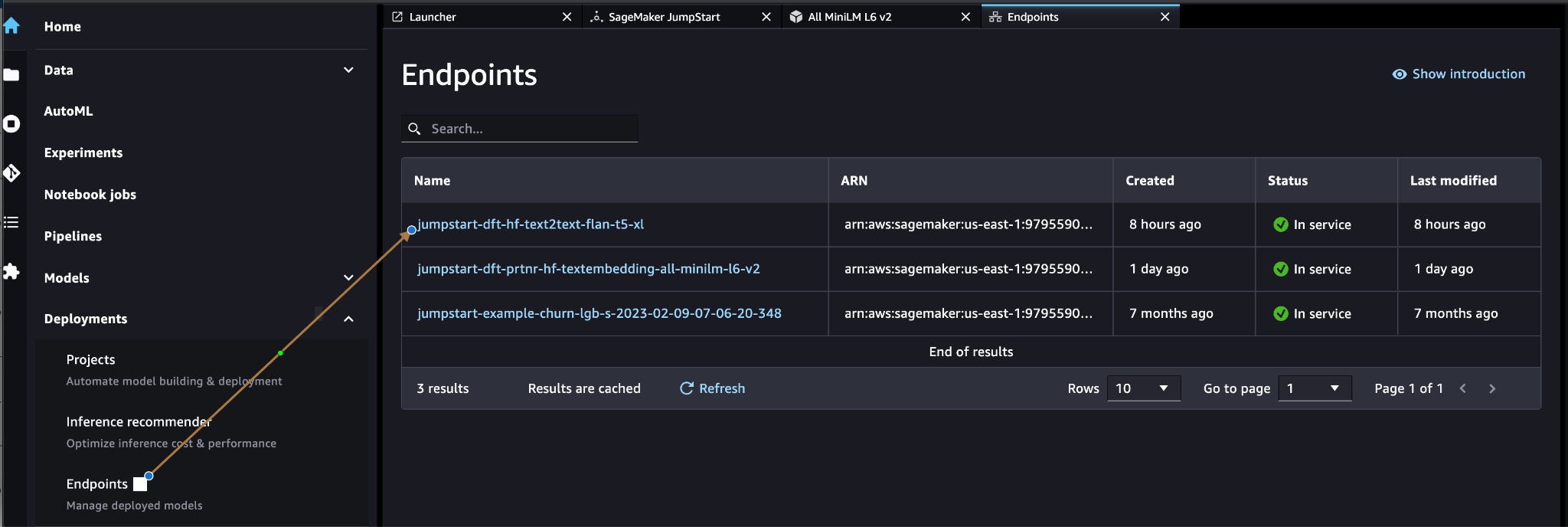

Verificare che il modello sia stato distribuito correttamente e verificare che l'endpoint sia stato creato.

Incorporamento di vettori

Incorporamento di vettori è un processo di conversione di un testo o di un'immagine in una rappresentazione vettoriale. Con il seguente codice possiamo generare incorporamenti di vettori con SageMaker JumpStart e aggiornare la raccolta con il vettore creato per ogni documento:

payload = {"text_inputs": [document[field_name_to_be_vectorized]]}

query_response = query_endpoint_with_json_payload(json.dumps(payload).encode('utf-8'))

embeddings = parse_response_multiple_texts(query_response) # update the document

update = {'$set': {vector_field_name : embeddings[0]}}

collection.update_one(query, update)Il codice sopra mostra come aggiornare un singolo oggetto in una raccolta. Per aggiornare tutti gli oggetti seguire il istruzioni.

Archivio dati vettoriali MongoDB

Ricerca vettoriale Atlas MongoDB è una nuova funzionalità che ti consente di archiviare e cercare dati vettoriali in MongoDB. I dati vettoriali sono un tipo di dati che rappresentano un punto in uno spazio ad alta dimensione. Questo tipo di dati viene spesso utilizzato nelle applicazioni ML e di intelligenza artificiale. MongoDB Atlas Vector Search utilizza una tecnica chiamata k-vicini più vicini (k-NN) per cercare vettori simili. k-NN funziona trovando i k vettori più simili a un dato vettore. I vettori più simili sono quelli più vicini al vettore dato in termini di distanza euclidea.

L'archiviazione dei dati vettoriali accanto ai dati operativi può migliorare le prestazioni riducendo la necessità di spostare i dati tra diversi sistemi di archiviazione. Ciò è particolarmente vantaggioso per le applicazioni che richiedono l'accesso in tempo reale ai dati vettoriali.

Crea un indice di ricerca vettoriale

Il prossimo passo è creare un Indice di ricerca vettoriale MongoDB sul campo vettoriale creato nel passaggio precedente. MongoDB utilizza il knnVector digitare per indicizzare gli incorporamenti di vettori. Il campo vettoriale deve essere rappresentato come una matrice di numeri (solo tipi di dati BSON int32, int64 o double).

Fare riferimento a Esaminare le limitazioni del tipo di vettore knn per ulteriori informazioni sulle limitazioni di knnVector tipo.

Il codice seguente è una definizione di indice di esempio:

{ "mappings": { "dynamic": true, "fields": { "egVector": { "dimensions": 384, "similarity": "euclidean", "type": "knnVector" } } }

}

Tieni presente che la dimensione deve corrispondere alla dimensione del modello di incorporamento.

Interrogare l'archivio dati vettoriali

È possibile eseguire query sull'archivio dati vettoriali utilizzando il file Pipeline di aggregazione di ricerca vettoriale. Utilizza l'indice di ricerca vettoriale ed esegue a ricerca semantica nell'archivio dati vettoriali.

Il codice seguente è una definizione di ricerca di esempio:

{ $search: { "index": "<index name>", // optional, defaults to "default" "knnBeta": { "vector": [<array-of-numbers>], "path": "<field-to-search>", "filter": {<filter-specification>}, "k": <number>, "score": {<options>} } }

}

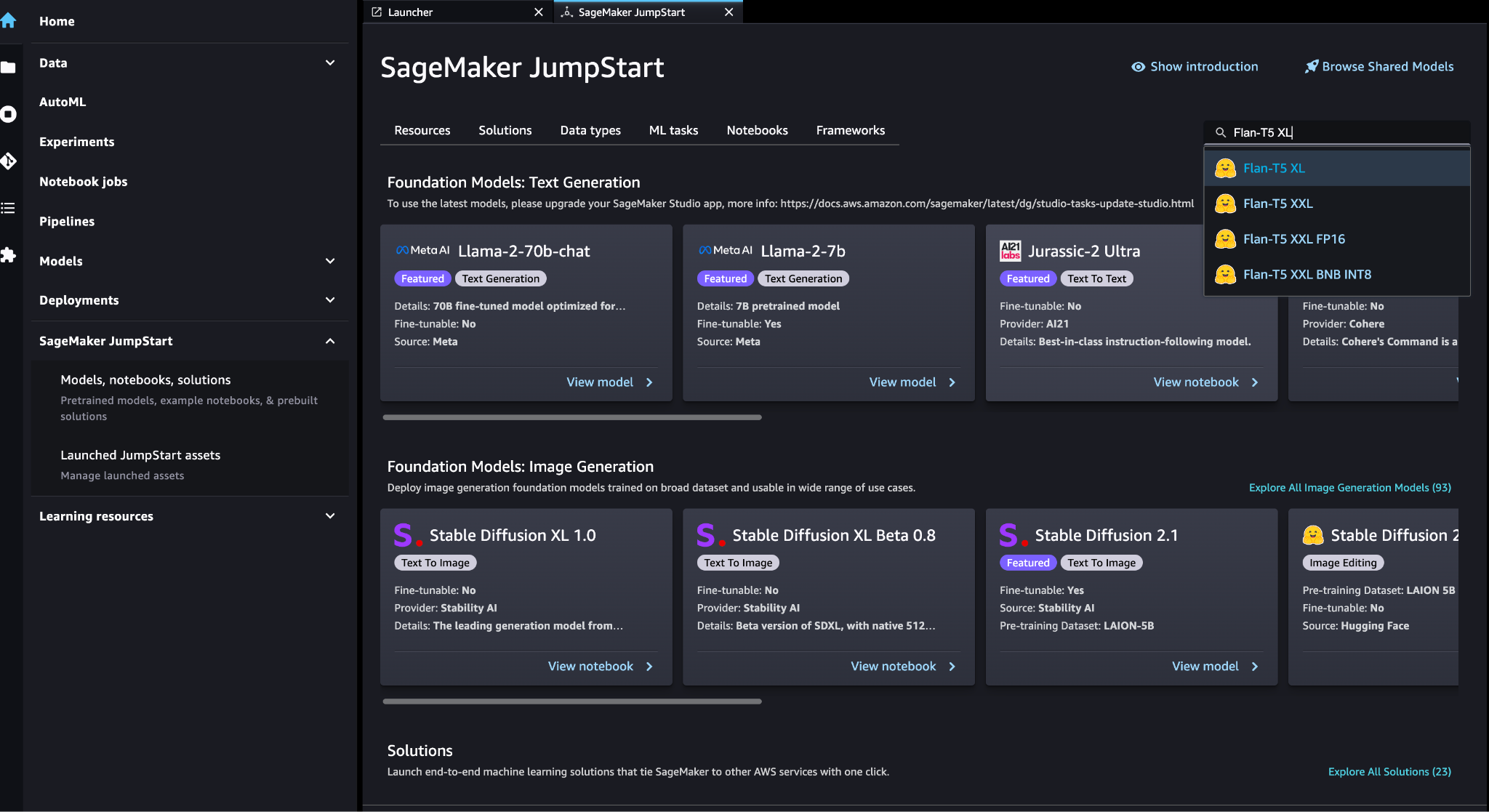

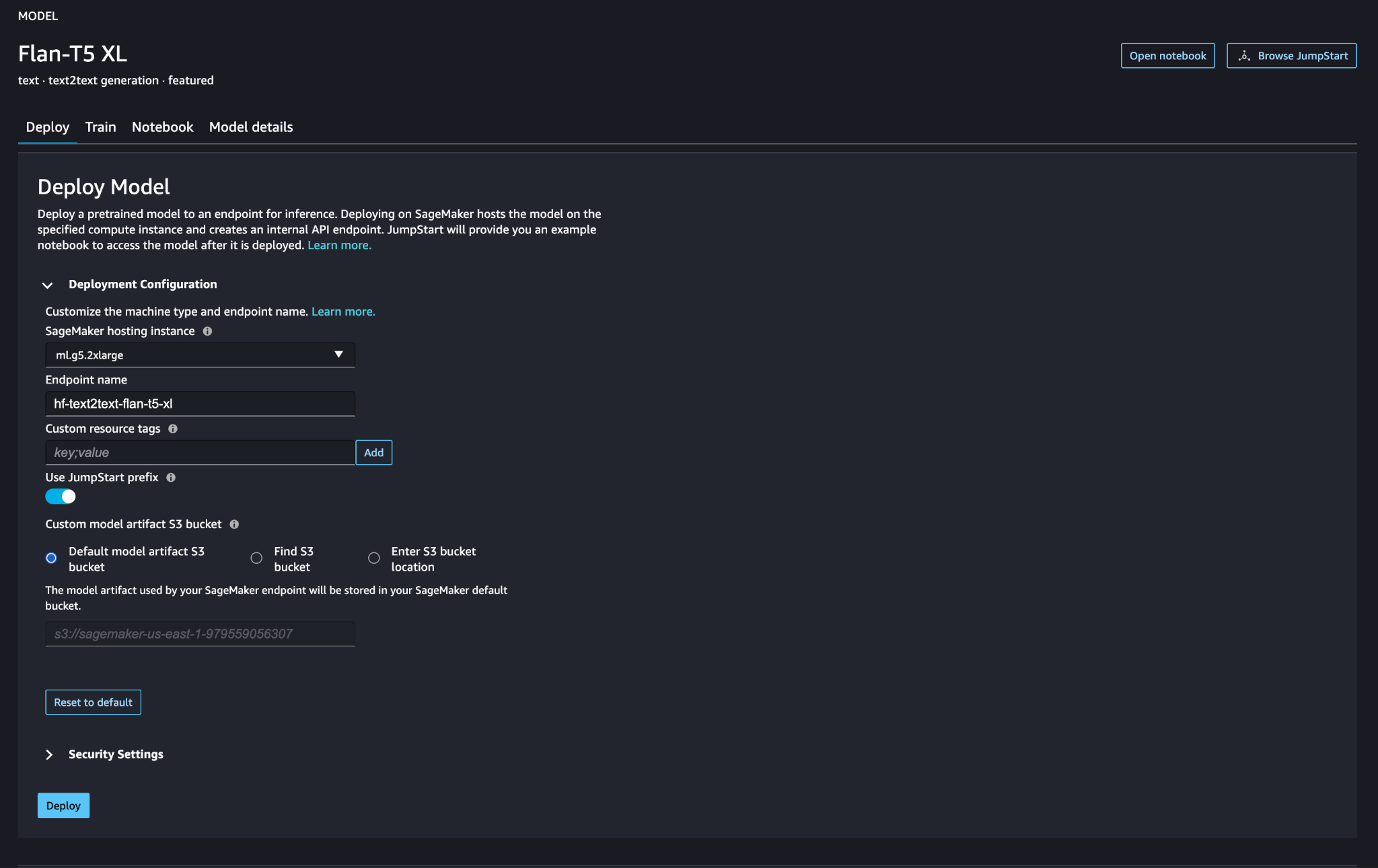

Distribuisci il modello linguistico di grandi dimensioni SageMaker

Modelli di base SageMaker JumpStart sono modelli di linguaggio di grandi dimensioni (LLM) preaddestrati che vengono utilizzati per risolvere una varietà di attività di elaborazione del linguaggio naturale (NLP), come il riepilogo del testo, la risposta alle domande e l'inferenza del linguaggio naturale. Sono disponibili in una varietà di dimensioni e configurazioni. In questa soluzione utilizziamo il file Abbracciare il viso Modello FLAN-T5-XL.

Cerca il modello FLAN-T5-XL in SageMaker JumpStart.

Scegli Schierare per configurare il modello FLAN-T5-XL.

Verificare che il modello sia distribuito correttamente e che l'endpoint sia attivo.

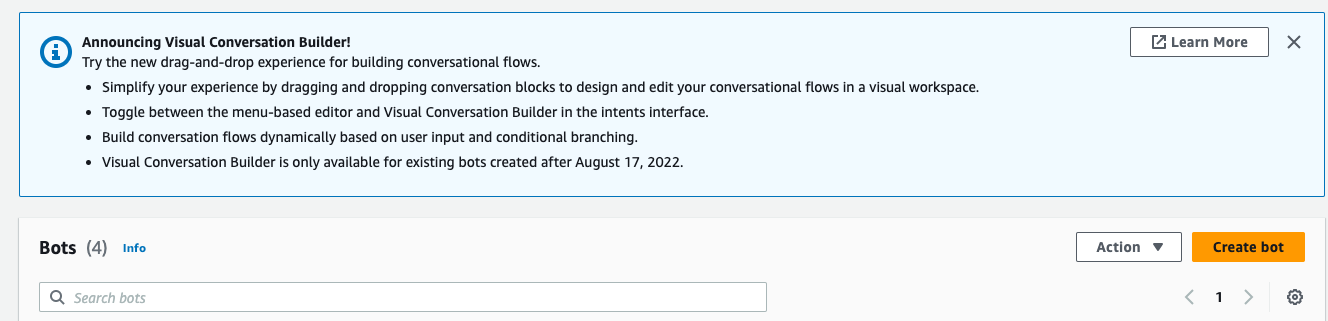

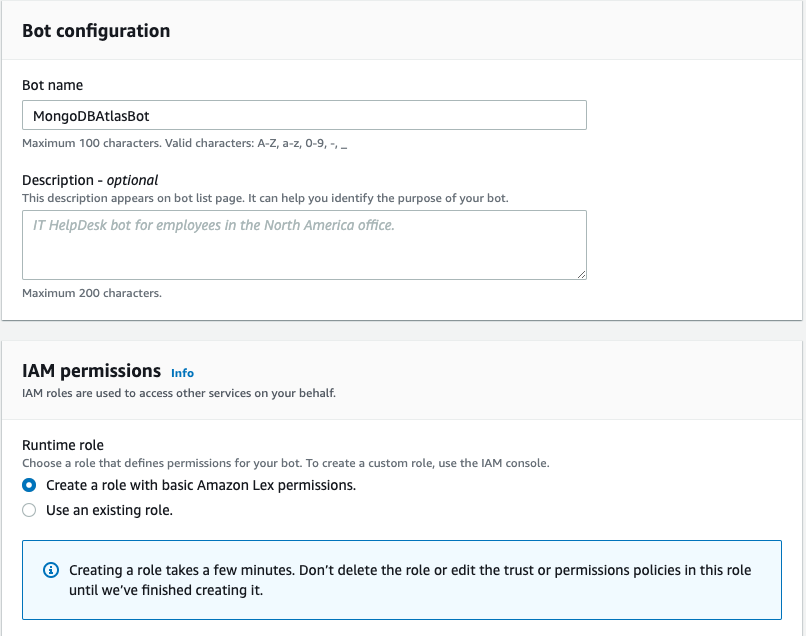

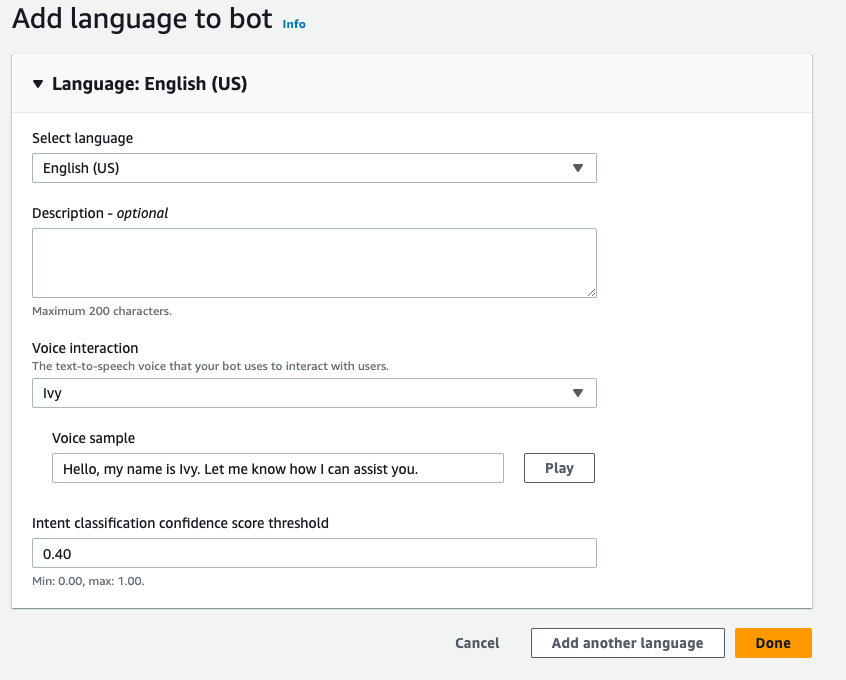

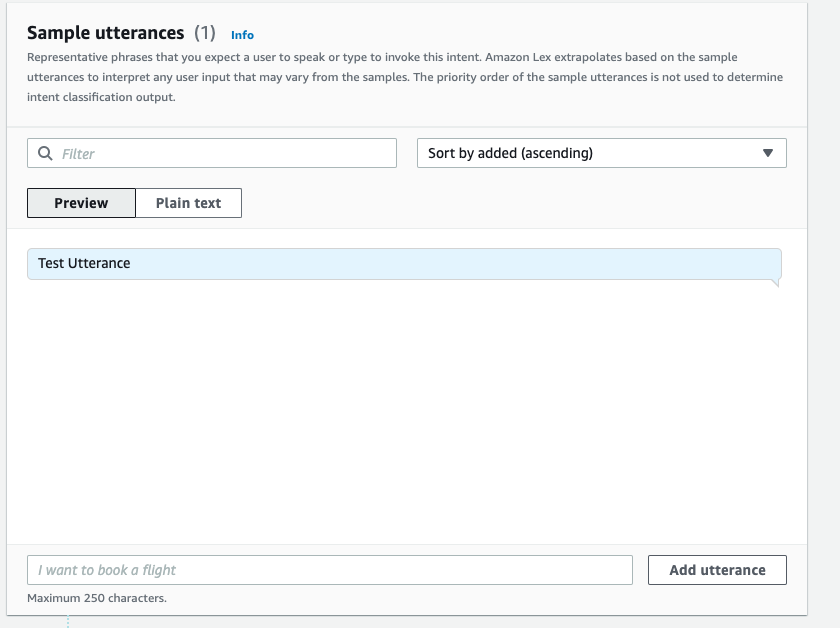

Crea un bot Amazon Lex

Per creare un bot Amazon Lex, completa i seguenti passaggi:

- Sulla console Amazon Lex, selezionare Crea bot.

- Nel Nome del bot, inserisci un nome.

- Nel Ruolo di runtime, selezionare Crea un ruolo con le autorizzazioni di base di Amazon Lex.

- Specifica le impostazioni della lingua, quindi scegli Fatto.

- Aggiungi un'espressione di esempio nel file

NewIntentUI e scegli Salva intento.

- Passare alla

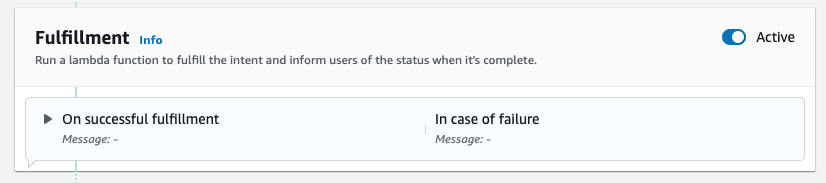

FallbackIntentche è stato creato per te per impostazione predefinita e attiva/disattiva Attivo nel Adempimento .

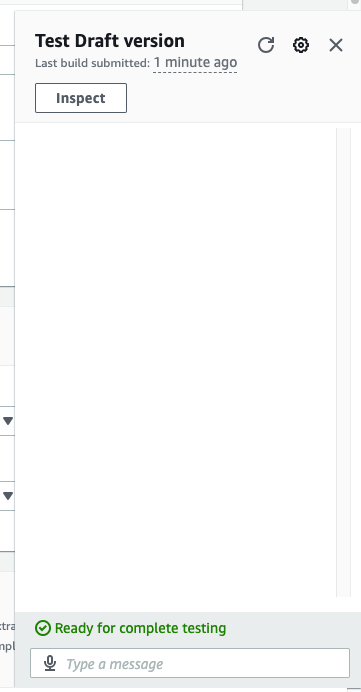

- Scegli Costruire e dopo che la compilazione ha avuto successo, scegli Test.

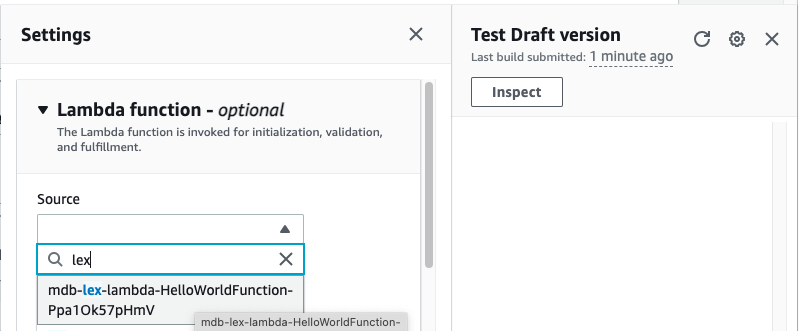

- Prima del test, scegli l'icona dell'ingranaggio.

- specificare la AWS Lambda funzione che interagirà con MongoDB Atlas e LLM per fornire risposte. Per creare la funzione lambda seguire questi passaggi.

- Ora puoi interagire con LLM.

ripulire

Per ripulire le tue risorse, completa i seguenti passaggi:

- Elimina il bot Amazon Lex.

- Elimina la funzione Lambda.

- Elimina l'endpoint LLM SageMaker.

- Elimina l'endpoint SageMaker del modello di incorporamento.

- Elimina il cluster MongoDB Atlas.

Conclusione

Nel post, abbiamo mostrato come creare un semplice bot che utilizza la ricerca semantica MongoDB Atlas e si integra con un modello di SageMaker JumpStart. Questo bot ti consente di prototipare rapidamente l'interazione dell'utente con diversi LLM in SageMaker Jumpstart abbinandoli al contesto originario di MongoDB Atlas.

Come sempre, AWS accoglie volentieri i feedback. Si prega di lasciare il vostro feedback e domande nella sezione commenti.

Circa gli autori

Igor Alekseev è Senior Partner Solution Architect presso AWS nel dominio Dati e analisi. Nel suo ruolo Igor sta lavorando con partner strategici aiutandoli a costruire complesse architetture ottimizzate per AWS. Prima di entrare in AWS, come Data/Solution Architect ha implementato molti progetti nel dominio dei Big Data, inclusi diversi data lake nell'ecosistema Hadoop. In qualità di Data Engineer, è stato coinvolto nell'applicazione di AI/ML al rilevamento delle frodi e all'automazione dell'ufficio.

Babu Srivasan è Senior Partner Solutions Architect presso MongoDB. Nel suo ruolo attuale, sta lavorando con AWS per creare le integrazioni tecniche e le architetture di riferimento per le soluzioni AWS e MongoDB. Ha più di due decenni di esperienza nelle tecnologie Database e Cloud. È appassionato di fornire soluzioni tecniche ai clienti che lavorano con più Global System Integrator (GSI) in più aree geografiche.

Babu Srivasan è Senior Partner Solutions Architect presso MongoDB. Nel suo ruolo attuale, sta lavorando con AWS per creare le integrazioni tecniche e le architetture di riferimento per le soluzioni AWS e MongoDB. Ha più di due decenni di esperienza nelle tecnologie Database e Cloud. È appassionato di fornire soluzioni tecniche ai clienti che lavorano con più Global System Integrator (GSI) in più aree geografiche.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/retrieval-augmented-generation-with-langchain-amazon-sagemaker-jumpstart-and-mongodb-atlas-semantic-search/

- :ha

- :È

- :Dove

- $ SU

- 100

- 200

- 321

- 361

- 7

- 9

- a

- WRI

- sopra

- accelerare

- accesso

- operanti in

- attivo

- Dopo shavasana, sedersi in silenzio; saluti;

- aggregazione

- AI

- AI-alimentato

- AI / ML

- Tutti

- consente

- sempre

- Amazon

- Amazon-Lex

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- an

- analitica

- ed

- API

- applicazioni

- AMMISSIONE

- architettura

- SONO

- Italia

- artificiale

- intelligenza artificiale

- AS

- At

- aumenti

- Automazione

- disponibile

- AWS

- AWS Lambda

- basic

- BE

- benefico

- fra

- Big

- Big Data

- Bot

- bots

- costruire

- aziende

- ma

- by

- detto

- Materiale

- funzionalità

- attentamente

- sfide

- chatbots

- Scegli

- cavedano

- Cloud

- Cluster

- codice

- COERENTE

- collezione

- Commenti

- completamento di una

- complesso

- componenti

- Prendere in considerazione

- consolle

- contenuto

- contesto

- discorsivo

- conversione

- creare

- creato

- Corrente

- Clienti

- personalizzare

- dati

- memorizzazione dei dati

- data-driven

- Banca Dati

- banche dati

- decenni

- Predefinito

- defaults

- definizione

- schierare

- schierato

- rivelazione

- Mercato

- diverso

- Dimensioni

- dimensioni

- distanza

- documento

- dominio

- doppio

- dinamico

- ecosistema

- Efficace

- eliminando

- incorporamento

- Abilita

- endpoint

- impegnarsi

- ingegnere

- assicurando

- entrare

- Impresa

- aziende

- particolarmente

- Ogni

- esperienza

- esterno

- FAST

- caratteristica

- feedback

- pochi

- campo

- campi

- filtro

- ricerca

- seguire

- i seguenti

- Nel

- Fondazione

- Contesto

- frode

- rilevazione di frodi

- Gratis

- da

- function

- ingranaggio

- generare

- ELETTRICA

- generativo

- AI generativa

- geografie

- ottenere

- dato

- globali

- cintura da arrampicata

- Avere

- he

- Aiuto

- aiutare

- aiuta

- evidenzia

- il suo

- olistica

- Come

- Tutorial

- HTML

- http

- HTTPS

- ICON

- illustra

- Immagine

- realizzare

- implementato

- competenze

- in

- Compreso

- Index

- informazioni

- ingresso

- istruzioni

- integrato

- Integra

- Integrazione

- integrazione

- integrazioni

- Intelligence

- interagire

- interazione

- interazioni

- Interfaccia

- ai miglioramenti

- coinvolto

- IT

- SUO

- accoppiamento

- json

- ad appena

- laghi

- atterraggio

- Lingua

- grandi

- apprendimento

- Lasciare

- realistico

- limiti

- LLM

- macchina

- machine learning

- make

- molti

- partita

- ML

- modello

- modelli

- MongoDB

- Scopri di più

- maggior parte

- cambiano

- multiplo

- devono obbligatoriamente:

- Nome

- Naturale

- Elaborazione del linguaggio naturale

- Bisogno

- Rete

- New

- GENERAZIONE

- nlp

- adesso

- numeri

- oggetto

- oggetti

- of

- Office

- di frequente

- on

- quelli

- esclusivamente

- operativa

- Operazioni

- or

- originario

- superamento

- panoramica

- pagina

- appaiamento

- partner

- partner

- appassionato

- sentiero

- performance

- esegue

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- punto

- Post

- potenziale

- energia

- potente

- presents

- precedente

- Precedente

- processi

- lavorazione

- progetti

- prototipo

- fornire

- fornisce

- fornitura

- qualità

- domanda

- Domande

- rapidamente

- tempo reale

- riducendo

- riferimento

- pertinente

- rappresentazione

- rappresentato

- rappresenta

- richiedere

- Risorse

- risposte

- rivoluzionare

- Ruolo

- salvaguardare

- sagemaker

- Punto

- senza soluzione di continuità

- Cerca

- Sezione

- sezioni

- anziano

- separato

- Servizi

- set

- impostazioni

- alcuni

- dovrebbero

- ha mostrato

- Spettacoli

- simile

- Un'espansione

- semplificare

- singolo

- Dimensioni

- soluzione

- Soluzioni

- RISOLVERE

- fonti

- lo spazio

- iniziato

- step

- Passi

- conservazione

- Tornare al suo account

- Strategico

- partner strategici

- di successo

- Con successo

- tale

- suite

- sistema

- SISTEMI DI TRATTAMENTO

- task

- Consulenza

- per l'esame

- Tecnologie

- condizioni

- test

- Testing

- testo

- di

- che

- Il

- loro

- Li

- poi

- di

- questo

- Attraverso

- fila

- a

- Treni

- trasformativa

- transizioni

- vero

- seconda

- Digitare

- Tipi di

- ui

- Aggiornanento

- uso

- utilizzato

- Utente

- usa

- utilizzando

- varietà

- verificare

- Voce

- camminare

- Prima

- Modo..

- we

- sito web

- servizi web

- Benvenuto

- while

- volere

- con

- lavoro

- lavori

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro