הבלוג הזה נכתב בשיתוף עם ג'וש רייני, שיאק סן ואנופאם דאטה מ-TruEra

אמזון SageMaker JumpStart מספק מגוון דגמי יסודות מאומנים מראש כגון Llama-2 ו-Mistal 7B שניתן לפרוס במהירות לנקודת קצה. מודלים בסיסיים אלה מתפקדים היטב עם משימות יצירתיות, החל מיצירת טקסט וסיכומים, מענה על שאלות וכלה בהפקת תמונות וסרטונים. למרות יכולות ההכללה הנהדרות של מודלים אלו, לעיתים קרובות ישנם מקרי שימוש בהם יש להתאים מודלים אלו למשימות או לתחומים חדשים. אחת הדרכים להעלות את הצורך הזה היא על ידי הערכת המודל מול מערך נתונים של אמת קרקע אוצרת. לאחר שהצורך להתאים את מודל הבסיס ברור, אתה יכול להשתמש בסט של טכניקות כדי לבצע זאת. גישה פופולרית היא לכוונן את המודל באמצעות מערך נתונים המותאם למקרה השימוש. כוונון עדין יכול לשפר את מודל הבסיס וניתן למדוד את יעילותו שוב מול מערך הנתונים של האמת הבסיסית. זֶה מחברה מראה כיצד לכוונן דגמים עם SageMaker JumpStart.

אתגר אחד בגישה זו הוא שמערכי נתונים של אמת קרקע שנאספו יקרים ליצירה. בפוסט זה, אנו מתמודדים עם אתגר זה על ידי הגדלת זרימת העבודה הזו עם מסגרת להרחבה, הערכות אוטומטיות. אנו מתחילים עם מודל יסוד בסיסי מבית SageMaker JumpStart ומעריכים אותו באמצעותו TruLens, ספריית קוד פתוח להערכה ומעקב אחר יישומי מודל שפה גדול (LLM). לאחר שנזהה את הצורך בהסתגלות, נוכל להשתמש בכוונון עדין ב- SageMaker JumpStart ולאשר שיפור באמצעות TruLens.

הערכות TruLens משתמשות בהפשטה של פונקציות משוב. ניתן ליישם פונקציות אלו בכמה דרכים, כולל מודלים בסגנון BERT, LLMs עם הנחיה מתאימה ועוד. האינטגרציה של TruLens עם סלע אמזון מאפשר לך להפעיל הערכות באמצעות LLMs הזמינים מאמזון Bedrock. האמינות של תשתית Amazon Bedrock חשובה במיוחד לשימוש בביצוע הערכות בפיתוח וייצור.

פוסט זה משמש הן כהקדמה למקומה של TruEra בערימת האפליקציות המודרנית של LLM והן כמדריך מעשי לשימוש אמזון SageMaker ו TruEra לפרוס, לכוונן ולחזור על אפליקציות LLM. הנה השלם מחברה עם דוגמאות קוד להצגת הערכת ביצועים באמצעות TruLens

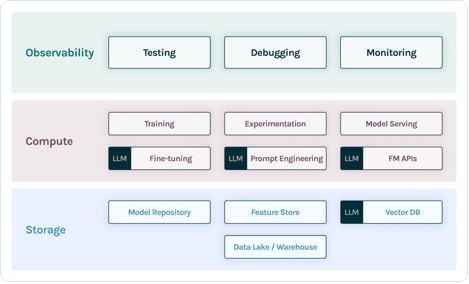

TruEra בערימת האפליקציות של LLM

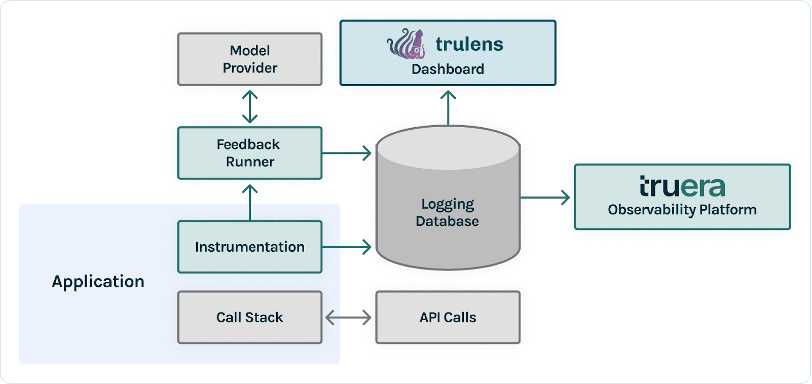

TruEra חי בשכבת הנראות של אפליקציות LLM. למרות שרכיבים חדשים עבדו לתוך שכבת המחשוב (כיוונון עדין, הנדסה מהירה, ממשקי API של מודל) ושכבת האחסון (מסדי נתונים וקטוריים), הצורך בצפייה נותר בעינו. צורך זה משתרע מפיתוח לייצור ודורש יכולות מקושרות לבדיקה, איתור באגים וניטור ייצור, כפי שמודגם באיור הבא.

בפיתוח, אתה יכול להשתמש TruLens בקוד פתוח כדי להעריך, לבצע ניפוי באגים ולחזור על יישומי LLM שלך בסביבה שלך. חבילה מקיפה של מדדי הערכה, כולל מדדים מבוססי LLM וגם מדדים מסורתיים הזמינים ב-TruLens, מאפשרת לך למדוד את האפליקציה שלך מול קריטריונים הנדרשים להעברת האפליקציה שלך לייצור.

בייצור, יומנים ומדדי הערכה אלה ניתנים לעיבוד בקנה מידה עם ניטור ייצור TruEra. על ידי חיבור ניטור ייצור עם בדיקות וניפוי באגים, ניתן לזהות ולתקן נפילות בביצועים כגון הזיה, בטיחות, אבטחה ועוד.

פרוס דגמי יסוד ב- SageMaker

אתה יכול לפרוס דגמי יסוד כגון Llama-2 ב- SageMaker עם שתי שורות בלבד של קוד Python:

הפעל את נקודת הקצה של הדגם

לאחר הפריסה, אתה יכול להפעיל את נקודת הקצה של המודל הפרוס על ידי יצירת תחילה מטען המכיל את התשומות ואת פרמטרי המודל שלך:

אז אתה יכול פשוט להעביר את המטען הזה לשיטת החיזוי של נקודת הקצה. שים לב שעליך להעביר את התכונה כדי לקבל את הסכם הרישיון של משתמש הקצה בכל פעם שאתה מפעיל את המודל:

הערכת ביצועים עם TruLens

עכשיו אתה יכול להשתמש ב-TruLens כדי להגדיר את ההערכה שלך. TruLens הוא כלי לצפייה, המציע קבוצה ניתנת להרחבה של פונקציות משוב למעקב והערכה של אפליקציות המופעלות על ידי LLM. פונקציות משוב חיוניות כאן באימות היעדר הזיה באפליקציה. פונקציות משוב אלו מיושמות על ידי שימוש בדגמי מדף של ספקים כגון Amazon Bedrock. דגמי Amazon Bedrock הם יתרון כאן בגלל האיכות והאמינות המאומתים שלהם. אתה יכול להגדיר את הספק עם TruLens באמצעות הקוד הבא:

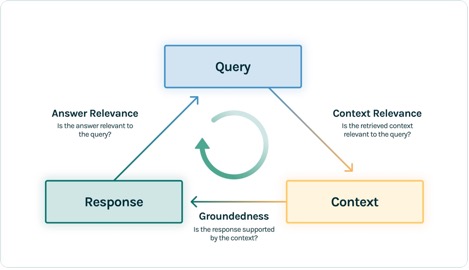

בדוגמה זו, אנו משתמשים בשלוש פונקציות משוב: רלוונטיות התשובה, רלוונטיות ההקשר והמקורקעות. הערכות אלו הפכו במהרה לסטנדרט לזיהוי הזיות ביישומי תשובות לשאלות המאפשרות הקשר והן שימושיות במיוחד עבור יישומים ללא פיקוח, המכסים את הרוב המכריע של יישומי ה-LLM של ימינו.

הבה נעבור על כל אחת מפונקציות המשוב הללו כדי להבין כיצד הן יכולות להועיל לנו.

רלוונטיות ההקשר

ההקשר הוא קלט קריטי לאיכות התגובות של האפליקציה שלנו, וזה יכול להיות שימושי כדי להבטיח באופן פרוגרמטי שההקשר שסופק רלוונטי לשאילתת הקלט. זה קריטי מכיוון שההקשר הזה ישמש את ה-LLM כדי ליצור תשובה, כך שכל מידע לא רלוונטי בהקשר עלול להישזר לתוך הזיה. TruLens מאפשרת לך להעריך את רלוונטיות ההקשר על ידי שימוש במבנה של הרשומה בסידרה:

מכיוון שההקשר המסופק ל-LLMs הוא השלב התוצאתי ביותר של צינור של Retrieval Augmented Generation (RAG), רלוונטיות ההקשר היא קריטית להבנת איכות האחזורים. בעבודה עם לקוחות על פני מגזרים, ראינו מגוון מצבי כשל שזוהו באמצעות הערכה זו, כגון הקשר לא שלם, הקשר חיצוני לא רלוונטי או אפילו היעדר הקשר מספיק זמין. על ידי זיהוי האופי של מצבי כשל אלו, המשתמשים שלנו יכולים להתאים את האינדקס שלהם (כגון הטמעת מודל וחתכים) ואסטרטגיות אחזור (כגון חלונות משפטים ומיזוג אוטומטי) כדי להקל על בעיות אלו.

מקורקעות

לאחר אחזור ההקשר, הוא נוצר לתשובה על ידי LLM. LLMs נוטים לעתים קרובות לסטות מהעובדות שסופקו, להגזים או להרחיב לתשובה שנשמעת נכונה. כדי לאמת את מקוריות הבקשה, עליך להפריד את התגובה להצהרות נפרדות ולחפש באופן עצמאי אחר ראיות התומכות בכל אחת מהן בהקשר שאוחזר.

בעיות עם מקורקעות יכולות להיות לעתים קרובות אפקט במורד הזרם של רלוונטיות ההקשר. כאשר ל-LLM חסר הקשר מספיק כדי ליצור תגובה מבוססת ראיות, סביר יותר להזות בניסיונו ליצור תגובה סבירה. אפילו במקרים שבהם מסופק הקשר מלא ורלוונטי, ה-LLM יכול ליפול לבעיות עם מקורקע. במיוחד, זה התרחש ביישומים שבהם ה-LLM מגיב בסגנון מסוים או בשימוש כדי להשלים משימה שהיא לא מתאימה לה. הערכות מקוריות מאפשרות למשתמשי TruLens לפרק תגובות LLM טענה לפי טענה כדי להבין היכן ה-LLM הוזה לרוב. פעולה זו הוכחה כמועילה במיוחד להארת הדרך קדימה בביטול הזיות באמצעות שינויים בצד הדגם (כגון הנחיה, בחירת דגם ופרמטרים של דגם).

רלוונטיות התשובה

לבסוף, התגובה עדיין צריכה לענות בצורה מועילה על השאלה המקורית. אתה יכול לאמת זאת על ידי הערכת הרלוונטיות של התגובה הסופית לקלט המשתמש:

על ידי הגעה להערכות משביעות רצון עבור שלישיה זו, אתה יכול להצהיר הצהרה ניואנסית לגבי נכונות הבקשה שלך; אפליקציה זו מאומתת נטולת הזיות עד לקצה גבול בסיס הידע שלה. במילים אחרות, אם מסד הנתונים הווקטוריים מכיל רק מידע מדויק, אז התשובות שמספקות אפליקציית התשובה לשאלות המאפשרת ההקשר הן גם מדויקות.

הערכת אמת קרקעית

בנוסף לפונקציות המשוב הללו לזיהוי הזיות, יש לנו מערך בדיקה, DataBricks-Dolly-15k, שמאפשר לנו להוסיף דמיון אמתי כמדד הערכה רביעי. ראה את הקוד הבא:

בנה את האפליקציה

לאחר שתגדיר את המעריכים שלך, תוכל לבנות את היישום שלך. בדוגמה זו, אנו משתמשים ביישום QA המאפשר הקשר. ביישום זה, ספק את ההוראה וההקשר למנוע ההשלמה:

לאחר שיצרת את האפליקציה ואת פונקציות המשוב, זה פשוט ליצור אפליקציה עטופה עם TruLens. היישום העטוף הזה, שאנו קוראים לו base_recorder, ירשום ויעריך את היישום בכל פעם שהוא נקרא:

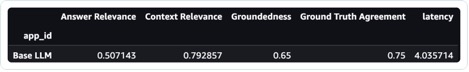

תוצאות עם בסיס לאמה-2

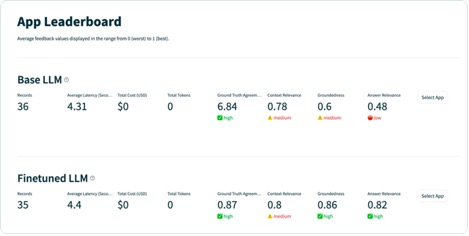

לאחר שתפעיל את היישום על כל רשומה במערך הנתונים של הבדיקה, תוכל להציג את התוצאות במחברת SageMaker שלך עם tru.get_leaderboard(). צילום המסך הבא מציג את תוצאות ההערכה. רלוונטיות התשובה נמוכה להחריד, מה שמעיד על כך שהמודל מתקשה לעקוב באופן עקבי אחר ההוראות שסופקו.

כוונן עדין את Llama-2 באמצעות SageMaker Jumpstart

שלבים לכוונון עדין של דגם Llama-2 באמצעות SageMaker Jumpstart מסופקים גם כאן מחברה.

כדי להגדיר כוונון עדין, תחילה עליך להוריד את ערכת ההדרכה ולהגדיר תבנית להוראות

לאחר מכן, העלה גם את מערך הנתונים וגם ההוראות ל-an שירות אחסון פשוט של אמזון (Amazon S3) דלי לאימון:

כדי לכוונן את SageMaker, אתה יכול להשתמש ב-SageMaker JumpStart Estimator. אנו משתמשים כאן בעיקר בהיפרפרמטרים המוגדרים כברירת מחדל, אלא שהגדרנו את כוונון ההוראות ל-true:

לאחר שהכשרת את המודל, תוכל לפרוס אותו וליצור את היישום שלך בדיוק כפי שעשית בעבר:

הערך את המודל המכוונן

אתה יכול להפעיל את המודל שוב על ערכת הבדיקה שלך ולראות את התוצאות, הפעם בהשוואה ל-Llama-2 הבסיס:

דגם ה-Llama-2 החדש והמעודן השתפר בצורה מסיבית ברלוונטיות התשובות והמקורקעות, יחד עם הדמיון למבחן האמת הבסיסית. השיפור הגדול הזה באיכות בא על חשבון עלייה קלה בהשהיה. עלייה זו בהשהיה היא תוצאה ישירה של כוונון עדין שמגדיל את גודל הדגם.

לא רק שאתה יכול להציג את התוצאות האלה במחברת, אלא שאתה יכול גם לחקור את התוצאות בממשק המשתמש של TruLens על ידי הפעלת tru.run_dashboard(). פעולה זו יכולה לספק את אותן תוצאות מצטברות בדף Leaderboard, אך גם נותנת לך את היכולת לצלול עמוק יותר לתוך רשומות בעייתיות ולזהות מצבי כשל של האפליקציה.

כדי להבין את השיפור באפליקציה ברמת שיא, ניתן לעבור לדף ההערכות ולבחון את ציוני המשוב ברמה פרטנית יותר.

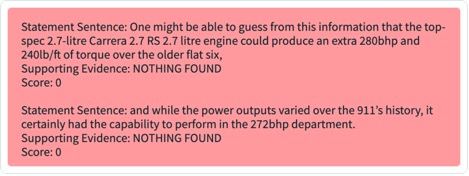

לדוגמה, אם אתה שואל את ה-LLM הבסיסי את השאלה "מהו מנוע ה-Flat six של פורשה החזק ביותר", הדגם הוזה את הדברים הבאים.

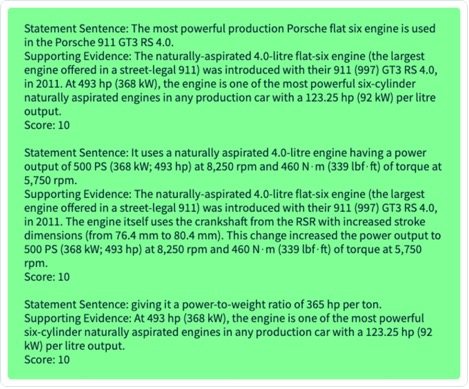

בנוסף, אתה יכול לבחון את ההערכה התוכנתית של רשומה זו כדי להבין את ביצועי היישום מול כל אחת מפונקציות המשוב שהגדרת. על ידי בחינת תוצאות המשוב המבוסס ב-TruLens, תוכל לראות פירוט מפורט של הראיות הזמינות לתמיכה בכל טענה שהועלתה על ידי ה-LLM.

אם אתה מייצא את אותו רשומה עבור ה-LLM המכוונן שלך ב-TruLens, אתה יכול לראות שכוונון עדין עם SageMaker JumpStart שיפר באופן דרמטי את הבסיסיות של התגובה.

על ידי שימוש בזרימת עבודה של הערכה אוטומטית עם TruLens, אתה יכול למדוד את היישום שלך על פני סט רחב יותר של מדדים כדי להבין טוב יותר את הביצועים שלו. חשוב לציין, כעת אתה יכול להבין את הביצועים הללו באופן דינמי עבור כל מקרה שימוש - אפילו לאלה שבהם לא אספת אמת יסודית.

איך TruLens עובד

לאחר שיצרת אב טיפוס לאפליקציית LLM שלך, תוכל לשלב את TruLens (הוצג קודם לכן) כדי להכשיר את ערימת השיחות שלו. לאחר שהמחסנית של השיחות נקלטה, ניתן להתחבר אליה בכל ריצה למסד נתונים של רישום החי בסביבה שלך.

בנוסף ליכולות המכשור והרישום, הערכה היא מרכיב מרכזי של ערך עבור משתמשי TruLens. הערכות אלו מיושמות ב-TruLens על ידי פונקציות משוב שיפעלו על גבי מחסנית השיחות המוכשרת שלך, ובתורן קוראים לספקי מודלים חיצוניים לייצר את המשוב בעצמו.

לאחר הסקת משוב, תוצאות המשוב נכתבות למסד הנתונים של רישום, ממנו ניתן להפעיל את לוח המחוונים של TruLens. לוח המחוונים של TruLens, הפועל בסביבתך, מאפשר לך לחקור, לבצע פעולות פעולות וניפוי באגים באפליקציית LLM שלך.

בקנה מידה, ניתן לדחוף את היומנים וההערכות הללו ל-TruEra עבור צפייה בייצור שיכול לעבד מיליוני תצפיות בדקה. על ידי שימוש בפלטפורמת התצפית של TruEra, אתה יכול לזהות במהירות הזיות ובעיות ביצועים אחרות, ולהתקרב לרשומה בודדת תוך שניות עם אבחון משולב. מעבר לנקודת מבט אבחנתית מאפשר לך לזהות ולצמצם בקלות מצבי כשל באפליקציית LLM שלך כגון הזיות, איכות שליפה ירודה, בעיות בטיחות ועוד.

הערך עבור תגובות כנות, לא מזיקות ומועילות

על ידי הגעה להערכות משביעות רצון עבור השלישייה הזו, אתה יכול להגיע לרמה גבוהה יותר של ביטחון באמיתות התגובות שהיא מספקת. מעבר לאמיתות, ל-TruLens יש תמיכה רחבה בהערכות הדרושות כדי להבין את הביצועים של ה-LLM שלך על הציר של "כנה, לא מזיק ומועיל". המשתמשים שלנו נהנו מאוד מהיכולת לזהות לא רק הזיות כפי שדיברנו קודם, אלא גם בעיות הקשורות לבטיחות, אבטחה, התאמת שפה, קוהרנטיות ועוד. כל אלו הן בעיות מבולגנות בעולם האמיתי שעמן מתמודדים מפתחי אפליקציות LLM, וניתן לזהותן מהקופסה עם TruLens.

סיכום

פוסט זה דן כיצד אתה יכול להאיץ את ייצור יישומי הבינה המלאכותית ולהשתמש במודלים של בסיס בארגון שלך. עם SageMaker JumpStart, Amazon Bedrock ו-TruEra, אתה יכול לפרוס, לכוונן ולחזור על דגמי יסוד עבור יישום ה-LLM שלך. תבדוק את זה קישור למידע נוסף על TruEra ולנסות את מחברה עַצמְךָ.

על המחברים

ג'וש רייני הוא תורם ליבה ל-TruLens בקוד פתוח ולמדען המייסד של קשרי מפתחים ב-TruEra, שם הוא אחראי על יוזמות חינוך וטיפוח קהילה משגשגת של מתרגלי איכות בינה מלאכותית.

ג'וש רייני הוא תורם ליבה ל-TruLens בקוד פתוח ולמדען המייסד של קשרי מפתחים ב-TruEra, שם הוא אחראי על יוזמות חינוך וטיפוח קהילה משגשגת של מתרגלי איכות בינה מלאכותית.

שיאק סנ הוא ה-CTO והמייסד המשותף של TruEra. Shayak מתמקדת בבניית מערכות ובהובלת מחקר כדי להפוך מערכות למידת מכונה לניתנות להסבר, תואמות פרטיות והוגנות יותר.

שיאק סנ הוא ה-CTO והמייסד המשותף של TruEra. Shayak מתמקדת בבניית מערכות ובהובלת מחקר כדי להפוך מערכות למידת מכונה לניתנות להסבר, תואמות פרטיות והוגנות יותר.

אנופם דאטה הוא מייסד שותף, נשיא ומדען ראשי של TruEra. לפני TruEra, הוא בילה 15 שנים בפקולטה באוניברסיטת קרנגי מלון (2007-22), לאחרונה כפרופסור קבוע להנדסת חשמל ומחשבים ומדעי המחשב.

אנופם דאטה הוא מייסד שותף, נשיא ומדען ראשי של TruEra. לפני TruEra, הוא בילה 15 שנים בפקולטה באוניברסיטת קרנגי מלון (2007-22), לאחרונה כפרופסור קבוע להנדסת חשמל ומחשבים ומדעי המחשב.

Vivek Gangasani הוא ארכיטקט פתרונות AI/ML לסטארט-אפים בינה מלאכותית ב-AWS. הוא עוזר לסטארט-אפים מתעוררים של GenAI לבנות פתרונות חדשניים באמצעות שירותי AWS ומחשוב מואץ. נכון לעכשיו, הוא מתמקד בפיתוח אסטרטגיות לכוונון עדין ואופטימיזציה של ביצועי ההסקה של מודלים של שפה גדולה. בזמנו הפנוי, ויווק נהנה לטייל, לצפות בסרטים ולנסות מאכלים שונים.

Vivek Gangasani הוא ארכיטקט פתרונות AI/ML לסטארט-אפים בינה מלאכותית ב-AWS. הוא עוזר לסטארט-אפים מתעוררים של GenAI לבנות פתרונות חדשניים באמצעות שירותי AWS ומחשוב מואץ. נכון לעכשיו, הוא מתמקד בפיתוח אסטרטגיות לכוונון עדין ואופטימיזציה של ביצועי ההסקה של מודלים של שפה גדולה. בזמנו הפנוי, ויווק נהנה לטייל, לצפות בסרטים ולנסות מאכלים שונים.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/deploy-foundation-models-with-amazon-sagemaker-iterate-and-monitor-with-truera/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 1

- 10

- 100

- 11

- 12

- 120

- 125

- 14

- שנים 15

- 15%

- 16

- 179

- 7

- 72

- 8

- 9

- a

- יכולת

- יכול

- אודות

- הפשטה

- להאיץ

- מוּאָץ

- לְקַבֵּל

- מדויק

- לרוחב

- להסתגל

- הסתגלות

- להוסיף

- תוספת

- כתובת

- יתרון

- לאחר

- שוב

- נגד

- הסכם

- AI

- AI / ML

- תעשיות

- להתיר

- מאפשר

- לאורך

- גם

- למרות

- אמזון בעברית

- אמזון SageMaker

- אמזון שירותי אינטרנט

- an

- ו

- לענות

- תשובות

- כל

- ממשקי API

- האפליקציה

- בקשה

- יישומים

- גישה

- כראוי

- אפליקציות

- ARE

- AS

- לשאול

- At

- ניסיון

- מוגבר

- אוטומטי

- זמין

- AWS

- צִיר

- בסיס

- Baseline

- BE

- כי

- להיות

- לפני

- להיות

- תאמינו

- להלן

- תועלת

- מוטב

- בֵּין

- מעבר

- בלוג

- שניהם

- אריזה מקורית

- לשבור

- התמוטטות

- רחב

- לִבנוֹת

- בִּניָן

- אבל

- by

- שיחה

- נקרא

- CAN

- יכולות

- קרנגי מלון

- לשאת

- מקרה

- מקרים

- קטגוריה

- לאתגר

- שינויים

- לתשלום

- רֹאשׁ

- בחירה

- לטעון

- בכיתה

- ברור

- מייסד שותף

- קוד

- אוסף

- עמודות

- מגיע

- קהילה

- השוואה

- להשלים

- הושלם

- השלמה

- תואם

- רְכִיב

- רכיבים

- מַקִיף

- לחשב

- המחשב

- הנדסת מחשבים

- מדעי מחשב

- אמון

- לאשר

- מקשר

- תוצאתית

- באופן עקבי

- מכיל

- הקשר

- תורם

- להמיר

- ליבה

- תורם הליבה

- תוקן

- יכול

- לכסות

- לִיצוֹר

- נוצר

- יוצרים

- הקריטריונים

- קריטי

- ראש אגף טכנולוגיה

- אוצר

- כיום

- לקוחות

- לוח מחוונים

- נתונים

- מדען נתונים

- מסד נתונים

- מאגרי מידע

- מערכי נתונים

- עמוק יותר

- בְּרִירַת מֶחדָל

- מוגדר

- תואר

- לפרוס

- פרס

- פריסה

- מתאר

- למרות

- מְפוֹרָט

- לאתר

- איתור

- מפתח

- מפתחים

- מתפתח

- צעצועי התפתחות

- אבחון

- DID

- אחר

- ישיר

- נָדוֹן

- צלילה

- עושה

- תחומים

- מטה

- להורדה

- באופן דרמטי

- באופן דינמי

- כל אחד

- מוקדם יותר

- בקלות

- חינוך

- השפעה

- יעילות

- חיסול

- הטבעה

- מתעורר

- מאפשר

- סוף

- נקודת קצה

- מנוע

- הנדסה

- לְהַבטִיחַ

- סביבה

- במיוחד

- חיוני

- להעריך

- הערכה

- הערכה

- הערכות

- אֲפִילוּ

- עדות

- לִבחוֹן

- בוחן

- דוגמה

- אלא

- הרחבת

- יקר

- לחקור

- יצוא

- חיצוני

- הוֹצָאָה

- פָּנִים

- עובדות

- כשלון

- הוגן

- ליפול

- שקר

- מָשׁוֹב

- תרשים

- שלח

- סופי

- סוף

- ראשון

- דירה

- מרוכז

- לעקוב

- הבא

- בעד

- טופס

- נוצר

- קדימה

- קרן

- ייסוד

- רביעית

- מסגרת

- חופשי

- החל מ-

- פונקציה

- פונקציות

- נוסף

- ליצור

- דור

- גנרטטיבית

- AI Generative

- נותן

- Go

- פרטני

- גדול

- קרקע

- מדריך

- ידות על

- יש

- he

- מועיל

- עוזר

- כאן

- גבוה יותר

- שֶׁלוֹ

- יָשָׁר

- איך

- איך

- HTML

- http

- HTTPS

- i

- מזוהה

- לזהות

- זיהוי

- if

- מאיר

- תמונות

- יושם

- לייבא

- חשוב

- לשפר

- משופר

- השבחה

- in

- באחר

- כולל

- להגדיל

- גדל

- באופן עצמאי

- מידע

- תשתית

- יוזמות

- חדשני

- קלט

- תשומות

- הוראות

- מכשיר

- לשלב

- משולב

- השתלבות

- מקושרים

- אל תוך

- מבוא

- בעיות

- IT

- שֶׁלָה

- עצמו

- jpg

- ג'סון

- רק

- מפתח

- ידע

- חוסר

- שפה

- גָדוֹל

- חֶבִיוֹן

- שכבה

- מוביל

- למידה

- רמה

- סִפְרִיָה

- רישיון

- החיים

- סביר

- להגביל

- קו

- קווים

- רשימה

- חי

- חי

- LLM

- מקומי

- היכנס

- מחובר

- רישום

- נמוך

- מכונה

- למידת מכונה

- עשוי

- הרוב

- לעשות

- באופן מאסיבי

- להתאים

- משמעות

- למדוד

- מלון

- שיטה

- מטרי

- מדדים

- מיליונים

- דקה

- להקל

- ML

- מודל

- מודלים

- מודרני

- מצבי

- צג

- ניטור

- יותר

- רוב

- בעיקר

- המהלך

- סרטים

- נע

- צריך

- שם

- טבע

- צורך

- נחוץ

- צרכי

- חדש

- הבא

- הערות

- מחברה

- עַכשָׁיו

- מטפח

- אובייקט

- of

- כבוי

- הצעה

- לעתים קרובות

- on

- ONE

- רק

- לפתוח

- קוד פתוח

- מיטוב

- or

- ארגון

- מְקוֹרִי

- אחר

- שלנו

- הַחוּצָה

- תפוקה

- עמוד

- מְזוּוָג

- פרמטרים

- מסוים

- במיוחד

- לעבור

- לְבַצֵעַ

- ביצועים

- ביצוע

- צינור

- מקום

- פלטפורמה

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- מתקבל על הדעת

- שיחק

- עני

- פופולרי

- פורשה

- הודעה

- חזק

- לחזות

- נשיא

- פְּרָטִיוּת

- בעייתי

- בעיות

- תהליך

- מעובד

- לייצר

- הפקת

- הפקה

- פרופסור

- פרוגרמטית

- לספק

- ובלבד

- ספק

- ספקים

- מספק

- דחף

- פיתון

- שאלות ותשובות

- איכות

- שאלה

- שאלות

- מהירות

- אקראי

- מהר

- לְהַגִיעַ

- הגעה

- עולם אמיתי

- לאחרונה

- שיא

- הקלטה

- רשום

- יחסים

- הרלוונטיות

- רלוונטי

- אמינות

- שְׂרִידִים

- להחליף

- לבקש

- נדרש

- דורש

- מחקר

- תגובה

- תגובות

- אחראי

- תוצאה

- תוצאות

- לַחֲזוֹר

- הפעלה

- ריצה

- בְּטִיחוּת

- בעל חכמים

- אותו

- סולם

- מדע

- מַדְעָן

- חיפוש

- שניות

- מגזרים

- אבטחה

- לִרְאוֹת

- לראות

- בחר

- משפט

- נפרד

- משמש

- שירותים

- סט

- התקנה

- כמה

- צריך

- לְהַצִיג

- הראה

- הופעות

- פָּשׁוּט

- בפשטות

- יחיד

- שישה

- מידה

- So

- פתרונות

- מָקוֹר

- משתרע

- מיוחד

- בילה

- לפצל

- לערום

- תֶקֶן

- התחלה

- סטארט - אפ

- חברות סטארט

- הצהרה

- הצהרות

- שלב

- עוד

- אחסון

- פשוט

- אסטרטגיות

- מִבְנֶה

- נאבק

- סגנון

- כזה

- מספיק

- מערכת

- תמיכה

- תומך

- משטח

- מערכות

- מותאם

- המשימות

- משימות

- טכניקות

- תבנית

- מבחן

- בדיקות

- טֶקסט

- זֶה

- השמיים

- שֶׁלָהֶם

- אז

- שם.

- אלה

- הֵם

- זֶה

- אלה

- שְׁלוֹשָׁה

- משגשגת

- דרך

- כָּך

- זמן

- ל

- של היום

- כלי

- חלק עליון

- לעקוב

- מעקב

- מסורתי

- רכבת

- מְאוּמָן

- הדרכה

- בצורה אדירה

- TRU

- נָכוֹן

- אמת

- לנסות

- מנסה

- מנגינה

- כונון

- תור

- שתיים

- ui

- להבין

- הבנה

- אוניברסיטה

- על

- us

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- משתמשים

- באמצעות

- בעל ערך

- ערך

- מגוון

- Vast

- מְאוּמָת

- לאמת

- אימות

- באמצעות

- וידאו

- לצפיה

- W

- צופה

- דֶרֶך..

- דרכים

- we

- אינטרנט

- שירותי אינטרנט

- טוֹב

- מתי

- אשר

- רחב יותר

- יצטרך

- עם

- בתוך

- מילים

- עבד

- זרימת עבודה

- עובד

- עטוף

- לכתוב

- כתוב

- שנים

- אתה

- עצמך

- זפירנט

- זום