צוות התכנון והבנייה של אמזון האיחוד האירופי (Amazon D&C) הוא צוות ההנדסה שמתכנן ובונה מחסני אמזון ברחבי אירופה ואזור MENA. תהליכי התכנון והפריסה של פרויקטים כוללים סוגים רבים של בקשות למידע (RFIs) לגבי דרישות הנדסיות לגבי אמזון והנחיות ספציפיות לפרויקט. בקשות אלה נעות מאחזור פשוט של ערכי עיצוב בסיסיים, לסקירת הצעות הנדסת ערך, לניתוח דוחות ובדיקות התאמה. כיום, אלה מטופלים על ידי צוות טכני מרכזי, המורכב ממומחים לנושאים (SMEs) שיכולים לענות על שאלות מיוחדות טכניות כאלה, ולספק שירות זה לכל בעלי העניין והצוותים לאורך מחזור חיי הפרויקט. הצוות מחפש א AI ייצור פתרון תשובות לשאלות כדי לקבל מידע במהירות ולהמשיך בתכנון ההנדסי שלהם. יש לציין, מקרי שימוש אלה אינם מוגבלים לצוות Amazon D&C בלבד, אלא חלים על ההיקף הרחב יותר של שירותי הנדסה גלובליים המעורבים בפריסת הפרויקט. כל מגוון מחזיקי העניין והצוותים העוסקים במחזור החיים של הפרויקט יכולים להפיק תועלת מפתרון תשובות לשאלות בינה מלאכותית, שכן הוא יאפשר גישה מהירה למידע קריטי, ייעול התכנון ההנדסי ותהליכי ניהול הפרויקטים.

פתרונות הבינה המלאכותית הגנרטיבית הקיימים למענה על שאלות מבוססים בעיקר על אחזור דור מוגבר (סְמַרטוּט). RAG מבצע חיפוש במסמכים מודל שפה גדול (LLM) הטמעה ו-Vectoring, יוצרת את ההקשר מתוצאות חיפוש דרך אשכולות, ומשתמשת בהקשר כהנחיה מוגברת להסקת מודל יסוד כדי לקבל את התשובה. שיטה זו פחות יעילה עבור המסמכים הטכניים ביותר מאמזון D&C, המכילים נתונים לא מובנים משמעותיים כגון גיליונות אקסל, טבלאות, רשימות, איורים ותמונות. במקרה זה, משימת המענה לשאלות עובדת טוב יותר על ידי כוונון עדין של ה-LLM עם המסמכים. כוונון עדין מתאים ומתאים את המשקולות של ה-LLM המאומן מראש כדי לשפר את איכות הדגם והדיוק.

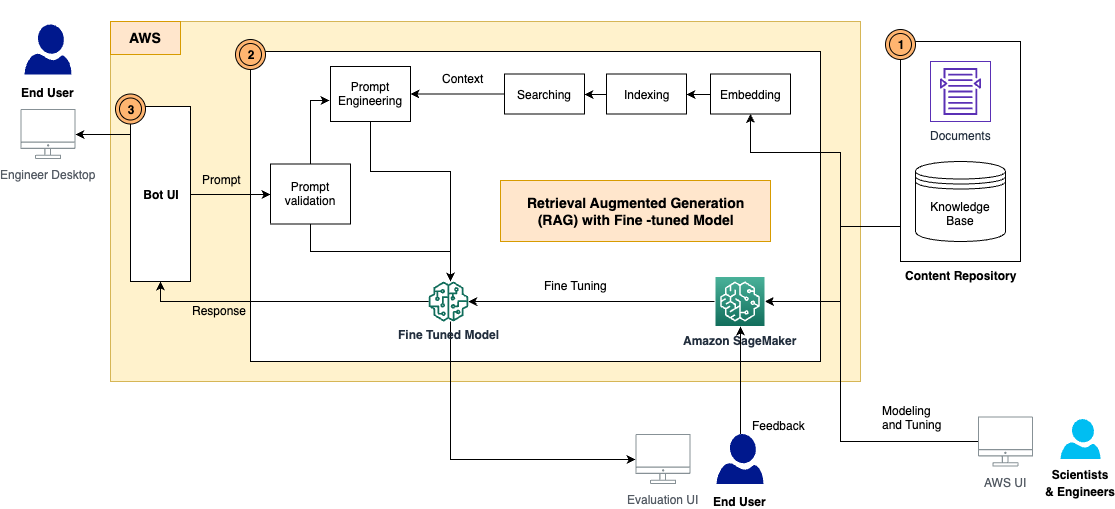

כדי להתמודד עם האתגרים הללו, אנו מציגים מסגרת חדשה עם RAG ו-LLMs מכוונים. הפתרון משתמש אמזון SageMaker JumpStart כשירות הליבה לכוונון עדין והסקת המודל. בפוסט זה, אנו לא רק מספקים את הפתרון, אלא גם דנים בלקחים שנלמדו ובשיטות העבודה המומלצות בעת יישום הפתרון במקרים של שימוש בעולם האמיתי. אנו משווים ועומדים בניגוד לאופן שבו פעלו מתודולוגיות שונות ו-LLMs בקוד פתוח במקרה השימוש שלנו ודנים כיצד למצוא את ההחלפה בין ביצועי מודל לעלויות משאבי מחשוב.

סקירת פתרונות

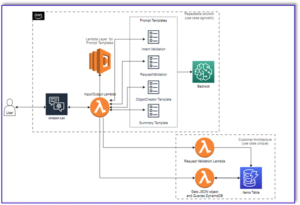

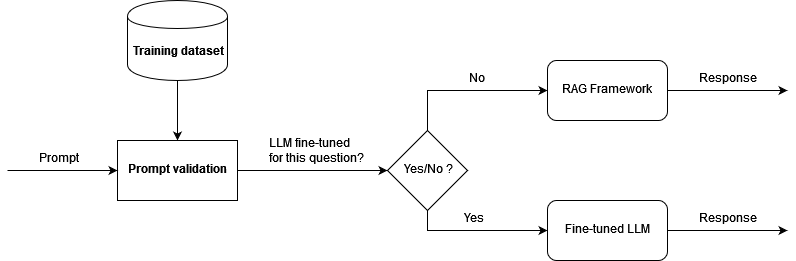

לפתרון יש את הרכיבים הבאים, כפי שמוצג בתרשים הארכיטקטורה:

- מאגר תוכן – התוכן של D&C כולל מגוון רחב של מסמכים הניתנים לקריאה על ידי אדם בפורמטים שונים, כגון קבצי PDF, גיליונות אקסל, דפי ויקי ועוד. בפתרון זה, אחסנו את התוכן הזה ב-an שירות אחסון פשוט של אמזון (Amazon S3) bucket והשתמש בהם כבסיס ידע לאחזור מידע כמו גם הסקה. בעתיד, נבנה מתאמי אינטגרציה כדי לגשת לתוכן ישירות מהמקום בו הם מתגוררים.

- מסגרת RAG עם LLM מכוון עדין - זה מורכב ממרכיבי המשנה הבאים:

- מסגרת RAG - זה מאחזר את הנתונים הרלוונטיים ממסמכים, מגדיל את ההנחיות על ידי הוספת הנתונים שאוחזרו בהקשר, ומעביר אותם ל-LLM מכוון עדין כדי ליצור פלטים.

- LLM מכוון עדין – בנינו את מערך ההדרכה מהמסמכים והתכנים וביצענו כוונון עדין על מודל הבסיס. לאחר הכוונון, המודל למד את הידע מתכני D&C, ולכן יכול להגיב לשאלות באופן עצמאי.

- מודול אימות מהיר – זה מודד את ההתאמה הסמנטית בין ההנחיה של המשתמש למערך הנתונים לצורך כוונון עדין. אם ה-LLM מכוון עדין לענות על שאלה זו, אז אתה יכול להסיק מהמודל המכוונן לקבלת תגובה. אם לא, אתה יכול להשתמש ב- RAG כדי ליצור את התגובה.

- LangChain - אנו משתמשים LangChain לבנות זרימת עבודה שתענה על השאלות הנכנסות.

- ממשק משתמש קצה – זהו ממשק המשתמש של הצ'אטבוט ללכוד שאלות ושאילתות של משתמשים, ולהציג את התשובה מתגובת RAG ו- LLM.

בסעיפים הבאים, אנו מדגים כיצד ליצור את זרימת העבודה של RAG ולבנות את המודלים המכוונים.

RAG עם דגמי יסוד של SageMaker JumpStart

RAG משלבת את הכוחות של שליפה צפופה מאומנת מראש ומודלים של יסודות רצף לרצף (seq2seq). למענה על שאלות ממסמכי Amazon D&C, עלינו להכין את הדברים הבאים מראש:

- הטמעה ואינדקס המסמכים באמצעות מודל הטבעה של LLM - חילקנו את המסמכים המרובים לנתחים קטנים בהתבסס על מבנה הפרק והקטע של המסמך, בדקנו עם דגם Amazon GPT-J-6B ב-SageMaker JumpStart כדי ליצור את האינדקסים, ואחסנו את האינדקסים בחנות וקטורית של FAISS

- מודל יסוד מיומן מראש ליצירת תגובות מהנחיות – בדקנו עם דגמי Flan-T5 XL, Flan-T5 XXL ו-Falcon-7B ב- SageMaker JumpStart

תהליך המענה לשאלות מיושם על ידי LangChain, שהיא מסגרת לפיתוח אפליקציות המופעלות על ידי מודלים של שפה. זרימת העבודה בשרשרת מכילה את השלבים הבאים:

- קבל שאלה מהמשתמש.

- בצע חיפוש סמנטי על המסמכים המאונדקסים באמצעות FAISS כדי לקבל את ה-K נתחי המסמכים המובילים ביותר.

- הגדר את תבנית ההנחיה, כגון

- הגדל את נתחי המסמך שאוחזר כ-

{context}ושאלת המשתמש בתור ה{question}בהנחיה. - הנח את מודל היסוד עם ההנחיה שנבנתה עם יריית אפס.

- החזר את פלט הדגם למשתמש.

בדקנו 125 שאלות על דרישות ומפרטי Amazon D&C, ו-RAG החזירה תשובה טובה לכמה שאלות. בדוגמה הבאה, RAG עם דגם Flan-T5-XXL סיפק תגובה מדויקת מהחלקים הנכונים של המסמכים.

| שאלה | מהן דרישות האינסטלציה עבור מזרקות שתייה ומקררי מים? (סעיף 22 47 00) |

| תשובה צפויה | היזם יספק סורגים להפקת מים, העומדים על הרצפה בחלל קיר המחסן, בסמוך לכניסה של כל בלוק שירותים המשרת את המחסן ובמיקום המקביל בצמוד לבלוק השירותים של חדר ההלבשה. היחידות יהיו בהתאם לתקן אמזון. מספרים סופיים ומיקום יסוכמו עם אמזון לפני ההתקנה. לפחות שתי יחידות מזרקות מים מקוררים וטמפרטורת החדר שיסופקו בכל מקום. מצנני מים או ברי מים - היזם יספק אספקת מים לשתייה כנדרש למקררי מים או ברי מים מרוחקים ברחבי המתקן. היזם יספק נקודות מים, ניקוז וכל שירותי חשמל הנדרשים בחדרי ההפסקה לברי המים אשר יסופקו על ידי קבלן הקייטרינג. |

| תשובה RAG (הטמעת GPT-J-6B עם Flan-T5-XXL) | היזם יספק סורגים להפקת מים, העומדים על הרצפה בחלל קיר המחסן, בסמוך לכניסה של כל בלוק שירותים המשרת את המחסן ובמיקום המקביל בצמוד לבלוק השירותים של חדר ההלבשה. היחידות יהיו בהתאם לתקן אמזון. מספרים סופיים ומיקום יסוכמו עם אמזון לפני ההתקנה. לפחות שתי יחידות מזרקות מים מקוררים וטמפרטורת החדר שיסופקו בכל מקום. מצנני מים או ברי מים - היזם יספק אספקת מים לשתייה כנדרש למקררי מים או ברי מים מרוחקים ברחבי המתקן. היזם יספק נקודות מים, ניקוז וכל שירותי חשמל הנדרשים בחדרי ההפסקה לברי המים אשר יסופקו על ידי קבלן הקייטרינג. |

עם זאת, ראינו ש-RAG לא מספקת תשובות ברורות וברורות לשאלות שהן יותר ספציפיות וטכניות, כגון הנחיות, מספרים ואיורים. כפי שמוצג בדוגמה הבאה, כאשר צפוי פלט של מימד טכני, RAG לא יכול לספק את התשובה הספציפית, בעיקר בגלל שתהליך ההטמעה והחיפוש לא יכול להחזיר הקשר תמציתי.

| שאלה | מהי הדרישה לגובה הרצפה עבור בטון ברמת קומה ראשונה P2? |

| תשובה צפויה | 7,50 מ' AFFL |

| תשובה RAG (הטמעת GPT-J-6B עם Flan-T5-XXL) | P2 בטון ברמת קומה ראשונה |

יש לשפר זאת מכיוון שהזיה אינה נסבלת בשל קריטיות ההשלכות במקרה שימוש זה.

כוונן את לימודי הלימוד LLM ב- SageMaker

כדי להתמודד עם אתגר זה ולשפר את איכות התגובה, אנו נוקטים בגישה חדשה לכוונון עדין של מודל ה-LLM באמצעות המסמכים עבור משימת מענה לשאלות. המודל יוכשר ללמוד את הידע המתאים מהמסמכים ישירות. שלא כמו RAG, זה לא תלוי אם המסמכים מוטבעים ומוספים כהלכה, ואם אלגוריתם החיפוש הסמנטי יעיל מספיק כדי להחזיר את התוכן הרלוונטי ביותר ממסד הנתונים הווקטוריים.

כדי להכין את מערך ההדרכה לכיוונון עדין, אנו מחלצים את המידע ממסמכי D&C ובונים את הנתונים בפורמט הבא:

- הוראה – מתאר את המשימה ומספק הנחיה חלקית

- קֶלֶט - מספק הקשר נוסף שיש לאחד לתוך ההנחיה

- תְגוּבָה – הפלט של הדגם

במהלך תהליך האימון, אנו מוסיפים מפתח הוראות, מפתח קלט ומפתח תגובה לכל חלק, משלבים אותם בהנחיית האימון ומסמנים אותו. לאחר מכן הנתונים מוזנים למאמן ב- SageMaker כדי ליצור את המודל המכוונן.

כדי להאיץ את תהליך ההכשרה ולהפחית את עלות משאבי המחשוב, העסיקנו כוונון עדין יעיל של פרמטרים (PEFT) עם ה התאמה בדרגה נמוכה טכניקת (LoRA). PEFT מאפשר לנו לכוונן רק מספר קטן של פרמטרים נוספים של דגם, ו-LoRA מייצג את עדכוני המשקל עם שתי מטריצות קטנות יותר באמצעות פירוק בדרגה נמוכה. עם PEFT ו-LoRA על קוונטיזציה של 8 סיביות (פעולת דחיסה שמקטינה עוד יותר את טביעת הזיכרון של המודל ומאיצה את ביצועי האימון וההסקה), אנו מסוגלים להתאים את האימון של 125 זוגות שאלות ותשובות בתוך מופע g4dn.x עם GPU יחיד.

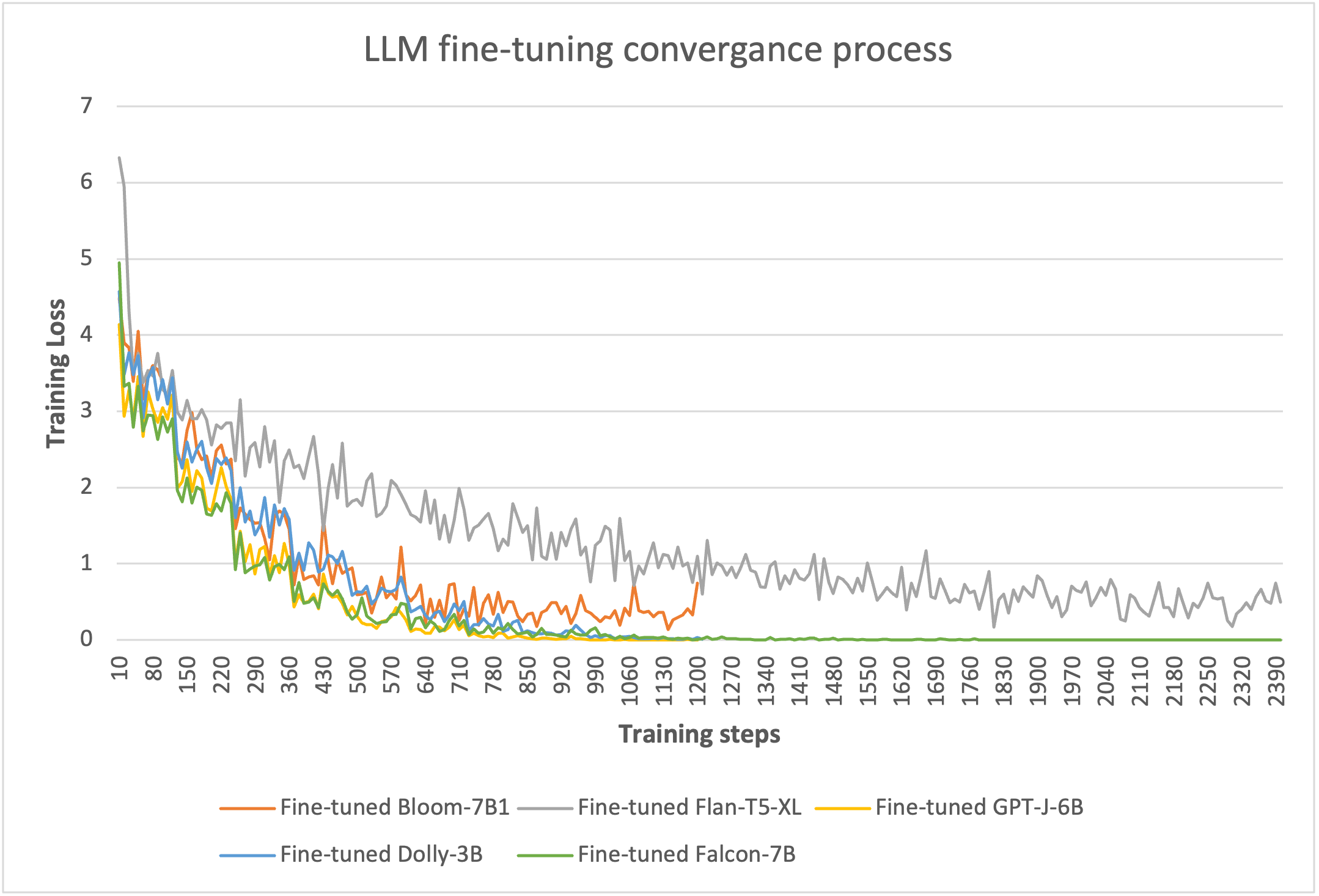

כדי להוכיח את יעילות הכוונון העדין, בדקנו עם מספר LLMs ב- SageMaker. בחרנו חמישה דגמים בגודל קטן: Bloom-7B, Flan-T5-XL, GPT-J-6B ו-Falcon-7B ב- SageMaker JumpStart, ודולי-3B מ- פנים מחבקות ב- SageMaker.

באמצעות אימון מבוסס LoRA של 8 סיביות, אנו מסוגלים לצמצם את הפרמטרים הניתנים לאימון ללא יותר מ-5% מהמשקל המלא של כל דגם. האימון לוקח 10-20 עידנים להתכנס, כפי שמוצג באיור הבא. עבור כל דגם, תהליכי הכוונון העדינים יכולים להתאים ל-GPU יחיד של מופע g4dn.x, מה שמיטב את עלויות משאבי המחשוב.

הסיק את הדגם המכוונן שנפרס ב- SageMaker

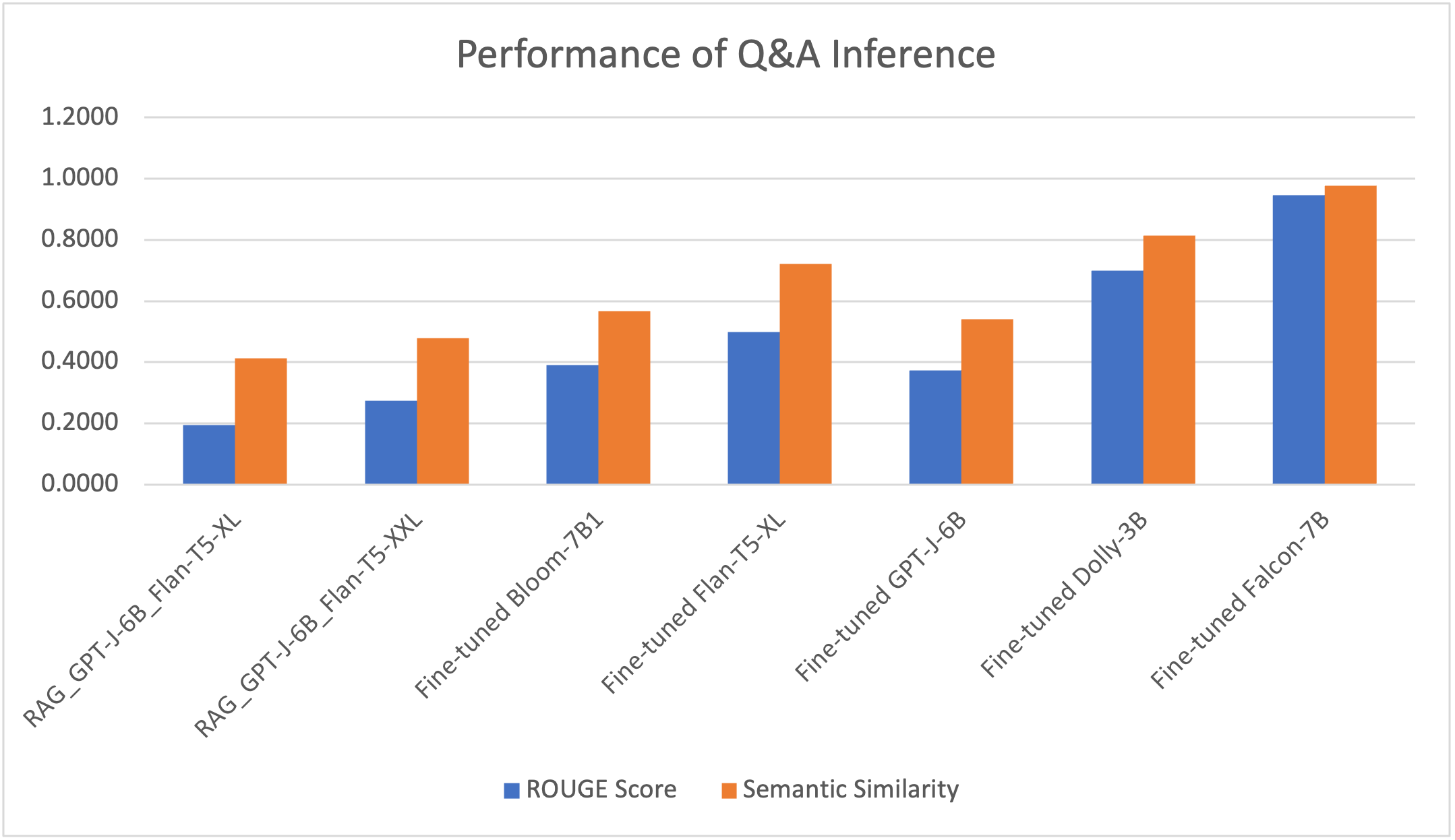

פרסנו את המודל המכוונן יחד עם מסגרת RAG בצומת GPU יחיד g4dn.x ב- SageMaker והשווינו את תוצאות ההסקה עבור 125 השאלות. ביצועי המודל נמדדים על ידי שני מדדים. האחד הוא ה אדום (Recall-Oriented Understudy for Gisting Evaluation), ציון פופולרי עיבוד שפה טבעית שיטת הערכת מודל (NLP) המחשבת את מנת המילים התואמות תחת הספירה הכוללת של המילים במשפט ההתייחסות. השני הוא ה דמיון סמנטי (טקסטואלי). score, המודד עד כמה המשמעות של שני חלקי משמעויות טקסט קרובה על ידי שימוש במודל שנאי כדי לקודד משפטים כדי לקבל את ההטמעות שלהם, ולאחר מכן שימוש במדד דמיון קוסינוס כדי לחשב את ציון הדמיון שלהם. מהניסויים, אנו יכולים לראות שני מדדים אלה עקביים למדי בהצגת איכות התשובות לשאלות.

בטבלה ובאיור הבאות, אנו יכולים לראות שדגם ה-Falcon-7B המכוונן עדין מספק את איכות המענה הטובה ביותר, וגם הדגמים Flan-T5-XL ו-Dolly-3B מייצרים תגובות מדויקות.

| . | RAG_GPT-J-6B_Flan-T5-XL | RAG_GPT-J-6B_Flan-T5-XXL | כוונון עדין של Bloom-7B1 | Flan-T5-XL מכוון עדין | GPT-J-6B מכוון עדין | דולי-3B מכוון עדין | Falcon-7B מכוון עדין |

| ציון ROUGE | 0.1938 | 0.2747 | 0.3914 | 0.4977 | 0.3740 | 0.6991 | 0.9459 |

| ציון דמיון סמנטי | 0.4121 | 0.4786 | 0.5666 | 0.7205 | 0.5414 | 0.8147 | 0.9774 |

להלן תשובה אחת לדוגמה מהמודלים. RAG עם דגם Flan-T5-XL סיפק תגובה הזויה ביותר, בעוד שהתגובה של RAG עם דגם Flan-T5-XXL הגדול יותר הייתה רלוונטית יותר אך עדיין לא הצליחה לכסות את המסר המצופה במלואו. באופן השוואתי, כל הדגמים המכוונים (Flan-T5-XL, Dolly-3B ו-Falcon-7B) הצליחו לספק את התגובה המדויקת ביותר כתשובה הצפויה.

| שאלה | מהן הדרישות לאטם/מקשה לאחר השחזה? (TS0004 – סעיף 2.8) |

| תשובה צפויה | איטום/מקשה מבוסס ליתיום ישמש לאחר כל הליכי השחזה/שיוף שיבוצעו על רצפת AR. אנא עיין בהליכי TGC /0007 AR Floor SCA. חלופות ייבחנו אך צריכות להיות מאושרות על ידי אמזון ויועץ הריצוף. |

| תשובה מ-RAG (הטבעה של GPT-J-6B עם Flan-T5-XL) | יש לדון במקשה בטון חודר בפגישת הטרום יציקה ויש לקבל את אישורו של יועץ הריצוף ואמזון |

| תשובה מ-RAG (הטמעת GPT-J-6B עם Flan-T5-XXL) | יש לדון במתחם המוצע בפגישת הקדם-יציקה ויש לקבל את אישורו של יועץ הריצוף ואמזון. חלופות ייבחנו אך צריכות להיות מאושרות על ידי אמזון ויועץ הריצוף. |

| תשובה מ-Flan-T5-XL המכוונן עדין | איטום/מקשה מבוסס ליתיום ישמש לאחר כל הליכי השחזה/שיוף שיבוצעו על רצפת AR. אנא עיין בהליכי TGC /0007 AR Floor SCA. חלופות ייבחנו אך צריכות להיות מאושרות על ידי אמזון ויועץ הריצוף. |

| תשובה מ-Dolly-3B המכוונן עדין | איטום/מקשה מבוסס ליתיום ישמש לאחר כל הליכי השחזה/שיוף שיבוצעו על רצפת AR. אנא עיין בהליכי TGC /0007 AR Floor SCA. חלופות ייבחנו אך צריכות להיות מאושרות על ידי אמזון ויועץ הריצוף. |

| תשובה מ-Falcon-7B המכוונן עדין | איטום/מקשה מבוסס ליתיום ישמש לאחר כל הליכי השחזה/שיוף שיבוצעו על רצפת AR. אנא עיין בהליכי TGC /0007 AR Floor SCA. חלופות ייבחנו אך צריכות להיות מאושרות על ידי אמזון ויועץ הריצוף. |

אב טיפוס ותוצאה של פתרון

פיתחנו אב טיפוס המבוסס על הארכיטקטורה שהוצגה וביצענו הוכחת קונספט כדי להדגים את התוצאה. כדי לנצל גם את מסגרת ה- RAG וגם את ה-LLM המכוונן עדין, וגם כדי להפחית את ההזיה, תחילה אנו מאשרים סמנטי את השאלה הנכנסת. אם השאלה היא בין נתוני ההדרכה לכיוונון העדין (למודל המכוונן כבר יש את הידע לספק תשובה איכותית), אז אנו מפנים את השאלה כהנחיה להסקת המודל המכוונן. אחרת, השאלה עוברת דרך LangChain ומקבלת את התגובה מ-RAG. התרשים הבא ממחיש זרימת עבודה זו.

בדקנו את הארכיטקטורה עם מערך בדיקה של 166 שאלות, המכיל את 125 השאלות ששימשו לכוונון עדין של המודל ו-41 שאלות נוספות שהמודל המכוונן לא הוכשר איתן. מסגרת RAG עם מודל ההטמעה ודגם Falcon-7B המכוונן עדין סיפקה תוצאות באיכות גבוהה עם ציון ROUGE של 0.7898 וציון דמיון סמנטי של 0.8781. כפי שמוצג בדוגמאות הבאות, המסגרת מסוגלת ליצור תשובות לשאלות של משתמשים המתואמות היטב למסמכי D&C.

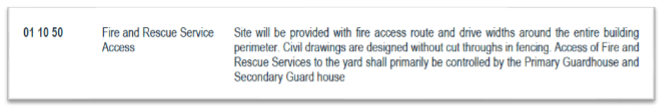

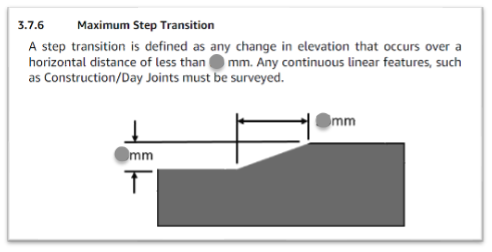

התמונה הבאה היא מסמך הדוגמה הראשון שלנו.

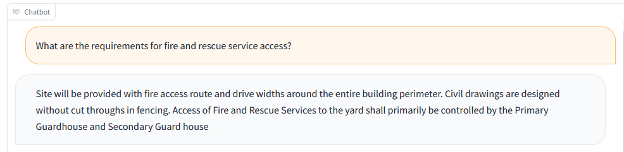

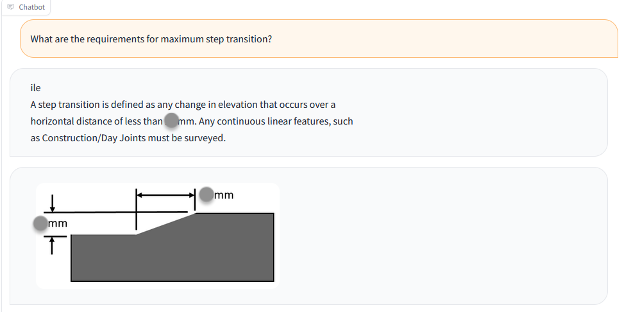

צילום המסך הבא מציג את פלט הבוט.

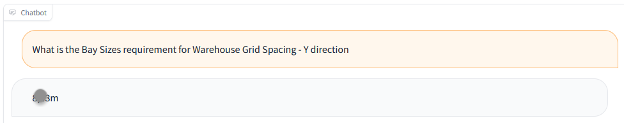

הבוט מסוגל גם להגיב עם נתונים מטבלה או רשימה ולהציג נתונים עבור השאלות המתאימות. לדוגמה, אנו משתמשים במסמך הבא.

צילום המסך הבא מציג את פלט הבוט.

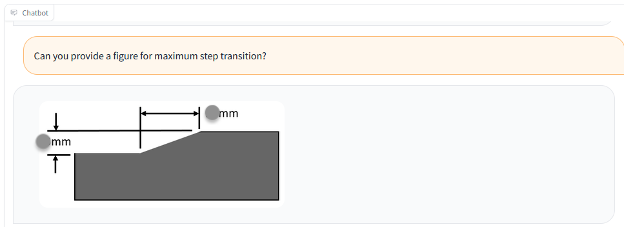

אנו יכולים גם להשתמש במסמך עם דמות, כמו בדוגמה הבאה.

צילום המסך הבא מציג את פלט הבוט עם טקסט ואיור.

צילום המסך הבא מציג את פלט הבוט עם הדמות בלבד.

הפקת לקחים ושיטות עבודה מומלצות

באמצעות עיצוב הפתרון והניסויים עם מספר רב של LLMs, למדנו כיצד להבטיח את האיכות והביצועים עבור משימת המענה לשאלות בפתרון AI מחולל. אנו ממליצים על השיטות המומלצות הבאות כאשר אתה מיישם את הפתרון לשאלתך המענה למקרי שימוש:

- RAG מספקת תשובות הגיוניות לשאלות הנדסיות. הביצועים תלויים במידה רבה בהטמעת מסמכים ואינדקס. עבור מסמכים מאוד לא מובנים, ייתכן שתזדקק לעבודה ידנית כדי לפצל ולהגדיל את המסמכים כראוי לפני הטבעה והוספה של LLM.

- חיפוש האינדקס חשוב לקביעת הפלט הסופי של RAG. עליך לכוון כראוי את אלגוריתם החיפוש כדי להשיג רמת דיוק טובה ולהבטיח ש- RAG ייצור תגובות רלוונטיות יותר.

- לימודי LLM מכוונים עדינים מסוגלים ללמוד ידע נוסף ממסמכים טכניים ובלתי מובנים ביותר, ולהחזיק בידע בתוך המודל ללא תלות במסמכים לאחר ההכשרה. זה שימושי במיוחד במקרים שבהם ההזיה לא נסבלת.

- כדי להבטיח את איכות תגובת המודל, פורמט מערך ההדרכה לכוונון עדין צריך להשתמש בתבנית הנחיה מוגדרת כהלכה, ספציפית למשימה. צינור ההסקה צריך לעקוב אחר אותה תבנית כדי ליצור תגובות דמויות אדם.

- LLMs מגיעים לרוב עם תג מחיר משמעותי ודורשים משאבים ניכרים ועלויות מוגזמות. אתה יכול להשתמש ב-PEFT וב-LoRA ובטכניקות קוונטיזציה כדי להפחית את הדרישה לכוח מחשוב ולהימנע מעלויות הכשרה והסקת מסקנות גבוהות.

- SageMaker JumpStart מספקת LLMs מאומנים מראש קלים לגישה לכוונון עדין, מסקנות ופריסה. זה יכול להאיץ באופן משמעותי את התכנון והיישום של פתרונות הבינה המלאכותית.

סיכום

עם מסגרת RAG ו-LLMs מכוונים ב- SageMaker, אנו מסוגלים לספק תשובות דמויות אנושיות לשאלות והנחיות של משתמשים, ובכך לאפשר למשתמשים לאחזר ביעילות מידע מדויק מכמות גדולה של מסמכים מאוד לא מובנים ולא מאורגנים. נמשיך לפתח את הפתרון, כגון מתן רמה גבוהה יותר של תגובה הקשרית מאינטראקציות קודמות, ועוד כוונון עדין של המודלים ממשוב אנושי.

המשוב שלך תמיד יתקבל בברכה; אנא השאר את המחשבות והשאלות שלך בקטע ההערות.

על המחברים

יונפאי באי הוא אדריכל פתרונות בכיר ב-AWS. עם רקע ב-AI/ML, מדעי נתונים וניתוח, Yunfei עוזרת ללקוחות לאמץ שירותי AWS כדי לספק תוצאות עסקיות. הוא מעצב פתרונות AI/ML וניתוח נתונים שמתגברים על אתגרים טכניים מורכבים ומניעים יעדים אסטרטגיים. ליונפיי יש דוקטורט בהנדסת אלקטרוניקה וחשמל. מחוץ לעבודה, יונפיי נהנית מקריאה ומוזיקה.

יונפאי באי הוא אדריכל פתרונות בכיר ב-AWS. עם רקע ב-AI/ML, מדעי נתונים וניתוח, Yunfei עוזרת ללקוחות לאמץ שירותי AWS כדי לספק תוצאות עסקיות. הוא מעצב פתרונות AI/ML וניתוח נתונים שמתגברים על אתגרים טכניים מורכבים ומניעים יעדים אסטרטגיים. ליונפיי יש דוקטורט בהנדסת אלקטרוניקה וחשמל. מחוץ לעבודה, יונפיי נהנית מקריאה ומוזיקה.

בורק גוזלוקלו הוא אדריכל ראשי ב-ML מומחה לפתרונות הממוקם בבוסטון, MA. לבוראק יש למעלה מ-15 שנות ניסיון בתעשייה בדוגמנות סימולציה, מדעי נתונים וטכנולוגיית ML. הוא עוזר ללקוחות גלובליים לאמץ טכנולוגיות AWS ובמיוחד פתרונות AI/ML כדי להשיג את היעדים העסקיים שלהם. לבוראק יש דוקטורט בהנדסת אווירונאוטיקה וחלל מ- METU, תואר שני בהנדסת מערכות ופוסט-דוקטורט בדינמיקה של מערכת מ-MIT בקיימברידג', MA. בורק נלהב מיוגה ומדיטציה.

בורק גוזלוקלו הוא אדריכל ראשי ב-ML מומחה לפתרונות הממוקם בבוסטון, MA. לבוראק יש למעלה מ-15 שנות ניסיון בתעשייה בדוגמנות סימולציה, מדעי נתונים וטכנולוגיית ML. הוא עוזר ללקוחות גלובליים לאמץ טכנולוגיות AWS ובמיוחד פתרונות AI/ML כדי להשיג את היעדים העסקיים שלהם. לבוראק יש דוקטורט בהנדסת אווירונאוטיקה וחלל מ- METU, תואר שני בהנדסת מערכות ופוסט-דוקטורט בדינמיקה של מערכת מ-MIT בקיימברידג', MA. בורק נלהב מיוגה ומדיטציה.

אלעד דווק הוא מנהל טכנולוגיות בנייה באמזון. עם רקע בבנייה וניהול פרויקטים, אלעד מסייעת לצוותים לאמץ טכנולוגיות חדשות ותהליכים מבוססי נתונים כדי לספק פרויקטי בנייה. הוא מזהה צרכים ופתרונות, ומקל על פיתוח התכונות המותאמות אישית. לאלעד תואר MBA ותואר ראשון בהנדסת מבנים. מחוץ לעבודה, אלעד אוהב יוגה, עיבוד עץ ומטיילים עם משפחתו.

אלעד דווק הוא מנהל טכנולוגיות בנייה באמזון. עם רקע בבנייה וניהול פרויקטים, אלעד מסייעת לצוותים לאמץ טכנולוגיות חדשות ותהליכים מבוססי נתונים כדי לספק פרויקטי בנייה. הוא מזהה צרכים ופתרונות, ומקל על פיתוח התכונות המותאמות אישית. לאלעד תואר MBA ותואר ראשון בהנדסת מבנים. מחוץ לעבודה, אלעד אוהב יוגה, עיבוד עץ ומטיילים עם משפחתו.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/a-generative-ai-powered-solution-on-amazon-sagemaker-to-help-amazon-eu-design-and-construction/

- :יש ל

- :הוא

- :לֹא

- :איפה

- 1

- 100

- 125

- שנים 15

- 15%

- 152

- 17

- 22

- 41

- 50

- 7

- 8

- 80

- 9

- a

- יכול

- אודות

- להאיץ

- מאיץ

- גישה

- בהתאם

- דיוק

- מדויק

- להשיג

- לרוחב

- מסתגל

- להוסיף

- מוסיף

- נוסף

- כתובת

- ממוען

- סמוך

- לְאַמֵץ

- לקדם

- יתרון

- אווירי

- לאחר

- מוסכם

- AI

- מונע AI

- AI / ML

- אַלגוֹרִיתְם

- תעשיות

- מאפשר

- לבד

- לאורך

- כְּבָר

- גם

- חלופות

- תמיד

- אמזון בעברית

- אמזון SageMaker

- אמזון שירותי אינטרנט

- בין

- an

- אנליזה

- ניתוח

- ו

- לענות

- תשובות

- כל

- ישים

- יישומים

- החל

- גישה

- מאושר

- AR

- ארכיטקטורה

- ARE

- AS

- At

- תכונות

- מוגבר

- לְהִמָנַע

- AWS

- רקע

- סורגים

- בסיס

- מבוסס

- Baseline

- BE

- כי

- לפני

- תועלת

- בהתאמה אישית

- הטוב ביותר

- שיטות עבודה מומלצות

- מוטב

- בֵּין

- לחסום

- בוסטון

- בוט

- שניהם

- לשבור

- רחב

- BSC

- לִבנוֹת

- עסקים

- אבל

- by

- מחשב

- קיימברידג'

- CAN

- ללכוד

- מקרה

- מקרים

- מֶרכָּזִי

- שרשרת

- לאתגר

- האתגרים

- הפרק

- chatbot

- בדיקות

- ברור

- סְגוֹר

- קיבוץ

- לשלב

- משלב

- איך

- הערות

- באופן יחסי

- לְהַשְׁווֹת

- לעומת

- מורכב

- הענות

- רכיבים

- תרכובת

- מורכב

- לחשב

- מושג

- תמציתית

- מנוהל

- השלכות

- רב

- נחשב

- עִקבִי

- מורכב

- לבנות

- בנייה

- בניה

- יועץ

- מכיל

- תוכן

- הקשר

- קשר

- להמשיך

- קבלן

- לעומת זאת

- לְהִתְכַּנֵס

- ליבה

- תוֹאֵם

- עלות

- עלויות

- לכסות

- לִיצוֹר

- יוצר

- קריטי

- ביקורתיות

- לקוחות

- נתונים

- ניתוח נתונים

- מדע נתונים

- מסד נתונים

- מוגדר

- למסור

- דרישה

- להפגין

- תלות

- תלוי

- פרס

- פריסה

- עיצוב

- תכנון

- עיצובים

- לקבוע

- לפתח

- מפותח

- מפתח

- מתפתח

- צעצועי התפתחות

- אחר

- מֵמַד

- ישיר

- ישירות

- לדון

- נָדוֹן

- לְהַצִיג

- מסמך

- מסמכים

- לא

- תעלת ניקוז

- נהיגה

- ראוי

- דינמיקה

- כל אחד

- אפקטיבי

- יְעִילוּת

- יעיל

- יעילות

- אֶלֶקטרוֹנִי

- מוטבע

- הטבעה

- מוּעֳסָק

- לאפשר

- מה שמאפשר

- מאורס

- הנדסה

- מספיק

- לְהַבטִיחַ

- שלם

- תקופות

- שווה

- במיוחד

- EU

- אירופה

- הערכה

- דוגמה

- דוגמאות

- Excel

- קיימים

- צפוי

- ניסיון

- ניסויים

- מומחים

- נוסף

- תמצית

- מקל

- מתקן

- למדי

- משפחה

- הפד

- מָשׁוֹב

- תרשים

- דמויות

- קבצים

- סופי

- ראשון

- מתאים

- חמש

- קוֹמָה

- לעקוב

- הבא

- עָקֵב

- בעד

- פוּרמָט

- קרן

- מסגרת

- החל מ-

- מלא

- נוסף

- עתיד

- ליצור

- מייצר

- גנרטטיבית

- AI Generative

- לקבל

- גלוֹבָּלִי

- Goes

- טוב

- GPU

- טחינה

- הנחיות

- he

- בִּכְבֵדוּת

- גבהים

- לעזור

- עוזר

- גָבוֹהַ

- באיכות גבוהה

- גבוה יותר

- מאוד

- שֶׁלוֹ

- איך

- איך

- HTML

- HTTPS

- בן אנוש

- קריא אדם

- מזהה

- if

- מדגים

- תמונה

- תמונות

- מיד

- הפעלה

- יושם

- יישום

- חשוב

- לשפר

- משופר

- in

- לכלול

- נכנס

- באופן עצמאי

- מדד

- -

- אינדקסים

- תעשייה

- מידע

- קלט

- התקנה

- למשל

- השתלבות

- יחסי גומלין

- אל תוך

- לערב

- מעורב

- IT

- jpg

- רק

- מפתח

- ידע

- שפה

- גָדוֹל

- גדול יותר

- לִלמוֹד

- למד

- יציאה

- פחות

- שיעורים

- הפקת לקחים

- רמה

- מעגל החיים

- מוגבל

- רשימה

- רשימות

- לחיות

- LLM

- ממוקם

- מיקום

- הסתכלות

- בעיקר

- ניהול

- מנהל

- מדריך ל

- עבודה ידנית

- רב

- להתאים

- מתאים

- תואם

- דבר

- מאי..

- משמעות

- משמעויות

- אמצעים

- מפגש

- זכרון

- MENA

- אזור המזרח התיכון וצפון אפריקה

- הודעה

- שיטה

- מתודולוגיות

- מטרי

- מדדים

- מינימום

- MIT

- ML

- מודל

- דוגמנות

- מודלים

- יותר

- רוב

- MS

- מספר

- כלי נגינה

- צריך

- צורך

- צרכי

- חדש

- טכנולוגיות חדשות

- הבא

- NLP

- לא

- צומת

- בייחוד

- מספר

- מספרים

- יעדים

- of

- לעתים קרובות

- on

- ONE

- רק

- קוד פתוח

- מבצע

- אופטימיזציה

- or

- להזמין

- אחר

- אַחֶרֶת

- שלנו

- תוֹצָאָה

- תפוקה

- בחוץ

- יותר

- להתגבר על

- דפים

- זוגות

- פרמטרים

- חלק

- מעברי

- לוהט

- ביצועים

- ביצעתי

- דוקטורט

- חתיכות

- צינור

- מיקום

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- אנא

- נקודות

- פופולרי

- להחזיק

- הודעה

- כּוֹחַ

- מופעל

- כוחות

- פרקטיקות

- מראש

- להכין

- להציג

- מוצג

- קודם

- מחיר

- מנהל

- קודם

- נהלים

- להמשיך

- תהליך

- תהליכים

- פּרוֹיֶקט

- ניהול פרויקטים

- פרויקטים

- הוכחה

- הוכחה של רעיון או תאוריה

- כמו שצריך

- הצעות

- מוּצָע

- אב טיפוס

- להוכיח

- לספק

- ובלבד

- מספק

- מתן

- איכות

- שאילתות

- שאלה

- שאלות

- מָהִיר

- מהירות

- רכס

- קריאה

- עולם אמיתי

- סביר

- להמליץ

- להפחית

- מפחית

- להתייחס

- בדבר

- באזור

- רלוונטי

- מרחוק

- דוחות לדוגמא

- מייצג

- בקשות

- נדרש

- דרישה

- דרישות

- משאב

- משאבים

- להגיב

- תגובה

- תגובות

- תוצאות

- לַחֲזוֹר

- סקירה

- תקין

- חֶדֶר

- חדרים

- בעל חכמים

- אותו

- מדע

- היקף

- ציון

- חיפוש

- חיפושים

- חיפוש

- סעיף

- סעיפים

- לִרְאוֹת

- נבחר

- לחצני מצוקה לפנסיונרים

- משפט

- שרות

- שירותים

- הגשה

- צריך

- הראה

- הופעות

- משמעותי

- באופן משמעותי

- פָּשׁוּט

- הדמיה

- יחיד

- קטן

- קטן יותר

- חברות קטנות ובינוניות

- פִּתָרוֹן

- פתרונות

- כמה

- מֶרחָב

- מומחה

- מיוחד

- ספציפי

- במיוחד

- מפרטים

- לפצל

- בעלי עניין

- תֶקֶן

- צעדים

- עוד

- אחסון

- מאוחסן

- אסטרטגי

- התייעלות

- מִבנִי

- מִבְנֶה

- נושא

- ניכר

- כזה

- מערכת

- מערכות

- שולחן

- תָג

- לקחת

- לוקח

- המשימות

- נבחרת

- צוותי

- טכני

- טכניקות

- טכנולוגיות

- טכנולוגיה

- תבנית

- מבחן

- נבדק

- טֶקסט

- טקסטואלית

- מֵאֲשֶׁר

- זֶה

- השמיים

- העתיד

- המידע

- שֶׁלָהֶם

- אותם

- אז

- בכך

- לכן

- אלה

- הֵם

- זֶה

- דרך

- בכל

- ל

- היום

- tokenize

- חלק עליון

- סה"כ

- מְאוּמָן

- הדרכה

- שנאי

- נסיעה

- שתיים

- סוגים

- ui

- תחת

- יחידות

- בניגוד

- עדכונים

- us

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- משתמשים

- שימושים

- באמצעות

- לנצל

- לְאַמֵת

- אימות

- ערך

- ערכים

- שונים

- כֶּרֶך

- קיר

- היה

- מים

- we

- אינטרנט

- שירותי אינטרנט

- מִשׁקָל

- ברוך הבא

- טוֹב

- היו

- מתי

- ואילו

- אם

- אשר

- מי

- רָחָב

- טווח רחב

- ויקיפדיה

- יצטרך

- עם

- בתוך

- מילים

- תיק עבודות

- זרימת עבודה

- עובד

- X

- שנים

- יוגה

- אתה

- זפירנט