実稼働環境での機械学習 (ML) モデルのデプロイを成功させるには、エンドツーエンドの ML パイプラインに大きく依存します。 このようなパイプラインの開発は困難な場合がありますが、問題を扱う場合はさらに複雑になります。 エッジ ML の使用例。 エッジでの機械学習は、ML モデルをローカルで実行する機能をエッジ デバイスにもたらす概念です。 これらのモデルをエッジで展開、監視、保守するには、堅牢な MLOps パイプラインが必要です。 MLOps パイプラインを使用すると、データのラベル付けからモデルのトレーニングとデプロイに至るまで、ML ライフサイクル全体を自動化できます。

エッジに MLOps パイプラインを実装すると、さらに複雑さが生じ、運用オーバーヘッドが増加するため、自動化、統合、メンテナンスのプロセスがより困難になります。 ただし、次のような専用サービスを使用すると、 アマゾンセージメーカー および AWS IoT Greengrass を使用すると、この労力を大幅に削減できます。 このシリーズでは、SageMaker、AWS IoT Greengrass、および AWSクラウド開発キット (AWS CDK)。

この投稿では、MLOps パイプライン アーキテクチャ全体の設計に焦点を当てます。 第2部 および 第3部 このシリーズでは、個々のコンポーネントの実装に焦点を当てます。 付属のサンプル実装を提供しています。 GitHubリポジトリ あなた自身を試してみてください。 AWS のエッジで MLOps を使い始めたばかりの場合は、を参照してください。 Amazon SageMaker Edge Manager と AWS IoT Greengrass を使用したエッジでの MLOps 概要とリファレンス アーキテクチャについては、

使用例: 金属タグの品質検査

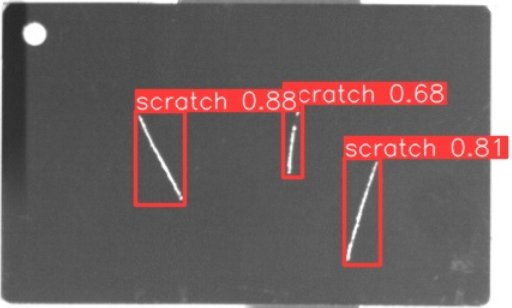

ML エンジニアとして、取り組んでいるビジネスケースを理解することが重要です。 MLOps パイプライン アーキテクチャに入る前に、この投稿のサンプル ユースケースを見てみましょう。 カスタマイズされた荷物タグを作成するために金属タグを彫刻するメーカーの生産ラインを想像してください。 未加工の金属タグに傷などの欠陥がないか手動で検査する必要があるため、品質保証プロセスにはコストがかかります。 このプロセスをより効率的にするために、ML を使用してプロセスの早い段階で欠陥のあるタグを検出します。 これは、生産プロセスの後の段階で、コストのかかる欠陥を回避するのに役立ちます。 モデルは、傷などの可能性のある欠陥をほぼリアルタイムで特定し、マークする必要があります。 製造現場の環境では、多くの場合、接続がない場合や帯域幅の制約、遅延の増加に対処する必要があります。 したがって、製造現場でローカルに推論を実行し、接続に関する要件を軽減できる、視覚的な品質検査用のオンエッジ ML ソリューションを実装したいと考えています。 例をわかりやすくするために、検出された傷を境界ボックスでマークするモデルをトレーニングします。 次の画像は、XNUMX つのスクラッチがマークされたデータセットのタグの例です。

パイプライン アーキテクチャの定義

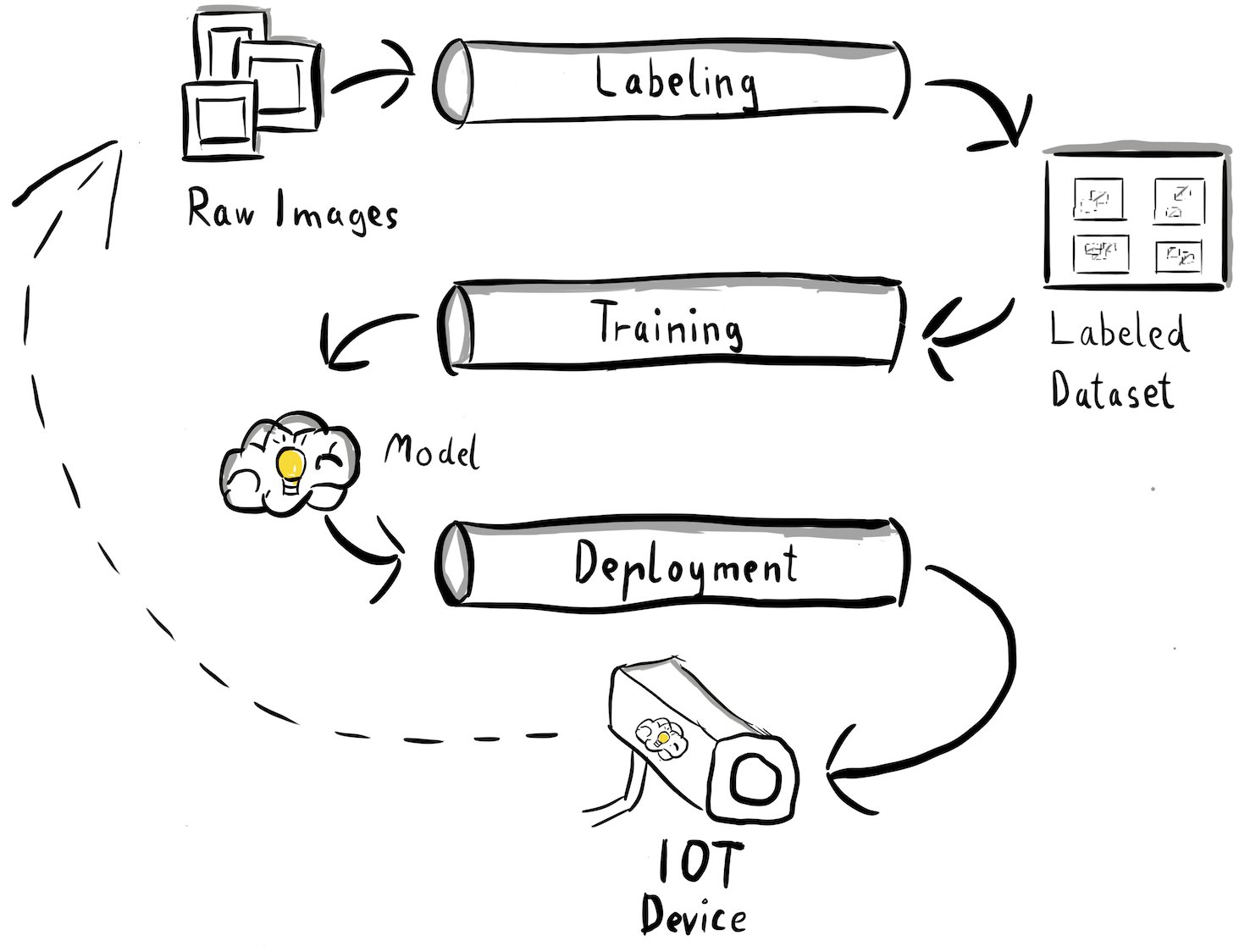

これで、ユースケースと、エッジでのオブジェクト検出を中心とした、私たちが対処しようとしている特定の ML 問題が明確になりました。 ここで、MLOps パイプラインのアーキテクチャを作成します。 現段階では、まだテクノロジーや特定のサービスには注目していませんが、むしろパイプラインの高レベルのコンポーネントに注目しています。 迅速に再トレーニングしてデプロイするには、データのラベル付けからトレーニング、推論まで、エンドツーエンドのプロセス全体を自動化する必要があります。 ただし、エッジケース向けのパイプラインの設定を特に困難にするいくつかの課題があります。

- このプロセスのさまざまな部分を構築するには、さまざまなスキルセットが必要です。 たとえば、データのラベル付けとトレーニングにはデータ サイエンスに重点が置かれており、エッジ展開にはモノのインターネット (IoT) の専門家が必要であり、プロセス全体の自動化は通常、DevOps スキル セットを持つ担当者によって行われます。

- 組織によっては、このプロセス全体が複数のチームによって実装される場合もあります。 私たちのユースケースでは、別々のチームがラベル付け、トレーニング、展開を担当するという想定に基づいて作業しています。

- 役割とスキルセットが増えると、ツールやプロセスの要件も異なります。 たとえば、データ サイエンティストは、使い慣れたノートブック環境を監視して作業したいと考えるかもしれません。 MLOps エンジニアは、コードとしてのインフラストラクチャ (IaC) ツールを使用して作業することを望んでおり、 AWSマネジメントコンソール.

これはパイプライン アーキテクチャにとって何を意味するのでしょうか?

まず、さまざまなチームが独立して作業できるようにするエンドツーエンド システムの主要コンポーネントを明確に定義することが重要です。 次に、コラボレーションの効率を高めるために、チーム間のインターフェースを明確に定義する必要があります。 これらのインターフェイスは、チーム間の混乱を最小限に抑えるのに役立ち、定義されたインターフェイスに従っている限り、必要に応じて内部プロセスを変更できるようになります。 次の図は、これがコンピューター ビジョン パイプラインでどのようになるかを示しています。

MLOps パイプラインの全体的なアーキテクチャを詳しく調べてみましょう。

- このプロセスは、初期トレーニング データセットを形成するために実稼働環境でエッジ カメラ デバイスを使用してキャプチャされた金属タグの生画像の収集から始まります。

- 次のステップでは、これらの画像にラベルを付け、境界ボックスを使用して欠陥をマークします。 ラベル付きデータセットをバージョン管理し、使用されたトレーニング データのトレーサビリティと説明責任を確保することが不可欠です。

- ラベル付きデータセットを取得したら、モデルのトレーニング、微調整、評価、バージョン管理を進めることができます。

- モデルのパフォーマンスに満足したら、モデルをエッジ デバイスにデプロイし、エッジでライブ推論を実行できます。

- モデルが運用環境で動作している間、エッジ カメラ デバイスは、これまでに見たことのない欠陥やエッジ ケースを含む貴重な画像データを生成します。 このデータを使用して、モデルのパフォーマンスをさらに向上させることができます。 これを達成するために、モデルが低い信頼度で予測した画像、または誤った予測を行った画像を保存します。 これらの画像は生のデータセットに再び追加され、プロセス全体が再度開始されます。

生の画像データ、ラベル付きデータセット、トレーニングされたモデルが、個別のパイプライン間の明確に定義されたインターフェイスとして機能することに注意することが重要です。 MLOps エンジニアとデータ サイエンティストは、これらのアーティファクトを一貫して生成する限り、パイプライン内のテクノロジーを柔軟に選択できます。 最も重要なことは、閉じたフィードバック ループを確立したことです。 本番環境で行われた誤った予測または信頼性の低い予測を使用して、データセットを定期的に強化し、モデルを自動的に再トレーニングして強化することができます。

ターゲットアーキテクチャ

高レベルのアーキテクチャが確立されたので、次はさらに XNUMX レベル深く進み、AWS のサービスを使用してこれを構築する方法を検討します。 この投稿で示されているアーキテクチャは、データ サイエンス プロセス全体を完全に制御することを前提としていることに注意してください。 ただし、エッジでの品質検査を始めたばかりの場合は、次のことをお勧めします。 アマゾンルックアウトフォービジョン。 これにより、ML コードを構築、保守、理解することなく、独自の品質検査モデルをトレーニングする方法が提供されます。 詳細については、以下を参照してください。 Amazon Lookout for Visionは、エッジでの製品欠陥の目視検査をサポートするようになりました.

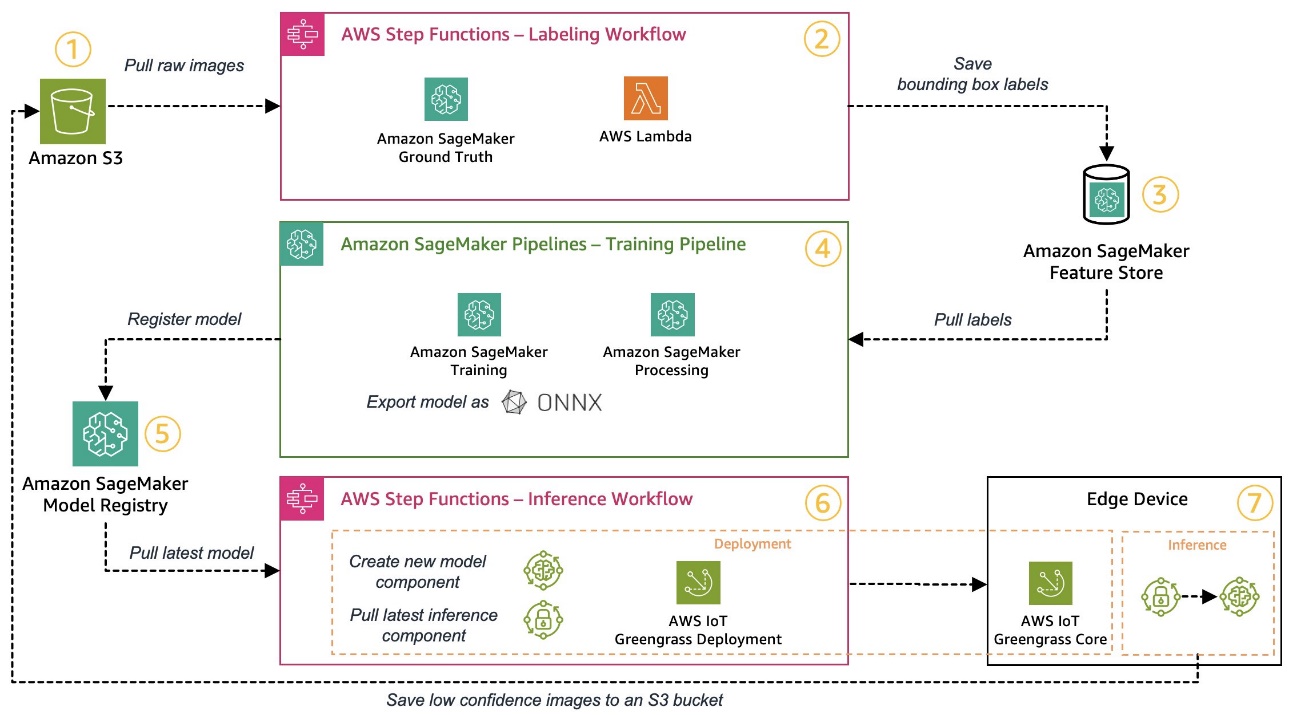

ただし、完全に制御したい場合は、次の図にアーキテクチャがどのようになるかを示します。

前と同様に、ワークフローを段階的に説明し、どの AWS サービスが要件に適合するかを特定してみましょう。

- Amazon シンプル ストレージ サービス (Amazon S3) は、低コストのストレージ ソリューションを提供するため、生の画像データを保存するために使用されます。

- ラベル付けワークフローは、次を使用して調整されます。 AWSステップ関数は、ラベル付けワークフローのステップを簡単に調整できるサーバーレス ワークフロー エンジンです。 このワークフローの一部として、 Amazon SageMakerグラウンドトゥルース ラベル付けジョブと管理された人間の労働力を使用して、ラベル付けを完全に自動化します。 AWSラムダ データを準備し、ラベル付けジョブを開始し、ラベルを保存するために使用されます。 Amazon SageMaker フィーチャーストア.

- SageMaker Feature Store はラベルを保存します。 これにより、機能を一元管理して共有できるようになり、組み込みのデータ バージョン管理機能が提供されるため、パイプラインがより堅牢になります。

- を使用してモデルの構築とトレーニング パイプラインを調整します。 AmazonSageMakerパイプライン。 組み込みのステップを介して必要な他の SageMaker 機能と統合されます。 SageMaker トレーニング ジョブ モデルのトレーニングを自動化するために使用されます。 SageMaker処理ジョブ データを準備し、モデルのパフォーマンスを評価するために使用されます。 この例では、 ウルトラリティクス YOLOv8 物体検出モデルをトレーニングしてエクスポートするための Python パッケージとモデル アーキテクチャ ONNX 移植性を考慮した ML モデル形式。

- パフォーマンスが許容できる場合、トレーニングされたモデルは次の場所に登録されます。 Amazon SageMaker モデルレジストリ 増分バージョン番号が付加されます。 これは、モデルのトレーニングとエッジ展開のステップの間のインターフェイスとして機能します。 モデルの承認状況もここで管理します。 使用されている他のサービスと同様に、フルマネージドであるため、独自のインフラストラクチャの実行に注意を払う必要はありません。

- エッジ展開ワークフローは、ラベル付けワークフローと同様に、Step Functions を使用して自動化されます。 Step Functions の API 統合を使用すると、AWS IoT Greengrass などのさまざまな必要な AWS サービス API を簡単に呼び出して、新しいモデル コンポーネントを作成し、その後コンポーネントをエッジ デバイスにデプロイできます。

- AWS IoT Greengrass はエッジデバイスのランタイム環境として使用されます。 これは、エッジでのモデルと推論コンポーネントの展開ライフサイクルを管理します。 これにより、単純な API 呼び出しを使用して、モデルと推論コンポーネントの新しいバージョンを簡単にデプロイできるようになります。 さらに、エッジの ML モデルは通常、単独では実行されません。 さまざまなものを使用できます AWS および コミュニティ 他のサービスに接続するための AWS IoT Greengrass のコンポーネントを提供しました。

ここで説明したアーキテクチャは、前に示した高レベルのアーキテクチャに似ています。 Amazon S3、SageMaker Feature Store、および SageMaker Model Registry は、異なるパイプライン間のインターフェイスとして機能します。 ソリューションの実行と運用にかかる労力を最小限に抑えるために、可能な限りマネージド サービスとサーバーレス サービスを使用します。

堅牢な CI/CD システムへの統合

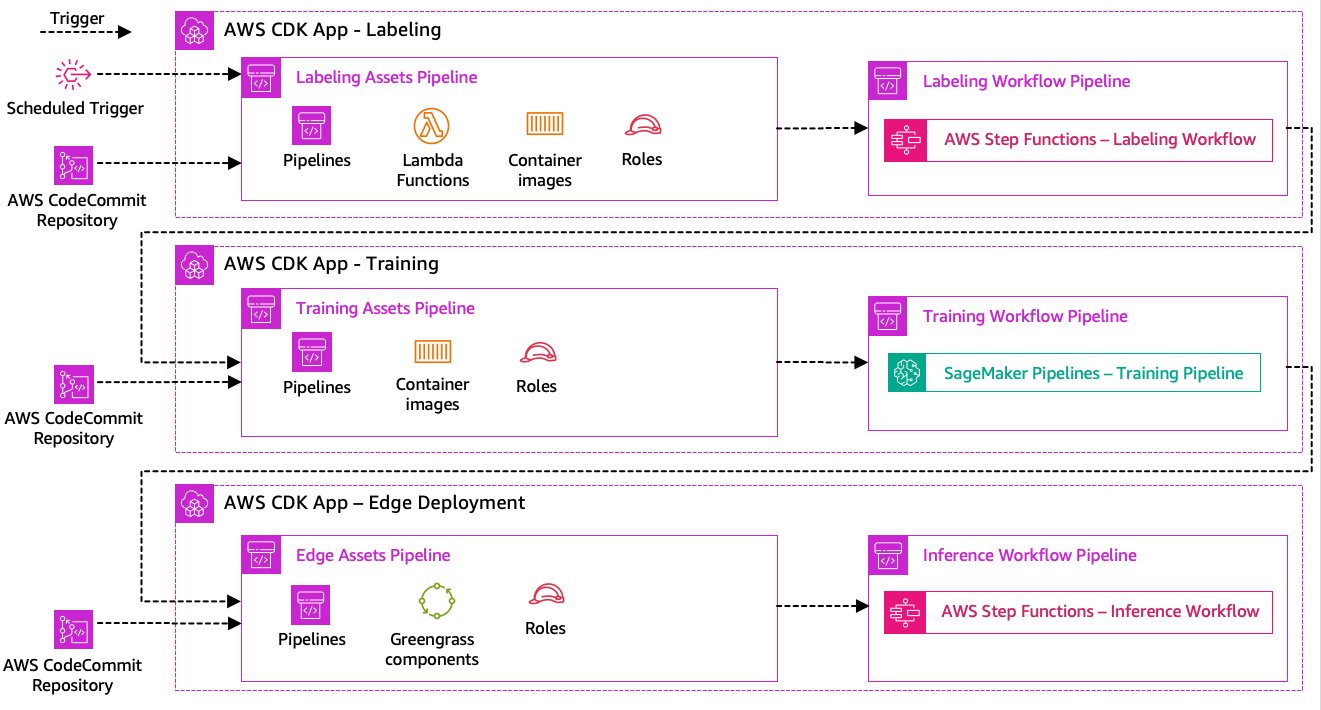

データのラベル付け、モデルのトレーニング、エッジ展開の手順は、当社のソリューションの中核です。 そのため、これらの部分の基礎となるコードまたはデータに関連する変更は、オーケストレーション プロセス全体の新たな実行をトリガーする必要があります。 これを実現するには、このパイプラインを CI/CD システムに統合する必要があります。これにより、バージョン管理されたコード リポジトリから実稼働環境にコードとインフラストラクチャの変更を自動的にデプロイできるようになります。 前のアーキテクチャと同様に、ここでもチームの自律性が重要な側面です。 次の図は、AWS のサービスを使用するとこれがどのようになるかを示しています。

CI/CD アーキテクチャを見てみましょう。

- AWS コードコミット Git リポジトリとして機能します。 わかりやすくするために、提供されたサンプルでは、単一の git リポジトリ内のサブフォルダーを介して個別の部分 (ラベル付け、モデル トレーニング、エッジ デプロイメント) を分離しました。 実際のシナリオでは、各チームがパーツごとに異なるリポジトリを使用する可能性があります。

- インフラストラクチャのデプロイは AWS CDK を使用して自動化され、各部分 (ラベル付け、トレーニング、エッジ) が独自の AWS CDK アプリを取得して、独立したデプロイが可能になります。

- AWS CDK パイプライン機能では、 AWS コードパイプライン インフラストラクチャとコードのデプロイメントを自動化します。

- AWS CDK は、ステップごとに XNUMX つのコード パイプライン (アセット パイプラインとワークフロー パイプライン) をデプロイします。 アセットに変更がない場合 (トレーニングに使用できる新しいイメージがある場合など) に備えて、ワークフローをアセットのデプロイメントから分離し、ワークフローを個別に開始できるようにしました。

- アセット コード パイプラインは、ワークフローが正常に実行されるために必要なすべてのインフラストラクチャをデプロイします。 AWS IDおよびアクセス管理 (IAM) ロール、Lambda 関数、トレーニング中に使用されるコンテナー イメージ。

- ワークフロー コード パイプラインは、実際のラベル付け、トレーニング、またはエッジ デプロイメントのワークフローを実行します。

- アセット パイプラインは、前のワークフロー パイプラインが完了したときだけでなく、コミット時にも自動的にトリガーされます。

- プロセス全体は、 アマゾンイベントブリッジ 定期的な再トレーニングのルール。

CI/CD の統合により、エンドツーエンドのチェーン全体が完全に自動化されました。 パイプラインは、Git リポジトリ内のコードが変更されるたびに、またデータ変更に対応するスケジュールに従ってトリガーされます。

先に考えます

説明されているソリューション アーキテクチャは、エッジでエンドツーエンドの MLOps パイプラインを構築するための基本コンポーネントを表しています。 ただし、要件によっては、追加機能の追加を検討する場合があります。 以下にいくつかの例を示します。

まとめ

この投稿では、AWS のサービスを使用してエッジで視覚的な品質検査を行うためのエンドツーエンドの MLOps パイプラインを構築するためのアーキテクチャの概要を説明しました。 このアーキテクチャは、データのラベル付け、モデル開発、エッジ展開を含むプロセス全体を合理化し、モデルの新しいバージョンを迅速かつ確実にトレーニングして実装できるようにします。 サーバーレスおよびマネージド サービスを使用すると、インフラストラクチャの管理ではなく、ビジネス価値の提供に重点を置くことができます。

In 第2部 このシリーズでは、さらに XNUMX レベル深く掘り下げて、このアーキテクチャの実装、特にラベル付けとモデル構築を詳しく見ていきます。 コードに直接ジャンプしたい場合は、付属のコードをチェックしてください。 GitHubレポ.

著者について

マイケル・ロート AWS のシニア ソリューション アーキテクトとして、ドイツの製造業の顧客が AWS テクノロジーを通じてビジネス上の課題を解決できるようサポートしています。 仕事と家族のほかに、スポーツカーに興味があり、イタリアン コーヒーを楽しんでいます。

マイケル・ロート AWS のシニア ソリューション アーキテクトとして、ドイツの製造業の顧客が AWS テクノロジーを通じてビジネス上の課題を解決できるようサポートしています。 仕事と家族のほかに、スポーツカーに興味があり、イタリアン コーヒーを楽しんでいます。

イェルク・ヴェールレ AWS のソリューションアーキテクトとして、ドイツの製造業の顧客と協力しています。 Joerg は自動化に情熱を持っており、AWS 入社以前はソフトウェア開発者、DevOps エンジニア、サイト信頼性エンジニアとして働いてきました。 雲を超えて、彼は野心的なランナーであり、家族と充実した時間を楽しんでいます。 DevOps に挑戦したい場合、またはランニングに行きたい場合は、彼に知らせてください。

イェルク・ヴェールレ AWS のソリューションアーキテクトとして、ドイツの製造業の顧客と協力しています。 Joerg は自動化に情熱を持っており、AWS 入社以前はソフトウェア開発者、DevOps エンジニア、サイト信頼性エンジニアとして働いてきました。 雲を超えて、彼は野心的なランナーであり、家族と充実した時間を楽しんでいます。 DevOps に挑戦したい場合、またはランニングに行きたい場合は、彼に知らせてください。

ヨハネス・ランガー AWS のシニア ソリューション アーキテクトで、ドイツの企業顧客と協力しています。 Johannes は、実際のビジネス上の問題を解決するために機械学習を適用することに情熱を持っています。 私生活では、ヨハネスは家の改善プロジェクトに取り組み、家族と屋外で時間を過ごすことを楽しんでいます。

ヨハネス・ランガー AWS のシニア ソリューション アーキテクトで、ドイツの企業顧客と協力しています。 Johannes は、実際のビジネス上の問題を解決するために機械学習を適用することに情熱を持っています。 私生活では、ヨハネスは家の改善プロジェクトに取り組み、家族と屋外で時間を過ごすことを楽しんでいます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/build-an-end-to-end-mlops-pipeline-for-visual-quality-inspection-at-the-edge-part-1/

- :持っている

- :は

- $UP

- 1

- 150

- 7

- 710

- a

- 私たちについて

- ことができます。

- アクセス

- 対応する

- こちらからお申し込みください。

- 説明責任

- 達成する

- 行為

- 使徒行伝

- 実際の

- 追加されました

- 追加

- 添加

- NEW

- 住所

- 付着します

- その後

- 再び

- 目指す

- すべて

- 許す

- ことができます

- また

- しかし

- Amazon

- アマゾンセージメーカー

- Amazon Webサービス

- 野心的な

- an

- および

- とインフラ

- どれか

- API

- API

- アプリ

- 適用

- 承認

- 建築

- です

- 周りに

- AS

- 側面

- 資産

- と仮定する

- 仮定

- 保証

- At

- 自動化する

- 自動化

- 自動的に

- 自動化する

- オートメーション

- 利用できます

- 避ける

- AWS

- AWS IoT Greengrass

- バック

- 帯域幅

- 基本

- BE

- なぜなら

- になる

- ほかに

- の間に

- 越えて

- ボックス

- もたらす

- ビルド

- 建物

- 内蔵

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- コール

- コール

- カメラ

- 缶

- 機能

- 機能

- 捕捉した

- これ

- 自動車

- 場合

- 例

- チェーン

- 挑戦する

- 課題

- 挑戦

- 変化する

- 変更

- チェック

- 選択する

- 明瞭

- はっきりと

- 閉まっている

- クラウド

- コード

- コーヒー

- 環境、テクノロジーを推奨

- コレクション

- comes

- コミット

- コンプリート

- 複雑な

- 複雑さ

- コンポーネント

- コンピュータ

- Computer Vision

- コンセプト

- 信頼

- お問合せ

- 接続性

- 一貫して

- コンテナ

- コントロール

- 基本

- 高額で

- 可能性

- 作ります

- 重大な

- Customers

- カスタマイズ

- データ

- データサイエンス

- 取引

- 取引

- 減少

- より深い

- 定義します

- 定義済みの

- 配信する

- 掘り下げる

- によっては

- 展開します

- 展開

- 配備

- 配備する

- 記載された

- 設計

- 詳細

- 検出

- 検出された

- 検出

- Developer

- 開発

- 開発

- デバイス

- Devices

- 異なります

- 直接

- 混乱

- 明確な

- ダイビング

- ありません

- 行われ

- ドント

- ドラフト

- 原因

- 間に

- 各

- 早い

- 簡単に

- 簡単に

- エッジ(Edge)

- 効率

- 効率的な

- 努力

- 有効にする

- 包含する

- 端から端まで

- エンジン

- エンジニア

- エンジニア

- 高めます

- 確保する

- Enterprise

- 全体

- 環境

- 環境

- 本質的な

- 設立

- 評価する

- 評価します

- さらに

- 調べる

- 例

- 例

- export

- おなじみの

- 家族

- 欠陥のある

- 特徴

- 特徴

- フィードバック

- 少数の

- 柔軟性

- 床

- フォーカス

- 焦点を当てて

- フォロー中

- フォーム

- 形式でアーカイブしたプロジェクトを保存します.

- から

- フル

- 完全に

- 機能性

- 機能

- さらに

- 獲得

- 生成

- ドイツ

- 受け

- Gitの

- Go

- 陸上

- ハッピー

- ハード

- 持ってる

- 持って

- 重く

- 助けます

- ことができます

- こちら

- ハイレベル

- 彼に

- 彼の

- ホーム

- 認定条件

- しかしながら

- HTML

- HTTP

- HTTPS

- 人間

- 識別する

- アイデンティティ

- if

- 説明する

- 画像

- 画像

- 絵

- 実装する

- 実装

- 実装

- 重要

- 重要な側面

- 改善

- in

- 増加した

- 独立しました

- 単独で

- 個人

- 情報

- インフラ関連事業

- 初期

- 統合する

- 統合された

- 統合する

- 統合

- 統合

- 興味がある

- インタフェース

- インターフェース

- 内部

- インターネット

- モノのインターネット

- に

- 紹介します

- 関係する

- IOT

- 分離

- IT

- イタリアの

- ITS

- Jobs > Create New Job

- JPG

- ジャンプ

- ただ

- キープ

- 知っている

- ラベリング

- ラベル

- レイテンシ

- 後で

- 学習

- う

- レベル

- 生活

- wifecycwe

- ような

- LINE

- ライブ

- 局部的に

- 長い

- 見て

- のように見える

- 探して

- ロー

- 低コストの

- 機械

- 機械学習

- 製

- 維持する

- メンテナンス

- 主要な

- make

- 作る

- 管理します

- マネージド

- 管理

- マネージャー

- 管理する

- 管理する

- 手動で

- メーカー

- 製造業

- マーク

- マークされた

- マーキング

- 意味する

- 金属

- Michael Liebreich

- かもしれない

- ML

- MLOps

- モデル

- 修正する

- モニター

- 他には?

- もっと効率的

- 最も

- の試合に

- しなければなりません

- 必要

- 必要とされる

- 新作

- 次の

- いいえ

- ノート

- 今

- 数

- オブジェクト

- オブジェクト検出

- of

- 頻繁に

- on

- ONE

- 操作する

- 動作

- オペレーショナル

- or

- 調整された

- 編成

- 注文

- 組織

- その他

- 私たちの

- でる

- 屋外で

- 概説

- 全体

- 概要

- 自分の

- パッケージ

- 部

- 特に

- 部品

- 情熱

- 情熱的な

- パフォーマンス

- 個人的な

- パイプライン

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 移植性

- 可能

- ポスト

- 予測

- 予測

- 準備

- 前

- 前に

- 問題

- 問題

- 進む

- プロセス

- ラボレーション

- 処理

- 作り出す

- プロダクト

- 生産

- プロジェクト(実績作品)

- 提供

- は、大阪で

- Python

- 品質

- すぐに

- むしろ

- Raw

- リアル

- 現実の世界

- 推奨する

- 減らします

- 参照する

- よろしく

- 登録された

- レジストリ

- レギュラー

- 定期的に

- 関連する

- 信頼性

- 倉庫

- 表し

- の提出が必要です

- 要件

- 必要

- 似てる

- 責任

- 回転する

- 堅牢な

- 役割

- ルール

- ラン

- ランナー

- ランニング

- runs

- セージメーカー

- 酒

- Save

- シナリオ

- スケジュール

- 科学

- 科学者たち

- シニア

- 別

- シリーズ

- 役立つ

- サーバレス

- サービス

- サービス

- セッションに

- セット

- 設定

- シェアする

- オンラインストア

- すべき

- 示す

- 作品

- 著しく

- 同様の

- 簡単な拡張で

- 単純

- ウェブサイト

- 技能

- So

- ソフトウェア

- 溶液

- ソリューション

- 解決する

- 一部

- 誰か

- 専門家

- 特定の

- 特に

- 支出

- スポーツ

- ステージ

- ステージ

- start

- 開始

- 都道府県

- 手順

- ステップ

- ストレージ利用料

- 店舗

- 店舗

- ストレート

- 簡単な

- 強い

- 成功した

- 首尾よく

- そのような

- スーツ

- 支援する

- サポート

- 素早く

- TAG

- 取る

- チーム

- チーム

- テクノロジー

- テクノロジー

- より

- それ

- アプリ環境に合わせて

- それら

- その後

- そこ。

- したがって、

- ボーマン

- 彼ら

- 物事

- 考える

- この

- それらの

- 三

- 介して

- 時間

- 〜へ

- 豊富なツール群

- に向かって

- トレーサビリティ

- トレーニング

- 訓練された

- トレーニング

- トリガー

- トリガ

- 試します

- 2

- 下

- 根本的な

- わかる

- us

- つかいます

- 使用事例

- 中古

- 使用されます

- 通常

- 利用された

- 貴重な

- 値

- さまざまな

- バージョン

- バージョン

- 、

- ビジョン

- 歩く

- 欲しいです

- 仕方..

- we

- ウェブ

- Webサービス

- WELL

- 明確な

- この試験は

- いつ

- たびに

- which

- 全体

- 意志

- 以内

- 無し

- 仕事

- 働いていました

- ワークフロー

- ワークフロー

- ワーキング

- まだ

- You

- あなたの

- あなた自身

- ゼファーネット