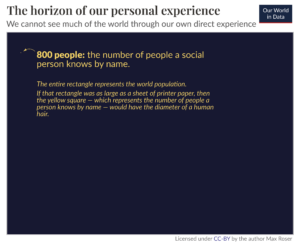

Sinds ChatGPT in november vorig jaar zijn intrede deed in de tech-scene, helpt het mensen allerlei soorten materiaal te schrijven, code te genereren en informatie te vinden. Het en andere grote taalmodellen (LLM's) hebben taken vergemakkelijkt, van het afhandelen van klantenservice-oproepen tot het opnemen van fastfoodbestellingen. Gezien hoe nuttig LLM's zijn geweest voor mensen in de korte tijd dat ze er zijn, hoe kan een ChatGPT voor robots hun vermogen om te leren en nieuwe dingen te doen beïnvloeden? Onderzoekers van Google DeepMind besloten het uit te zoeken en publiceerden hun bevindingen in een blogpost en papier vorige week vrijgegeven.

Ze noemen hun systeem RT-2. Het is een afkorting voor robotica transformator 2, en het is de opvolger van robottransformator 1, die het bedrijf eind vorig jaar uitbracht. RT-1 was gebaseerd op een klein taal- en visieprogramma en specifiek getraind om veel taken uit te voeren. De software werd gebruikt in Alphabet X's Alledaagse robots, waardoor ze meer dan 700 verschillende taken kunnen uitvoeren met een slagingspercentage van 97 procent. Maar wanneer ze werden gevraagd om nieuwe taken uit te voeren waarvoor ze niet waren opgeleid, waren robots die RT-1 gebruikten slechts in 32 procent van de gevallen succesvol.

RT-2 verdubbelt dit percentage bijna en voert met succes nieuwe taken uit in 62 procent van de gevallen waarin dit wordt gevraagd. De onderzoekers noemen RT-2 een vision-language-action (VLA) model. Het gebruikt tekst en afbeeldingen die het online ziet om nieuwe vaardigheden te leren. Dat is niet zo eenvoudig als het klinkt; het vereist dat de software eerst een concept 'begrijpt', dat begrip vervolgens toepast op een opdracht of reeks instructies en vervolgens acties uitvoert die aan die instructies voldoen.

Een voorbeeld dat de auteurs van het artikel geven, is het weggooien van afval. In eerdere modellen moest de software van de robot eerst worden getraind om afval te identificeren. Als er bijvoorbeeld een gepelde banaan op een tafel ligt met de schil ernaast, zou de bot laten zien dat de schil afval is terwijl de banaan dat niet is. Het zou dan worden geleerd hoe de schil moet worden opgepakt, naar een vuilnisbak moet worden verplaatst en daar moet worden gedeponeerd.

RT-2 werkt echter een beetje anders. Omdat het model heeft getraind op heel veel informatie en gegevens van internet, heeft het een algemeen begrip van wat afval is, en hoewel het niet is getraind om afval weg te gooien, kan het de stappen samenstellen om deze taak te voltooien.

De LLM's die de onderzoekers gebruikten om RT-2 te trainen zijn PaLI-X (een visie- en taalmodel met 55 miljard parameters), en PALM-E (wat Google een belichaamd multimodaal taalmodel noemt, speciaal ontwikkeld voor robots, met 12 miljard parameters). "Parameter" verwijst naar een attribuut dat een machine learning-model definieert op basis van zijn trainingsgegevens. In het geval van LLM's modelleren ze de relaties tussen woorden in een zin en wegen ze af hoe waarschijnlijk het is dat een bepaald woord wordt voorafgegaan of gevolgd door een ander woord.

Door de relaties en patronen tussen woorden in een gigantische dataset te vinden, leren de modellen van hun eigen gevolgtrekkingen. Ze kunnen uiteindelijk uitzoeken hoe verschillende concepten zich tot elkaar verhouden en context onderscheiden. In het geval van RT-2 vertaalt het die kennis in algemene instructies voor robotacties.

Die acties worden voor de robot weergegeven als tokens, die meestal worden gebruikt om tekst in natuurlijke taal weer te geven in de vorm van woordfragmenten. In dit geval zijn de tokens onderdeel van een actie en koppelt de software meerdere tokens aan elkaar om een actie uit te voeren. Deze structuur stelt de software ook in staat om op basis van gedachten te redeneren, wat betekent dat het kan reageren op vragen of prompts die een zekere mate van redenering vereisen.

Voorbeelden die het team geeft, zijn onder meer het kiezen van een voorwerp om als hamer te gebruiken als er geen hamer beschikbaar is (de robot kiest een steen) en het kiezen van het beste drankje voor een vermoeide persoon (de robot kiest een energiedrankje).

"RT-2 toont verbeterde generalisatiemogelijkheden en semantisch en visueel begrip dat verder gaat dan de robotgegevens waaraan het werd blootgesteld", schreven de onderzoekers in een Google blogpost. "Dit omvat het interpreteren van nieuwe commando's en het reageren op gebruikerscommando's door rudimentaire redeneringen uit te voeren, zoals redeneren over objectcategorieën of beschrijvingen op hoog niveau."

De droom van robots voor algemeen gebruik die mensen kan helpen met alles wat zich voordoet - of het nu thuis, in een commerciële omgeving of in een industriële omgeving is - zal pas haalbaar zijn als robots onderweg kunnen leren. Wat voor ons het meest basale instinct lijkt, is voor robots een complexe combinatie van het begrijpen van de context, er doorheen kunnen redeneren en acties ondernemen om problemen op te lossen waarvan niet werd verwacht dat ze zouden opduiken. Het is onmogelijk om ze te programmeren om adequaat te reageren op verschillende ongeplande scenario's, dus moeten ze kunnen generaliseren en leren van ervaringen, net als mensen.

RT-2 is een stap in deze richting. De onderzoekers erkennen echter dat hoewel RT-2 semantische en visuele concepten kan generaliseren, het zelf nog niet in staat is om nieuwe acties te leren. Integendeel, het past de acties die het al kent toe op nieuwe scenario's. Misschien kunnen RT-3 of 4 deze vaardigheden naar een hoger niveau tillen. In de tussentijd, zoals het team concludeert in hun blogpost, "Hoewel er nog enorm veel werk aan de winkel is om behulpzame robots in mensgerichte omgevingen mogelijk te maken, laat RT-2 ons zien dat een opwindende toekomst voor robotica binnen handbereik ligt."

Krediet van het beeld: Google DeepMind

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://singularityhub.com/2023/08/02/deepminds-chatgpt-like-brain-for-robots-lets-them-learn-from-the-internet/

- : heeft

- :is

- :niet

- $UP

- 12

- 32

- 700

- a

- vermogen

- in staat

- Over

- erkennen

- Actie

- acties

- Alles

- Alfabet

- al

- ook

- bedragen

- an

- en

- Nog een

- verwachte

- Solliciteer

- op gepaste wijze

- ZIJN

- rond

- AS

- At

- auteurs

- Beschikbaar

- weg

- Banana

- gebaseerde

- basis-

- BE

- geweest

- wezen

- BEST

- tussen

- Verder

- Miljard

- Bot

- Hersenen

- maar

- by

- Bellen

- oproepen

- CAN

- mogelijkheden

- dragen

- geval

- categorieën

- ChatGPT

- het kiezen van

- code

- combinatie van

- hoe

- commercieel

- afstand

- compleet

- complex

- concept

- concepten

- verband

- Credits

- klant

- Klantenservice

- gegevens

- beslist

- DeepMind

- definieert

- Mate

- storting

- ontwikkelde

- anders

- richting

- do

- gedaan

- Doubles

- droom

- Drinken

- elk

- in staat stellen

- maakt

- waardoor

- einde

- energie-niveau

- omgevingen

- uiteindelijk

- voorbeeld

- opwindend

- ervaring

- blootgestelde

- vergemakkelijkt

- SNELLE

- Figuur

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- het vinden van

- bevindingen

- Voornaam*

- gevolgd

- eten

- Voor

- formulier

- oppompen van

- toekomst

- Algemeen

- voortbrengen

- reus

- Geven

- gegeven

- geeft

- Go

- Kopen Google Reviews

- grijpen

- hamer

- Hebben

- hulp

- nuttig

- het helpen van

- high-level

- Home

- Hoe

- How To

- HTML

- HTTPS

- Mensen

- identificeren

- if

- afbeeldingen

- Impact

- onmogelijk

- verbeterd

- in

- omvatten

- omvat

- industrieel

- informatie

- instructies

- Internet

- in

- IT

- HAAR

- jpg

- voor slechts

- kennis

- taal

- Groot

- Achternaam*

- Afgelopen jaar

- LEARN

- leren

- Laten we

- Niveau

- als

- Waarschijnlijk

- Elke kleine stap levert grote resultaten op!

- ladingen

- machine

- machine learning

- veel

- materiaal

- max-width

- Mei..

- betekenis

- ondertussen

- macht

- model

- modellen

- meest

- beweging

- meervoudig

- Naturel

- Noodzaak

- New

- volgende

- geen

- November

- object

- of

- on

- online.

- Slechts

- naar

- or

- orders

- Overige

- uit

- over

- het te bezitten.

- Papier

- parameters

- onderdelen

- patronen

- Mensen

- procent

- Uitvoeren

- uitvoerend

- misschien

- persoon

- kiezen

- stuk

- Plato

- Plato gegevensintelligentie

- PlatoData

- knal

- vorig

- problemen

- Programma

- Programming

- gepubliceerde

- Contact

- tarief

- liever

- Reageren

- reden

- verwijst

- Relaties

- uitgebracht

- vertegenwoordigen

- vertegenwoordigd

- vereisen

- vereist

- onderzoekers

- Reageren

- reageert

- robot

- robotica

- robots

- rots

- s

- scenario's

- scène

- lijkt

- ziet

- zin

- service

- reeks

- het instellen van

- Bermuda's

- getoond

- Shows

- Eenvoudig

- sinds

- vaardigheden

- Klein

- So

- Software

- OPLOSSEN

- sommige

- specifiek

- Stap voor

- Stappen

- Still

- structuur

- succes

- geslaagd

- Met goed gevolg

- dergelijk

- system

- tafel

- Nemen

- het nemen

- Taak

- taken

- onderwezen

- team

- tech

- dat

- De

- hun

- Ze

- harte

- Er.

- Deze

- ze

- spullen

- dit

- die

- toch?

- Door

- niet de tijd of

- moe

- naar

- samen

- tokens

- Trainen

- getraind

- Trainingen

- transformator

- ontzettend

- begrip

- tot

- us

- .

- gebruikt

- Gebruiker

- toepassingen

- gebruik

- doorgaans

- variëteit

- visie

- was

- week

- wegen

- waren

- Wat

- wat

- wanneer

- welke

- en

- wil

- Met

- binnen

- Woord

- woorden

- Mijn werk

- Bedrijven

- zou

- schrijven

- schreef

- X's

- jaar

- nog

- zephyrnet