Snelle engineering is een essentiële vaardigheid geworden voor iedereen die met grote taalmodellen (LLM's) werkt om hoogwaardige en relevante teksten te genereren. Hoewel de techniek van tekstprompts uitgebreid is besproken, is de techniek van visuele prompts een opkomend vakgebied dat aandacht vereist. Visuele aanwijzingen kunnen begrenzingsvakken of maskers bevatten die visiemodellen begeleiden bij het genereren van relevante en nauwkeurige uitvoer. In dit bericht onderzoeken we de basisprincipes van visuele prompt-engineering, de voordelen ervan en hoe het kan worden gebruikt om een specifieke gebruikssituatie op te lossen: beeldsegmentatie voor autonoom rijden.

De afgelopen jaren is er op het gebied van computer vision aanzienlijke vooruitgang geboekt op het gebied van beeldsegmentatie. Eén van die doorbraken is de Segment Anything-model (SAM) van Meta AI, dat het potentieel heeft om een revolutie teweeg te brengen in de segmentatie op objectniveau met zero-shot of weinig-shot training. In dit bericht gebruiken we het SAM-model als voorbeeld van een funderingsvisiemodel en verkennen we de toepassing ervan op de BDD100K-gegevensset, een diverse dataset voor autonoom rijden voor heterogeen multitask leren. Door de sterke punten van SAM te combineren met de rijke gegevens van BDD100K, laten we het potentieel van visuele prompt-engineering zien met verschillende versies van SAM. Geïnspireerd door de LangChain raamwerk voor taalmodellen stellen we een visuele keten voor om visuele aanwijzingen uit te voeren door objectdetectiemodellen te combineren met SAM.

Hoewel dit artikel zich richt op autonoom rijden, zijn de besproken concepten breed toepasbaar op domeinen met rijke, op visie gebaseerde toepassingen, zoals de gezondheidszorg en de levenswetenschappen, en media en entertainment. Laten we beginnen met wat meer te leren over wat er schuilgaat achter een fundamenteel visiemodel als SAM. We gebruikten Amazon SageMaker Studio op een ml.g5.16xlarge-instantie voor dit bericht.

Segment Anything-model (SAM)

Foundation-modellen zijn grote machine learning-modellen (ML) die zijn getraind op een grote hoeveelheid gegevens en kunnen worden aangestuurd of verfijnd voor taakspecifieke gebruiksscenario's. Hier onderzoeken we het Segment Anything Model (SAM), een fundamenteel model voor visie, met name beeldsegmentatie. Het is vooraf getraind op een enorme dataset van 11 miljoen afbeeldingen en 1.1 miljard maskers, waardoor het op het moment van schrijven de grootste segmentatiedataset is. Deze uitgebreide dataset omvat een breed scala aan objecten en categorieën, waardoor SAM beschikt over een diverse en grootschalige trainingsgegevensbron.

Het SAM-model is getraind om objecten te begrijpen en kan segmentatiemaskers uitvoeren voor elk object in afbeeldingen of videoframes. Het model maakt visuele prompt-engineering mogelijk, waardoor u invoer kunt geven zoals tekst, punten, selectiekaders of maskers om labels te genereren zonder de originele afbeelding te wijzigen. SAM is beschikbaar in drie formaten: basis (ViT-B, 91 miljoen parameters), groot (ViT-L, 308 miljoen parameters) en enorm (ViT-H, 636 miljoen parameters), waarmee aan verschillende computervereisten en gebruiksscenario's kan worden voldaan.

De belangrijkste motivatie achter SAM is het verbeteren van de segmentatie op objectniveau met minimale trainingsvoorbeelden en tijdvakken voor alle interessante objecten. De kracht van SAM ligt in het vermogen om zich aan te passen aan nieuwe beelddistributies en -taken zonder voorafgaande kennis, een functie die bekend staat als zero-shot-overdracht. Dit aanpassingsvermogen wordt bereikt door middel van training op de uitgebreide SA-1B-dataset, die indrukwekkende zero-shot-prestaties heeft laten zien en veel eerdere, volledig gecontroleerde resultaten heeft overtroffen.

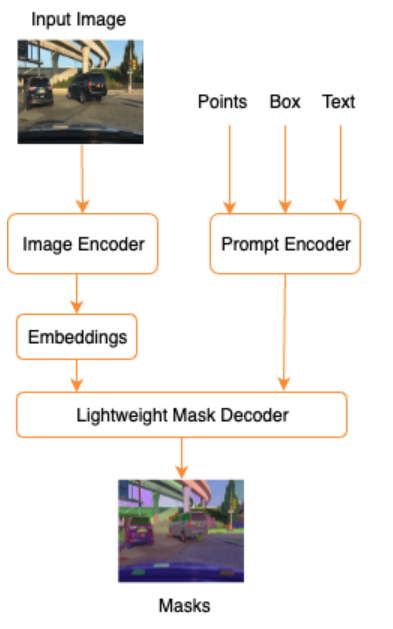

Zoals blijkt uit de volgende architectuur voor SAM, omvat het proces van het genereren van segmentatiemaskers drie stappen:

- Een afbeeldingsencoder zorgt voor een eenmalige inbedding van de afbeelding.

- Een prompt-encoder converteert elke prompt naar een inbeddingsvector voor de prompt.

- De lichtgewicht decoder combineert de informatie van de beeld-encoder en de prompt-encoder om segmentatiemaskers te voorspellen.

We kunnen bijvoorbeeld een invoer leveren met een afbeelding en een selectiekader rond een interessant object in die afbeelding (bijvoorbeeld een zilveren auto of rijstrook) en het SAM-model zou segmentatiemaskers voor dat object produceren.

Visuele snelle engineering

Prompt engineering verwijst naar het structureren van input naar een model waardoor het model de bedoeling begrijpt en het gewenste resultaat oplevert. Met tekstuele prompt-engineering kunt u de invoertekst structureren door middel van wijzigingen zoals woordkeuze, opmaak, volgorde en meer om de gewenste uitvoer te krijgen. Visuele prompt-engineering gaat ervan uit dat de gebruiker in een visuele modaliteit (beeld of video) werkt en input levert. Het volgende is een niet-uitputtende lijst van mogelijke manieren om input te leveren voor het generatieve AI-model in het visuele domein:

- Punt – Een enkelvoudig (x, y)-coördinaatpunt in het beeldvlak

- Punten – Meerdere (x, y) coördinaatpunten, die niet noodzakelijkerwijs aan elkaar gerelateerd zijn

- Begrenzend kader – Een set van vier waarden (x, y, w, h) die een rechthoekig gebied in het afbeeldingsvlak definiëren

- Contour – Een reeks (x, y)-coördinaatpunten in het beeldvlak die een gesloten vorm vormen

- Masker – Een array van dezelfde grootte als de afbeelding met een gedeeltelijk masker van het gewenste object

Laten we, met de visuele prompt-engineeringtechnieken in gedachten, onderzoeken hoe dit kan worden toegepast op het vooraf getrainde SAM-model. We hebben de basisversie van het vooraf getrainde model gebruikt.

Zero-shot prompting met het vooraf getrainde SAM-model

Laten we om te beginnen de zero-shot-aanpak onderzoeken. Het volgende is een voorbeeldafbeelding uit de trainingsgegevensset van de camera aan de voorkant van een voertuig.

We kunnen segmentatiemaskers voor alle objecten uit de afbeelding krijgen zonder enige expliciete visuele aanwijzing automatisch maskers genereren met slechts een invoerafbeelding. In de volgende afbeelding zien we dat delen van de auto, de weg, verkeersborden, kentekenplaten, viaduct, pilaren, borden en meer gesegmenteerd zijn.

Deze uitvoer is echter niet onmiddellijk nuttig om de volgende redenen:

- De auto's zijn niet als geheel gesegmenteerd, maar in delen. Voor de meeste waarnemingsmodellen maakt het ons bijvoorbeeld niet zoveel uit dat elk van de banden afzonderlijke uitvoermaskers heeft. Dit geldt ook bij het zoeken naar andere bekende interessante objecten, zoals wegen, vegetatie, borden, enzovoort.

- Delen van de afbeelding die nuttig zijn voor stroomafwaartse taken, zoals berijdbaar gebied, zijn opgesplitst, zonder uitleg. Aan de andere kant worden vergelijkbare instanties afzonderlijk geïdentificeerd, en zijn we mogelijk geïnteresseerd in het groeperen van vergelijkbare objecten (panoptische versus instantiesegmentatie).

Visuele snelle engineering met het vooraf getrainde SAM-model

Gelukkig ondersteunt SAM invoerprompts en kunnen we punten, puntarrays en selectiekaders als invoer gebruiken. Met deze specifieke instructies verwachten we dat SAM het beter zal doen met segmentaties die zich richten op specifieke punten of gebieden. Dit kan worden vergeleken met de taalpromptsjabloon"What is a good name for a company that makes {product}?"

waarbij de invoer samen met deze promptsjabloon van de gebruiker de {product}. {product} is een invoerslot. Bij visuele aanwijzingen zijn de selectiekaders, punten of maskers de invoervakken.

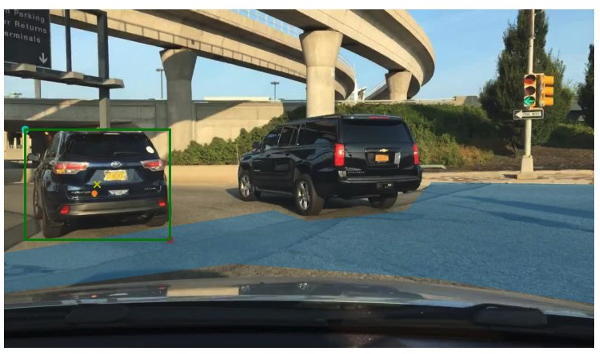

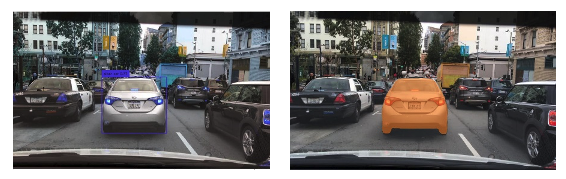

De volgende afbeelding toont het originele grondwaarheidskader rond voertuigen, en het berijdbare gebiedsvlak van BDD100K grondwaarheidsgegevens. De afbeelding toont ook een invoerpunt (een gele X) in het midden van het groene selectiekader waarnaar we in de volgende paragrafen zullen verwijzen.

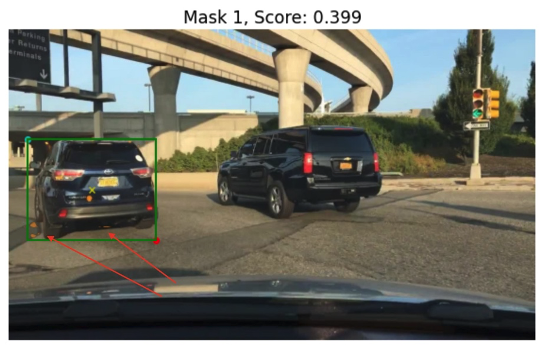

Laten we proberen een masker te genereren voor de auto aan de linkerkant met het groene selectiekader als invoer voor SAM. Zoals u in het volgende voorbeeld kunt zien, vindt het basismodel van SAM niet echt iets. Dit is ook terug te zien in de lage segmentatiescore. Als we de segmentatiemaskers nader bekijken, zien we dat er kleine gebieden zijn die als maskers worden geretourneerd (aangeduid met rode pijlen) die niet echt bruikbaar zijn voor enige downstream-toepassing.

Laten we een combinatie van een selectiekader en een punt proberen als visuele invoerprompt. Het gele kruis in de voorgaande afbeelding is het midden van het selectiekader. Het opgeven van de (x,y)-coördinaten van dit punt als prompt, samen met de beperking van het selectiekader, geeft ons het volgende masker en een iets hogere score. Dit is nog steeds op geen enkele manier bruikbaar.

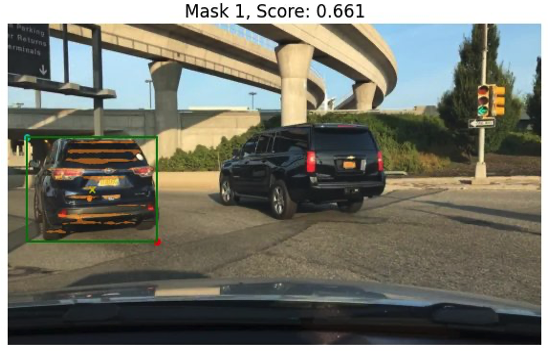

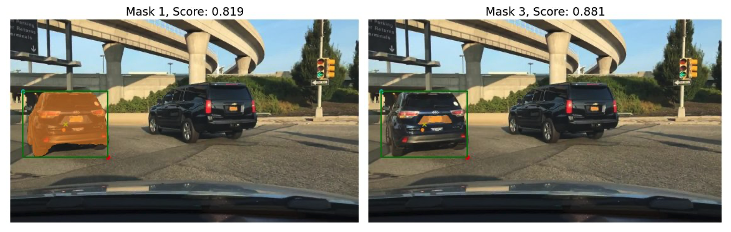

Ten slotte kunnen we met het vooraf getrainde basismodel alleen het invoerpunt als prompt opgeven (zonder het selectiekader). De volgende afbeeldingen tonen twee van de drie beste maskers waarvan wij dachten dat ze interessant waren.

Masker 1 segmenteert de volledige auto, terwijl Masker 3 een gebied segmenteert met de kentekenplaat van de auto dicht bij het gele kruis (invoerprompt). Masker 1 is nog steeds geen strak, schoon masker om de auto; dit wijst op de kwaliteit van het model, waarvan we kunnen aannemen dat deze toeneemt met de modelgrootte.

We kunnen grotere, vooraf getrainde modellen proberen met dezelfde invoerprompt. De volgende afbeeldingen tonen onze resultaten. Bij gebruik van het enorme, voorgetrainde SAM-model is Masker 3 de hele auto, terwijl Masker 1 en 2 kunnen worden gebruikt om de kentekenplaat eruit te halen.

De grote versie van het SAM-model biedt ook vergelijkbare outputs.

Het proces dat we hier hebben doorlopen, is vergelijkbaar met handmatige prompt-engineering voor tekstprompts waarmee u wellicht al bekend bent. Merk op dat een recente verbetering in het SAM-model om alles in hoge kwaliteit te segmenteren veel betere object- en contextspecifieke resultaten oplevert. In ons geval merken we dat zero-shot-prompts met tekst- en visuele aanwijzingen (punt-, box- en punt- en box-invoer) de resultaten niet drastisch verbeteren, zoals we hierboven zagen.

Snelle sjablonen en visuele ketens

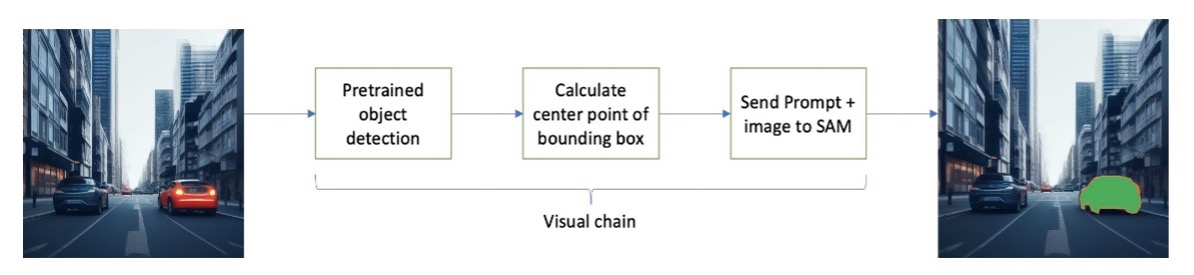

Zoals we uit de voorgaande zero-shot-voorbeelden kunnen zien, heeft SAM moeite om alle objecten in de scène te identificeren. Dit is een goed voorbeeld van hoe we kunnen profiteren van promptsjablonen en visuele ketens. Visual chain is geïnspireerd op het ketenconcept in het populaire LangChain-framework voor taaltoepassingen. Het helpt de gegevensbronnen en een LLM aan elkaar te koppelen om de uitvoer te produceren. We kunnen bijvoorbeeld een API-keten gebruiken om een API aan te roepen en een LLM aanroepen om de vraag te beantwoorden op basis van het API-antwoord.

Geïnspireerd door LangChain stellen we een sequentiële visuele keten voor die eruitziet als de volgende afbeelding. We gebruiken een hulpmiddel (zoals een vooraf getraind objectdetectiemodel) om initiële begrenzingsvakken te verkrijgen, het punt in het midden van het begrenzingsvak te berekenen en dit te gebruiken om het SAM-model te voorzien van de invoerafbeelding.

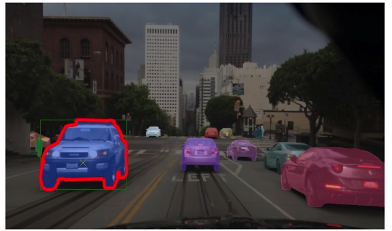

De volgende afbeelding toont bijvoorbeeld de segmentatiemaskers als resultaat van het uitvoeren van deze keten.

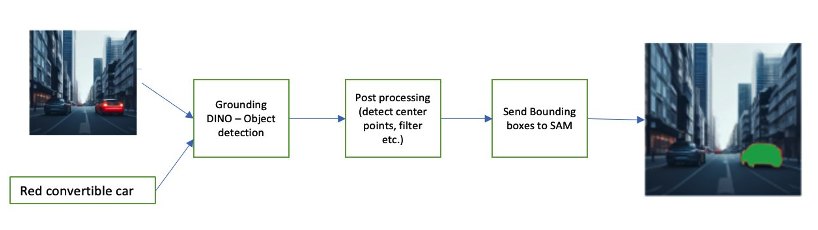

Een andere voorbeeldketen kan een tekstinvoer omvatten van het object dat de gebruiker wil identificeren. Om dit te implementeren, hebben we een pijplijn aangelegd met behulp van Aarding DINO, een objectdetectiemodel dat SAM om segmentatie vraagt.

Grounding DINO is een zero-shot objectdetectiemodel dat objectdetectie kan uitvoeren met tekst met categorienamen (zoals “verkeerslichten” of “vrachtwagen”) en uitdrukkingen (zoals “gele vrachtwagen”). Het accepteert tekst- en afbeeldingsparen om de objectdetectie uit te voeren. Het is gebaseerd op een transformatorarchitectuur en maakt kruismodaliteiten met tekst- en beeldgegevens mogelijk. Voor meer informatie over het aarden van DINO, zie Aarding DINO: Combineer DINO met geaarde voortraining voor detectie van open objecten. Dit genereert begrenzingsvakken en labels en kan verder worden verwerkt om middelpunten te genereren, te filteren op basis van labels, drempels en meer. Dit wordt gebruikt (vakken of punten) als een prompt voor SAM voor segmentatie, die maskers uitvoert.

Hieronder volgen enkele voorbeelden van de invoertekst, DINO-uitvoer (grensvakken) en de uiteindelijke SAM-uitvoer (segmentatiemaskers).

De volgende afbeeldingen tonen de uitvoer voor 'gele vrachtwagen'.

De volgende afbeeldingen tonen de uitvoer voor 'zilveren auto'.

De volgende afbeelding toont de uitvoer voor ‘rijstrook’.

We kunnen deze pijplijn gebruiken om een visuele keten op te bouwen. In het volgende codefragment wordt dit concept uitgelegd:

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Hoewel dit een eenvoudig voorbeeld is, kan dit concept worden uitgebreid tot het verwerken van feeds van camera's op voertuigen, het volgen van objecten, het redigeren van persoonlijk identificeerbare informatie (PII) en meer. We kunnen de selectiekaders ook van kleinere modellen verkrijgen, of in sommige gevallen met behulp van standaard computer vision-tools. Het is vrij eenvoudig om een vooraf getraind model of een dienst als Amazon Rekognition te gebruiken om initiële (visuele) labels voor uw prompt te krijgen. Op het moment dat dit wordt geschreven, zijn er meer dan 70 modellen beschikbaar op Amazon SageMaker Jumpstart voor objectdetectie, en Amazon Rekognition identificeert al verschillende nuttige categorieën objecten in afbeeldingen, waaronder auto's, voetgangers en andere voertuigen.

Vervolgens bekijken we enkele kwantitatieve resultaten met betrekking tot de prestaties van SAM-modellen met een subset van BDD100K-gegevens.

Kwantitatieve resultaten

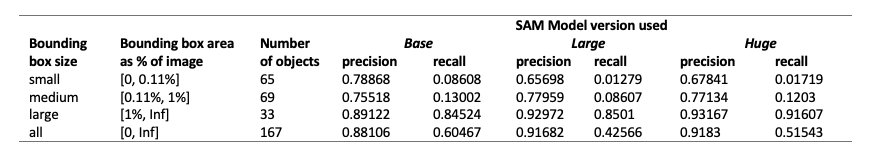

Ons doel is om de prestaties van drie vooraf getrainde modellen te vergelijken wanneer ze dezelfde visuele aanwijzingen krijgen. In dit geval gebruiken we het middelpunt van de objectlocatie als visuele invoer. We vergelijken de prestaties met betrekking tot de objectgroottes (in verhouding tot de afbeeldingsgrootte): klein (gebied <0.11%), middelgroot (0.11% < gebied < 1%) en groot (gebied > 1%). De drempels voor het begrenzingskader worden gedefinieerd door de Common Objects in Context (COCO) evaluatiestatistieken [Lin et al., 2014].

De evaluatie vindt plaats op pixelniveau en we gebruiken de volgende evaluatiestatistieken:

- Precisie = (aantal relevante en opgehaalde exemplaren) / (totaal aantal opgehaalde exemplaren)

- Recall = (aantal relevante en opgehaalde exemplaren) / (totaal aantal relevante exemplaren)

- Instanties hier zijn elke pixel binnen het selectiekader van het object van interesse

De volgende tabel rapporteert de prestaties van drie verschillende versies van het SAM-model (basis, groot en enorm). Deze versies hebben drie verschillende encoders: ViT-B (basis), ViT-L (groot), ViT-H (groot). De encoders hebben verschillende parameteraantallen, waarbij het basismodel minder parameters heeft dan groot, en groot minder dan groot is. Hoewel het vergroten van het aantal parameters verbeterde prestaties bij grotere objecten laat zien, is dit niet het geval voor kleinere objecten.

SAM afstemmen op uw gebruiksscenario

In veel gevallen is het rechtstreeks gebruiken van een vooraf getraind SAM-model niet erg nuttig. Laten we bijvoorbeeld eens kijken naar een typische scène in het verkeer: de volgende afbeelding is de uitvoer van het SAM-model met willekeurig bemonsterde promptpunten als invoer aan de linkerkant, en de daadwerkelijke labels van de semantische segmentatietaak van BDD100K aan de rechterkant. Deze zijn uiteraard heel verschillend.

Perceptiestapels in AV's kunnen gemakkelijk het tweede beeld gebruiken, maar niet het eerste. Aan de andere kant zijn er enkele nuttige resultaten uit de eerste afbeelding die kunnen worden gebruikt, en dat het model niet expliciet is getraind op bijvoorbeeld rijstrookmarkeringen, trottoirsegmentatie, kentekenplaatmaskers, enzovoort. We kunnen het SAM-model verfijnen om de segmentatieresultaten te verbeteren. Om deze verfijning uit te voeren, hebben we een trainingsdataset gemaakt met behulp van een subset voor instantiesegmentatie (500 afbeeldingen) uit de BDD10K-dataset. Dit is een zeer kleine subset van afbeeldingen, maar ons doel is om te bewijzen dat fundamentele visiemodellen (net als LLM's) goed kunnen presteren voor uw gebruiksscenario met een verrassend klein aantal afbeeldingen. De volgende afbeelding toont de invoerafbeelding, het uitvoermasker (in blauw, met een rode rand voor de auto aan de linkerkant) en mogelijke aanwijzingen (begrenzingsvak in groen en middelpunt X in geel).

We hebben de verfijning uitgevoerd met behulp van de Hugging Face-bibliotheek Amazon SageMaker Studio. We gebruikten de ml.g4dn.xlarge-instantie voor de SAM-basismodeltests, en de ml.g4dn.2xlarge voor de SAM-gigantische modeltests. In onze eerste experimenten hebben we vastgesteld dat het verfijnen van het basismodel met alleen selectiekaders niet succesvol was. De verfijnde en vooraf getrainde modellen waren niet in staat autospecifieke grondwaarheidsmaskers uit de originele datasets te leren. Ook het toevoegen van zoekpunten aan de verfijning verbeterde de training niet.

Vervolgens kunnen we proberen het enorme SAM-model te verfijnen voor 30 tijdperken, met een zeer kleine dataset (500 afbeeldingen). Het originele Ground Truth-masker ziet eruit als de volgende afbeelding voor de auto met label.

Zoals te zien is in de volgende afbeeldingen, geeft de originele, vooraf getrainde versie van het enorme model met een specifieke selectiekader (in het groen) geen uitvoer, terwijl de verfijnde versie wel uitvoer geeft (nog steeds niet nauwkeurig, maar de fijnafstemming is afgebroken uitgeschakeld na 40 tijdperken, en met een zeer kleine trainingsdataset van 500 afbeeldingen). Het originele, vooraf getrainde enorme model was niet in staat maskers te voorspellen voor de afbeeldingen die we hebben getest. Als voorbeeld van een downstream-toepassing kan het verfijnde model worden gebruikt in workflows voor het labelen, zoals beschreven in Module voor automatische labeling voor op deep learning gebaseerde geavanceerde rijhulpsystemen op AWS.

Conclusie

In dit bericht hebben we het fundamentele visiemodel besproken dat bekend staat als het Segment Anything Model (SAM) en de architectuur ervan. We hebben het SAM-model gebruikt om visuele aanwijzingen en de verschillende inputs voor visuele aanwijzingen te bespreken. We hebben onderzocht hoe verschillende visuele aanwijzingen presteren en wat hun beperkingen zijn. We hebben ook beschreven hoe visuele ketens de prestaties verbeteren ten opzichte van het gebruik van slechts één prompt, vergelijkbaar met de LangChain API. Vervolgens hebben we een kwantitatieve evaluatie van drie vooraf getrainde modellen gegeven. Ten slotte bespraken we het verfijnde SAM-model en de resultaten ervan in vergelijking met het oorspronkelijke basismodel. Het verfijnen van basismodellen helpt de modelprestaties voor specifieke taken zoals segmentatie te verbeteren. Opgemerkt moet worden dat het SAM-model vanwege de resourcevereisten het gebruik beperkt voor realtime gebruiksscenario's en gevolgtrekkingen aan de rand in de huidige staat. We hopen dat toekomstige iteraties en verbeterde technieken de rekenvereisten zullen verminderen en de latentie zullen verbeteren.

We hopen dat dit bericht u aanmoedigt om visuele aanwijzingen voor uw gebruiksscenario's te verkennen. Omdat dit nog steeds een opkomende vorm van prompt engineering is, valt er veel te ontdekken op het gebied van visuele prompts, visuele ketens en de prestaties van deze tools. Amazon Sage Maker is een volledig beheerd ML-platform waarmee bouwers grote taal- en visuele modellen kunnen verkennen en generatieve AI-applicaties kunnen bouwen. Begin vandaag nog met het bouwen aan de toekomst met AWS.

Over de auteurs

Gopi Krishnamurthy is een Senior AI/ML Solutions Architect bij Amazon Web Services in New York City. Hij werkt samen met grote Automotive-klanten als hun vertrouwde adviseur om hun Machine Learning-workloads te transformeren en naar de cloud te migreren. Zijn kerninteresses omvatten deep learning en serverloze technologieën. Buiten zijn werk brengt hij graag tijd door met zijn gezin en ontdekt hij een breed scala aan muziek.

Gopi Krishnamurthy is een Senior AI/ML Solutions Architect bij Amazon Web Services in New York City. Hij werkt samen met grote Automotive-klanten als hun vertrouwde adviseur om hun Machine Learning-workloads te transformeren en naar de cloud te migreren. Zijn kerninteresses omvatten deep learning en serverloze technologieën. Buiten zijn werk brengt hij graag tijd door met zijn gezin en ontdekt hij een breed scala aan muziek.

Shreyas Subramaniër is een Principal AI/ML-specialist Solutions Architect en helpt klanten door Machine Learning te gebruiken om hun zakelijke uitdagingen op te lossen met behulp van het AWS-platform. Shreyas heeft een achtergrond in grootschalige optimalisatie en Machine Learning, en in het gebruik van Machine Learning en Reinforcement Learning voor het versnellen van optimalisatietaken.

Shreyas Subramaniër is een Principal AI/ML-specialist Solutions Architect en helpt klanten door Machine Learning te gebruiken om hun zakelijke uitdagingen op te lossen met behulp van het AWS-platform. Shreyas heeft een achtergrond in grootschalige optimalisatie en Machine Learning, en in het gebruik van Machine Learning en Reinforcement Learning voor het versnellen van optimalisatietaken.

Sujitha Martin is een toegepaste wetenschapper bij het Generative AI Innovation Center (GAIIC). Haar expertise ligt in het bouwen van machine learning-oplossingen met computervisie en natuurlijke taalverwerking voor verschillende branches. Ze heeft in het bijzonder uitgebreide ervaring met het werken aan mensgericht situationeel bewustzijn en kennisgeïnfundeerd leren voor zeer autonome systemen.

Sujitha Martin is een toegepaste wetenschapper bij het Generative AI Innovation Center (GAIIC). Haar expertise ligt in het bouwen van machine learning-oplossingen met computervisie en natuurlijke taalverwerking voor verschillende branches. Ze heeft in het bijzonder uitgebreide ervaring met het werken aan mensgericht situationeel bewustzijn en kennisgeïnfundeerd leren voor zeer autonome systemen.

Francisco Calderon is datawetenschapper bij het Generative AI Innovation Center (GAIIC). Als lid van de GAIIC helpt hij bij het ontdekken van de kunst van het mogelijke bij AWS-klanten met behulp van generatieve AI-technologieën. In zijn vrije tijd speelt Francisco graag muziek en gitaar, voetbalt hij met zijn dochters en geniet hij van tijd met zijn gezin.

Francisco Calderon is datawetenschapper bij het Generative AI Innovation Center (GAIIC). Als lid van de GAIIC helpt hij bij het ontdekken van de kunst van het mogelijke bij AWS-klanten met behulp van generatieve AI-technologieën. In zijn vrije tijd speelt Francisco graag muziek en gitaar, voetbalt hij met zijn dochters en geniet hij van tijd met zijn gezin.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- : heeft

- :is

- :niet

- :waar

- $UP

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- vermogen

- in staat

- Over

- boven

- versnellen

- Accepteert

- accuraat

- bereikt

- daadwerkelijk

- aanpassen

- toe te voegen

- vergevorderd

- vooruitgang

- Voordeel

- adviseur

- Na

- AI

- AI / ML

- AL

- Alles

- toestaat

- langs

- al

- ook

- Hoewel

- Amazone

- Amazon Rekognition

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- en

- beantwoorden

- elke

- iedereen

- iets

- api

- toepasselijk

- Aanvraag

- toepassingen

- toegepast

- nadering

- architectuur

- ZIJN

- GEBIED

- gebieden

- rond

- reeks

- Kunst

- AS

- Hulp

- ervan uitgaan

- gaat uit van

- At

- aandacht

- automotive

- autonoom

- Beschikbaar

- bewustzijn

- AWS

- achtergrond

- baseren

- gebaseerde

- De Basis

- BE

- omdat

- worden

- geweest

- beginnen

- achter

- betekent

- Betere

- Miljard

- Blauw

- grens

- Box camera's

- dozen

- doorbraak

- breed

- bouw

- bouwers

- Gebouw

- bebouwd

- bedrijfsdeskundigen

- maar

- by

- berekenen

- Bellen

- camera

- camera's

- CAN

- Kan krijgen

- auto

- verzorging

- auto's

- geval

- gevallen

- categorieën

- Categorie

- catering

- Centreren

- keten

- ketens

- uitdagingen

- keuze

- Plaats

- schoon

- Sluiten

- CLOSED

- van nabij

- Cloud

- kokosnoot

- code

- combinatie van

- combines

- combineren

- Gemeen

- afstand

- vergelijken

- vergeleken

- computationeel

- Berekenen

- computer

- Computer visie

- concept

- concepten

- verband

- coördineren

- Kern

- Covers

- aangemaakt

- Cross

- Actueel

- Huidige toestand

- Klanten

- Snijden

- gegevens

- data scientist

- datasets

- deep

- diepgaand leren

- bepalen

- gedefinieerd

- gedemonstreerd

- beschreven

- gewenste

- Opsporing

- anders

- dino

- direct

- Onthul Nu

- bespreken

- besproken

- Uitkeringen

- diversen

- do

- Nee

- domein

- domeinen

- Dont

- drastisch

- bestuurder

- aandrijving

- twee

- e

- E & T

- elk

- gemakkelijk

- rand

- inbedding

- opkomende

- maakt

- waardoor

- moedigt

- Engineering

- Onstpanning

- Geheel

- tijdperken

- essentieel

- evaluatie

- voorbeeld

- voorbeelden

- expansieve

- verwachten

- ervaring

- experimenten

- expertise

- Verklaart

- uitleg

- uitdrukkelijk

- Verken

- Nagegaan

- uitdrukkingen

- uitgebreid

- Uitgebreide ervaring

- extract

- Gezicht

- tamelijk

- vertrouwd

- familie

- Kenmerk

- weinig

- veld-

- Figuur

- filter

- finale

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voornaam*

- richt

- gericht

- volgend

- Voor

- formulier

- Foundation

- fundamentele

- vier

- Achtergrond

- Francisco

- oppompen van

- voor

- vol

- geheel

- verder

- toekomst

- voortbrengen

- genereert

- het genereren van

- generatief

- generatieve AI

- krijgen

- gegeven

- geeft

- goed

- Groen

- Ground

- gids

- hand

- Hebben

- met

- he

- gezondheidszorg

- helpt

- haar

- hier

- Hoge

- hoogwaardige

- hoger

- zeer

- zijn

- houdt

- kap

- hoop

- Hoe

- HTML

- HTTPS

- reusachtig

- geïdentificeerd

- identificeert

- identificeren

- het identificeren van

- beeld

- afbeeldingen

- per direct

- uitvoeren

- indrukwekkend

- verbeteren

- verbeterd

- verbetering

- in

- omvatten

- Inclusief

- Laat uw omzet

- Verhoogt

- meer

- -industrie

- informatie

- geïnfundeerd

- eerste

- Innovatie

- invoer

- ingangen

- geinspireerd

- instantie

- Instantiesegmentatie

- instructies

- aandachtig

- belang

- geïnteresseerd

- interessant

- belangen

- in

- betrekken

- waarbij

- IT

- iteraties

- HAAR

- jpg

- voor slechts

- eentje maar

- kennis

- bekend

- label

- labels

- Rijstrook

- taal

- Groot

- grootschalig

- groter

- grootste

- tot slot

- Wachttijd

- LEARN

- leren

- links

- minder

- Niveau

- Bibliotheek

- Vergunning

- ligt

- Life

- Bio

- lichtgewicht

- als

- sympathieën

- beperkingen

- grenzen

- lin

- Lijst

- Elke kleine stap levert grote resultaten op!

- LLM

- plaats

- Kijk

- op zoek

- LOOKS

- Laag

- machine

- machine learning

- MERKEN

- maken

- beheerd

- handboek

- veel

- trouwen

- maskeren

- Maskers

- massief

- Mei..

- middel

- Media

- Medium

- lid

- meta

- Metriek

- trekken

- miljoen

- denken

- minimaal

- ML

- model

- modellen

- wijzigingen

- Module

- meer

- meest

- Motivatie

- veel

- meervoudig

- Muziek

- naam

- namen

- Naturel

- Natural Language Processing

- nodig

- New

- New York

- new york city

- volgende

- geen

- bekend

- aantal

- object

- Objectdetectie

- doel van de persoon

- objecten

- of

- korting

- on

- EEN

- optimalisatie

- or

- origineel

- Overige

- onze

- uit

- Resultaat

- uitgang

- uitgangen

- buiten

- over

- paren

- parameter

- parameters

- bijzonder

- onderdelen

- Patch

- perceptie

- Uitvoeren

- prestatie

- uitgevoerd

- Persoonlijk

- beeld

- pijlers

- pijpleiding

- pixel

- vliegtuig

- platform

- Plato

- Plato gegevensintelligentie

- PlatoData

- Spelen

- spelen

- punt

- punten

- Populair

- mogelijk

- Post

- potentieel

- energie

- voorspellen

- primair

- Principal

- Voorafgaand

- Verwerkt

- verwerking

- produceren

- produceert

- proportie

- voorstellen

- Bewijzen

- zorgen voor

- mits

- biedt

- het verstrekken van

- doel

- kwaliteit

- kwantitatief

- hoeveelheid

- vraag

- reeks

- real-time

- werkelijk

- redenen

- recent

- Rood

- verminderen

- verwijzen

- verwijst

- regio

- regio

- verwant

- relevante

- Rapporten

- Voorwaarden

- vereist

- hulpbron

- culturele wortels

- antwoord

- resultaat

- Resultaten

- revolutioneren

- Rijk

- rechts

- weg

- lopend

- sagemaker

- Sam

- dezelfde

- zagen

- Scale

- scène

- WETENSCHAPPEN

- Wetenschapper

- partituur

- Tweede

- secties

- zien

- gezien

- segment

- segmentatie

- segmenten

- senior

- apart

- Serverless

- service

- Diensten

- reeks

- verscheidene

- ze

- moet

- tonen

- showcase

- getoond

- Shows

- teken

- aanzienlijke

- Signs

- Zilver

- gelijk

- Eenvoudig

- enkelvoud

- Maat

- maten

- bekwaamheid

- sleuf

- speelautomaten

- Klein

- kleinere

- snipper

- So

- Voetbal

- Oplossingen

- OPLOSSEN

- sommige

- bron

- bronnen

- specialist

- specifiek

- specifiek

- besteden

- spleet

- Stacks

- standaard

- begin

- Land

- Stappen

- Still

- eenvoudig

- sterke punten

- structuur

- structurering

- strijd

- geslaagd

- dergelijk

- steunen

- overtreffen

- Systems

- tafel

- Nemen

- ingenomen

- Taak

- taken

- technieken

- Technologies

- sjabloon

- templates

- termen

- getest

- testen

- tekst

- tekstueel

- neem contact

- dat

- De

- De omgeving

- The Basics

- De toekomst

- de informatie

- hun

- Er.

- Deze

- dit

- gedachte

- drie

- Door

- niet de tijd of

- banden

- naar

- vandaag

- tools

- tools

- top

- Totaal

- Tracking

- verkeer

- getraind

- Trainingen

- Transformeren

- transformator

- truck

- waar

- vertrouwde

- waarheid

- proberen

- twee

- type dan:

- typisch

- voor

- begrijpen

- us

- bruikbaar

- Gebruik

- .

- use case

- gebruiksgevallen

- gebruikt

- Gebruiker

- gebruik

- Values

- divers

- groot

- vegetatie

- Voertuigen

- versie

- versies

- verticals

- zeer

- Video

- visie

- visuele

- vs

- W

- was

- manieren

- we

- web

- webservices

- GOED

- gegaan

- waren

- Wat

- Wat is

- wanneer

- terwijl

- welke

- geheel

- breed

- Grote range

- wijd

- wil

- Met

- binnen

- zonder

- getuige

- woorden

- Mijn werk

- workflows

- werkzaam

- Bedrijven

- zou

- het schrijven van

- X

- jaar

- york

- You

- Your

- zephyrnet