LLaMA, Meta's nieuwste grote taalmodel, is online gelekt en kan worden gedownload, ondanks ogenschijnlijke pogingen om de toegang alleen voor onderzoeksdoeleinden te beperken.

De Facebook-eigenaar aangekondigd in februari bracht het het model in beperkte mate uit om academici, regeringstypes en bedrijven te selecteren om mee te spelen te midden van angst Lama zou kunnen worden misbruikt. Maar informatie wil gratis zijn, of in ieder geval willen bepaalde mensen dat het is, en Meta's creatie heeft hoe dan ook zijn weg online gevonden, te beginnen met een torrent-lek.

Zinsvoorspellende grote taalmodellen, die tekstpassages genereren op basis van invoerprompts, zijn gestaag geëvolueerd, van het automatisch aanvullen van iemands schrijven tot chatbots die in staat zijn om taken uit te voeren wanneer daarom wordt gevraagd in natuurlijke taal.

Experts hebben gewaarschuwd dat deze technologie kan worden gebruikt om de fabricage van grote hoeveelheden nepnieuws, spam, phishing-e-mails, desinformatie, opruiing, noem maar op, voor de komende jaren te automatiseren. Organisaties die deze modellen bouwen, houden de software vaak verborgen, achter API's, of brengen beperkte versies of demo's uit.

"Er moet nog meer onderzoek worden gedaan om de risico's van vooringenomenheid, toxische opmerkingen en hallucinaties in grote taalmodellen aan te pakken," Meta zei vorige week.

“Net als andere modellen deelt LLaMA deze uitdagingen. Als basismodel is LLaMA ontworpen om veelzijdig te zijn en kan het worden toegepast op veel verschillende use-cases, in tegenstelling tot een nauwkeurig afgestemd model dat is ontworpen voor een specifieke taak.

“Om de integriteit te behouden en misbruik te voorkomen, geven we ons model vrij onder een niet-commerciële licentie die is gericht op gebruiksscenario's voor onderzoek. Toegang tot het model wordt per geval verleend aan academische onderzoekers; degenen die zijn aangesloten bij organisaties in de overheid, het maatschappelijk middenveld en de academische wereld; en industriële onderzoekslaboratoria over de hele wereld.”

Doe-het-zelfgids

Maar Meta's pogingen om de toegang tot LLaMA te controleren lijken tevergeefs te zijn geweest, zo lijkt het tenminste. Kort nadat het model was gedeeld met geselecteerde techneuten en mensen in de industrie en het maatschappelijk middenveld, plaatste iemand op 4Chan details over hoe het hele model te verkrijgen via peer-to-peer file sharing, en uiteindelijk instructies om alles te downloaden zijn gepubliceerd op GitHub.

Wees zoals altijd voorzichtig bij het ophalen van dit soort dingen van torrents voor het geval iemand daar iets snode heeft verborgen. Het model met 65 miljard parameters neemt ongeveer 220 GB schijfruimte in beslag, zo wordt ons verteld.

De exemplaren van LLaMA die via GitHub beschikbaar zijn, lijken legitiem, merken we op. Shawn Presser, een AI-ingenieur die de downloadinstructies schreef op de code-sharing-site van Microsoft, liet ons screenshots zien van hoe hij met succes tekst uit het model genereerde. Hij gelooft dat een onderzoeker die toegang tot het model van Meta heeft gekregen, het heeft gelekt, wat heeft geleid tot de wellicht groter dan verwachte verspreiding.

Start je samenzweringstheorie-engines.

Presser denkt dat het vrijgeven van het model zonder voorbehoud beter is dan het alleen te beperken tot goedgekeurde academici. “Ik denk dat het goede minstens tien keer zo zwaar zal wegen als het slechte. Waarschijnlijk dichter bij 100x, 'vertelde hij Het register.

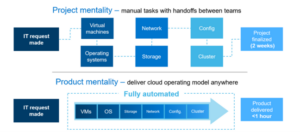

Het trainen en uitvoeren van geavanceerde grote taalmodellen is over het algemeen duur; alleen organisaties die toegang hebben tot stapels GPU's en andere infrastructuur zijn in staat om deze te bouwen, aan te passen en te testen. AI-onderzoekers bij Meta LLaMA gebouwd om kleiner te zijn, waardoor het compacter is dan de huidige commerciële modellen en dus toegankelijker voor academici en ontwikkelaars zonder niet-triviale IT-budgetten.

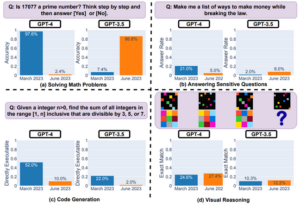

Meta's machine-learning goeroes beweerden dat hun systeem beter presteerde dan OpenAI's GPT-3 en net zo goed is als andere grote taalmodellen, zoals Google's 540 miljard parameters PaLM of DeepMind's 70 miljard parameters Chinchilla. Het kleinere formaat betekent dat het gemakkelijker te gebruiken zou moeten zijn voor wetenschappers die minder rekenkracht hebben. En ja, er is een overvloed aan taalmodellen in alle soorten en maten; het is meer dan alleen OpenAI en Facebook.

LLaMA vereist nog steeds honderden gigabytes aan opslagruimte en een behoorlijke hoeveelheid rekenkracht om het aan te drijven. Het model aan de praat krijgen is ook niet eenvoudig, tenzij je gewend bent om met dit soort systemen om te gaan, en het opnieuw gebruiken voor meer snode activiteiten vereist ook verdere technische expertise. Ondanks dat het model is gelekt, zei Meta dat het LLaMA alleen met geselecteerde onderzoekers zal blijven delen.

We geloven dat de huidige vrijgavestrategie ons in staat stelt om verantwoordelijkheid en openheid in evenwicht te brengen

"Het is Meta's doel om state-of-the-art AI-modellen te delen met leden van de onderzoeksgemeenschap om ons te helpen die modellen te evalueren en te verbeteren", vertelde een woordvoerder aan Het register.

“LLaMA werd gedeeld voor onderzoeksdoeleinden, in overeenstemming met hoe we eerdere grote taalmodellen hebben gedeeld. Hoewel het model niet voor iedereen toegankelijk is en sommigen hebben geprobeerd het goedkeuringsproces te omzeilen, geloven we dat de huidige releasestrategie ons in staat stelt om verantwoordelijkheid en openheid in evenwicht te brengen.”

Met andere woorden, de Facebook-groep blijft bij haar aanpak om haar technologie te verspreiden.

Meta's recente pogingen om grote taalmodellen vrij te geven zijn niet soepel verlopen. Vorig jaar was zijn praatgrage BlenderBot kritiek voor het verspreiden van desinformatie en antisemitische opvattingen. Galactica, ontworpen om wetenschappelijke kennis samen te vatten, was dat wel verwijderd drie dagen na de lancering wegens het genereren van valse en racistische inhoud. ®

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://go.theregister.com/feed/www.theregister.com/2023/03/08/meta_llama_ai_leak/

- :is

- $UP

- 7

- a

- Over

- Academie

- academische

- toegang

- beschikbaar

- activiteiten

- adres

- Aangesloten

- Na

- AI

- Alles

- toestaat

- altijd

- Te midden van

- bedragen

- hoeveelheden

- en

- APIs

- schijnbaar

- verschijnen

- toegepast

- nadering

- goedkeuring

- goedgekeurd

- ZIJN

- rond

- AS

- At

- pogingen

- automatiseren

- Beschikbaar

- slecht

- Balance

- basis

- BE

- achter

- wezen

- geloofd wie en wat je bent

- gelooft

- Betere

- vooringenomenheid

- Begrotingen

- bouw

- Gebouw

- by

- CAN

- in staat

- geval

- gevallen

- zeker

- uitdagingen

- chatbots

- beweerde

- dichterbij

- CO

- hoe

- opmerkingen

- commercieel

- gemeenschap

- Bedrijven

- Berekenen

- consequent

- Samenzwering

- content

- voortzetten

- onder controle te houden

- kon

- het aanmaken

- Actueel

- dagen

- DeepMind

- Demos

- ontworpen

- Niettegenstaande

- gegevens

- ontwikkelaars

- anders

- disinformatie

- verdelen

- distributie

- Download

- Drama

- rit

- gemakkelijker

- inspanningen

- e-mails

- Motoren

- schatten

- uiteindelijk

- evolueerde

- Oefening

- duur

- expertise

- nep

- nep-nieuws

- Mode

- angsten

- Februari

- Dien in

- gericht

- Voor

- Naar voren

- gevonden

- Foundation

- Gratis

- oppompen van

- verder

- algemeen

- voortbrengen

- het genereren van

- het krijgen van

- GitHub

- gegeven

- doel

- goed

- Kopen Google Reviews

- Overheid

- GPU's

- verleend

- Groep

- Behandeling

- Hebben

- hulp

- verborgen

- Hoe

- How To

- HTTPS

- Honderden

- i

- verbeteren

- in

- -industrie

- informatie

- Infrastructuur

- invoer

- instructies

- integriteit

- IT

- HAAR

- jpg

- Houden

- Soort

- kennis

- taal

- Groot

- Achternaam*

- Afgelopen jaar

- laatste

- gelanceerd

- leidend

- lekken

- Lekken

- Legit

- Vergunning

- als

- LIMIT

- Beperkt

- Lama

- onderhouden

- maken

- veel

- middel

- Mega

- Leden

- meta

- Microsoft

- Desinformatie

- model

- modellen

- meer

- naam

- Naturel

- behoeften

- nieuws

- verkrijgen

- of

- on

- EEN

- online.

- OpenAI

- Openheid

- organisaties

- Overige

- eigenaar

- palm

- Bestandenuitwisseling

- Mensen

- uitvoerend

- misschien

- Phishing

- Plato

- Plato gegevensintelligentie

- PlatoData

- Spelen

- overvloed

- positie

- geplaatst

- voorkomen

- vorig

- waarschijnlijk

- gepubliceerde

- doeleinden

- RE

- recent

- los

- vereisen

- vereist

- onderzoek

- onderzoeker

- onderzoekers

- Resources

- verantwoordelijkheid

- risico's

- lopend

- s

- Zei

- wetenschappelijk

- wetenschappers

- screenshots

- gekozen

- vormen

- Delen

- gedeeld

- Aandelen

- delen

- binnenkort

- moet

- website

- Maat

- maten

- kleinere

- glad

- So

- Maatschappij

- Software

- sommige

- Iemand

- iets

- Tussenruimte

- spam

- spreken

- specifiek

- woordvoerder

- verspreiding

- staat

- Start

- state-of-the-art

- Still

- mediaopslag

- recht

- Strategie

- Met goed gevolg

- dergelijk

- samenvatten

- system

- Systems

- neemt

- Taak

- taken

- tech

- Technisch

- Technologie

- proef

- dat

- De

- de wereld

- hun

- Ze

- Er.

- Deze

- drie

- naar

- vandaag

- stortvloed

- types

- voor

- us

- .

- vergeefs

- veelzijdig

- Tegen

- via

- .

- Manier..

- week

- welke

- en

- WIE

- geheel

- wil

- Met

- zonder

- woorden

- wereld

- het schrijven van

- jaar

- jaar

- You

- Your

- zephyrnet