Vandaag zijn we verheugd aan te kondigen dat de door Meta ontwikkelde Llama 2-basismodellen beschikbaar zijn voor klanten via Amazon SageMaker JumpStart. De Llama 2-familie van grote taalmodellen (LLM's) is een verzameling van vooraf getrainde en verfijnde generatieve tekstmodellen, variërend in schaal van 7 miljard tot 70 miljard parameters. Verfijnde LLM's, Llama-2-chat genaamd, zijn geoptimaliseerd voor gebruikssituaties in de dialoog. U kunt deze modellen eenvoudig uitproberen en gebruiken met SageMaker JumpStart, een machine learning-hub (ML) die toegang biedt tot algoritmen, modellen en ML-oplossingen, zodat u snel aan de slag kunt met ML.

In dit bericht laten we zien hoe u Llama 2-modellen kunt gebruiken via SageMaker JumpStart.

Wat is Lama 2

Llama 2 is een auto-regressief taalmodel dat gebruik maakt van een geoptimaliseerde transformatorarchitectuur. Llama 2 is bedoeld voor commercieel en onderzoeksgebruik in het Engels. Het wordt geleverd in een reeks parametergroottes - 7 miljard, 13 miljard en 70 miljard - evenals vooraf getrainde en nauwkeurig afgestelde variaties. Volgens Meta gebruiken de afgestemde versies gesuperviseerde fijnafstemming (SFT) en versterkend leren met menselijke feedback (RLHF) om af te stemmen op menselijke voorkeuren voor behulpzaamheid en veiligheid. Lama 2 is vooraf getraind op 2 biljoen tokens aan gegevens uit openbaar beschikbare bronnen. De afgestemde modellen zijn bedoeld voor assistent-achtige chat, terwijl vooraf getrainde modellen kunnen worden aangepast voor een verscheidenheid aan taken voor het genereren van natuurlijke taal. Ongeacht welke versie van het model een ontwikkelaar gebruikt, de gids voor verantwoord gebruik van Meta kan helpen bij het begeleiden van aanvullende fijnafstellingen die nodig kunnen zijn om de modellen aan te passen en te optimaliseren met de juiste veiligheidsbeperkingen.

Wat is SageMaker JumpStart

Met SageMaker JumpStart kunnen ML-beoefenaars kiezen uit een brede selectie van open source basismodellen. ML-beoefenaars kunnen basismodellen inzetten voor dedicated Amazon Sage Maker instances uit een netwerkgeïsoleerde omgeving en pas modellen aan met SageMaker voor modeltraining en -implementatie.

Je kunt Llama 2 nu met een paar klikken ontdekken en inzetten Amazon SageMaker Studio of programmatisch via de SageMaker Python SDK, zodat u modelprestaties en MLOps-besturingselementen kunt afleiden met SageMaker-functies zoals Amazon SageMaker-pijpleidingen, Amazon SageMaker-foutopsporing, of containerlogboeken. Het model wordt geïmplementeerd in een AWS-beveiligde omgeving en onder uw VPC-controles, waardoor gegevensbeveiliging wordt gegarandeerd. Llama 2-modellen zijn vanaf vandaag beschikbaar in Amazon SageMaker Studio, aanvankelijk in us-east 1 en us-west 2 Regio's.

Ontdek modellen

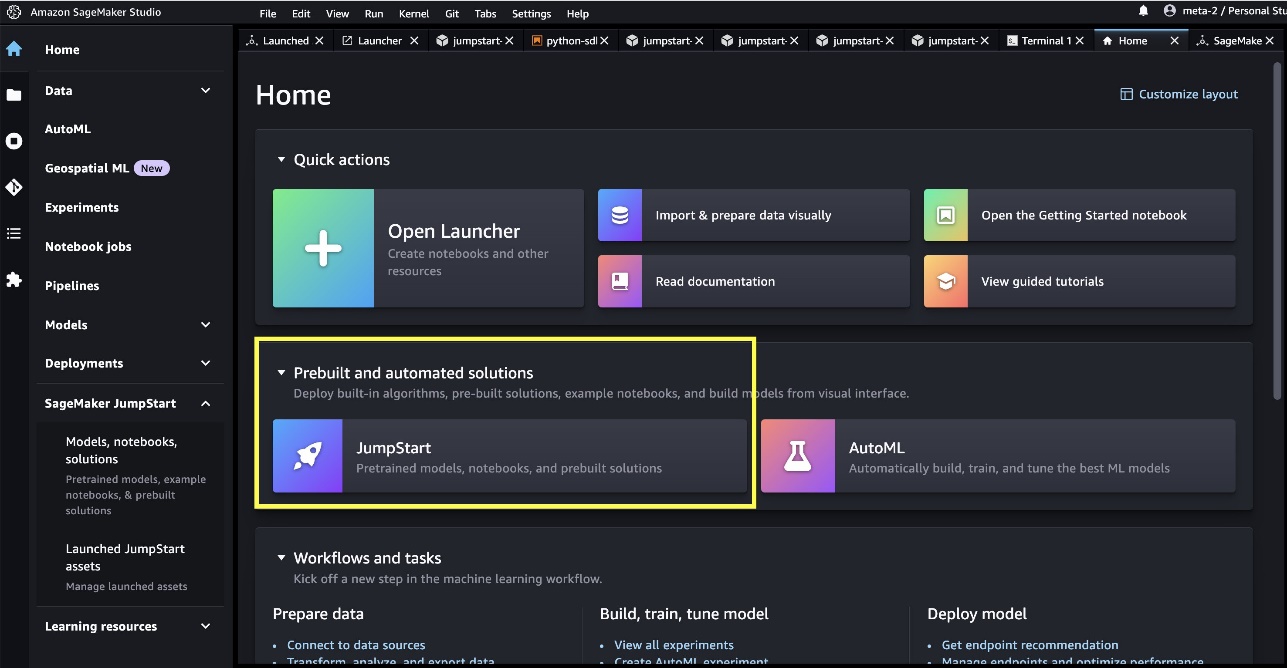

U hebt toegang tot de basismodellen via SageMaker JumpStart in de gebruikersinterface van SageMaker Studio en de SageMaker Python SDK. In dit gedeelte bespreken we hoe u de modellen in SageMaker Studio kunt ontdekken.

SageMaker Studio is een geïntegreerde ontwikkelomgeving (IDE) die een enkele webgebaseerde visuele interface biedt waar u toegang hebt tot speciaal gebouwde tools om alle ML-ontwikkelingsstappen uit te voeren, van het voorbereiden van gegevens tot het bouwen, trainen en implementeren van uw ML-modellen. Raadpleeg voor meer informatie over hoe u aan de slag kunt gaan en SageMaker Studio kunt instellen Amazon SageMaker Studio.

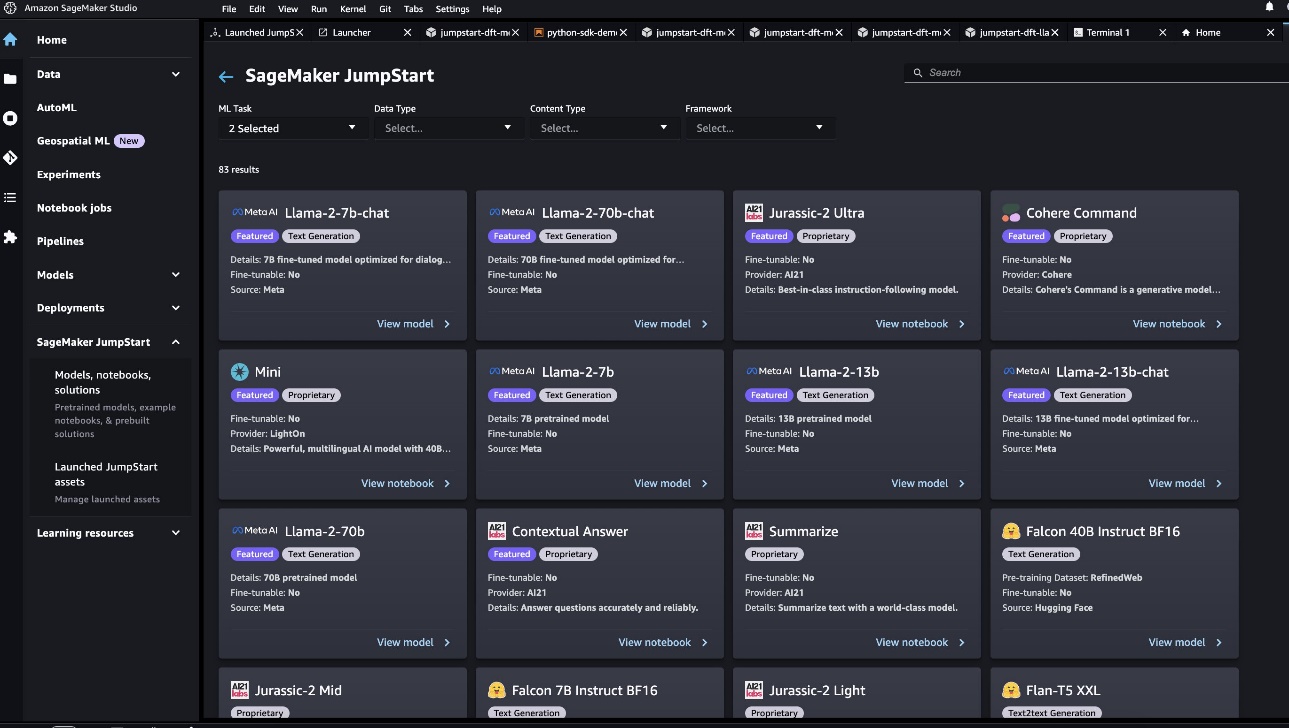

Als u eenmaal in de SageMaker Studio bent, hebt u toegang tot SageMaker JumpStart, dat vooraf getrainde modellen, notebooks en kant-en-klare oplossingen bevat, onder Kant-en-klare en geautomatiseerde oplossingen.

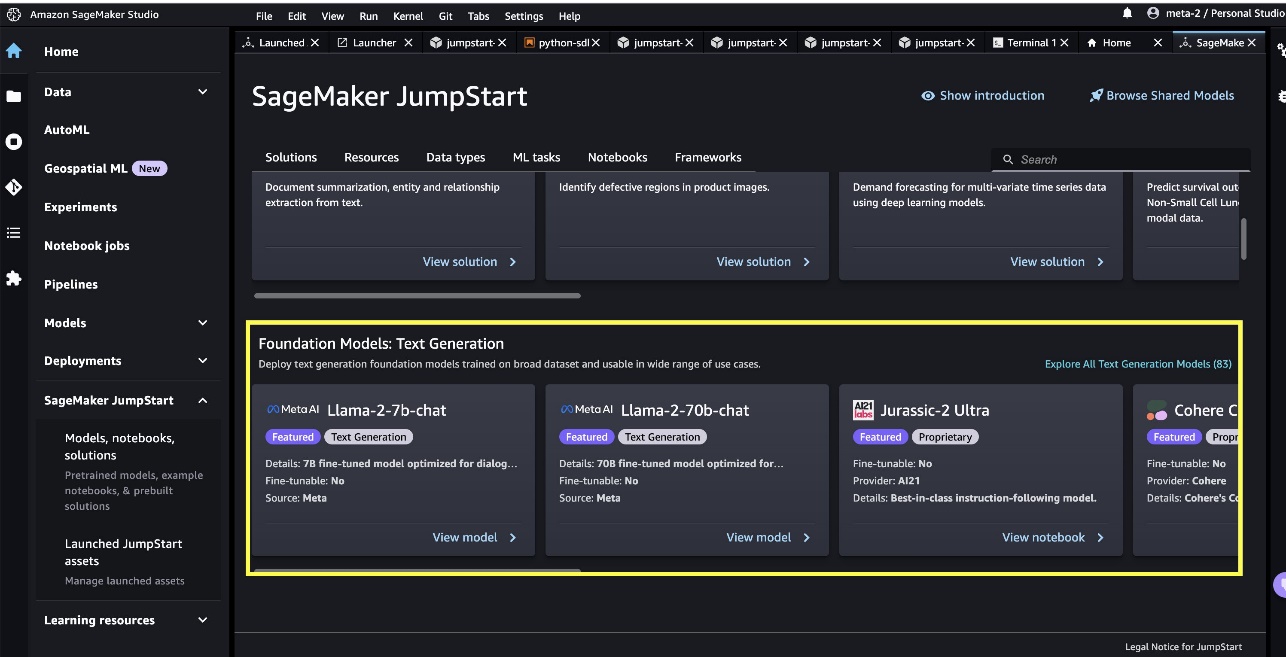

Vanaf de startpagina van SageMaker JumpStart kunt u zoeken naar oplossingen, modellen, notebooks en andere bronnen. Je kunt twee vlaggenschip Llama 2-modellen vinden in de Stichting modellen: Tekst genereren carrousel. Als u geen Llama 2-modellen ziet, werkt u uw SageMaker Studio-versie bij door af te sluiten en opnieuw op te starten. Raadpleeg voor meer informatie over versie-updates Sluit Studio-apps af en werk ze bij.

U kunt ook vier andere modelvarianten vinden door te kiezen Ontdek alle modellen voor tekstgeneratie of zoeken naar llama in het zoekvak.

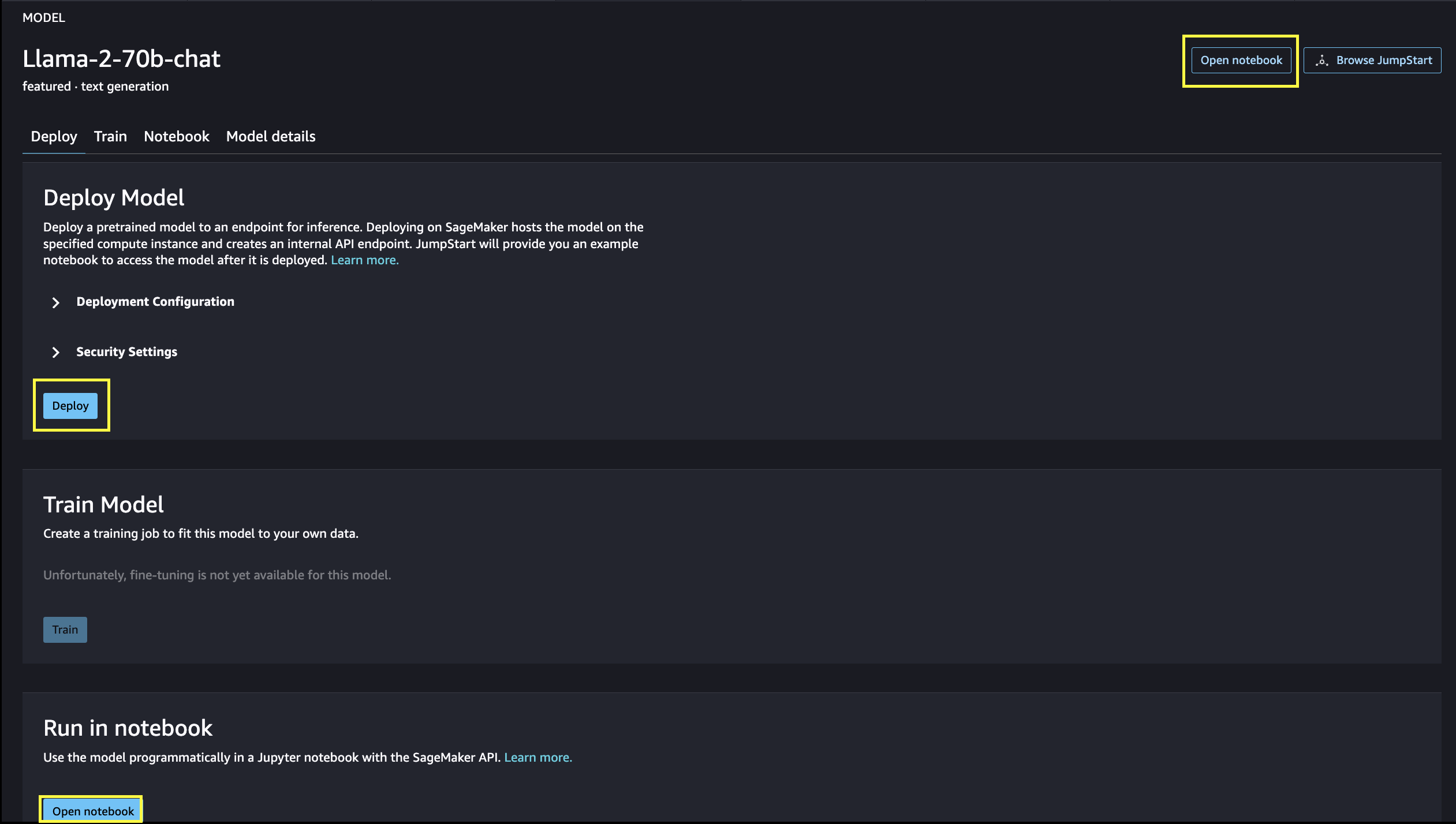

U kunt de modelkaart kiezen om details over het model te bekijken, zoals licentie, gegevens die zijn gebruikt om te trainen en hoe te gebruiken. U kunt ook twee knoppen vinden, Implementeren en Notitieblok openen, die u helpen het model te gebruiken.

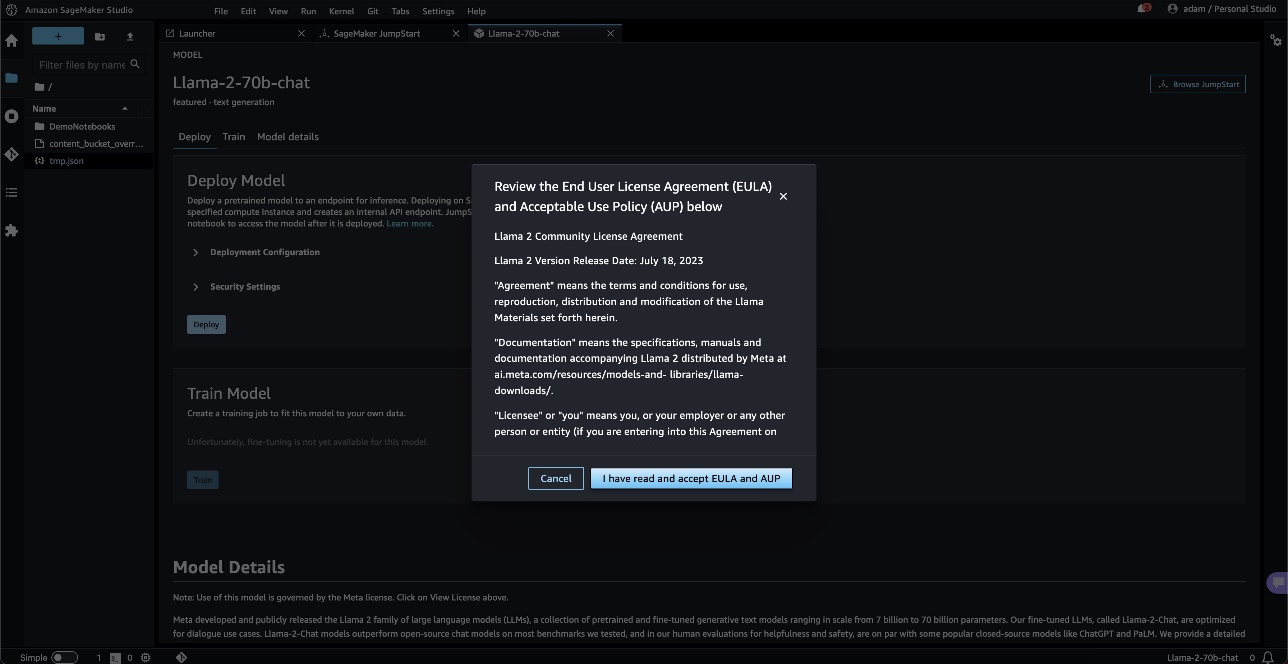

Wanneer u een van beide knoppen kiest, toont een pop-up de licentieovereenkomst voor eindgebruikers en het beleid voor acceptabel gebruik dat u moet bevestigen.

Na bevestiging gaat u verder met de volgende stap om het model te gebruiken.

Een model implementeren

Wanneer je kiest Implementeren en accepteer de voorwaarden, de modelimplementatie begint. U kunt ook implementeren via het voorbeeldnotitieblok dat wordt weergegeven door te kiezen Notitieblok openen. Het voorbeeldnotitieblok biedt end-to-end-richtlijnen voor het implementeren van het model voor deductie en het opschonen van bronnen.

Om te implementeren met behulp van een notebook, beginnen we met het selecteren van een geschikt model, gespecificeerd door de model_id. U kunt elk van de geselecteerde modellen op SageMaker implementeren met de volgende code:

Dit implementeert het model op SageMaker met standaardconfiguraties, inclusief standaard instantietype en standaard VPC-configuraties. U kunt deze configuraties wijzigen door niet-standaardwaarden op te geven in JumpStart-model. Nadat het is geïmplementeerd, kunt u deductie uitvoeren tegen het geïmplementeerde eindpunt via de SageMaker-voorspeller:

Verfijnde chatmodellen (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) accepteren een chatgeschiedenis tussen de gebruiker en de chatassistent en genereren de daaropvolgende chat. De vooraf getrainde modellen (Llama-2-7b, Llama-2-13b, Llama-2-70b) vereisen een tekenreeksprompt en voeren tekstaanvulling uit op de opgegeven prompt. Zie de volgende code:

Merk op dat standaard accept_eula is ingesteld op onwaar. Je moet instellen accept_eula=true om het eindpunt met succes aan te roepen. Door dit te doen, accepteert u de gebruikerslicentieovereenkomst en het beleid voor acceptabel gebruik zoals eerder vermeld. Je kan ook Download de licentieovereenkomst.

Custom_attributes die worden gebruikt om EULA door te geven, zijn sleutel/waarde-paren. De sleutel en waarde worden gescheiden door = en paren worden gescheiden door ;. Als de gebruiker dezelfde sleutel meer dan eens doorgeeft, wordt de laatste waarde bewaard en doorgegeven aan de scripthandler (dwz in dit geval gebruikt voor voorwaardelijke logica). Als bijvoorbeeld accept_eula=false; accept_eula=true wordt vervolgens doorgegeven aan de server accept_eula=true wordt bewaard en doorgegeven aan de scripthandler.

Inferentieparameters regelen het proces voor het genereren van tekst op het eindpunt. De maximale controle over nieuwe tokens verwijst naar de grootte van de uitvoer die door het model wordt gegenereerd. Merk op dat dit niet hetzelfde is als het aantal woorden, omdat het vocabulaire van het model niet hetzelfde is als het Engelse vocabulaire en elk token mogelijk geen Engelstalig woord is. Temperatuur regelt de willekeur in de uitvoer. Hogere temperaturen resulteren in meer creatieve en hallucinerende resultaten. Alle inferentieparameters zijn optioneel.

De volgende tabel geeft een overzicht van alle Lama-modellen die beschikbaar zijn in SageMaker JumpStart samen met de model_ids, standaardinstantietypen en het maximale aantal totale tokens (som van het aantal invoertokens en het aantal gegenereerde tokens) dat voor elk van deze modellen wordt ondersteund.

| Modelnaam | Model ID | Maximale totale tokens | Standaard instantietype |

| Lama-2-7b | meta-tekstgeneratie-lama-2-7b | 4096 | ml.g5.2xgroot |

| Lama-2-7b-chat | meta-tekstgeneratie-lama-2-7b-f | 4096 | ml.g5.2xgroot |

| Lama-2-13b | meta-tekstgeneratie-lama-2-13b | 4096 | ml.g5.12xgroot |

| Lama-2-13b-chat | meta-tekstgeneratie-lama-2-13b-f | 4096 | ml.g5.12xgroot |

| Lama-2-70b | meta-tekstgeneratie-lama-2-70b | 4096 | ml.g5.48xgroot |

| Lama-2-70b-chat | meta-tekstgeneratie-lama-2-70b-f | 4096 | ml.g5.48xgroot |

Houd er rekening mee dat SageMaker-eindpunten een time-outlimiet van 60 seconden hebben. Dus hoewel het model mogelijk 4096 tokens kan genereren, zal het verzoek mislukken als het genereren van tekst meer dan 60 seconden duurt. Voor 7B-, 13B- en 70B-modellen raden we aan om in te stellen max_new_tokens niet meer dan respectievelijk 1500, 1000 en 500, terwijl het totale aantal tokens minder dan 4K blijft.

Inferentie- en voorbeeldvragen voor Llama-2-70b

U kunt Llama-modellen gebruiken voor tekstaanvulling voor elk stuk tekst. Door het genereren van tekst kunt u verschillende taken uitvoeren, zoals het beantwoorden van vragen, taalvertaling, sentimentanalyse en nog veel meer. De invoerpayload naar het eindpunt ziet eruit als de volgende code:

Hieronder volgen enkele voorbeeldprompts en de tekst die door het model wordt gegenereerd. Alle uitvoer wordt gegenereerd met inferentieparameters {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

In het volgende voorbeeld laten we zien hoe Llama-modellen kunnen worden gebruikt met weinig-shot in-context leren, waarbij we trainingsvoorbeelden beschikbaar stellen voor het model. Houd er rekening mee dat we alleen conclusies trekken over het geïmplementeerde model en tijdens dit proces veranderen de modelgewichten niet.

Inferentie- en voorbeeldvragen voor Llama-2-70b-chat

Met Llama-2-Chat-modellen, die zijn geoptimaliseerd voor gebruiksscenario's voor dialogen, is de invoer voor de eindpunten van het chatmodel de eerdere geschiedenis tussen de chatassistent en de gebruiker. U kunt contextuele vragen stellen over het gesprek dat tot nu toe heeft plaatsgevonden. U kunt ook de systeemconfiguratie opgeven, zoals persona's die het gedrag van de chatassistent bepalen. De invoerpayload naar het eindpunt ziet eruit als de volgende code:

Hieronder volgen enkele voorbeeldprompts en de tekst die door het model wordt gegenereerd. Alle uitvoer wordt gegenereerd met de inferentieparameters {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

In het volgende voorbeeld heeft de gebruiker een gesprek gehad met de assistent over toeristische bezienswaardigheden in Parijs. Vervolgens informeert de gebruiker naar de eerste optie die door de chatassistent wordt aanbevolen.

In de volgende voorbeelden stellen we de configuratie van het systeem in:

Opruimen

Nadat u klaar bent met het uitvoeren van de notebook, moet u ervoor zorgen dat u alle resources verwijdert, zodat alle resources die u tijdens het proces hebt gemaakt, worden verwijderd en uw facturering wordt stopgezet:

Conclusie

In dit bericht hebben we je laten zien hoe je aan de slag kunt met Llama 2-modellen in SageMaker Studio. Hiermee heb je toegang tot zes Llama 2 foundation modellen die miljarden parameters bevatten. Omdat basismodellen vooraf zijn getraind, kunnen ze ook helpen de kosten voor training en infrastructuur te verlagen en maatwerk voor uw gebruik mogelijk te maken. Ga naar de volgende bronnen om aan de slag te gaan met SageMaker JumpStart:

Over de auteurs

juni gewonnen is een productmanager bij SageMaker JumpStart. Hij richt zich op het gemakkelijk vindbaar en bruikbaar maken van basismodellen om klanten te helpen bij het bouwen van generatieve AI-applicaties. Zijn ervaring bij Amazon omvat ook mobiele winkelapplicaties en last mile-bezorging.

juni gewonnen is een productmanager bij SageMaker JumpStart. Hij richt zich op het gemakkelijk vindbaar en bruikbaar maken van basismodellen om klanten te helpen bij het bouwen van generatieve AI-applicaties. Zijn ervaring bij Amazon omvat ook mobiele winkelapplicaties en last mile-bezorging.

Dr Vivek Madan is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign en was een postdoctoraal onderzoeker bij Georgia Tech. Hij is een actief onderzoeker op het gebied van machine learning en algoritmeontwerp en heeft artikelen gepubliceerd op EMNLP-, ICLR-, COLT-, FOCS- en SODA-conferenties.

Dr Vivek Madan is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign en was een postdoctoraal onderzoeker bij Georgia Tech. Hij is een actief onderzoeker op het gebied van machine learning en algoritmeontwerp en heeft artikelen gepubliceerd op EMNLP-, ICLR-, COLT-, FOCS- en SODA-conferenties.  Dr Kyle Ulrich is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Zijn onderzoeksinteresses omvatten schaalbare machine learning-algoritmen, computervisie, tijdreeksen, Bayesiaanse niet-parametrische gegevens en Gaussiaanse processen. Zijn PhD is van Duke University en hij heeft artikelen gepubliceerd in NeurIPS, Cell en Neuron.

Dr Kyle Ulrich is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Zijn onderzoeksinteresses omvatten schaalbare machine learning-algoritmen, computervisie, tijdreeksen, Bayesiaanse niet-parametrische gegevens en Gaussiaanse processen. Zijn PhD is van Duke University en hij heeft artikelen gepubliceerd in NeurIPS, Cell en Neuron.  Dr Ashish Khetan is een Senior Applied Scientist bij Amazon SageMaker JumpStart en helpt bij het ontwikkelen van machine learning-algoritmen. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign. Hij is een actief onderzoeker op het gebied van machine learning en statistische inferentie, en heeft veel artikelen gepubliceerd op NeurIPS-, ICML-, ICLR-, JMLR-, ACL- en EMNLP-conferenties.

Dr Ashish Khetan is een Senior Applied Scientist bij Amazon SageMaker JumpStart en helpt bij het ontwikkelen van machine learning-algoritmen. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign. Hij is een actief onderzoeker op het gebied van machine learning en statistische inferentie, en heeft veel artikelen gepubliceerd op NeurIPS-, ICML-, ICLR-, JMLR-, ACL- en EMNLP-conferenties.  Soendar Ranganathan is het wereldwijde hoofd van GenAI/Frameworks GTM-specialisten bij AWS. Hij richt zich op het ontwikkelen van GTM-strategieën voor grote taalmodellen, GenAI en grootschalige ML-workloads voor AWS-services zoals Amazon EC2, EKS, EFA, AWS Batch en Amazon SageMaker. Zijn ervaring omvat leiderschapsrollen in productbeheer en productontwikkeling bij NetApp, Micron Technology, Qualcomm en Mentor Graphics.

Soendar Ranganathan is het wereldwijde hoofd van GenAI/Frameworks GTM-specialisten bij AWS. Hij richt zich op het ontwikkelen van GTM-strategieën voor grote taalmodellen, GenAI en grootschalige ML-workloads voor AWS-services zoals Amazon EC2, EKS, EFA, AWS Batch en Amazon SageMaker. Zijn ervaring omvat leiderschapsrollen in productbeheer en productontwikkeling bij NetApp, Micron Technology, Qualcomm en Mentor Graphics.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- : heeft

- :is

- :niet

- :waar

- $UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360 graden

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- in staat

- Over

- ACCEPTEREN

- aanvaardbaar

- toegang

- de toegankelijkheid

- beschikbaar

- Volgens

- erkennen

- over

- actieve

- toevoegen

- toe te voegen

- Extra

- adres

- Na

- weer

- tegen

- Overeenkomst

- AI

- algoritme

- algoritmen

- richten

- Alles

- toelaten

- langs

- ook

- altijd

- am

- Amazone

- Amazon EC2

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Amazon Web Services

- Amerikaans

- an

- analyse

- en

- en infrastructuur

- aankondigen

- Nog een

- beantwoorden

- elke

- iedereen

- Aanvraag

- toepassingen

- toegepast

- waarderen

- passend

- Boog

- architectuur

- ZIJN

- Kunst

- AS

- helpen

- Assistent

- At

- Sfeer

- attracties

- geautomatiseerde

- Beschikbaar

- AWS

- Banana

- basis-

- Strijd

- Bayesian

- BE

- prachtige

- Beauty

- werd

- omdat

- worden

- geweest

- bier

- vaardigheden

- gedrag

- Beijing

- geloofd wie en wat je bent

- geloofde

- BEST

- tussen

- factuuradres

- Miljard

- miljarden

- Zwart

- Box camera's

- Breken

- adembenemend

- breed

- bouw

- Gebouw

- bebouwd

- maar

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- CAN

- hoofdstad

- auto

- kaart

- carrousel

- geval

- gevallen

- KAT

- verandering

- Chocolade

- Kies

- het kiezen van

- Plaats

- klassiek

- code

- Collectie

- gecombineerde

- combines

- komt

- komst

- commercieel

- afstand

- voltooiing

- computer

- Computer visie

- conferenties

- zeker

- Configuratie

- beschouwd

- constante

- bouw

- bevatten

- Containers

- bevat

- content

- contextual

- voortzetten

- doorlopend

- onder controle te houden

- controles

- gemakkelijk

- Gesprek

- Kosten

- Land

- moed

- deksel

- en je merk te creëren

- aangemaakt

- Creatieve

- culturele

- Culture

- beker

- Klanten

- maatwerk

- aan te passen

- gegevens

- gegevensbeveiliging

- toegewijd aan

- toewijding

- Standaard

- bepalen

- levering

- implementeren

- ingezet

- het inzetten

- inzet

- ontplooit

- Design

- ontworpen

- gewenste

- bestemming

- bestemmingen

- gegevens

- ontwikkelen

- ontwikkelde

- Ontwikkelaar

- het ontwikkelen van

- Ontwikkeling

- Dialoog

- verschil

- anders

- moeilijk

- Onthul Nu

- kenmerkend

- do

- documentaires

- doen

- gedaan

- Dont

- verdubbelde

- beneden

- Hertog

- Duke universiteit

- gedurende

- e

- elk

- Vroeger

- gemakkelijk

- En het is heel gemakkelijk

- Edward

- einstein

- beide

- in staat stellen

- waardoor

- einde

- eind tot eind

- Endpoint

- Engineering

- Engels

- en geniet van

- genoeg

- verzekeren

- Milieu

- uitrusting

- Ether

- Zelfs

- EVENTS

- iedereen

- voorbeeld

- voorbeelden

- opgewonden

- ervaring

- experiment

- experimenten

- uitdrukkelijk

- FAIL

- Mislukt

- eerlijk

- vals

- familie

- beroemd

- ver

- prestatie

- uitgelicht

- Voordelen

- feedback

- Voeten

- weinig

- films

- finale

- Tot slot

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voornaam*

- vlaggeschip

- Vlotter

- Stromen

- richt

- volgend

- Voor

- Naar voren

- gevonden

- Foundation

- vier

- Frankrijk

- Frans

- oppompen van

- geheel

- verder

- toekomst

- Algemeen

- voortbrengen

- gegenereerde

- generatie

- generatief

- generatieve AI

- krijgen

- Geven

- glas

- Globaal

- Go

- gaan

- grafiek

- groot

- meer

- baanbrekende

- Groeien

- leiding

- gids

- HAD

- Handvaten

- gebeurd

- gelukkig

- Hard

- hard werken

- Hebben

- met

- he

- hoofd

- hulp

- het helpen van

- helpt

- hier

- hi

- Hoge

- hoger

- zijn

- historisch

- geschiedenis

- behuizing

- Hoe

- How To

- HTML

- HTTPS

- Naaf

- menselijk

- i

- iconische

- idee

- if

- ii

- Illinois

- Impact

- importeren

- belangrijk

- indrukwekkend

- in

- omvatten

- omvat

- Inclusief

- Incorporated

- informatie

- Infrastructuur

- eerste

- invoer

- geinspireerd

- inspirerende

- instantie

- ogenblikkelijk

- instructies

- geïntegreerde

- bestemde

- belangen

- Interface

- in

- geïsoleerd

- IT

- HAAR

- jpg

- voor slechts

- houden

- gehouden

- sleutel

- Soort

- blijven

- bekend

- landing

- mijlpaal

- taal

- Groot

- grootschalig

- grootste

- Achternaam*

- Laat

- lancering

- Wetten

- Leadership

- LEARN

- Leer en groei

- leren

- minst

- minder

- niveaus

- Vergunning

- Life

- licht

- als

- LIMIT

- lijsten

- literatuur

- ll

- Lama

- logica

- lang

- lange tijd

- op zoek

- LOOKS

- liefde

- hield

- te verlagen

- machine

- machine learning

- gemaakt

- maken

- MERKEN

- maken

- management

- manager

- veel

- wonder

- Materie

- maximaal

- Mei..

- betekenis

- maatregel

- Media

- Medium

- vermeld

- Bericht

- meta

- micron

- minuut

- minuten

- mengsel

- ML

- MLops

- Mobile

- model

- modellen

- moment

- maanden

- meer

- meest

- Meest populair

- beweging

- filmpje

- veel

- Museum

- musea

- Muziek

- naam

- Naturel

- noodzakelijk

- Noodzaak

- nodig

- netwerk

- New

- New York

- volgende

- geen

- notitieboekje

- nu

- aantal

- vele

- NY

- of

- bieden

- het aanbieden van

- Aanbod

- Olie

- on

- eens

- EEN

- Slechts

- open

- open source

- Optimaliseer

- geoptimaliseerde

- Keuze

- or

- Overige

- Overig

- anders-

- onze

- uit

- uitgang

- over

- totaal

- pagina

- paren

- Papier

- papieren

- parameter

- parameters

- Parijs

- deel

- passeren

- voorbij

- passes

- verleden

- vrede te brengen.

- Uitvoeren

- prestatie

- blijvend

- phone

- foto's

- Fysica

- stuk

- Pizza

- plastic

- Plato

- Plato gegevensintelligentie

- PlatoData

- gespeeld

- beleidsmaatregelen

- pop-up

- Populair

- Post

- via de post

- predictor

- voorkeuren

- voorbereiding

- presenteren

- vorig

- processen

- Product

- productontwikkeling

- product management

- product manager

- voorstellen

- trots

- zorgen voor

- mits

- biedt

- het verstrekken van

- publiek

- openbaar vervoer

- in het openbaar

- gepubliceerde

- doel

- zetten

- Python

- Qualcomm

- Contact

- Quick

- snel

- ramps

- willekeurigheid

- reeks

- variërend

- klaar

- redenen

- ontvangen

- recept

- adviseren

- aanbevolen

- verwijst

- achteloos

- regio

- relatief

- relativiteit

- herhaald

- vertegenwoordigen

- te vragen

- vereist

- onderzoek

- onderzoeker

- Resources

- respectievelijk

- Reageren

- REST

- resultaat

- Resultaten

- Rivier

- Rol

- rollen

- lopen

- lopend

- s

- Veiligheid

- sagemaker

- zout

- dezelfde

- schaalbare

- Scale

- Wetenschapper

- wetenschappers

- sdk

- SEA

- Ontdek

- zoeken

- sectie

- beveiligen

- veiligheid

- zien

- te zien

- scheen

- gekozen

- selecteren

- selectie

- sturen

- senior

- sentiment

- -Series

- Diensten

- serveer-

- reeks

- het instellen van

- Vorm

- haai

- Winkelen

- moet

- tonen

- vertoonde

- Shows

- het afsluiten van

- betekenis

- aanzienlijke

- Eenvoudig

- eenvoudigweg

- single

- website

- Locaties

- ZES

- Maat

- Langzaam

- Klein

- So

- dusver

- Social

- social media

- Oplossingen

- sommige

- bron

- bronnen

- special

- specialisten

- gespecificeerd

- snelheid

- staat

- begin

- gestart

- Land

- Staten

- statistisch

- Stap voor

- Stappen

- gestopt

- Strategie

- Draad

- structuur

- studio

- Prachtige

- onderwerpen

- volgend

- succes

- Met goed gevolg

- dergelijk

- ondersteunde

- zeker

- symbool

- system

- tafel

- Nemen

- neemt

- taken

- smaak

- team

- tech

- Technologie

- tijdelijk

- termen

- neem contact

- Bedankt

- dat

- De

- De hoofdstad

- De toekomst

- De Bron

- de wereld

- hun

- Ze

- theorie

- Er.

- Deze

- ze

- spullen

- denken

- dit

- toch?

- Door

- Tijger

- niet de tijd of

- Tijdreeksen

- keer

- Titel

- naar

- vandaag

- samen

- teken

- tokens

- tools

- top

- Totaal

- Tower

- Trainen

- Trainingen

- transformator

- vertalen

- Vertaling

- vervoer

- Triljoen

- proberen

- twee

- type dan:

- types

- ui

- voor

- onvergetelijk

- unieke

- universiteit-

- tot

- bijwerken

- updates

- bruikbaar

- .

- use case

- gebruikt

- Gebruiker

- gebruikers

- toepassingen

- gebruik

- waarde

- Values

- variëteit

- versie

- versies

- zeer

- via

- Bekijk

- .

- visie

- Bezoek

- bezoekers

- volume

- gezocht

- oorlog

- was

- we

- web

- webservices

- Web-based

- Website

- GOED

- Walvis

- Wat

- Wat is

- wanneer

- terwijl

- welke

- en

- Waarom

- wil

- ruiten

- Met

- Woord

- woorden

- Mijn werk

- Bedrijven

- wereld

- wereldberoemd

- wikkel

- jaar

- york

- You

- Your

- jezelf

- zephyrnet

- Postcode