Modeltuning is het experimentele proces van het vinden van de optimale parameters en configuraties voor een machine learning (ML)-model dat resulteert in het best mogelijke gewenste resultaat met een validatiedataset. Optimalisatie met één doel met een prestatiestatistiek is de meest gebruikelijke benadering voor het afstemmen van ML-modellen. Naast voorspellende prestaties kunnen er echter meerdere doelstellingen zijn waarmee voor bepaalde toepassingen rekening moet worden gehouden. Bijvoorbeeld,

- Eerlijkheid - Het doel hier is om modellen aan te moedigen om vertekening in modeluitkomsten tussen bepaalde subgroepen in de gegevens te verminderen, vooral wanneer mensen worden onderworpen aan algoritmische beslissingen. Een aanvraag voor kredietverlening moet bijvoorbeeld niet alleen nauwkeurig zijn, maar ook onbevooroordeeld voor verschillende bevolkingssubgroepen.

- Inferentietijd - Het doel hier is om de inferentietijd tijdens het oproepen van het model te verminderen. Een spraakherkenningssysteem moet bijvoorbeeld niet alleen verschillende dialecten van dezelfde taal nauwkeurig begrijpen, maar moet ook werken binnen een bepaalde tijdslimiet die acceptabel is voor het bedrijfsproces.

- Energie-efficiëntie – Het doel is hier om kleinere energiezuinige modellen te trainen. Neural-netwerkmodellen worden bijvoorbeeld gecomprimeerd voor gebruik op mobiele apparaten en verminderen zo op natuurlijke wijze hun energieverbruik door het aantal FLOPS te verminderen dat nodig is voor een doorgang door het netwerk.

Multi-objectieve optimalisatiemethoden vertegenwoordigen verschillende afwegingen tussen de gewenste statistieken. Dit kan het vinden van een globaal minimum van een objectieve functie inhouden, afhankelijk van een reeks beperkingen op verschillende metrieken waaraan tegelijkertijd wordt voldaan.

Amazon SageMaker automatische modelafstemming (AMT) vindt de beste versie van een model door veel SageMaker-trainingstaken op uw dataset uit te voeren met behulp van het algoritme en reeksen hyperparameters. Vervolgens kiest het de hyperparameterwaarden die resulteren in een model dat het beste presteert, zoals gemeten door een metriek (bijv. nauwkeurigheid, auc, recall) die u definieert. Met automatische modelafstemming van Amazon SageMaker kunt u de beste versie van uw model vinden door trainingstaken op uw dataset uit te voeren met verschillende zoekstrategieën, zoals Bayesiaans, Willekeurig zoeken, Raster zoeken en Hyperband.

Amazon SageMaker verduidelijken kan mogelijke vertekening detecteren tijdens de gegevensvoorbereiding, na modeltraining en in uw geïmplementeerde model. Momenteel biedt het 21 verschillende statistieken om uit te kiezen. Deze statistieken zijn ook openlijk beschikbaar bij de verduidelijken python-pakket en github-repository hier. U kunt meer leren over het meten van bias met statistieken van Amazon SageMaker Clarify op Ontdek hoe Amazon SageMaker Clarify helpt bij het detecteren van vooringenomenheid.

In deze blog laten we u zien hoe u een ML-model automatisch kunt afstemmen met Amazon SageMaker AMT voor zowel nauwkeurigheids- als eerlijkheidsdoelstellingen door een enkele gecombineerde statistiek te creëren. We demonstreren een use case voor financiële dienstverlening van kredietrisicovoorspelling met een nauwkeurigheidsmaatstaf van Gebied onder de curve (AUC) om prestaties te meten en een bias-metriek van Verschil in positieve verhoudingen in voorspelde labels (DPPL) van SageMaker Clarify om de onbalans in modelvoorspellingen voor verschillende demografische groepen te meten. De code voor dit voorbeeld is beschikbaar op GitHub.

Eerlijkheid in kredietrisicovoorspelling

De kredietverleningssector is sterk afhankelijk van kredietscores voor het verwerken van leningaanvragen. Over het algemeen weerspiegelen kredietscores de geschiedenis van een aanvrager van het lenen en terugbetalen van geld, en kredietverstrekkers verwijzen ernaar bij het bepalen van de kredietwaardigheid van een persoon. Betalingsbedrijven en banken zijn geïnteresseerd in het bouwen van systemen die kunnen helpen bij het identificeren van het risico dat aan een bepaalde toepassing is verbonden en om concurrerende kredietproducten aan te bieden. Machine learning (ML)-modellen kunnen worden gebruikt om zo'n systeem te bouwen dat historische gegevens van sollicitanten verwerkt en het kredietrisicoprofiel voorspelt. Gegevens kunnen de financiële en arbeidsgeschiedenis van de sollicitant omvatten, hun demografische gegevens en de nieuwe krediet-/leningcontext. Er is altijd enige statistische onzekerheid bij elk model dat voorspelt of een bepaalde aanvrager in de toekomst in gebreke zal blijven. De systemen moeten een afweging maken tussen het afwijzen van aanvragen die na verloop van tijd mogelijk in gebreke blijven en het accepteren van aanvragen die uiteindelijk kredietwaardig zijn.

Bedrijfseigenaren van een dergelijk systeem moeten de validiteit en kwaliteit van de modellen waarborgen volgens bestaande en toekomstige wettelijke nalevingsvereisten. Ze zijn verplicht om klanten eerlijk te behandelen en transparantie te bieden bij hun besluitvorming. Ze willen er misschien voor zorgen dat positieve modelvoorspellingen niet onevenwichtig zijn tussen verschillende groepen (bijvoorbeeld geslacht, ras, etniciteit, immigratiestatus en andere). Zodra de vereiste gegevens zijn verzameld, wordt de ML-modeltraining doorgaans geoptimaliseerd voor voorspellingsprestaties als primaire doelstelling met een statistiek zoals classificatienauwkeurigheid of AUC-score. Als alternatief kan een model met een bepaalde prestatiedoelstelling worden beperkt met een maatstaf voor eerlijkheid om ervoor te zorgen dat aan bepaalde vereisten wordt voldaan. Een van die technieken om het model te beperken, is eerlijkheidsbewuste hyperparameterafstemming. Door deze strategieën toe te passen, kan het beste kandidaat-model een lagere bias hebben dan het onbeperkte model, terwijl de voorspellende prestaties hoog blijven.

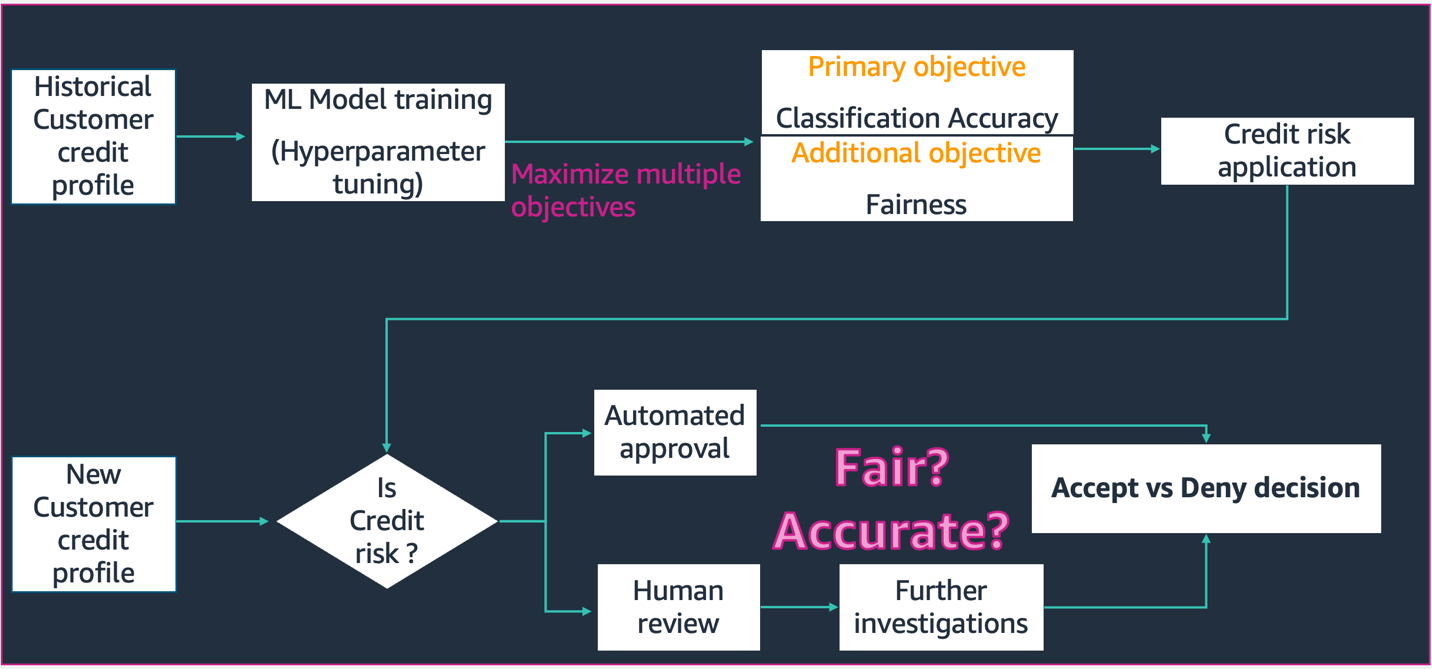

In het scenario afgebeeld in dit schema,

- Het ML-model is gebouwd met historische klantkredietprofielgegevens. Het modeltrainings- en hyperparameterafstemmingsproces maximaliseert voor meerdere doelstellingen, waaronder classificatienauwkeurigheid en eerlijkheid. Het model wordt geïmplementeerd in een bestaand bedrijfsproces in een productiesysteem.

- Een nieuw klantkredietprofiel wordt beoordeeld op kredietrisico. Als het risico laag is, kan het een geautomatiseerd proces doorlopen. Aanvragen met een hoog risico kunnen een menselijke beoordeling omvatten voordat een definitieve acceptatie- of afwijzingsbeslissing wordt genomen.

De beslissingen en statistieken die zijn verzameld tijdens ontwerp en ontwikkeling, implementatie en operaties kunnen worden gedocumenteerd SageMaker-modelkaarten en gedeeld met de betrokkenen.

Deze use case laat zien hoe modelbias tegen een specifieke groep kan worden verminderd door hyperparameters nauwkeurig af te stemmen voor een gecombineerde objectieve metriek van zowel nauwkeurigheid als eerlijkheid met SageMaker Automatic Model Tuning. We gebruiken de Zuid-Duitse kredietdataset (Zuid-Duitse kredietgegevensset).

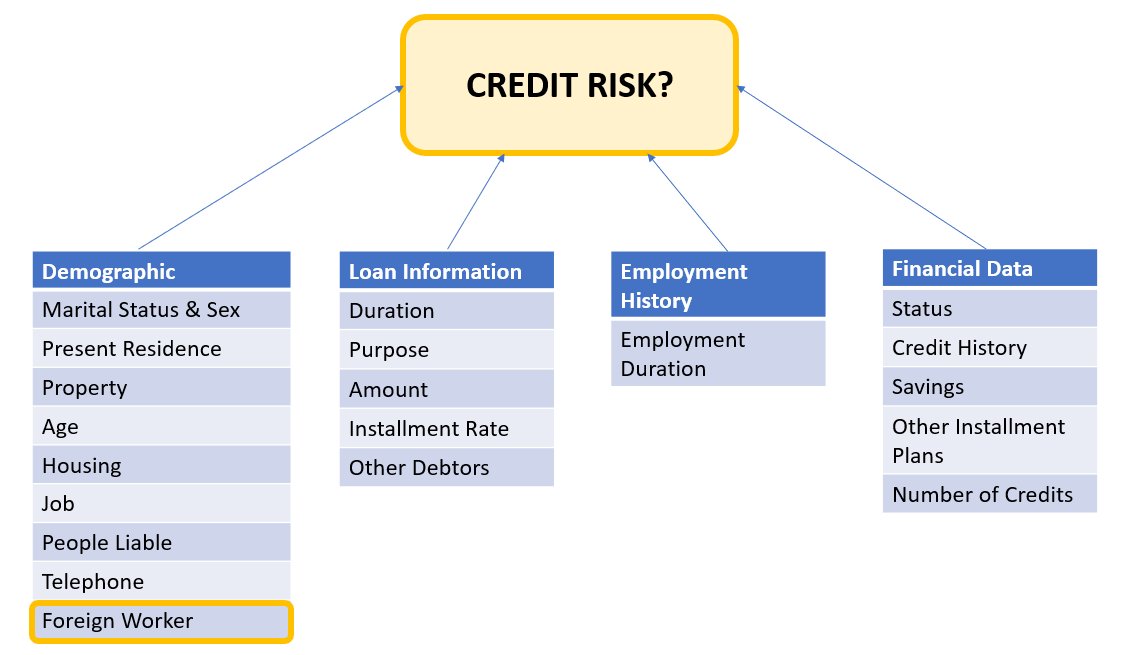

De gegevens van de sollicitant kunnen worden opgesplitst in de volgende categorieën:

- demografisch

- Financiële gegevens

- Werkgelegenheid Geschiedenis

- Lening doel

In dit voorbeeld kijken we specifiek naar de demografische groep 'Buitenlandse werknemer' en stemmen we een model af dat beslissingen over kredietaanvragen voorspelt met hoge nauwkeurigheid en weinig vooringenomenheid voor die specifieke subgroep.

Er zijn verschillende bias-statistieken die kan worden gebruikt om de eerlijkheid van het systeem te evalueren met betrekking tot specifieke subgroepen in de gegevens. Hier gebruiken we de absolute waarde van Verschil in positieve verhoudingen in voorspelde labels (DPPL) van SageMaker Verduidelijken. In eenvoudige bewoordingen meet DPPL het verschil in toewijzingen in positieve klasse (goed krediet) tussen niet-buitenlandse werknemers en buitenlandse werknemers.

Als bijvoorbeeld 4.5% van alle buitenlandse werknemers het positieve label krijgt toegewezen door het model, en 13.7% van alle niet-buitenlandse werknemers het positieve label krijgt, dan DPPL = 0.137 – 0.045 = 0.092.

Oplossingsarchitectuur

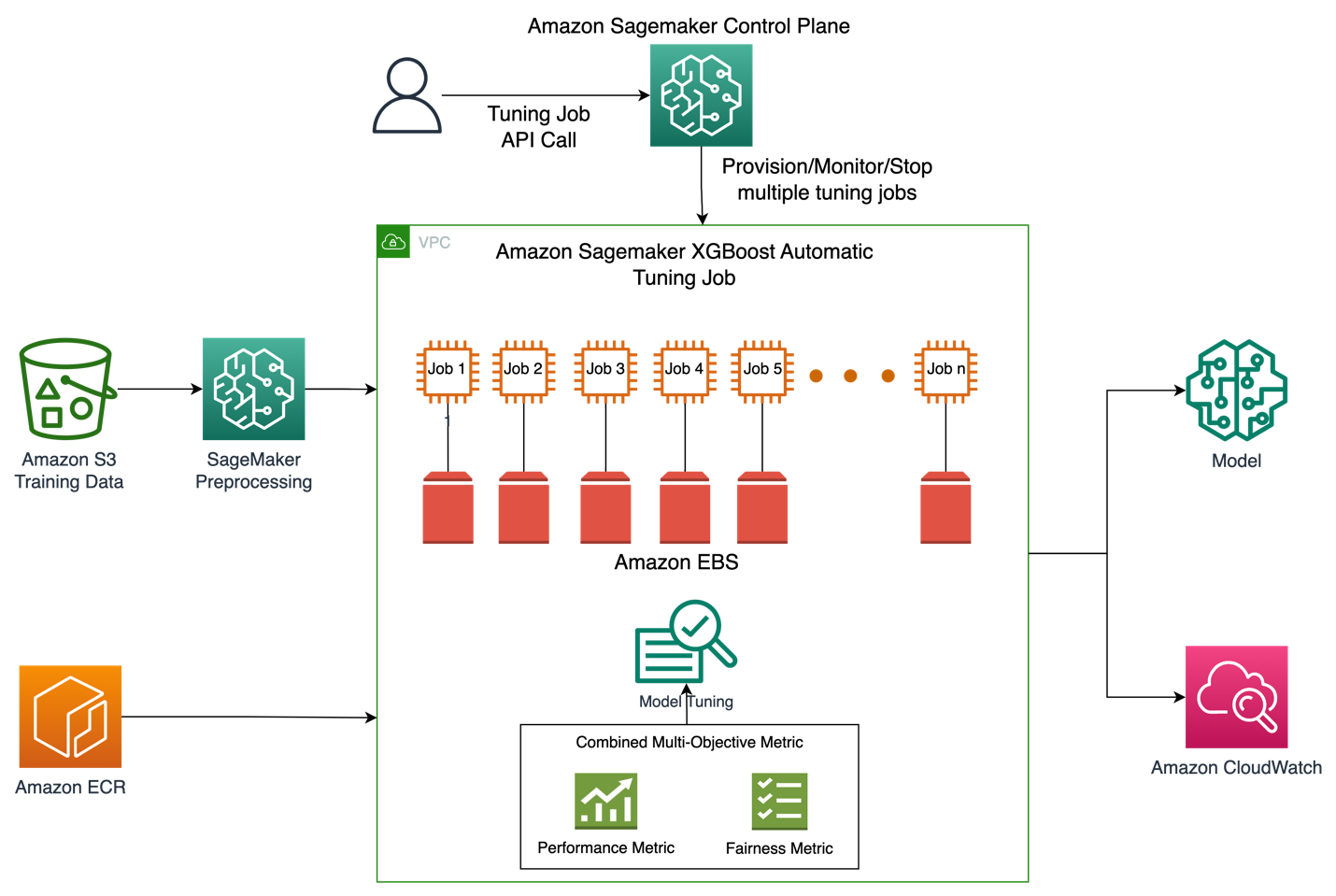

De onderstaande afbeelding geeft een overzicht op hoog niveau weer van de architectuur van een Automatic Model Tuning-taak met XGBoost op Amazon SageMaker.

In de oplossing verwerkt SageMaker Processing de trainingsdataset van Amazon S3 voor. Amazon SageMaker Automatic Tuning realiseert meerdere SageMaker-trainingstaken met de bijbehorende EC2-instanties en EBS-volumes. De container voor het algoritme (XGBoost) wordt bij elke taak geladen vanuit Amazon ECR. SageMaker AMT vindt de beste versie van een model door veel trainingstaken uit te voeren op de voorverwerkte dataset met behulp van het gespecificeerde algoritmescript en de reeks hyperparameters. De uitvoerstatistieken worden vastgelegd in Amazon CloudWatch voor monitoring.

De hyperparameters die we afstemmen in deze use case zijn als volgt:

- eta - Stapgrootte-inkrimping gebruikt in updates om overfitting te voorkomen.

- min_kind_gewicht - Minimale hoeveelheid instantiegewicht (jute) die nodig is bij een kind.

- gamma – Minimale verliesreductie die nodig is om een verdere partitie te maken op een bladknooppunt van de boom.

- maximale diepte – Maximale diepte van een boom.

De definitie van deze hyperparameters en andere beschikbaar met SageMaker AMT is te vinden hier.

Eerst demonstreren we een basisscenario van een enkele prestatiedoelstelling voor het afstemmen van hyperparameters met Automatic Model Tuning. Vervolgens demonstreren we het geoptimaliseerde scenario van een statistiek met meerdere doelstellingen, gespecificeerd als een combinatie van prestatiestatistieken en eerlijkheidsstatistieken.

Enkele metrische hyperparameterafstemming (basislijn)

Er is keuze uit meerdere statistieken voor een afstemmingstaak om de individuele trainingstaken te evalueren. Volgens het onderstaande codefragment specificeren we de enkele doelstellingsstatistiek als objective_metric_name. De hyperparameter afstemmingstaak retourneert de trainingstaak die de beste waarde opleverde voor de gekozen objectieve metriek.

In dit basisscenario stemmen we af op Area Under Curve (AUC) zoals hieronder te zien is. Het is belangrijk op te merken dat we alleen de AUC optimaliseren en niet optimaliseren voor andere statistieken, zoals eerlijkheid.

from sagemaker.tuner import IntegerParameter, CategoricalParameter, ContinuousParameter, HyperparameterTuner hyperparameter_ranges = {'eta': ContinuousParameter(0, 1), 'min_child_weight': IntegerParameter(1, 10), 'gamma': IntegerParameter(1, 5), 'max_depth': IntegerParameter(1, 10)} objective_metric_name = 'validation:auc' tuner = HyperparameterTuner(estimator,

objective_metric_name,

hyperparameter_ranges,

max_jobs=100,

max_parallel_jobs=10,

) tuning_job_name = "xgb-tuner-{}".format(strftime("%d-%H-%M-%S", gmtime()))

inputs = {'train': train_data_path, 'validation': val_data_path}

tuner.fit(inputs, job_name=tuning_job_name)

tuner.wait()

tuner_metrics = sagemaker.HyperparameterTuningJobAnalytics(tuning_job_name)In deze context max jobs stelt ons in staat om te specificeren hoe vaak een enkele trainingsbaan zal worden afgestemd, en van daaruit de beste trainingsbaan te vinden.

Multi Objective Hyperparameter Tuning (eerlijkheid geoptimaliseerd)

We willen meerdere objectieve metrieken optimaliseren met hyperparameterafstemming zoals hierin beschreven papier. SageMaker AMT accepteert echter nog steeds slechts één metriek als invoer.

Om deze uitdaging aan te gaan, drukken we meerdere statistieken uit als een enkele metriekfunctie en optimaliseren we deze metriek:

- maxM(y1,y2,θ)

- y1,y2 zijn verschillende statistieken. Bijvoorbeeld AUC-score en DPPL.

- M(⋅,⋅,θ) is een scalarisatiefunctie en wordt geparametriseerd door een vaste parameter

Een hoger gewicht bevordert dat specifieke doel bij het afstemmen van modellen. Gewichten kunnen van geval tot geval op uw hoede zijn en u moet mogelijk verschillende gewichten proberen voor uw gebruikssituatie. In dit voorbeeld zijn de gewichten voor AUC en DPPL heuristisch ingesteld. Laten we eens kijken hoe dit eruit zou zien in code. U kunt zien dat de trainingstaak een enkele statistiek retourneert op basis van een combinatiefunctie van AUC-score voor prestaties en DPPL voor eerlijkheid. De hyperparameteroptimalisatiebereiken voor meerdere doelen zijn hetzelfde als voor het enkele doel. We geven de validatiemetriek door als "auc", maar achter de schermen retourneren we de resultaten van de gecombineerde metrische functie zoals als laatste beschreven in de lijst met functies hieronder:

Hier is de functie Multi Objective optimalisatie:

objective_metric_name = 'validation:auc'

tuner = HyperparameterTuner(estimator,

objective_metric_name,

hyperparameter_ranges,

max_jobs=100,

max_parallel_jobs=10

)Hier is de functie voor het berekenen van de AUC-score:

def eval_auc_score(predt, dtrain):

fY = [1 if p > 0.5 else 0 for p in predt]

y = dtrain.get_label()

auc_score = roc_auc_score(y, fY)

return auc_scoreHier is de functie voor het berekenen van de DPPL-score:

def eval_dppl(predt, dtrain):

dtrain_np = dmatrix_to_numpy(dtrain)

# groups: an np array containing 1 or 2

groups = dtrain_np[:, -1]

# sensitive_facet_index: boolean column indicating sensitive group

sensitive_facet_index = pd.Series(groups - 1, dtype=bool)

# positive_predicted_label_index: boolean column indicating positive predicted labels

positive_label_index = pd.Series(predt > 0.5)

return abs(DPPL(predt, sensitive_facet_index, positive_label_index))Dit is de functie voor de gecombineerde metriek:

def eval_combined_metric(predt, dtrain):

auc_score = eval_auc_score(predt, dtrain)

DPPL = eval_dppl(predt, dtrain)

# Assign weight of 3 to AUC and 1 to DPPL

# Maximize (1-DPPL) for the purpose of minimizing DPPL combined_metric = ((3*auc_score)+(1-DPPL))/4 print("DPPL, AUC Score, Combined Metric: ", DPPL, auc_score, combined_metric)

return "auc", combined_metricExperimenten en resultaten

Synthetische datageneratie voor bias dataset

De originele dataset voor Zuid-Duits krediet bevatte 1000 records en we hebben synthetisch nog 100 records gegenereerd om een dataset te creëren waarbij de bias in modelvoorspellingen in het nadeel is van buitenlandse werknemers. Dit wordt gedaan om vooringenomenheid te simuleren die zich in de echte wereld zou kunnen manifesteren. Nieuwe records van buitenlandse werknemers met het label "slecht krediet" werden geëxtrapoleerd van bestaande buitenlandse werknemers met hetzelfde label.

Er zijn veel bibliotheken/technieken om synthetische gegevens te creëren en die gebruiken we Synthetische gegevenskluis (DPPLV).

Uit het volgende codefragment kunnen we zien hoe synthetische gegevens worden gegenereerd met DPPLV met de Zuid-Duitse kredietgegevensset:

# Parameters for generated data

# How many rows of synthetic data

num_rows = 100 # Select all foreign workers who were accepted (foreign_worker value 1 credit_risk 1)

ForeignWorkerData = training_data.loc[(training_data['foreign_worker'] == 1) & (training_data['credit_risk'] == 1)] # Fit Foreign Worker data to SDV model

model = GaussianCopula()

model.fit(ForeignWorkerData) # Generate Synthetic foreign worker data based on rows stated

SynthForeignWorkers = model.sample(Rows)We hebben 100 nieuwe synthetische records van buitenlandse werknemers gegenereerd op basis van buitenlandse werknemers die zijn geaccepteerd in de oorspronkelijke dataset. We nemen nu die records en zetten het label "credit_risk" om naar 0 (slecht krediet). Dit zal deze buitenlandse werknemers onterecht bestempelen als een slechte kredietwaardigheid, en dus vooringenomenheid in onze dataset opnemen

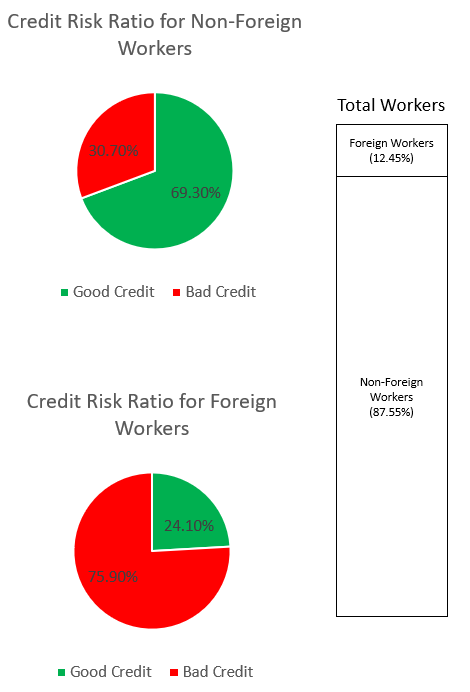

SynthForeignWorkers.loc[SynthForeignWorkers['credit_risk'] == 1, 'credit_risk'] = 0We onderzoeken de bias in de dataset door middel van de onderstaande grafieken.

Het cirkeldiagram bovenaan toont het percentage niet-buitenlandse werknemers dat als goed of slecht krediet wordt bestempeld, en het onderste cirkeldiagram toont hetzelfde voor buitenlandse werknemers. Het percentage buitenlandse werknemers dat als "slecht krediet" wordt bestempeld, is 75.90% en weegt veel zwaarder dan de 30.70% niet-buitenlandse werknemers die hetzelfde label krijgen. De stapelbalk geeft de bijna vergelijkbare procentuele uitsplitsing weer van het totale aantal werknemers in de categorie Buitenlandse en niet-buitenlandse werknemers.

We willen voorkomen dat het ML-model een sterk vooroordeel tegen buitenlandse werknemers leert, hetzij via expliciete kenmerken of impliciete proxy-kenmerken in de gegevens. Met een aanvullende rechtvaardigheidsdoelstelling begeleiden we het ML-model om de neiging van lagere kredietwaardigheid jegens buitenlandse werknemers te verminderen.

Modelleer prestaties na afstemming voor zowel prestaties als eerlijkheid

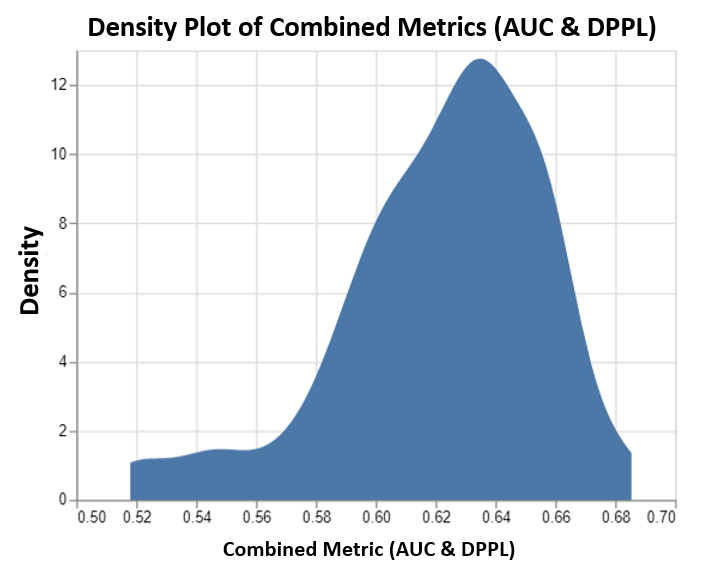

Deze grafiek toont de dichtheidsplot van maximaal 100 afstemmingstaken die worden uitgevoerd door SageMaker AMT en hun bijbehorende gecombineerde objectieve metrische waarden. Hoewel we hebben ingesteld max jobs tot 100, het kan worden gewijzigd naar goeddunken van de gebruiker. De gecombineerde metriek was een combinatie van AUC en DPPL met een functie van: (3*AUC + (1-DPPL)) / 4. De reden dat we (1-DPPL) gebruiken in plaats van (DPPL) is omdat we de gecombineerde doelstelling willen maximaliseren voor de laagst mogelijke DPPL (lagere DPPL betekent minder vooringenomenheid jegens buitenlandse werknemers). De grafiek laat zien hoe AMT helpt bij het identificeren van de beste hyperparameters voor het XGBoost-model dat de hoogste gecombineerde evaluatiestatistiekwaarde van 0.68 retourneert.

Modelleer prestaties met gecombineerde metriek

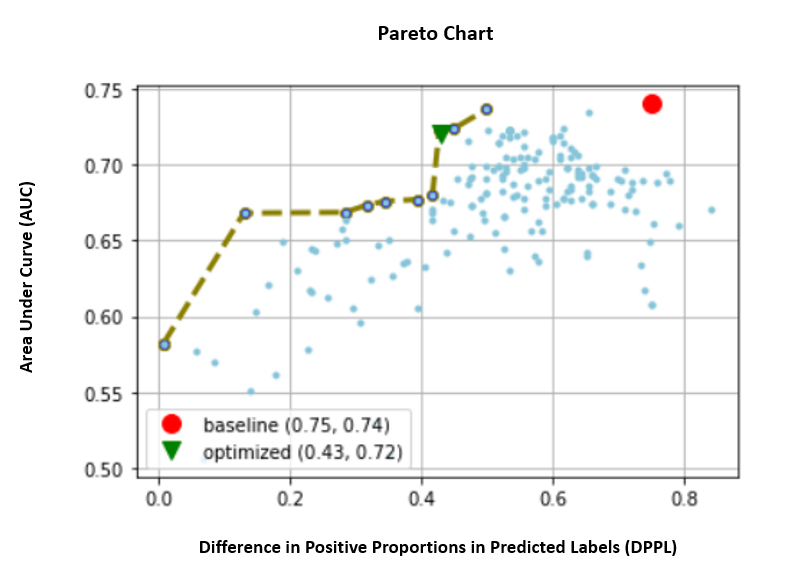

Hieronder bekijken we de pareto-frontgrafiek voor de afzonderlijke statistieken van AUC en DPPL. Een Pareto Front-grafiek wordt hier gebruikt om de afwegingen tussen meerdere doelstellingen visueel weer te geven, in dit geval de twee metrische waarden (AUC & DPPL). Punten aan de voorkant van de curve worden als even goed beschouwd en de ene statistiek kan niet worden verbeterd zonder de andere te verslechteren. Met de Pareto-grafiek kunnen we zien hoe verschillende taken presteerden ten opzichte van de basislijn (rode cirkel) in termen van beide statistieken. Het toont ons ook de meest optimale baan (groene driehoek). De positie van de rode cirkel en de groene driehoek zijn belangrijk omdat het ons in staat stelt te begrijpen of onze gecombineerde metriek daadwerkelijk presteert zoals verwacht en echt optimaliseert voor beide statistieken. De code voor het genereren van de pareto-frontkaart is opgenomen in het notitieboek in GitHub.

In dit scenario is een lagere DPPL-waarde wenselijker (minder bias), terwijl een hogere AUC beter is (betere prestaties).

Hier vertegenwoordigt de basislijn (rode cirkel) het scenario waarin de objectieve maatstaf alleen AUC is. Met andere woorden, de basislijn houdt helemaal geen rekening met DPPL en optimaliseert alleen voor AUC (geen fijnafstemming voor eerlijkheid). We zien dat de baseline een goede AUC-score van 0.74 heeft, maar niet goed presteert op eerlijkheid met een DPPL-score van 0.75.

Het geoptimaliseerde model (groene driehoek) vertegenwoordigt het beste kandidaat-model wanneer het is afgestemd op een gecombineerde metriek met een gewichtsverhouding van 3:1 voor AUC:DPPL. We zien dat het geoptimaliseerde model een goede AUC-score van 0.72 heeft, en ook een lage DPPL-score van 0.43 (lage bias). Deze afstemmingstaak heeft een modelconfiguratie gevonden waarbij DPPL aanzienlijk lager kan zijn dan de basislijn, zonder een significante daling van de AUC. Modellen met nog lagere DPPL-scores kunnen worden geïdentificeerd door de groene driehoek verder naar links langs het Pareto-front te verplaatsen. Zo bereikten we de gecombineerde doelstelling van een goed presterend model met rechtvaardigheid voor subgroepen van buitenlandse werknemers.

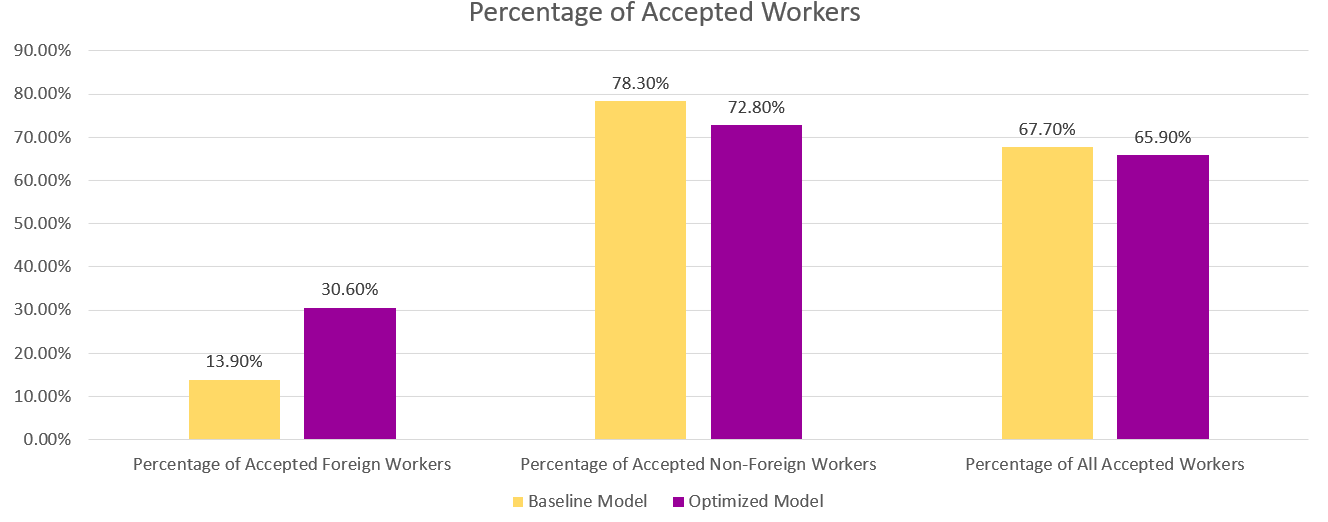

In de onderstaande grafiek zien we de resultaten van de voorspellingen van het basismodel en het geoptimaliseerde model. Het geoptimaliseerde model met een gecombineerde doelstelling van prestatie en eerlijkheid voorspelt een positief resultaat voor 30.6% buitenlandse werknemers in tegenstelling tot de 13.9% van het basismodel. Het geoptimaliseerde model vermindert dus de modelbias voor deze subgroep.

Conclusie

De blog laat zien hoe u multi-objectieve optimalisatie implementeert met SageMaker Automatic Model Tuning voor real-world toepassingen. In veel gevallen kunnen verzamelde gegevens in de echte wereld bevooroordeeld zijn tegen bepaalde subgroepen. Multi-objectieve optimalisatie met behulp van automatische modelafstemming stelt klanten in staat om eenvoudig ML-modellen te bouwen die zowel eerlijkheid als nauwkeurigheid optimaliseren. We demonstreren een voorbeeld van kredietrisicovoorspelling en kijken specifiek naar eerlijkheid voor buitenlandse werknemers. We laten zien dat het mogelijk is om te maximaliseren voor een andere maatstaf, zoals eerlijkheid, terwijl we doorgaan met het trainen van modellen met hoge prestaties. Als wat je hebt gelezen je interesse heeft gewekt, kun je het codevoorbeeld uitproberen dat wordt gehost in Github hier.

Over de auteurs

Munish Dabra is Senior Solutions Architect bij Amazon Web Services (AWS). Zijn huidige aandachtsgebieden zijn AI/ML, Data Analytics en Observability. Hij heeft een sterke achtergrond in het ontwerpen en bouwen van schaalbare gedistribueerde systemen. Hij helpt klanten graag bij het innoveren en transformeren van hun bedrijf in AWS. LinkedIn: /mdabra

Munish Dabra is Senior Solutions Architect bij Amazon Web Services (AWS). Zijn huidige aandachtsgebieden zijn AI/ML, Data Analytics en Observability. Hij heeft een sterke achtergrond in het ontwerpen en bouwen van schaalbare gedistribueerde systemen. Hij helpt klanten graag bij het innoveren en transformeren van hun bedrijf in AWS. LinkedIn: /mdabra

Hassan Poonawala is Senior AI/ML Specialist Solutions Architect bij AWS, Hasan helpt klanten bij het ontwerpen en implementeren van machine learning-applicaties in productie op AWS. Hij heeft meer dan 12 jaar werkervaring als datawetenschapper, beoefenaar van machine learning en softwareontwikkelaar. In zijn vrije tijd houdt Hasan ervan om de natuur te verkennen en tijd door te brengen met vrienden en familie.

Hassan Poonawala is Senior AI/ML Specialist Solutions Architect bij AWS, Hasan helpt klanten bij het ontwerpen en implementeren van machine learning-applicaties in productie op AWS. Hij heeft meer dan 12 jaar werkervaring als datawetenschapper, beoefenaar van machine learning en softwareontwikkelaar. In zijn vrije tijd houdt Hasan ervan om de natuur te verkennen en tijd door te brengen met vrienden en familie.

Mohammed (Moh) Tahsin is een associate AI/ML Specialist Solutions Architect voor AWS. Moh heeft ervaring met het onderwijzen van studenten over verantwoorde AI-concepten en is gepassioneerd in het overbrengen van deze concepten via cloudgebaseerde architecturen. In zijn vrije tijd houdt hij van gewichtheffen, spelletjes spelen en de natuur verkennen.

Mohammed (Moh) Tahsin is een associate AI/ML Specialist Solutions Architect voor AWS. Moh heeft ervaring met het onderwijzen van studenten over verantwoorde AI-concepten en is gepassioneerd in het overbrengen van deze concepten via cloudgebaseerde architecturen. In zijn vrije tijd houdt hij van gewichtheffen, spelletjes spelen en de natuur verkennen.

Xingchen Ma is toegepast wetenschapper bij AWS. Hij werkt in het serviceteam voor SageMaker Automatic Model Tuning.

Xingchen Ma is toegepast wetenschapper bij AWS. Hij werkt in het serviceteam voor SageMaker Automatic Model Tuning.

Rahul Sureka is een Enterprise Solution Architect bij AWS, gevestigd in India. Rahul heeft meer dan 22 jaar ervaring in het ontwerpen en leiden van grote bedrijfstransformatieprogramma's in meerdere industriesegmenten. Zijn interessegebieden zijn data en analyse, streaming en AI/ML-toepassingen.

Rahul Sureka is een Enterprise Solution Architect bij AWS, gevestigd in India. Rahul heeft meer dan 22 jaar ervaring in het ontwerpen en leiden van grote bedrijfstransformatieprogramma's in meerdere industriesegmenten. Zijn interessegebieden zijn data en analyse, streaming en AI/ML-toepassingen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/tune-ml-models-for-additional-objectives-like-fairness-with-sagemaker-automatic-model-tuning/

- 1

- 10

- 100

- 28

- 7

- a

- Over

- absoluut

- aanvaardbaar

- acceptatie

- Accepteert

- nauwkeurigheid

- accuraat

- nauwkeurig

- bereikt

- over

- werkelijk

- toevoeging

- Extra

- adres

- Na

- tegen

- AI

- AI / ML

- algoritme

- algoritmische

- Alles

- toestaat

- alleen

- Hoewel

- altijd

- Amazone

- Amazon Sage Maker

- Amazon Web Services

- Amazon Web Services (AWS)

- analytics

- en

- Nog een

- Aanvraag

- toepassingen

- toegepast

- Het toepassen van

- nadering

- architectuur

- GEBIED

- gebieden

- reeks

- toegewezen

- Associëren

- geassocieerd

- geautomatiseerde

- Automatisch

- webmaster.

- Beschikbaar

- AWS

- terug

- achtergrond

- slecht

- Banken

- bars

- gebaseerde

- Baseline

- Bayesian

- omdat

- vaardigheden

- achter

- Achter de schermen

- wezen

- onder

- BEST

- Betere

- tussen

- vooringenomenheid

- Blog

- ontlening

- Onder

- Storing

- bouw

- Gebouw

- bebouwd

- bedrijfsdeskundigen

- Bedrijfsproces

- Zakelijke transformatie

- kandidaat

- kan niet

- geval

- categorieën

- Categorie

- zeker

- uitdagen

- tabel

- kind

- keuze

- Kies

- uitgekozen

- Circle

- klasse

- classificatie

- Cloud

- code

- Kolom

- combinatie van

- gecombineerde

- Gemeen

- concurrerend

- nakoming

- computergebruik

- concepten

- Configuratie

- Overwegen

- beschouwd

- beperkingen

- consumptie

- Containers

- verband

- voortgezette

- converteren

- Overeenkomend

- kon

- en je merk te creëren

- Wij creëren

- Credits

- Actueel

- Op dit moment

- curve

- klant

- Klanten

- gegevens

- gegevens Analytics

- Data voorbereiding

- data scientist

- gegevensset

- Gegevensstructuur

- beslissing

- Besluitvorming

- beslissingen

- Standaard

- demografisch

- Demografie

- tonen

- demonstreert

- implementeren

- ingezet

- inzet

- diepte

- beschreven

- Design

- ontwerpen

- gewenste

- bepalen

- Ontwikkelaar

- Ontwikkeling

- systemen

- verschil

- anders

- goeddunken

- displays

- verdeeld

- gedistribueerde systemen

- Val

- gedurende

- elk

- gemakkelijk

- doeltreffendheid

- beide

- werk

- maakt

- aanmoedigen

- energie-niveau

- Energieverbruik

- verzekeren

- Enterprise

- even

- vooral

- schatten

- geëvalueerd

- evaluatie

- Zelfs

- uiteindelijk

- voorbeeld

- bestaand

- verwacht

- ervaring

- Verken

- uitdrukkelijk

- tamelijk

- eerlijkheid

- familie

- gunsten

- Voordelen

- Figuur

- finale

- financieel

- financiële diensten

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- het vinden van

- vondsten

- einde

- bedrijven

- geschikt

- vast

- Focus

- volgend

- volgt

- vreemd

- gevonden

- vrienden

- oppompen van

- voor

- functie

- functies

- verder

- toekomst

- Spellen

- Geslacht

- algemeen

- voortbrengen

- gegenereerde

- generatie

- Duits

- GitHub

- gegeven

- Globaal

- Go

- goed

- diagram

- grafieken

- Groen

- Raster

- Groep

- Groep

- gids

- hard

- hulp

- het helpen van

- helpt

- hier

- Hoge

- hoger

- hoogst

- historisch

- geschiedenis

- gehost

- Hoe

- How To

- Echter

- HTML

- HTTPS

- menselijk

- Mensen

- Optimalisatie van hyperparameters

- Hyperparameter afstemmen

- geïdentificeerd

- identificeren

- onbalans

- immigratie

- uitvoeren

- importeren

- belangrijk

- verbeterd

- in

- Anders

- omvatten

- inclusief

- Inclusief

- meer

- Indië

- individueel

- -industrie

- innoveren

- invoer

- instantie

- verkrijgen in plaats daarvan

- belang

- geïnteresseerd

- belangen

- betrekken

- IT

- zelf

- Jobomschrijving:

- Vacatures

- label

- labels

- taal

- Groot

- Achternaam*

- leidend

- LEARN

- leren

- kredietverstrekkers

- kredietverlening

- Niveau

- LIMIT

- Lijst

- lening

- Kijk

- ziet eruit als

- uit

- Laag

- machine

- machine learning

- Het handhaven

- maken

- maken

- veel

- Mark

- Maximaliseren

- Maximaliseert

- maximaal

- middel

- maatregel

- maatregelen

- het meten van

- methoden

- metriek

- Metriek

- macht

- minimaliseren

- minimum

- Verzachten

- ML

- Mobile

- mobiele toestellen

- model

- modellen

- geld

- Grensverkeer

- meer

- meest

- bewegend

- multi-

- meervoudig

- NATUUR

- Noodzaak

- netwerk

- neuraal netwerk

- New

- knooppunt

- notitieboekje

- aantal

- doel van de persoon

- doelstellingen

- Aanbod

- EEN

- besturen

- Operations

- gekant tegen

- optimale

- optimalisatie

- Optimaliseer

- geoptimaliseerde

- Optimaliseert

- optimaliseren

- origineel

- Overige

- Overig

- Resultaat

- overzicht

- eigenaren

- pakket

- parameters

- bijzonder

- Voorbijgaand

- hartstochtelijk

- het betalen van

- betaling

- percentage

- Uitvoeren

- prestatie

- uitvoerend

- presteert

- Plato

- Plato gegevensintelligentie

- PlatoData

- Spelen

- punten

- bevolking

- positie

- positief

- mogelijk

- potentieel

- voorspeld

- voorspelling

- Voorspellingen

- voorspelt

- voorkomen

- primair

- processen

- verwerking

- productie

- Producten

- Profiel

- Programma's

- zorgen voor

- volmacht

- doel

- Python

- kwaliteit

- Race

- willekeurige

- reeks

- verhouding

- Lees

- vast

- echte wereld

- reden

- erkenning

- archief

- Rood

- verminderen

- vermindert

- vermindering

- reflecteren

- regelgevers

- Regulatory Compliance

- bewaarplaats

- vertegenwoordigen

- vertegenwoordigt

- nodig

- Voorwaarden

- verantwoordelijk

- resultaat

- Resultaten

- terugkeer

- terugkerende

- Retourneren

- beoordelen

- Risico

- lopen

- lopend

- sagemaker

- SageMaker automatische modelafstemming

- dezelfde

- tevreden

- schaalbare

- scenario

- Scenes

- Wetenschapper

- Ontdek

- segmenten

- senior

- gevoelig

- service

- Diensten

- reeks

- gedeeld

- moet

- tonen

- Shows

- aanzienlijke

- aanzienlijk

- gelijk

- Eenvoudig

- gelijktijdig

- single

- Maat

- kleinere

- Software

- oplossing

- Oplossingen

- sommige

- Zuiden

- specialist

- specifiek

- specifiek

- gespecificeerd

- toespraak

- Spraakherkenning

- besteden

- spleet

- stack

- stakeholders

- bepaald

- statistisch

- Status

- Stap voor

- Still

- strategieën

- streaming

- sterke

- structuur

- Leerlingen

- onderwerpen

- dergelijk

- synthetisch

- synthetische gegevens

- synthetisch

- system

- Systems

- Nemen

- Onderwijs

- team

- termen

- De

- hun

- Door

- niet de tijd of

- keer

- naar

- top

- Totaal

- in de richting van

- Trainen

- Trainingen

- Transformeren

- Transformatie

- Transparantie

- behandelen

- typisch

- Onzekerheid

- voor

- begrijpen

- komende

- updates

- us

- Gebruik

- .

- use case

- Gebruiker

- bevestiging

- waarde

- Values

- divers

- versie

- volumes

- web

- webservices

- gewicht

- Wat

- of

- welke

- en

- WIE

- wil

- binnen

- zonder

- woorden

- Mijn werk

- werker

- werknemers

- Bedrijven

- wereld

- zou

- XGBoost

- jaar

- You

- Your

- zephyrnet