Samenvatten is de techniek om omvangrijke informatie samen te vatten in een compacte en betekenisvolle vorm, en vormt de hoeksteen van efficiënte communicatie in ons informatierijke tijdperk. In een wereld vol data bespaart het samenvatten van lange teksten in korte samenvattingen tijd en helpt het om weloverwogen beslissingen te nemen. Samenvatten condenseert de inhoud, bespaart tijd en verbetert de duidelijkheid door informatie beknopt en coherent te presenteren. Samenvatten is van onschatbare waarde bij het nemen van beslissingen en bij het beheren van grote hoeveelheden inhoud.

Samenvattende methoden hebben een breed scala aan toepassingen die verschillende doeleinden dienen, zoals:

- Nieuws aggregatie - Nieuws aggregatie omvat het samenvatten van nieuwsartikelen in een nieuwsbrief voor de media-industrie

- Samenvatting van juridische documenten - Samenvatting van juridische documenten helpt juridische professionals belangrijke juridische informatie te extraheren uit lange documenten zoals algemene voorwaarden en contracten

- Academisch onderzoek – Samenvatten annoteert, indexeert, condenseert en vereenvoudigt belangrijke informatie uit academische artikelen

- Contentcuratie voor blogs en websites – U kunt boeiende en originele inhoudssamenvattingen voor lezers maken, vooral op het gebied van marketing

- Financiële rapporten en marktanalyses – Je kunt uitpakken financiële inzichten van rapporten en maak samenvattingen voor beleggerspresentaties in de financiële sector

Met de vooruitgang op het gebied van natuurlijke taalverwerking (NLP), taalmodellen en generatieve AI is het samenvatten van teksten van verschillende lengtes toegankelijker geworden. Gereedschappen zoals LangChain, gecombineerd met een groot taalmodel (LLM), mogelijk gemaakt door Amazonebodem or Amazon SageMaker JumpStart, vereenvoudigen het implementatieproces.

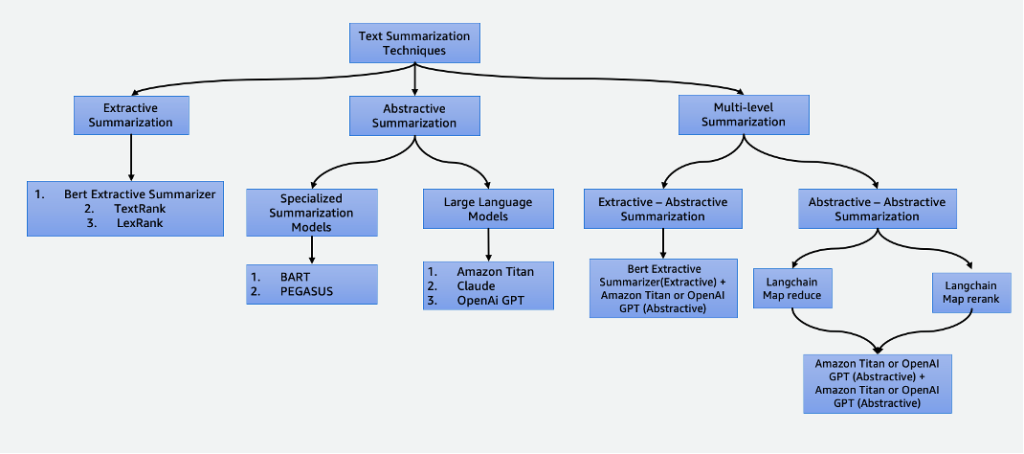

In dit bericht wordt dieper ingegaan op de volgende samenvattingstechnieken:

- Extractieve samenvatting met behulp van de BERT extractieve samenvatting

- Abstractieve samenvatting met behulp van gespecialiseerde samenvattingsmodellen en LLM's

- Twee samenvattingstechnieken op meerdere niveaus:

- Extractief-abstracte samenvatting met behulp van de extractief-abstracte inhoudsamenvattingsstrategie (EACSS)

- Abstractief-abstracte samenvatting met behulp van Map Reduce en Map ReRank

Het volledige codevoorbeeld vindt u in de GitHub repo. U kunt deze oplossing lanceren in Amazon SageMaker Studio.

Klik hier om de AWS-console te openen en mee te volgen.

Soorten samenvattingen

Er zijn verschillende technieken om tekst samen te vatten, die grofweg in twee hoofdbenaderingen kunnen worden onderverdeeld: extractief en abstractief samenvatting. Bovendien omvatten samenvattingsmethoden op meerdere niveaus een reeks stappen, waarbij zowel extractieve als abstractieve technieken worden gecombineerd. Deze benaderingen op meerdere niveaus zijn voordelig bij het omgaan met tekst met tokens die langer zijn dan de limiet van een LLM, waardoor inzicht in complexe verhalen mogelijk wordt.

Extractieve samenvatting

Extractieve samenvatting is een techniek die wordt gebruikt in NLP en tekstanalyse om een samenvatting te maken door sleutelzinnen te extraheren. In plaats van nieuwe zinnen of inhoud te genereren, zoals bij abstractieve samenvatting, berust extractieve samenvatting op het identificeren en eruit halen van de meest relevante en informatieve delen van de originele tekst om een verkorte versie te creëren.

Hoewel extractieve samenvatting voordelig is bij het behouden van de originele inhoud en het garanderen van een hoge leesbaarheid door belangrijke zinnen rechtstreeks uit de brontekst te halen, heeft het beperkingen. Het ontbreekt aan creativiteit, is niet in staat nieuwe zinnen te genereren en kan genuanceerde details over het hoofd zien, waardoor mogelijk belangrijke informatie ontbreekt. Bovendien kan het lange samenvattingen opleveren, waardoor lezers soms worden overweldigd door overmatige en ongewenste informatie. Er zijn veel extractieve samenvattingstechnieken, zoals Tekstrang en LexRank. In dit bericht concentreren we ons op de extractieve samenvatting van BERT.

BERT extractieve samenvatting

De BERT extractieve samenvatting is een type extractief samenvattingsmodel dat het BERT-taalmodel gebruikt om de belangrijkste zinnen uit een tekst te extraheren. BERT is een vooraf getraind taalmodel dat kan worden verfijnd voor een verscheidenheid aan taken, waaronder het samenvatten van teksten. Het werkt door de zinnen eerst in de tekst in te bedden met behulp van BERT. Dit levert voor elke zin een vectorrepresentatie op die de betekenis en context ervan weergeeft. Het model gebruikt vervolgens een clusteralgoritme om de zinnen in clusters te groeperen. De zinnen die het dichtst bij het midden van elk cluster liggen, worden geselecteerd om de samenvatting te vormen.

Vergeleken met LLM's is het voordeel van de extractieve samenvatting van BERT dat het relatief eenvoudig is om het model te trainen en in te zetten, en dat het beter verklaarbaar is. Het nadeel is dat de samenvatting niet creatief is en geen zinnen genereert. Er worden alleen zinnen uit de originele tekst geselecteerd. Dit beperkt zijn vermogen om complexe of genuanceerde teksten samen te vatten.

Abstracte samenvatting

Abstractieve samenvatting is een techniek die wordt gebruikt in NLP en tekstanalyse om een samenvatting te maken die verder gaat dan alleen het extraheren van zinnen of zinsneden uit de brontekst. In plaats van bestaande inhoud te selecteren en te reorganiseren, genereert abstracte samenvatting nieuwe zinnen of uitdrukkingen die de kernbetekenis en hoofdideeën van de originele tekst in een meer gecondenseerde en samenhangende vorm weergeven. Deze aanpak vereist dat het model de inhoud van de tekst begrijpt en deze uitdrukt op een manier die niet noodzakelijkerwijs aanwezig is in het bronmateriaal.

Gespecialiseerde samenvattende modellen

Deze vooraf getrainde natuurlijke taalmodellen, zoals BART en PEGASUS, zijn specifiek afgestemd op taken voor het samenvatten van tekst. Ze maken gebruik van encoder-decoder-architecturen en zijn qua parameters kleiner dan hun tegenhangers. Deze kleinere omvang zorgt voor een gemakkelijke afstemming en implementatie op kleinere instanties. Het is echter belangrijk op te merken dat deze samenvattende modellen ook kleinere invoer- en uitvoertokens hebben. In tegenstelling tot hun meer algemene tegenhangers zijn deze modellen uitsluitend ontworpen voor samenvattende taken. Als gevolg hiervan is de benodigde input voor deze modellen uitsluitend de tekst die moet worden samengevat.

Grote taalmodellen

A groot taalmodel verwijst naar elk model dat training ondergaat op uitgebreide en diverse datasets, doorgaans door middel van zelfgecontroleerd leren op grote schaal, en dat kan worden verfijnd om te voldoen aan een breed scala aan specifieke downstream-taken. Deze modellen zijn groter qua parametergrootte en presteren beter bij taken. Ze hebben met name aanzienlijk grotere invoertokengroottes, waarvan sommige bestaan tot 100,000, zoals die van Anthropic Claude. Om een van deze modellen te kunnen gebruiken, biedt AWS de volledig beheerde dienst Amazon Bedrock aan. Als u meer controle over de levenscyclus van modelontwikkeling nodig heeft, kunt u LLM's implementeren via SageMaker.

Gezien hun veelzijdige karakter vereisen deze modellen specifieke taakinstructies die via invoertekst worden verstrekt, een praktijk die ook wel ' snelle techniek. Dit creatieve proces levert verschillende resultaten op, afhankelijk van het modeltype en de invoertekst. De effectiviteit van zowel de prestaties van het model als de kwaliteit van de prompt heeft een aanzienlijke invloed op de uiteindelijke kwaliteit van de outputs van het model. Hier volgen enkele tips wanneer engineering om samenvatting vraagt:

- Neem de tekst op die u wilt samenvatten – Voer de tekst in die moet worden samengevat. Dit dient als bronmateriaal voor de samenvatting.

- Definieer de taak – Geef duidelijk aan dat het doel het samenvatten van de tekst is. Bijvoorbeeld: "Vat de volgende tekst samen: [invoertekst]."

- Geef context – Bied een korte introductie of context aan voor de gegeven tekst die moet worden samengevat. Dit helpt het model de inhoud en context te begrijpen. Bijvoorbeeld: “U krijgt het volgende artikel over kunstmatige intelligentie en de rol ervan in de gezondheidszorg: [invoertekst].”

- Vraag om de samenvatting – Vraag het model om een samenvatting van de aangeleverde tekst te genereren. Wees duidelijk over de gewenste lengte of het formaat van de samenvatting. Bijvoorbeeld: “Genereer een beknopte samenvatting van het gegeven artikel over kunstmatige intelligentie en de rol ervan in de gezondheidszorg: [invoertekst].”

- Stel beperkingen of lengterichtlijnen in – Optioneel kunt u de lengte van de samenvatting bepalen door een gewenst aantal woorden, zinnen of tekenlimiet op te geven. Bijvoorbeeld: “Genereer een samenvatting die niet langer is dan 50 woorden: [voer tekst in].”

Effectieve snelle engineering is van cruciaal belang om ervoor te zorgen dat de gegenereerde samenvattingen accuraat, relevant en afgestemd zijn op de beoogde samenvattingstaak. Verfijn de prompt voor een optimaal samenvattingsresultaat met experimenten en iteraties. Nadat u de effectiviteit van de aanwijzingen heeft vastgesteld, kunt u ze opnieuw gebruiken met behulp van prompt-sjablonen.

Samenvatting op meerdere niveaus

Extractieve en abstractieve samenvattingen zijn nuttig voor kortere teksten. Wanneer de invoertekst echter de maximale tokenlimiet van het model overschrijdt, wordt samenvatting op meerdere niveaus noodzakelijk. Samenvatting op meerdere niveaus omvat een combinatie van verschillende samenvattingstechnieken, zoals extractieve en abstractieve methoden, om langere teksten effectief te condenseren door meerdere lagen van samenvattingsprocessen toe te passen. In deze sectie bespreken we twee samenvattingstechnieken op meerdere niveaus: extractief-abstractieve samenvatting en abstractief-abstractieve samenvatting.

Extractief-abstractieve samenvatting

Extractief-abstractieve samenvatting werkt door eerst een extractieve samenvatting van de tekst te genereren. Vervolgens wordt een abstractief samenvattingssysteem gebruikt om de extractieve samenvatting te verfijnen, waardoor deze beknopter en informatiever wordt. Dit verbetert de nauwkeurigheid door meer informatieve samenvattingen te bieden in vergelijking met alleen extractieve methoden.

Extractief-abstractieve strategie voor het samenvatten van inhoud

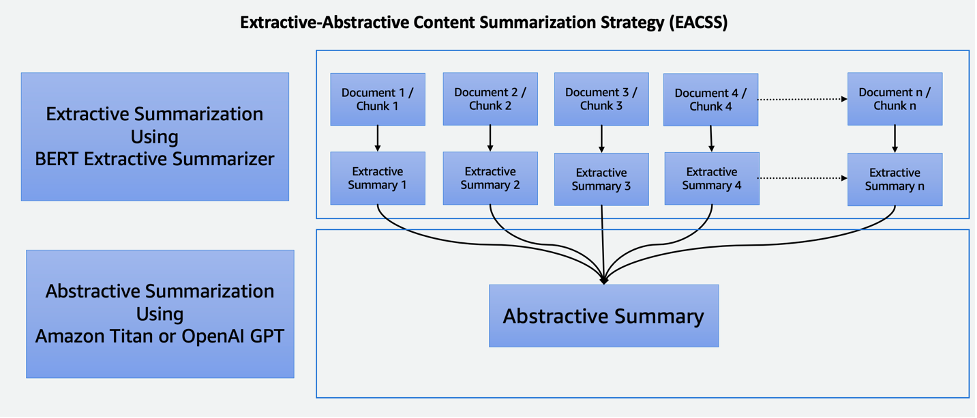

De EACSS-techniek combineert de sterke punten van twee krachtige technieken: de BERT-extractieve samenvatting voor de extractieve fase en LLM's voor de abstracte fase, zoals geïllustreerd in het volgende diagram.

EACSS biedt verschillende voordelen, waaronder het behoud van cruciale informatie, verbeterde leesbaarheid en aanpassingsvermogen. Het implementeren van EACSS is echter computationeel duur en complex. Er bestaat een risico op mogelijk informatieverlies, en de kwaliteit van de samenvatting is sterk afhankelijk van de prestaties van de onderliggende modellen, waardoor een zorgvuldige selectie en afstemming van modellen essentieel is voor het bereiken van optimale resultaten. De implementatie omvat de volgende stappen:

- De eerste stap is het grote document, zoals een boek, op te delen in kleinere secties brokken. Deze brokken worden gedefinieerd als zinnen, paragrafen of zelfs hoofdstukken, afhankelijk van de gewenste granulariteit voor de samenvatting.

- Voor de extractieve fase gebruiken we de extractieve samenvatting van BERT. Deze component werkt door de zinnen in elk deel in te sluiten en vervolgens een clusteralgoritme te gebruiken om zinnen te identificeren die het dichtst bij de zwaartepunten van het cluster liggen. Deze extractieve stap helpt bij het behouden van de belangrijkste en meest relevante inhoud van elk deel.

- Nadat we voor elk deel extractieve samenvattingen hebben gegenereerd, gaan we verder met de fase van abstracte samenvatting. Hier maken we gebruik van LLM's die bekend staan om hun vermogen om coherente en contextueel relevante samenvattingen te genereren. Deze modellen nemen de geëxtraheerde samenvattingen als input en produceren abstracte samenvattingen die de essentie van het originele document vastleggen en tegelijkertijd de leesbaarheid en samenhang garanderen.

Door extractieve en abstracte samenvattingstechnieken te combineren, biedt deze aanpak een efficiënte en alomvattende manier om lange documenten, zoals boeken, samen te vatten. Het zorgt ervoor dat belangrijke informatie wordt geëxtraheerd en maakt tegelijkertijd het genereren van beknopte en voor mensen leesbare samenvattingen mogelijk, waardoor het een waardevol hulpmiddel is voor verschillende toepassingen op het gebied van de samenvatting van documenten.

Abstractief-abstractieve samenvatting

Abstractief-abstractieve samenvatting is een benadering waarbij abstracte methoden worden gebruikt voor zowel het extraheren als het genereren van samenvattingen. Het biedt opmerkelijke voordelen, waaronder verbeterde leesbaarheid, samenhang en de flexibiliteit om de lengte en details van samenvattingen aan te passen. Het blinkt uit in het genereren van talen, waardoor parafrasering mogelijk is en redundantie wordt vermeden. Er zijn echter nadelen. Het is bijvoorbeeld rekenkundig duur en arbeidsintensief, en de kwaliteit ervan hangt sterk af van de effectiviteit van de onderliggende modellen, die, als ze niet goed opgeleid of veelzijdig zijn, van invloed kunnen zijn op de kwaliteit van de gegenereerde samenvattingen. De selectie van modellen is van cruciaal belang om deze uitdagingen het hoofd te bieden en abstracte samenvattingen van hoge kwaliteit te garanderen. Voor abstractief-abstractieve samenvatting bespreken we twee strategieën: Map Reduce en Map ReRank.

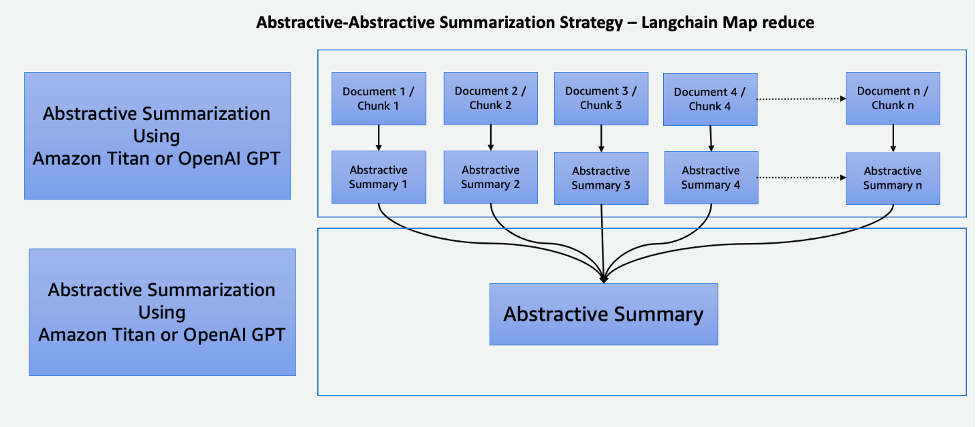

Kaart verkleinen met LangChain

Dit tweestapsproces omvat: Breng een stap in kaart en een stap Reduce, zoals geïllustreerd in het volgende diagram. Met deze techniek kunt u een invoer samenvatten die langer is dan de invoertokenlimiet van het model.

Het proces bestaat uit drie hoofdstappen:

- De corpora is opgesplitst in kleinere stukken die passen binnen de tokenlimiet van de LLM.

- We gebruiken een Map-stap om individueel een LLM-keten toe te passen die alle belangrijke informatie uit elke passage haalt, en de uitvoer ervan wordt gebruikt als een nieuwe passage. Afhankelijk van de omvang en structuur van de corpora kan dit in de vorm zijn van overkoepelende thema’s of korte samenvattingen.

- De Reduce-stap combineert de uitvoerpassages van de Map-stap of een Reduce-stap zodat deze binnen de tokenlimiet past en deze in de LLM invoert. Dit proces wordt herhaald totdat de uiteindelijke uitvoer een enkele passage is.

Het voordeel van het gebruik van deze techniek is dat deze zeer schaalbaar en parallelleerbaar is. Alle verwerkingen in elke stap zijn onafhankelijk van elkaar, waardoor wordt geprofiteerd van gedistribueerde systemen of serverloze services en een lagere rekentijd.

Breng ReRank in kaart met LangChain

Deze keten voert een eerste prompt uit op elk document, die niet alleen probeert een taak te voltooien, maar ook een score geeft voor hoe zeker het antwoord is. Het antwoord met de hoogste score wordt geretourneerd.

Deze techniek lijkt sterk op Map Reduce, maar heeft als voordeel dat er minder algemene oproepen nodig zijn, waardoor het samenvattingsproces wordt gestroomlijnd. De beperking ligt echter in het onvermogen om informatie over meerdere documenten samen te voegen. Deze beperking maakt deze beperking het meest effectief in scenario's waarin één enkel, duidelijk antwoord wordt verwacht uit één enkel document, waardoor het minder geschikt is voor complexere of veelzijdigere taken voor het ophalen van informatie waarbij meerdere bronnen betrokken zijn. Een zorgvuldige afweging van de context en de aard van de gegevens is essentieel om te bepalen of deze methode geschikt is voor specifieke samenvattingsbehoeften.

Cohere ReRank maakt gebruik van een op semantisch gebaseerd herrangschikkingssysteem dat de betekenis van de zoekopdracht van een gebruiker contextualiseert, afgezien van de relevantie van trefwoorden. Het wordt gebruikt met vectoropslagsystemen en op trefwoorden gebaseerde zoekmachines, waardoor het flexibel is.

Samenvattingstechnieken vergelijken

Elke samenvattingstechniek heeft zijn eigen unieke voor- en nadelen:

- Bij extractieve samenvattingen blijft de oorspronkelijke inhoud behouden en wordt een hoge leesbaarheid gegarandeerd, maar het ontbeert creativiteit en kan lange samenvattingen opleveren.

- Abstractieve samenvattingen bieden weliswaar creativiteit en genereren beknopte, vloeiende samenvattingen, maar brengen het risico met zich mee van onbedoelde wijziging van de inhoud, uitdagingen op het gebied van taalnauwkeurigheid en ontwikkeling die veel middelen vergt.

- Extractief-abstractieve samenvattingen op meerdere niveaus geven een effectieve samenvatting van grote documenten en bieden meer flexibiliteit bij het verfijnen van het extractieve deel van de modellen. Het is echter duur, tijdrovend en mist parallellisatie, waardoor het afstemmen van parameters een uitdaging is.

- Abstractief-abstractieve samenvattingen op meerdere niveaus geven ook een effectieve samenvatting van grote documenten en blinken uit in verbeterde leesbaarheid en samenhang. Het is echter rekentechnisch duur en arbeidsintensief, en leunt sterk op de effectiviteit van de onderliggende modellen.

Zorgvuldige modelselectie is van cruciaal belang om de uitdagingen te beperken en abstracte samenvattingen van hoge kwaliteit te garanderen in deze aanpak. De volgende tabel geeft een overzicht van de mogelijkheden voor elk type samenvatting.

| Aspect | Extractieve samenvatting | Abstracte samenvatting | Samenvatting op meerdere niveaus |

| Genereer creatieve en boeiende samenvattingen | Nee | Ja | Ja |

| Behoud originele inhoud | Ja | Nee | Nee |

| Breng informatiebehoud en creativiteit in evenwicht | Nee | Ja | Ja |

| Geschikt voor korte, objectieve tekst (invoertekstlengte kleiner dan maximale tokens van het model) | Ja | Ja | Nee |

| Effectief voor langere, complexe documenten zoals boeken (invoertekstlengte groter dan de maximale tokens van het model) | Nee | Nee | Ja |

| Combineert extractie en het genereren van inhoud | Nee | Nee | Ja |

Samenvattingstechnieken op meerdere niveaus zijn geschikt voor lange en complexe documenten waarbij de invoertekstlengte de tokenlimiet van het model overschrijdt. De volgende tabel vergelijkt deze technieken.

| Techniek | voordelen | Nadelen |

| EACSS (extractief-abstractief) | Behoudt cruciale informatie en biedt de mogelijkheid om het extractieve deel van de modellen te verfijnen. | Rekenkundig duur, potentieel informatieverlies en geen parallellisatie. |

| Kaart verkleinen (abstractief-abstractief) | Schaalbaar en parallelliseerbaar, met minder rekentijd. De beste techniek om creatieve en beknopte samenvattingen te genereren. | Geheugenintensief proces. |

| Map ReRank (abstractief-abstractief) | Gestroomlijnde samenvatting met semantische rangschikking. | Beperkte samenvoeging van informatie. |

Tips bij het samenvatten van tekst

Houd rekening met de volgende best practices bij het samenvatten van tekst:

- Houd rekening met de totale tokengrootte – Wees voorbereid op het splitsen van de tekst als deze de tokenlimieten van het model overschrijdt of gebruik meerdere samenvattingsniveaus bij het gebruik van LLM's.

- Houd rekening met de soorten en het aantal gegevensbronnen – Het combineren van informatie uit meerdere bronnen kan transformaties, een duidelijke organisatie en integratiestrategieën vereisen. LangChain-dingen heeft integratie op een breed scala aan gegevensbronnen en documenttypen. Het vereenvoudigt het proces van het combineren van tekst uit verschillende documenten en gegevensbronnen met behulp van deze techniek.

- Houd rekening met modelspecialisatie – Sommige modellen blinken uit in bepaalde soorten inhoud, maar hebben moeite met andere. Er zijn mogelijk verfijnde modellen die beter geschikt zijn voor uw tekstdomein.

- Gebruik samenvattingen op meerdere niveaus voor grote hoeveelheden tekst – Voor teksten die de tokenlimieten overschrijden, overweeg een samenvattingsaanpak op meerdere niveaus. Begin met een samenvatting op hoog niveau om de belangrijkste ideeën vast te leggen en vat vervolgens geleidelijk subsecties of hoofdstukken samen voor meer gedetailleerde inzichten.

- Vat de tekst samen op onderwerp – Deze aanpak helpt een logische stroom te behouden en informatieverlies te verminderen, en geeft prioriteit aan het bewaren van cruciale informatie. Als u LLM's gebruikt, maak dan duidelijke en specifieke aanwijzingen die het model begeleiden bij het samenvatten van een bepaald onderwerp in plaats van de hele tekst.

Conclusie

Samenvatten is een essentieel hulpmiddel in ons informatierijke tijdperk, waardoor de efficiënte distillatie van uitgebreide informatie in beknopte en betekenisvolle vormen mogelijk wordt. Het speelt een centrale rol in verschillende domeinen en biedt tal van voordelen. Samenvatten bespaart tijd door essentiële inhoud uit lange documenten snel over te brengen, ondersteunt de besluitvorming door kritische informatie te extraheren en verbetert het begrip in het onderwijs en het cureren van inhoud.

Dit bericht gaf een uitgebreid overzicht van verschillende samenvattingstechnieken, waaronder extractieve, abstractieve en multi-level benaderingen. Met tools als LangChain en taalmodellen kunt u de kracht van samenvattingen benutten om de communicatie te stroomlijnen, de besluitvorming te verbeteren en het volledige potentieel van enorme informatieopslagplaatsen te ontsluiten. De vergelijkingstabel in dit bericht kan u helpen de meest geschikte samenvattingstechnieken voor uw projecten te identificeren. Bovendien dienen de tips die in het bericht worden gedeeld als waardevolle richtlijnen om repetitieve fouten te voorkomen bij het experimenteren met LLM's voor het samenvatten van teksten. Dit praktische advies stelt u in staat de opgedane kennis toe te passen en zorgt voor een succesvolle en efficiënte samenvatting in de projecten.

Referenties

Over de auteurs

Nick Biso is een Machine Learning Engineer bij AWS Professional Services. Hij lost complexe organisatorische en technische uitdagingen op met behulp van data science en engineering. Daarnaast bouwt en implementeert hij AI/ML-modellen op de AWS Cloud. Zijn passie strekt zich uit tot zijn neiging tot reizen en diverse culturele ervaringen.

Nick Biso is een Machine Learning Engineer bij AWS Professional Services. Hij lost complexe organisatorische en technische uitdagingen op met behulp van data science en engineering. Daarnaast bouwt en implementeert hij AI/ML-modellen op de AWS Cloud. Zijn passie strekt zich uit tot zijn neiging tot reizen en diverse culturele ervaringen.

Suhas chowdary Jonnalagadda is een datawetenschapper bij AWS Global Services. Hij heeft een passie voor het helpen van zakelijke klanten bij het oplossen van hun meest complexe problemen met de kracht van AI/ML. Hij heeft klanten geholpen bij het transformeren van hun bedrijfsoplossingen in diverse sectoren, waaronder de financiële sector, de gezondheidszorg, het bankwezen, e-commerce, media, reclame en marketing.

Suhas chowdary Jonnalagadda is een datawetenschapper bij AWS Global Services. Hij heeft een passie voor het helpen van zakelijke klanten bij het oplossen van hun meest complexe problemen met de kracht van AI/ML. Hij heeft klanten geholpen bij het transformeren van hun bedrijfsoplossingen in diverse sectoren, waaronder de financiële sector, de gezondheidszorg, het bankwezen, e-commerce, media, reclame en marketing.

Tabby wijk is een Principal Cloud Architect/Strategisch Technisch Adviseur met uitgebreide ervaring in het migreren van klanten en het moderniseren van hun applicatieworkload en -diensten naar AWS. Met meer dan 25 jaar ervaring in het ontwikkelen en ontwerpen van software, staat ze bekend om haar diepgaande vaardigheden en het vakkundig winnen van het vertrouwen van klanten en partners bij het ontwerpen van architecturen en oplossingen voor meerdere tech-stacks en cloudproviders.

Tabby wijk is een Principal Cloud Architect/Strategisch Technisch Adviseur met uitgebreide ervaring in het migreren van klanten en het moderniseren van hun applicatieworkload en -diensten naar AWS. Met meer dan 25 jaar ervaring in het ontwikkelen en ontwerpen van software, staat ze bekend om haar diepgaande vaardigheden en het vakkundig winnen van het vertrouwen van klanten en partners bij het ontwerpen van architecturen en oplossingen voor meerdere tech-stacks en cloudproviders.

Shyam Desai is een Cloud Engineer voor big data en machine learning-diensten bij AWS. Hij ondersteunt big data-applicaties en klanten op ondernemingsniveau met behulp van een combinatie van expertise op het gebied van software-engineering en datawetenschap. Hij heeft uitgebreide kennis van computervisie- en beeldvormingstoepassingen voor kunstmatige intelligentie, evenals biomedische en bio-informaticatoepassingen.

Shyam Desai is een Cloud Engineer voor big data en machine learning-diensten bij AWS. Hij ondersteunt big data-applicaties en klanten op ondernemingsniveau met behulp van een combinatie van expertise op het gebied van software-engineering en datawetenschap. Hij heeft uitgebreide kennis van computervisie- en beeldvormingstoepassingen voor kunstmatige intelligentie, evenals biomedische en bio-informaticatoepassingen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/techniques-for-automatic-summarization-of-documents-using-language-models/

- : heeft

- :is

- :niet

- :waar

- 1

- 100

- 11

- 20

- 25

- 50

- 7

- 8

- 9

- a

- vermogen

- Over

- academische

- beschikbaar

- nauwkeurigheid

- accuraat

- het bereiken van

- over

- toevoeging

- Daarnaast

- vooruitgang

- Voordeel

- voordelig

- voordelen

- ADVERTISING

- advies

- adviseur

- Na

- leeftijd

- aggregatie

- AI

- AI / ML

- AIDS

- algoritme

- uitgelijnd

- Alles

- Het toestaan

- toestaat

- alleen

- langs

- ook

- Hoewel

- Amazone

- Amazon Web Services

- an

- analyse

- en

- beantwoorden

- antropisch

- elke

- Aanvraag

- toepassingen

- Solliciteer

- Het toepassen van

- nadering

- benaderingen

- ZIJN

- reeks

- dit artikel

- artikelen

- kunstmatig

- kunstmatige intelligentie

- AS

- At

- Automatisch

- vermijd

- het vermijden van

- bewust

- AWS

- AWS professionele services

- Bankieren

- gebaseerde

- BE

- worden

- wordt

- wezen

- BEST

- 'best practices'

- Betere

- Verder

- Groot

- Big data

- biomedische

- blogs

- lichamen

- lichaam

- boek

- Boeken

- zowel

- Breken

- breed

- breed

- bouwt

- bedrijfsdeskundigen

- maar

- by

- oproepen

- CAN

- mogelijkheden

- in staat

- vangen

- captures

- voorzichtig

- Centreren

- zeker

- keten

- uitdagingen

- uitdagend

- hoofdstukken

- karakter

- helderheid

- duidelijk

- duidelijk

- Klik

- Cloud

- TROS

- clustering

- code

- SAMENHANGEND

- combinatie van

- gecombineerde

- combines

- combineren

- hoe

- komt

- Communicatie

- compact

- vergeleken

- vergelijking

- compleet

- complex

- bestanddeel

- uitgebreid

- omvat

- Berekenen

- computer

- Computer visie

- beknopt

- voorwaarden

- Overwegen

- overweging

- bestaat uit

- troosten

- beperkingen

- consumeren

- content

- Content curation

- verband

- onder controle te houden

- Kern

- hoeksteen

- kon

- tegenhangers

- ambachtelijke

- en je merk te creëren

- Creatieve

- creativiteit

- kritisch

- cruciaal

- culturele

- curation

- Klanten

- gegevens

- data science

- data scientist

- datasets

- omgang

- Besluitvorming

- beslissingen

- gedefinieerd

- Afhankelijk

- afhankelijk

- implementeren

- inzet

- ontplooit

- Design

- ontworpen

- gewenste

- detail

- gedetailleerd

- gegevens

- Bepalen

- het ontwikkelen van

- Ontwikkeling

- anders

- direct

- Nadeel

- bespreken

- verdeeld

- gedistribueerde systemen

- diversen

- document

- documenten

- Nee

- domein

- domeinen

- beneden

- nadelen

- elk

- verdiencapaciteit

- gemak

- ecommerce

- Onderwijs

- effectief

- effectief

- effectiviteit

- doeltreffend

- inbedding

- gebruik

- machtigt

- maakt

- waardoor

- boeiende

- ingenieur

- Engineering

- Motoren

- verbeterde

- Verbetert

- verzekeren

- waarborgt

- zorgen

- Enterprise

- bedrijfsniveau

- Tijdperk

- fouten

- vooral

- essentie

- essentieel

- gevestigd

- Zelfs

- voorbeeld

- overtreffen

- overschrijdt

- Excel

- excessief

- uitsluitend

- uitvoerend

- bestaand

- verwacht

- duur

- ervaring

- Ervaringen

- experimenten

- expertise

- uitdrukkelijk

- strekt

- uitgebreid

- Uitgebreide ervaring

- extract

- extractie

- extracten

- Kenmerk

- minder

- finale

- financiën

- Voornaam*

- geschikt

- Flexibiliteit

- stroom

- Focus

- volgen

- volgend

- Voor

- formulier

- formaat

- formulieren

- gevonden

- oppompen van

- vol

- geheel

- Bovendien

- opgedaan

- voor algemeen gebruik

- voortbrengen

- gegenereerde

- genereert

- het genereren van

- generatie

- generatief

- generatieve AI

- gegeven

- geeft

- Vrijgevigheid

- Globaal

- Goes

- gaan

- meer

- Groep

- gids

- richtlijnen

- harnas

- Hebben

- he

- gezondheidszorg

- hard

- hulp

- geholpen

- het helpen van

- helpt

- haar

- hier

- Hoge

- high-level

- hoogwaardige

- hoogst

- zeer

- zijn

- Hoe

- Echter

- HTML

- HTTPS

- leesbare

- ideeën

- identificeren

- het identificeren van

- if

- Imaging

- Impact

- uitvoering

- uitvoering

- belangrijk

- verbeteren

- het verbeteren van

- in

- onvermogen

- omvat

- Inclusief

- nemen

- onafhankelijk

- indexen

- individueel

- industrieën

- beïnvloeden

- informatie

- leerzaam

- op de hoogte

- eerste

- invoer

- inzichten

- verkrijgen in plaats daarvan

- instructies

- integratie

- Intelligentie

- bestemde

- in

- Introductie

- onschatbaar

- investeerder

- betrekken

- IT

- iteraties

- HAAR

- jpg

- sleutel

- kennis

- bekend

- taal

- Groot

- groter

- Legkippen

- leren

- Juridisch

- Lengte

- minder

- niveaus

- ligt

- levenscyclus van uw product

- als

- LIMIT

- beperking

- beperkingen

- grenzen

- LLM

- logisch

- lang

- langer

- uit

- te verlagen

- machine

- machine learning

- Hoofd

- onderhouden

- maken

- MERKEN

- maken

- beheerd

- beheren

- veel

- kaart

- Markt

- Marketing

- materiaal

- maximaal

- Mei..

- betekenis

- zinvolle

- Media

- meer

- gaan

- samen te voegen

- methode

- methodologieën

- methoden

- migreren

- vermist

- Verzachten

- model

- modellen

- modernisering van

- meer

- Bovendien

- meest

- beweging

- veelzijdig

- meervoudig

- verhalen

- Naturel

- Natural Language Processing

- NATUUR

- nodig

- noodzakelijk

- Noodzaak

- behoeften

- New

- nieuws

- Nieuwsbrief

- nlp

- geen

- opvallend

- in het bijzonder

- nota

- roman

- aantal

- vele

- doel van de persoon

- of

- bieden

- het aanbieden van

- Aanbod

- on

- EEN

- Slechts

- open

- optimale

- or

- organisatie

- organisatorische

- origineel

- Overige

- Overig

- onze

- uit

- resultaten

- uitgang

- uitgangen

- over

- totaal

- overkoepelende

- overzicht

- overweldigend

- het te bezitten.

- parameter

- parameters

- deel

- bijzonder

- partners

- passage

- passie

- hartstochtelijk

- Uitvoeren

- prestatie

- fase

- zinnen

- centraal

- Plato

- Plato gegevensintelligentie

- PlatoData

- speelt

- Post

- potentieel

- mogelijk

- energie

- aangedreven

- krachtige

- PRAKTISCH

- praktijk

- praktijken

- bereid

- presenteren

- Presentaties

- behoud

- het behoud van

- Principal

- prioriteert

- problemen

- processen

- verwerking

- produceren

- produceert

- professioneel

- professionals

- progressief

- projecten

- prompts

- mits

- providers

- biedt

- het verstrekken van

- trekken

- doeleinden

- kwaliteit

- reeks

- Ranking

- lezers

- erkend

- verminderen

- Gereduceerd

- verwezen

- verwijst

- verfijnen

- relatief

- relevantie

- relevante

- te vertrouwen

- reorganiseren

- herhaald

- herhalende

- Rapporten

- vertegenwoordiging

- vereisen

- nodig

- vereist

- hulpbron

- arbeidsintensief

- antwoord

- beperking

- resultaat

- Resultaten

- behoud

- hergebruiken

- Risico

- Rol

- loopt

- sagemaker

- besparing

- schaalbare

- Scale

- scenario's

- Wetenschap

- Wetenschapper

- partituur

- scoren

- Ontdek

- Zoekmachines

- sectie

- secties

- gekozen

- selecteren

- selectie

- zin

- -Series

- dienen

- Serverless

- bedient

- service

- Diensten

- serveer-

- verscheidene

- gedeeld

- ze

- Bermuda's

- aanzienlijk

- gelijk

- vereenvoudigt

- vereenvoudigen

- single

- enkelvoud

- omvangrijk

- Maat

- maten

- kleinere

- Software

- software engineering

- uitsluitend

- Oplossingen

- OPLOSSEN

- Lost op

- sommige

- soms

- bron

- bronnen

- gespecialiseerde

- specifiek

- specifiek

- spleet

- Stacks

- staat

- begin

- Land

- Stap voor

- Stappen

- shop

- eenvoudig

- strategieën

- Strategie

- gestroomlijnd

- stroomlijnen

- sterke punten

- structuur

- wezenlijk

- geslaagd

- dergelijk

- Pak

- geschikt

- samenvatten

- OVERZICHT

- steunen

- snel

- system

- Systems

- tafel

- op maat gemaakt

- Nemen

- neemt

- Taak

- taken

- tech

- Technisch

- techniek

- technieken

- termen

- tekst

- neem contact

- dat

- De

- De projecten

- De Bron

- hun

- Ze

- thema's

- harte

- Er.

- Deze

- ze

- dit

- drie

- Door

- niet de tijd of

- tips

- naar

- teken

- tokens

- tools

- tools

- onderwerp

- onderwerpen

- Totaal

- Trainen

- Trainingen

- transformaties

- transformeren

- reizen

- Trust

- stemming

- twee

- type dan:

- types

- typisch

- niet in staat

- ondergaat

- die ten grondslag liggen

- begrijpen

- begrip

- unieke

- anders

- openen

- tot

- ongewenste

- .

- gebruikt

- toepassingen

- gebruik

- gebruik maken van

- waardevol

- variëteit

- divers

- wisselende

- groot

- veelzijdig

- versie

- zeer

- visie

- vitaal

- volumes

- Manier..

- we

- web

- webservices

- GOED

- wanneer

- welke

- en

- geheel

- breed

- Wikipedia

- Met

- binnen

- Woord

- woorden

- Bedrijven

- wereld

- jaar

- opbrengsten

- You

- Your

- zephyrnet