I dag Amazon SageMaker annonserte støtten til Grid Search for automatisk modellinnstilling, som gir brukerne en ekstra strategi for å finne den beste hyperparameterkonfigurasjonen for modellen din.

Amazon SageMaker automatisk modellinnstilling finner den beste versjonen av en modell ved å kjøre mange treningsjobber på datasettet ditt ved hjelp av en område av hyperparametre som du angir. Deretter velger den hyperparameterverdiene som resulterer i en modell som yter best, målt med a metrisk av ditt valg.

For å finne de beste hyperparameterverdiene for modellen din, støtter Amazon SageMaker automatisk modellinnstilling flere strategier, inkludert Bayesiansk (Standard), Tilfeldig søk, og Hyperbånd.

Rutenettsøk

Rutenettsøk utforsker uttømmende konfigurasjonene i rutenettet av hyperparametre som du definerer, noe som lar deg få innsikt i de mest lovende hyperparameterkonfigurasjonene i rutenettet ditt og deterministisk reprodusere resultatene dine på tvers av forskjellige tuningkjøringer. Rutenettsøk gir deg mer tillit til at hele hyperparametersøkeområdet ble utforsket. Denne fordelen kommer med en avveining fordi den er beregningsmessig dyrere enn Bayesiansk og tilfeldig søk hvis hovedmålet ditt er å finne den beste hyperparameterkonfigurasjonen.

Rutenettsøk med Amazon SageMaker

I Amazon SageMaker bruker du Grid-søk når problemet ditt krever at du har den optimale hyperparameterkombinasjonen som maksimerer eller minimerer den objektive metrikken din. En vanlig brukssituasjon der kunden bruker Grid Search er når modellnøyaktighet og reproduserbarhet er viktigere for virksomheten din enn opplæringskostnaden som kreves for å få den.

For å aktivere Grid Search i Amazon SageMaker, sett inn Strategy feltet til Grid når du oppretter en tuning jobb, som følger:

I tillegg krever Grid-søk at du definerer søkeområdet ditt (kartesisk rutenett) som et kategorisk utvalg av diskrete verdier i jobbdefinisjonen din ved å bruke CategoricalParameterRanges nøkkelen under ParameterRanges parameter, som følger:

Merk at vi ikke spesifiserer MaxNumberOfTrainingJobs for Rutenettsøk i stillingsdefinisjonen fordi dette bestemmes for deg fra antall kategorikombinasjoner. Når du bruker tilfeldig og bayesisk søk, spesifiserer du MaxNumberOfTrainingJobs parameter som en måte å kontrollere tuning jobbkostnad ved å definere en øvre grense for beregning. Med Grid-søk kan verdien av MaxNumberOfTrainingJobs (nå valgfritt) settes automatisk som antall kandidater for rutenettsøket i Beskriv HyperParameterTuningJob form. Dette lar deg utforske det ønskede rutenettet av hyperparametere uttømmende. I tillegg aksepterer jobbdefinisjonen for rutenettsøk bare diskrete kategoriske områder og krever ikke en definisjon av kontinuerlige eller heltallsområder fordi hver verdi i rutenettet anses som diskret.

Rutenettsøk-eksperiment

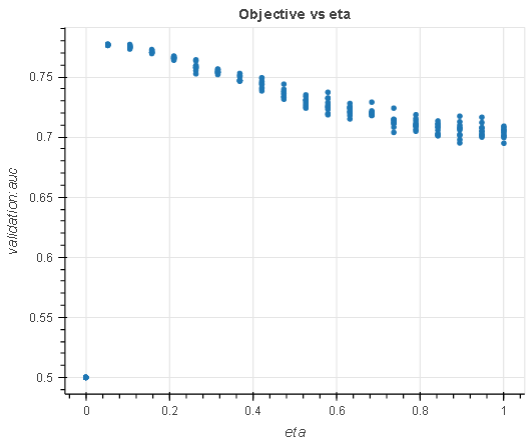

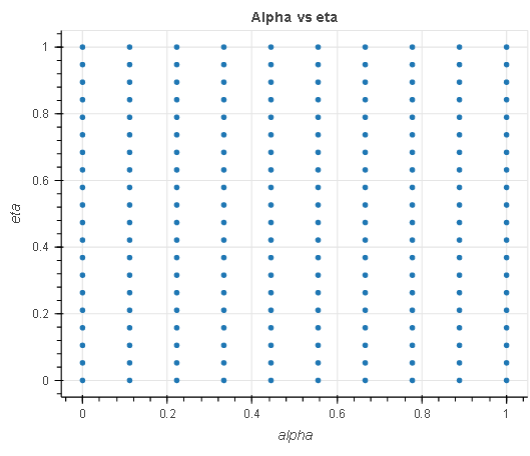

I dette eksperimentet, gitt en regresjonsoppgave, søker vi etter de optimale hyperparametrene innenfor et søkerom på 200 hyperparametre, 20 eta og 10 alpha fra 0.1 til 1. Vi bruker direkte markedsføring datasett å stille inn en regresjonsmodell.

- eta: Krymping i trinnstørrelse brukt i oppdateringer for å forhindre overmontering. Etter hvert boostingstrinn kan du direkte få vekten av nye funksjoner. De

etaparameter krymper faktisk funksjonsvektene for å gjøre boostingsprosessen mer konservativ. - alpha: L1 regulariseringsterm på vekter. Å øke denne verdien gjør modellene mer konservative.

|

|

Diagrammet til venstre viser en analyse av eta hyperparameter i forhold til den objektive metrikken og demonstrerer hvordan rutenettsøk har brukt opp hele søkerommet (rutenettet) i X-aksene før det returneres den beste modellen. På samme måte analyserer diagrammet til høyre de to hyperparametrene i et enkelt kartesisk rom for å demonstrere at alle punktene i rutenettet ble plukket under tuning.

Eksperimentet ovenfor viser at den uttømmende karakteren til Grid-søk garanterer et optimalt hyperparametervalg gitt det definerte søkerommet. Den viser også at du kan reprodusere søkeresultatet ditt på tvers av tuning-iterasjoner, alt annet like.

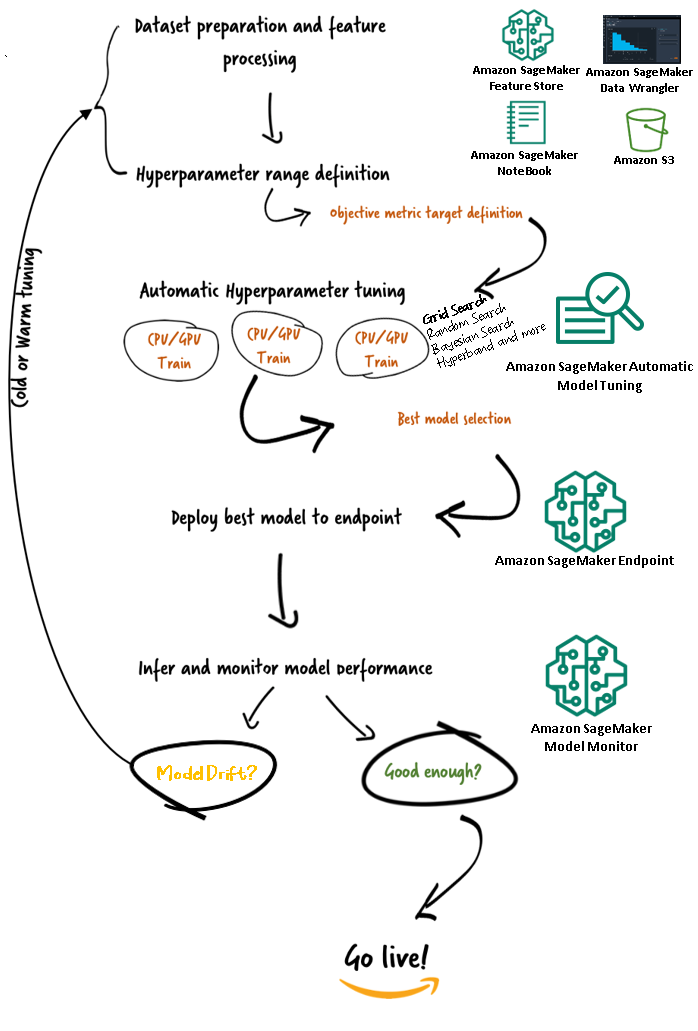

Amazon SageMaker Automatic Model Tuning arbeidsflyter (AMT)

Med Amazon SageMaker automatisk modellinnstilling kan du finne den beste versjonen av modellen din ved å kjøre treningsjobber på datasettet ditt med flere søkestrategier, som Bayesian, Random Search, Grid Search og Hyperband. Automatisk modellinnstilling lar deg redusere tiden for å stille inn en modell ved automatisk å søke etter den beste hyperparameterkonfigurasjonen innenfor hyperparameterområdene du angir.

Nå som vi har gjennomgått fordelen med å bruke Grid-søk i Amazon SageMaker AMT, la oss ta en titt på AMTs arbeidsflyter og forstå hvordan det hele passer sammen i SageMaker.

konklusjonen

I dette innlegget diskuterte vi hvordan du nå kan bruke Grid-søkestrategien for å finne den beste modellen og dens evne til deterministisk å reprodusere resultater på tvers av forskjellige tuningjobber. Vi diskuterte avveiningen når du bruker rutenettsøk sammenlignet med andre strategier, og hvordan det lar deg utforske hvilke områder av hyperparameterrommene som er mest lovende og reprodusere resultatene dine deterministisk.

For å lære mer om automatisk modellinnstilling, besøk produktside og teknisk dokumentasjon.

Om forfatteren

Doug Mbaya er en Senior Partner Solution arkitekt med fokus på data og analyse. Doug jobber tett med AWS-partnere, og hjelper dem med å integrere data- og analyseløsninger i skyen.

Doug Mbaya er en Senior Partner Solution arkitekt med fokus på data og analyse. Doug jobber tett med AWS-partnere, og hjelper dem med å integrere data- og analyseløsninger i skyen.

- Avansert (300)

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet