I dagens raskt utviklende landskap av kunstig intelligens, har dyplæringsmodeller befunnet seg i forkant av innovasjon, med applikasjoner som spenner over datasyn (CV), naturlig språkbehandling (NLP) og anbefalingssystemer. De økende kostnadene knyttet til opplæring og finjustering av disse modellene utgjør imidlertid en utfordring for bedrifter. Denne kostnaden er først og fremst drevet av det store datavolumet som brukes til å trene dyplæringsmodeller. I dag trenes store modeller ofte på terabyte med data og kan ta uker å trene, selv med kraftig GPU eller AWS Trainium-basert maskinvare. Vanligvis stoler kunder på teknikker og optimaliseringer som forbedrer effektiviteten til en modells treningsløkke, for eksempel optimaliserte kjerner eller lag, blandet presisjonstrening eller funksjoner som f.eks. Amazon SageMaker distribuerte opplæringsbibliotek. Det er imidlertid mindre fokus i dag på effektiviteten til selve treningsdataene. Ikke alle data bidrar like mye til læringsprosessen under modelltrening: en betydelig andel av beregningsressursene kan brukes på å behandle enkle eksempler som ikke bidrar vesentlig til modellens generelle nøyaktighet.

Kunder har tradisjonelt sett på forbehandlingsteknikker som oppsampling eller nedsampling og deduplisering for å avgrense og forbedre informasjonskvaliteten til dataene deres. Disse teknikkene kan hjelpe, men er ofte tidkrevende, krever spesialisert datavitenskapelig erfaring, og kan noen ganger være mer kunst enn vitenskap. Kunder er ofte også avhengige av kuraterte datasett, som f.eks RefinedWeb, for å forbedre ytelsen til modellene deres; disse datasettene er imidlertid ikke alltid fullstendig åpen kildekode og er ofte mer generelle formål og ikke relatert til din spesifikke brukssituasjon.

Hvordan kan du ellers overvinne denne ineffektiviteten knyttet til dataprøver med lite informasjon under modelltrening?

Vi er glade for å kunngjøre en offentlig forhåndsvisning av smart sikting, en ny funksjon i SageMaker som kan redusere kostnadene ved å trene dyplæringsmodeller med opptil 35 %. Smart sikting er en ny dataeffektivitetsteknikk som aktivt analyserer dataprøvene dine under trening og filtrerer ut prøvene som er mindre informative for modellen. Ved å trene på et mindre delsett av data med bare prøvene som bidrar mest til modellkonvergens, reduseres total trening og kostnad med minimal eller ingen innvirkning på nøyaktigheten. I tillegg, fordi funksjonen fungerer online under modelltrening, krever ikke smart sikting endringer i oppstrømsdata eller nedstrøms treningspipeline.

I dette innlegget diskuterer vi følgende emner:

- Den nye smarte siktefunksjonen i SageMaker og hvordan den fungerer

- Hvordan bruke smart sikting med PyTorch treningsarbeidsmengder

Du kan også sjekke ut vår dokumentasjon og eksempel på notatbøker for ytterligere ressurser om hvordan du kommer i gang med smart sikting.

Slik fungerer SageMaker smart sikting

Vi begynner dette innlegget med en oversikt over hvordan den smarte siktingsevnen kan akselerere modelltreningen din på SageMaker.

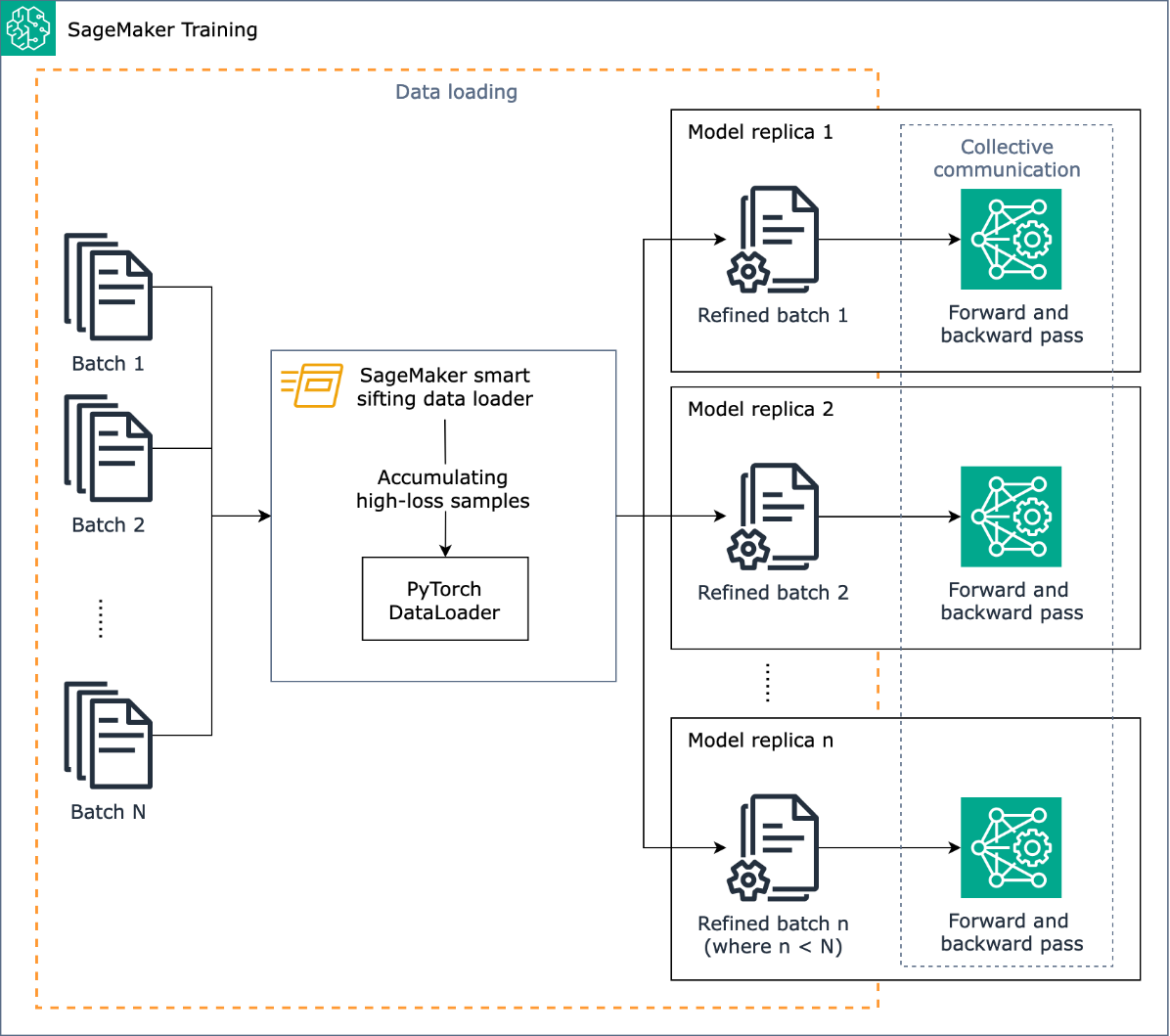

Smart siftings oppgave er å sile gjennom treningsdataene dine under treningsprosessen og bare mate de mer informative prøvene til modellen. Under en typisk trening med PyTorch blir data iterativt sendt i batcher til treningssløyfen og til akseleratorenheter (for eksempel GPUer eller Trainium-brikker) av PyTorch DataLoader. Smart sikting er implementert i dette datainnlastingsstadiet og er derfor uavhengig av eventuell oppstrøms dataforbehandling i treningspipeline.

Smart sikting bruker modellen din og en brukerspesifisert tapsfunksjon for å gjøre en evaluerende videresending av hver dataprøve etter hvert som den lastes inn. Prøver som har høye tap vil ha vesentlig innvirkning på modelltrening og brukes derfor i trening; dataprøver som har relativt lite tap blir satt til side og ekskludert fra trening.

Et viktig input til smart sikting er andelen data som skal ekskluderes: for eksempel ved å sette andelen til 33 % (beta_value=0.5), vil prøver i omtrent den nederste tredjedelen av tapet av hver batch bli ekskludert fra trening. Når nok prøver med høyt tap er identifisert til å fullføre en batch, sendes dataene gjennom hele treningssløyfen og modellen lærer og trener normalt. Du trenger ikke gjøre noen endringer i treningsløkken når smart sikting er aktivert.

Følgende diagram illustrerer denne arbeidsflyten.

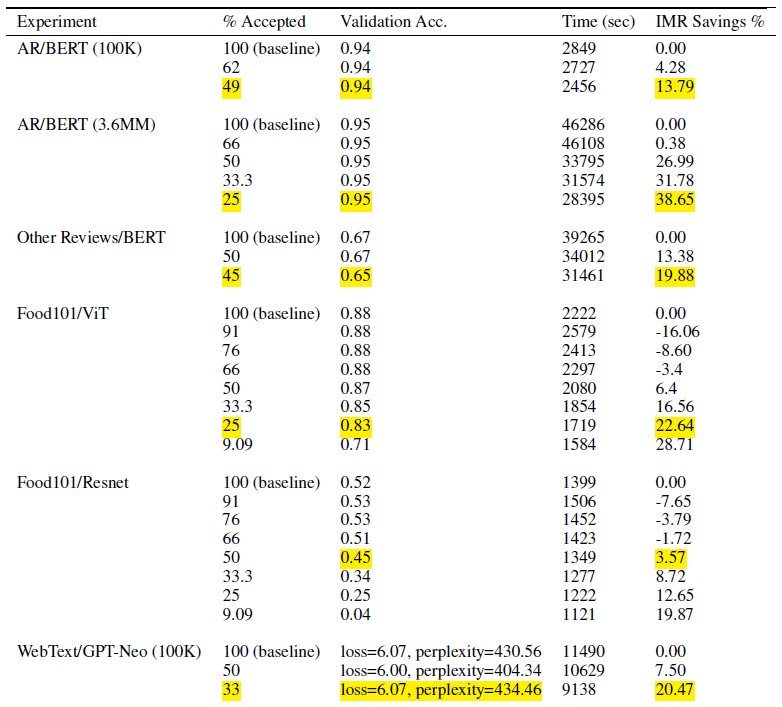

Ved å inkludere bare et delsett av treningsdataene dine, reduserer smart sikting tiden og beregningen som trengs for å trene modellen. I testene våre oppnådde vi opptil 40 % reduksjon i total treningstid og kostnad. Med smart sikting av data kan det være minimal eller ingen innvirkning på modellnøyaktigheten fordi de ekskluderte prøvene var relativt lave tap for modellen. I tabellen nedenfor inkluderer vi et sett med eksperimentelle resultater som viser ytelsesforbedringen som er mulig med SageMaker smart sikting.

I tabellen angir % Akseptert-kolonnen andelen data som er inkludert og brukt i treningssløyfen. Å øke denne justerbare parameteren reduserer kostnadene (som vist i kolonnen IMR Savings %), men det kan også påvirke nøyaktigheten. Den riktige innstillingen for % akseptert er en funksjon av datasettet og modellen. du bør eksperimentere med og justere denne parameteren for å oppnå den beste balansen mellom reduserte kostnader og innvirkning på nøyaktighet.

Løsningsoversikt

I de følgende delene går vi gjennom et praktisk eksempel på å aktivere smart sikting med en PyTorch-treningsjobb på SageMaker. Hvis du vil komme raskt i gang, kan du hoppe til PyTorch eller PyTorch Lightning eksempler.

Forutsetninger

Vi antar at du allerede vet hvordan du trener en modell ved å bruke PyTorch eller PyTorch Lightning ved å bruke SageMaker Python SDK og Estimator-klassen ved å bruke SageMaker Deep Learning Containers for trening. Hvis ikke, se Bruker SageMaker Python SDK før du fortsetter.

Kom i gang med SageMaker smart sikting

I en typisk PyTorch-treningsjobb initialiserer du PyTorch-treningen DataLoader med datasettet ditt og andre nødvendige parametere, som gir input-batcher etter hvert som opplæringen skrider frem. For å aktivere smart sikting av treningsdataene dine, bruker du en ny DataLoader klasse: smart_sifting.dataloader.sift_dataloader.SiftingDataloader. Denne klassen brukes som en innpakning på toppen av din eksisterende PyTorch DataLoader og opplæringsprosessen vil i stedet bruke SiftingDataloader for å få input batcher. De SiftingDataLoader henter input-batchen fra din originale PyTorch DataLoader, evaluerer viktigheten av prøver i batchen, og konstruerer en siktet batch med prøver med høyt tap, som deretter sendes til treningstrinnet. Innpakningen ser ut som følgende kode:

De SiftingDataloader krever noen ekstra parametere for å analysere treningsdataene dine, som du kan spesifisere via sift_config parameter. Lag først en smart_sifting.sift_config.sift_configs.RelativeProbabilisticSiftConfig gjenstand. Dette objektet har det konfigurerbare og nødvendige beta_value og loss_history_length, som henholdsvis definerer andelen prøver som skal beholdes og vinduet med prøver som skal inkluderes ved evaluering av relativt tap. Merk at fordi smart sikting bruker modellen din for å definere viktigheten av prøven, kan det være negative implikasjoner hvis vi bruker en modell med helt tilfeldige vekter. I stedet kan du bruke loss_based_sift_config og en sift_delay å forsinke sikteprosessen til parametervektene i modellen er oppdatert utover tilfeldige verdier. (For mer informasjon, se Bruk smart sikting på treningsskriptet ditt.) I følgende kode definerer vi sift_config og spesifiser beta_value og loss_history_length, samt forsinke starten av sikting ved hjelp av loss_based_sift_config:

Deretter må du også inkludere en loss_impl parameter i SiftingDataloader gjenstand. Smart sikting fungerer på individuelt prøvenivå, og det er avgjørende å ha tilgang til en tapsberegningsmetode for å bestemme viktigheten av prøven. Du må implementere en siktetapsmetode som returnerer en nx1-tensor, som inneholder tapsverdier på n prøver. Vanligvis spesifiserer du samme tapsmetode som brukes av din model under trening. Til slutt inkluderer du en peker til modellen din i SiftingDataloader objekt, som brukes til å evaluere prøver før de inkluderes i opplæring. Se følgende kode:

Følgende kode viser et komplett eksempel på å aktivere smart sikting med en eksisterende BERT-treningsjobb:

konklusjonen

I dette innlegget utforsket vi den offentlige forhåndsvisningen av smart sikting, en ny funksjon i SageMaker som kan redusere treningskostnadene for dyplæringsmodeller med opptil 35 %. Denne funksjonen forbedrer dataeffektiviteten under trening som filtrerer ut mindre informative dataeksempler. Ved å inkludere bare de mest virkningsfulle dataene for modellkonvergens, kan du redusere treningstid og utgifter betraktelig, samtidig som nøyaktigheten opprettholdes. Dessuten integreres den sømløst i eksisterende prosesser uten å kreve endringer i data eller opplæringspipeline.

For å dykke dypere inn i SageMaker smart sikting, utforske hvordan det fungerer og implementere det med PyTorch treningsarbeidsmengder, sjekk ut vår dokumentasjon og eksempel på notatbøker og kom i gang med denne nye muligheten.

Om forfatterne

Robert Van Dusen er senior produktsjef hos Amazon SageMaker. Han leder rammeverk, kompilatorer og optimaliseringsteknikker for dyp læringstrening.

Robert Van Dusen er senior produktsjef hos Amazon SageMaker. Han leder rammeverk, kompilatorer og optimaliseringsteknikker for dyp læringstrening.

K Lokesh Kumar Reddy er senioringeniør i Amazon Applied AI-teamet. Han er fokusert på effektive ML-treningsteknikker og å bygge verktøy for å forbedre AI-systemer for samtale. På fritiden liker han å oppsøke nye kulturer, nye opplevelser og holde seg oppdatert med de nyeste teknologitrendene.

K Lokesh Kumar Reddy er senioringeniør i Amazon Applied AI-teamet. Han er fokusert på effektive ML-treningsteknikker og å bygge verktøy for å forbedre AI-systemer for samtale. På fritiden liker han å oppsøke nye kulturer, nye opplevelser og holde seg oppdatert med de nyeste teknologitrendene.

Abhishek Dan er senior Dev Manager i Amazon Applied AI-teamet og jobber med maskinlæring og AI-systemer for samtale. Han er lidenskapelig opptatt av AI-teknologier og jobber i skjæringspunktet mellom vitenskap og ingeniørvitenskap for å fremme evnene til AI-systemer for å skape mer intuitive og sømløse interaksjoner mellom mennesker og datamaskiner. Han bygger for tiden applikasjoner på store språkmodeller for å drive effektivitet og CX-forbedringer for Amazon.

Abhishek Dan er senior Dev Manager i Amazon Applied AI-teamet og jobber med maskinlæring og AI-systemer for samtale. Han er lidenskapelig opptatt av AI-teknologier og jobber i skjæringspunktet mellom vitenskap og ingeniørvitenskap for å fremme evnene til AI-systemer for å skape mer intuitive og sømløse interaksjoner mellom mennesker og datamaskiner. Han bygger for tiden applikasjoner på store språkmodeller for å drive effektivitet og CX-forbedringer for Amazon.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/accelerate-deep-learning-model-training-up-to-35-with-amazon-sagemaker-smart-sifting/

- :er

- :ikke

- $OPP

- 100

- 125

- 13

- 14

- 23

- 25

- 35%

- 7

- a

- Om oss

- akselerere

- akselerator

- akseptert

- adgang

- nøyaktighet

- Oppnå

- oppnådd

- aktivt

- legge til

- Ytterligere

- I tillegg

- Advancing

- påvirke

- AI

- AI-systemer

- Alle

- allerede

- også

- endringer

- alltid

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- analysere

- analyser

- og

- Kunngjøre

- noen

- søknader

- anvendt

- Anvendt AI

- hensiktsmessig

- ca

- ER

- Kunst

- kunstig

- kunstig intelligens

- AS

- side

- assosiert

- anta

- At

- AWS

- Balansere

- BE

- fordi

- vært

- før du

- begynne

- BEST

- mellom

- Beyond

- Bunn

- Bygning

- men

- by

- beregne

- beregningen

- CAN

- evner

- evne

- saken

- utfordre

- Endringer

- sjekk

- chips

- klasse

- kode

- Kolonne

- fullføre

- helt

- beregningen

- beregnings

- Beregn

- datamaskin

- Datamaskin syn

- konstruerer

- tidkrevende

- Containere

- fortsetter

- bidra

- bidrar

- Konvergens

- conversational

- samtale AI

- Kostnad

- Kostnader

- skape

- avgjørende

- kuratert

- I dag

- Kunder

- CX

- dato

- datavitenskap

- datasett

- Dato

- avtar

- dyp

- dyp læring

- dypere

- definere

- definere

- forsinkelse

- demonstrert

- demonstrere

- detaljer

- Bestem

- dev

- enhet

- Enheter

- diskutere

- distribueres

- distribuert opplæring

- dykk

- do

- ikke

- ikke

- stasjonen

- drevet

- under

- hver enkelt

- effektivitet

- effektiv

- ellers

- muliggjøre

- aktivert

- muliggjør

- ingeniør

- Ingeniørarbeid

- nok

- bedrifter

- like

- evaluere

- evaluere

- Selv

- utvikling

- eksempel

- eksempler

- opphisset

- ekskludert

- eksisterende

- erfaring

- Erfaringer

- eksperiment

- eksperimentell

- utforske

- utforsket

- Trekk

- Egenskaper

- filtre

- Endelig

- Først

- Fokus

- fokuserte

- etter

- Til

- teten

- Forward

- funnet

- rammer

- fra

- fullt

- fullt

- funksjon

- general

- få

- GPU

- GPU

- maskinvare

- Ha

- he

- hjelpe

- hans

- holder

- Hvordan

- Hvordan

- Men

- HTML

- HTTPS

- identifisert

- if

- illustrerer

- Påvirkning

- innflytelsesrik

- iverksette

- implementert

- implikasjoner

- importere

- betydning

- forbedre

- forbedring

- forbedringer

- forbedrer

- in

- inkludere

- inkludert

- Inkludert

- økende

- uavhengig

- indikerer

- individuelt

- ineffektivitet

- informasjon

- informative

- Innovasjon

- inngang

- i stedet

- Integrerer

- Intelligens

- interaksjoner

- kryss

- inn

- intuitiv

- IT

- selv

- Jobb

- jpg

- hoppe

- Hold

- nøkkel

- Vet

- Kumar

- landskap

- Språk

- stor

- siste

- lag

- Fører

- læring

- lærer

- mindre

- Nivå

- bibliotekene

- Lyn

- i likhet med

- lasting

- logikk

- UTSEENDE

- tap

- maskin

- maskinlæring

- Vedlike

- gjøre

- leder

- materielt

- Kan..

- metode

- minimal

- blandet

- ML

- modell

- modeller

- Moduler

- mer

- mest

- må

- Naturlig

- Natural Language Processing

- nesten

- Trenger

- nødvendig

- negativ

- Ny

- nlp

- Nei.

- none

- normalt

- note

- objekt

- of

- ofte

- on

- på nett

- bare

- åpen

- åpen kildekode

- opererer

- optimalisering

- optimalisert

- or

- original

- Annen

- vår

- ut

- utganger

- samlet

- Overcome

- oversikt

- parameter

- parametere

- passere

- bestått

- lidenskapelig

- for

- ytelse

- rørledning

- plato

- Platon Data Intelligence

- PlatonData

- positurer

- mulig

- Post

- kraftig

- Praktisk

- Precision

- Forhåndsvisning

- primært

- prosess

- Prosesser

- prosessering

- Produkt

- Produktsjef

- Andelen

- gir

- offentlig

- formål

- Python

- pytorch

- kvalitet

- raskt

- tilfeldig

- raskt

- Anbefaling

- redusere

- Redusert

- reduserer

- reduksjon

- referere

- avgrense

- i slekt

- slektning

- relativt

- avhengige

- krever

- påkrevd

- Krever

- Ressurser

- henholdsvis

- REST

- Resultater

- retur

- avkastning

- sagemaker

- samme

- Besparelser

- Vitenskap

- SDK

- sømløs

- sømløst

- seksjoner

- se

- søker

- SELV

- senior

- sendt

- Tjenester

- sett

- innstilling

- bør

- Viser

- Sikte

- signifikant

- betydelig

- Enkelt

- mindre

- Smart

- noen

- noen ganger

- kilde

- Spenning

- spesialisert

- spesifikk

- brukt

- Scene

- Begynn

- startet

- blir

- Trinn

- i det vesentlige

- slik

- Systemer

- bord

- Ta

- Oppgave

- lag

- teknikk

- teknikker

- Technologies

- Teknologi

- tester

- enn

- Det

- De

- informasjonen

- deres

- seg

- deretter

- Der.

- derfor

- Disse

- de

- Tredje

- denne

- Gjennom

- tid

- til

- i dag

- dagens

- verktøy

- topp

- temaer

- lommelykt

- Totalt

- tradisjonelt

- Tog

- trent

- Kurs

- Togene

- Trender

- melodi

- typisk

- typisk

- til

- oppdatert

- Oppstrøms data

- bruke

- bruk sak

- brukt

- bruker

- ved hjelp av

- Verdier

- av

- syn

- volum

- gå

- ønsker

- we

- web

- webtjenester

- uker

- VI VIL

- var

- når

- hvilken

- mens

- vil

- vindu

- med

- uten

- arbeidsflyt

- virker

- Du

- Din

- zephyrnet