Microsoft demonstrerte denne uken VASA–1, et rammeverk for å lage videoer av folk som snakker fra et stillbilde, lydeksempel og tekstskript, og hevder – med rette – at det er for farlig til å bli utgitt for offentligheten.

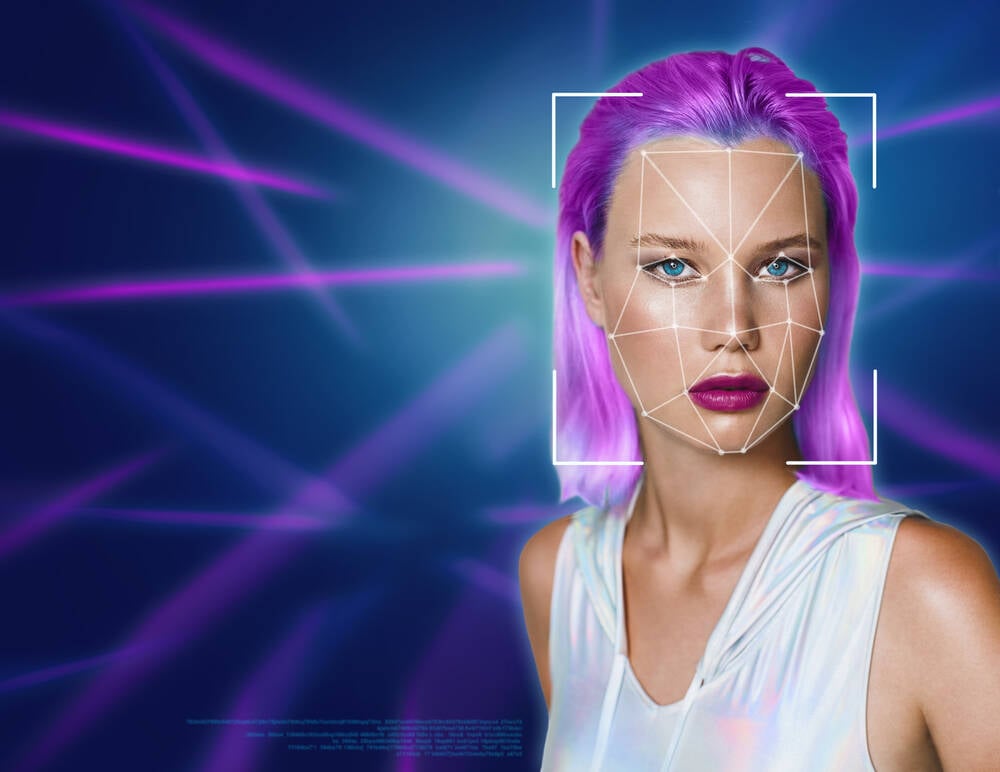

Disse AI-genererte videoene, der folk på en overbevisende måte kan animeres til å snakke skriptede ord med en klonet stemme, er akkurat den typen ting USAs føderale handelskommisjon advaret om forrige måned, etter tidligere foreslår en regel for å forhindre at AI-teknologi brukes til falsk identitet.

Microsofts team anerkjenner så mye i deres kunngjøring, som forklarer at teknologien ikke blir utgitt på grunn av etiske hensyn. De insisterer på at de presenterer forskning for å generere virtuelle interaktive karakterer og ikke for å utgi seg for noen. Som sådan er det ikke planlagt noe produkt eller API.

"Vår forskning fokuserer på å generere visuelle affektive ferdigheter for virtuelle AI-avatarer, med sikte på positive applikasjoner," uttaler Redmond Boffins. «Det er ikke ment å lage innhold som brukes til å villede eller lure.

"I likhet med andre relaterte innholdsgenereringsteknikker kan det imidlertid fortsatt potensielt misbrukes for å etterligne mennesker. Vi er motstandere av enhver oppførsel for å skape villedende eller skadelig innhold av ekte personer, og er interessert i å bruke vår teknikk for å fremme forfalskningsoppdagelse.»

Kevin Surace, styreleder for Token, en biometrisk autentiseringsbiz, og hyppig foredragsholder om generativ AI, fortalte Registeret i en e-post om at selv om det har vært tidligere teknologidemonstrasjoner av ansikter animert fra en stillbilde og klonet stemmefil, gjenspeiler Microsofts demonstrasjon det siste innen teknikk.

"Konsekvensene for personalisering av e-poster og annen massekommunikasjon er fabelaktig," mente han. “Til og med animere eldre bilder også. Til en viss grad er dette bare moro, og til en annen har det solide forretningsapplikasjoner vi alle vil bruke i de kommende månedene og årene.»

Det "morsomme" med deepfakes var 96 prosent porno uten samtykke, når vurderes [PDF] i 2019 av cybersikkerhetsfirmaet Deeptrace.

Ikke desto mindre antyder Microsofts forskere at det å være i stand til å skape realistisk utseende mennesker og legge ord i munnen deres har positive bruksområder.

"Slik teknologi har løftet om å berike digital kommunikasjon, øke tilgjengeligheten for de med kommunikasjonsvansker, transformere utdanning, metoder med interaktiv AI-veiledning og gi terapeutisk støtte og sosial interaksjon i helsevesenet," foreslår de i en forskning papir som ikke inneholder ordene «porno» eller «feilinformasjon».

Selv om det kan diskuteres, er AI-generert video ikke helt det samme som en deepfake, sistnevnte definert ved digital manipulasjon i motsetning til en generativ metode, blir skillet uvesentlig når en overbevisende falsk kan trylles uten klipp-og-lim poding.

På spørsmål om hva han mener om det faktum at Microsoft ikke gir ut denne teknologien til offentligheten av frykt for misbruk, uttrykte Surace tvil om levedyktigheten til restriksjoner.

"Microsoft og andre har holdt tilbake for nå til de finner ut av personvern- og bruksproblemene," sa han. "Hvordan vil noen regulere hvem som bruker dette av de riktige grunnene?"

Surace la til at det allerede er åpen kildekode-modeller som er like sofistikerte, og peker på EMO. "Man kan hente kildekoden fra GitHub og bygge en tjeneste rundt den som uten tvil vil konkurrere med Microsofts produksjon," observerte han. "På grunn av plassens åpen kildekode, vil det i alle fall være umulig å regulere det."

Når det er sagt, prøver land rundt om i verden å regulere AI-fabrikerte mennesker. Canada, Kina, og UK, blant andre nasjoner, har alle forskrifter som kan brukes på deepfakes, hvorav noen oppfyller bredere politiske mål. Storbritannia denne uken gjort det ulovlig å lage et seksuelt eksplisitt dypfalske bilde uten samtykke. Deling av slike bilder var allerede forbudt i henhold til Storbritannias Online Safety Act av 2023.

I januar, en bipartisan gruppe av amerikanske lovgivere introdusert Disrupt Explicit Forged Images and Non-Consensual Edits Act of 2024 (DEFIANCE Act), et lovforslag som skaper en måte for ofre for dypfalske bilder uten samtykke til å sende inn et sivilt krav i retten.

Og tirsdag 16. april holdt den amerikanske senatkomiteen for rettsvesenet, underkomiteen for personvern, teknologi og loven en høring med tittelen "Oversight of AI: Election Deepfakes."

I forberedte bemerkninger sa Rijul Gupta, administrerende direktør i DeepMedia, en biz for dypfalsk deteksjon:

[D]et mest alarmerende aspektet ved deepfakes er deres evne til å gi dårlige skuespillere plausibel benektelse, slik at de kan avvise ekte innhold som falskt. Denne erosjonen av offentlig tillit treffer selve kjernen av vårt sosiale stoff og grunnlaget for vårt demokrati. Den menneskelige hjernen, kablet til å tro det den ser og hører, er spesielt sårbar for bedrag av dype forfalskninger. Ettersom disse teknologiene blir stadig mer sofistikerte, truer de med å undergrave den delte virkelighetsfølelsen som ligger til grunn for samfunnet vårt, og skaper et klima av usikkerhet og skepsis der innbyggerne blir stående i tvil om sannheten til hver informasjon de møter.

Men tenk på markedsføringsapplikasjonene. ®

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://go.theregister.com/feed/www.theregister.com/2024/04/20/microsoft_deepfake_vasa/

- : har

- :er

- :ikke

- :hvor

- 16

- 2019

- 2023

- 2024

- 7

- a

- evne

- I stand

- Om oss

- tilgjengelighet

- anerkjenne

- Handling

- aktører

- la til

- Advancing

- Etter

- AI

- Sikter

- Alle

- tillate

- allerede

- blant

- an

- og

- En annen

- noen

- noen

- api

- søknader

- anvendt

- påføring

- April

- ER

- antageligvis

- rundt

- Kunst

- AS

- aspektet

- At

- lyd

- Autentisering

- avatarer

- tilbake

- dårlig

- BE

- fordi

- bli

- blir

- vært

- atferd

- være

- tro

- Bill

- biometrisk

- biometrisk autentisering

- tverrpolitisk

- biz

- Brain

- britain

- bredere

- bygge

- virksomhet

- Business Applications

- by

- CAN

- saken

- konsernsjef

- Chair

- tegn

- Borgere

- sivil

- hevder

- krav

- Klima

- CO

- kode

- kommer

- kommisjon

- Utvalget

- Kommunikasjon

- samtykke

- betraktninger

- inneholde

- innhold

- Innholdsgenerering

- innhold

- Kjerne

- kunne

- land

- Court

- skape

- skaper

- Opprette

- Cybersecurity

- Dangerous

- lure

- bedrag

- deepfakes

- Defiance

- Demokrati

- demonstrasjon

- Gjenkjenning

- digitalt

- Forkast

- Avbryte

- skillet

- gjør

- tviler

- to

- Kunnskap

- Valg

- emalje

- e-post

- møte

- berikende

- etisk

- Selv

- Hver

- forklarer

- uttrykte

- grad

- stoff

- ansikter

- Faktisk

- forfalskning

- frykt

- Federal

- Federal Trade Commission

- filet

- Firm

- fokuserer

- Til

- smidd

- forfalskning

- Foundations

- RAMME

- Rammeverk

- svindel

- hyppig

- fra

- FTC

- Innfri

- moro

- generert

- genererer

- generasjonen

- generative

- Generativ AI

- ekte

- GitHub

- Mål

- god

- Gruppe

- Gupta

- skadelig

- Ha

- he

- helsetjenester

- Held

- holder

- Hvordan

- Men

- HTML

- HTTPS

- menneskelig

- Mennesker

- bilde

- bilder

- implikasjoner

- umulig

- in

- økende

- stadig

- informasjon

- tiltenkt

- interaksjon

- interaktiv

- interessert

- saker

- IT

- Januar

- jpg

- bare

- Justice

- Siste

- Law

- lovgivere

- venstre

- Lovgivning

- i likhet med

- ser

- GJØR AT

- Manipulasjon

- Marketing

- Mass

- metode

- metoder

- Microsoft

- feil~~POS=TRUNC

- villedende

- misbruk

- modeller

- Måned

- måneder

- mest

- mye

- Nasjoner

- Natur

- Nei.

- nå

- of

- eldre

- on

- ONE

- på nett

- åpen

- åpen kildekode

- motsetning

- or

- Annen

- andre

- vår

- ut

- produksjon

- oppsyn

- spesielt

- Ansatte

- prosent

- personer

- Bilder

- brikke

- planlagt

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- politisk

- positiv

- potensielt

- forberedt

- presentere

- forebygge

- tidligere

- Før

- privatliv

- Produkt

- løfte

- foreslå

- gi

- gi

- offentlig

- offentlig tillit

- sette

- ganske

- RE

- ekte

- realistisk

- Reality

- grunner

- Gjenspeiler

- Regulere

- regulerende

- forskrifter

- i slekt

- slipp

- utgitt

- frigjør

- forskning

- forskere

- restriksjoner

- ikke sant

- Rival

- s

- Sikkerhet

- Sa

- samme

- sample

- script

- Sees

- Senatet

- forstand

- tjeneste

- delt

- deling

- på samme måte

- Skepsis

- ferdigheter

- selskap

- Samfunnet

- solid

- noen

- sofistikert

- kilde

- kildekoden

- Rom

- snakke

- Høyttaler

- Tilstand

- Still

- streik

- underutvalg

- slik

- foreslår

- støtte

- snakker

- lag

- tech

- teknikk

- teknikker

- Technologies

- Teknologi

- tekst

- Det

- De

- loven

- Kilden

- Staten

- Storbritannia

- verden

- deres

- Dem

- Der.

- Disse

- de

- ting

- tror

- denne

- denne uka

- De

- true

- tittelen

- til

- token

- fortalte

- også

- handel

- transformere

- Stol

- prøver

- tirsdag

- Veiledning

- Uk

- Usikkerhet

- etter

- undergrave

- til

- avduker

- us

- US Federal

- USAs føderale handelskommisjon

- Amerikanske lovgivere

- Det amerikanske senatet

- bruk

- bruke

- brukt

- bruker

- veldig

- levedyktighet

- ofre

- video

- videoer

- virtuelle

- visuell

- Voice

- Sårbar

- var

- Vei..

- we

- uke

- VI VIL

- Hva

- når

- hvilken

- mens

- HVEM

- vil

- med

- uten

- ord

- Arbeid

- trene

- verden

- ville

- år

- zephyrnet