Amazon SageMaker Autopilot har lagt til en ny treningsmodus som støtter modellensembling drevet av AutoGluon. Ensembletreningsmodus i Autopilot trener flere basismodeller og kombinerer spådommene deres ved hjelp av modellstabling. For datasett på mindre enn 100 MB bygger ensembletreningsmodus maskinlæringsmodeller (ML) med høy nøyaktighet raskt – opptil åtte ganger raskere enn treningsmodus for hyperparameteroptimalisering (HPO) med 250 forsøk, og opptil 5.8 ganger raskere enn HPO-treningsmodus med 100 forsøk. Den støtter et bredt spekter av algoritmer, inkludert LightGBM, CatBoost, XGBoost, Random Forest, Extra Trees, lineære modeller og nevrale nettverk basert på PyTorch og FastAI.

Hvordan AutoGluon bygger ensemblemodeller

AutoGluon-tabell (AGT) er et populært AutoML-rammeverk med åpen kildekode som trener svært nøyaktige ML-modeller på tabellformede datasett. I motsetning til eksisterende AutoML-rammeverk, som primært fokuserer på modell- og hyperparametervalg, lykkes AGT ved å sette sammen flere modeller og stable dem i flere lag. Standardoppførselen til AGT kan oppsummeres som følger: Gitt et datasett, trener AGT ulike basismodeller som spenner fra hylleforsterkede trær til tilpassede nevrale nettverk på datasettet. Spådommene fra basismodellene brukes som funksjoner for å bygge en stablemodell, som lærer den passende vekten til hver basismodell. Med disse innlærte vektene kombinerer stablemodellen deretter basismodellens spådommer og returnerer de kombinerte prediksjonene som det endelige settet med spådommer.

Hvordan Autopilotens ensembletreningsmodus fungerer

Ulike datasett har egenskaper som passer for ulike algoritmer. Gitt et datasett med ukjente egenskaper, er det vanskelig å vite på forhånd hvilke algoritmer som vil fungere best på et datasett. Med dette i tankene lager dataforskere som bruker AGT ofte flere tilpassede konfigurasjoner med et undersett av algoritmer og parametere. De kjører disse konfigurasjonene på et gitt datasett for å finne den beste konfigurasjonen når det gjelder ytelse og slutningsforsinkelse.

Autopilot er et lavkodet ML-produkt som automatisk bygger de beste ML-modellene for dataene dine. I den nye ensembletreningsmodusen velger Autopilot et optimalt sett med AGT-konfigurasjoner og kjører flere forsøk for å returnere den beste modellen. Disse forsøkene kjøres parallelt for å evaluere om AGTs ytelse kan forbedres ytterligere, når det gjelder objektive beregninger eller slutningsforsinkelse.

Resultater observert ved bruk av OpenML benchmarks

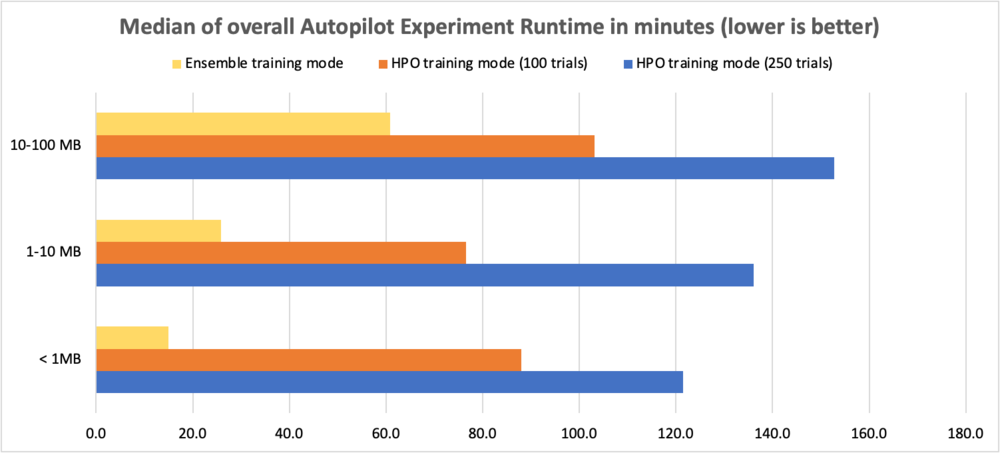

For å evaluere ytelsesforbedringene brukte vi OpenML benchmark-datasett med størrelser som varierer fra 0.5–100 MB og kjørte 10 AGT-forsøk med forskjellige kombinasjoner av algoritmer og hyperparameterkonfigurasjoner. Testene sammenlignet ensembletreningsmodus med HPO-modus med 250 forsøk og HPO-modus med 100 forsøk. Tabellen nedenfor sammenligner den totale kjøretiden for autopiloteksperimentet (i minutter) mellom de to treningsmodusene for ulike datasettstørrelser.

| Datasettstørrelse | HPO-modus (250 forsøk) | HPO-modus (100 forsøk) | Ensemble-modus (10 prøver) | Kjøretidsforbedring med HPO 250 | Kjøretidsforbedring med HPO 100 |

| < 1 MB | 121.5 minutter | 88.0 minutter | 15.0 minutter | 8.1x | 5.9x |

| 1-10 MB | 136.1 minutter | 76.5 minutter | 25.8 minutter | 5.3x | 3.0x |

| 10-100 MB | 152.7 minutter | 103.1 minutter | 60.9 minutter | 2.5x | 1.7x |

For å sammenligne ytelsen til flerklasses klassifiseringsproblemer bruker vi nøyaktighet, for binære klassifiseringsproblemer bruker vi F1-score, og for regresjonsproblemer bruker vi R2. Gevinsten i objektive beregninger er vist i tabellene nedenfor. Vi observerte at ensembletreningsmodus presterte bedre enn HPO-treningsmodus (både 100 og 250 forsøk).

Merk at ensemblemodus viser konsekvent forbedring i forhold til HPO-modus med 250 forsøk uavhengig av datasettstørrelse og problemtyper.

Følgende tabell sammenligner nøyaktighet for klassifiseringsproblemer i flere klasser (høyere er bedre).

| Datasettstørrelse | HPO-modus (250 forsøk) | HPO-modus (100 forsøk) | Ensemble-modus (10 prøver) | Prosentvis forbedring over HPO 250 |

| < 1 MB | 0.759 | 0.761 | 0.771 | 1.46% |

| 1-5 MB | 0.941 | 0.935 | 0.957 | 1.64% |

| 5-10 MB | 0.639 | 0.633 | 0.671 | 4.92% |

| 10-50 MB | 0.998 | 0.999 | 0.999 | 0.11% |

| 51-100 MB | 0.853 | 0.852 | 0.875 | 2.56% |

Følgende tabell sammenligner F1-score for binære klassifiseringsproblemer (høyere er bedre).

| Datasettstørrelse | HPO-modus (250 forsøk) | HPO-modus (100 forsøk) | Ensemble-modus (10 prøver) | Prosentvis forbedring over HPO 250 |

| < 1 MB | 0.801 | 0.807 | 0.826 | 3.14% |

| 1-5 MB | 0.59 | 0.587 | 0.629 | 6.60% |

| 5-10 MB | 0.886 | 0.889 | 0.898 | 1.32% |

| 10-50 MB | 0.731 | 0.736 | 0.754 | 3.12% |

| 51-100 MB | 0.503 | 0.493 | 0.541 | 7.58% |

Følgende tabell sammenligner R2 for regresjonsproblemer (høyere er bedre).

| Datasettstørrelse | HPO-modus (250 forsøk) | HPO-modus (100 forsøk) | Ensemble-modus (10 prøver) | Prosentvis forbedring over HPO 250 |

| < 1 MB | 0.717 | 0.718 | 0.716 | 0% |

| 1-5 MB | 0.803 | 0.803 | 0.817 | 2% |

| 5-10 MB | 0.590 | 0.586 | 0.614 | 4% |

| 10-50 MB | 0.686 | 0.688 | 0.684 | 0% |

| 51-100 MB | 0.623 | 0.626 | 0.631 | 1% |

I de neste avsnittene viser vi hvordan du bruker den nye ensembletreningsmodusen i Autopilot for å analysere datasett og enkelt bygge ML-modeller av høy kvalitet.

Datasettoversikt

Vi bruker Titanic datasett å forutsi om en gitt passasjer overlevde eller ikke. Dette er et binært klassifiseringsproblem. Vi fokuserer på å lage et autopiloteksperiment ved å bruke den nye ensembletreningsmodusen og sammenligne resultatene av F1-poengsum og total kjøretid med et autopiloteksperiment som bruker HPO-treningsmodus (100 forsøk).

| Kolonnenavn | Beskrivelse |

| Passasjerid | Identifikasjonsnummer |

| Overlevde | Survival |

| Pclass | Billettklasse |

| Navn | Passasjernavn |

| Kjønn | Kjønn |

| Alder | Alder i år |

| Sibsp | Antall søsken eller ektefeller ombord på Titanic |

| Parkering | Antall foreldre eller barn ombord på Titanic |

| Billett | Billettnummer |

| Billettpris | Passasjerpris |

| Kabin | Hyttenummer |

| Begynte | Ombordstigningshavn |

Datasettet har 890 rader og 12 kolonner. Den inneholder demografisk informasjon om passasjerene (alder, kjønn, billettklasse og så videre) og målkolonnen Overlevde (ja/nei).

Forutsetninger

Fullfør følgende forutsetningstrinn:

- Sørg for at du har en AWS-konto, sikker tilgang for å logge på kontoen via AWS-administrasjonskonsollog AWS identitets- og tilgangsadministrasjon (IAM) tillatelser å bruke Amazon SageMaker og Amazon enkel lagringstjeneste (Amazon S3) ressurser.

- Last ned Titanic datasett og last den opp til en S3-bøtte i kontoen din.

- Ombord på et SageMaker-domene og tilgang Amazon SageMaker Studio å bruke autopilot. For instruksjoner, se Ombord på Amazon SageMaker Domain. Hvis du bruker eksisterende Studio, oppgrader til siste versjon av Studio for å bruke den nye ensembletreningsmodusen.

Lag et autopiloteksperiment med ensembletreningsmodus

Når datasettet er klart, kan du initialisere et autopiloteksperiment i Studio. For fullstendige instruksjoner, se Lag et Amazon SageMaker Autopilot-eksperiment. Opprett et autopiloteksperiment ved å oppgi et eksperimentnavn, datainndataene og spesifisere måldataene som skal forutsies i Eksperiment og datadetaljer seksjon. Eventuelt kan du spesifisere datasølt forhold og automatisk opprettelse av Amazon S3-utdataplasseringen.

For vårt bruk gir vi et eksperimentnavn, legger inn Amazon S3-plassering og velger Overlevde som målet. Vi holder autodelingen aktivert og overstyrer standard utdata Amazon S3-plassering.

Deretter spesifiserer vi treningsmetoden i Treningsmetode seksjon. Du kan enten la autopilot velge treningsmodus automatisk ved hjelp av Auto basert på datasettstørrelsen, eller velg treningsmodus manuelt for enten ensembling eller HPO. Detaljene om hvert alternativ er som følger:

- Auto – Autopiloten velger automatisk enten ensembling eller HPO-modus basert på datasettstørrelsen din. Hvis datasettet ditt er større enn 100 MB, velger Autopilot HPO, ellers velger den ensembling.

- Ensemblering – Autopilot bruker AutoGluonsin ensemblingsteknikk for å trene flere basismodeller og kombinerer deres spådommer ved å bruke modellstabling til en optimal prediktiv modell.

- Optimalisering av hyperparameter – Autopilot finner den beste versjonen av en modell ved å justere hyperparametere ved å bruke Bayesian Optimization-teknikken og kjøre treningsjobber på datasettet ditt. HPO velger algoritmene som er mest relevante for datasettet ditt og velger det beste utvalget av hyperparametre for å justere modellene.

For vår brukssituasjon velger vi Ensemblering som vår treningsmodus.

Etter dette går vi videre til Implementering og avanserte innstillinger seksjon. Her velger vi bort Automatisk distribusjon alternativ. Under Avanserte innstillinger, kan du spesifisere typen ML-problem du vil løse. Hvis ingenting er oppgitt, bestemmer Autopilot automatisk modellen basert på dataene du oppgir. Fordi vårt er et binært klassifiseringsproblem, velger vi Binær klassifisering som vår problemtype og F1 som vår objektive beregning.

Til slutt gjennomgår vi våre valg og velger Lag eksperiment.

På dette tidspunktet er det trygt å forlate Studio og returnere senere for å sjekke resultatet, som du kan finne på eksperimenter menyen.

Følgende skjermbilde viser de endelige resultatene av vår titanic-ens ensemble-treningsmodus Autopilot-jobb.

Du kan se flere forsøk som har blitt forsøkt av autopiloten i ensembletreningsmodus. Hver utprøving returnerer den beste modellen fra utvalget av individuelle modellkjøringer og stable-ensemblemodellkjøringer.

For å forklare dette litt nærmere, la oss anta at prøve 1 vurderte alle de åtte støttede algoritmene og brukte stablingsnivå 2. Den vil internt lage de individuelle modellene for hver algoritme, så vel som de vektede ensemblemodellene med stabelnivå 0, nivå 1 og nivå 2 Utdataene fra prøveversjon 1 vil imidlertid være den beste modellen fra utvalget av modeller som er opprettet.

På samme måte, la oss vurdere at prøveversjon 2 kun har plukket opp trebaserte boostingsalgoritmer. I dette tilfellet vil Trial 2 internt lage tre individuelle modeller for hver av de tre algoritmene så vel som de vektede ensemblemodellene, og returnere den beste modellen fra kjøringen.

Den endelige modellen som returneres av en prøveperiode kan være en vektet ensemblemodell eller ikke, men flertallet av forsøkene vil mest sannsynlig returnere sin best vektede ensemblemodell. Til slutt, basert på den valgte målberegningen, vil den beste modellen blant alle de 10 forsøkene bli identifisert.

I det foregående eksemplet var vår beste modell den med høyest F1-poengsum (vår objektive beregning). Flere andre nyttige beregninger, inkludert nøyaktighet, balansert nøyaktighet, presisjon og tilbakekalling vises også. I vårt miljø var ende-til-ende-kjøringstiden for dette autopiloteksperimentet 10 minutter.

Lag et autopiloteksperiment med HPO-treningsmodus

La oss nå utføre alle de nevnte trinnene for å lage et andre Autopilot-eksperiment med HPO-treningsmetoden (standard 100 forsøk). Bortsett fra valg av treningsmetode, som er nå Optimalisering av hyperparameter, alt annet forblir det samme. I HPO-modus kan du spesifisere antall forsøk ved å angi Maks kandidater etter Avanserte innstillinger forum Runtime, men vi anbefaler å la dette stå som standard. Gir ingen verdi i Maks kandidater vil kjøre 100 HPO-forsøk. I vårt miljø var ende-til-ende-kjøringstiden for dette autopiloteksperimentet 2 timer.

Sammenligning av kjøretid og ytelse

Vi ser at for datasettet vårt (under 1 MB), ikke bare kjørte ensembletreningsmodus 12 ganger raskere enn HPO-treningsmodus (120 minutter til 10 minutter), men det ga også forbedrede F1-score og andre ytelsesmålinger.

| Treningsmodus | F1-poengsum | Nøyaktighet | Balansert nøyaktighet | AUC | Precision | Husker | Loggtap | Runtime |

| Ensemblemodus - Vektet Ensemble | 0.844 | 0.878 | 0.865 | 0.89 | 0.912 | 0.785 | 0.394 | 10 minutter |

| HPO-modus – XGBoost | 0.784 | 0.843 | 0.824 | 0.867 | 0.831 | 0.743 | 0.428 | 120 minutter |

slutning

Nå som vi har en vinnermodell, kan vi enten distribuer den til et endepunkt for sanntidsslutning or bruk batch-transformasjoner for å lage spådommer på det umerkede datasettet vi lastet ned tidligere.

Oppsummering

Du kan kjøre Autopilot-eksperimentene dine raskere uten noen innvirkning på ytelsen med den nye ensembletreningsmodusen for datasett mindre enn 100 MB. For å komme i gang, lage et SageMaker Autopilot-eksperiment på Studio-konsollen og velg Ensemblering som treningsmodus, eller la autopilot utlede treningsmodusen automatisk basert på datasettstørrelsen. Du kan referere til CreateAutoMLJob API-referanseveiledning for oppdateringer til API, og oppgradering til siste versjon av Studio for å bruke den nye ensembletreningsmodusen. For mer informasjon om denne funksjonen, se Modellstøtte, beregninger og validering med Amazon SageMaker Autopilot og for å lære mer om autopilot, besøk produktside.

Om forfatterne

Janisha Anand er senior produktsjef i SageMaker Low/No Code ML-teamet, som inkluderer SageMaker Autopilot. Hun liker kaffe, holder seg aktiv og tilbringer tid med familien.

Janisha Anand er senior produktsjef i SageMaker Low/No Code ML-teamet, som inkluderer SageMaker Autopilot. Hun liker kaffe, holder seg aktiv og tilbringer tid med familien.

Saket Sathe er Senior Applied Scientist i SageMaker Autopilot-teamet. Han brenner for å bygge neste generasjon maskinlæringsalgoritmer og -systemer. Bortsett fra jobben elsker han å lese, lage mat, slurpe ramen og spille badminton.

Saket Sathe er Senior Applied Scientist i SageMaker Autopilot-teamet. Han brenner for å bygge neste generasjon maskinlæringsalgoritmer og -systemer. Bortsett fra jobben elsker han å lese, lage mat, slurpe ramen og spille badminton.

Abhishek singh er programvareingeniør for autopilotteamet i AWS. Han har 8+ års erfaring som programvareutvikler, og brenner for å bygge skalerbare programvareløsninger som løser kundeproblemer. På fritiden liker Abhishek å holde seg aktiv ved å gå på fotturer eller engasjere seg i fotballkamper.

Abhishek singh er programvareingeniør for autopilotteamet i AWS. Han har 8+ års erfaring som programvareutvikler, og brenner for å bygge skalerbare programvareløsninger som løser kundeproblemer. På fritiden liker Abhishek å holde seg aktiv ved å gå på fotturer eller engasjere seg i fotballkamper.

Vadim Omeltchenko er en Sr. AI/ML Solutions Architect som brenner for å hjelpe AWS-kunder med å innovere i skyen. Hans tidligere IT-erfaring var hovedsakelig på bakken.

Vadim Omeltchenko er en Sr. AI/ML Solutions Architect som brenner for å hjelpe AWS-kunder med å innovere i skyen. Hans tidligere IT-erfaring var hovedsakelig på bakken.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- Amazon SageMaker Autopilot

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet