Dette er en meningsredaksjon av Aleksandar Svetski, forfatter av "The UnCommunist Manifesto" og grunnlegger av den Bitcoin-fokuserte språkmodellen Spirit of Satoshi.

Språkmodeller er i raseri, og mange mennesker tar bare grunnmodeller (oftest ChatGPT eller noe lignende) og kobler dem deretter til en vektordatabase slik at når folk stiller "modellen" et spørsmål, svarer den på svaret med kontekst fra denne vektordatabasen.

Hva er en vektor database? Jeg vil forklare det mer detaljert i et fremtidig essay, men en enkel måte å forstå det på er som en samling av informasjon lagret som databiter, som en språkmodell kan spørre etter og bruke for å produsere bedre svar. Se for deg "The Bitcoin Standard", delt inn i avsnitt og lagret i denne vektordatabasen. Du stiller denne nye "modellen" et spørsmål om pengenes historie. Den underliggende modellen vil faktisk spørre databasen, velge den mest relevante konteksten (noen avsnitt fra "The Bitcoin Standard") og deretter mate den inn i ledeteksten til den underliggende modellen (i mange tilfeller ChatGPT). Modellen skal da svare med et mer relevant svar. Dette er kult, og fungerer OK i noen tilfeller, men løser ikke de underliggende problemene med vanlig støy og skjevhet som de underliggende modellene er utsatt for under treningen.

Dette er hva vi prøver å gjøre på Spirit of Satoshi. Vi har bygget en modell som er beskrevet ovenfor for omtrent seks måneder siden, som du kan prøve ut her.. Du vil legge merke til at det ikke er dårlig med noen svar, men det kan ikke holde en samtale, og det fungerer veldig dårlig når det kommer til shitcoinery og ting som en ekte Bitcoiner ville vite.

Dette er grunnen til at vi har endret tilnærmingen vår og bygger en full språkmodell fra bunnen av. I dette essayet vil jeg snakke litt om det, for å gi deg en idé om hva det innebærer.

En mer 'basert' Bitcoin-språkmodell

Oppdraget med å bygge en mer "basert" språkmodell fortsetter. Det har vist seg å være mer involvert enn jeg hadde trodd, ikke fra en "teknisk komplisert" ståsted, men mer fra en "fan, dette er kjedelig" ståsted.

Alt handler om data. Og ikke mengden av data, men kvaliteten og formatet på data. Du har sikkert hørt nerder snakke om dette, og du setter ikke veldig pris på det før du faktisk begynner å mate tingene til en modell, og du får et resultat ... som ikke nødvendigvis var det du ønsket.

Datapipeline er der alt arbeidet er. Du må samle og kuratere dataene, så må du trekke ut den. Da må du programmatisk ren det (det er umulig å gjøre en førstegangsrens manuelt).

Så tar du disse programmatisk rensede, rå dataene, og du må forvandle det inn i flere data formater (tenk på spørsmål-og-svar-par, eller semantisk-sammenhengende biter og avsnitt). Dette må du også gjøre programmatisk, hvis du har å gjøre med masse data - som er tilfellet for en språkmodell. Morsomt nok er andre språkmodeller faktisk gode for denne oppgaven! Du bruker språkmodeller for å bygge nye språkmodeller.

Deretter, fordi det sannsynligvis vil være masse søppel igjen der inne, og irrelevant søppel generert av hvilken som helst språkmodell du brukte til å transformere dataene programmatisk, må du gjøre en mer intens ren.

Dette er der du trenger å få menneskelig hjelp, fordi på dette stadiet ser det ut til at mennesker fortsatt er de eneste skapningene på planeten med byrået som er nødvendig for å differensiere og bestemme kvalitet. Algoritmer kan på en måte gjøre dette, men ikke så bra med språk ennå - spesielt i mer nyanserte, komparative sammenhenger - som er der Bitcoin rett og slett sitter.

I alle fall er det utrolig vanskelig å gjøre dette i stor skala med mindre du har en hær av mennesker til å hjelpe deg. Den hæren av mennesker kan være leiesoldater betalt av noen, som OpenAI som har mer penger enn Gud, eller de kan være misjonærer, som er hva Bitcoin-fellesskapet generelt er (vi er veldig heldige og takknemlige for dette hos Spirit of Satoshi). Enkeltpersoner går gjennom dataelementer og velger én etter én om de vil beholde, forkaste eller endre dataene.

Når dataene går gjennom denne prosessen, ender du opp med noe rent i den andre enden. Selvfølgelig er det flere forviklinger involvert her. Du må for eksempel sørge for at dårlige skuespillere som prøver å feile oppryddingsprosessen din blir luket ut, eller at deres innspill blir forkastet. Du kan gjøre det på en rekke måter, og alle gjør det litt annerledes. Du kan screene folk på vei inn, du kan bygge en slags intern konsensusmodell for opprydding slik at terskler må oppfylles for at dataelementer skal beholdes eller forkastes, osv. Hos Spirit of Satoshi gjør vi en blanding av begge, og jeg antar at vi får se hvor effektivt det er i løpet av de kommende månedene.

Nå ... når du har fått disse vakre rene dataene ut, slutten av denne "rørledning," du må da format det nok en gang som forberedelse til "trening" en modell.

Dette siste stadiet er der de grafiske prosesseringsenhetene (GPUer) kommer inn i bildet, og det er egentlig det folk flest tenker på når de hører om å bygge språkmodeller. Alle de andre tingene jeg dekket blir generelt ignorert.

Dette hjemme-stretch-stadiet innebærer å trene en serie modeller, og leke med parameterne, datablandingene, datakvantumet, modelltypene osv. Dette kan fort bli dyrt, så det er best å ha noen jævla gode data og det er bedre å starte med mindre modeller og bygge deg oppover.

Det hele er eksperimentelt, og det du får ut i den andre enden er... et resultat…

Det er utrolig de tingene vi mennesker tryller frem. Uansett…

Hos Spirit of Satoshi er resultatet fortsatt under utvikling, og vi jobber med det på et par måter:

- Vi ber frivillige hjelpe oss med å samle inn og kuratere de mest relevante dataene for modellen. Vi gjør det kl Nakamoto-depotet. Dette er et oppbevaringssted for hver bok, essay, artikkel, blogg, YouTube-video og podcast om og relatert til Bitcoin, og periferiutstyr som verkene til Friedrich Nietzsche, Oswald Spengler, Jordan Peterson, Hans-Hermann Hoppe, Murray Rothbard, Carl Jung, Bibelen osv.

Du kan søke etter hva som helst der og få tilgang til URL, tekstfil eller PDF. Hvis en frivillig ikke finner noe, eller føler at det må inkluderes, kan de "legge til" en post. Hvis de imidlertid legger til søppel, blir det ikke akseptert. Ideelt sett vil frivillige sende inn dataene som en .txt-fil sammen med en lenke.

- Fellesskapsmedlemmer kan også faktisk hjelpe oss med å rense dataene og tjene sats. Husker du det misjonærstadiet jeg nevnte? Vel, dette er det. Vi ruller ut en hel verktøykasse som en del av dette, og deltakerne vil kunne spille «FUD buster» og «rank replies» og alt mulig annet. Foreløpig er det som en Tinder-aktig keep/cast/comment-opplevelse på datagrensesnitt for å rydde opp i det som er i pipelinen.

Dette er en måte for folk som har brukt år på å lære om og forstå Bitcoin, for å forvandle dette "arbeidet" til innsats. Nei, de kommer ikke til å bli rike, men de kan bidra til å bidra til noe de kanskje anser som et verdig prosjekt, og tjene noe på veien.

Sannsynlighetsprogrammer, ikke AI

I noen få tidligere essays har jeg hevdet at "kunstig intelligens" er et mangelfullt begrep, fordi selv om det is kunstig, er det ikke intelligent - og dessuten har fryktpornoen rundt kunstig generell intelligens (AGI) vært helt ubegrunnet fordi det bokstavelig talt ikke er noen risiko for at denne tingen spontant blir sansende og dreper oss alle. Noen måneder senere, og jeg er enda mer overbevist om dette.

Jeg tenker tilbake på John Carters utmerkede artikkel "Jeg er allerede lei av generativ AI" og han var så spot on.

Det er egentlig ikke noe magisk, eller intelligent for den saks skyld, med noen av disse AI-tingene. Jo mer vi leker med det, jo mer tid vi bruker på å bygge vår egen, jo mer innser vi at det ikke er noen sans her. Det er ingen faktisk tenkning eller resonnement som skjer. Det er ikke noe byrå. Dette er bare "sannsynlighetsprogrammer."

Måten de er merket på, og begrepene som kastes rundt, enten det er "AI" eller "maskin læring” eller “agenter,” er faktisk der mesteparten av frykten, usikkerheten og tvilen ligger.

Disse etikettene er bare et forsøk på å beskrive et sett med prosesser, som egentlig er ulikt noe et menneske gjør. Problemet med språk er at vi umiddelbart begynner å antropomorfisere det for å forstå det. Og i ferd med å gjøre det, er det publikum eller lytteren som blåser liv i Frankensteins monster.

AI har Nei. annet liv enn det du gir det med din egen fantasi. Dette er omtrent det samme med enhver annen imaginær, eskatologisk trussel.

(Sett inn eksempler rundt klimaendringer, romvesener eller hva annet som skjer på Twitter/X.)

Dette er selvfølgelig veldig nyttig for globo-homo-byråkrater som ønsker å bruke et slikt verktøy/program/maskin til sine egne formål. De har snurret historier og fortellinger siden før de kunne gå, og dette er bare den siste å snurre. Og fordi folk flest er lemen og vil tro hva enn noen som høres noen få IQ-poeng smartere enn dem har å si, vil de bruke det til sin fordel.

Jeg husker at jeg snakket om at reguleringen kommer på trappene. Jeg la merke til at forrige uke eller uken før, er det nå "offisielle retningslinjer" eller noe lignende for generativ AI - med tillatelse fra våre byråkratiske overherrer. Hva dette betyr er det ingen som egentlig vet. Det er maskert i det samme useriøse språket som alle deres andre forskrifter er. Nettoresultatet er nok en gang: "Vi skriver reglene, vi får bruke verktøyene slik vi vil, du må bruke det slik vi forteller deg det, ellers."

Den mest latterlige delen er at en haug med mennesker jublet over dette, og tenkte at de på en eller annen måte er tryggere fra det imaginære monsteret som aldri var. Faktisk vil de sannsynligvis kreditere disse byråene med å "redde oss fra AGI" fordi det aldri ble noe av.

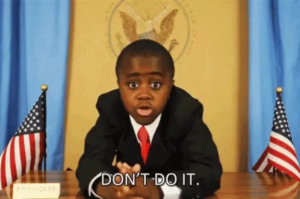

Det minner meg om dette:

Da jeg la ut bildet ovenfor på Twitter, fortalte mengden av idioter som reagerte med ekte tro på at unngåelsen av disse katastrofene var et resultat av økt byråkratisk intervensjon meg alt jeg trengte å vite om nivået av kollektiv etterretning på den plattformen.

Likevel, her er vi. Igjen. Samme historie, nye karakterer.

Akk, det er egentlig lite vi kan gjøre med det, annet enn å fokusere på våre egne ting. Vi vil fortsette å gjøre det vi har satt oss for å gjøre.

Jeg har blitt mindre begeistret for «GenAI» generelt, og jeg har en følelse av at mye av hypen avtar etter hvert som folks oppmerksomhet beveger seg over på romvesener og politikk igjen. Jeg er også mindre overbevist om at det er noe vesentlig transformativt her - i hvert fall i den grad jeg trodde for seks måneder siden. Kanskje jeg blir bevist feil. Jeg tror disse verktøyene har latent, uutnyttet potensial, men det er bare det: latent.

Jeg tror vi må være mer realistiske om hva de er (i stedet for kunstig intelligens, er det bedre å kalle dem "sannsynlighetsprogrammer") og det kan faktisk bety at vi bruker mindre tid og energi på pipe dreams og fokuserer mer på å bygge nyttige applikasjoner. Sånn sett forblir jeg nysgjerrig og forsiktig optimistisk på at noe virkelig materialiserer seg, og tror at et eller annet sted i forbindelsen med Bitcoin, sannsynlighetsprogrammer og protokoller som Nostr, vil noe veldig nyttig dukke opp.

Jeg håper at vi kan ta del i det, og jeg vil gjerne at du også tar del i det hvis du er interessert. Til det formål skal jeg overlate dere alle til dagen deres, og håper dette var en nyttig 10-minutters innsikt i hva som kreves for å bygge en språkmodell.

Dette er et gjesteinnlegg av Aleksander Svetski. Uttrykte meninger er helt deres egne og reflekterer ikke nødvendigvis meningene til BTC Inc eller Bitcoin Magazine.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- ChartPrime. Hev handelsspillet ditt med ChartPrime. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://bitcoinmagazine.com/culture/how-to-build-your-own-bitcoin-language-model

- : har

- :er

- :ikke

- :hvor

- $OPP

- 7

- a

- I stand

- Om oss

- ovenfor

- akseptert

- adgang

- aktører

- faktiske

- faktisk

- legge til

- Fordel

- en gang til

- byråer

- byrå

- AGI

- siden

- AI

- algoritmer

- romvesener

- Alle

- langs

- allerede

- også

- am

- beløp

- an

- og

- besvare

- svar

- noen

- hva som helst

- app

- søknader

- verdsette

- tilnærming

- ER

- argumentert

- Army

- rundt

- Artikkel

- kunstig

- kunstig generell intelligens

- kunstig intelligens

- AS

- At

- oppmerksomhet

- publikum

- forfatter

- tilbake

- dårlig

- BE

- vakker

- fordi

- bli

- bli

- vært

- før du

- begynne

- være

- tro

- tro

- BEST

- Bedre

- Bias

- Bit

- Bitcoin

- Bitcoin-fellesskap

- Bitcoin Magazine

- bitcoin standard

- Blend

- blander

- Blogg

- bok

- Bored

- både

- BTC

- BTC Inc.

- bygge

- Bygning

- bygget

- Bunch

- byråkratisk

- men

- by

- ring

- CAN

- kan ikke

- Carl

- saken

- saker

- katastrofer

- forsiktig

- endring

- endret

- tegn

- ChatGPT

- Klima

- Klima forandringer

- samle

- samling

- Collective

- Kom

- kommer

- kommer

- samfunnet

- helt

- Tilkobling

- Konsensus

- kontekst

- sammenhenger

- fortsette

- fortsetter

- bidra

- Samtale

- overbevist

- Kul

- kunne

- Par

- Kurs

- dekket

- kreditt

- Crunchbase

- nysgjerrig

- dato

- Database

- dag

- håndtering

- anser

- Grad

- beskrive

- beskrevet

- detalj

- Bestem

- differensiere

- do

- gjør

- ikke

- gjør

- ikke

- tviler

- ned

- drømmer

- under

- tjene

- Redaksjonell

- Effektiv

- ellers

- dukke

- slutt

- energi

- nok

- sikre

- fullstendig

- spesielt

- ESSAY

- etc

- Selv

- Event

- Hver

- alle

- eksempel

- eksempler

- utmerket

- opphisset

- dyrt

- erfaring

- eksperimentell

- Forklar

- uttrykte

- Faktisk

- frykt

- fôring

- føler

- Noen få

- filet

- slutt~~POS=TRUNC

- Finn

- feil

- Fokus

- Til

- format

- Fundament

- Grunnleggeren

- fra

- fullt

- morsomt

- Dess

- framtid

- general

- generell intelligens

- generelt

- generert

- generative

- Generativ AI

- ekte

- få

- Gi

- Go

- Går

- skal

- god

- GPU

- takknemlig

- Gjest

- gjest innlegg

- HAD

- Hans Hermann Hoppe

- Skjer

- Hard

- Ha

- he

- høre

- hørt

- hjelpe

- her.

- historie

- hold

- håp

- håpefull

- Hvordan

- Hvordan

- http

- HTTPS

- menneskelig

- Mennesker

- Hype

- i

- JEG VIL

- Tanken

- ideelt sett

- if

- innbilt

- fantasi

- forestille

- umiddelbart

- umulig

- in

- inkludert

- økt

- utrolig

- utrolig

- individer

- informasjon

- innganger

- innsikt

- i stedet

- Intelligens

- Intelligent

- interessert

- Interface

- intern

- intervensjon

- inn

- forviklinger

- involvert

- saker

- IT

- varer

- John

- Jordan

- Jordan Peterson

- jpg

- bare

- Hold

- holdt

- Type

- Vet

- etiketter

- Språk

- Siste

- siste

- læring

- minst

- Permisjon

- venstre

- mindre

- Nivå

- ligger

- Life

- i likhet med

- Sannsynlig

- LINK

- lytteren

- lite

- laster

- Lot

- elsker

- magazine

- Mainstream

- gjøre

- Making

- manuelt

- mange

- mange folk

- materialiserer

- Saken

- me

- bety

- midler

- medlemmer

- nevnt

- møtte

- Microsoft

- kunne

- Oppdrag

- modell

- modeller

- modifisere

- penger

- måneder

- mer

- mest

- trekk

- mye

- flere

- Murray

- må

- nakamoto

- fortellinger

- nødvendigvis

- nødvendig

- Trenger

- nødvendig

- behov

- nett

- aldri

- Ny

- nexus

- Nei.

- Bråk

- Vår

- ingenting

- Legge merke til..

- nå

- of

- off

- ofte

- on

- gang

- ONE

- bare

- videre til

- OpenAI

- Mening

- Meninger

- Optimistisk

- or

- rekkefølge

- Annen

- vår

- ut

- egen

- betalt

- par

- parametere

- del

- deltakere

- Ansatte

- folks

- utfører

- kanskje

- periferiutstyr

- Peterson

- bilde

- brikke

- rør

- rørledning

- planet

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- Spille

- spiller

- podcast

- poeng

- politikk

- Post

- postet

- potensiell

- forberedelse

- forrige

- sannsynligvis

- Problem

- prosess

- Prosesser

- prosessering

- produsere

- programmer

- prosjekt

- protokoller

- utprøvd

- formål

- kvalitet

- kvantitet

- Quantum

- spørsmål

- raskt

- Rage

- Raw

- ekte

- realistisk

- realisere

- virkelig

- rekord

- reflektere

- Regulering

- forskrifter

- i slekt

- relevant

- forbli

- husker

- Repository

- Svare

- svar

- resultere

- retur

- Rich

- Risiko

- rullende

- regler

- sikrere

- samme

- Satoshi

- satser

- sier

- Skala

- skraper

- Skjerm

- Søk

- se

- synes

- forstand

- Serien

- sett

- bør

- lignende

- Enkelt

- siden

- sitter

- SIX

- Seks måneder

- mindre

- smartere

- So

- LØSE

- noen

- Noen

- noe

- et sted

- bruke

- brukt

- Snurre rundt

- ånd

- splittet

- Spot

- Scene

- Standard

- ståsted

- Start

- Still

- lagret

- Stories

- Story

- emne

- send

- i det vesentlige

- slik

- rundt

- Ta

- tar

- ta

- Snakk

- snakker

- fortelle

- begrep

- vilkår

- enn

- Det

- De

- deres

- Dem

- deretter

- Der.

- Disse

- de

- ting

- ting

- tror

- tenker

- denne

- De

- selv om?

- trodde

- trussel

- Gjennom

- tid

- til

- Toolbox

- verktøy

- mot

- Kurs

- Transform

- transformative

- prøve

- typer

- Usikkerhet

- underliggende

- forstå

- forståelse

- lomper

- I motsetning til

- uutnyttet

- til

- URL

- us

- bruke

- brukt

- veldig

- video

- frivillig

- frivillige

- ønsker

- ønsket

- var

- Vei..

- måter

- we

- webp

- uke

- VI VIL

- Hva

- uansett

- når

- om

- hvilken

- mens

- HVEM

- hele

- hvorfor

- vil

- med

- Arbeid

- arbeid

- virker

- ville

- skrive

- Feil

- år

- ennå

- Du

- Din

- youtube

- zephyrnet