Tim Palmer sier at vi må samle ressursene våre for å produsere høyoppløselige klimamodeller som samfunn kan bruke, før det er for sent

Det var en brennhet i fjor. Temperaturen på land og hav var opptil 0.2 °C høyere hver eneste måned i andre halvdel av 2023, med disse varme anomaliene som fortsatte inn i 2024. Vi vet at verden varmes opp, men den plutselige hetepiken var ikke forutsagt. Som NASA klimaforsker Gavin Schmidt skrev in Natur nylig: "Det er ydmykende og litt bekymringsfullt å innrømme at ingen år har forvirret klimaforskeres prediksjonsevne mer enn 2023 har gjort."

Som Schmidt fortsatte med å forklare, hadde en periode med rekordstor varme blitt ansett som "usannsynlig" til tross for at 2023 var et El Niño-år, der det relativt kjølige vannet i det sentrale og østlige ekvatoriale Stillehavet er erstattet med varmere vann. Problemet er at de komplekse interaksjonene mellom atmosfærisk dyp konveksjon og ekvatoriale moduser for havvariabilitet, som ligger bak El Niño, er dårlig løst i konvensjonelle klimamodeller.

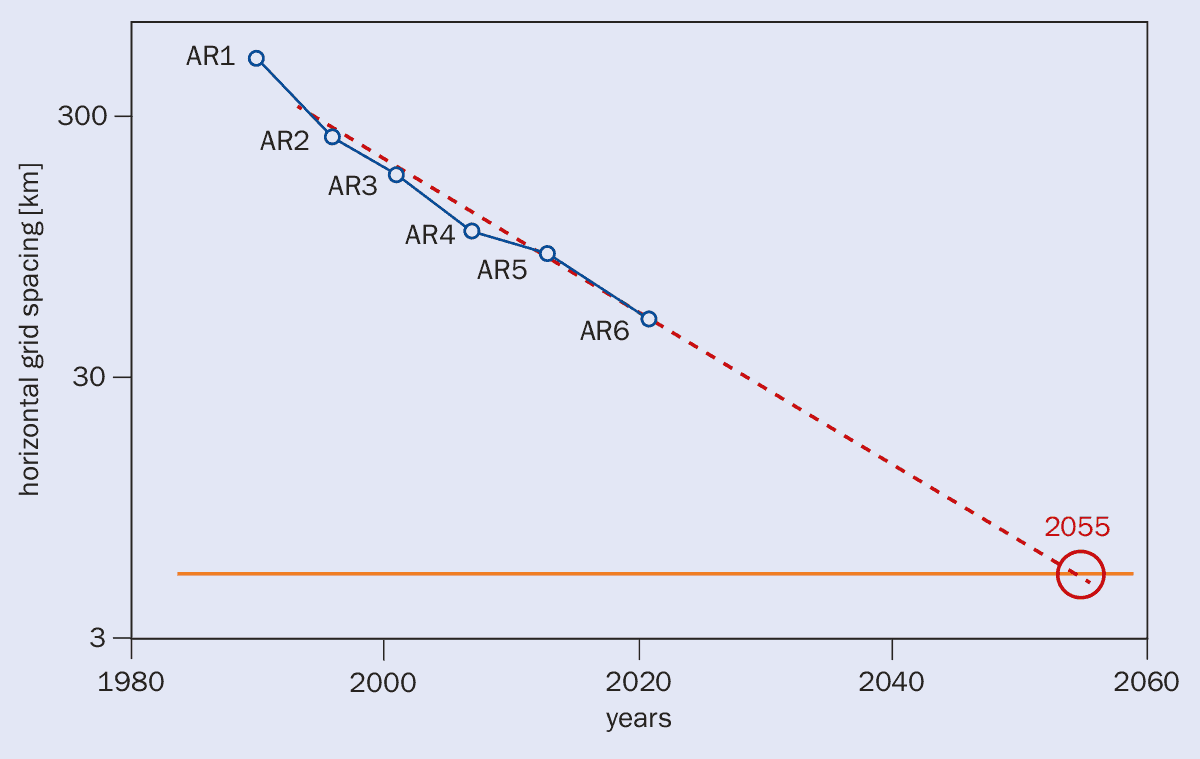

Vår manglende evne til å simulere El Niño riktig med dagens klimamodeller (J. Klima 10.1175/JCLI-D-21-0648.1) er symptomatisk for et mye større problem. I 2011 argumenterte jeg for at moderne klimamodeller ikke var gode nok til å simulere den skiftende naturen til ekstremvær som tørke, hetebølger og flom (se "Et CERN for klimaendringer” Mars 2011 s13). Med rutenett-punktavstander vanligvis rundt 100 km, gir disse modellene et uklart, forvrengt syn på fremtidens klima. For variabler som nedbør, de systematiske feilene forbundet med så lav romlig oppløsning er større enn klimaendringens signaler som modellene forsøker å forutsi.

Pålitelige klimamodeller er avgjørende for at samfunn kan tilpasse seg klimaendringene, vurdere hvor haster det er å nå netto-null eller implementere geoengineering-løsninger hvis ting blir virkelig ille. Men hvordan er det mulig å tilpasse seg hvis vi ikke vet om tørke, hetebølger, stormer eller flom utgjør den største trusselen? Hvordan vurderer vi at det haster med net-null hvis modellene ikke kan simulere "tipping"-punkter? Hvordan er det mulig å bli enige om potensielle geoingeniørløsninger hvis det ikke er mulig å pålitelig vurdere om sprøyting av aerosoler i stratosfæren vil svekke monsunene eller redusere fukttilførselen til de tropiske regnskogene? Klimamodellører må ta spørsmålet om mangelfulle modeller mye mer alvorlig hvis de ønsker å gi samfunnet pålitelig handlingskraftig informasjon om klimaendringer.

Jeg konkluderte i 2011 med at vi trengte å utvikle globale klimamodeller med romlig oppløsning på rundt 1 km (med kompatibel tidsmessig oppløsning), og den eneste måten å oppnå dette på er å slå sammen menneskelige og dataressurser for å opprette ett eller flere internasjonalt forente institutter. Med andre ord trenger vi et «CERN for klimaendringer» – en innsats inspirert av partikkelfysikkanlegget nær Genève, som har blitt et emblem for internasjonalt samarbeid og fremgang.

Det var 13 år siden, og siden den gang har naturen snakket med hevn. Vi har sett enestående hetebølger, stormer og flom, så mye at World Economic Forum vurderte "ekstremvær" som den mest sannsynlige globale begivenheten å utløse en økonomisk krise i årene som kommer. Som fremtredende klimaforsker Michael Mann bemerket i 2021 etter en ødeleggende flom i Nord-Europa: "Klimaendringssignalet kommer fra støyen raskere enn modellene forutså." Det synet ble støttet av en orienteringsnotat fra Royal Society for COP26 klimaendringsmøtet holdt i Glasgow i 2021, som uttalte at manglende evne til å simulere fysiske prosesser i fine detaljer står for "de mest betydelige usikkerhetene i fremtidens klima, spesielt på regionalt og lokalt nivå".

Likevel har ikke modelleringsforbedringer holdt tritt med den skiftende naturen til disse ekstremene i den virkelige verden. Mens mange nasjonale klimamodelleringssentre endelig har startet arbeidet med høyoppløselige modeller, vil det på nåværende trender ta til andre halvdel av århundret å nå kilometerskala oppløsning. Dette vil være for sent til at det er nyttig å takle klimaendringene (se figuren nedenfor), og det haster mer enn noen gang.

En klima-EVE

Samling av menneskelige ressurser og dataressurser internasjonalt er en løsning som virker åpenbar. I en anmeldelse av britisk vitenskap i 2023, nobelprisvinneren Paul Nurse kommenterte at "det er forskningsområder av global strategisk betydning der nye multinasjonalt finansierte institutter eller internasjonale forskningsinfrastrukturer kan vurderes, et åpenbart eksempel er et institutt for klimaendringer bygget på EMBL [European Molecular Biology Laboratory]-modellen". Han la til at "slike institutter er kraftige verktøy for multinasjonalt samarbeid og gir stor fordel ikke bare internasjonalt, men også for vertsnasjonen".

Så hvorfor har det ikke skjedd? Noen sier at vi ikke trenger mer vitenskap og i stedet må bruke penger på å hjelpe de som allerede lider av klimaendringer. Det er sant, men datamodeller har hjulpet sårbare samfunn enormt gjennom årene. Før 1980-tallet kunne dårlig varslede tropiske sykloner drepe hundretusenvis av mennesker i sårbare samfunn. Nå, med forbedret modelloppløsning, kan utmerkede ukesprognoser (og muligheten til å kommunisere prognosene) lages, og det er sjelden at mer enn noen titalls mennesker blir drept av ekstremvær.

Klimamodeller med høy oppløsning vil bidra til å målrette milliarder av investeringsdollar for å la sårbare samfunn bli motstandsdyktige mot regionalt spesifikke typer fremtidig ekstremvær. Uten denne informasjonen kan regjeringer sløse bort enorme mengder penger på feiltilpasning. Faktisk, forskere fra det globale sør allerede klager at de ikke har brukbar informasjon fra moderne modeller for å ta informerte beslutninger.

Andre sier at forskjellige modeller er nødvendige, slik at når de alle er enige, kan vi være trygge på deres spådommer. Den nåværende generasjonen av klimamodeller er imidlertid ikke mangfoldig i det hele tatt. De antar alle at kritisk viktige sub-grid klimatiske prosesser som dyp konveksjon, flyt over orografi og havblanding av mesoskala virvler kan parametriseres med enkle formler. Denne antagelsen er feil og er opphavet til vanlige systematiske feil i moderne modeller. Det er bedre å representere modellusikkerhet med mer vitenskapelig forsvarlige metoder.

Et skifte kan imidlertid være i horisonten. I fjor ble det holdt et klimatoppmøte i Berlin for å kickstarte det internasjonale prosjektet Earth Visualization Engines (EVE). Den har som mål å ikke bare lage høyoppløselige modeller, men også fremme samarbeid mellom forskere fra det globale nord og sør for å jobbe sammen for å få nøyaktig, pålitelig og handlingskraftig klimainformasjon.

I likhet med EMBL, er det planlagt at EVE vil omfatte en serie av svært sammenkoblede noder, hver med dedikert exascale databehandlingsevne, og betjene hele det globale samfunnet. Finansieringen for hver node – rundt 300 millioner dollar per år – er liten sammenlignet med de billioner av dollar i tap og skade som klimaendringer vil forårsake.

Forhåpentligvis vil EVE eller noe lignende om ytterligere 13 år produsere de pålitelige klimaspådommene som samfunn over hele kloden nå sårt trenger. Hvis ikke, så frykter jeg at det vil være for sent.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://physicsworld.com/a/why-we-still-need-a-cern-for-climate-change/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 1

- 10

- 100

- 13

- 2011

- 2021

- 2023

- 2024

- 7

- a

- evne

- Om oss

- kontoer

- nøyaktig

- Oppnå

- handlings

- tilpasse

- la til

- innrømme

- siden

- mål

- Alle

- tillate

- allerede

- også

- beløp

- an

- og

- abnormiteter

- En annen

- ER

- områder

- argumentert

- rundt

- AS

- vurdere

- evaluering

- anta

- forutsetningen

- At

- atmosfærisk

- forsøk

- Backed

- dårlig

- basert

- BE

- bli

- vært

- før du

- bak

- være

- under

- nytte

- Berlin

- Bedre

- mellom

- større

- milliarder

- biologi

- Bit

- bringe

- bygget

- men

- by

- CAN

- kan ikke

- evner

- evne

- Årsak

- sentrum

- sentral

- sentre

- Århundre

- endring

- endring

- klikk

- Klima

- Klima forandringer

- CNN

- samarbeid

- kommer

- Felles

- kommunisere

- sammenlignet

- kompatibel

- komplekse

- datamaskin

- databehandling

- konkluderte

- trygg

- overveid

- moderne

- fortsetter

- konvensjonell

- Kul

- kunne

- skape

- krise

- Gjeldende

- skade

- avgjørelser

- dedikert

- anses

- dyp

- desperat

- Til tross for

- detalj

- ødeleggende

- utvikle

- forskjellig

- diverse

- do

- dollar

- ikke

- hver enkelt

- østlige

- økonomisk

- økonomisk krise

- Økonomisk forum

- innsats

- el

- Emery

- nok

- feil

- spesielt

- Europa

- europeisk

- eve

- NOEN GANG

- Hver

- eksempel

- Eksascale

- Exascale Computing

- utmerket

- Forklar

- ekstrem

- ytterpunktene

- Facility

- falsk

- raskere

- frykt

- forent

- Noen få

- Figur

- Endelig

- slutt

- flom

- flyten

- etter

- Til

- Varsel

- prognoser

- Forum

- Foster

- fra

- finansierte

- finansiering

- framtid

- gavin

- generasjonen

- Genève

- få

- Global

- globus

- god

- regjeringer

- graf

- flott

- større

- HAD

- Halvparten

- skjedde

- Ha

- he

- Held

- hjelpe

- hjulpet

- hjelpe

- Høy

- høy oppløsning

- høyere

- svært

- horisont

- vert

- Hvordan

- Men

- HTML

- HTTPS

- menneskelig

- Hundrevis

- i

- if

- bilde

- Påvirkning

- iverksette

- betydning

- viktig

- forbedret

- forbedringer

- in

- I andre

- manglende evne

- faktisk

- informasjon

- informert

- infrastruktur

- inspirert

- i stedet

- Institute

- interaksjoner

- sammenhengende

- internasjonalt

- internasjonalt

- inn

- investering

- utstedelse

- IT

- jpg

- holdt

- Drepe

- Vet

- laboratorium

- Tomt

- større

- Siste

- I fjor

- Late

- løgn

- i likhet med

- Sannsynlig

- lite

- lokal

- tap

- Lav

- laget

- gjøre

- mange

- Mars

- massivt

- max bredde

- møte

- Michael

- Blanding

- modell

- modellering

- modeller

- moduser

- molekyl~~POS=TRUNC

- penger

- Måned

- mer

- Marokko

- mest

- mye

- multinasjonale

- må

- Nasa

- nasjonal

- Natur

- Nær

- nødvendig

- Trenger

- nødvendig

- net null-

- Ny

- Nei.

- node

- noder

- Bråk

- nord

- nå

- få

- Åpenbare

- hav

- of

- on

- ONE

- bare

- åpen

- or

- opprinnelse

- original

- Annen

- vår

- enn

- Fred

- Pacific

- Stillehavet

- panel

- paul

- Ansatte

- for

- fysisk

- Fysikk

- Fysikkens verden

- planlagt

- plato

- Platon Data Intelligence

- PlatonData

- poeng

- basseng

- mulig

- potensiell

- kraftig

- forutsi

- spådd

- Spådommer

- Problem

- Prosesser

- produsere

- produserende

- Progress

- prosjekt

- fremtredende

- riktig

- gi

- Publisering

- SJELDEN

- karakter

- å nå

- nå

- virkelige verden

- virkelig

- nylig

- redusere

- regional

- regionalt

- relativt

- pålitelig

- erstattet

- Rapporter

- representere

- påkrevd

- forskning

- spenstig

- oppløsning

- løst

- Ressurser

- anmeldelse

- kongelig

- sier

- sier

- Vitenskap

- Forsker

- forskere

- SEA

- Sekund

- se

- synes

- sett

- Serien

- alvor

- tjeneste

- servering

- skift

- Signal

- signaler

- signifikant

- lignende

- Enkelt

- simulere

- siden

- enkelt

- liten

- So

- Samfunnet

- løsning

- Solutions

- noen

- noe

- Lyd

- Sør

- romlig

- spesifikk

- TRYLLEFORMEL

- bruke

- spike

- talt

- startet

- uttalte

- Still

- stormer

- Strategisk

- stratosfæren

- gate

- slik

- plutselig

- lidelse

- Summit

- levere

- takle

- Ta

- Target

- titus

- enn

- Det

- De

- Fremtiden

- verden

- deres

- deretter

- Disse

- de

- ting

- denne

- De

- tusener

- trussel

- thumbnail

- tid

- til

- sammen

- også

- verktøy

- Trender

- utløse

- billioner

- problemer

- sant

- typer

- typisk

- Uk

- usikkerheter

- Usikkerhet

- enestående

- til

- hastverk

- bruke

- brukt

- nyttig

- enorme

- Se

- syn

- Sårbar

- varm

- varmere

- varme

- var

- Waters

- bølger

- Vei..

- we

- Vær

- gikk

- var

- når

- om

- hvilken

- mens

- hvorfor

- vil

- Vinner

- ønske

- med

- uten

- ord

- Arbeid

- arbeide sammen

- verden

- World Economic Forum

- bekymringsfull

- skrev

- XML

- år

- år

- ennå

- zephyrnet