I dag er vi glade for å kunngjøre at Llama 2-fundamentmodeller utviklet av Meta er tilgjengelige for kunder gjennom Amazon SageMaker JumpStart. Llama 2-familien av store språkmodeller (LLM) er en samling av forhåndstrente og finjusterte generative tekstmodeller som varierer i skala fra 7 milliarder til 70 milliarder parametere. Finjusterte LLM-er, kalt Llama-2-chat, er optimalisert for brukstilfeller for dialog. Du kan enkelt prøve ut disse modellene og bruke dem med SageMaker JumpStart, som er en maskinlæringshub (ML) som gir tilgang til algoritmer, modeller og ML-løsninger slik at du raskt kan komme i gang med ML.

I dette innlegget går vi gjennom hvordan du bruker Llama 2-modeller via SageMaker JumpStart.

Hva er Llama 2

Llama 2 er en autoregressiv språkmodell som bruker en optimalisert transformatorarkitektur. Llama 2 er beregnet for kommersiell bruk og forskningsbruk på engelsk. Den kommer i en rekke parameterstørrelser – 7 milliarder, 13 milliarder og 70 milliarder – så vel som forhåndstrente og finjusterte variasjoner. I følge Meta bruker de innstilte versjonene overvåket finjustering (SFT) og forsterkningslæring med menneskelig tilbakemelding (RLHF) for å tilpasse seg menneskelige preferanser for hjelpsomhet og sikkerhet. Llama 2 ble forhåndstrent på 2 billioner tokens med data fra offentlig tilgjengelige kilder. De innstilte modellene er ment for assistent-lignende chat, mens forhåndstrente modeller kan tilpasses for en rekke naturlige språkgenereringsoppgaver. Uavhengig av hvilken versjon av modellen en utvikler bruker, vil ansvarlig bruksveiledning fra Meta kan hjelpe til med å veilede ytterligere finjusteringer som kan være nødvendig for å tilpasse og optimalisere modellene med passende sikkerhetsreduksjoner.

Hva er SageMaker JumpStart

Med SageMaker JumpStart kan ML-utøvere velge fra et bredt utvalg av grunnmodeller med åpen kildekode. ML-utøvere kan distribuere grunnmodeller til dedikerte Amazon SageMaker forekomster fra et nettverksisolert miljø og tilpasse modeller ved hjelp av SageMaker for modellopplæring og distribusjon.

Du kan nå oppdage og distribuere Llama 2 med noen få klikk inn Amazon SageMaker Studio eller programmatisk gjennom SageMaker Python SDK, slik at du kan utlede modellytelse og MLOps-kontroller med SageMaker-funksjoner som f.eks. Amazon SageMaker-rørledninger, Amazon SageMaker Debugger, eller containerlogger. Modellen er distribuert i et AWS-sikkert miljø og under dine VPC-kontroller, noe som bidrar til å sikre datasikkerhet. Llama 2-modeller er tilgjengelig i dag i Amazon SageMaker Studio, først i us-east 1 og us-west 2 regioner.

Oppdag modeller

Du kan få tilgang til grunnmodellene gjennom SageMaker JumpStart i SageMaker Studio UI og SageMaker Python SDK. I denne delen går vi gjennom hvordan du oppdager modellene i SageMaker Studio.

SageMaker Studio er et integrert utviklingsmiljø (IDE) som gir et enkelt nettbasert visuelt grensesnitt der du kan få tilgang til spesialbygde verktøy for å utføre alle ML-utviklingstrinn, fra å forberede data til å bygge, trene og distribuere ML-modellene dine. For mer informasjon om hvordan du kommer i gang og konfigurerer SageMaker Studio, se Amazon SageMaker Studio.

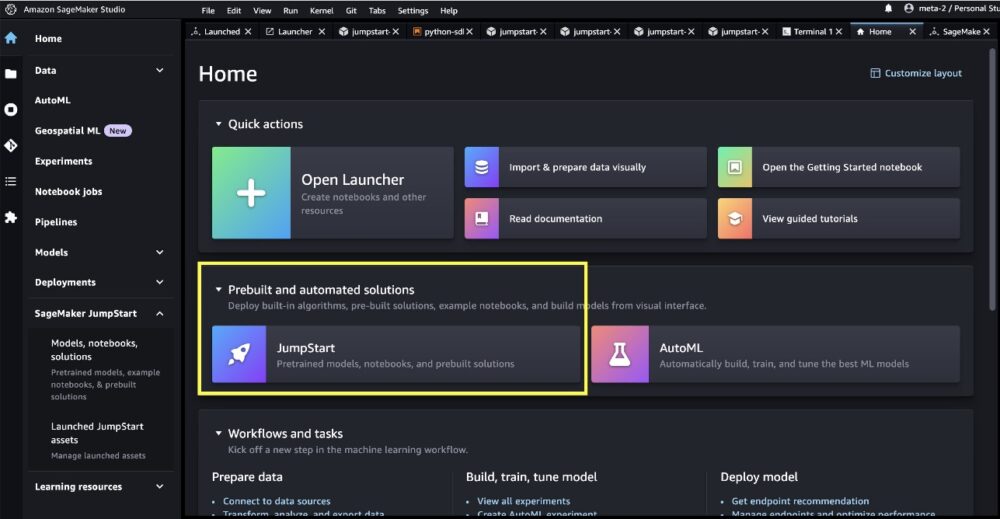

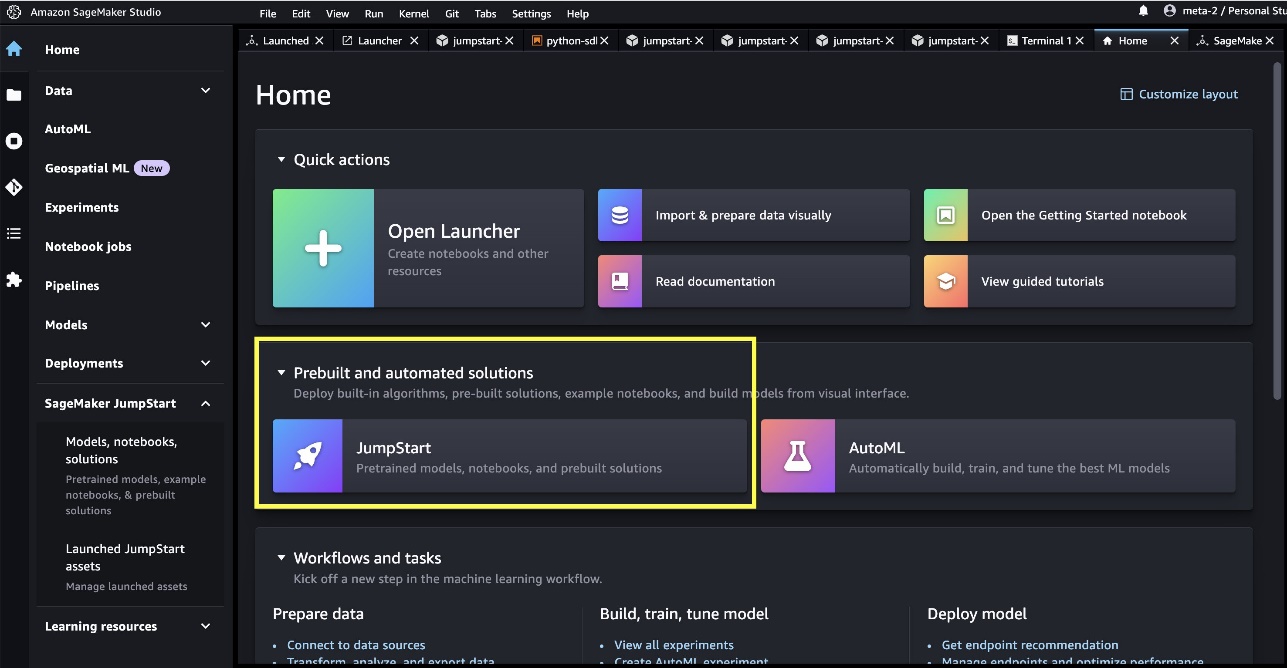

Når du er på SageMaker Studio, kan du få tilgang til SageMaker JumpStart, som inneholder forhåndsopplærte modeller, bærbare datamaskiner og forhåndsbygde løsninger, under Forhåndsbygde og automatiserte løsninger.

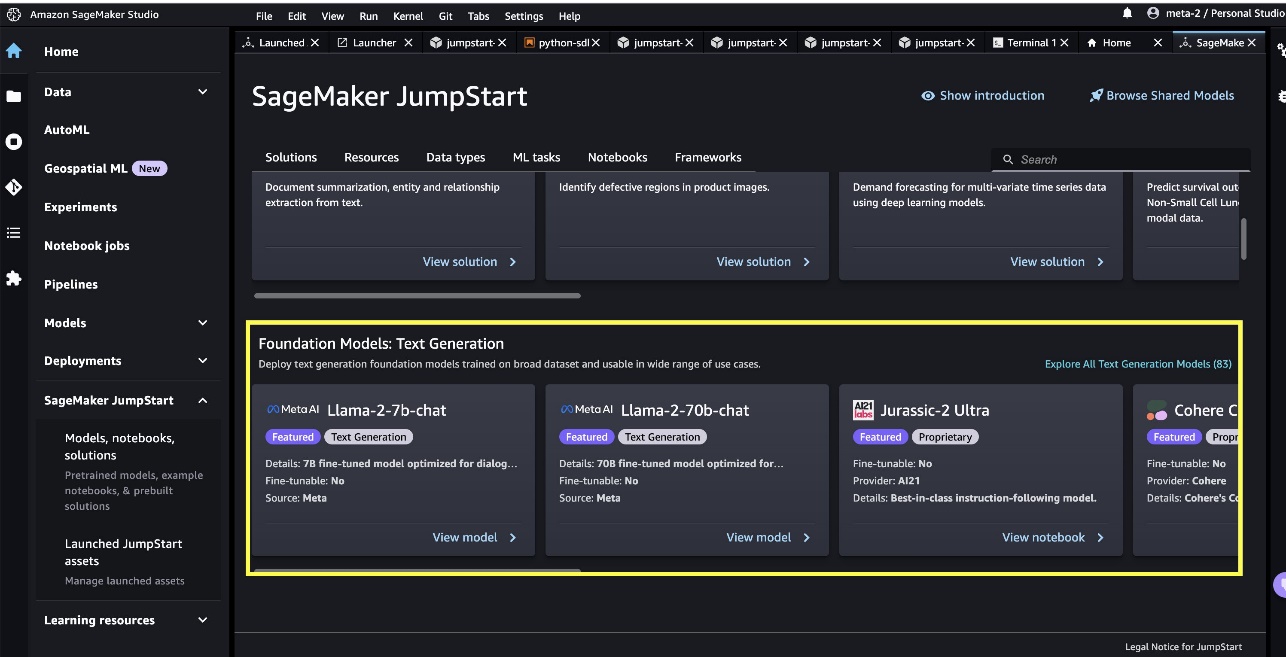

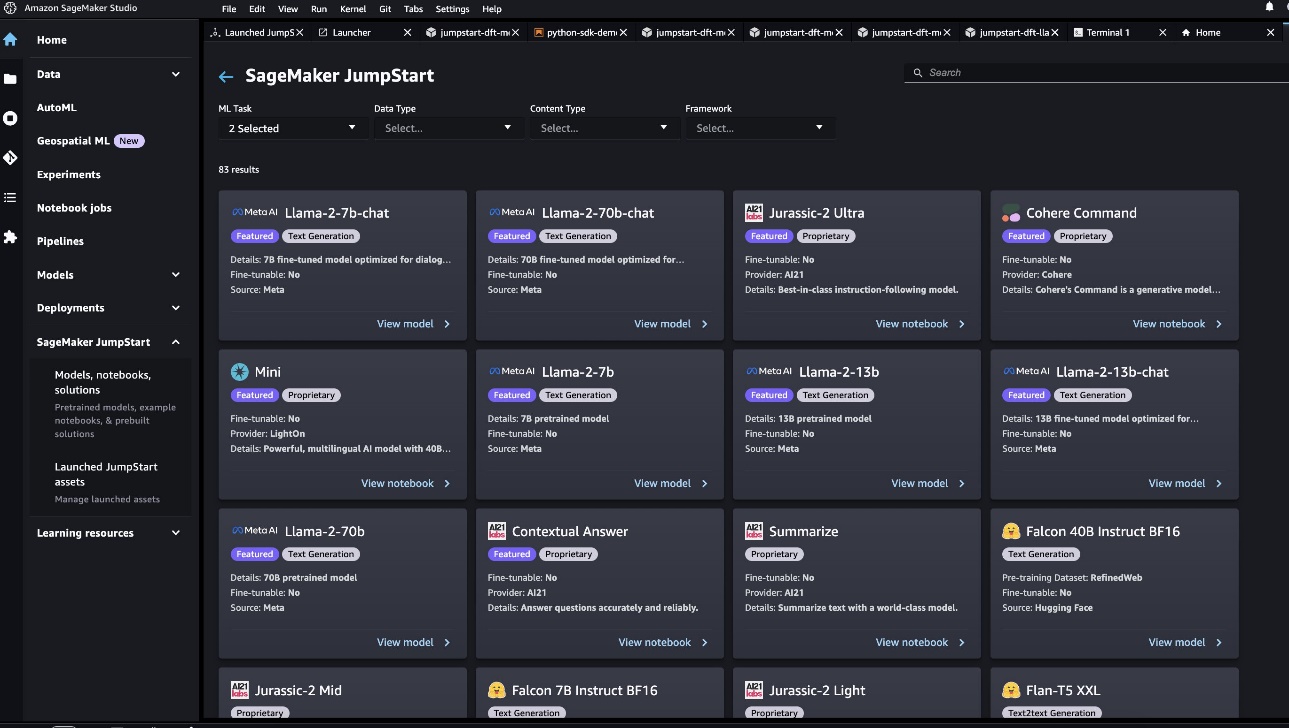

Fra SageMaker JumpStart-landingssiden kan du søke etter løsninger, modeller, notatbøker og andre ressurser. Du kan finne to flaggskip Llama 2-modeller i Fundamentmodeller: Tekstgenerering karusell. Hvis du ikke ser Llama 2-modeller, oppdater SageMaker Studio-versjonen din ved å slå av og starte på nytt. For mer informasjon om versjonsoppdateringer, se Slå av og oppdater Studio-apper.

Du kan også finne andre fire modellvarianter ved å velge Utforsk alle tekstgenerasjonsmodeller eller søker etter llama i søkeboksen.

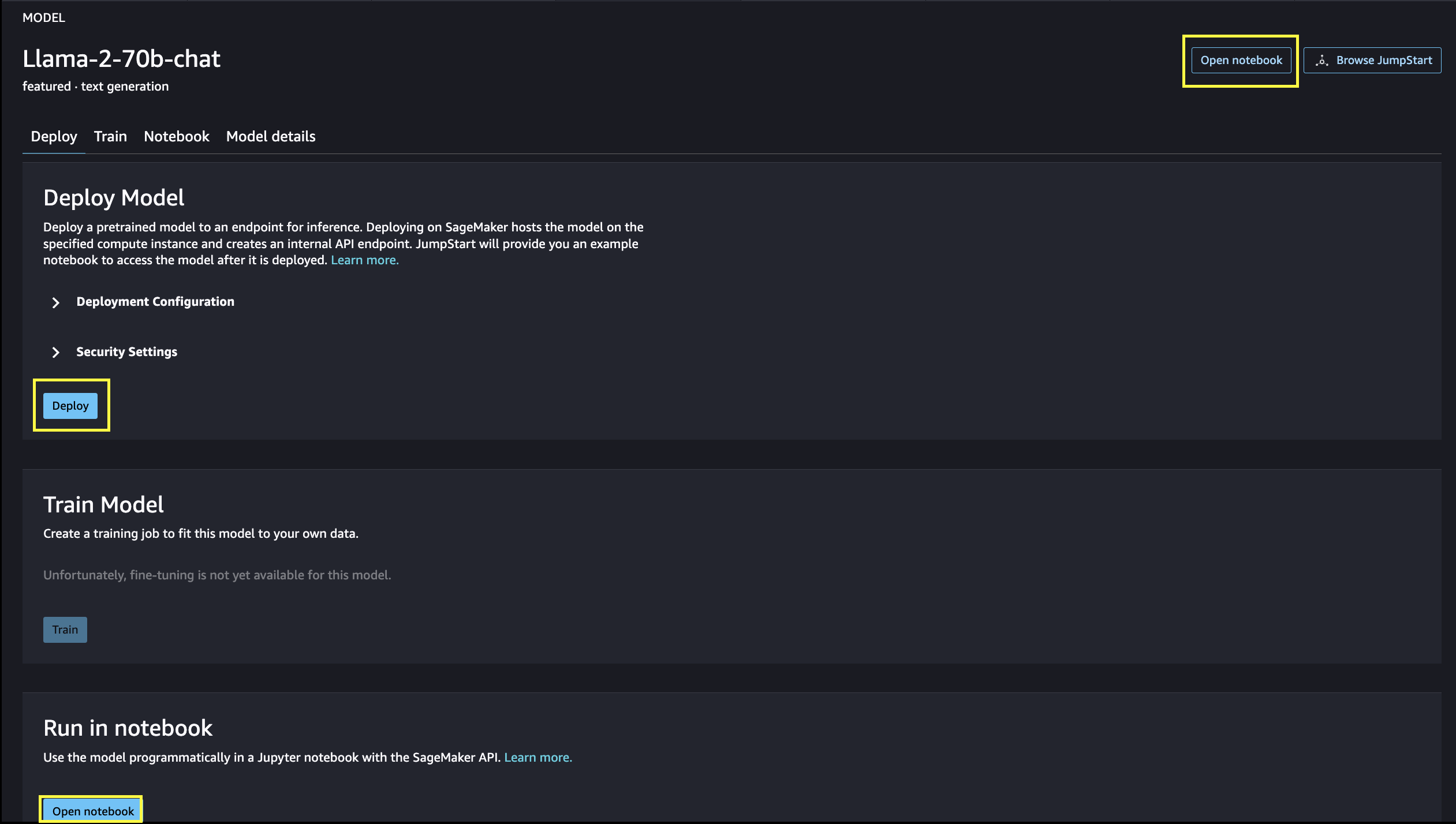

Du kan velge modellkortet for å se detaljer om modellen, for eksempel lisens, data som brukes til å trene, og hvordan du bruker den. Du kan også finne to knapper, Distribuer og Åpne Notebook, som hjelper deg med å bruke modellen.

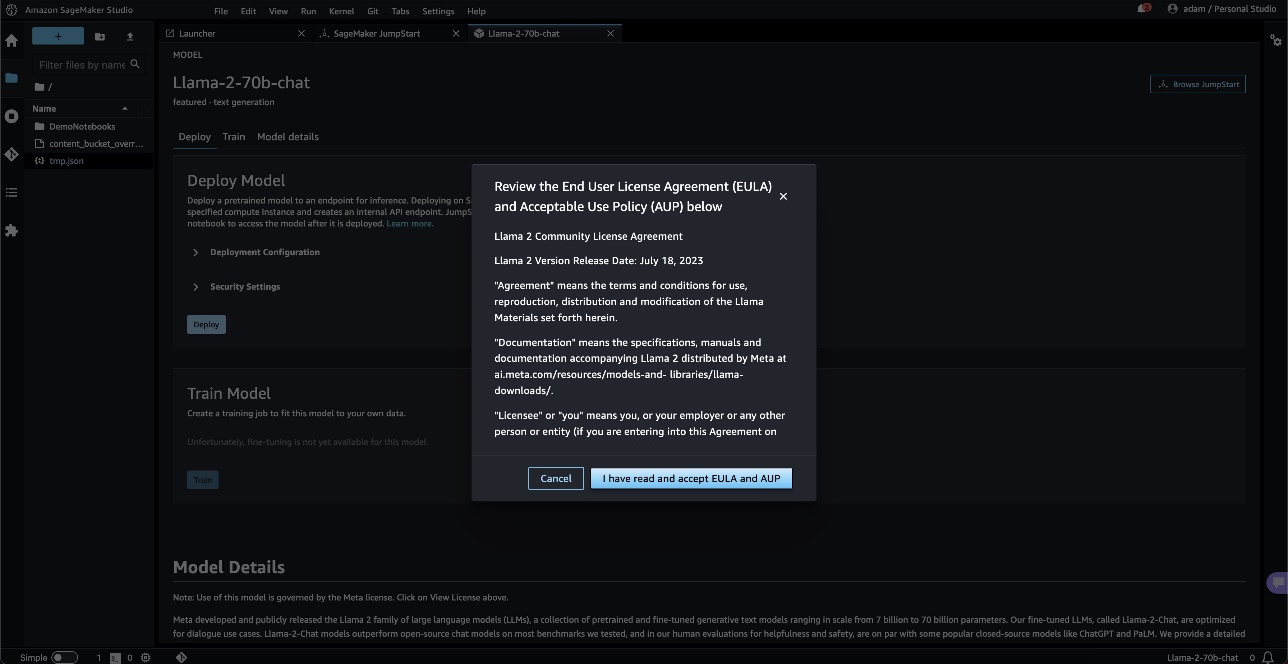

Når du velger en av knappene, vil et popup-vindu vise lisensavtalen for sluttbruker og retningslinjer for akseptabel bruk som du kan bekrefte.

Etter å ha bekreftet, vil du gå videre til neste trinn for å bruke modellen.

Distribuer en modell

Når du velger Distribuer og godkjenne vilkårene, vil modellimplementeringen starte. Alternativt kan du distribuere gjennom eksempelnotisboken som dukker opp ved å velge Åpne Notebook. Eksempelnotisboken gir ende-til-ende veiledning om hvordan du kan distribuere modellen for slutninger og rydde opp i ressurser.

For å distribuere ved hjelp av en bærbar PC, starter vi med å velge en passende modell, spesifisert av model_id. Du kan distribuere hvilken som helst av de valgte modellene på SageMaker med følgende kode:

Dette distribuerer modellen på SageMaker med standardkonfigurasjoner, inkludert standard forekomsttype og standard VPC-konfigurasjoner. Du kan endre disse konfigurasjonene ved å spesifisere ikke-standardverdier i JumpStartModel. Etter at det er distribuert, kan du kjøre slutninger mot det distribuerte endepunktet gjennom SageMaker-prediktoren:

Finjusterte chattemodeller (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) godtar en chathistorikk mellom brukeren og chat-assistenten, og genererer den påfølgende chatten. De forhåndstrente modellene (Llama-2-7b, Llama-2-13b, Llama-2-70b) krever en strengmelding og utfører tekstfullføring på den oppgitte ledeteksten. Se følgende kode:

Merk at som standard, accept_eula er satt til usann. Du må stille inn accept_eula=true for å starte endepunktet. Ved å gjøre det godtar du brukerlisensavtalen og akseptabel brukspolicy som nevnt tidligere. Du kan også nedlasting lisensavtalen.

Custom_attributes som brukes til å sende EULA er nøkkel/verdi-par. Nøkkelen og verdien er atskilt med = og par er atskilt med ;. Hvis brukeren sender den samme nøkkelen mer enn én gang, beholdes den siste verdien og sendes til skriptbehandleren (dvs. i dette tilfellet brukt til betinget logikk). For eksempel hvis accept_eula=false; accept_eula=true sendes til serveren, da accept_eula=true beholdes og sendes til skriptbehandleren.

Inferensparametere styrer tekstgenereringsprosessen ved endepunktet. Den maksimale kontrollen for nye tokens refererer til størrelsen på utdataene som genereres av modellen. Merk at dette ikke er det samme som antall ord fordi vokabularet til modellen ikke er det samme som det engelskspråklige vokabularet, og hver token er kanskje ikke et engelskspråklig ord. Temperaturen kontrollerer tilfeldigheten i utgangen. Høyere temperatur resulterer i mer kreative og hallusinerte utganger. Alle slutningsparametrene er valgfrie.

Tabellen nedenfor viser alle Llama-modellene som er tilgjengelige i SageMaker JumpStart sammen med model_ids, standard forekomsttyper og det maksimale antallet totale tokens (summen av antall input-tokens og antall genererte tokens) som støttes for hver av disse modellene.

| Modellnavn | Modell-ID | Maks totalt antall tokens | Standard forekomsttype |

| Lama-2-7b | meta-tekstgenerasjon-llama-2-7b | 4096 | ml.g5.2xlarge |

| Lama-2-7b-chat | meta-tekstgenerasjon-llama-2-7b-f | 4096 | ml.g5.2xlarge |

| Lama-2-13b | meta-tekstgenerasjon-llama-2-13b | 4096 | ml.g5.12xlarge |

| Lama-2-13b-chat | meta-tekstgenerasjon-llama-2-13b-f | 4096 | ml.g5.12xlarge |

| Lama-2-70b | meta-tekstgenerasjon-llama-2-70b | 4096 | ml.g5.48xlarge |

| Lama-2-70b-chat | meta-tekstgenerasjon-llama-2-70b-f | 4096 | ml.g5.48xlarge |

Merk at SageMaker-endepunkter har en tidsavbruddsgrense på 60s. Selv om modellen kan være i stand til å generere 4096 tokens, vil forespørselen mislykkes hvis tekstgenerering tar mer enn 60 sekunder. For 7B-, 13B- og 70B-modeller anbefaler vi å stille inn max_new_tokens ikke større enn henholdsvis 1500, 1000 og 500, mens det totale antallet tokens holdes mindre enn 4K.

Inferens- og eksempelmeldinger for Llama-2-70b

Du kan bruke Lama-modeller for tekstfullføring for et hvilket som helst stykke tekst. Gjennom tekstgenerering kan du utføre en rekke oppgaver, for eksempel svare på spørsmål, språkoversettelse, sentimentanalyse og mange flere. Inndata nyttelast til endepunktet ser ut som følgende kode:

Følgende er noen eksempler på ledetekster og teksten generert av modellen. Alle utganger genereres med inferensparametere {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

I det neste eksempelet viser vi hvordan du bruker Llama-modeller med få skudd i kontekstlæring, der vi gir treningseksempler tilgjengelig for modellen. Legg merke til at vi kun trekker slutninger om den distribuerte modellen, og under denne prosessen endres ikke modellvektene.

Inferens- og eksempelmeldinger for Llama-2-70b-chat

Med Llama-2-Chat-modeller, som er optimert for brukstilfeller for dialog, er inngangen til chat-modellens endepunkter den tidligere historikken mellom chat-assistenten og brukeren. Du kan stille spørsmål kontekstuelle til samtalen som har skjedd så langt. Du kan også oppgi systemkonfigurasjonen, for eksempel personas som definerer chat-assistentens oppførsel. Inndatanyttelasten til endepunktet ser ut som følgende kode:

Følgende er noen eksempler på ledetekster og teksten generert av modellen. Alle utganger genereres med inferensparametrene {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

I følgende eksempel har brukeren hatt en samtale med assistenten om turiststeder i Paris. Deretter spør brukeren om det første alternativet anbefalt av chat-assistenten.

I de følgende eksemplene angir vi systemets konfigurasjon:

Rydd opp

Når du er ferdig med å kjøre notatblokken, sørg for å slette alle ressursene slik at alle ressursene du opprettet i prosessen blir slettet og faktureringen stoppes:

konklusjonen

I dette innlegget viste vi deg hvordan du kommer i gang med Llama 2-modeller i SageMaker Studio. Med dette har du tilgang til seks Llama 2-fundamentmodeller som inneholder milliarder av parametere. Fordi grunnmodeller er forhåndsopplærte, kan de også bidra til å redusere opplærings- og infrastrukturkostnadene og muliggjøre tilpasning for ditt bruksområde. For å komme i gang med SageMaker JumpStart, besøk følgende ressurser:

Om forfatterne

juni vant er produktsjef hos SageMaker JumpStart. Han fokuserer på å gjøre grunnmodeller lett synlige og brukbare for å hjelpe kunder med å bygge generative AI-applikasjoner. Hans erfaring hos Amazon inkluderer også mobil shoppingapplikasjon og siste mil levering.

juni vant er produktsjef hos SageMaker JumpStart. Han fokuserer på å gjøre grunnmodeller lett synlige og brukbare for å hjelpe kunder med å bygge generative AI-applikasjoner. Hans erfaring hos Amazon inkluderer også mobil shoppingapplikasjon og siste mil levering.

Dr. Vivek Madan er en Applied Scientist med Amazon SageMaker JumpStart-teamet. Han fikk sin doktorgrad fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker innen maskinlæring og algoritmedesign og har publisert artikler på EMNLP-, ICLR-, COLT-, FOCS- og SODA-konferanser.

Dr. Vivek Madan er en Applied Scientist med Amazon SageMaker JumpStart-teamet. Han fikk sin doktorgrad fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker innen maskinlæring og algoritmedesign og har publisert artikler på EMNLP-, ICLR-, COLT-, FOCS- og SODA-konferanser.  Dr. Kyle Ulrich er en Applied Scientist med Amazon SageMaker JumpStart-teamet. Hans forskningsinteresser inkluderer skalerbare maskinlæringsalgoritmer, datasyn, tidsserier, Bayesianske ikke-parametriske og Gaussiske prosesser. Hans doktorgrad er fra Duke University og han har publisert artikler i NeurIPS, Cell og Neuron.

Dr. Kyle Ulrich er en Applied Scientist med Amazon SageMaker JumpStart-teamet. Hans forskningsinteresser inkluderer skalerbare maskinlæringsalgoritmer, datasyn, tidsserier, Bayesianske ikke-parametriske og Gaussiske prosesser. Hans doktorgrad er fra Duke University og han har publisert artikler i NeurIPS, Cell og Neuron.  Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker JumpStart og hjelper til med å utvikle maskinlæringsalgoritmer. Han fikk sin doktorgrad fra University of Illinois Urbana-Champaign. Han er en aktiv forsker innen maskinlæring og statistisk inferens, og har publisert mange artikler på NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP-konferanser.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker JumpStart og hjelper til med å utvikle maskinlæringsalgoritmer. Han fikk sin doktorgrad fra University of Illinois Urbana-Champaign. Han er en aktiv forsker innen maskinlæring og statistisk inferens, og har publisert mange artikler på NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP-konferanser.  Sundar Ranganathan er Global Head of GenAI/Frameworks GTM Specialists hos AWS. Han fokuserer på å utvikle GTM-strategi for store språkmodeller, GenAI og storskala ML-arbeidsbelastninger på tvers av AWS-tjenester som Amazon EC2, EKS, EFA, AWS Batch og Amazon SageMaker. Hans erfaring inkluderer lederroller innen produktledelse og produktutvikling hos NetApp, Micron Technology, Qualcomm og Mentor Graphics.

Sundar Ranganathan er Global Head of GenAI/Frameworks GTM Specialists hos AWS. Han fokuserer på å utvikle GTM-strategi for store språkmodeller, GenAI og storskala ML-arbeidsbelastninger på tvers av AWS-tjenester som Amazon EC2, EKS, EFA, AWS Batch og Amazon SageMaker. Hans erfaring inkluderer lederroller innen produktledelse og produktutvikling hos NetApp, Micron Technology, Qualcomm og Mentor Graphics.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-graders

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- I stand

- Om oss

- Aksepterer

- akseptabelt

- adgang

- tilgjengelighet

- tilgjengelig

- Ifølge

- anerkjenne

- tvers

- aktiv

- legge til

- legge

- Ytterligere

- adresse

- Etter

- en gang til

- mot

- Avtale

- AI

- algoritme

- algoritmer

- justere

- Alle

- tillate

- langs

- også

- alltid

- am

- Amazon

- Amazon EC2

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Amazon Web Services

- amerikansk

- an

- analyse

- og

- og infrastruktur

- Kunngjøre

- En annen

- besvare

- noen

- noen

- Søknad

- søknader

- anvendt

- verdsette

- hensiktsmessig

- Arc

- arkitektur

- ER

- Kunst

- AS

- bistå

- Assistent

- At

- Atmosfære

- attraksjoner

- Automatisert

- tilgjengelig

- AWS

- Banan

- grunnleggende

- Battle

- Bayesiansk

- BE

- vakker

- Beauty

- ble

- fordi

- bli

- vært

- øl

- før du

- atferd

- Beijing

- tro

- antatt

- BEST

- mellom

- fakturering

- Milliarder

- milliarder

- Svart

- Eske

- Break

- fantastisk

- bred

- bygge

- Bygning

- bygget

- men

- knapp

- by

- som heter

- CAN

- hovedstad

- bil

- kort

- karusellen

- saken

- saker

- CAT

- endring

- Sjokolade

- Velg

- velge

- City

- Classic

- kode

- samling

- kombinert

- skurtreskerne

- kommer

- kommer

- kommersiell

- Selskapet

- ferdigstillelse

- datamaskin

- Datamaskin syn

- konferanser

- trygg

- Konfigurasjon

- ansett

- konstant

- konstruksjon

- inneholde

- Container

- inneholder

- innhold

- kontekstuelle

- fortsette

- kontinuerlig

- kontroll

- kontroller

- Praktisk

- Samtale

- Kostnader

- land

- mot

- dekke

- skape

- opprettet

- Kreativ

- kulturell

- Kultur

- kopp

- Kunder

- tilpasning

- tilpasse

- dato

- datasikkerhet

- dedikert

- dedikasjon

- Misligholde

- definere

- levering

- utplassere

- utplassert

- utplasserings

- distribusjon

- Distribueres

- utforming

- designet

- ønsket

- destinasjonen

- destinasjoner

- detaljer

- utvikle

- utviklet

- Utvikler

- utvikle

- Utvikling

- Dialog

- forskjell

- forskjellig

- vanskelig

- oppdage

- særegen

- do

- dokumentarer

- gjør

- gjort

- ikke

- doblet

- ned

- Duke

- duke universitetet

- under

- e

- hver enkelt

- Tidligere

- lett

- lett

- Edward

- Einstein

- enten

- emalje

- muliggjøre

- muliggjør

- slutt

- ende til ende

- Endpoint

- Ingeniørarbeid

- Engelsk

- nyte

- nok

- sikre

- Miljø

- utstyr

- Eter

- Selv

- hendelser

- alle

- eksempel

- eksempler

- opphisset

- erfaring

- eksperiment

- eksperimenter

- ekspress

- FAIL

- Mislyktes

- rettferdig

- falsk

- familie

- berømt

- langt

- feat

- kjennetegnet

- Egenskaper

- tilbakemelding

- Feet

- Noen få

- filmer

- slutt~~POS=TRUNC

- Endelig

- Finn

- Først

- flaggskip

- Flyte

- Flows

- fokuserer

- etter

- Til

- Forward

- funnet

- Fundament

- fire

- Frankrike

- Fransk

- fra

- fullt

- videre

- framtid

- general

- generere

- generert

- generasjonen

- generative

- Generativ AI

- Georgia

- få

- Gi

- glass

- Global

- Go

- skal

- grafikk

- flott

- større

- banebrytende

- Grow

- veiledning

- veilede

- HAD

- Håndterer

- skjedde

- lykkelig

- Hard

- hardt arbeid

- Ha

- å ha

- he

- hode

- hjelpe

- hjelpe

- hjelper

- her.

- hi

- Høy

- høyere

- hans

- historisk

- historie

- bolig

- Hvordan

- Hvordan

- HTML

- HTTPS

- Hub

- menneskelig

- i

- ikonisk

- Tanken

- if

- ii

- Illinois

- Påvirkning

- importere

- viktig

- imponerende

- in

- inkludere

- inkluderer

- Inkludert

- Incorporated

- informasjon

- Infrastruktur

- i utgangspunktet

- inngang

- inspirert

- inspirerende

- f.eks

- øyeblikkelig

- instruksjoner

- integrert

- tiltenkt

- interesser

- Interface

- inn

- isolert

- IT

- DET ER

- reise

- jpg

- bare

- holde

- holdt

- nøkkel

- Type

- Vet

- kjent

- landing

- landemerke

- Språk

- stor

- storskala

- største

- Siste

- Late

- lansere

- Lover

- Ledelse

- LÆRE

- Lær og vokse

- læring

- minst

- mindre

- nivåer

- Tillatelse

- Life

- lett

- i likhet med

- BEGRENSE

- lister

- litteratur

- ll

- Llama

- logikk

- Lang

- lang tid

- ser

- UTSEENDE

- elsker

- elsket

- lavere

- maskin

- maskinlæring

- laget

- gjøre

- GJØR AT

- Making

- ledelse

- leder

- mange

- vidunder

- Saken

- maksimal

- Kan..

- betyr

- måle

- Media

- medium

- nevnt

- melding

- Meta

- micron

- minutt

- minutter

- blanding

- ML

- MLOps

- Mobil

- modell

- modeller

- øyeblikk

- måneder

- mer

- mest

- Mest populær

- bevegelse

- film

- mye

- museum

- museer

- musikk

- navn

- Naturlig

- nødvendig

- Trenger

- nødvendig

- nettverk

- Ny

- New York

- neste

- Nei.

- bærbare

- nå

- Antall

- mange

- NY

- of

- tilby

- tilby

- Tilbud

- Olje

- on

- gang

- ONE

- bare

- åpen

- åpen kildekode

- Optimalisere

- optimalisert

- Alternativ

- or

- Annen

- andre

- ellers

- vår

- ut

- produksjon

- enn

- samlet

- side

- par

- Papir

- papirer

- parameter

- parametere

- paris

- del

- passere

- bestått

- passerer

- Past

- fred

- Utfør

- ytelse

- permanent

- telefon

- fotografier

- Fysikk

- brikke

- Pizza

- plast

- plato

- Platon Data Intelligence

- PlatonData

- spilt

- politikk

- pop-up

- Populær

- Post

- postal

- Predictor

- preferanser

- forbereder

- presentere

- forrige

- prosess

- Prosesser

- Produkt

- produktutvikling

- produktledelse

- Produktsjef

- forslag

- stolt

- gi

- forutsatt

- gir

- gi

- offentlig

- offentlig transport

- offentlig

- publisert

- formål

- sette

- Python

- Qualcomm

- spørsmål

- Rask

- raskt

- ramper

- tilfeldig

- område

- spenner

- klar

- grunner

- motta

- .

- anbefaler

- anbefales

- refererer

- Uansett

- regioner

- slektning

- relativt

- gjentatt

- representere

- anmode

- Krever

- forskning

- forsker

- Ressurser

- henholdsvis

- Svare

- REST

- resultere

- Resultater

- River

- Rolle

- roller

- Kjør

- rennende

- s

- Sikkerhet

- sagemaker

- salt

- samme

- skalerbar

- Skala

- Forsker

- forskere

- SDK

- SEA

- Søk

- søker

- Seksjon

- sikre

- sikkerhet

- se

- se

- syntes

- valgt

- velge

- utvalg

- send

- senior

- sentiment

- Serien

- Tjenester

- servering

- sett

- innstilling

- Form

- Hai

- Shopping

- bør

- Vis

- viste

- Viser

- nedleggelse

- betydning

- signifikant

- Enkelt

- ganske enkelt

- enkelt

- nettstedet

- Nettsteder

- SIX

- Størrelse

- Sakte

- liten

- So

- så langt

- selskap

- sosiale medier

- Solutions

- noen

- kilde

- Kilder

- spesiell

- spesialister

- spesifisert

- fart

- står

- Begynn

- startet

- Tilstand

- Stater

- statistisk

- Trinn

- Steps

- stoppet

- Strategi

- String

- struktur

- studio

- Stunning

- emne

- senere

- suksess

- vellykket

- slik

- Støttes

- sikker

- symbol

- system

- bord

- Ta

- tar

- oppgaver

- smak

- lag

- tech

- Teknologi

- midlertidig

- vilkår

- enn

- Takk

- Det

- De

- Hovedstaden

- Fremtiden

- Kilden

- verden

- deres

- Dem

- teori

- Der.

- Disse

- de

- ting

- tror

- denne

- selv om?

- Gjennom

- Tiger

- tid

- Tidsserier

- ganger

- Tittel

- til

- i dag

- sammen

- token

- tokens

- verktøy

- topp

- Totalt

- Tårn

- Tog

- Kurs

- transformator

- oversette

- Oversettelse

- transport

- Trillion

- prøve

- to

- typen

- typer

- ui

- etter

- uforglemmelig

- unik

- universitet

- til

- Oppdater

- oppdateringer

- bruk

- bruke

- bruk sak

- brukt

- Bruker

- Brukere

- bruker

- ved hjelp av

- verdi

- Verdier

- variasjon

- versjon

- versjoner

- veldig

- av

- Se

- visninger

- syn

- Besøk

- besøkende

- volum

- ønsket

- krig

- var

- we

- web

- webtjenester

- Web-basert

- Nettsted

- VI VIL

- Whale

- Hva

- Hva er

- når

- mens

- hvilken

- mens

- hvorfor

- vil

- vinduer

- med

- ord

- ord

- Arbeid

- virker

- verden

- verdenskjent

- vikle

- år

- york

- Du

- Din

- deg selv

- zephyrnet

- Zip