Dziś z radością ogłaszamy, że Mixtral-8x7B model dużego języka (LLM), opracowany przez Mistral AI, jest dostępny dla klientów za pośrednictwem Amazon SageMaker JumpStart wdrożyć jednym kliknięciem, aby uruchomić wnioskowanie. Mixtral-8x7B LLM to wstępnie wytrenowana, rzadka mieszanka modelu eksperckiego, oparta na 7-miliardowym szkielecie parametrów z ośmioma ekspertami na warstwę wyprzedzającą. Możesz wypróbować ten model za pomocą SageMaker JumpStart, centrum uczenia maszynowego (ML), które zapewnia dostęp do algorytmów i modeli, dzięki czemu możesz szybko rozpocząć korzystanie z ML. W tym poście opisujemy, jak odkryć i wdrożyć model Mixtral-8x7B.

Co to jest Mixtral-8x7B

Mixtral-8x7B to podstawowy model opracowany przez Mistral AI, obsługujący tekst w języku angielskim, francuskim, niemieckim, włoskim i hiszpańskim, z możliwością generowania kodu. Obsługuje różne przypadki użycia, takie jak podsumowywanie tekstu, klasyfikacja, uzupełnianie tekstu i uzupełnianie kodu. Zachowuje się dobrze w trybie czatu. Aby zademonstrować łatwość dostosowywania modelu, Mistral AI wypuściło także model instrukcji Mixtral-8x7B do zastosowań w czacie, dopracowany przy użyciu różnych publicznie dostępnych zbiorów danych konwersacji. Modele Mixtral mają dużą długość kontekstu wynoszącą do 32,000 XNUMX tokenów.

Mixtral-8x7B zapewnia znaczną poprawę wydajności w porównaniu z poprzednimi, najnowocześniejszymi modelami. Jego rzadka mieszanka architektury eksperckiej umożliwia osiągnięcie lepszych wyników wydajności w 9 z 12 testów porównawczych przetwarzania języka naturalnego (NLP) przetestowanych przez Sztuczna inteligencja Mistrala. Mixtral dorównuje lub przewyższa wydajnością modele nawet 10-krotnie większe. Wykorzystując jedynie ułamek parametrów na token, osiąga większą prędkość wnioskowania i niższe koszty obliczeń w porównaniu z gęstymi modelami o równoważnych rozmiarach — na przykład z 46.7 miliardami parametrów ogółem, ale tylko 12.9 miliarda wykorzystywanych na token. To połączenie wysokiej wydajności, obsługi wielu języków i wydajności obliczeniowej sprawia, że Mixtral-8x7B jest atrakcyjnym wyborem dla zastosowań NLP.

Model udostępniany jest na liberalnej licencji Apache 2.0, do wykorzystania bez ograniczeń.

Co to jest SageMaker JumpStart

Dzięki SageMaker JumpStart praktycy ML mogą wybierać z rosnącej listy najskuteczniejszych modeli fundamentów. Praktycy ML mogą wdrażać modele podstawowe w dedykowanych Amazon Sage Maker instancje w izolowanym środowisku sieciowym i dostosowywać modele za pomocą programu SageMaker do szkolenia modeli i wdrażania.

Możesz teraz odkryć i wdrożyć Mixtral-8x7B za pomocą kilku kliknięć Studio Amazon SageMaker lub programowo za pośrednictwem pakietu SageMaker Python SDK, co pozwala uzyskać wydajność modelu i elementy sterujące MLOps za pomocą funkcji SageMaker, takich jak Rurociągi Amazon SageMaker, Debuger Amazon SageMakerlub dzienniki kontenerów. Model jest wdrażany w bezpiecznym środowisku AWS i pod kontrolą VPC, co pomaga zapewnić bezpieczeństwo danych.

Odkryj modele

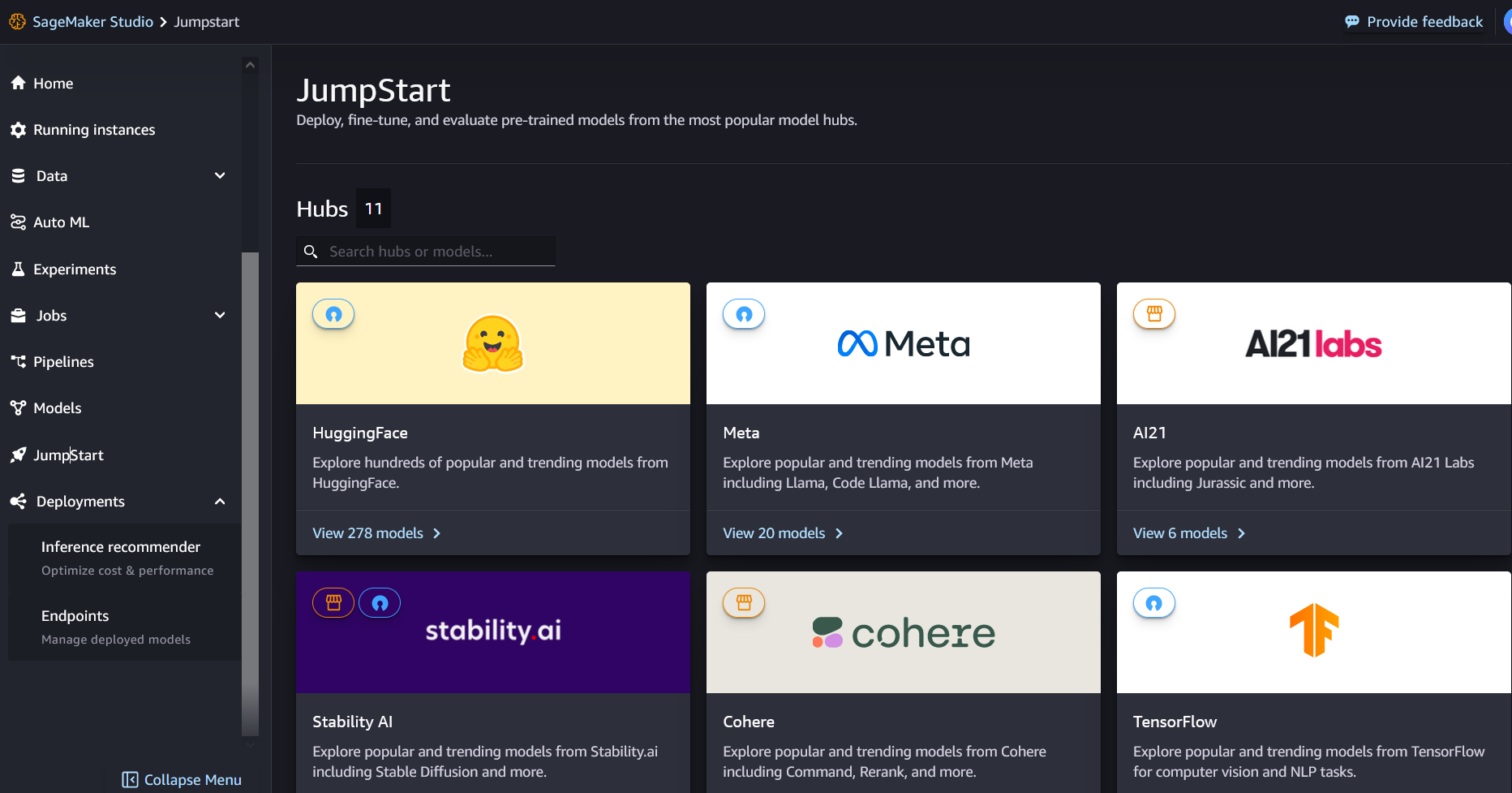

Dostęp do modeli podstawowych Mixtral-8x7B można uzyskać poprzez SageMaker JumpStart w interfejsie użytkownika SageMaker Studio i SageMaker Python SDK. W tej sekcji omówimy, jak odkryć modele w SageMaker Studio.

SageMaker Studio to zintegrowane środowisko programistyczne (IDE) zapewniające pojedynczy internetowy interfejs wizualny, w którym można uzyskać dostęp do specjalnie zaprojektowanych narzędzi umożliwiających wykonanie wszystkich etapów programowania ML, od przygotowania danych po budowanie, trenowanie i wdrażanie modeli ML. Aby uzyskać więcej informacji na temat rozpoczęcia i konfiguracji SageMaker Studio, zobacz Studio Amazon SageMaker.

W SageMaker Studio możesz uzyskać dostęp do SageMaker JumpStart, wybierając Szybki start w okienku nawigacji.

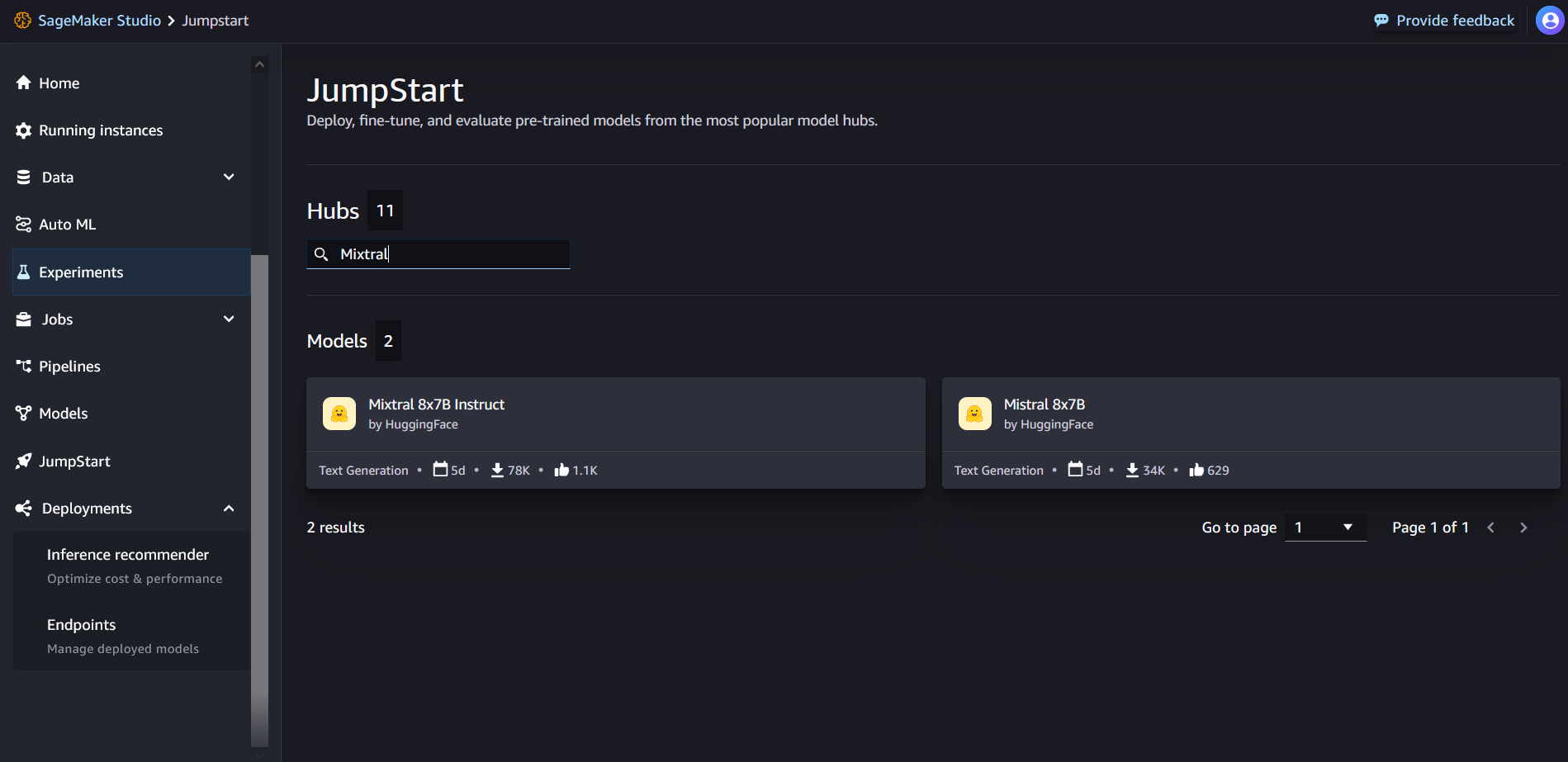

Na stronie docelowej SageMaker JumpStart możesz wyszukać „Mixtral” w polu wyszukiwania. Zobaczysz wyniki wyszukiwania pokazujące Mixtral 8x7B i Mixtral 8x7B Instruct.

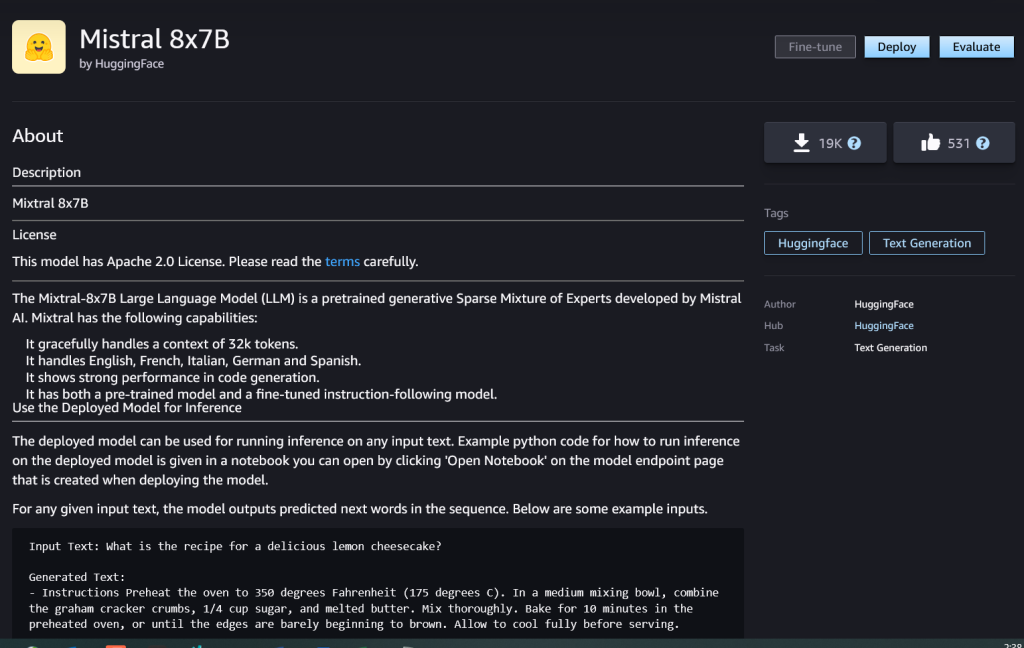

Możesz wybrać kartę modelu, aby wyświetlić szczegółowe informacje na temat modelu, takie jak licencja, dane użyte do szkolenia i sposób korzystania. Znajdziesz tu także Rozmieścić przycisk, którego można użyć do wdrożenia modelu i utworzenia punktu końcowego.

Wdróż model

Wdrożenie rozpoczyna się, kiedy wybierzesz Rozmieścić. Po zakończeniu wdrażania zostanie utworzony punkt końcowy. Możesz przetestować punkt końcowy, przekazując przykładowy ładunek żądania wnioskowania lub wybierając opcję testowania za pomocą zestawu SDK. Po wybraniu opcji użycia pakietu SDK zobaczysz przykładowy kod, którego możesz użyć w preferowanym edytorze notatników w SageMaker Studio.

Aby wdrożyć za pomocą pakietu SDK, zaczynamy od wybrania modelu Mixtral-8x7B określonego przez model_id with value huggingface-llm-mixtral-8x7b. Możesz wdrożyć dowolny z wybranych modeli w SageMaker za pomocą poniższego kodu. Podobnie możesz wdrożyć instrukcję Mixtral-8x7B przy użyciu własnego identyfikatora modelu:

Spowoduje to wdrożenie modelu w SageMaker z domyślnymi konfiguracjami, w tym domyślnym typem instancji i domyślnymi konfiguracjami VPC. Można zmienić te konfiguracje, określając wartości inne niż domyślne w Model JumpStart.

Po wdrożeniu możesz uruchomić wnioskowanie na temat wdrożonego punktu końcowego za pomocą predyktora SageMaker:

Przykładowe monity

Z modelem Mixtral-8x7B można wchodzić w interakcję jak z każdym standardowym modelem generowania tekstu, w którym model przetwarza sekwencję wejściową i wyprowadza przewidywane kolejne słowa w sekwencji. W tej sekcji podajemy przykładowe podpowiedzi.

Generowanie kodu

Korzystając z poprzedniego przykładu, możemy użyć podpowiedzi generowania kodu w następujący sposób:

Otrzymasz następujące dane wyjściowe:

Monit dotyczący analizy nastrojów

W przypadku Mixtral 8x7B możesz przeprowadzić analizę nastrojów, korzystając z podpowiedzi podobnej do poniższej:

Otrzymasz następujące dane wyjściowe:

Monity dotyczące odpowiedzi na pytania

W przypadku Mixtral-8x7B możesz użyć podpowiedzi odpowiadającej na pytanie w następujący sposób:

Otrzymasz następujące dane wyjściowe:

Instrukcja Mixtral-8x7B

Wersja Mixtral-8x7B dostosowana do instrukcji akceptuje sformatowane instrukcje, w których role konwersacyjne muszą rozpoczynać się od podpowiedzi użytkownika i naprzemiennie zawierać instrukcje użytkownika i asystenta (odpowiedź modelowa). Należy ściśle przestrzegać formatu instrukcji, w przeciwnym razie model będzie generował nieoptymalne wyniki. Szablon używany do budowania podpowiedzi dla modelu Instruct jest zdefiniowany w następujący sposób:

Należy pamiętać, że <s> i </s> są specjalnymi tokenami początku łańcucha (BOS) i końca łańcucha (EOS), natomiast [INST] i [/INST] są zwykłymi ciągami.

Poniższy kod pokazuje, jak sformatować zachętę w formacie instrukcji:

Wyszukiwanie wiedzy

Aby wyświetlić monit o odzyskanie wiedzy, możesz użyć następującego kodu:

Otrzymasz następujące dane wyjściowe:

Kodowanie

Modele Mixtral mogą wykazać mocne strony w zadaniach kodowania, jak pokazano w poniższym kodzie:

Matematyka i rozumowanie

Modele mieszane zgłaszają również mocne strony w zakresie dokładności matematycznej:

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- zdolności

- O nas

- powyżej

- przyspieszenie

- Akceptuje

- dostęp

- Konta

- precyzja

- Osiągać

- Osiąga

- w poprzek

- aktywny

- w dodatku

- dodanie

- Po

- przed

- AI

- AI / ML

- Algorytmy

- Wszystkie kategorie

- również

- Amazonka

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- ilość

- an

- analiza

- i

- i infrastruktura

- Ogłosić

- odpowiedź

- każdy

- Apache

- pociągający

- aplikacje

- stosowany

- Stosowanie

- architektura

- SĄ

- argument

- artykuł

- AS

- Asystent

- At

- dostępny

- AWS

- z powrotem

- Kręgosłup

- na podstawie

- bash

- bateria

- Bayesian

- BE

- bo

- być

- zanim

- Początek

- uważa,

- Dzwon

- testowany

- Benchmarki

- Ulepsz Swój

- pomiędzy

- Rachunek

- billing

- Miliard

- kupiony

- Pudełko

- przerwa

- przynieść

- budować

- Budowanie

- wbudowany

- biznes

- ale

- by

- obliczać

- wezwanie

- nazywa

- Połączenia

- CAN

- karta

- walizka

- Etui

- zmiana

- pogawędzić

- wybór

- Dodaj

- Wybierając

- Chris

- klasyfikacja

- kliknij

- kod

- Kodowanie

- połączenie

- w porównaniu

- skompilowany

- ukończenia

- obliczeniowy

- obliczać

- komputer

- Wizja komputerowa

- konferencje

- stale

- Pojemnik

- zawartość

- kontekst

- ciągły

- bez przerwy

- kontroli

- Rozmowa

- Koszty:

- Koszty:

- mógłby

- Stwórz

- stworzony

- istotny

- Kubek

- Aktualny

- Klientów

- dostosowywanie

- dostosować

- dane

- bezpieczeństwo danych

- zbiory danych

- dzień

- Dni

- dedykowane

- Domyślnie

- zdefiniowane

- Demokratyzować

- wykazać

- rozwijać

- wdrażane

- wdrażanie

- Wdrożenie

- wdraża się

- czerpać

- detale

- rozwijać

- rozwinięty

- Deweloper

- oprogramowania

- DICT

- ZROBIŁ

- odkryj

- do

- robi

- dolarów

- domeny

- zrobić

- na dół

- Spadek

- Książę

- uniwersytet książęcy

- każdy

- Gospodarczy

- redaktor

- efektywność

- Jajka

- więcej

- umożliwiać

- Umożliwia

- umożliwiając

- zakończenia

- Punkt końcowy

- Inżynieria

- Angielski

- zapewnić

- Środowisko

- EOS

- równy

- Równoważny

- etyczny

- przykład

- przekracza

- podniecony

- z pominięciem

- ekspert

- eksperci

- Wyjaśniać

- wyjaśnienie

- rozbudowa

- członków Twojej rodziny

- szybciej

- Korzyści

- kilka

- Akta

- filtry

- Znajdź

- i terminów, a

- następujący

- następujący sposób

- W razie zamówieenia projektu

- format

- Fundacja

- frakcja

- francuski

- od

- funkcjonować

- przyszłość

- ogólny cel

- Generować

- wygenerowane

- generacja

- generatywny

- generatywna sztuczna inteligencja

- niemiecki

- otrzymać

- Go

- dobry

- got

- Rozwój

- nienawidzić

- Have

- he

- pomoc

- pomoc

- pomaga

- jej

- tutaj

- Wysoki

- Wzgórza

- jego

- W jaki sposób

- How To

- HTML

- HTTPS

- Piasta

- i

- ICE

- lody

- ID

- if

- Illinois

- choroba

- importować

- ważny

- podnieść

- ulepszenia

- in

- zawierać

- Włącznie z

- Rejestrowy

- Infrastruktura

- wkład

- Wejścia

- przykład

- instrukcje

- integrować

- zintegrowany

- interakcji

- zainteresowania

- Interfejs

- Zmyślony

- odosobniony

- IT

- Włoski

- JEGO

- samo

- jpg

- dzieci

- wiedza

- Kyle

- Labs

- lądowanie

- język

- duży

- Nazwisko

- warstwa

- Wyprowadzenia

- nauka

- Długość

- niech

- Licencja

- lubić

- lubi

- Limity

- LINK

- Lista

- Słuchanie

- mało

- LLM

- logika

- poszukuje

- niższy

- maszyna

- uczenie maszynowe

- zrobiony

- WYKONUJE

- Dokonywanie

- kierownik

- wiele

- zapałki

- matematyka

- matematyka

- me

- średni

- mieszanina

- ML

- MLOps

- Moda

- model

- modele

- zmodyfikowano

- Miesiąc

- jeszcze

- motocykl

- dużo

- pomnożona

- Muzyka

- musi

- my

- Naturalny

- Przetwarzanie języka naturalnego

- Nawigacja

- ujemny

- sieć

- Neutralny

- Nowości

- Następny

- nlp

- żaden

- noty

- notatnik

- już dziś

- numer

- of

- Olej

- on

- pewnego razu

- ONE

- tylko

- operacyjny

- system operacyjny

- Option

- or

- Inne

- Inaczej

- na zewnątrz

- wydajność

- Wyjścia

- zewnętrzne

- koniec

- własny

- strona

- płatny

- chleb

- Papiery

- parametr

- parametry

- Przechodzący

- pasja

- namiętny

- ścieżki

- dla

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- PhD

- telefon

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- przenośny

- pozytywny

- Post

- poprzedzający

- Przewiduje

- Urządzenie prognozujące

- Korzystny

- przygotowanie

- poprzedni

- Główny

- proceduralny

- wygląda tak

- procesów

- przetwarzanie

- Produkt

- Program

- Programowanie

- monity

- dobrobyt

- zapewniać

- dostawców

- zapewnia

- publicznie

- opublikowany

- Python

- Kwartał

- pytanie

- szybko

- RE

- Czytający

- Przepis

- Rekurencyjne

- zmniejszyć

- odnosić się

- regularny

- wydany

- raport

- zażądać

- Badania naukowe

- badacz

- Zasoby

- szanowany

- odpowiedź

- odpowiedzialny

- Ograniczenia

- dalsze

- Efekt

- powrót

- powraca

- jazda konna

- Ryzyko

- Rola

- role

- Pokój

- run

- bieganie

- s

- SA

- sagemaker

- sól

- skalowalny

- Skala

- nauka

- Naukowiec

- Sdk

- Szukaj

- Sekcja

- bezpieczne

- bezpieczeństwo

- widzieć

- wybierać

- wybrany

- wybierając

- wybór

- senior

- sentyment

- oddzielny

- Sekwencja

- Serie

- Usługi

- zestaw

- pokazał

- pokazane

- Targi

- znaczący

- Podobnie

- Prosty

- ponieważ

- pojedynczy

- Rozmiar

- So

- Obserwuj Nas

- Społeczeństwo

- Tworzenie

- rozwiązanie

- hiszpański

- specjalny

- specjalista

- określony

- prędkości

- Spędzanie

- standard

- początek

- rozpoczęty

- rozpocznie

- state-of-the-art

- statystyczny

- Ewolucja krok po kroku

- Cel

- Nadal

- zatrzymany

- sklep

- bezpośredni

- Strategiczny

- strumień

- silne strony

- sznur

- zbudowany

- studio

- taki

- wsparcie

- Wspierający

- podpory

- system

- trwa

- zadania

- klucze

- zespół

- Technologia

- szablon

- test

- przetestowany

- Testowanie

- XNUMX

- że

- Połączenia

- Przyszłość

- następnie

- Te

- one

- to

- Przez

- czas

- Szereg czasowy

- czasy

- do

- razem

- żeton

- Żetony

- także

- narzędzia

- Kwota produktów:

- Pociąg

- Trening

- prawdziwy

- próbować

- ćwierkać

- rodzaj

- ui

- dla

- uniwersytet

- UNIX

- odblokować

- aż do

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- zastosowania

- za pomocą

- Wykorzystując

- Dolina

- wartość

- Wartości

- różnorodność

- wersja

- Wideo

- Zobacz i wysłuchaj

- wizja

- Odwiedzić

- wizualny

- spacer

- była

- Uzdatnianie wody

- we

- sieć

- usługi internetowe

- Web-based

- DOBRZE

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- natomiast

- który

- biały

- KIM

- będzie

- w

- w ciągu

- bez

- słowa

- Praca

- by

- napisać

- napisany

- You

- Twój

- zefirnet

Rachna Czadha jest głównym architektem rozwiązań AI/ML w obszarze kont strategicznych w AWS. Rachna jest optymistą, który wierzy, że etyczne i odpowiedzialne korzystanie z AI może w przyszłości poprawić społeczeństwo i przynieść dobrobyt gospodarczy i społeczny. W wolnym czasie Rachna lubi spędzać czas z rodziną, spacerować i słuchać muzyki.

Rachna Czadha jest głównym architektem rozwiązań AI/ML w obszarze kont strategicznych w AWS. Rachna jest optymistą, który wierzy, że etyczne i odpowiedzialne korzystanie z AI może w przyszłości poprawić społeczeństwo i przynieść dobrobyt gospodarczy i społeczny. W wolnym czasie Rachna lubi spędzać czas z rodziną, spacerować i słuchać muzyki. dr Kyle Ulrich jest naukowcem z

dr Kyle Ulrich jest naukowcem z  Krzysztofa Whittena jest programistą w zespole JumpStart. Pomaga w wyborze modeli w skali i integrowaniu ich z innymi usługami SageMaker. Chrisa pasjonuje się przyspieszaniem wszechobecności sztucznej inteligencji w różnych obszarach biznesowych.

Krzysztofa Whittena jest programistą w zespole JumpStart. Pomaga w wyborze modeli w skali i integrowaniu ich z innymi usługami SageMaker. Chrisa pasjonuje się przyspieszaniem wszechobecności sztucznej inteligencji w różnych obszarach biznesowych. Doktor Fabio Nonato de Paula jest starszym menedżerem, specjalistą GenAI SA, pomagającym dostawcom modeli i klientom skalować generatywną sztuczną inteligencję w AWS. Fabio ma pasję demokratyzacji dostępu do generatywnej technologii AI. Poza pracą możesz spotkać Fabio jeżdżącego na motocyklu po wzgórzach Doliny Sonoma lub czytającego ComiXology.

Doktor Fabio Nonato de Paula jest starszym menedżerem, specjalistą GenAI SA, pomagającym dostawcom modeli i klientom skalować generatywną sztuczną inteligencję w AWS. Fabio ma pasję demokratyzacji dostępu do generatywnej technologii AI. Poza pracą możesz spotkać Fabio jeżdżącego na motocyklu po wzgórzach Doliny Sonoma lub czytającego ComiXology. Dr Ashish Khetan jest starszym naukowcem z wbudowanymi algorytmami Amazon SageMaker i pomaga rozwijać algorytmy uczenia maszynowego. Doktoryzował się na University of Illinois Urbana-Champaign. Jest aktywnym badaczem uczenia maszynowego i wnioskowania statystycznego oraz opublikował wiele artykułów na konferencjach NeurIPS, ICML, ICLR, JMLR, ACL i EMNLP.

Dr Ashish Khetan jest starszym naukowcem z wbudowanymi algorytmami Amazon SageMaker i pomaga rozwijać algorytmy uczenia maszynowego. Doktoryzował się na University of Illinois Urbana-Champaign. Jest aktywnym badaczem uczenia maszynowego i wnioskowania statystycznego oraz opublikował wiele artykułów na konferencjach NeurIPS, ICML, ICLR, JMLR, ACL i EMNLP. Karola Albertsena kieruje produktem, inżynierią i nauką w Amazon SageMaker Algorithms i JumpStart, centrum uczenia maszynowego SageMaker. Pasjonuje się stosowaniem uczenia maszynowego w celu odblokowania wartości biznesowej.

Karola Albertsena kieruje produktem, inżynierią i nauką w Amazon SageMaker Algorithms i JumpStart, centrum uczenia maszynowego SageMaker. Pasjonuje się stosowaniem uczenia maszynowego w celu odblokowania wartości biznesowej.