Amazon Sage Maker umożliwia teraz porównanie wydajności nowej wersji stosu obsługującego modele z obecnie wdrożoną wersją przed pełnym wdrożeniem produkcyjnym przy użyciu praktyki bezpieczeństwa wdrażania znanej jako testowanie cienia. Testy w tle mogą pomóc zidentyfikować potencjalne błędy konfiguracji i problemy z wydajnością, zanim wpłyną one na użytkowników końcowych. Dzięki SageMaker nie musisz inwestować w budowanie infrastruktury do testowania w tle, co pozwala skupić się na rozwoju modelu. SageMaker zajmuje się wdrażaniem nowej wersji wraz z bieżącą wersją obsługującą żądania produkcyjne, kierując część żądań do wersji w tle. Następnie można porównać wydajność dwóch wersji przy użyciu metryk, takich jak opóźnienie i współczynnik błędów. Daje to większą pewność, że wdrożenia produkcyjne do punktów końcowych wnioskowania SageMaker nie spowodują regresji wydajności i pomaga uniknąć przestojów spowodowanych przypadkowymi błędami konfiguracji.

W tym poście demonstrujemy tę nową funkcję SageMaker. Odpowiedni przykładowy notatnik jest dostępny w tym serwisie GitHub składnica.

Przegląd rozwiązania

Twoja infrastruktura obsługująca model składa się z modelu uczenia maszynowego (ML), kontenera obsługującego lub wystąpienia obliczeniowego. Rozważmy następujące scenariusze:

- Rozważasz promowanie nowego modelu, który został zweryfikowany w trybie offline do środowiska produkcyjnego, ale przed podjęciem tej decyzji chcesz ocenić metryki wydajności operacyjnej, takie jak opóźnienie, współczynnik błędów itd.

- Rozważasz zmiany w kontenerze infrastruktury obsługującej, takie jak łatanie luk w zabezpieczeniach lub uaktualnianie do nowszych wersji, i chcesz ocenić wpływ tych zmian przed przejściem do produkcji.

- Rozważasz zmianę instancji ML i chcesz ocenić, jak nowa instancja poradziłaby sobie z żądaniami wnioskowania na żywo.

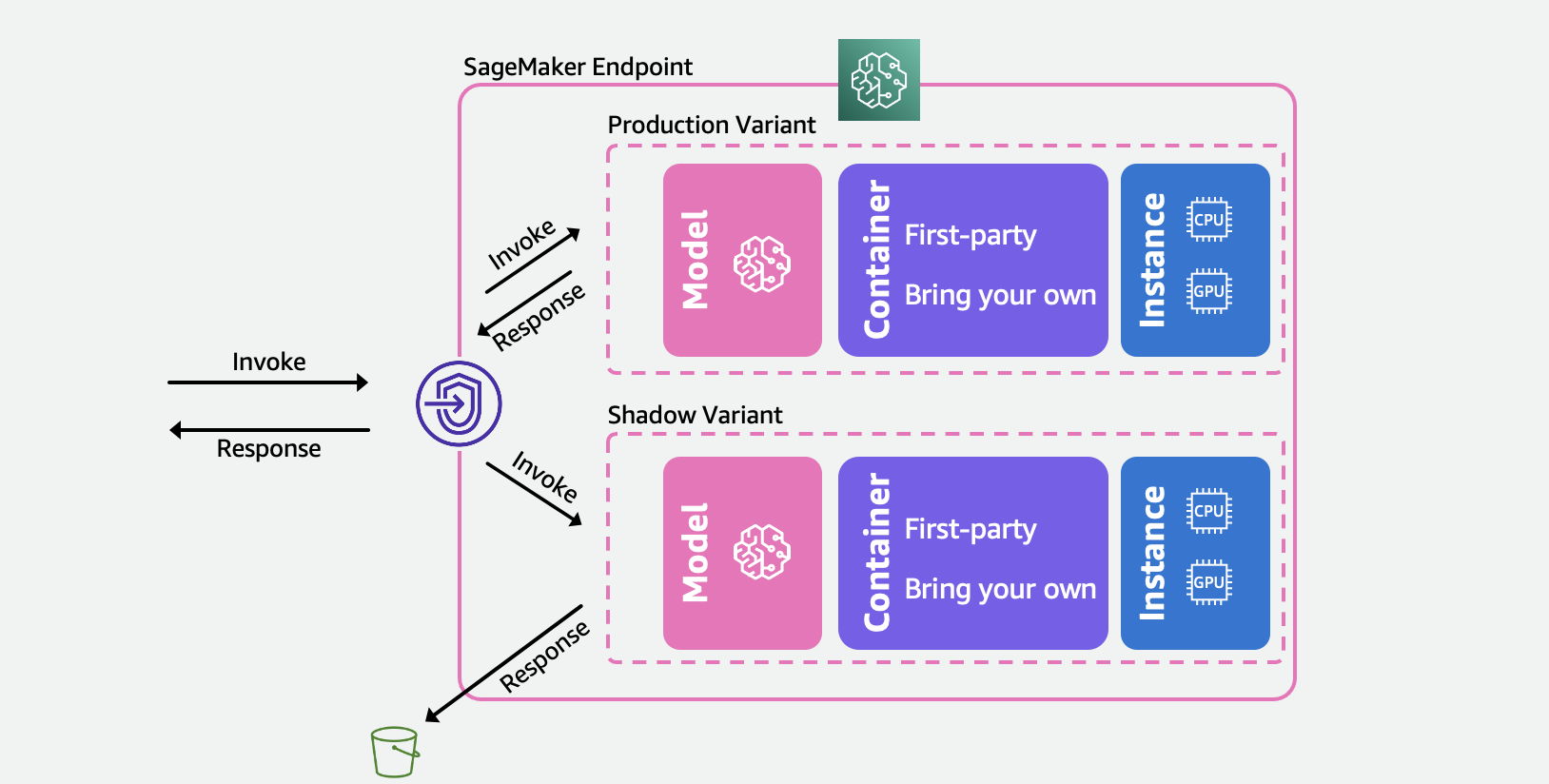

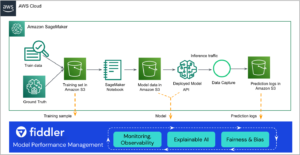

Poniższy diagram ilustruje naszą architekturę rozwiązania.

Dla każdego z tych scenariuszy wybierz wariant produkcyjny, który chcesz przetestować, a SageMaker automatycznie wdroży nowy wariant w trybie cienia i przekieruje do niego kopię żądań wnioskowania w czasie rzeczywistym w tym samym punkcie końcowym. Do aplikacji wywołującej zwracane są tylko odpowiedzi wariantu produkcyjnego. Możesz odrzucić lub zarejestrować odpowiedzi wariantu cienia w celu porównania offline. Opcjonalnie możesz monitorować warianty za pomocą wbudowanego pulpitu nawigacyjnego z bezpośrednim porównaniem wskaźników wydajności. Możesz użyć tej możliwości albo przez interfejs API SageMaker wnioskowania o aktualizacji punktu końcowego, albo przez konsolę SageMaker.

Warianty Shadow opierają się na możliwości wariantów produkcyjnych w punktach końcowych wnioskowania SageMaker. Powtórzę, A wariant produkcyjny składa się z modelu ML, obsługującego kontenera i instancji ML. Ponieważ każdy wariant jest niezależny od innych, możesz mieć różne modele, kontenery lub typy instancji w różnych wariantach. SageMaker pozwala określić zasady automatycznego skalowania dla poszczególnych wariantów, dzięki czemu mogą one skalować się niezależnie w oparciu o przychodzące obciążenie. SageMaker obsługuje do 10 wariantów produkcyjnych na punkt końcowy. Możesz skonfigurować wariant tak, aby odbierał część ruchu przychodzącego, ustawiając wagi wariantów, lub określić wariant docelowy w żądaniu przychodzącym. Odpowiedź z wariantu produkcyjnego jest przekazywana z powrotem do wywołującego.

A wariant cienia (nowy) ma te same komponenty co wariant produkcyjny. Określona przez użytkownika część żądań, znana jako procent próbkowania ruchu, jest przekazywany do wariantu cienia. Możesz zarejestrować odpowiedź wariantu cienia Usługa Amazon Simple Storage (Amazon S3) lub wyrzucić.

Należy pamiętać, że SageMaker obsługuje maksymalnie jeden wariant cienia na punkt końcowy. W przypadku punktu końcowego z wariantem w tle może istnieć maksymalnie jeden wariant produkcyjny.

Po skonfigurowaniu wariantów produkcyjnych i cienia można monitorować metryki wywołania zarówno dla wersji produkcyjnej, jak i cieniowej w Amazon Cloud Watch pod AWS/SageMaker przestrzeń nazw. Wszystkie aktualizacje punktu końcowego SageMaker są organizowane przy użyciu wdrożenia niebieskie/zielone i przebiegać bez utraty dostępności. Twoje punkty końcowe będą nadal odpowiadać na żądania produkcyjne podczas dodawania, modyfikowania lub usuwania wariantów w tle.

Możesz użyć tej możliwości na jeden z dwóch sposobów:

- Zarządzane testy w tle za pomocą konsoli SageMaker – Możesz wykorzystać konsolę, aby uzyskać doświadczenie z przewodnikiem, aby zarządzać kompleksową podróżą testowania w tle. Pozwala to skonfigurować testy w tle na określony czas, monitorować postępy za pomocą pulpitu nawigacyjnego na żywo, czyścić po zakończeniu i działać na podstawie wyników.

- Samoobsługowe testowanie w tle przy użyciu interfejsów API wnioskowania SageMaker — Jeśli Twój przepływ pracy wdrażania korzysta już z interfejsów API tworzenia/aktualizowania/usuwania punktów końcowych, możesz nadal używać ich do zarządzania wariantami w tle.

W poniższych sekcjach omówimy każdy z tych scenariuszy.

Scenariusz 1 — Zarządzane testowanie w tle przy użyciu konsoli SageMaker

Jeśli chcesz wybrać SageMaker do kompleksowego zarządzania przepływem pracy tworzenia, zarządzania i działania na podstawie wyników testów w tle, rozważ użycie możliwości testów w tle w sekcji Wnioskowanie konsoli SageMaker. Jak wspomniano wcześniej, umożliwia to skonfigurowanie testów w tle na określony czas, monitorowanie postępów za pomocą pulpitu nawigacyjnego na żywo, przedstawianie opcji czyszczenia po zakończeniu i podejmowanie działań na podstawie wyników. Aby dowiedzieć się więcej, odwiedź testy cienia Sekcja naszej dokumentacji, aby uzyskać szczegółowe instrukcje dotyczące tej funkcji.

Wymagania wstępne

Modele do produkcji i cieniowania należy utworzyć w SageMaker. Proszę odnieść się do CreateModel API tutaj.

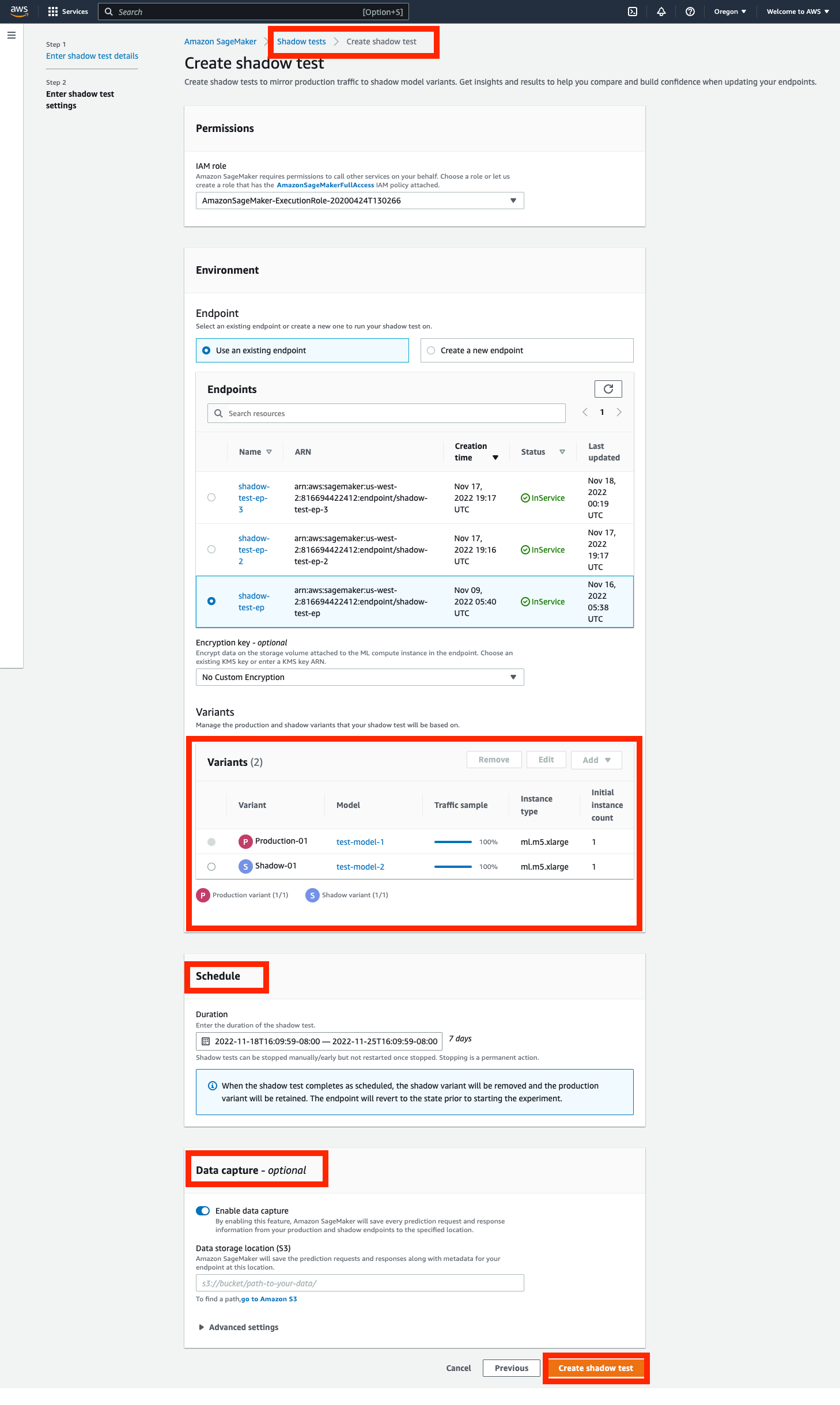

Krok 1 – Utwórz test cienia

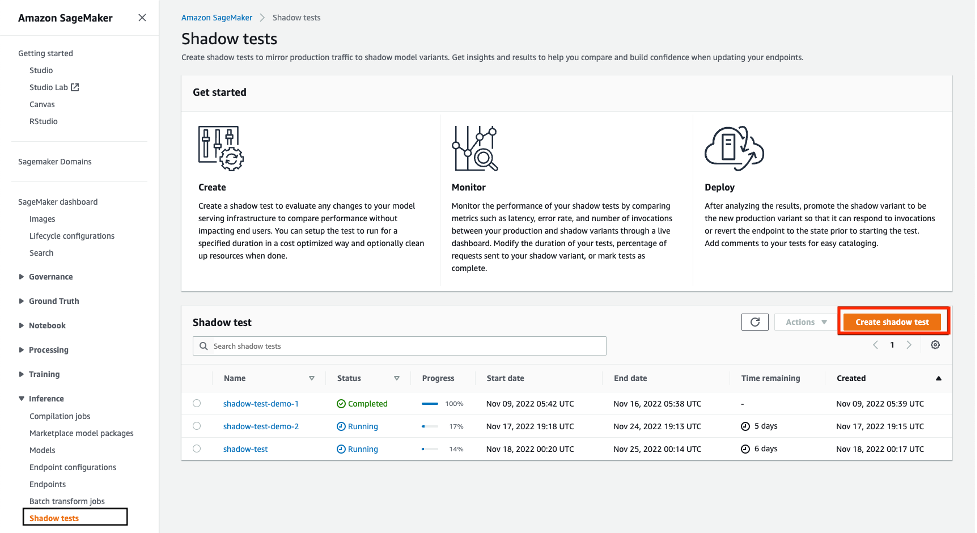

Nawiguj do Wnioskowanie sekcję w lewym panelu nawigacyjnym konsoli SageMaker, a następnie wybierz Testy w tle. Spowoduje to przejście do pulpitu nawigacyjnego ze wszystkimi zaplanowanymi, uruchomionymi i ukończonymi testami w tle. Kliknij 'utwórz test cienia”. Wprowadź nazwę testu i wybierz następny.

Spowoduje to przejście do strony ustawień testu cienia. Możesz wybrać istniejącą rolę IAM lub utworzyć taką, która ma AmazonSageMakerFullAccess Zasady IAM w załączeniu. Następnie wybierz „Utwórz nowy punkt końcowy' i wprowadź nazwę (xgb-prod-shadow-1). Możesz dodać jedną produkcję i jeden wariant w tle powiązany z tym punktem końcowym, klikając „Dodać' w sekcji Warianty. Możesz wybrać modele, które stworzyłeś w 'Dodaj model' Okno dialogowe. Spowoduje to utworzenie produkcji lub wariantu. Opcjonalnie możesz zmienić typ instancji i liczbę powiązaną z każdym wariantem.

Cały ruch trafia do wariantu produkcyjnego, który odpowiada na żądania wywołań. Możesz kontrolować część żądań kierowanych do wariantu w tle, zmieniając plik Traffic Sampling Percentage.

Możesz kontrolować czas trwania testu od jednej godziny do 30 dni. Jeśli nie jest określony, domyślnie jest to 7 dni. Po tym okresie test jest oznaczany jako zakończony. Jeśli przeprowadzasz test na istniejącym punkcie końcowym, zostanie on przywrócony do stanu sprzed rozpoczęcia testu po zakończeniu.

Opcjonalnie możesz przechwytywać żądania i odpowiedzi wariantu Shadow za pomocą Przechwytywania danych opcje. Jeśli nie zostanie określony, odpowiedzi wariantu cienia zostaną odrzucone.

Krok 2 – Monitoruj test cienia

Możesz wyświetlić listę testów w tle, przechodząc do Shadow Tests sekcja pod Wnioskowaniem. Kliknij test w tle utworzony w poprzednim kroku, aby wyświetlić szczegóły testu w tle i monitorować go w trakcie lub po jego zakończeniu.

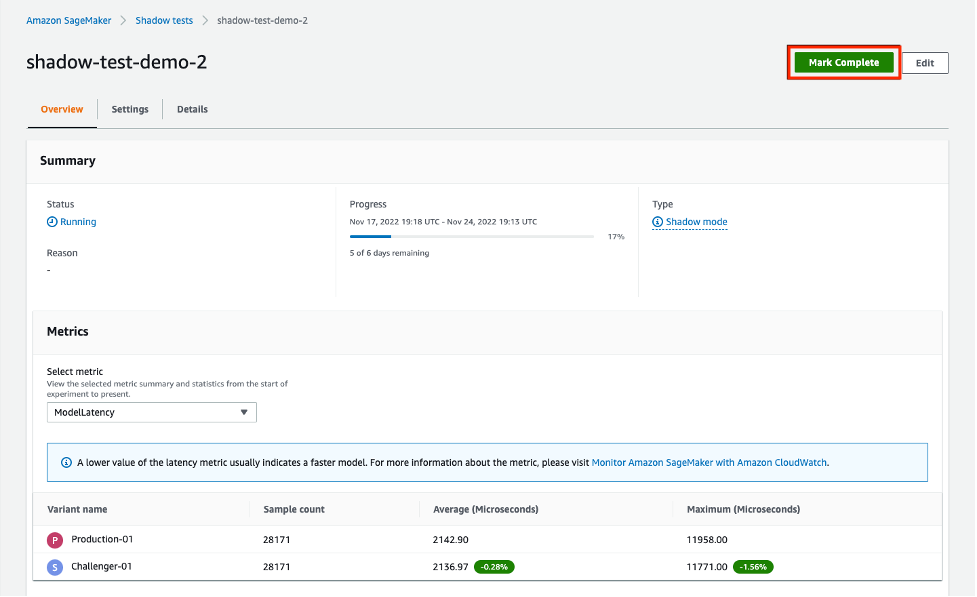

Sekcja Metrics zawiera porównanie kluczowych metryk i zapewnia nałożone wykresy między wariantami produkcyjnymi i shadowingowymi, wraz ze statystykami opisowymi. Możesz porównać metryki wywołania, takie jak ModelLatency i Invocation4xxErrors a także metryki instancji, takie jak CPUUtilization i DiskUtilization.

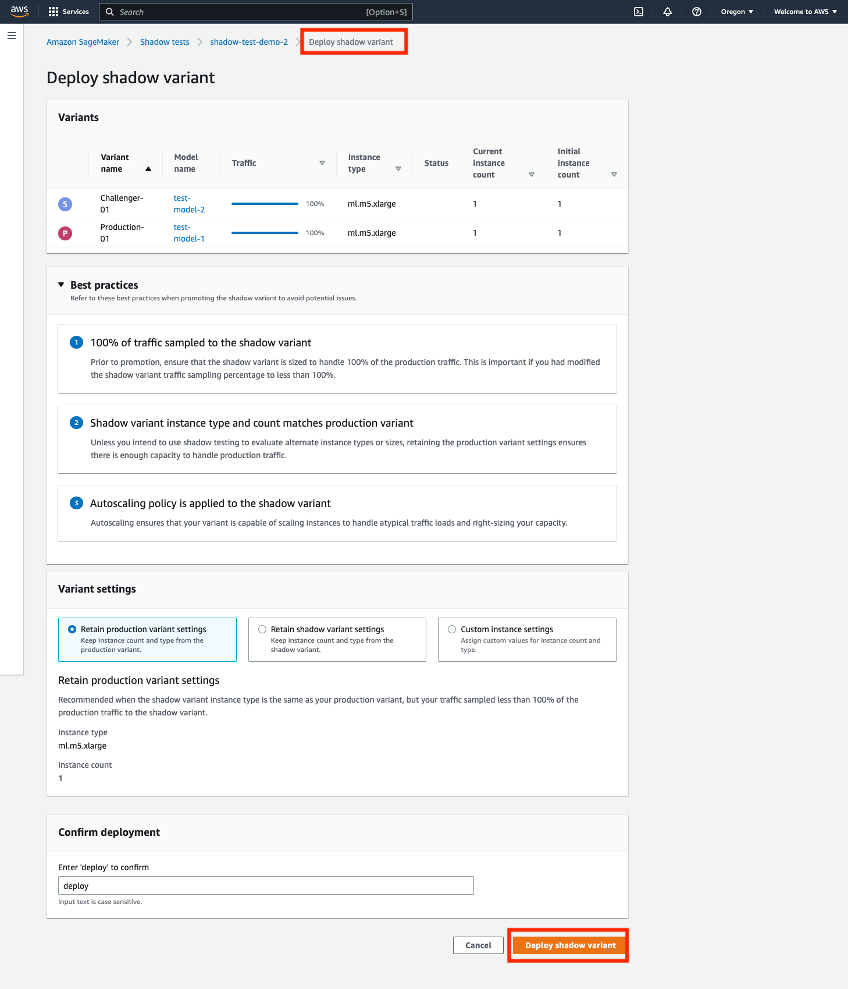

Krok 3 – Promuj wariant Shadow do nowego wariantu produkcyjnego

Po porównaniu możesz albo promować wariant zastępczy jako nowy wariant produkcyjny, albo usunąć wariant zastępczy. W przypadku obu tych opcji wybierz „Oznacz jako ukończone' na górze strony. Daje to możliwość promowania lub usuwania wariantu cienia.

Jeśli zdecydujesz się awansować, zostaniesz przeniesiony na stronę wdrożenia, na której możesz potwierdzić ustawienia wariantu przed wdrożeniem. Przed wdrożeniem zalecamy zmianę rozmiaru wariantów w tle, aby móc obsłużyć 100% ruchu związanego z wywołaniami. Jeśli nie używasz testów w tle do oceny alternatywnych typów lub rozmiarów instancji, możesz użyć opcji „zachować ustawienia wariantów produkcyjnych. W przeciwnym razie możesz wybrać opcjęzachowaj ustawienia wariantów cienia. Jeśli wybierzesz tę opcję, upewnij się, że próbkowanie ruchu jest ustawione na 100%. Alternatywnie możesz określić typ instancji i liczbę, jeśli chcesz zastąpić te ustawienia.

Gdy potwierdzisz wdrożenie, SageMaker zainicjuje aktualizację Twojego punktu końcowego, aby awansować wariant shadow do nowego wariantu produkcyjnego. Podobnie jak w przypadku wszystkich aktualizacji SageMaker, Twój punkt końcowy będzie nadal działał podczas aktualizacji.

Scenariusz 2: Testowanie w tle przy użyciu interfejsów API wnioskowania SageMaker

W tej sekcji opisano, jak używać istniejących interfejsów API SageMaker do tworzenia/aktualizowania/usuwania punktów końcowych w celu wdrażania wariantów w tle.

W tym przykładzie mamy dwa modele XGBoost, które reprezentują dwie różne wersje wstępnie wytrenowanych modeli. model.tar.gz to model obecnie wdrożony w produkcji. model2 to nowszy model i chcemy przetestować jego wydajność pod względem wskaźników operacyjnych, takich jak opóźnienie, zanim zdecydujemy się użyć go w środowisku produkcyjnym. Wdrażamy model2 jako wariant cienia model.tar.gz. Oba wstępnie wytrenowane modele są przechowywane w publicznym zasobniku S3 s3://sagemaker-sample-files. Najpierw pobieramy model z naszej lokalnej instancji obliczeniowej, a następnie przesyłamy do S3.

Modele w tym przykładzie służą do przewidywania prawdopodobieństwa odejścia klienta mobilnego od obecnego operatora komórkowego. Zbiór danych, którego używamy, jest publicznie dostępny i został wymieniony w książce Odkrywanie wiedzy w danych przez Daniela T. Larose'a. Modele te były trenowane przy użyciu Notatnik przewidywania odejść XGB w SageMakerze. Możesz także użyć własnych, wstępnie przeszkolonych modeli, w takim przypadku możesz pominąć pobieranie s3://sagemaker-sample-files i skopiuj własne modele bezpośrednio do modelu/folderu.

Krok 1 – Utwórz modele

Przesyłamy pliki modeli do naszego własnego zasobnika S3 i tworzymy dwa modele SageMaker. Zobacz następujący kod:

Krok 2 — Wdróż dwa modele jako warianty produkcyjne i w tle w punkcie końcowym wnioskowania w czasie rzeczywistym

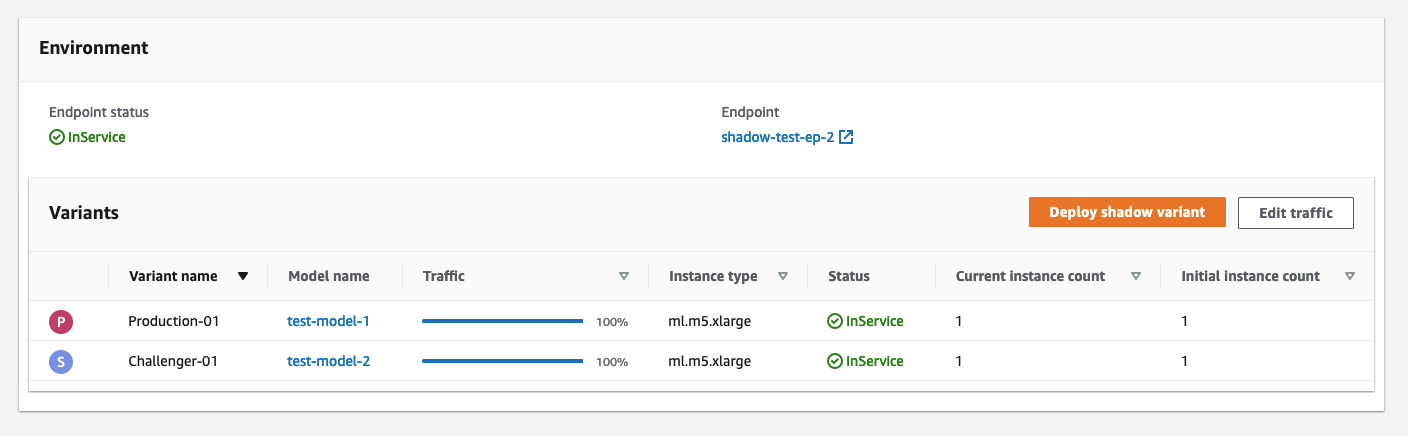

Tworzymy konfigurację punktu końcowego z wariantami produkcyjnymi i shadow. The ProductionVariants i ShadowProductionVariants cieszą się szczególnym zainteresowaniem. Oba te warianty mają instancje ml.m5.xlarge z 4 procesorami wirtualnymi i 16 GiB pamięci, a początkowa liczba instancji jest ustawiona na 1. Zobacz następujący kod:

Na koniec tworzymy wariant produkcyjny i cień:

Krok 3 — Wywołaj punkt końcowy do testowania

Po pomyślnym utworzeniu punktu końcowego można rozpocząć jego wywoływanie. Wysyłamy około 3,000 zapytań w sposób sekwencyjny:

Krok 4 – Porównaj wskaźniki

Teraz, gdy wdrożyliśmy modele produkcyjne i w tle, porównajmy metryki wywołań. Aby uzyskać listę metryk wywołań dostępnych do porównania, zobacz Monitoruj Amazon SageMaker za pomocą Amazon CloudWatch. Zacznijmy od porównania wywołań między wariantami produkcyjnymi i shadow.

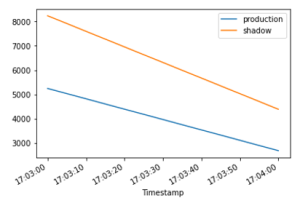

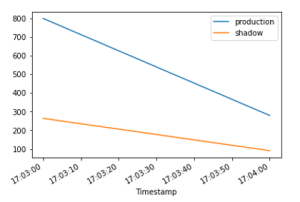

Połączenia InvocationsPerInstance metryka odnosi się do liczby wywołań wysłanych do wariantu produkcyjnego. Ułamek tych wywołań, określony w wadze wariantu, jest wysyłany do wariantu cienia. Wywołanie na instancję jest obliczane poprzez podzielenie całkowitej liczby wywołań przez liczbę instancji w wariancie. Jak pokazano na poniższych wykresach, możemy potwierdzić, że zarówno wariant produkcyjny, jak i cień odbierają żądania wywołania zgodnie z wagami określonymi w konfiguracji punktu końcowego.

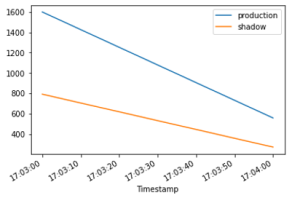

Następnie porównajmy opóźnienie modelu (ModelLatency metryczna) między wariantami produkcyjnymi i cienistymi. Opóźnienie modelu to czas potrzebny modelowi na odpowiedź, widziany z SageMaker. Możemy obserwować, jak opóźnienie modelu wariantu cienia porównuje się z wariantem produkcyjnym bez narażania użytkowników końcowych na wariant cienia.

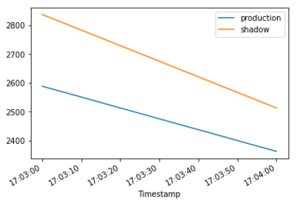

Oczekujemy opóźnienia narzutu (OverheadLatency metryka), aby były porównywalne między wariantami produkcyjnymi i alternatywnymi. Opóźnienie narzutu to interwał mierzony od czasu, w którym SageMaker otrzymuje żądanie do zwrócenia odpowiedzi klientowi, pomniejszony o opóźnienie modelu.

Krok 5 - Promuj swój wariant cienia

Aby awansować model w tle do produkcji, utwórz nową konfigurację punktu końcowego za pomocą current ShadowProductionVariant jak nowy ProductionVariant i usuń ShadowProductionVariant. Spowoduje to usunięcie prądu ProductionVariant i promować wariant cienia, aby stał się nowym wariantem produkcyjnym. Jak zawsze, wszystkie aktualizacje SageMaker są zorganizowane jako niebieskie/zielone wdrożenia pod maską i nie ma utraty dostępności podczas przeprowadzania aktualizacji.

Opcjonalnie możesz skorzystać z dźwigni Poręcze wdrażania jeśli chcesz używać jednorazowego przenoszenia ruchu i automatycznego wycofywania podczas aktualizacji.

Krok 6 – Posprzątaj

Jeśli nie planujesz dalej używać tego punktu końcowego, należy go usunąć, aby uniknąć ponoszenia dodatkowych opłat i wyczyścić inne zasoby utworzone w tym blogu.

Wnioski

W tym poście wprowadziliśmy nową możliwość wnioskowania SageMaker w celu porównania wydajności nowej wersji stosu obsługującego modele z obecnie wdrożoną wersją przed pełnym wdrożeniem produkcyjnym przy użyciu praktyki bezpieczeństwa wdrażania znanej jako testowanie w tle. Przeprowadziliśmy Cię przez zalety korzystania z wariantów cienia i metod konfigurowania wariantów za pomocą narzędzia an przykład od końca do końca. Aby dowiedzieć się więcej o wariantach cienia, zapoznaj się z testami cienia dokumentacja.

O autorach

Raghu Ramesza jest architektem rozwiązań uczenia maszynowego w zespole Amazon SageMaker Service. Koncentruje się na pomaganiu klientom w budowaniu, wdrażaniu i migracji obciążeń produkcyjnych ML do SageMaker na dużą skalę. Specjalizuje się w dziedzinie uczenia maszynowego, sztucznej inteligencji i wizji komputerowej oraz posiada tytuł magistra informatyki uzyskany na UT Dallas. W wolnym czasie lubi podróżować i fotografować.

Raghu Ramesza jest architektem rozwiązań uczenia maszynowego w zespole Amazon SageMaker Service. Koncentruje się na pomaganiu klientom w budowaniu, wdrażaniu i migracji obciążeń produkcyjnych ML do SageMaker na dużą skalę. Specjalizuje się w dziedzinie uczenia maszynowego, sztucznej inteligencji i wizji komputerowej oraz posiada tytuł magistra informatyki uzyskany na UT Dallas. W wolnym czasie lubi podróżować i fotografować.

Qingwei Li jest specjalistą ds. uczenia maszynowego w Amazon Web Services. Uzyskał stopień doktora. w badaniach operacyjnych po tym, jak złamał konto grantu naukowego swojego doradcy i nie przekazał obiecanej nagrody Nobla. Obecnie pomaga klientom z branży usług finansowych i ubezpieczeniowych budować rozwiązania machine learning na AWS. W wolnym czasie lubi czytać i uczyć.

Qingwei Li jest specjalistą ds. uczenia maszynowego w Amazon Web Services. Uzyskał stopień doktora. w badaniach operacyjnych po tym, jak złamał konto grantu naukowego swojego doradcy i nie przekazał obiecanej nagrody Nobla. Obecnie pomaga klientom z branży usług finansowych i ubezpieczeniowych budować rozwiązania machine learning na AWS. W wolnym czasie lubi czytać i uczyć.

Qiyun Zhao jest starszym inżynierem ds. rozwoju oprogramowania w zespole Amazon SageMaker Inference Platform. Jest głównym programistą Deployment Guardrails i Shadow Deployments i koncentruje się na pomaganiu klientom w zarządzaniu obciążeniami i wdrożeniami ML na dużą skalę przy wysokiej dostępności. Pracuje również nad ewolucją architektury platformy w celu szybkiego i bezpiecznego wdrażania zadań ML oraz swobodnego przeprowadzania eksperymentów ML online. W wolnym czasie lubi czytać, grać w gry i podróżować.

Qiyun Zhao jest starszym inżynierem ds. rozwoju oprogramowania w zespole Amazon SageMaker Inference Platform. Jest głównym programistą Deployment Guardrails i Shadow Deployments i koncentruje się na pomaganiu klientom w zarządzaniu obciążeniami i wdrożeniami ML na dużą skalę przy wysokiej dostępności. Pracuje również nad ewolucją architektury platformy w celu szybkiego i bezpiecznego wdrażania zadań ML oraz swobodnego przeprowadzania eksperymentów ML online. W wolnym czasie lubi czytać, grać w gry i podróżować.

Tarun Sairam jest starszym menedżerem produktu w Amazon SageMaker Inference. Interesuje się poznawaniem najnowszych trendów w uczeniu maszynowym i pomaganiem klientom w ich wykorzystaniu. W wolnym czasie lubi jeździć na rowerze, jeździć na nartach i grać w tenisa.

Tarun Sairam jest starszym menedżerem produktu w Amazon SageMaker Inference. Interesuje się poznawaniem najnowszych trendów w uczeniu maszynowym i pomaganiem klientom w ich wykorzystaniu. W wolnym czasie lubi jeździć na rowerze, jeździć na nartach i grać w tenisa.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Uczenie maszynowe Amazon

- Amazon Sage Maker

- Autopilot Amazon SageMaker

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- Testowanie cienia

- składnia

- zefirnet