Raporty radiologiczne to obszerne, obszerne dokumenty opisujące i interpretujące wyniki badania obrazowego radiologicznego. W typowym przebiegu pracy radiolog nadzoruje, czyta i interpretuje obrazy, a następnie zwięźle podsumowuje najważniejsze ustalenia. Podsumowanie (lub wrażenie) jest najważniejszą częścią raportu, ponieważ pomaga klinicystom i pacjentom skoncentrować się na najważniejszej treści raportu, która zawiera informacje potrzebne do podejmowania decyzji klinicznych. Stworzenie jasnego i wpływowego wrażenia wymaga znacznie więcej wysiłku niż zwykłe powtórzenie ustaleń. Cały proces jest zatem pracochłonny, czasochłonny i podatny na błędy. Często potrzeba lat trening aby lekarze zgromadzili wystarczającą wiedzę specjalistyczną w zakresie pisania zwięzłych i pouczających podsumowań raportów radiologicznych, co dodatkowo podkreśla znaczenie automatyzacji procesu. Dodatkowo automatyczne generowanie podsumowań ustaleń raportu ma kluczowe znaczenie dla raportowania radiologicznego. Umożliwia tłumaczenie raportów na język zrozumiały dla człowieka, odciążając w ten sposób obciążenie pacjentów związane z czytaniem długich i niejasnych raportów.

Aby rozwiązać ten problem, proponujemy zastosowanie generatywnej sztucznej inteligencji, czyli rodzaju sztucznej inteligencji, która może tworzyć nowe treści i pomysły, w tym rozmowy, historie, obrazy, filmy i muzykę. Generatywna sztuczna inteligencja opiera się na modelach uczenia maszynowego (ML) — bardzo dużych modelach, które są wstępnie szkolone na ogromnych ilościach danych i powszechnie określa się je mianem modeli podstawowych (FM). Niedawne postępy w uczeniu maszynowym (w szczególności wynalezienie architektury sieci neuronowej opartej na transformatorach) doprowadziły do powstania modeli zawierających miliardy parametrów lub zmiennych. Rozwiązanie zaproponowane w tym poście wykorzystuje dostrajanie wstępnie wytrenowanych modeli dużego języka (LLM), aby pomóc w generowaniu podsumowań na podstawie wyników badań radiologicznych.

W tym poście przedstawiono strategię dostrajania publicznie dostępnych LLM do zadania podsumowania raportów radiologicznych przy użyciu usług AWS. LLM wykazały niezwykłe zdolności w zakresie rozumienia i generowania języka naturalnego, służąc jako podstawowe modele, które można dostosować do różnych dziedzin i zadań. Korzystanie z wstępnie wytrenowanego modelu wiąże się ze znaczącymi korzyściami. Zmniejsza koszty obliczeń, zmniejsza ślad węglowy i pozwala na korzystanie z najnowocześniejszych modeli bez konieczności szkolenia ich od podstaw.

Nasze rozwiązanie wykorzystuje FLAN-T5 XL FM, za pomocą Amazon SageMaker JumpStart, które jest centrum ML oferującym algorytmy, modele i rozwiązania ML. Pokazujemy, jak to osiągnąć za pomocą notatnika w Studio Amazon SageMaker. Dostrajanie wstępnie wyszkolonego modelu obejmuje dalsze szkolenie na określonych danych w celu poprawy wydajności innego, ale powiązanego zadania. Rozwiązanie to polega na dostrojeniu modelu FLAN-T5 XL, który jest udoskonaloną wersją T5 (Transformator transferu tekstu na tekst) ogólnego przeznaczenia LLM. T5 przekształca zadania przetwarzania języka naturalnego (NLP) w ujednolicony format zamiany tekstu na tekst, w przeciwieństwie do BERTI-style modele, które mogą wyświetlać tylko etykietę klasy lub zakres danych wejściowych. Jest dostosowany do zadań podsumowujących 91,544 XNUMX raportów radiologicznych w postaci dowolnego tekstu uzyskanych z Zbiór danych MIMIC-CXR.

Przegląd rozwiązania

W tej sekcji omawiamy kluczowe elementy naszego rozwiązania: wybór strategii dla zadania, dostrojenie LLM i ocenę wyników. Ilustrujemy również architekturę rozwiązania i kroki wdrożenia rozwiązania.

Określ strategię zadania

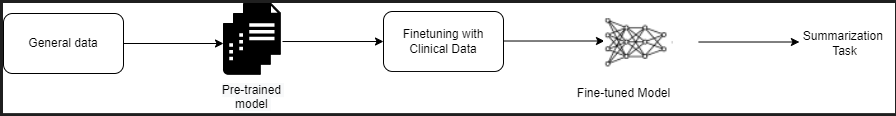

Istnieją różne strategie podejścia do zadania automatyzacji podsumowania raportu klinicznego. Na przykład moglibyśmy zastosować model języka specjalistycznego, wstępnie przeszkolony od podstaw na podstawie raportów klinicznych. Alternatywnie moglibyśmy bezpośrednio dostroić publicznie dostępny model języka ogólnego przeznaczenia, aby wykonać zadanie kliniczne. Korzystanie z precyzyjnie dostrojonego modelu niezależnego od domeny może być konieczne w sytuacjach, w których szkolenie: a model języka od zera jest zbyt kosztowne. W tym rozwiązaniu demonstrujemy drugie podejście polegające na wykorzystaniu modelu FLAN -T5 XL, który dostosowujemy do zadania klinicznego polegającego na podsumowywaniu raportów radiologicznych. Poniższy diagram ilustruje przepływ pracy w modelu.

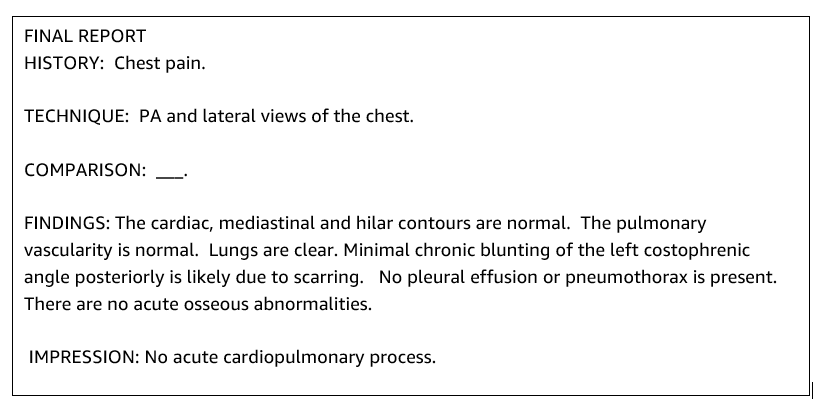

Typowy raport radiologiczny jest dobrze zorganizowany i zwięzły. Takie raporty często składają się z trzech kluczowych sekcji:

- Tło – Dostarcza ogólnych informacji o demografii pacjenta, wraz z niezbędnymi informacjami o pacjencie, historii klinicznej i istotnej historii choroby oraz szczegółach procedur badawczych

- Ustalenia – Przedstawia szczegółową diagnozę i wyniki badania

- druk – Zwięźle podsumowuje najważniejsze ustalenia lub interpretację wyników wraz z oceną znaczenia i potencjalną diagnozą w oparciu o zaobserwowane nieprawidłowości

Korzystając z sekcji wyników w raportach radiologicznych, rozwiązanie generuje sekcję wycisków, która odpowiada podsumowaniu lekarzy. Poniższy rysunek jest przykładem raportu radiologicznego.

Dostosuj LLM ogólnego przeznaczenia do zadania klinicznego

W tym rozwiązaniu dostrajamy model FLAN-T5 XL (dostrajamy wszystkie parametry modelu i optymalizujemy je pod kątem zadania). Dopracowujemy model, korzystając ze zbioru danych domeny klinicznej MIMIC-CXR, który jest publicznie dostępnym zbiorem danych radiogramów klatki piersiowej. Aby dostroić ten model za pomocą narzędzia SageMaker Jumpstart, należy dostarczyć oznaczone przykłady w postaci par {prompt,complete}. W tym przypadku używamy par {Wnioski, Wrażenia} z oryginalnych raportów w zbiorze danych MIMIC-CXR. Do wnioskowania używamy podpowiedzi, jak pokazano w poniższym przykładzie:

![]()

Model jest dopracowywany w oparciu o przyspieszone obliczenia ml.p3.16xduże instancja z 64 wirtualnymi procesorami i 488 GiB pamięci. Do walidacji wybrano losowo 5% zbioru danych. Czas zadania szkoleniowego SageMaker z dostrajaniem wyniósł 38,468 11 sekund (około XNUMX godzin).

Oceń wyniki

Po zakończeniu szkolenia bardzo ważna jest ocena jego wyników. Do ilościowej analizy wygenerowanego wrażenia używamy CZERWONA (Recall-Oriented Understudy for Gisting Evaluation), najczęściej używany miernik do oceny podsumowania. Ta metryka porównuje automatycznie utworzone podsumowanie z odniesieniem lub zestawem odniesień (stworzonym przez człowieka), podsumowaniem lub tłumaczeniem. ROUGE1 odnosi się do nakładania się unigramy (każde słowo) pomiędzy kandydatem (wynikiem modelu) a podsumowaniami referencyjnymi. ROUGE2 odnosi się do nakładania się biggramy (dwa słowa) pomiędzy streszczeniem kandydata i referencjami. ROUGEL jest metryką na poziomie zdania i odnosi się do najdłuższego wspólnego podciągu (LCS) pomiędzy dwoma fragmentami tekstu. Ignoruje znaki nowej linii w tekście. ROUGELsum to metryka na poziomie podsumowania. W przypadku tej metryki znaki nowej linii w tekście nie są ignorowane, ale są interpretowane jako granice zdania. Następnie obliczany jest LCS pomiędzy każdą parą zdań referencyjnych i kandydujących, a następnie obliczana jest suma-LCS. W celu zagregowania tych wyników dla danego zestawu zdań referencyjnych i kandydujących obliczana jest średnia.

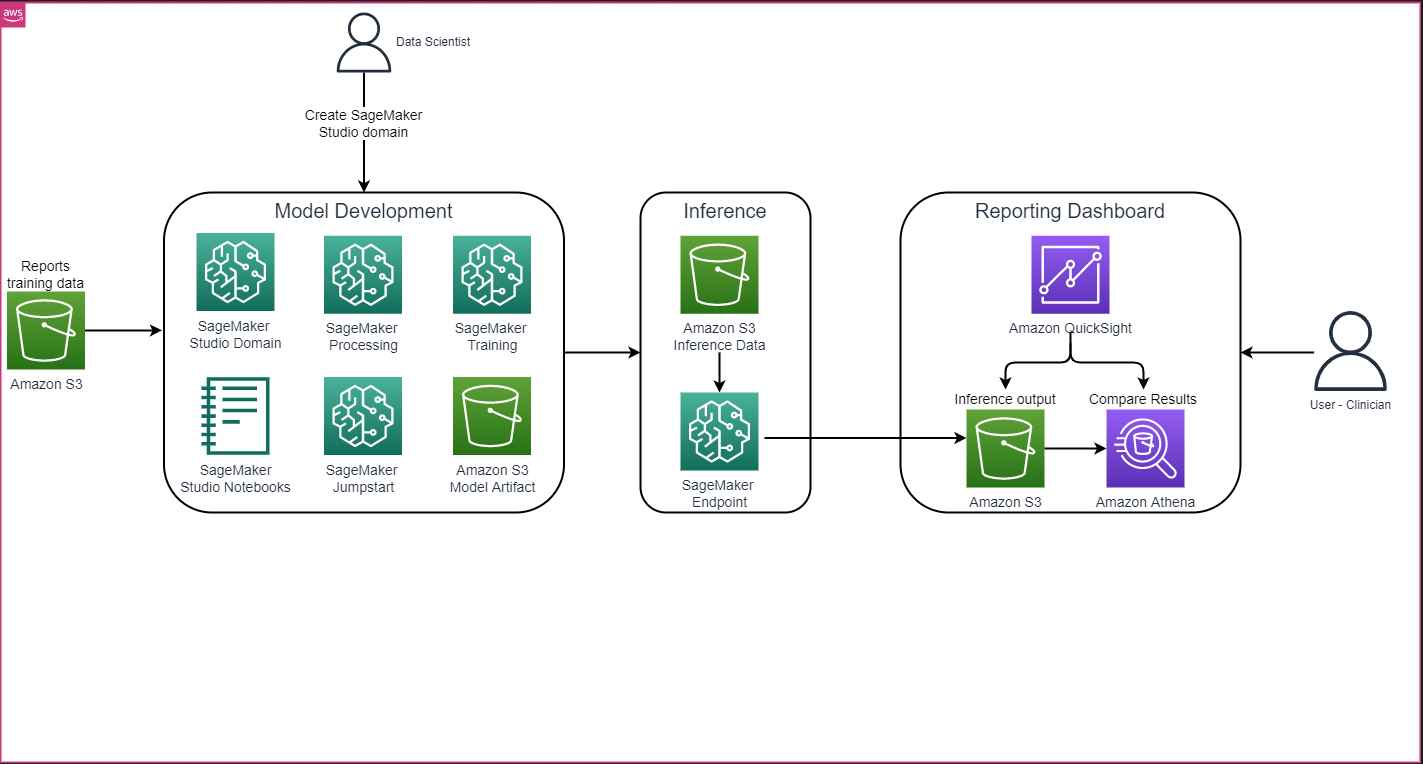

Opis przejścia i architektura

Ogólna architektura rozwiązania pokazana na poniższym rysunku składa się głównie ze środowiska programistycznego modelu korzystającego z SageMaker Studio, wdrożenia modelu z punktem końcowym SageMaker oraz panelu raportowania wykorzystującego Amazon QuickSight.

W poniższych sekcjach demonstrujemy dostrajanie LLM dostępnego w SageMaker JumpStart w celu podsumowania zadań specyficznych dla domeny za pośrednictwem pakietu SageMaker Python SDK. W szczególności poruszamy następujące tematy:

- Kroki konfigurowania środowiska programistycznego

- Przegląd zbiorów danych raportów radiologicznych, na podstawie których model jest dopracowywany i oceniany

- Demonstracja dostrajania modelu FLAN-T5 XL przy użyciu oprogramowania SageMaker JumpStart i pakietu SageMaker Python SDK

- Wnioskowanie i ocena wstępnie wyszkolonych i dostrojonych modeli

- Porównanie wyników z modelu wstępnie wytrenowanego i modelu dostrojonego

Rozwiązanie jest dostępne w Generowanie wycisku raportu radiologicznego przy użyciu generatywnej sztucznej inteligencji z modelem dużego języka w AWS GitHub repo.

Wymagania wstępne

Aby rozpocząć, potrzebujesz Konto AWS w którym możesz korzystać z SageMaker Studio. Będziesz musiał utworzyć profil użytkownika dla SageMaker Studio, jeśli jeszcze go nie masz.

Typ instancji szkoleniowej użyty w tym poście to ml.p3.16xlarge. Należy pamiętać, że typ instancji p3 wymaga zwiększenia limitu usług.

Połączenia Zbiór danych MIMIC CXR można uzyskać dostęp poprzez umowę o korzystaniu z danych, która wymaga rejestracji użytkownika i zakończenia procesu uwierzytelniania.

Skonfiguruj środowisko programistyczne

Aby skonfigurować środowisko programistyczne, utwórz wiadro S3, skonfiguruj notatnik, utwórz punkty końcowe i wdróż modele, a także utwórz pulpit nawigacyjny QuickSight.

Utwórz wiadro S3

Utwórz wiadro S3 nazywa llm-radiology-bucket do przechowywania zbiorów danych dotyczących szkoleń i ocen. Będzie to również wykorzystywane do przechowywania artefaktu modelu podczas jego opracowywania.

Skonfiguruj notatnik

Wykonaj następujące kroki:

- Uruchom SageMaker Studio z konsoli SageMaker lub z pliku Interfejs wiersza poleceń AWS (interfejs wiersza poleceń AWS).

Aby uzyskać więcej informacji na temat dołączania do domeny, zobacz Na pokładzie do domeny Amazon SageMaker.

- Stwórz nowy Notatnik SageMaker Studio do czyszczenia danych raportu i dostrajania modelu. Używamy instancji notebooka ml.t3.medium 2vCPU+4GiB z jądrem Python 3.

- W notebooku zainstaluj odpowiednie pakiety, takie jak

nest-asyncio,IPyWidgets(dla interaktywnych widżetów dla notatnika Jupyter) i SDK SageMaker Python:

Do wnioskowania na temat wstępnie wytrenowanych i dostrojonych modeli utwórz punkt końcowy i wdróż każdy model w notatniku następująco:

- Utwórz obiekt modelu z klasy Model, który można wdrożyć w punkcie końcowym HTTPS.

- Utwórz punkt końcowy HTTPS za pomocą wstępnie skompilowanego obiektu modelu

deploy()metoda:

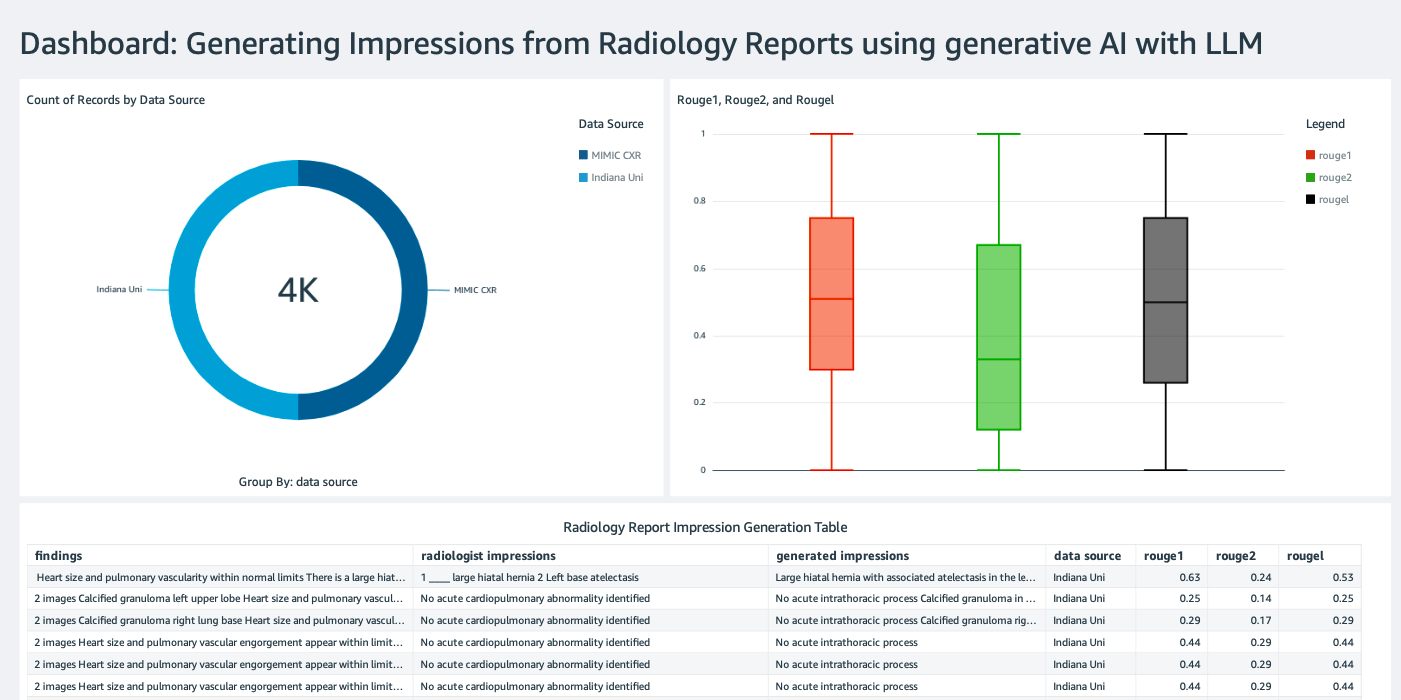

Utwórz pulpit nawigacyjny QuickSight

Stwórz Panel QuickSight ze źródłem danych Athena z wnioskowaniem skutkuje Usługa Amazon Simple Storage (Amazon S3), aby porównać wyniki wnioskowania z podstawową prawdą. Poniższy zrzut ekranu przedstawia nasz przykładowy dashboard.

Zestawy danych raportów radiologicznych

Model jest teraz dostrojony, wszystkie parametry modelu są dostrojone na podstawie 91,544 XNUMX raportów pobranych z witryny Zbiór danych MIMIC-CXR v2.0. Ponieważ korzystaliśmy wyłącznie z danych tekstowych raportu radiologicznego, pobraliśmy tylko jeden skompresowany plik raportu (mimic-cxr-reports.zip) ze strony internetowej MIMIC-CXR. Teraz oceniamy dopracowany model na 2,000 raportów (tzw dev1 zbiór danych) od oddzielnego wystawiony podzbiór tego zbioru danych. Korzystamy z kolejnych 2,000 raportów radiologicznych (tzw dev2) za ocenę dopracowanego modelu z kolekcji zdjęć rentgenowskich klatki piersiowej z Sieć szpitali Uniwersytetu Indiana. Wszystkie zbiory danych są odczytywane jako pliki JSON i przesyłane do nowo utworzonego segmentu S3 llm-radiology-bucket. Należy pamiętać, że wszystkie zbiory danych domyślnie nie zawierają żadnych chronionych informacji zdrowotnych (PHI); wszystkie wrażliwe informacje są zastępowane trzema kolejnymi podkreśleniami (___) przez dostawców.

Dostosuj się dzięki pakietowi SDK SageMaker Python

W celu dokładnego dostrojenia, model_id jest określony jako huggingface-text2text-flan-t5-xl z listy modeli SageMaker JumpStart. The training_instance_type jest ustawiony na ml.p3.16xlarge i inference_instance_type jako ml.g5.2xlarge. Dane szkoleniowe w formacie JSON są odczytywane z segmentu S3. Następnym krokiem jest użycie wybranego model_id do wyodrębnienia identyfikatorów URI zasobów SageMaker JumpStart, w tym image_uri ( Rejestr elastycznego pojemnika Amazon (Amazon ECR) URI dla obrazu Dockera), model_uri (wstępnie wyszkolony artefakt modelu Amazon S3 URI) oraz script_uri (scenariusz szkolenia):

Ponadto lokalizacja wyjściowa jest konfigurowana jako folder w segmencie S3.

Tylko jeden hiperparametr, epoki, zostaje zmieniony na 3, a pozostałe są ustawione jako domyślne:

Metryki szkoleniowe, takie jak eval_loss (za utratę walidacji), loss (z tytułu utraty treningu) oraz epoch które mają być śledzone, są zdefiniowane i wymienione:

Używamy identyfikatorów URI zasobów SageMaker JumpStart (image_uri, model_uri, script_uri) zidentyfikowane wcześniej, aby utworzyć estymator i dostroić go na zbiorze danych szkoleniowych, określając ścieżkę S3 zbioru danych. Klasa Estimator wymaga entry_point parametr. W tym przypadku korzysta z JumpStart transfer_learning.py. Zadanie szkoleniowe nie zostanie uruchomione, jeśli ta wartość nie zostanie ustawiona.

Ukończenie tego zadania szkoleniowego może zająć wiele godzin; dlatego zaleca się ustawienie parametru Wait na False i monitorowanie statusu zadania szkoleniowego w konsoli SageMaker. Użyj TrainingJobAnalytics funkcja śledzenia metryk szkoleniowych w różnych znacznikach czasu:

Wdróż punkty końcowe wnioskowania

Aby dokonać porównań, wdrażamy punkty końcowe wnioskowania zarówno dla modeli wstępnie wyszkolonych, jak i dostrojonych.

Najpierw pobierz wnioskowanie URI obrazu platformy Docker za pomocą model_idi użyj tego identyfikatora URI, aby utworzyć instancję modelu SageMaker dla wstępnie wyszkolonego modelu. Wdróż wstępnie wyszkolony model, tworząc punkt końcowy HTTPS z wstępnie skompilowanym obiektem modelu deploy() metoda. Aby uruchomić wnioskowanie poprzez API SageMaker, należy przekazać klasę Predictor.

Powtórz poprzedni krok, aby utworzyć instancję modelu SageMaker dla precyzyjnie dostrojonego modelu i utwórz punkt końcowy w celu wdrożenia modelu.

Oceń modele

Najpierw ustaw długość podsumowanego tekstu, liczbę wyników modelu (powinna być większa niż 1, jeśli trzeba wygenerować wiele podsumowań) i liczbę belek dla wyszukiwanie wiązki.

Skonstruuj żądanie wnioskowania jako ładunek JSON i użyj go do wysyłania zapytań do punktów końcowych w celu uzyskania wstępnie wytrenowanych i dostrojonych modeli.

Oblicz zagregowane ROUGE zdobywa punkty (ROUGE1, ROUGE2, ROUGEL, ROUGELsum), jak opisano wcześniej.

Porównaj wyniki

Poniższa tabela przedstawia wyniki oceny dla dev1 i dev2 zbiory danych. Wynik oceny dot dev1 (2,000 ustaleń z raportu radiologicznego MIMIC CXR) pokazuje poprawę zagregowanej średniej o około 38 punktów procentowych ROUGE1 i ROUGE2 wyniki w porównaniu z modelem wstępnie wytrenowanym. W przypadku dev2 zaobserwowano poprawę wyników ROUGE31 i ROUGE25 o 1 punktów procentowych i 2 punktów procentowych. Ogólnie rzecz biorąc, dostrajanie doprowadziło do poprawy wyników ROUGELsum o 38.2 punktu procentowego i 31.3 punktu procentowego dla dev1 i dev2 odpowiednio zbiory danych.

|

Ocena Dataset |

Wstępnie przeszkolony model | Model dopracowany | ||||||

| RÓŻ 1 | RÓŻ 2 | ROUGEL | ROUGEL suma | RÓŻ 1 | RÓŻ 2 | ROUGEL | ROUGEL suma | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

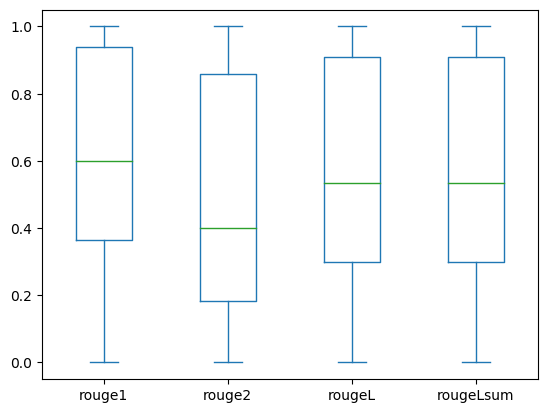

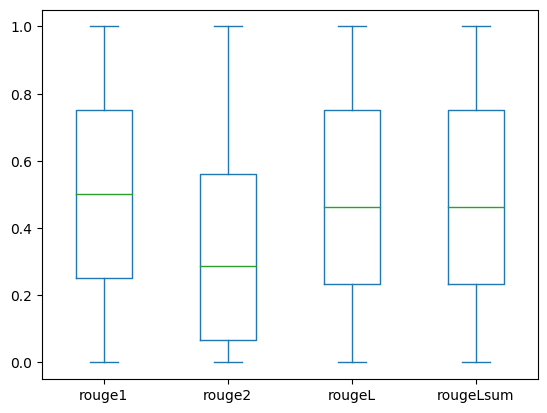

Poniższe wykresy pudełkowe przedstawiają rozkład wyników ROUGE dla: dev1 i dev2 zbiory danych oceniane przy użyciu dopracowanego modelu.

|

|

(O): dev1 |

(B): dev2 |

Poniższa tabela pokazuje, że wyniki ROUGE dla zbiorów danych oceny mają w przybliżeniu tę samą medianę i średnią, a zatem są rozłożone symetrycznie.

| Zbiory danych | Partitury | Liczyć | Oznaczać | Odchylenie standardowe | Minimum | 25% percentyl | 50% percentyl | 75% percentyl | Maksymalny |

dev1 |

RÓŻ 1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| RÓŻ 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGEL suma | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

RÓŻ 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| RÓŻ 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Sprzątać

Aby uniknąć przyszłych opłat, usuń utworzone zasoby za pomocą następującego kodu:

Wnioski

W tym poście zademonstrowaliśmy, jak dostroić model FLAN-T5 XL do zadania podsumowania specyficznego dla domeny klinicznej za pomocą SageMaker Studio. Aby zwiększyć pewność, porównaliśmy przewidywania z prawdą i oceniliśmy wyniki za pomocą wskaźników ROUGE. Pokazaliśmy, że model dostosowany do konkretnego zadania daje lepsze wyniki niż model wstępnie przeszkolony do ogólnego zadania NLP. Chcielibyśmy podkreślić, że dostrojenie LLM ogólnego przeznaczenia całkowicie eliminuje koszty szkolenia wstępnego.

Chociaż prezentowane tutaj prace skupiają się na raportach rentgenowskich klatki piersiowej, można je rozszerzyć na większe zbiory danych o różnej anatomii i modalnościach, takie jak MRI i CT, w przypadku których raporty radiologiczne mogą być bardziej złożone i zawierać wiele wyników. W takich przypadkach radiolodzy mogą pobrać wyciski według stopnia krytyczności i dołączyć zalecenia dotyczące dalszych obserwacji. Ponadto utworzenie pętli sprzężenia zwrotnego dla tej aplikacji umożliwiłoby radiologom poprawę wydajności modelu w miarę upływu czasu.

Jak pokazaliśmy w tym poście, dopracowany model generuje wyciski do raportów radiologicznych z wysokimi wynikami ROUGE. Możesz spróbować dostosować LLM do innych raportów medycznych specyficznych dla domeny z różnych działów.

O autorach

Doktor Adewale Akinfaderin jest starszym analitykiem danych w dziedzinie opieki zdrowotnej i nauk przyrodniczych w AWS. Jego wiedza specjalistyczna obejmuje powtarzalne i kompleksowe metody AI/ML, praktyczne wdrożenia oraz pomaganie klientom z branży opieki zdrowotnej na całym świecie w formułowaniu i opracowywaniu skalowalnych rozwiązań problemów interdyscyplinarnych. Posiada dwa stopnie naukowe z fizyki i stopień doktora inżynierii.

Doktor Adewale Akinfaderin jest starszym analitykiem danych w dziedzinie opieki zdrowotnej i nauk przyrodniczych w AWS. Jego wiedza specjalistyczna obejmuje powtarzalne i kompleksowe metody AI/ML, praktyczne wdrożenia oraz pomaganie klientom z branży opieki zdrowotnej na całym świecie w formułowaniu i opracowywaniu skalowalnych rozwiązań problemów interdyscyplinarnych. Posiada dwa stopnie naukowe z fizyki i stopień doktora inżynierii.

Priya Padate jest starszym architektem rozwiązań partnerskich z rozległą wiedzą specjalistyczną w zakresie opieki zdrowotnej i nauk przyrodniczych w AWS. Priya wraz z partnerami tworzy strategie wejścia na rynek i wspiera rozwój rozwiązań w celu przyspieszenia rozwoju opartego na sztucznej inteligencji/ML. Jej pasją jest wykorzystywanie technologii do przekształcania branży opieki zdrowotnej w celu poprawy wyników opieki nad pacjentami.

Priya Padate jest starszym architektem rozwiązań partnerskich z rozległą wiedzą specjalistyczną w zakresie opieki zdrowotnej i nauk przyrodniczych w AWS. Priya wraz z partnerami tworzy strategie wejścia na rynek i wspiera rozwój rozwiązań w celu przyspieszenia rozwoju opartego na sztucznej inteligencji/ML. Jej pasją jest wykorzystywanie technologii do przekształcania branży opieki zdrowotnej w celu poprawy wyników opieki nad pacjentami.

Ekta Walia Bhullar, doktor, jest starszym konsultantem AI/ML w jednostce biznesowej usług profesjonalnych AWS Healthcare and Life Sciences (HCLS). Posiada szerokie doświadczenie w stosowaniu AI/ML w służbie zdrowia, zwłaszcza w radiologii. Poza pracą, jeśli nie rozmawia o sztucznej inteligencji w radiologii, lubi biegać i wędrować.

Ekta Walia Bhullar, doktor, jest starszym konsultantem AI/ML w jednostce biznesowej usług profesjonalnych AWS Healthcare and Life Sciences (HCLS). Posiada szerokie doświadczenie w stosowaniu AI/ML w służbie zdrowia, zwłaszcza w radiologii. Poza pracą, jeśli nie rozmawia o sztucznej inteligencji w radiologii, lubi biegać i wędrować.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- ChartPrime. Podnieś poziom swojej gry handlowej dzięki ChartPrime. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Zdolny

- O nas

- przyśpieszyć

- przyśpieszony

- dostęp

- wykonać

- Gromadź BTC

- do tego

- postępy

- przed

- zbiór

- Umowa

- AI

- AI / ML

- Algorytmy

- Wszystkie kategorie

- pozwala

- już

- również

- całkowicie

- Amazonka

- Amazon Sage Maker

- Amazon Web Services

- kwoty

- an

- analiza

- i

- Inne

- każdy

- api

- Zastosowanie

- podejście

- w przybliżeniu

- architektura

- SĄ

- argument

- AS

- oszacowanie

- At

- automatycznie

- automatycznie

- automatyzacja

- dostępny

- średni

- uniknąć

- AWS

- baza

- na podstawie

- BE

- bo

- zanim

- jest

- Korzyści

- Ulepsz Swój

- pomiędzy

- większe

- miliardy

- obie

- Granice

- Pudełko

- ciężar

- biznes

- ale

- by

- nazywa

- CAN

- kandydat

- możliwości

- węgiel

- który

- walizka

- Etui

- zmieniony

- Opłaty

- Wybierając

- klasa

- Sprzątanie

- jasny

- Kliniczne

- klinicyści

- kod

- kolekcja

- wspólny

- powszechnie

- porównać

- w porównaniu

- kompletny

- ukończenia

- kompleks

- składniki

- wszechstronny

- obliczenia

- computing

- zwięzły

- pewność siebie

- kolejny

- składa się

- Konsola

- konsultant

- zawierać

- Pojemnik

- zawartość

- treść

- kontrast

- rozmowy

- odpowiada

- Koszty:

- kosztowny

- Koszty:

- mógłby

- Para

- Stwórz

- stworzony

- Tworzenie

- krytyczny

- krytyczność

- zwyczaj

- Klientów

- tablica rozdzielcza

- dane

- naukowiec danych

- zbiory danych

- Podejmowanie decyzji

- Domyślnie

- zdefiniowane

- Stopień

- Demografia

- wykazać

- wykazać

- demonstruje

- Działy

- rozwijać

- wdrażane

- Wdrożenie

- opisać

- opisane

- szczegółowe

- detale

- rozwijać

- oprogramowania

- różne

- bezpośrednio

- dyskutować

- Omawiając

- dystrybuowane

- 分配

- Doker

- Lekarze

- dokumenty

- domena

- domeny

- nie

- rysować

- napęd

- dyski

- podczas

- każdy

- Wcześniej

- wysiłek

- bądź

- eliminuje

- więcej

- umożliwiać

- Umożliwia

- koniec końców

- Punkt końcowy

- Inżynieria

- wzmocnione

- dość

- Cały

- Środowisko

- epoka

- epoki

- błąd

- szczególnie

- niezbędny

- oceniać

- oceniane

- oceny

- ewaluację

- egzamin

- przykład

- przykłady

- wykonać

- rozszerzony

- doświadczenie

- ekspertyza

- rozległy

- Szerokie doświadczenie

- wyciąg

- nie

- fałszywy

- informacja zwrotna

- Postać

- filet

- Akta

- Ustalenia

- Skupiać

- koncentruje

- następujący

- następujący sposób

- W razie zamówieenia projektu

- Nasz formularz

- format

- Fundacja

- od

- funkcjonować

- dalej

- Ponadto

- przyszłość

- Ogólne

- ogólny cel

- Generować

- wygenerowane

- generuje

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- dany

- Globalne

- Idź do sklepu

- absolwent

- większy

- Ziemia

- Have

- mający

- he

- Zdrowie

- informacje o zdrowiu

- opieki zdrowotnej

- przemysł medyczny

- pomoc

- pomoc

- pomaga

- tutaj

- Wysoki

- podświetlanie

- Wycieczka

- jego

- historia

- gospodarz

- GODZINY

- W jaki sposób

- How To

- HTML

- http

- HTTPS

- Piasta

- Przytulanie twarzy

- człowiek

- ID

- pomysły

- zidentyfikowane

- if

- ilustruje

- obraz

- zdjęcia

- Obrazowanie

- wpływowy

- wdrożenia

- wdrożenia

- importować

- ważny

- podnieść

- poprawa

- in

- zawierać

- Włącznie z

- Zwiększać

- przemysł

- Informacja

- informacyjny

- wkład

- zainstalować

- przykład

- interaktywne

- interpretacja

- najnowszych

- Wynalazek

- IT

- Praca

- Oferty pracy

- json

- właśnie

- tylko jeden

- Trzymać

- Klawisz

- Etykieta

- język

- duży

- uruchomić

- nauka

- Doprowadziło

- Długość

- życie

- Life Sciences

- lubić

- lubi

- LIMIT

- Linia

- Lista

- Katalogowany

- LLM

- usytuowany

- lokalizacja

- od

- maszyna

- uczenie maszynowe

- robić

- Może..

- oznaczać

- medyczny

- średni

- Pamięć

- metoda

- metody

- metryczny

- Metryka

- może

- minut

- ML

- model

- modele

- monitor

- jeszcze

- większość

- MRI

- dużo

- wielokrotność

- Muzyka

- musi

- Nazwa

- Naturalny

- Przetwarzanie języka naturalnego

- niezbędny

- Potrzebować

- sieć

- sieci neuronowe

- Nowości

- nowo

- Następny

- nlp

- notatnik

- już dziś

- numer

- przedmiot

- uzyskane

- of

- oferuje

- często

- on

- Wprowadzenie

- ONE

- tylko

- optymalizacji

- or

- zamówienie

- oryginalny

- Inne

- ludzkiej,

- na zewnątrz

- wyniki

- wydajność

- zewnętrzne

- koniec

- ogólny

- Zastąp

- przegląd

- Pakiety

- đôi

- par

- parametr

- parametry

- część

- szczególny

- partnerem

- wzmacniacz

- przechodzić

- namiętny

- ścieżka

- pacjent

- pacjenci

- procent

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- PhD

- Fizyka

- sztuk

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- zwrotnica

- Post

- potencjał

- powered

- Praktyczny

- Przewidywania

- Urządzenie prognozujące

- przedstawione

- prezenty

- głównie

- Problem

- problemy

- wygląda tak

- przetwarzanie

- Wytworzony

- profesjonalny

- Profil

- zaproponować

- zaproponowane

- chroniony

- pod warunkiem,

- dostawców

- zapewnia

- publicznie

- Python

- ilościowy

- Czytaj

- Czytający

- niedawny

- zalecenia

- Zalecana

- zmniejsza

- referencje

- , o którym mowa

- odnosi

- regex

- Rejestracja

- związane z

- znakomity

- otrzymuje

- raport

- Raportowanie

- Raporty

- zażądać

- wymagany

- Wymaga

- Zasób

- Zasoby

- odpowiednio

- REST

- dalsze

- Efekt

- powraca

- Rosnąć

- run

- bieganie

- sagemaker

- taki sam

- skalowalny

- NAUKI

- Naukowiec

- zadraśnięcie

- Sdk

- Szukaj

- sekund

- Sekcja

- działy

- widzieć

- wybrany

- senior

- wrażliwy

- wyrok

- oddzielny

- usługa

- Usługi

- służąc

- zestaw

- ustawienie

- w panelu ustawień

- ona

- powinien

- pokazał

- pokazane

- Targi

- znaczenie

- znaczący

- Prosty

- po prostu

- mały

- So

- rozwiązanie

- Rozwiązania

- ROZWIĄZANIA

- kilka

- rozpiętość

- wyspecjalizowanym

- specyficzny

- swoiście

- określony

- początek

- rozpoczęty

- state-of-the-art

- Rynek

- Ewolucja krok po kroku

- Cel

- Nadal

- przechowywanie

- sklep

- historie

- strategie

- Strategia

- studio

- taki

- PODSUMOWANIE

- pewnie

- stół

- Brać

- trwa

- Zadanie

- zadania

- Technologia

- niż

- że

- Połączenia

- Im

- następnie

- Tam.

- a tym samym

- w związku z tym

- Te

- to

- tych

- trzy

- Przez

- czas

- do

- także

- tematy

- śledzić

- Pociąg

- Trening

- przenieść

- Przekształcać

- transformator

- Tłumaczenie

- Prawda

- próbować

- drugiej

- rodzaj

- typowy

- podkreślenia

- zrozumienie

- Ujednolicony

- jednostka

- uniwersytet

- przesłanych

- posługiwać się

- używany

- Użytkownik

- zastosowania

- za pomocą

- uprawomocnienie

- wartość

- Wartości

- różnorodny

- Naprawiono

- wersja

- przez

- Filmy

- Wirtualny

- czekać

- była

- we

- sieć

- usługi internetowe

- Strona internetowa

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- szerokość

- będzie

- w

- w ciągu

- bez

- słowo

- słowa

- Praca

- workflow

- by

- pisanie

- rentgenowski

- lat

- You

- Twój

- zefirnet