Wprowadzenie

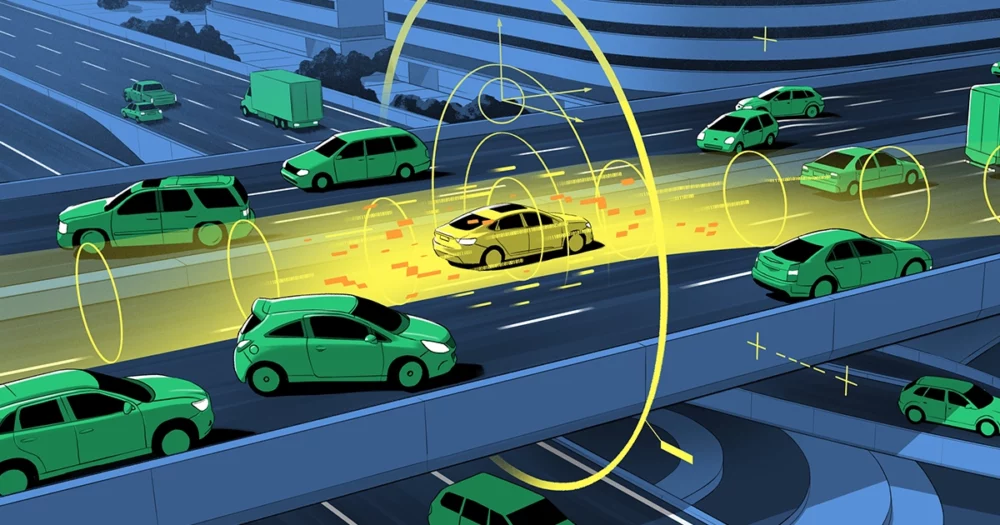

Samochody i samoloty bez kierowcy nie są już przyszłością. W samym mieście San Francisco dwie firmy taksówkarskie do sierpnia 8 r. przejechały łącznie 2023 milionów mil autonomicznej jazdy. W Stanach Zjednoczonych zarejestrowanych jest ponad 850,000 XNUMX autonomicznych statków powietrznych, czyli dronów – nie licząc tych będących własnością wojska.

Istnieją jednak uzasadnione obawy dotyczące bezpieczeństwa. Na przykład w okresie 10 miesięcy zakończonym w maju 2022 r. Krajowa Administracja ds. Bezpieczeństwa Ruchu Drogowego zgłaszane prawie 400 wypadków z udziałem samochodów korzystających z jakiejś formy autonomicznej kontroli. W wyniku tych wypadków zginęło sześć osób, a pięć zostało ciężko rannych.

Zwykły sposób rozwiązania tego problemu — czasami nazywany „testowaniem przez wyczerpanie” — polega na testowaniu tych systemów do czasu upewnienia się, że są bezpieczne. Ale nigdy nie możesz być pewien, że ten proces odkryje wszystkie potencjalne wady. „Ludzie przeprowadzają testy, dopóki nie wyczerpią się zasoby i cierpliwość” – powiedział Sajan Mitra, informatyk na Uniwersytecie Illinois w Urbana-Champaign. Same testy nie mogą jednak zapewnić gwarancji.

Mitra i jego koledzy mogą. Jego drużynie się to udało dowód dotychczasowy bezpieczeństwo możliwości śledzenia pasa ruchu dla samochodów i systemy lądowania dla autonomicznych samolotów. Ich strategia jest obecnie wykorzystywana do pomocy w lądowaniu dronów na lotniskowcach, a Boeing planuje w tym roku przetestować ją na eksperymentalnym samolocie. „Ich metoda zapewniania kompleksowych gwarancji bezpieczeństwa jest bardzo ważna” – powiedział Corina Pasareanu, pracownik naukowy na Uniwersytecie Carnegie Mellon i Centrum Badawczym Amesa w NASA.

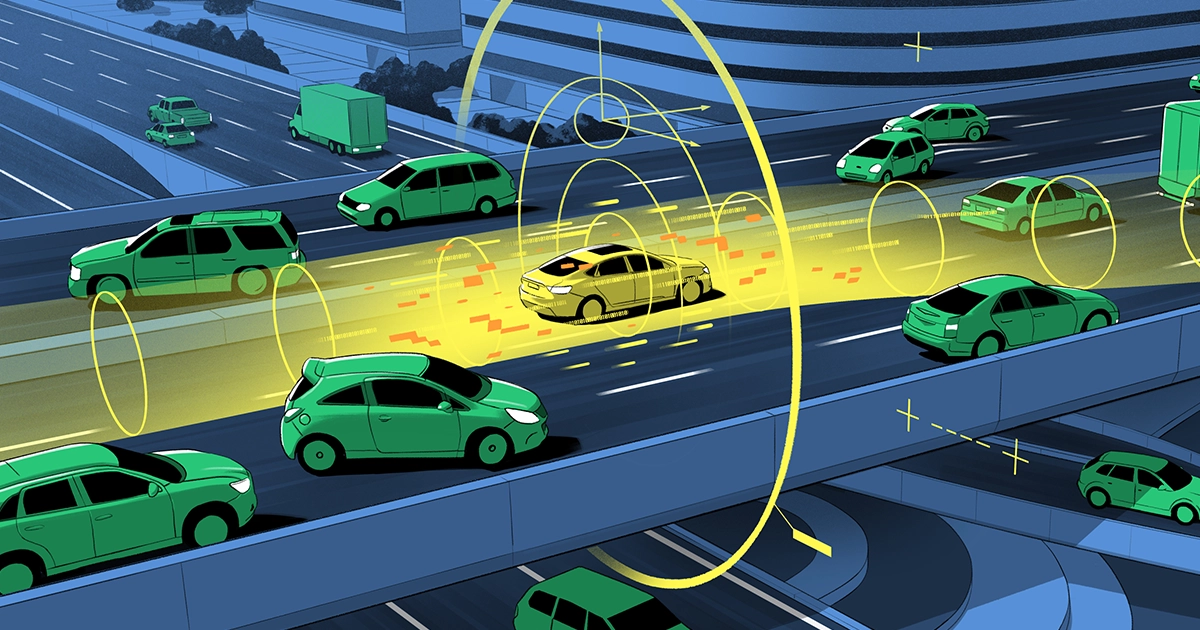

Ich praca polega na gwarantowaniu wyników algorytmów uczenia maszynowego wykorzystywanych do informowania pojazdów autonomicznych. Ogólnie rzecz biorąc, wiele pojazdów autonomicznych składa się z dwóch elementów: systemu percepcyjnego i systemu sterowania. System percepcji informuje Cię na przykład, jak daleko znajduje się Twój samochód od środka pasa ruchu, w jakim kierunku zmierza samolot i jaki jest jego kąt względem horyzontu. System działa poprzez dostarczanie surowych danych z kamer i innych narzędzi sensorycznych do algorytmów uczenia maszynowego opartych na sieciach neuronowych, które odtwarzają środowisko na zewnątrz pojazdu.

Oceny te są następnie przesyłane do osobnego systemu, modułu sterującego, który decyduje, co zrobić. Na przykład, jeśli zbliża się przeszkoda, decyduje, czy nacisnąć hamulce, czy ominąć ją. Według Luca Carlone, profesor nadzwyczajny w Massachusetts Institute of Technology, choć moduł sterujący opiera się na uznanej technologii, „podejmuje decyzje na podstawie wyników percepcji i nie ma gwarancji, że wyniki te są prawidłowe”.

Aby zapewnić gwarancję bezpieczeństwa, zespół Mitry pracował nad zapewnieniem niezawodności systemu percepcji pojazdu. Najpierw założyli, że bezpieczeństwo można zagwarantować, gdy dostępne jest doskonałe odwzorowanie świata zewnętrznego. Następnie określili, ile błędów system percepcji wprowadza do odtwarzania otoczenia pojazdu.

Kluczem do tej strategii jest ilościowe określenie związanych z tym niepewności, zwanych pasmem błędu lub „znanymi niewiadomymi”, jak to ujął Mitra. Obliczenia te pochodzą z czegoś, co on i jego zespół nazywają kontraktem percepcji. W inżynierii oprogramowania kontrakt jest zobowiązaniem, że dla danego wejścia do programu komputerowego wynik będzie mieścić się w określonym zakresie. Ustalenie tego zakresu nie jest łatwe. Jak dokładne są czujniki w samochodzie? Jak dużo mgły, deszczu lub blasku słońca może tolerować dron? Jeśli jednak uda się utrzymać pojazd w określonym przedziale niepewności i określenie tego zakresu będzie wystarczająco dokładne, zespół Mitry udowodnił, że można zapewnić mu bezpieczeństwo.

Wprowadzenie

Jest to sytuacja znana każdemu, kto ma niedokładny prędkościomierz. Jeśli wiesz, że urządzenie nigdy nie wyłącza się o więcej niż 5 mil na godzinę, nadal możesz unikać przekroczenia prędkości, utrzymując prędkość o 5 mil na godzinę poniżej dopuszczalnej prędkości (jak wskazuje twój niewiarygodny prędkościomierz). Kontrakt percepcji daje podobną gwarancję bezpieczeństwa niedoskonałego systemu, który opiera się na uczeniu maszynowym.

„Nie potrzebujesz doskonałej percepcji” – powiedział Carlone. „Chcesz tylko, żeby było wystarczająco dobre, aby nie zagrażać bezpieczeństwu”. Największy wkład zespołu, stwierdził, polega na „przedstawieniu całej idei kontraktów percepcyjnych” i zapewnieniu metod ich konstruowania. Dokonali tego, czerpiąc z technik z dziedziny informatyki zwanej weryfikacją formalną, która zapewnia matematyczny sposób potwierdzenia, że zachowanie systemu spełnia zestaw wymagań.

„Chociaż nie wiemy dokładnie, jak sieć neuronowa robi to, co robi” – stwierdził Mitra, wykazali, że nadal możliwe jest udowodnienie liczbowe, że niepewność sygnału wyjściowego sieci neuronowej mieści się w pewnych granicach. A jeśli tak jest, system będzie bezpieczny. „Możemy wtedy zapewnić statystyczną gwarancję, czy (i w jakim stopniu) dana sieć neuronowa rzeczywiście spełni te ograniczenia”.

Firma lotnicza Sierra Nevada testuje obecnie te gwarancje bezpieczeństwa podczas lądowania drona na lotniskowcu. Problem ten jest pod pewnymi względami bardziej skomplikowany niż prowadzenie samochodu ze względu na dodatkowy wymiar związany z lataniem. „Podczas lądowania istnieją dwa główne zadania” – powiedział Dragos Marginantu, główny technolog AI w Boeingu, „dopasowuje samolot do pasa startowego i upewnia się, że pas startowy jest wolny od przeszkód. Nasza współpraca z Sayanem wiąże się z uzyskaniem gwarancji na te dwie funkcje.”

„Symulacje z wykorzystaniem algorytmu Sayana pokazują, że ustawienie [samolotu przed lądowaniem] rzeczywiście się poprawia” – powiedział. Następnym krokiem, zaplanowanym na koniec tego roku, będzie wykorzystanie tych systemów podczas lądowania eksperymentalnego samolotu Boeinga. Margineantu zauważył, że jednym z największych wyzwań będzie ustalenie, czego nie wiemy – „określenie niepewności naszych szacunków” – i sprawdzenie, jak to wpływa na bezpieczeństwo. „Większość błędów ma miejsce, gdy robimy rzeczy, o których myślimy, że wiemy, a okazuje się, że tak nie jest”.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.quantamagazine.org/how-to-guarantee-the-safety-of-autonomous-vehicles-20240116/

- :ma

- :Jest

- :nie

- ][P

- 000

- 2022

- 2023

- 400

- 8

- a

- O nas

- wypadki

- Stosownie

- dokładny

- ACM

- faktycznie

- adresowanie

- administracja

- Lotnictwo

- AI

- samolot

- algorytm

- Algorytmy

- wyrównanie

- Wszystkie kategorie

- sam

- zawsze

- an

- i

- ktoś

- Aplikuj

- SĄ

- na około

- AS

- oceny

- Współpracownik

- przypuszczalny

- At

- Sierpnia

- autonomiczny

- pojazdy autonomiczne

- dostępny

- uniknąć

- ZESPÓŁ MUZYCZNY

- na podstawie

- BE

- bo

- zachowanie

- jest

- poniżej

- Najwyższa

- Boeing

- miedza

- Oddział

- ale

- by

- obliczenie

- wezwanie

- nazywa

- kamery

- CAN

- nie może

- możliwości

- wózek

- Carnegie Mellona

- przewoźnicy

- nieść

- samochody

- walizka

- Centrum

- pewien

- wyzwania

- szef

- Miasto

- koledzy

- zbiorowo

- byliśmy spójni, od początku

- zobowiązanie

- Firmy

- sukcesy firma

- skomplikowane

- składniki

- komputer

- Computer Science

- Obawy

- budowy

- umowa

- składki

- kontrola

- skorygowania

- rachunkowość

- Obecnie

- dane

- Decyzje

- Stopień

- zależy

- determinacja

- ustalona

- urządzenie

- ZROBIŁ

- zmarł

- Wymiary

- kierunek

- do

- robi

- nie

- rysunek

- jazdy

- Warkot

- Drony

- łatwo

- koniec końców

- zakończony

- Inżynieria

- dość

- zapewnić

- zapewnienie

- Cały

- Środowisko

- błąd

- Błędy

- dokładnie

- przykład

- eksperymentalny

- dodatkowy

- Spadać

- znajomy

- daleko

- karmienie

- i terminów, a

- pięć

- Skazy

- latający

- Mgła

- W razie zamówieenia projektu

- Nasz formularz

- formalny

- Francisco

- Darmowy

- od

- Funkcje

- przyszłość

- miejsce

- dany

- dobry

- gwarancja

- gwarancji

- zdarzyć

- Have

- he

- Nagłówek

- pomoc

- Wysoki

- Autostrada

- jego

- horyzont

- godzina

- W jaki sposób

- How To

- Jednak

- HTML

- HTTPS

- pomysł

- IEEE

- if

- Illinois

- ważny

- podnieść

- in

- wskazany

- informować

- wkład

- przykład

- Instytut

- najnowszych

- Przedstawia

- zaangażowany

- z udziałem

- problem

- IT

- JEGO

- właśnie

- Trzymać

- Klawisz

- Wiedzieć

- znany

- Kraj

- lądowanie

- Tor

- później

- nauka

- prawowity

- poziom

- leży

- LIMIT

- zalogowany

- dłużej

- maszyna

- uczenie maszynowe

- magazyn

- Główny

- Dokonywanie

- zarządzane

- wiele

- massachusetts

- Instytut Technologii w Massachusetts

- matematyczny

- Może..

- Poznaj nasz

- Mellon

- metoda

- metody

- Wojsko

- milion

- MIT

- Moduł

- jeszcze

- dużo

- narodowy

- prawie

- Potrzebować

- sieć

- sieci

- nerwowy

- sieci neuronowe

- sieci neuronowe

- NEVADA

- nigdy

- Następny

- Nie

- zauważyć

- już dziś

- przeszkoda

- Przeszkody

- of

- poza

- on

- ONE

- działa

- or

- Inne

- ludzkiej,

- na zewnątrz

- wydajność

- zewnętrzne

- własność

- Cierpliwość

- Ludzie

- dla

- postrzeganie

- doskonały

- okres

- samolot

- planowany

- plany

- plato

- Analiza danych Platona

- PlatoDane

- możliwy

- potencjał

- Wcześniejszy

- Problem

- wygląda tak

- Profesor

- Program

- Udowodnij

- okazały

- zapewniać

- zapewnia

- że

- położyć

- RAIN

- zasięg

- Surowy

- zarejestrowany

- niezawodność

- wykonanie

- wymagania

- Badania naukowe

- Zasoby

- poszanowanie

- dalsze

- Efekt

- Ryzyko

- pas startowy

- "bezpiecznym"

- Bezpieczeństwo

- Powiedział

- San

- San Francisco

- zadowolony

- nauka

- Naukowiec

- widzenie

- czujniki

- wysłany

- oddzielny

- poważnie

- zestaw

- pokazać

- pokazał

- podobny

- sytuacja

- SIX

- So

- Tworzenie

- Inżynieria oprogramowania

- słoneczny

- kilka

- czasami

- określony

- prędkość

- Zjednoczone

- statystyczny

- przebywający

- sterować

- Ewolucja krok po kroku

- Nadal

- Strategia

- pewnie

- system

- systemy

- zadania

- zespół

- Techniki

- technolog

- Technologia

- mówi

- test

- Testowanie

- Testy

- niż

- że

- Połączenia

- Przyszłość

- ich

- Im

- następnie

- Tam.

- Te

- one

- rzeczy

- myśleć

- to

- w tym roku

- tych

- chociaż?

- Przez

- do

- narzędzia

- ruch drogowy

- włącza

- drugiej

- niepewności

- Niepewność

- odkryć

- Zjednoczony

- United States

- uniwersytet

- aż do

- zbliżających

- używany

- za pomocą

- zwykły

- pojazd

- Pojazdy

- Weryfikacja

- początku.

- chcieć

- Droga..

- sposoby

- we

- webp

- były

- Co

- jeśli chodzi o komunikację i motywację

- czy

- który

- Podczas

- będzie

- w

- w ciągu

- Praca

- pracował

- świat

- rok

- You

- Twój

- zefirnet