Na całym świecie nastąpiła przyspieszona zmiana w kierunku bezproblemowych cyfrowych doświadczeń użytkowników. Niezależnie od tego, czy chodzi o rejestrację na stronie internetowej, dokonywanie transakcji online, czy po prostu logowanie się na konto bankowe, organizacje aktywnie starają się zmniejszyć tarcia, jakich doświadczają ich klienci, jednocześnie ulepszając środki bezpieczeństwa, zgodności i zapobiegania oszustwom. Przejście w kierunku bezproblemowych doświadczeń użytkowników zaowocowało rozwiązaniami do biometrycznej weryfikacji tożsamości opartymi na twarzy, których celem jest odpowiedź na pytanie „Jak zweryfikować osobę w cyfrowym świecie?”

Istnieją dwie kluczowe zalety biometrii twarzy, jeśli chodzi o kwestie identyfikacji i uwierzytelniania. Po pierwsze, jest to wygodna technologia dla użytkowników: nie trzeba pamiętać hasła, radzić sobie z wieloczynnikowymi wyzwaniami, klikać linków weryfikacyjnych ani rozwiązywać zagadek CAPTCHA. Po drugie, osiąga się wysoki poziom bezpieczeństwa: identyfikacja i uwierzytelnianie na podstawie danych biometrycznych twarzy jest bezpieczne i mniej podatne na oszustwa i ataki.

W tym poście przyjrzymy się dwóm podstawowym przypadkom użycia weryfikacji tożsamości: wprowadzaniu i uwierzytelnianiu. Następnie zagłębimy się w dwa kluczowe wskaźniki używane do oceny dokładności systemu biometrycznego: współczynnik fałszywych dopasowań (znany również jako współczynnik fałszywych akceptacji) i współczynnik fałszywych niedopasowań (znany również jako współczynnik fałszywych odrzuceń). Te dwie miary są szeroko stosowane przez organizacje do oceny dokładności i poziomu błędów systemów biometrycznych. Na koniec omawiamy ramy i najlepsze praktyki przeprowadzania oceny usługi weryfikacji tożsamości.

Patrz załączony Notatnik Jupyter który przechodzi przez wszystkie kroki wymienione w tym poście.

Przypadki użycia: wprowadzanie i uwierzytelnianie

Istnieją dwa podstawowe przypadki użycia rozwiązań biometrycznych: wprowadzanie użytkowników (często określane jako weryfikacja) i uwierzytelnianie (często określane jako identyfikacja). Onboarding polega na dopasowaniu twarzy jeden do jednego między dwoma obrazami, na przykład porównanie selfie z zaufanym dokumentem tożsamości, takim jak prawo jazdy lub paszport. Uwierzytelnianie, z drugiej strony, polega na wyszukiwaniu twarzy jeden do wielu w przechowywanym zbiorze twarzy, na przykład przeszukiwaniu zbioru twarzy pracowników w celu sprawdzenia, czy pracownik ma upoważniony dostęp do określonego piętra w budynku.

Dokładność przypadków użycia w zakresie wdrażania i uwierzytelniania jest mierzona na podstawie błędów fałszywie dodatnich i fałszywie ujemnych, które może popełnić rozwiązanie biometryczne. Wynik podobieństwa (od 0% oznaczający brak dopasowania do 100% oznaczający idealne dopasowanie) jest używany do określenia dopasowania lub decyzji o braku dopasowania. Fałszywy alarm pojawia się, gdy rozwiązanie traktuje obrazy dwóch różnych osób jako tę samą osobę. Z drugiej strony fałszywy wynik negatywny oznacza, że rozwiązanie uznało dwa obrazy tej samej osoby za różne.

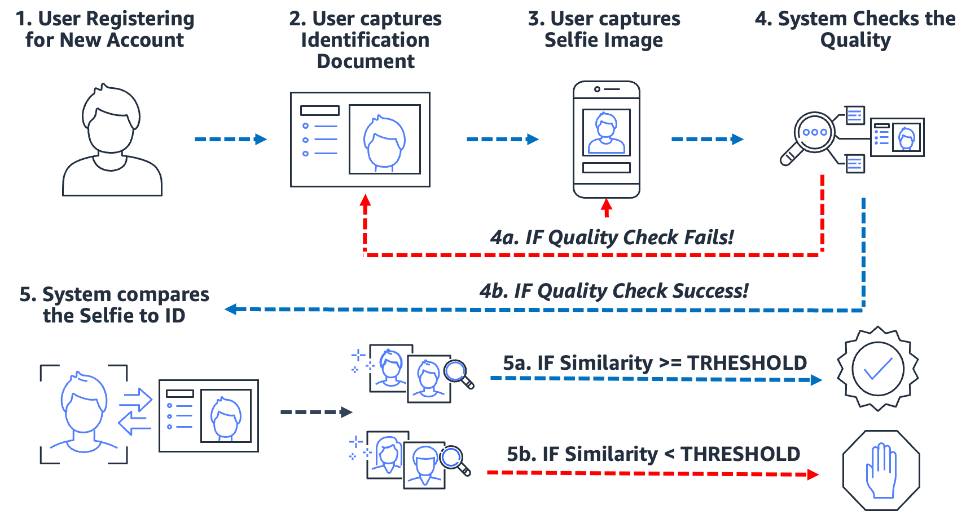

Wdrażanie: weryfikacja indywidualna

Procesy onboardingu oparte na danych biometrycznych zarówno upraszczają, jak i zabezpieczają ten proces. Co najważniejsze, przygotowuje organizację i klienta do niemal bezproblemowego wdrożenia. Aby to zrobić, użytkownicy muszą po prostu przedstawić zdjęcie jakiejś formy zaufanego dokumentu tożsamości zawierającego twarz użytkownika (takiego jak prawo jazdy lub paszport), a także zrobić zdjęcie selfie podczas procesu onboardingu. Po uzyskaniu tych dwóch obrazów system po prostu porównuje twarze na tych dwóch obrazach. Kiedy podobieństwo jest większe niż określony próg, mamy dopasowanie; w przeciwnym razie masz niedopasowanie. Poniższy schemat przedstawia ten proces.

Rozważmy przykład Julie, nowego użytkownika otwierającego cyfrowe konto bankowe. Rozwiązanie prosi ją o zrobienie zdjęcia prawa jazdy (krok 2) i zrobienie sobie selfie (krok 3). Po sprawdzeniu jakości zdjęć przez system (krok 4), porównuje twarz na selfie z twarzą na prawie jazdy (dopasowanie jeden do jednego) i generowana jest ocena podobieństwa (krok 5). Jeśli wynik podobieństwa jest niższy niż wymagany próg podobieństwa, próba przyjęcia Julie zostaje odrzucona. To właśnie nazywamy fałszywym niedopasowaniem lub fałszywym odrzuceniem: rozwiązanie uważało, że dwa obrazy tej samej osoby są różne. Z drugiej strony, jeśli wynik podobieństwa był większy niż wymagane podobieństwo, wówczas rozwiązanie traktuje te dwa obrazy jako tę samą osobę lub dopasowanie.

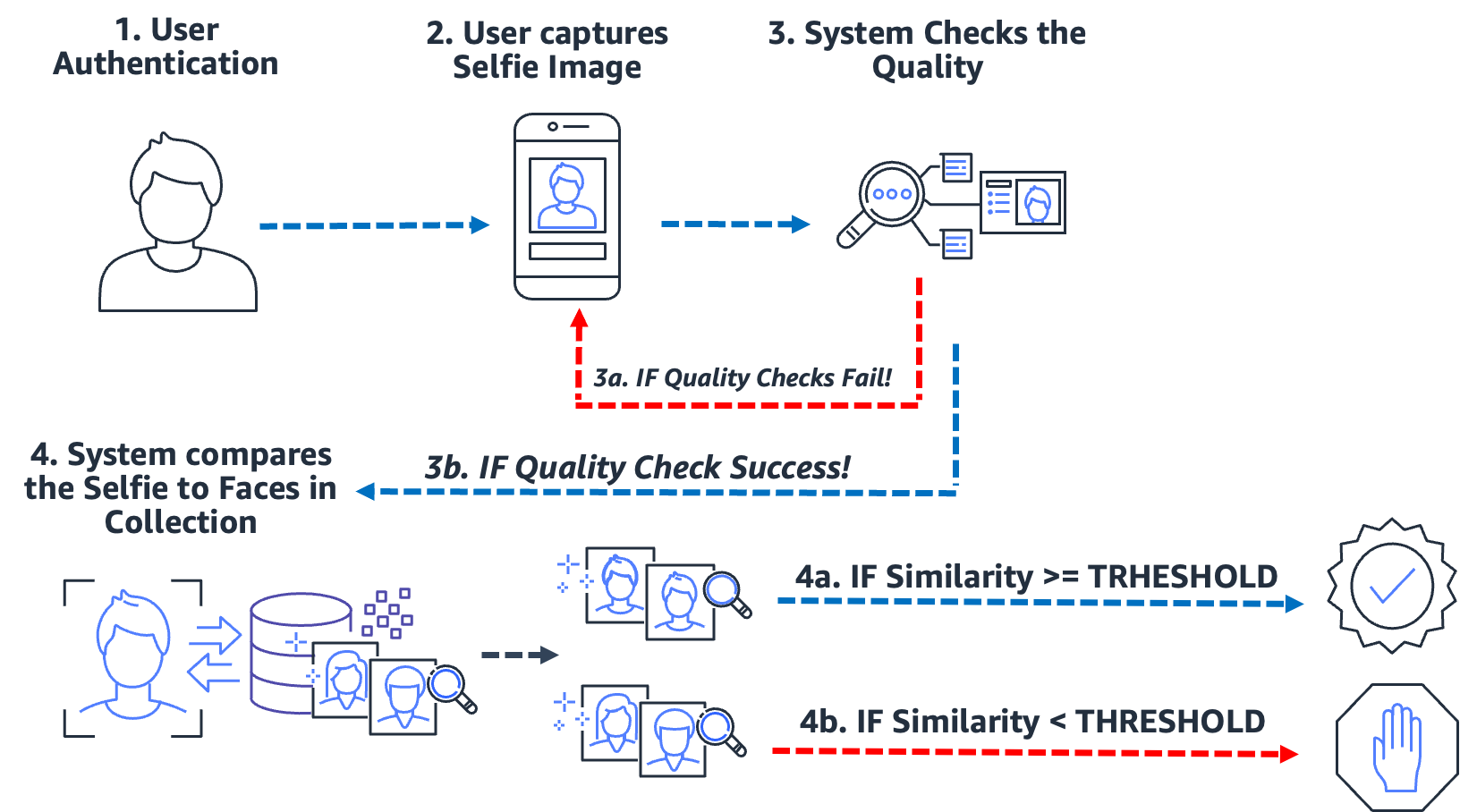

Uwierzytelnianie: Identyfikacja jeden do wielu

Od wejścia do budynku, przez meldowanie się w kiosku, aż po monitowanie użytkownika o zrobienie sobie selfie w celu zweryfikowania jego tożsamości, ten typ uwierzytelniania od zera do niskiego tarcia za pomocą rozpoznawania twarzy stał się powszechny w wielu organizacjach. Zamiast przeprowadzać dopasowywanie obrazu do obrazu, ten przypadek użycia uwierzytelniania bierze pojedynczy obraz i porównuje go z przeszukiwalną kolekcją obrazów w celu potencjalnego dopasowania. W typowym przypadku użycia uwierzytelniania użytkownik jest proszony o zrobienie selfie, które jest następnie porównywane z twarzami przechowywanymi w kolekcji. Wynik wyszukiwania daje zero, jedno lub więcej potencjalnych dopasowań z odpowiednimi wynikami podobieństwa i identyfikatorami zewnętrznymi. Jeśli nie zostanie zwrócone żadne dopasowanie, użytkownik nie zostanie uwierzytelniony; jednak zakładając, że wyszukiwanie zwróci jedno lub więcej dopasowań, system podejmuje decyzję o uwierzytelnieniu na podstawie wyników podobieństwa i zewnętrznych identyfikatorów. Jeśli wynik podobieństwa przekroczy wymagany próg podobieństwa, a identyfikator zewnętrzny pasuje do oczekiwanego identyfikatora, wówczas użytkownik zostaje uwierzytelniony (dopasowany). Na poniższym diagramie przedstawiono przykładowy proces uwierzytelniania biometrycznego na podstawie twarzy.

Rozważmy przykład Jose, który jest dostawcą usług ekonomicznych. Usługa dostawy uwierzytelnia kierowców dostarczających, prosząc kierowcę o zrobienie sobie selfie przed rozpoczęciem dostawy za pomocą firmowej aplikacji mobilnej. Jednym z problemów, z jakimi borykają się dostawcy usług w ramach gospodarki koncertowej, jest dzielenie się pracą; zasadniczo dwóch lub więcej użytkowników korzysta z tego samego konta, aby grać w system. Aby temu zaradzić, wiele usługodawców korzysta z kamery samochodowej, aby robić zdjęcia kierowcy (krok 2) w losowych momentach podczas dostawy (aby upewnić się, że kierowca dostawy jest upoważnionym kierowcą). W tym przypadku Jose nie tylko robi selfie na początku porodu, ale kamera w samochodzie robi mu zdjęcia podczas porodu. System przeprowadza kontrolę jakości (krok 3) i przeszukuje (krok 4) zbiór zarejestrowanych kierowców w celu weryfikacji tożsamości kierowcy. Jeśli zostanie wykryty inny kierowca, usługa dostawy gig-economy może przeprowadzić dalsze dochodzenie.

Fałszywe dopasowanie (fałszywie dodatnie) występuje, gdy rozwiązanie uważa dwa lub więcej obrazów różnych osób za tę samą osobę. W naszym przypadku załóżmy, że zamiast autoryzowanego kierowcy, Jose, pozwala swojemu bratu Miguelowi odebrać za niego jedną z jego dostaw. Jeśli rozwiązanie nieprawidłowo dopasuje selfie Miguela do zdjęć Jose, nastąpi fałszywe dopasowanie (fałszywie dodatnie).

Aby zwalczyć potencjalne fałszywe dopasowania, zalecamy, aby kolekcje zawierały kilka zdjęć każdego tematu. Powszechną praktyką jest indeksowanie zaufanych dokumentów identyfikacyjnych zawierających twarz, selfie w momencie wejścia na pokład oraz selfie z kilku ostatnich kontroli tożsamości. Indeksowanie kilku obrazów podmiotu zapewnia możliwość agregowania wyników podobieństwa zwróconych twarzy, poprawiając w ten sposób dokładność identyfikacji. Dodatkowo stosowane są identyfikatory zewnętrzne w celu ograniczenia ryzyka fałszywej akceptacji. Przykładowa reguła biznesowa może wyglądać mniej więcej tak:

JEŻELI zagregowany wynik podobieństwa >= wymagany próg podobieństwa ORAZ identyfikator zewnętrzny == oczekiwany identyfikator TO uwierzytelnienie

Kluczowe środki dokładności biometrycznej

W systemie biometrycznym interesuje nas współczynnik fałszywych dopasowań (FMR) i fałszywy współczynnik niezgodności (FNMR) na podstawie wyników podobieństwa z porównań i wyszukiwań twarzy. Niezależnie od tego, czy chodzi o wdrożenie, czy uwierzytelnienie, systemy biometryczne decydują o zaakceptowaniu lub odrzuceniu dopasowań twarzy użytkownika na podstawie wyniku podobieństwa dwóch lub więcej obrazów. Jak każdy system decyzyjny, wystąpią błędy, gdy system niepoprawnie zaakceptuje lub odrzuci próbę onboardingu lub uwierzytelnienia. W ramach oceny rozwiązania do weryfikacji tożsamości należy ocenić system przy różnych progach podobieństwa, aby zminimalizować liczbę fałszywych dopasowań i fałszywych niedopasowań, a także porównać te błędy z kosztami błędnych odrzuceń i akceptacji. Używamy FMR i FNMR jako naszych dwóch kluczowych wskaźników do oceny systemów biometrycznych twarzy.

Fałszywy współczynnik niedopasowania

Gdy system weryfikacji tożsamości nie może poprawnie zidentyfikować lub autoryzować prawdziwego użytkownika, pojawia się fałszywa niezgodność, znana również jako fałszywie negatywna. Współczynnik fałszywych niedopasowań (FNMR) jest miarą podatności systemu na nieprawidłową identyfikację lub autoryzację prawdziwego użytkownika.

FNMR jest wyrażony jako procent przypadków, w których podejmowana jest próba wejścia na pokład lub uwierzytelnienia, w których twarz użytkownika jest nieprawidłowo odrzucana (fałszywy wynik negatywny), ponieważ wynik podobieństwa jest poniżej określonego progu.

Prawdziwie pozytywna (TP) ma miejsce, gdy rozwiązanie uważa dwa lub więcej obrazów tej samej osoby za takie same. Oznacza to, że podobieństwo porównania lub wyszukiwania przekracza wymagany próg podobieństwa.

Fałszywy wynik negatywny (FN) ma miejsce, gdy rozwiązanie uznaje dwa lub więcej obrazów tej samej osoby za różne. Oznacza to, że podobieństwo porównania lub wyszukiwania jest poniżej wymaganego progu podobieństwa.

Wzór na FNMR to:

FNMR = liczba fałszywie ujemnych / (liczba prawdziwie dodatnia + liczba fałszywie ujemnych)

Załóżmy na przykład, że mamy 10,000 100 autentycznych prób uwierzytelnienia, ale 9,900 zostało odrzuconych, ponieważ ich podobieństwo do obrazu referencyjnego lub kolekcji spada poniżej określonego progu podobieństwa. Tutaj mamy 100 wyników prawdziwie dodatnich i 1.0 wyników fałszywie ujemnych, dlatego nasz FNMR wynosi XNUMX%.

FNMR = 100 / (9900 + 100) lub 1.0%

Fałszywy współczynnik dopasowania

Gdy system weryfikacji tożsamości nieprawidłowo identyfikuje lub autoryzuje nieautoryzowanego użytkownika jako prawdziwego, występuje fałszywe dopasowanie, znane również jako fałszywy alarm. Współczynnik fałszywych dopasowań (FMR) jest miarą podatności systemu na błędną identyfikację lub autoryzację nieautoryzowanego użytkownika. Mierzy się to liczbą fałszywych rozpoznań lub uwierzytelnień podzieloną przez całkowitą liczbę prób identyfikacji.

Fałszywy alarm pojawia się, gdy rozwiązanie traktuje dwa lub więcej obrazów różnych osób jako tę samą osobę. Oznacza to, że wynik podobieństwa porównania lub wyszukiwania przekracza wymagany próg podobieństwa. Zasadniczo system nieprawidłowo identyfikuje lub autoryzuje użytkownika, podczas gdy powinien był odrzucić jego próbę identyfikacji lub uwierzytelnienia.

Wzór na FMR to:

FMR = liczba fałszywie dodatnich wyników / (całkowita liczba prób)

Załóżmy na przykład, że mamy 100,000 100 prób uwierzytelnienia, ale 100 fałszywych użytkowników zostało nieprawidłowo autoryzowanych, ponieważ ich podobieństwo do obrazu referencyjnego lub kolekcji przekracza określony próg podobieństwa. Tutaj mamy 0.01 fałszywych alarmów, dlatego nasz FMR wynosi XNUMX%

FMR = 100 / (100,000 0.01) lub XNUMX%

Współczynnik fałszywych dopasowań a współczynnik fałszywych niedopasowań

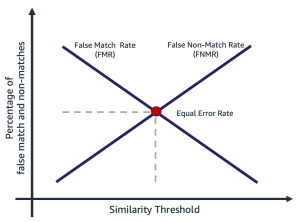

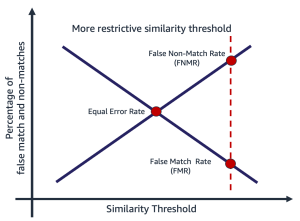

Fałszywy współczynnik dopasowania i fałszywy współczynnik niedopasowania są ze sobą sprzeczne. Wraz ze wzrostem progu podobieństwa zmniejsza się prawdopodobieństwo fałszywego dopasowania, podczas gdy wzrasta prawdopodobieństwo fałszywego braku dopasowania. Innym sposobem myślenia o tym kompromisie jest to, że wraz ze wzrostem progu podobieństwa rozwiązanie staje się bardziej restrykcyjne, powodując mniej dopasowań o niskim podobieństwie. Na przykład często zdarza się, że przypadki użycia związane z bezpieczeństwem publicznym ustawiają dość wysoki próg podobieństwa dopasowania (99 i więcej). Alternatywnie, organizacja może wybrać mniej restrykcyjny próg podobieństwa (90 i więcej), gdzie ważniejszy jest wpływ tarcia na użytkownika. Poniższy diagram ilustruje te kompromisy. Wyzwaniem dla organizacji jest znalezienie progu, który minimalizuje zarówno FMR, jak i FNMR w oparciu o wymagania organizacji i aplikacji.

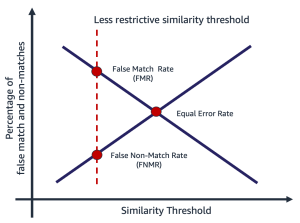

Wybór progu podobieństwa zależy od aplikacji biznesowej. Załóżmy na przykład, że chcesz ograniczyć konflikty z klientami podczas dołączania (mniej restrykcyjny próg podobieństwa, jak pokazano na poniższym rysunku po lewej). W tym przypadku możesz mieć niższy wymagany próg podobieństwa i jesteś skłonny zaakceptować ryzyko dołączania użytkowników, których pewność dopasowania między ich selfie a prawem jazdy jest niższa. Z drugiej strony załóżmy, że chcesz mieć pewność, że tylko autoryzowani użytkownicy będą mieli dostęp do aplikacji. Tutaj możesz działać na dość restrykcyjnym progu podobieństwa (jak pokazano na rysunku po prawej).

|

|

Etapy obliczania współczynników fałszywego dopasowania i niedopasowania

Istnieje kilka sposobów obliczania tych dwóch wskaźników. Poniżej przedstawiono stosunkowo proste podejście polegające na podzieleniu kroków na zebranie prawdziwych par obrazów, utworzenie parowania oszustów (obrazy, które nie powinny pasować), a na koniec użycie sondy do zapętlenia oczekiwanych par obrazów pasujących i niedopasowanych, przechwytując wynikłe podobieństwo. Kroki są następujące:

- Zbierz prawdziwy przykładowy zestaw obrazów. Zalecamy rozpoczęcie od zestawu par obrazów i przypisanie zewnętrznego identyfikatora, który służy do oficjalnego ustalenia dopasowania. Para składa się z następujących obrazów:

- Obraz źródłowy — Twój zaufany obraz źródłowy, na przykład prawo jazdy.

- Obraz docelowy – Twoje selfie lub zdjęcie, z którym będziesz porównywać.

- Zbierz zestaw obrazów pasujących do oszustów. Są to pary obrazów, w których źródło i cel nie pasują do siebie. Służy do oceny FMR (prawdopodobieństwo, że system nieprawidłowo dopasuje twarze dwóch różnych użytkowników). Możesz utworzyć zestaw obrazów oszusta, używając par obrazów, tworząc iloczyn kartezjański obrazów, a następnie filtrując i próbkując wynik.

- Zbadaj oryginalne i fałszywe zestawy dopasowań, przeglądając pary obrazów, porównując źródło i cel oszusta oraz przechwytując wynikające z tego podobieństwo.

- Oblicz FMR i FNMR, obliczając wyniki fałszywie dodatnie i fałszywie ujemne przy różnych minimalnych progach podobieństwa.

Możesz oszacować koszt FMR i FNMR przy różnych progach podobieństwa w zależności od potrzeb Twojej aplikacji.

Krok 1: Zbierz oryginalne próbki par obrazów

Wybór reprezentatywnej próbki par obrazów do oceny ma kluczowe znaczenie podczas oceny usługi weryfikacji tożsamości. Pierwszym krokiem jest zidentyfikowanie prawdziwego zestawu par obrazów. Są to znane obrazy źródłowe i docelowe użytkownika. Prawdziwe parowanie obrazów służy do oceny FNMR, zasadniczo prawdopodobieństwa, że system nie dopasuje dwóch twarzy tej samej osoby. Jedno z pierwszych często zadawanych pytań brzmi: „Ile par obrazów jest potrzebnych?” Odpowiedź brzmi: zależy to od przypadku użycia, ale ogólne wytyczne są następujące:

- Miarą wykonalności jest od 100 do 1,000 par obrazów

- Do 10,000 XNUMX par obrazów to wystarczająco dużo, aby zmierzyć zmienność między obrazami

- Ponad 10,000 XNUMX par obrazów stanowi miarę jakości operacyjnej i możliwości uogólnienia

Więcej danych jest zawsze lepsze; jednak jako punkt wyjścia użyj co najmniej 1,000 par obrazów. Jednak nierzadko zdarza się, że używa się ponad 10,000 XNUMX par obrazów, aby wyzerować akceptowalny FNMR lub FMR dla danego problemu biznesowego.

Poniżej znajduje się przykładowy plik mapowania par obrazów. Używamy pliku mapowania par obrazów do kierowania resztą procesu oceny.

| ZEWNĘTRZNY_ID | ŹRÓDŁO | TARGET | TESTOWANIE |

| 9055 | 9055_M0.jpeg | 9055_M1.jpeg | prawdziwy |

| 19066 | 19066_M0.jpeg | 19066_M1.jpeg | prawdziwy |

| 11396 | 11396_M0.jpeg | 11396_M1.jpeg | prawdziwy |

| 12657 | 12657_M0.jpeg | 12657_M1.jpeg | prawdziwy |

| ... | . | . | . |

Krok 2: Wygeneruj parę fałszywych obrazów zestaw

Teraz, gdy masz plik prawdziwych par obrazów, możesz utworzyć iloczyn kartezjański obrazów docelowych i źródłowych, w których zewnętrzne identyfikatory nie pasują. Powoduje to utworzenie par źródło-docelowych, które nie powinny pasować. To parowanie służy do oceny FMR, zasadniczo prawdopodobieństwa, że system dopasuje twarz jednego użytkownika do twarzy innego użytkownika.

| identyfikator_zewnętrzny | ŹRÓDŁO | TARGET | TESTOWANIE |

| 114192 | 114192_4M49.jpeg | 307107_00M17.jpeg | Imposter |

| 105300 | 105300_04F42.jpeg | 035557_00M53.jpeg | Imposter |

| 110771 | 110771_3M44.jpeg | 120381_1M33.jpeg | Imposter |

| 281333 | 281333_04F35.jpeg | 314769_01M17.jpeg | Imposter |

| 40081 | 040081_2F52.jpeg | 326169_00F32.jpeg | Imposter |

| ... | . | . | . |

Krok 3: Zbadaj oryginalne i fałszywe zestawy par obrazów

Za pomocą programu sterującego nakładamy Amazon Rekognition Interfejs API PorównajFaski nad parami obrazów i uchwycić podobieństwo. Możesz także przechwytywać dodatkowe informacje, takie jak ułożenie, jakość i inne wyniki porównania. Oceny podobieństwa są wykorzystywane do obliczenia współczynnika fałszywego dopasowania i niedopasowania w następnym kroku.

W poniższym fragmencie kodu stosujemy interfejs API CompareFaces do wszystkich par obrazów i wypełniamy wszystkie wyniki podobieństwa w tabeli:

Fragment kodu daje następujące dane wyjściowe.

| ZEWNĘTRZNY_ID | ŹRÓDŁO | TARGET | TESTOWANIE | PODOBIEŃSTWO |

| 9055 | 9055_M0.jpeg | 9055_M1.jpeg | prawdziwy | 98.3 |

| 19066 | 19066_M0.jpeg | 19066_M1.jpeg | prawdziwy | 94.3 |

| 11396 | 11396_M0.jpeg | 11396_M1.jpeg | prawdziwy | 96.1 |

| ... | . | . | . | . |

| 114192 | 114192_4M49.jpeg | 307107_00M17.jpeg | Imposter | 0.0 |

| 105300 | 105300_04F42.jpeg | 035557_00M53.jpeg | Imposter | 0.0 |

| 110771 | 110771_3M44.jpeg | 120381_1M33.jpeg | Imposter | 0.0 |

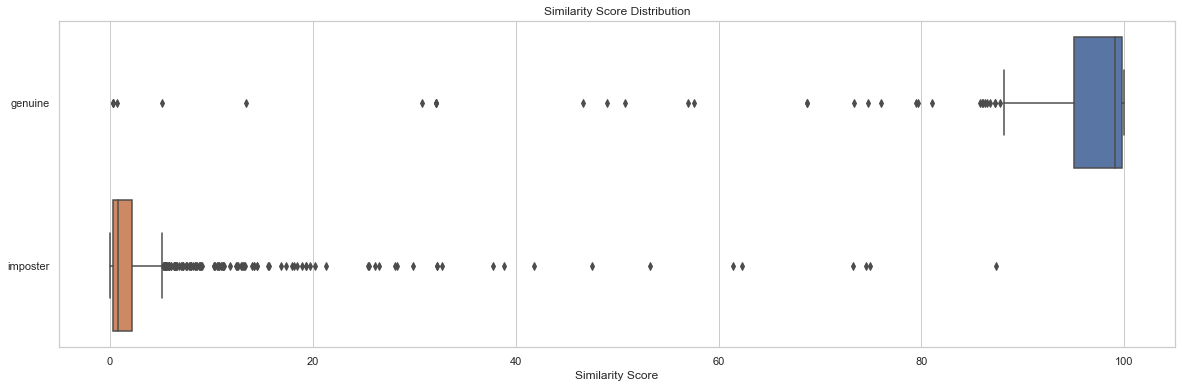

Analiza rozkładu wyników podobieństwa według testów jest punktem wyjścia do zrozumienia wyniku podobieństwa według par obrazów. Poniższy fragment kodu i wykres wyjściowy pokazują prosty przykład rozkładu wyniku podobieństwa według zestawu testów, a także wynikowe statystyki opisowe:

| test | liczyć | min | max | oznaczać | mediana | std |

| prawdziwy | 204 | 0.2778 | 99.9957 | 91.7357 | 99.0961 | 19.9097 |

| oszust | 1020 | 0.0075 | 87.3893 | 2.8111 | 0.8330 | 7.3496 |

W tym przykładzie widzimy, że średnie i mediana podobieństwa dla prawdziwych par twarzy wynosiła 91.7 i 99.1, podczas gdy dla par oszustów odpowiednio 2.8 i 0.8. Zgodnie z oczekiwaniami, pokazuje to wysokie wyniki podobieństwa dla prawdziwych par obrazów i niskie wyniki podobieństwa dla par obrazów oszustów.

Krok 4: Oblicz FMR i FNMR przy różnych poziomach progowych podobieństwa

W tym kroku obliczamy odsetek fałszywych dopasowań i niedopasowań przy różnych progach podobieństwa. Aby to zrobić, po prostu przechodzimy przez progi podobieństwa (na przykład 90–100). Przy każdym wybranym progu podobieństwa obliczamy naszą macierz zamieszania zawierającą liczby prawdziwie dodatnie, prawdziwie ujemne, fałszywie dodatnie i fałszywie ujemne, które są wykorzystywane do obliczania FMR i FNMR przy każdym wybranym podobieństwie.

| Aktualne | |||

| Przewidywana | |||

| . | Mecz | Nie pasuje | |

| >= wybrane podobieństwo | TP | FP | |

| < wybrane podobieństwo | FN | TN | |

Aby to zrobić, tworzymy funkcję, która zwraca liczby fałszywie dodatnie i ujemne, i przechodzi przez zakres wyników podobieństwa (90–100):

Poniższa tabela przedstawia wyniki zliczeń dla każdego progu podobieństwa.

| Próg podobieństwa | TN | FN | TP | FP | FNMR | FMR |

| 80 | 1019 | 22 | 182 | 1 | 0.1% | 0.1% |

| 85 | 1019 | 23 | 181 | 1 | 0.11% | 0.1% |

| 90 | 1020 | 35 | 169 | 0 | 0.12% | 0.0% |

| 95 | 1020 | 51 | 153 | 0 | 0.2% | 0.0% |

| 96 | 1020 | 53 | 151 | 0 | 0.25% | 0.0% |

| 97 | 1020 | 60 | 144 | 0 | 0.3% | 0.0% |

| 98 | 1020 | 75 | 129 | 0 | 0.4% | 0.0% |

| 99 | 1020 | 99 | 105 | 0 | 0.5% | 0.0% |

W jaki sposób próg podobieństwa wpływa na odsetek fałszywych niedopasowań?

Załóżmy, że mamy 1,000 autentycznych prób wprowadzenia użytkowników i odrzucamy 10 z tych prób na podstawie wymaganego minimalnego podobieństwa wynoszącego 95%, aby można je było uznać za dopasowanie. W tym przypadku odrzucamy 10 autentycznych prób wejścia na pokład (fałszywych wyników negatywnych), ponieważ ich podobieństwo spada poniżej określonego minimalnego wymaganego progu podobieństwa. W tym przypadku nasz FNMR wynosi 1.0%.

| Aktualne | |||

| Przewidywana | |||

| . | Mecz | Nie pasuje | |

| >= 95% podobieństwa | 990 | 0 | |

| <95% podobieństwa | 10 | 0 | |

| . | całkowity | 1,000 | . |

FNMR = liczba fałszywie ujemnych / (liczba prawdziwie dodatnia + liczba fałszywie ujemnych)

FNMR = 10 / (990 + 10) lub 1.0%

Z drugiej strony załóżmy, że zamiast 1,000 prawdziwych użytkowników na pokładzie mamy 990 prawdziwych użytkowników i 10 fałszywych użytkowników (fałszywie dodatnich). Załóżmy, że przy minimalnym 95% podobieństwie zaakceptujemy wszystkich 1,000 użytkowników jako autentycznych. Tutaj mielibyśmy 1% FMR.

| Aktualne | ||||

| Przewidywana | ||||

| . | Mecz | Nie pasuje | całkowity | |

| >= 95% podobieństwa | 990 | 10 | 1,000 | |

| <95% podobieństwa | 0 | 0 | . | |

FMR = liczba fałszywie dodatnich wyników / (całkowita liczba prób)

FMR = 10 / (1,000 1.0) lub XNUMX%

Szacowanie kosztów FMR i FNMR podczas onboardingu

W przypadku użycia onboardingu koszt fałszywego niezgodności (odrzucenia) jest generalnie związany z dodatkowymi problemami użytkownika lub utratą rejestracji. Na przykład w naszym przypadku użycia w bankowości załóżmy, że Julia przedstawia dwa swoje zdjęcia, ale zostaje błędnie odrzucona w momencie rejestracji, ponieważ podobieństwo między tymi dwoma obrazami spada poniżej wybranego podobieństwa (fałszywy brak dopasowania). Instytucja finansowa może zaryzykować utratę Julie jako potencjalnego klienta lub może spowodować dodatkowe tarcia Julie, wymagając od niej wykonania czynności w celu udowodnienia jej tożsamości.

I odwrotnie, załóżmy, że dwa obrazy Julie przedstawiają różne osoby, a wprowadzenie Julie powinno zostać odrzucone. W przypadku, gdy Julie zostanie błędnie zaakceptowana (fałszywe dopasowanie), koszt i ryzyko dla instytucji finansowej są zupełnie inne. Mogą istnieć kwestie regulacyjne, ryzyko oszustwa i inne ryzyka związane z transakcjami finansowymi.

Odpowiedzialne użytkowanie

Sztuczna inteligencja (AI) zastosowana poprzez uczenie maszynowe (ML) będzie jedną z najbardziej transformacyjnych technologii naszego pokolenia, rozwiązując niektóre z najtrudniejszych problemów ludzkości, zwiększając ludzką wydajność i maksymalizując produktywność. Odpowiedzialne korzystanie z tych technologii jest kluczem do wspierania ciągłych innowacji. AWS jest zaangażowana w opracowywanie uczciwych i dokładnych usług AI i ML oraz dostarczanie narzędzi i wskazówek potrzebnych do odpowiedzialnego tworzenia aplikacji AI i ML.

W miarę wdrażania i zwiększania wykorzystania AI i ML, AWS oferuje kilka zasobów opartych na naszym doświadczeniu, aby pomóc Ci w odpowiedzialnym rozwoju i korzystaniu z AI i ML:

Najlepsze praktyki i typowe błędy, których należy unikać

W tej sekcji omówimy następujące najlepsze praktyki:

- Użyj wystarczająco dużej próbki obrazów

- Unikaj otwartych i syntetycznych zestawów danych twarzy

- Unikaj ręcznej i syntetycznej manipulacji obrazem

- Sprawdź jakość obrazu w czasie oceny i w czasie

- Monitoruj FMR i FNMR w czasie

- Użyj człowieka w przeglądzie pętli

- Bądź na bieżąco z Amazon Rekognition

Użyj wystarczająco dużej próbki obrazów

Użyj wystarczająco dużej, ale rozsądnej próbki obrazów. Jaka jest rozsądna wielkość próbki? To zależy od problemu biznesowego. Jeśli jesteś pracodawcą i masz 10,000 10,000 pracowników, których chcesz uwierzytelnić, użycie wszystkich 5,000 20,000 obrazów jest prawdopodobnie rozsądne. Załóżmy jednak, że jesteś organizacją z milionami klientów, których chcesz wdrożyć. W takim przypadku pobranie reprezentatywnej próby klientów, takiej jak XNUMX XNUMX–XNUMX XNUMX, jest prawdopodobnie wystarczające. Oto kilka wskazówek dotyczących wielkości próbki:

- Wielkość próbki 100 – 1,000 par obrazów dowodzi wykonalności

- Wielkość próbki 1,000 – 10,000 XNUMX par obrazów jest przydatnych do pomiaru zmienności między obrazami

- Wielkość próbki 10,000 – 1 milion par obrazów stanowi miarę jakości operacyjnej i możliwości uogólnienia

Kluczem do próbkowania par obrazów jest upewnienie się, że próbka zapewnia wystarczającą zmienność w populacji twarzy w aplikacji. Możesz dodatkowo rozszerzyć pobieranie próbek i testy, aby uwzględnić informacje demograficzne, takie jak odcień skóry, płeć i wiek.

Unikaj otwartych i syntetycznych zestawów danych twarzy

Istnieją dziesiątki wyselekcjonowanych zestawów danych obrazu twarzy typu open source, a także zdumiewająco realistyczne syntetyczne zestawy twarzy, które są często wykorzystywane w badaniach i studiach wykonalności. Wyzwanie polega na tym, że te zestawy danych generalnie nie są przydatne w przypadku 99% rzeczywistych przypadków użycia po prostu dlatego, że nie są reprezentatywne dla kamer, twarzy i jakości obrazów, które aplikacja może napotkać w środowisku naturalnym. Chociaż są one przydatne do tworzenia aplikacji, miary dokładności tych zestawów obrazów nie uogólniają tego, co napotkasz we własnej aplikacji. Zamiast tego zalecamy rozpoczęcie od reprezentatywnej próbki rzeczywistych obrazów z Twojego rozwiązania, nawet jeśli przykładowe pary obrazów są małe (poniżej 1,000).

Unikaj ręcznej i syntetycznej manipulacji obrazem

Często zdarzają się skrajne przypadki, które ludzie są zainteresowani zrozumieniem. Kwestie takie jak jakość przechwytywania obrazu lub zaciemnianie określonych rysów twarzy są zawsze interesujące. Na przykład często jesteśmy pytani o wpływ wieku i jakości obrazu na rozpoznawanie twarzy. Można po prostu syntetycznie postarzać twarz lub manipulować obrazem, aby obiekt wyglądał na starszy, lub manipulować jakością obrazu, ale nie przekłada się to dobrze na rzeczywiste starzenie się obrazów. Zamiast tego zalecamy zebranie reprezentatywnej próbki rzeczywistych przypadków brzegowych, które chcesz przetestować.

Sprawdź jakość obrazu w czasie oceny i w czasie

Technologia aparatów i aplikacji zmienia się dość szybko w miarę upływu czasu. Jako najlepszą praktykę zalecamy monitorowanie jakości obrazu w czasie. Od wielkości uchwyconych twarzy (za pomocą obwiedni), przez jasność i ostrość obrazu, po pozę twarzy, a także potencjalne zaciemnienia (kapelusze, okulary przeciwsłoneczne, brody itd.), wszystkie te obrazy i rysy twarzy zmieniają się z czasem.

Monitoruj FNMR i FMR w czasie

Następują zmiany, niezależnie od tego, czy chodzi o obrazy, aplikację, czy progi podobieństwa stosowane w aplikacji. Ważne jest, aby okresowo monitorować wskaźniki fałszywych dopasowań i niedopasowań w czasie. Zmiany stawek (nawet subtelne) mogą często wskazywać na wyzwania związane z aplikacją lub sposobem jej używania. Zmiany progów podobieństwa i reguł biznesowych używanych do podejmowania decyzji o akceptacji lub odrzuceniu mogą mieć duży wpływ na doświadczenia użytkowników związane z wdrażaniem i uwierzytelnianiem.

Użyj człowieka w przeglądzie pętli

Systemy weryfikacji tożsamości podejmują zautomatyzowane decyzje o dopasowaniu i braku dopasowania na podstawie progów podobieństwa i reguł biznesowych. Oprócz wymogów regulacyjnych i wewnętrznych, ważnym procesem w każdym zautomatyzowanym systemie decyzyjnym jest wykorzystanie weryfikatorów przez ludzi w ramach ciągłego monitorowania procesu decyzyjnego. Nadzór ludzki nad tymi zautomatyzowanymi systemami decyzyjnymi zapewnia walidację i ciągłe doskonalenie, a także przejrzystość zautomatyzowanego procesu decyzyjnego.

Bądź na bieżąco z Amazon Rekognition

Model twarzy Amazon Recognition jest okresowo aktualizowany (zwykle co roku) i obecnie jest w wersji 6. Ta zaktualizowana wersja zawiera ważne ulepszenia dokładności i indeksowania. Ważne jest, aby być na bieżąco z nowymi wersjami modeli i wiedzieć, jak używać tych nowych wersji we wniosku o weryfikację tożsamości. Po uruchomieniu nowych wersji modelu twarzy Amazon Rekognition dobrą praktyką jest ponowne przeprowadzenie procesu oceny tożsamości i określenie wszelkich potencjalnych wpływów (pozytywnych i negatywnych) na wskaźniki fałszywych dopasowań i niedopasowań.

Wnioski

W tym poście omówiono kluczowe elementy potrzebne do oceny wydajności rozwiązania do weryfikacji tożsamości pod kątem różnych metryk dokładności. Jednak dokładność to tylko jeden z wielu wymiarów, które należy ocenić przy wyborze konkretnej usługi moderacji treści. Bardzo ważne jest uwzględnienie innych parametrów, takich jak całkowity zestaw funkcji usługi, łatwość użycia, istniejące integracje, prywatność i bezpieczeństwo, opcje dostosowywania, wpływ na skalowalność, obsługa klienta i ceny.

Aby dowiedzieć się więcej o weryfikacji tożsamości w Amazon Rekognition, odwiedź stronę Weryfikacja tożsamości za pomocą Amazon Rekognition.

O autorach

Mike'a Amesa jest analitykiem danych, który został specjalistą ds. rozwiązań do weryfikacji tożsamości, z dużym doświadczeniem w opracowywaniu rozwiązań do uczenia maszynowego i sztucznej inteligencji w celu ochrony organizacji przed oszustwami, marnotrawstwem i nadużyciami. W wolnym czasie można go spotkać podczas wędrówek, jazdy na rowerze górskim lub zabawy we freebee ze swoim psem Maxem.

Mike'a Amesa jest analitykiem danych, który został specjalistą ds. rozwiązań do weryfikacji tożsamości, z dużym doświadczeniem w opracowywaniu rozwiązań do uczenia maszynowego i sztucznej inteligencji w celu ochrony organizacji przed oszustwami, marnotrawstwem i nadużyciami. W wolnym czasie można go spotkać podczas wędrówek, jazdy na rowerze górskim lub zabawy we freebee ze swoim psem Maxem.

Amit Gupta jest starszym architektem rozwiązań usług AI w AWS. Jego pasją jest udostępnianie klientom dobrze zaprojektowanych rozwiązań uczenia maszynowego na dużą skalę.

Amit Gupta jest starszym architektem rozwiązań usług AI w AWS. Jego pasją jest udostępnianie klientom dobrze zaprojektowanych rozwiązań uczenia maszynowego na dużą skalę.

Zuhayra Raghiba jest architektem rozwiązań AI Services w AWS. Specjalizuje się w stosowanej sztucznej inteligencji/uczeniu maszynowym i jest pasjonatem umożliwiania klientom korzystania z chmury w celu szybszego wprowadzania innowacji i przekształcania ich firm.

Zuhayra Raghiba jest architektem rozwiązań AI Services w AWS. Specjalizuje się w stosowanej sztucznej inteligencji/uczeniu maszynowym i jest pasjonatem umożliwiania klientom korzystania z chmury w celu szybszego wprowadzania innowacji i przekształcania ich firm.

Marcela Pividala jest starszym architektem rozwiązań usług AI w World-Wide Specialist Organization. Marcel ma ponad 20-letnie doświadczenie w rozwiązywaniu problemów biznesowych za pomocą technologii dla fintechów, dostawców usług płatniczych, farmaceutycznych i agencji rządowych. Jego obecne obszary zainteresowania to zarządzanie ryzykiem, zapobieganie oszustwom i weryfikacja tożsamości.

Marcela Pividala jest starszym architektem rozwiązań usług AI w World-Wide Specialist Organization. Marcel ma ponad 20-letnie doświadczenie w rozwiązywaniu problemów biznesowych za pomocą technologii dla fintechów, dostawców usług płatniczych, farmaceutycznych i agencji rządowych. Jego obecne obszary zainteresowania to zarządzanie ryzykiem, zapobieganie oszustwom i weryfikacja tożsamości.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Amazon Rekognition

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- Najlepsze praktyki

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- zefirnet