Organizacje z różnych branż korzystają z automatycznego podsumowania tekstu, aby wydajniej przetwarzać ogromne ilości informacji i podejmować lepsze decyzje. W sektorze finansowym banki inwestycyjne skupiają raporty o wynikach do kluczowych wniosków, aby szybko analizować wyniki kwartalne. Firmy medialne korzystają z podsumowań do monitorowania wiadomości i mediów społecznościowych, dzięki czemu dziennikarze mogą szybko pisać artykuły na temat pojawiających się problemów. Agencje rządowe podsumowują długie dokumenty polityczne i raporty, aby pomóc decydentom w ustalaniu strategii i ustalaniu priorytetów celów.

Tworząc skrócone wersje długich i złożonych dokumentów, technologia podsumowań umożliwia użytkownikom skupienie się na najistotniejszych treściach. Prowadzi to do lepszego zrozumienia i zatrzymania kluczowych informacji. Oszczędność czasu pozwala zainteresowanym stronom zapoznać się z większą ilością materiału w krótszym czasie, zyskując szerszą perspektywę. Dzięki lepszemu zrozumieniu i bardziej zsyntetyzowanym spostrzeżeniom organizacje mogą podejmować bardziej świadome decyzje strategiczne, przyspieszać badania, poprawiać produktywność i zwiększać swój wpływ. Transformacyjna siła zaawansowanych funkcji podsumowań będzie nadal rosła, w miarę jak coraz więcej branż będzie wdrażać sztuczną inteligencję (AI) w celu wykorzystania przepełnionych strumieni informacji.

W tym poście omawiamy wiodące podejścia do obiektywnej oceny dokładności podsumowań, w tym metryki ROUGE, METEOR i BERTScore. Zrozumienie mocnych i słabych stron tych technik może pomóc w wyborze i doskonaleniu działań. Ogólnym celem tego wpisu jest objaśnienie ewaluacji podsumowującej, aby pomóc zespołom w lepszym porównywaniu wyników w zakresie tej krytycznej zdolności, gdy starają się maksymalizować wartość.

Rodzaje podsumowań

Podsumowanie można ogólnie podzielić na dwa główne typy: podsumowanie ekstrakcyjne i podsumowanie abstrakcyjne. Obydwa podejścia mają na celu skondensowanie długich fragmentów tekstu w krótsze formy, aby uchwycić najważniejsze informacje lub istotę oryginalnej treści, ale robią to zasadniczo na różne sposoby.

Podsumowanie ekstrakcyjne polega na identyfikacji i wyodrębnieniu kluczowych fraz, zdań lub segmentów z oryginalnego tekstu bez ich zmiany. System wybiera fragmenty tekstu, które uzna za najbardziej informacyjne lub reprezentatywne dla całości. Podsumowanie ekstraktywne jest przydatne, jeśli dokładność ma kluczowe znaczenie, a podsumowanie musi odzwierciedlać dokładne informacje z tekstu oryginalnego. Mogą to być przypadki użycia, takie jak podkreślenie konkretnych warunków prawnych, obowiązków i praw określonych w warunkach użytkowania. Najpopularniejszymi technikami stosowanymi do wyodrębniania podsumowań są częstotliwość odwrotności częstotliwości terminów (TF-IDF), punktacja zdań, algorytm rankingu tekstu i nadzorowane uczenie maszynowe (ML).

Abstrakcyjne podsumowanie idzie o krok dalej, generując nowe frazy i zdania, których nie było w tekście oryginalnym, zasadniczo parafrazując i kondensując oryginalną treść. Takie podejście wymaga głębszego zrozumienia tekstu, ponieważ sztuczna inteligencja musi zinterpretować znaczenie, a następnie wyrazić je w nowej, zwięzłej formie. Do abstrakcyjnych podsumowań najlepiej nadają się modele wielkojęzykowe (LLM), ponieważ modele transformatorowe wykorzystują mechanizmy uwagi, aby podczas generowania podsumowań skupiać się na odpowiednich częściach tekstu wejściowego. Mechanizm uwagi pozwala modelowi przypisać różne wagi różnym słowom lub tokenom w sekwencji wejściowej, umożliwiając mu przechwytywanie zależności dalekiego zasięgu i informacji istotnych kontekstowo.

Oprócz tych dwóch podstawowych typów istnieją podejścia hybrydowe, które łączą metody ekstrakcyjne i abstrakcyjne. Podejścia te mogą rozpoczynać się od wyodrębnionego podsumowania w celu zidentyfikowania najważniejszej treści, a następnie zastosować techniki abstrakcyjne do przepisania lub skondensowania tej treści w płynne podsumowanie.

Wyzwanie

Znalezienie optymalnej metody oceny jakości podsumowań pozostaje otwartym wyzwaniem. Ponieważ organizacje w coraz większym stopniu polegają na automatycznym podsumowywaniu tekstu w celu wyodrębnienia kluczowych informacji z dokumentów, rośnie zapotrzebowanie na standardowe techniki pomiaru dokładności podsumowań. W idealnym przypadku te wskaźniki oceny określałyby ilościowo, jak dobrze generowane maszynowo streszczenia wydobywają najistotniejsze treści z tekstów źródłowych i przedstawiają spójne streszczenia odzwierciedlające oryginalne znaczenie i kontekst.

Jednakże opracowanie solidnych metod oceny podsumowań tekstu stwarza trudności:

- Streszczenia referencyjne autorstwa człowieka używane do porównań często wykazują dużą zmienność w oparciu o subiektywne ustalenia ważności

- Zniuansowane aspekty jakości podsumowania, takie jak płynność, czytelność i spójność, okazują się trudne do programowego określenia ilościowego

- Istnieje duża różnorodność metod podsumowywania, od algorytmów statystycznych po sieci neuronowe, co komplikuje bezpośrednie porównania

Badanie zorientowane na wycofanie z rynku w zakresie oceny istotności (ROUGE)

Wskaźniki ROUGE, takie jak ROUGE-N i ROUGE-L, odgrywają kluczową rolę w ocenie jakości streszczeń generowanych maszynowo w porównaniu ze streszczeniami referencyjnymi pisanymi przez człowieka. Metryki te skupiają się na ocenie nakładania się treści podsumowań generowanych maszynowo i podsumowań stworzonych przez człowieka poprzez analizę n-gramów, które są grupami słów lub tokenów. Na przykład ROUGE-1 ocenia dopasowanie pojedynczych słów (unigramów), podczas gdy ROUGE-2 uwzględnia pary słów (bigramy). Dodatkowo ROUGE-N ocenia najdłuższy wspólny podciąg słów pomiędzy dwoma tekstami, umożliwiając elastyczność w kolejności słów.

Aby to zilustrować, rozważ następujące przykłady:

- Wskaźnik ROGUE-1 – ROUGE-1 ocenia nakładanie się unigramów (pojedynczych słów) pomiędzy wygenerowanym podsumowaniem a podsumowaniem referencyjnym. Na przykład, jeśli podsumowanie referencyjne zawiera „Szybkie brązowe lisy skaczą”, a wygenerowane podsumowanie to „Brązowy lis szybko skacze”, metryka ROUGE-1 uznałaby „brązowy”, „lis” i „skoki” za nakładające się unigramy. ROUGE-1 koncentruje się na obecności poszczególnych słów w podsumowaniach, mierząc, jak dobrze wygenerowane podsumowanie oddaje słowa kluczowe z podsumowania referencyjnego.

- Wskaźnik ROGUE-2 – ROUGE-2 ocenia nakładanie się bigramów (par sąsiadujących ze sobą słów) pomiędzy wygenerowanym podsumowaniem a podsumowaniem referencyjnym. Na przykład, jeśli podsumowanie referencyjne zawiera „Kot śpi”, a wygenerowane podsumowanie brzmi „Kot śpi”, ROUGE-2 zidentyfikuje „kot” i „śpi” jako nakładający się bigram. ROUGE-2 zapewnia wgląd w to, jak dobrze wygenerowane podsumowanie zachowuje kolejność i kontekst par słów w porównaniu z podsumowaniem referencyjnym.

- Metryczny ROUGE-N – ROUGE-N to uogólniona forma, w której N oznacza dowolną liczbę, umożliwiającą ocenę na podstawie n-gramów (sekwencji N słów). Biorąc pod uwagę N=3, jeśli podsumowanie odniesienia stwierdza „Słońce świeci jasno”, a wygenerowane podsumowanie brzmi „Słońce świeci jasno”, ROUGE-3 rozpoznałby „słońce świeci jasno” jako pasujący trygram. ROUGE-N oferuje elastyczność oceny podsumowań w oparciu o sekwencje słów o różnej długości, zapewniając bardziej wszechstronną ocenę nakładania się treści.

Te przykłady ilustrują, jak metryki ROUGE-1, ROUGE-2 i ROUGE-N funkcjonują w ocenie zadań automatycznego podsumowania lub tłumaczenia maszynowego poprzez porównanie wygenerowanych podsumowań z podsumowaniami referencyjnymi opartymi na różnych poziomach sekwencji słów.

Oblicz wynik ROUGE-N

Aby obliczyć wynik ROUGE-N, możesz wykonać następujące kroki:

- Tokenizuj wygenerowane podsumowanie i podsumowanie referencji na pojedyncze słowa lub tokeny, korzystając z podstawowych metod tokenizacji, takich jak dzielenie za pomocą białych znaków lub bibliotek przetwarzania języka naturalnego (NLP).

- Generuj n-gramy (ciągłe sekwencje N słów) zarówno na podstawie wygenerowanego podsumowania, jak i podsumowania referencyjnego.

- Policz liczbę nakładających się n-gramów pomiędzy wygenerowanym podsumowaniem a podsumowaniem referencyjnym.

- Oblicz precyzję, przywołanie i wynik F1:

- Detaliczność – Liczba nakładających się n-gramów podzielona przez całkowitą liczbę n-gramów w wygenerowanym podsumowaniu.

- Odwołanie – Liczba nakładających się n-gramów podzielona przez całkowitą liczbę n-gramów w podsumowaniu referencyjnym.

- Wynik F1 – Średnia harmoniczna precyzji i przypominania, obliczana jako (2 * precyzja * przypominanie) / (precyzja + przypominanie).

- Zagregowany wynik F1 uzyskany z obliczenia precyzji, przypominania i wyniku F1 dla każdego wiersza w zestawie danych jest uważany za wynik ROUGE-N.

Ograniczenia

ROGUE ma następujące ograniczenia:

- Wąski nacisk na nakładanie się leksykalne – Podstawową ideą ROUGE jest porównanie podsumowania wygenerowanego przez system z zestawem referencyjnym lub podsumowaniami stworzonymi przez człowieka i zmierzenie nakładania się leksykalnego pomiędzy nimi. Oznacza to, że ROUGE bardzo wąsko skupia się na podobieństwie na poziomie słów. W rzeczywistości nie ocenia znaczenia semantycznego, spójności ani czytelności streszczenia. System mógłby osiągnąć wysokie wyniki ROUGE po prostu wyodrębniając zdania słowo w słowo z oryginalnego tekstu, bez generowania spójnego i zwięzłego podsumowania.

- Niewrażliwość na parafrazę – Ponieważ ROUGE opiera się na dopasowaniu leksykalnym, nie może wykryć równoważności semantycznej między słowami i wyrażeniami. Dlatego parafrazowanie i używanie synonimów często prowadzi do niższych wyników ROUGE, nawet jeśli znaczenie zostaje zachowane. Jest to niekorzystne dla systemów, które parafrazują lub podsumowują w abstrakcyjny sposób.

- Brak zrozumienia semantycznego – ROUGE nie ocenia, czy system rzeczywiście zrozumiał znaczenia i koncepcje zawarte w oryginalnym tekście. Podsumowanie może w dużym stopniu pokrywać się leksykalnie z odniesieniami, pomijając główne idee lub zawierające niespójności faktyczne. ROUGE nie zidentyfikowałaby tych problemów.

Kiedy stosować ROUGE

ROUGE jest prosty i szybki w obliczeniach. Użyj go jako punktu odniesienia lub punktu odniesienia dla jakości podsumowania związanej z wyborem treści. Metryki ROUGE są najskuteczniej stosowane w scenariuszach obejmujących zadania podsumowujące abstrakcyjne, automatyczną ocenę podsumowującą, oceny LLM i analizy porównawcze różnych podejść do podsumowań. Wykorzystując w tych kontekstach metryki ROUGE, zainteresowane strony mogą ilościowo ocenić jakość i skuteczność procesów generowania podsumowań.

Miernik oceny tłumaczenia z jawnym porządkowaniem (METEOR)

Jednym z głównych wyzwań związanych z oceną systemów podsumowań jest ocena, jak dobrze wygenerowane podsumowanie jest logiczne, a nie tylko wybieranie odpowiednich słów i wyrażeń z tekstu źródłowego. Samo wyodrębnienie odpowiednich słów kluczowych i zdań niekoniecznie daje spójne i spójne podsumowanie. Podsumowanie powinno płynnie przebiegać i logicznie łączyć pomysły, nawet jeśli nie są one przedstawione w tej samej kolejności, co dokument oryginalny.

Elastyczność dopasowywania poprzez redukcję słów do ich rdzenia lub formy podstawowej (na przykład po rdzeniowaniu słowa takie jak „bieganie”, „biega” i „biegał” stają się „bieganiem”), a synonimy oznaczają METEOR lepiej koreluje z ludzką oceną jakości podsumowania. Potrafi określić, czy ważna treść została zachowana, nawet jeśli jej sformułowanie jest inne. Jest to kluczowa przewaga nad wskaźnikami opartymi na n-gramach, takimi jak ROUGE, które szukają tylko dokładnych dopasowań tokenów. METEOR przyznaje także wyższe oceny podsumowaniom skupiającym się na najistotniejszych treściach z źródła. Niższe oceny otrzymują powtarzające się lub nieistotne informacje. Jest to zgodne z celem podsumowania, jakim jest zachowanie tylko najważniejszych treści. METEOR to semantycznie znacząca metryka, która może pokonać niektóre ograniczenia dopasowywania n-gramowego do oceny podsumowania tekstu. Włączenie rdzeni i synonimów pozwala na lepszą ocenę nakładania się informacji i dokładności treści.

Aby to zilustrować, rozważ następujące przykłady:

Podsumowanie referencji: Liście opadają jesienią.

Wygenerowane podsumowanie 1: Liście opadają jesienią.

Wygenerowane podsumowanie 2: Liście latem zielone.

Słowa pasujące do odniesienia i wygenerowanego podsumowania 1 są podświetlone:

Podsumowanie referencji: Liście spadać jesienią.

Wygenerowane podsumowanie 1: Liście wpadać spadać.

Chociaż „jesień” i „jesień” to różne symbole, METEOR rozpoznaje je jako synonimy poprzez dopasowanie synonimów. „Upadek” i „upadek” są identyfikowane jako dopasowanie z łodygą. Dla wygenerowanego podsumowania 2 nie ma żadnych dopasowań do podsumowania referencyjnego poza „Liściemi”, więc to podsumowanie otrzyma znacznie niższą ocenę w METEOR. Im bardziej znaczące semantycznie dopasowania, tym wyższy wynik METEOR. Dzięki temu METEOR może lepiej ocenić zawartość i dokładność podsumowań w porównaniu do prostego dopasowywania n-gramowego.

Oblicz wynik METEOR

Wykonaj następujące kroki, aby obliczyć wynik METEOR:

- Tokenizuj wygenerowane podsumowanie i podsumowanie referencji na pojedyncze słowa lub tokeny, korzystając z podstawowych metod tokenizacji, takich jak dzielenie według białych znaków lub bibliotek NLP.

- Oblicz precyzję unigramu, zapamiętywanie i średni wynik F, dając więcej wagi do przypomnienia niż precyzji.

- Zastosuj karę za dokładne dopasowania, aby uniknąć ich nadmiernego podkreślania. Kara jest wybierana na podstawie charakterystyki zbioru danych, wymagań zadania i równowagi między precyzją a przypominaniem. Odejmij tę karę od średniego wyniku F obliczonego w kroku 2.

- Oblicz średni wynik F dla form rdzeniowych (redukując słowa do ich formy podstawowej lub rdzenia) i synonimów dla unigramów, jeśli ma to zastosowanie. Połącz to z wcześniej obliczonym średnim wynikiem F, aby otrzymać ostateczny wynik METEOR. Wynik METEOR waha się od 0–1, gdzie 0 oznacza brak podobieństwa między wygenerowanym podsumowaniem a podsumowaniem referencyjnym, a 1 oznacza idealne dopasowanie. Zazwyczaj wyniki podsumowania mieszczą się w przedziale 0–0.6.

Ograniczenia

Podczas stosowania metryki METEOR do oceny zadań podsumowujących może pojawić się kilka wyzwań:

- Złożoność semantyczna – Nacisk w projekcie METEOR na podobieństwo semantyczne może sprawiać trudności w uchwyceniu zniuansowanych znaczeń i kontekstu w złożonych zadaniach podsumowujących, co może prowadzić do niedokładności w ocenie.

- Zmienność odniesienia – Zmienność w podsumowaniach referencyjnych generowanych przez człowieka może mieć wpływ na wyniki METEOR, ponieważ różnice w treści referencyjnej mogą wpływać na ocenę podsumowań generowanych maszynowo.

- Różnorodność językowa – Skuteczność METEOR może różnić się w zależności od języka ze względu na różnice językowe, różnice w składni i niuanse semantyczne, co stwarza wyzwania w wielojęzycznych ocenach podsumowujących.

- Rozbieżność długości – Ocena podsumowań o różnej długości może stanowić wyzwanie dla METEOR, ponieważ rozbieżności w długości w porównaniu z podsumowaniem referencyjnym mogą skutkować karami lub niedokładnościami w ocenie.

- Strojenie parametrów – Optymalizacja parametrów METEORA pod kątem różnych zbiorów danych i zadań podsumowujących może być czasochłonna i wymagać starannego dostrojenia, aby mieć pewność, że metryka zapewnia dokładne oceny.

- Stronniczość oceny – Istnieje ryzyko stronniczości oceny METEOR-u, jeśli nie jest on odpowiednio dostosowany lub skalibrowany pod kątem konkretnych dziedzin lub zadań podsumowujących. Może to potencjalnie prowadzić do wypaczonych wyników i wpływać na wiarygodność procesu oceny.

Mając świadomość tych wyzwań i biorąc je pod uwagę podczas stosowania METEORu jako miernika zadań podsumowujących, badacze i praktycy mogą pokonać potencjalne ograniczenia i podejmować bardziej świadome decyzje w swoich procesach oceny.

Kiedy stosować METEOR

METEOR jest powszechnie używany do automatycznej oceny jakości streszczeń tekstowych. Zaleca się stosowanie METEORU jako miernika oceny, gdy w podsumowaniu liczy się kolejność pomysłów, koncepcji lub bytów. METEOR uwzględnia kolejność i dopasowuje n-gramy pomiędzy wygenerowanym podsumowaniem a podsumowaniami referencyjnymi. Nagradza podsumowania, które zachowują informacje sekwencyjne. W przeciwieństwie do wskaźników takich jak ROUGE, które opierają się na pokrywaniu się n-gramów z podsumowaniami referencyjnymi, METEOR dopasowuje tematy, synonimy i parafrazy. METEOR działa lepiej, gdy istnieje wiele poprawnych sposobów podsumowania oryginalnego tekstu. METEOR zawiera synonimy WordNet i tokeny macierzyste podczas dopasowywania n-gramów. Krótko mówiąc, streszczenia, które są semantycznie podobne, ale zawierają inne słowa lub sformułowania, nadal będą dobrze oceniane. METEOR ma wbudowaną karę za podsumowania zawierające powtarzające się n-gramy. Dlatego zniechęca do ekstrakcji słowo po słowie lub braku abstrakcji. METEOR jest dobrym wyborem, gdy podobieństwo semantyczne, kolejność pomysłów i płynne sformułowanie są ważne dla oceny jakości podsumowania. Jest mniej odpowiedni do zadań, w których liczy się jedynie nakładanie się leksykalne na streszczenia referencyjne.

BERTScore

Powierzchowne środki leksykalne, takie jak ROUGE i METEOR, oceniają systemy podsumowań, porównując nakładanie się słów w podsumowaniu kandydata i streszczeniu referencyjnym. Jednakże w dużym stopniu opierają się na dokładnym dopasowaniu ciągów między słowami i frazami. Oznacza to, że mogą przeoczyć podobieństwa semantyczne między słowami i wyrażeniami, które mają różne formy powierzchniowe, ale podobne ukryte znaczenia. Opierając się wyłącznie na dopasowaniu powierzchniowym, metryki te mogą niedoceniać jakość podsumowań systemowych, w których używane są słowa synonimiczne lub pojęcia parafrazy inaczej niż podsumowania referencyjne. Dwa streszczenia mogą przekazać niemal identyczne informacje, ale powierzchownie uzyskać niską ocenę ze względu na różnice w słownictwie.

BERTScore to sposób na automatyczną ocenę jakości podsumowania poprzez porównanie go z podsumowaniem referencyjnym napisanym przez człowieka. Wykorzystuje BERT, popularną technikę NLP, aby zrozumieć znaczenie i kontekst słów w streszczeniu kandydata i podsumowaniu referencji. W szczególności sprawdza każde słowo lub token w podsumowaniu kandydata i znajduje najbardziej podobne słowo w podsumowaniu referencyjnym w oparciu o osadzanie BERT, które są wektorową reprezentacją znaczenia i kontekstu każdego słowa. Mierzy podobieństwo za pomocą podobieństwa cosinus, który mówi, jak blisko siebie znajdują się wektory. Dla każdego słowa w podsumowaniu kandydata znajduje najbardziej powiązane słowo w podsumowaniu referencyjnym, korzystając ze zrozumienia języka BERT. Porównuje wszystkie te podobieństwa słów w całym podsumowaniu, aby uzyskać ogólny wynik pod względem semantycznego podobieństwa podsumowania kandydata do podsumowania referencyjnego. Im bardziej podobne słowa i znaczenia uchwycone przez BERT, tym wyższy wynik BERTScore. Pozwala to na automatyczną ocenę jakości wygenerowanego podsumowania poprzez porównanie go z danymi referencyjnymi wykonanymi przez człowieka, bez konieczności każdorazowej oceny przez człowieka.

Aby to zilustrować, wyobraź sobie, że masz wygenerowane maszynowo podsumowanie: „Szybki brązowy lis przeskakuje leniwego psa”. Rozważmy teraz streszczenie stworzone przez człowieka: „Szybki brązowy lis przeskakuje śpiącego psa”.

Oblicz wynik BERTScore

Wykonaj następujące kroki, aby obliczyć wynik BERTScore:

- BERTScore wykorzystuje osadzanie kontekstowe do reprezentowania każdego tokenu zarówno w zdaniach kandydujących (wygenerowanych maszynowo), jak i referencyjnych (stworzonych przez człowieka). Osadzanie kontekstowe to rodzaj reprezentacji słowa w NLP, który oddaje znaczenie słowa na podstawie jego kontekstu w zdaniu lub tekście. W przeciwieństwie do tradycyjnego osadzania słów, które przypisuje stały wektor każdemu słowu niezależnie od jego kontekstu, osadzanie kontekstowe uwzględnia otaczające słowa, aby wygenerować unikalną reprezentację każdego słowa w zależności od sposobu jego użycia w konkretnym zdaniu.

- Metryka następnie oblicza podobieństwo między każdym tokenem w zdaniu kandydującym do każdego tokenu w zdaniu referencyjnym, używając podobieństwa cosinus. Podobieństwo cosinusowe pomaga nam określić ilościowo, jak blisko powiązane są dwa zestawy danych, koncentrując się na kierunku, jaki wskazują w przestrzeni wielowymiarowej, co czyni go cennym narzędziem do zadań takich jak algorytmy wyszukiwania, NLP i systemy rekomendacji.

- Porównując osadzenie kontekstowe i obliczając wyniki podobieństwa dla wszystkich tokenów, BERTScore generuje wszechstronną ocenę, która oddaje znaczenie semantyczne i kontekst wygenerowanego podsumowania w porównaniu z odniesieniem stworzonym przez człowieka.

- Ostateczny wynik BERTScore zapewnia ocenę podobieństwa, która odzwierciedla, jak dobrze podsumowanie wygenerowane maszynowo jest zgodne z podsumowaniem referencyjnym pod względem znaczenia i kontekstu.

Zasadniczo BERTScore wykracza poza tradycyjne wskaźniki, biorąc pod uwagę niuanse semantyczne i kontekst zdań, oferując bardziej wyrafinowaną ocenę, która ściśle odzwierciedla ludzki osąd. To zaawansowane podejście zwiększa dokładność i niezawodność oceny zadań podsumowujących, czyniąc BERTScore cennym narzędziem w ocenie systemów generowania tekstu.

Ograniczenia:

Chociaż BERTScore oferuje znaczne korzyści w ocenie zadań podsumowujących, ma również pewne ograniczenia, które należy wziąć pod uwagę:

- Intensywność obliczeniowa – BERTScore może wymagać intensywnych obliczeń ze względu na opieranie się na wstępnie wyszkolonych modelach językowych, takich jak BERT. Może to prowadzić do dłuższych czasów oceny, szczególnie w przypadku przetwarzania dużych ilości danych tekstowych.

- Zależność od wstępnie wyszkolonych modeli – Skuteczność BERTScore w dużym stopniu zależy od jakości i przydatności zastosowanego wcześniej wyszkolonego modelu językowego. W scenariuszach, w których wstępnie wyszkolony model może nie uchwycić odpowiednio niuansów tekstu, może to mieć wpływ na wyniki oceny.

- Skalowalność – Skalowanie BERTScore pod kątem dużych zbiorów danych lub aplikacji czasu rzeczywistego może stanowić wyzwanie ze względu na wymagania obliczeniowe. Wdrożenie BERTScore w środowiskach produkcyjnych może wymagać strategii optymalizacji w celu zapewnienia wydajnej wydajności.

- Specyfika domeny – Wydajność BERTScore może się różnić w różnych domenach lub wyspecjalizowanych typach tekstu. Dostosowanie metryki do konkretnych dziedzin lub zadań może wymagać dostrojenia lub dostosowań w celu uzyskania dokładnych ocen.

- Interpretowalność – Chociaż BERTScore zapewnia wszechstronną ocenę opartą na osadzeniu kontekstowym, interpretacja konkretnych przyczyn wyników podobieństwa wygenerowanych dla każdego tokena może być złożona i może wymagać dodatkowej analizy.

- Ocena bez odniesień – Chociaż BERTScore ogranicza poleganie na podsumowaniach referencji przy ocenie, to podejście pozbawione odniesień może nie w pełni uchwycić wszystkie aspekty jakości podsumowań, szczególnie w scenariuszach, w których odniesienia stworzone przez człowieka są niezbędne do oceny trafności i spójności treści.

Uznanie tych ograniczeń może pomóc w podejmowaniu świadomych decyzji podczas korzystania z BERTScore jako miernika do oceny zadań podsumowujących, zapewniając zrównoważone zrozumienie jego mocnych i ograniczeń.

Kiedy stosować BERTScore

BERTScore może ocenić jakość podsumowania tekstu, porównując wygenerowane podsumowanie z podsumowaniem referencyjnym. Wykorzystuje sieci neuronowe, takie jak BERT, do pomiaru podobieństwa semantycznego wykraczającego poza samo dokładne dopasowanie słów lub fraz. To sprawia, że BERTScore jest bardzo przydatny, gdy wierność semantyczna zachowująca pełne znaczenie i treść ma kluczowe znaczenie dla zadania podsumowania. BERTScore przyzna wyższą ocenę podsumowaniom, które przekazują te same informacje, co podsumowanie referencyjne, nawet jeśli zawierają inne słowa i struktury zdaniowe. Najważniejsze jest to, że BERTScore idealnie nadaje się do zadań podsumowujących, w których istotne jest zachowanie pełnego znaczenia semantycznego, a nie tylko słów kluczowych lub tematów. Zaawansowana punktacja neuronowa pozwala na porównywanie znaczeń wykraczających poza dopasowywanie słów na poziomie powierzchni. Dzięki temu nadaje się do przypadków, w których subtelne różnice w sformułowaniach mogą znacząco zmienić ogólne znaczenie i implikacje. W szczególności BERTScore przoduje w wychwytywaniu podobieństwa semantycznego, co ma kluczowe znaczenie dla oceny jakości abstrakcyjnych podsumowań, takich jak te tworzone przez modele Retrieval Augmented Generation (RAG).

Ramy oceny modeli

Ramy oceny modeli są niezbędne do dokładnego pomiaru wydajności różnych modeli podsumowań. Ramy te odgrywają zasadniczą rolę w porównywaniu modeli, zapewnianiu spójności między wygenerowanymi podsumowaniami a treścią źródłową oraz wskazywaniu braków w metodach oceny. Przeprowadzając dokładne oceny i spójne analizy porównawcze, ramy te napędzają badania nad podsumowaniami tekstów, promując standardowe praktyki oceny i umożliwiając wieloaspektowe porównania modeli.

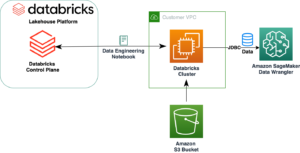

W AWS, Biblioteka FMEval w ciągu Amazon SageMaker Wyjaśnij usprawnia ocenę i wybór modeli podstawowych (FM) do zadań takich jak podsumowywanie tekstu, odpowiadanie na pytania i klasyfikacja. Umożliwia ocenę FM w oparciu o takie wskaźniki, jak dokładność, solidność, kreatywność, stronniczość i toksyczność, wspierając zarówno zautomatyzowane, jak i ludzkie oceny LLM. Dzięki ocenom opartym na interfejsie użytkownika lub programowym FMEval generuje szczegółowe raporty z wizualizacjami w celu ilościowego określenia ryzyka modelu, takiego jak niedokładności, toksyczność lub stronniczość, pomagając organizacjom dostosować się do odpowiedzialnych wytycznych dotyczących generatywnej sztucznej inteligencji. W tej sekcji pokażemy, jak korzystać z biblioteki FMEval.

Oceń Claude v2 pod kątem dokładności podsumowania przy użyciu Amazon Bedrock

Poniższy fragment kodu jest przykładem interakcji z modelem Anthropic Claude przy użyciu kodu Pythona:

Mówiąc najprościej, ten kod wykonuje następujące działania:

- Zaimportuj niezbędne biblioteki, w tym

json, do pracy z danymi JSON. - Zdefiniuj identyfikator modelu jako

anthropic.claude-v2i ustaw typ treści żądania. - Stwórz

prompt_datazmienna strukturyzująca dane wejściowe dla modelu Claude'a. W tym przypadku zadaje pytanie „Kim jest Barack Obama?” i oczekuje odpowiedzi od modela. - Utwórz obiekt JSON o nazwie body, który zawiera dane podpowiedzi i określ dodatkowe parametry, takie jak maksymalna liczba tokenów do wygenerowania.

- Wywołaj model Claude za pomocą

bedrock_runtime.invoke_modelz określonymi parametrami. - Przeanalizuj odpowiedź z modelu, wyodrębnij uzupełnienie (wygenerowany tekst) i wydrukuj.

Upewnij się, AWS Zarządzanie tożsamością i dostępem (IAM) rola związana z Studio Amazon SageMaker profil użytkownika ma dostęp do Amazońska skała macierzysta wywoływane modele. Odnosić się do Przykłady zasad opartych na tożsamości dla Amazon Bedrock aby uzyskać wskazówki dotyczące najlepszych praktyk i przykładów polityk opartych na tożsamości dla Amazon Bedrock.

Użycie biblioteki FMEval do oceny podsumowanych wyników Claude'a

Do oceny podsumowanych wyników używamy następującego kodu:

W powyższym fragmencie kodu, aby ocenić podsumowanie tekstu za pomocą biblioteki FMEval, wykonujemy następujące kroki:

- Stwórz

ModelRunneraby wykonać wywołanie na swoim LLM. Biblioteka FMEval zapewnia wbudowaną obsługę Amazon Sage Maker punkty końcowe i Amazon SageMaker JumpStart LLM. Możesz także przedłużyćModelRunnerinterfejs dla dowolnych LLM hostowanych w dowolnym miejscu. - Użyj obsługiwane

eval_algorithmstakie jak toksyczność, podsumowanie, dokładność, semantyka i solidność, w zależności od potrzeb w zakresie oceny. - Dostosuj parametry konfiguracyjne oceny do konkretnego przypadku użycia.

- Użyj algorytmu oceny z wbudowanymi lub niestandardowymi zestawami danych, aby ocenić swój model LLM. Zbiór danych użyty w tym przypadku pochodzi z poniższego źródła GitHub repo.

Patrz: przewodnik programisty i przykłady szczegółowego wykorzystania algorytmów ewaluacyjnych.

Poniższa tabela podsumowuje wyniki oceny.

| model_wejście | model_wyjście | wynik_docelowy | podpowiedź | wyniki | meteor_score | rouge_score | bert_score |

| John Edward 0 Bates, dawniej Spalding, Linco….. |

Nie mogę podać żadnego ostatecznego rozwiązania wyroki, jak… |

Były Funkcjonariusz policji w Lincolnshire zabrał… |

Człowiek: John Edward Bates, dawniej Spalding… |

[{'nazwa': 'meteor', 'wartość': 0.101010101010101 ... |

0.10101 | 0 | 0.557155 |

| Październik 23 2015 Ostatnia aktualizacja o 17:44 czasu polskiego|nit'… |

Oto kilka kluczowych punktów na temat huraganów/trop.. | Huragan Patricia został sklasyfikowany jako kategoria… | Człowiek: 23 Październik 2015 Ostatnia aktualizacja o 17:44 B ... |

[{'nazwa': meteor', "wartość": 0.102339181286549 .. |

0.102339 | 0.018265 | 0.441421 |

| Ferrari wydawało się być w stanie rzucić wyzwanie… | Oto kluczowe punkty artykułu:nin… | Lewis Hamilton szturmem zdobył pole position w… | Człowiek: Ferrari wydawało się być w stanie rzucić wyzwanie… | [{'nazwa': 'meteor', 'wartość': 0.322543352601156 ... |

0.322543 | 0.078212 | 0.606487 |

| Urodzony w Bath zawodnik (28 l.) zdobył 36 punktów pojawiać się… |

OK, podsumuję najważniejsze punkty:/nin- E….. | Newport Gwent Dragons numer osiem Eda Jacksona | Człowiek: Urodzony w Bath zawodnik (28 l.) zaliczył 36… | [{'nazwa': 'meteor', 'wartość': 0105740181268882 ... |

0.10574 | 0.012987 | 0.539488 |

| Słabości w sposobie, w jaki myszy wymieniały dane z c… | Oto kluczowe punkty, które zebrałem z… | Hakerzy mogą uzyskać dostęp do domu i | Człowiek: Słabe strony w myszy Swar wymieniły dane |

[{'nazwa': 'meteor', 'wartość': 0.201048289433848 ... |

0.201048 | 0.021858 | 0.526947 |

Sprawdź próbkę notatnik aby uzyskać więcej informacji na temat oceny podsumowującej, którą omawialiśmy w tym poście.

Wnioski

Wszystkie ROUGE, METEOR i BERTScore mierzą jakość podsumowań generowanych maszynowo, ale skupiają się na różnych aspektach, takich jak nakładanie się leksykalnych, płynność lub podobieństwo semantyczne. Upewnij się, że wybrałeś metrykę, która jest zgodna z definicją „dobrą” w konkretnym przypadku użycia podsumowania. Można także użyć kombinacji metryk. Zapewnia to bardziej wszechstronną ocenę i chroni przed potencjalnymi słabościami poszczególnych wskaźników. Dzięki właściwym pomiarom możesz iteracyjnie ulepszać swoje podsumowania, aby spełnić dowolne pojęcie dokładności, które jest najważniejsze.

Ponadto konieczna jest ocena FM i LLM, aby móc produkować te modele na dużą skalę. Dzięki FMEval otrzymujesz szeroki zestaw wbudowanych algorytmów do wielu zadań NLP, ale także skalowalne i elastyczne narzędzie do ewaluacji własnych modeli, zbiorów danych i algorytmów na dużą skalę. Aby skalować w górę, możesz użyć tego pakietu w potokach LLMOps ocenić wiele modeli. Aby dowiedzieć się więcej o FMEval w AWS i o tym, jak efektywnie z niego korzystać, zob Użyj SageMaker Clarify, aby ocenić duże modele językowe. Dalsze zrozumienie i wgląd w możliwości SageMaker Clarify w ocenie FM można znaleźć w artykule Amazon SageMaker Clarify ułatwia ocenę i wybór modeli fundamentów.

O autorach

Dinesha Kumara Subramaniego jest starszym architektem rozwiązań z siedzibą w Edynburgu w Szkocji. Specjalizuje się w sztucznej inteligencji i uczeniu maszynowym oraz jest członkiem społeczności technicznej w Amazon. Dinesh ściśle współpracuje z klientami z brytyjskiego rządu centralnego, aby rozwiązywać ich problemy za pomocą usług AWS. Poza pracą Dinesh lubi spędzać czas z rodziną, grać w szachy i poznawać różnorodną muzykę.

Pranav Sharma jest liderem AWS kierującym inicjatywami w zakresie transformacji technologicznej i biznesowej w Europie, na Bliskim Wschodzie i w Afryce. Posiada doświadczenie w projektowaniu i uruchamianiu w środowisku produkcyjnym platform sztucznej inteligencji, które wspierają miliony klientów i dostarczają efekty biznesowe. Pełnił role kierownicze w zakresie technologii i ludzi w organizacjach Global Financial Services. Poza pracą lubi czytać, grać z synem w tenisa i oglądać filmy.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/evaluate-the-text-summarization-capabilities-of-llms-for-enhanced-decision-making-on-aws/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 100

- 11

- 15%

- 16

- 17

- 20

- 2015

- 28

- 32

- 36

- 7

- a

- Zdolny

- O nas

- abstrakcja

- przyśpieszyć

- Akceptuj

- dostęp

- precyzja

- dokładny

- dokładnie

- Osiągać

- w poprzek

- działania

- faktycznie

- adaptacja

- dodatek

- Dodatkowy

- do tego

- odpowiednio

- sąsiadujący

- Skorygowana

- Korekty

- przyjąć

- zaawansowany

- Korzyść

- Zalety

- propagowanie

- oddziaływać

- afektowany

- Afryka

- Po

- przed

- agencje

- agregat

- AI

- zmierzać

- algorytm

- Algorytmy

- wyrównać

- wyrównanie

- Wyrównuje

- Wszystkie kategorie

- dopuszczać

- Pozwalać

- pozwala

- również

- zmieniać

- Chociaż

- Amazonka

- Amazon Web Services

- kwoty

- an

- analizuje

- analiza

- w czasie rzeczywistym sprawiają,

- Analizując

- i

- sekretarka

- Antropiczny

- każdy

- nigdzie

- pojawił się

- odpowiedni

- aplikacje

- podejście

- awanse

- właściwy

- SĄ

- powstać

- artykuł

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja (AI)

- Sztuczna inteligencja i uczenie maszynowe

- AS

- aspekty

- ocenia

- oceniając

- oszacowanie

- oceny

- Asystent

- powiązany

- At

- Uwaga

- zwiększona

- zautomatyzowane

- automatycznie

- automatycznie

- dostępny

- uniknąć

- świadomy

- AWS

- Bilans

- zrównoważony

- Banki

- Barack Obama

- baza

- na podstawie

- Baseline

- podstawowy

- BE

- bo

- stają się

- być

- za

- jest

- Benchmark

- Benchmarkingu

- oprócz

- BEST

- Najlepsze praktyki

- Ulepsz Swój

- pomiędzy

- Poza

- stronniczość

- ciało

- obie

- Dolny

- szerszy

- brązowy

- wbudowany

- biznes

- Transformacja biznesowa

- ale

- by

- obliczać

- obliczony

- obliczenie

- CAN

- kandydat

- nie może

- możliwości

- zdolność

- zdobyć

- Zajęte

- przechwytuje

- Przechwytywanie

- ostrożny

- prowadzone

- walizka

- Etui

- CAT

- centralny

- pewien

- wyzwanie

- wyzwania

- wyzwanie

- Charakterystyka

- Szachy

- wybór

- wybrany

- klasyfikacja

- Zamknij

- dokładnie

- kod

- ZGODNY

- spoisty

- połączenie

- połączyć

- byliśmy spójni, od początku

- wspólny

- powszechnie

- społeczność

- Firmy

- porównać

- w porównaniu

- porównanie

- porównanie

- porównania

- kompletny

- ukończenia

- kompleks

- wszechstronny

- obliczeniowy

- obliczeniowo

- computing

- Koncepcje

- zwięzły

- prowadzenia

- systemu

- Skontaktuj się

- Rozważać

- za

- wobec

- rozważa

- zgodny

- Ograniczenia

- zawiera

- zawartość

- kontekst

- konteksty

- kontekstowy

- kontynuować

- rdzeń

- skorygowania

- mógłby

- Tworzenie

- kreatywność

- krytyczny

- istotny

- zwyczaj

- Klientów

- dane

- zbiory danych

- Podejmowanie decyzji

- Decyzje

- uważane

- głębiej

- braki

- zdefiniowane

- Definiuje

- dostarczyć

- wymagania

- wykazać

- wyjaśnić

- Zależności

- zależny

- W zależności

- projektowanie

- szczegółowe

- detale

- wykryć

- rozwijanie

- Różnice

- różne

- różnie

- trudny

- trudności

- kierować

- kierunek

- omówione

- inny

- podzielony

- do

- dokument

- dokumenty

- Nie

- Pies

- domeny

- na dół

- jazdy

- Spadek

- z powodu

- podczas

- każdy

- Wcześniej

- Zarobki

- łatwiej

- Wschód

- ed

- faktycznie

- skuteczność

- wydajny

- skutecznie

- starania

- osiem

- bądź

- nacisk

- zatrudniony

- zatrudniający

- upoważnia

- Umożliwia

- umożliwiając

- wzmocnione

- Poprawia

- podmioty

- środowiska

- równorzędność

- szczególnie

- istota

- niezbędny

- istotnie

- Europie

- oceniać

- oceny

- ewaluację

- oceny

- Parzyste

- dokładny

- przykład

- przykłady

- wyróżnia się

- pokazać

- istnieje

- oczekuje

- doświadczenie

- odkryj

- Exploring

- ekspresowy

- rozciągać się

- wyciąg

- ekstrakcja

- f1

- Spadać

- członków Twojej rodziny

- FAST

- Ferrari

- wierność

- pole

- finał

- budżetowy

- Sektor finansowy

- usługi finansowe

- znajduje

- ustalony

- Elastyczność

- elastyczne

- pływ

- Przepływy

- Skupiać

- koncentruje

- skupienie

- następujący

- W razie zamówieenia projektu

- Nasz formularz

- format

- dawniej

- formularze

- Fundacja

- lis

- Ramy

- Częstotliwość

- od

- pełny

- w pełni

- funkcjonować

- zasadniczo

- dalej

- Wzrost

- zyskuje

- zebrane

- uogólnione

- ogólnie

- Generować

- wygenerowane

- generuje

- generujący

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- Dać

- dany

- daje

- Dający

- Globalne

- globalne finanse

- cel

- Gole

- Goes

- dobry

- Rząd

- agencje rządowe

- Zielony

- Grupy

- Rozwój

- Rośnie

- poradnictwo

- poprowadzi

- wytyczne

- Hamilton

- uchwyt

- uprząż

- Have

- he

- ciężko

- pomoc

- pomoc

- pomaga

- tutaj

- Wysoki

- wyższy

- Podświetlony

- podświetlanie

- wysoko

- jego

- Strona główna

- hostowane

- W jaki sposób

- How To

- Jednak

- HTML

- HTTPS

- człowiek

- Hybrydowy

- i

- ID

- pomysł

- idealny

- idealnie

- pomysły

- identiques

- zidentyfikowane

- zidentyfikować

- identyfikacja

- tożsamość

- ids

- if

- zilustrować

- obraz

- Rezultat

- wykonawczych

- implikacje

- importować

- ważny

- podnieść

- poprawa

- in

- włączony

- obejmuje

- Włącznie z

- niespójności

- zawiera

- Zwiększać

- coraz bardziej

- wskazuje

- indywidualny

- przemysłowa

- Informacja

- informacyjny

- poinformowany

- inicjatywy

- wkład

- wgląd

- spostrzeżenia

- przykład

- instrukcje

- instrumentalny

- Inteligencja

- interakcji

- Interfejs

- zinterpretować

- interpretacji

- najnowszych

- inwestycja

- banki inwestycyjne

- przywołany

- dotyczy

- z udziałem

- problemy

- IT

- JEGO

- Dziennikarze

- jpg

- json

- skoki

- właśnie

- Trzymać

- Klawisz

- słowa kluczowe

- Kumar

- Brak

- język

- Języki

- duży

- na dużą skalę

- Nazwisko

- prowadzić

- lider

- Przywództwo

- prowadzący

- Wyprowadzenia

- skoki

- UCZYĆ SIĘ

- nauka

- Regulamin

- Długość

- mniej

- niech

- poziomy

- biblioteki

- Biblioteka

- lubić

- lubi

- Ograniczenia

- Linia

- Lista

- LLM

- logicznie

- długo

- dłużej

- Popatrz

- WYGLĄD

- niski

- niższy

- maszyna

- uczenie maszynowe

- zrobiony

- Główny

- utrzymuje

- poważny

- robić

- WYKONUJE

- Dokonywanie

- wiele

- Mecz

- zapałki

- dopasowywanie

- materiał

- Matters

- Maksymalizuj

- maksymalny

- Może..

- me

- oznaczać

- znaczenie

- wymowny

- znaczenia

- znaczy

- zmierzyć

- Pomiary

- środków

- zmierzenie

- mechanizm

- Mechanizmy

- Media

- Poznaj nasz

- członek

- metoda

- metodologie

- metody

- metryczny

- Metryka

- Microsoft

- Środkowy

- Bliski Wschód

- może

- miliony

- tęsknić

- brakujący

- ML

- model

- modele

- monitor

- jeszcze

- większość

- Kino

- dużo

- wieloaspektowy

- wielokrotność

- Muzyka

- O imieniu

- wąski

- Naturalny

- Przetwarzanie języka naturalnego

- Nawigacja

- prawie

- koniecznie

- niezbędny

- Potrzebować

- potrzeba

- wymagania

- sieci

- nerwowy

- sieci neuronowe

- Nowości

- aktualności

- nlp

- Nie

- Pojęcie

- już dziś

- niuansowany

- zacienienie

- numer

- Obama

- przedmiot

- obiektywnie

- więzy

- uzyskać

- uzyskane

- październik

- of

- oferuje

- Oferty

- Oficer

- często

- on

- ONE

- tylko

- koncepcja

- Optymalny

- optymalizacja

- optymalizacji

- or

- zamówienie

- organizacji

- oryginalny

- Inne

- na zewnątrz

- wyniki

- opisane

- wydajność

- zewnętrzne

- koniec

- ogólny

- Przezwyciężać

- zakładka

- własny

- pakiet

- par

- parametry

- szczególny

- szczególnie

- strony

- kary

- kara

- Ludzie

- doskonały

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonuje

- perspektywa

- Zwroty

- sztuk

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- grał

- gracz

- gra

- punkt

- zwrotnica

- Policja

- polityka

- polityka

- politycy

- Popularny

- pozowanie

- position

- Post

- potencjał

- potencjalnie

- power

- praktyki

- praktycy

- poprzedzający

- Detaliczność

- lepszy

- obecność

- teraźniejszość

- przedstawione

- prezenty

- konserwowanie

- pierwotny

- Priorytet

- problemy

- wygląda tak

- procesów

- przetwarzanie

- produkować

- Wytworzony

- Produkcja

- wydajność

- Profil

- programowy

- Napędzać

- prawidłowo

- Udowodnij

- zapewniać

- zapewnia

- że

- Python

- jakość

- kwartalnie

- pytanie

- Szybki

- szybko

- szmata

- zasięg

- zakresy

- rankingu

- szybko

- rated

- raczej

- Czytaj

- czyta

- w czasie rzeczywistym

- Przyczyny

- otrzymać

- rozpoznać

- rozpoznaje

- Rekomendacja

- zmniejsza

- redukcja

- odnosić się

- odniesienie

- referencje

- odzwierciedlić

- odzwierciedlając

- odzwierciedla

- Bez względu

- związane z

- mających znaczenie

- niezawodność

- poleganie

- opiera się

- polegać

- opierając się

- szczątki

- powtarzalne

- Raporty

- reprezentować

- reprezentacja

- przedstawiciel

- reprezentuje

- zażądać

- wymagać

- wymagania

- Wymaga

- Badania naukowe

- Badacze

- odpowiedź

- odpowiedzialny

- dalsze

- Efekt

- wspornikowy

- retencja

- wyszukiwanie

- przeglądu

- Nagrody

- prawo

- prawa

- Ryzyko

- ryzyko

- krzepki

- krzepkość

- Rola

- role

- korzeń

- RZĄD

- bieganie

- sagemaker

- taki sam

- próba

- Oszczędności

- skalowalny

- Skala

- skalowaniem

- scenariusze

- wynik

- wyniki

- punktacji

- Szukaj

- Sekcja

- sektor

- widzieć

- Szukajcie

- Segmenty

- wybierać

- wybierając

- wybór

- wybiera

- semantyczny

- senior

- wyrok

- Sekwencja

- Usługi

- zestaw

- Zestawy

- kilka

- świecący

- Short

- krótszy

- powinien

- znaczący

- podobny

- podobieństwa

- Prosty

- po prostu

- pojedynczy

- płynnie

- skrawek

- So

- Obserwuj Nas

- Media społecznościowe

- Rozwiązania

- ROZWIĄZANIA

- kilka

- syn

- wyrafinowany

- Źródło

- pozyskiwany

- Typ przestrzeni

- wyspecjalizowanym

- specjalizuje się

- specyficzny

- swoiście

- Spędzanie

- interesariusze

- początek

- Zjednoczone

- statystyczny

- wywodził się

- wynika

- Ewolucja krok po kroku

- Cel

- Nadal

- historie

- Strategiczny

- strategie

- usprawnień

- Strumienie

- silne strony

- sznur

- zbudowany

- Struktury

- Walka

- subiektywny

- w zasadzie

- taki

- odpowiedni

- w kolorze

- streszczać

- PODSUMOWANIE

- lato

- Niedz

- wsparcie

- Utrzymany

- Wspierający

- pewnie

- Powierzchnia

- otaczający

- zamienione

- Synonim

- równoznaczny

- składnia

- system

- systemy

- stół

- Takeaways

- Zadanie

- zadania

- Zespoły

- Techniczny

- technika

- Techniki

- Technologia

- mówi

- tenis

- semestr

- REGULAMIN

- XNUMX

- niż

- że

- Połączenia

- Źródło

- ich

- Im

- następnie

- Tam.

- w związku z tym

- Te

- one

- to

- dokładny

- tych

- chociaż?

- Przez

- czas

- czasochłonne

- czasy

- do

- żeton

- tokenizacja

- Żetony

- narzędzie

- tematy

- Kwota produktów:

- tradycyjny

- Transformacja

- transformacyjny

- transformator

- Tłumaczenie

- naprawdę

- strojenie

- drugiej

- rodzaj

- typy

- zazwyczaj

- Uk

- zasadniczy

- zrozumieć

- zrozumienie

- zrozumiany

- wyjątkowy

- w odróżnieniu

- zaktualizowane

- us

- Stosowanie

- posługiwać się

- przypadek użycia

- używany

- użyteczny

- Użytkownik

- Użytkownicy

- zastosowania

- za pomocą

- Cenny

- wartość

- zmienna

- wariacje

- różnorodny

- różnią się

- zmienne

- Naprawiono

- Wersje

- początku.

- istotny

- kłęby

- Oglądaj

- Droga..

- sposoby

- we

- Słabości

- sieć

- usługi internetowe

- DOBRZE

- były

- Co

- jeśli chodzi o komunikację i motywację

- natomiast

- czy

- który

- Podczas

- KIM

- cały

- będzie

- w

- w ciągu

- bez

- słowo

- sformułowanie

- słowa

- Praca

- działa

- by

- napisać

- napisany

- You

- Twój

- zefirnet