Płótno Amazon SageMaker obsługuje teraz wdrażanie modeli uczenia maszynowego (ML) w punktach końcowych wnioskowania w czasie rzeczywistym, umożliwiając przeniesienie modeli ML do środowiska produkcyjnego i kierowanie działaniami w oparciu o spostrzeżenia oparte na technologii ML. SageMaker Canvas to przestrzeń robocza niewymagająca użycia kodu, która umożliwia analitykom i badaczom danych obywatelskich generowanie dokładnych prognoz ML dla ich potrzeb biznesowych.

Do tej pory SageMaker Canvas zapewniał możliwość oceny modelu uczenia maszynowego, generowania zbiorczych prognoz i przeprowadzania analiz typu „co by było, gdyby” w interaktywnym obszarze roboczym. Ale teraz możesz także wdrażać modele w punktach końcowych Amazon SageMaker w celu wnioskowania w czasie rzeczywistym, dzięki czemu korzystanie z przewidywań modeli i kierowanie działaniami poza obszarem roboczym SageMaker Canvas będzie łatwe. Możliwość bezpośredniego wdrażania modeli ML z SageMaker Canvas eliminuje potrzebę ręcznego eksportowania, konfigurowania, testowania i wdrażania modeli ML w środowisku produkcyjnym, co pozwala zaoszczędzić czas i złożoność. Dzięki temu operacjonalizacja modeli uczenia maszynowego staje się bardziej dostępna dla poszczególnych osób, bez konieczności pisania kodu.

W tym poście przeprowadzimy Cię przez proces wdrożyć model w SageMaker Canvas do punktu końcowego w czasie rzeczywistym.

Przegląd rozwiązania

Dla naszego przypadku użycia przyjmujemy rolę użytkownika biznesowego w dziale marketingu operatora telefonii komórkowej i z sukcesem stworzyliśmy model ML w SageMaker Canvas, aby zidentyfikować klientów z potencjalnym ryzykiem odejścia. Dzięki przewidywaniom wygenerowanym przez nasz model chcemy teraz przenieść to ze środowiska programistycznego do produkcyjnego. Aby usprawnić proces wdrażania punktu końcowego naszego modelu na potrzeby wnioskowania, wdrażamy modele ML bezpośrednio z SageMaker Canvas, eliminując w ten sposób potrzebę ręcznego eksportowania, konfigurowania, testowania i wdrażania modeli ML w środowisku produkcyjnym. Pomaga to zmniejszyć złożoność, oszczędza czas, a także sprawia, że operacjonalizacja modeli uczenia maszynowego jest bardziej dostępna dla poszczególnych osób, bez konieczności pisania kodu.

Kroki przepływu pracy są następujące:

- Prześlij nowy zestaw danych z obecną populacją klientów do SageMaker Canvas. Aby zapoznać się z pełną listą obsługiwanych źródeł danych, zobacz Importuj dane do Canvas.

- Twórz modele uczenia maszynowego i analizuj ich wskaźniki wydajności. Aby uzyskać instrukcje, zobacz Zbuduj niestandardowy model i Oceń wydajność swojego modelu w Amazon SageMaker Canvas.

- Wdróż zatwierdzoną wersję modelu jako punkt końcowy do wnioskowania w czasie rzeczywistym.

Możesz wykonać te kroki w SageMaker Canvas bez pisania ani jednej linii kodu.

Wymagania wstępne

W tym przewodniku upewnij się, że spełnione są następujące wymagania wstępne:

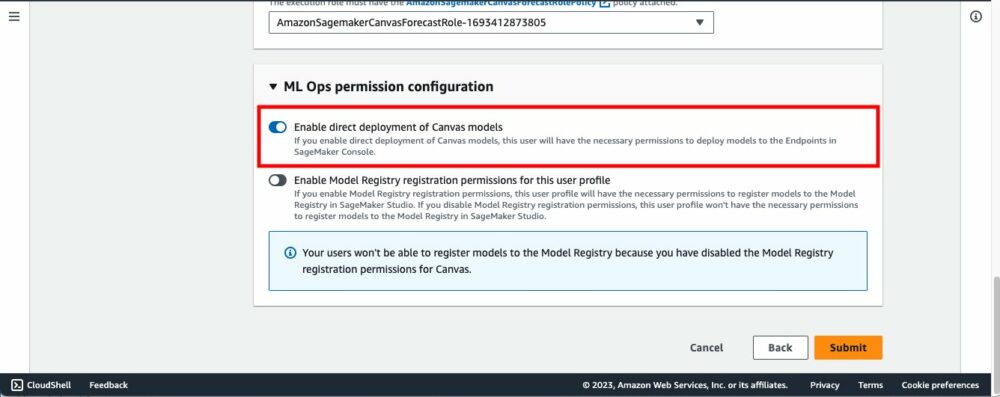

- Aby wdrożyć wersje modelu na punktach końcowych SageMaker, administrator SageMaker Canvas musi przyznać niezbędne uprawnienia użytkownikowi SageMaker Canvas, którymi można zarządzać w domenie SageMaker, w której znajduje się aplikacja SageMaker Canvas. Aby uzyskać więcej informacji, zobacz Zarządzanie uprawnieniami w Canvas.

- Zaimplementuj wymagania wstępne, o których mowa w Przewiduj odejścia klientów dzięki uczeniu maszynowemu bez kodu, korzystając z Amazon SageMaker Canvas.

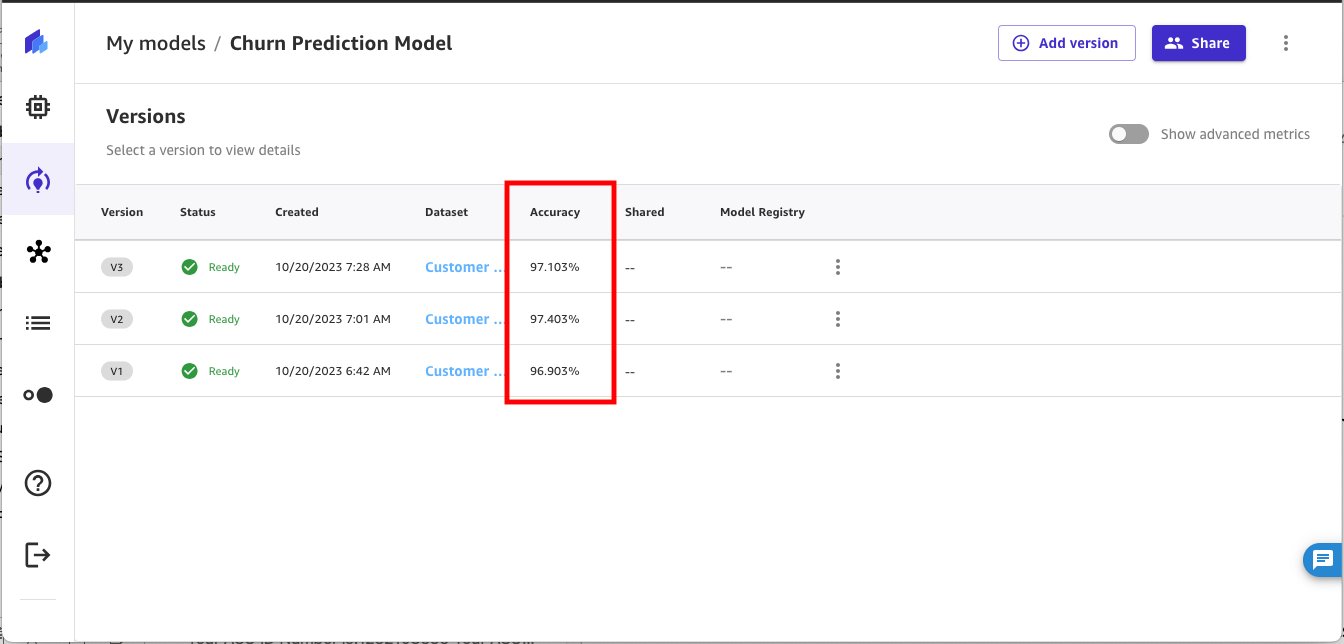

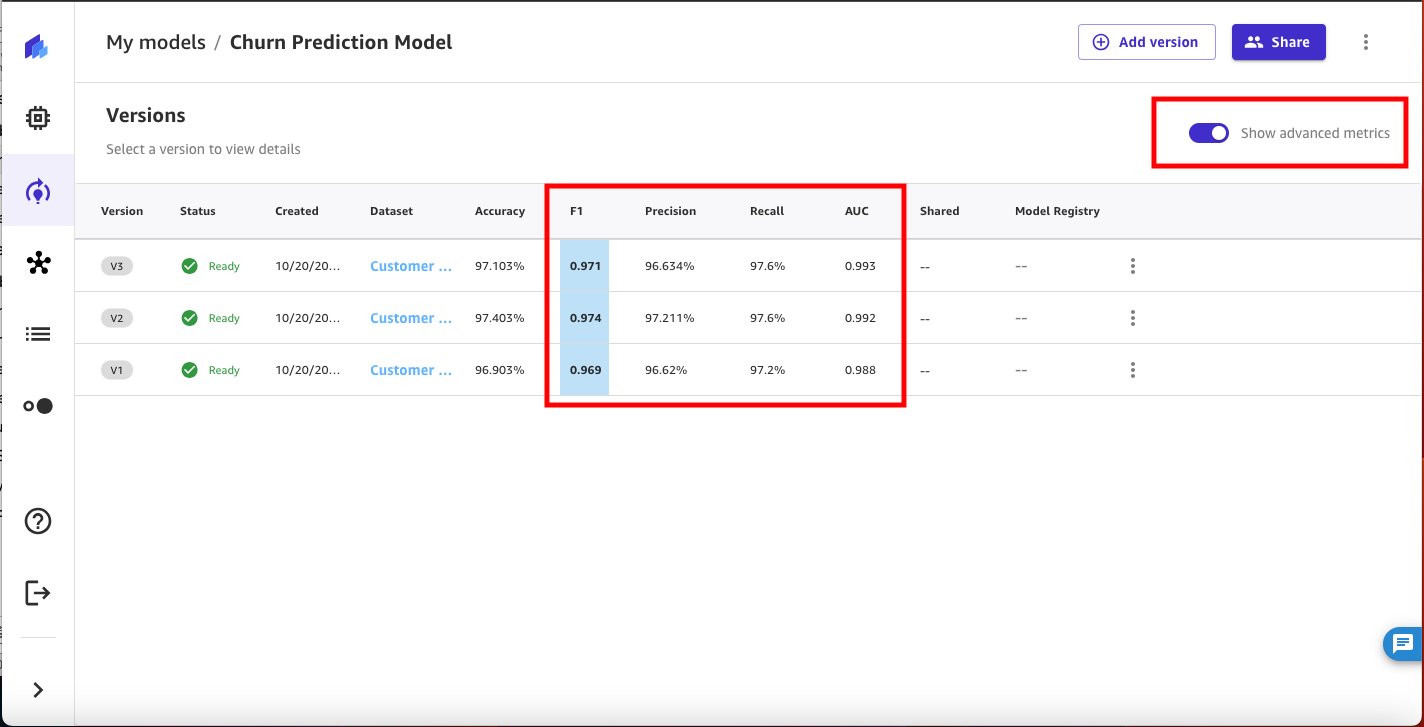

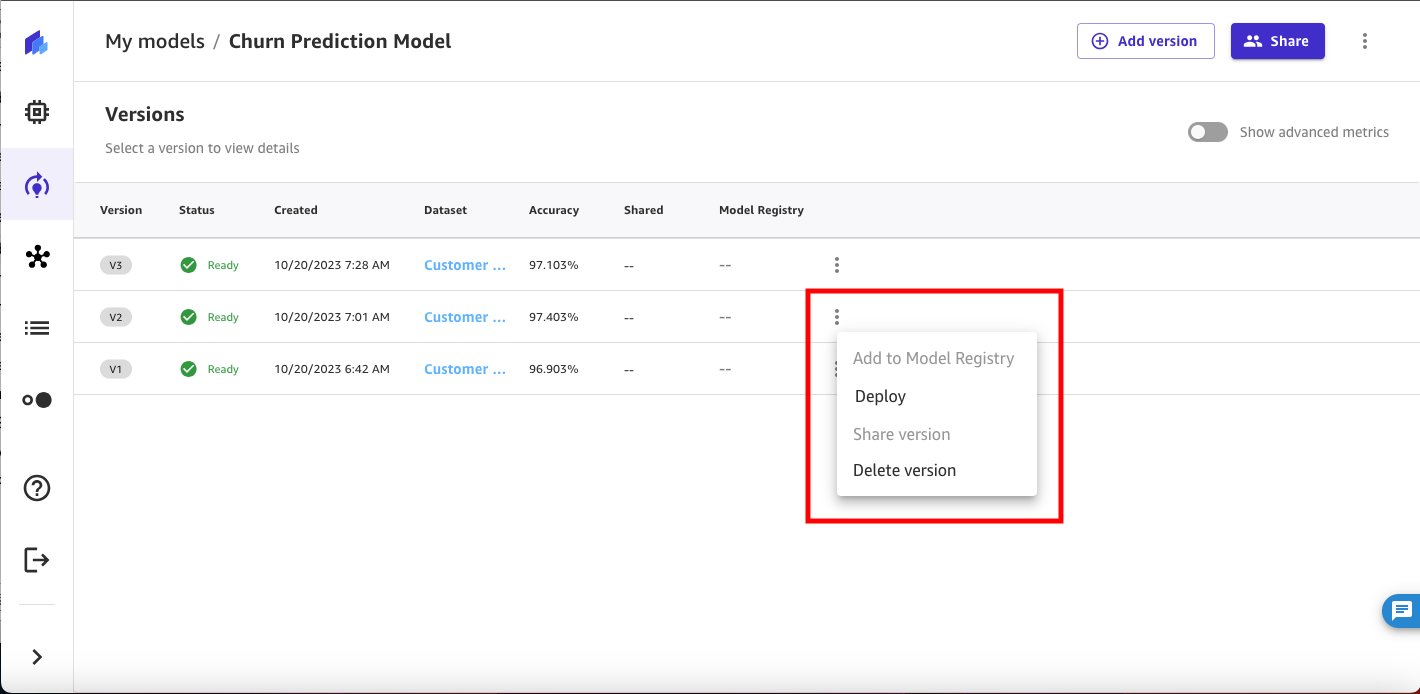

Powinieneś mieć teraz trzy wersje modelu wytrenowane na podstawie historycznych danych prognozy odejścia w Canvas:

- V1 przeszkolony ze wszystkimi 21 funkcjami i szybką konfiguracją kompilacji z wynikiem modelu 96.903%

- Szkolenie V2 ze wszystkimi 19 funkcjami (usunięte funkcje telefonu i stanu) oraz konfiguracja szybkiej kompilacji i poprawiona dokładność 97.403%

- V3 przeszkolony ze standardową konfiguracją kompilacji z wynikiem modelu 97.103%.

Użyj modelu przewidywania rezygnacji klientów

umożliwiać Pokaż zaawansowane metryki na stronie szczegółów modelu i przejrzyj obiektywne metryki powiązane z każdą wersją modelu, aby wybrać najskuteczniejszy model do wdrożenia w SageMaker jako punkcie końcowym.

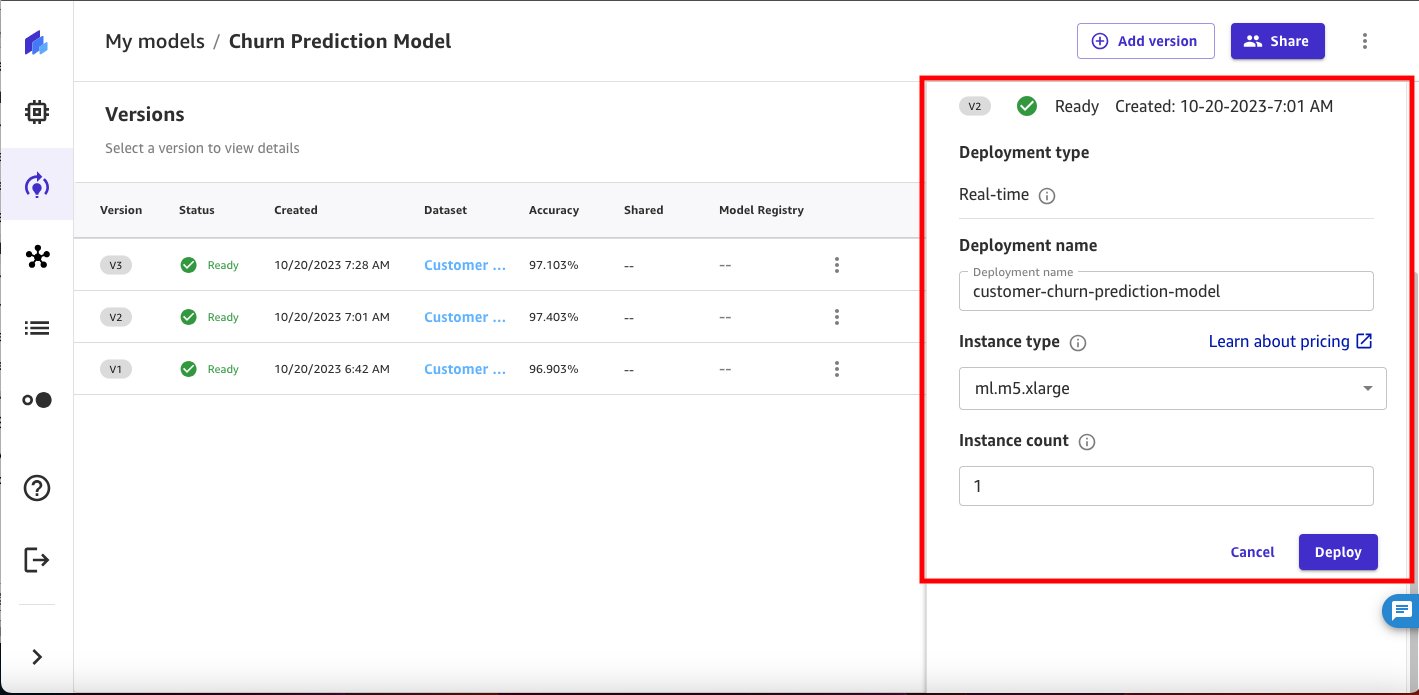

Na podstawie wskaźników wydajności wybieramy wersję 2 do wdrożenia.

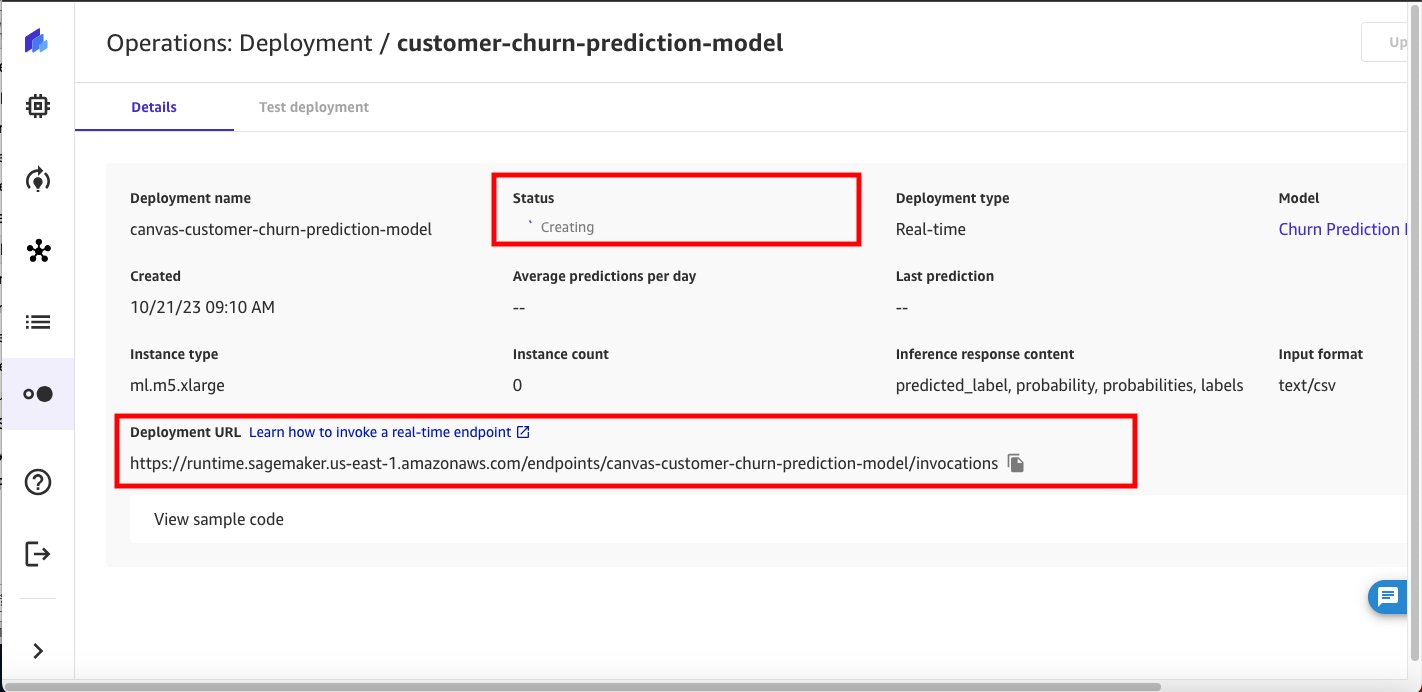

Skonfiguruj ustawienia wdrażania modelu — nazwę wdrożenia, typ instancji i liczbę instancji.

Na początek Canvas automatycznie zarekomenduje najlepszy typ instancji i liczbę instancji do wdrożenia modelu. Możesz go zmienić w zależności od potrzeb związanych z obciążeniem pracą.

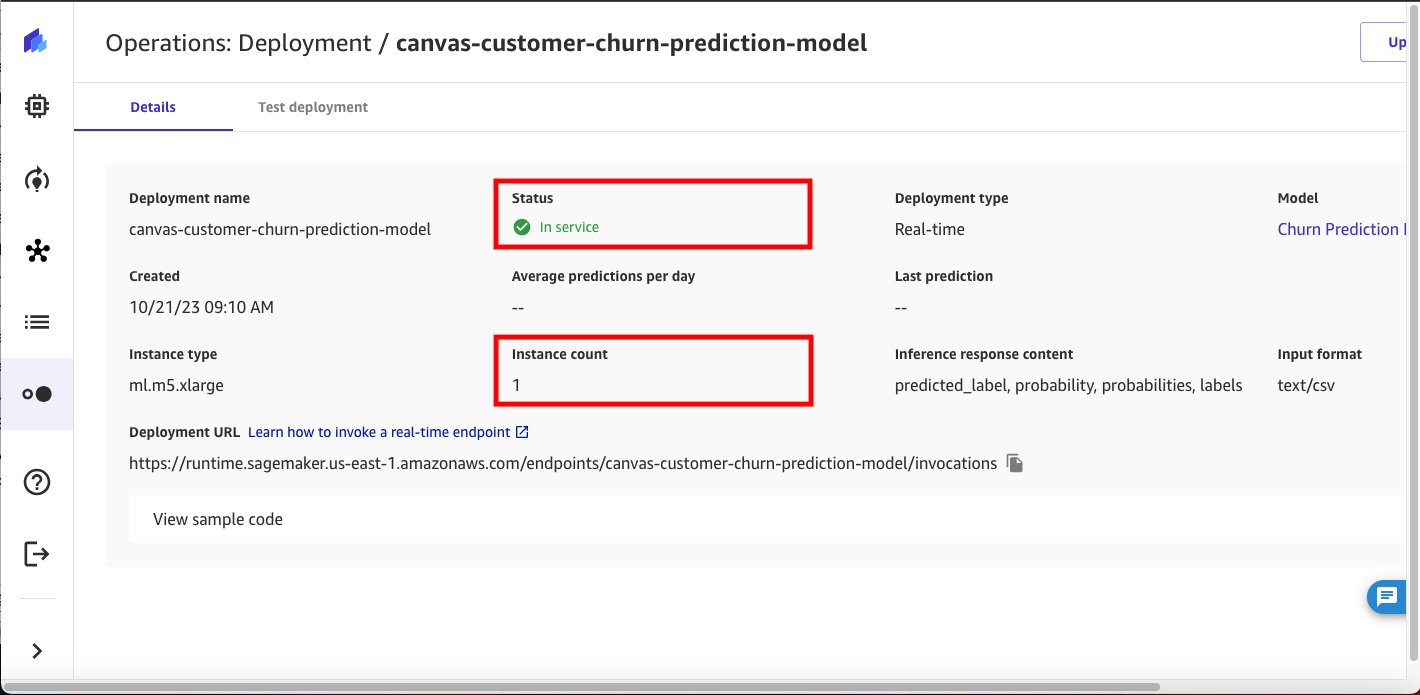

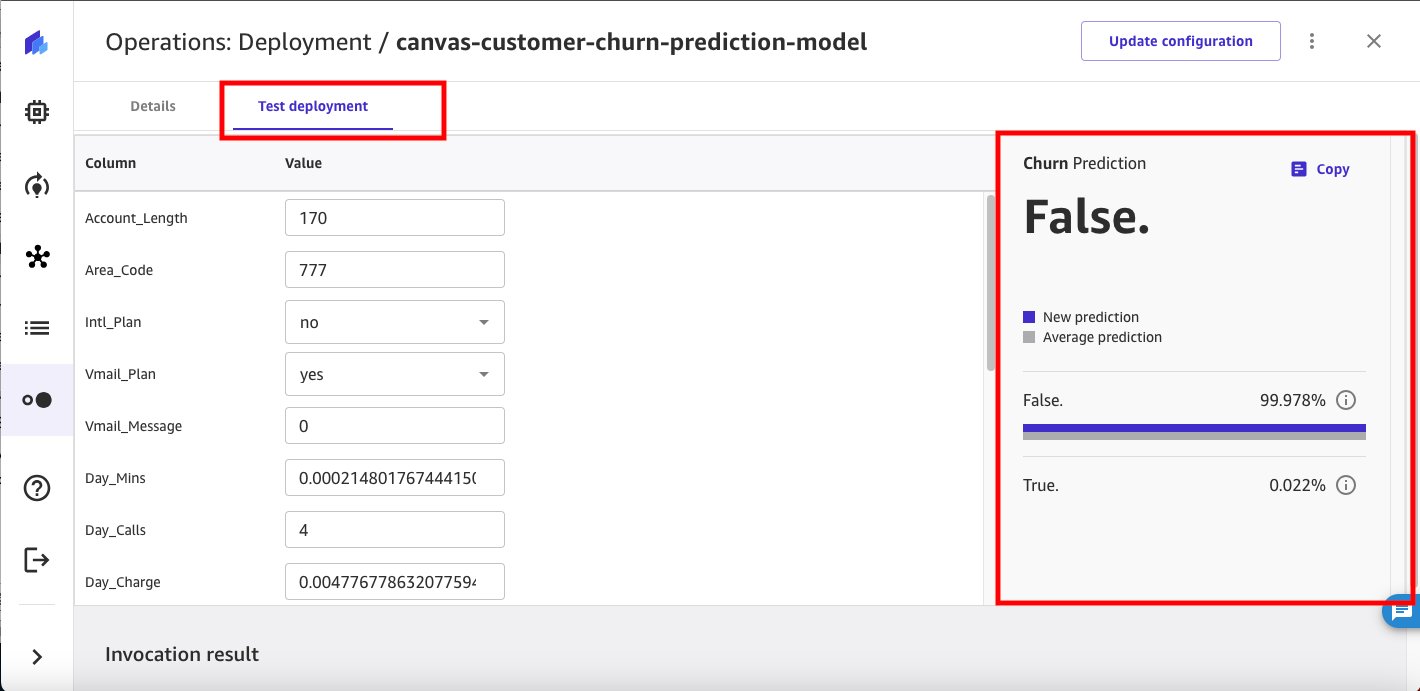

Możesz przetestować wdrożony punkt końcowy wnioskowania SageMaker bezpośrednio z poziomu SageMaker Canvas.

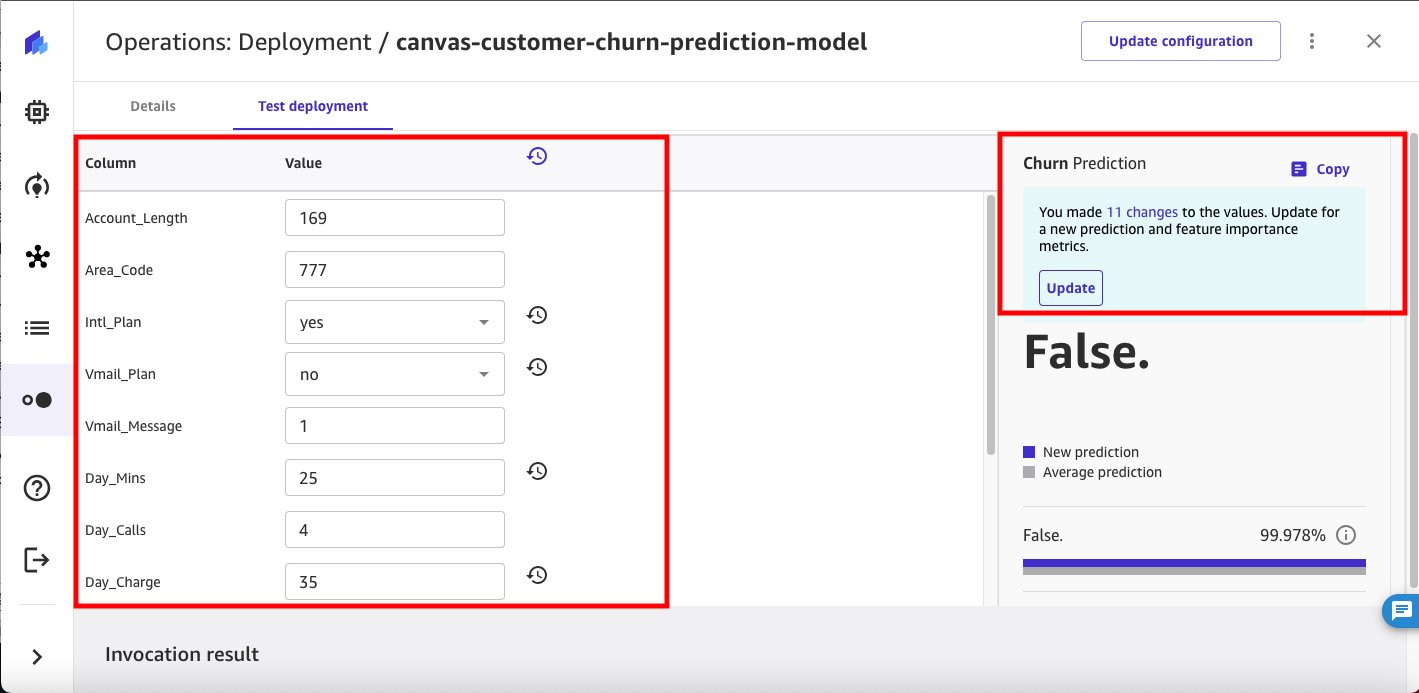

Możesz zmieniać wartości wejściowe za pomocą interfejsu użytkownika SageMaker Canvas, aby uzyskać dodatkową prognozę rezygnacji.

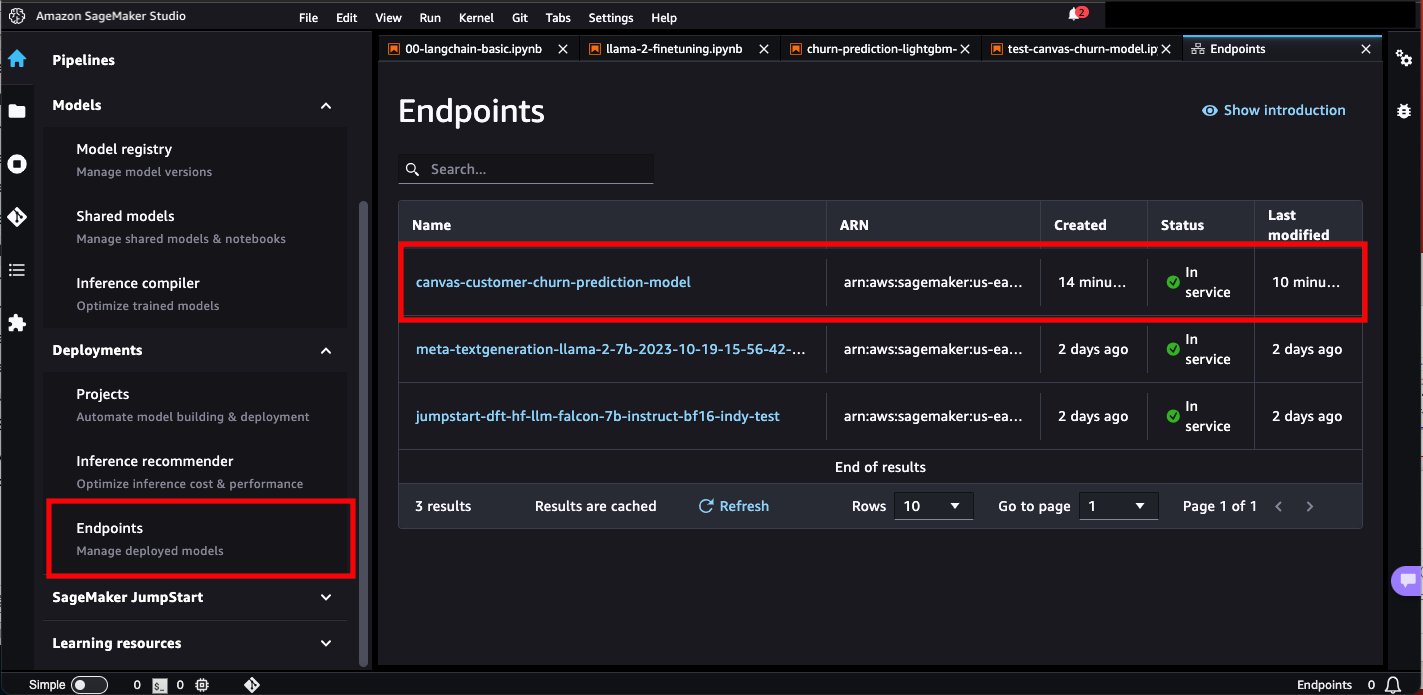

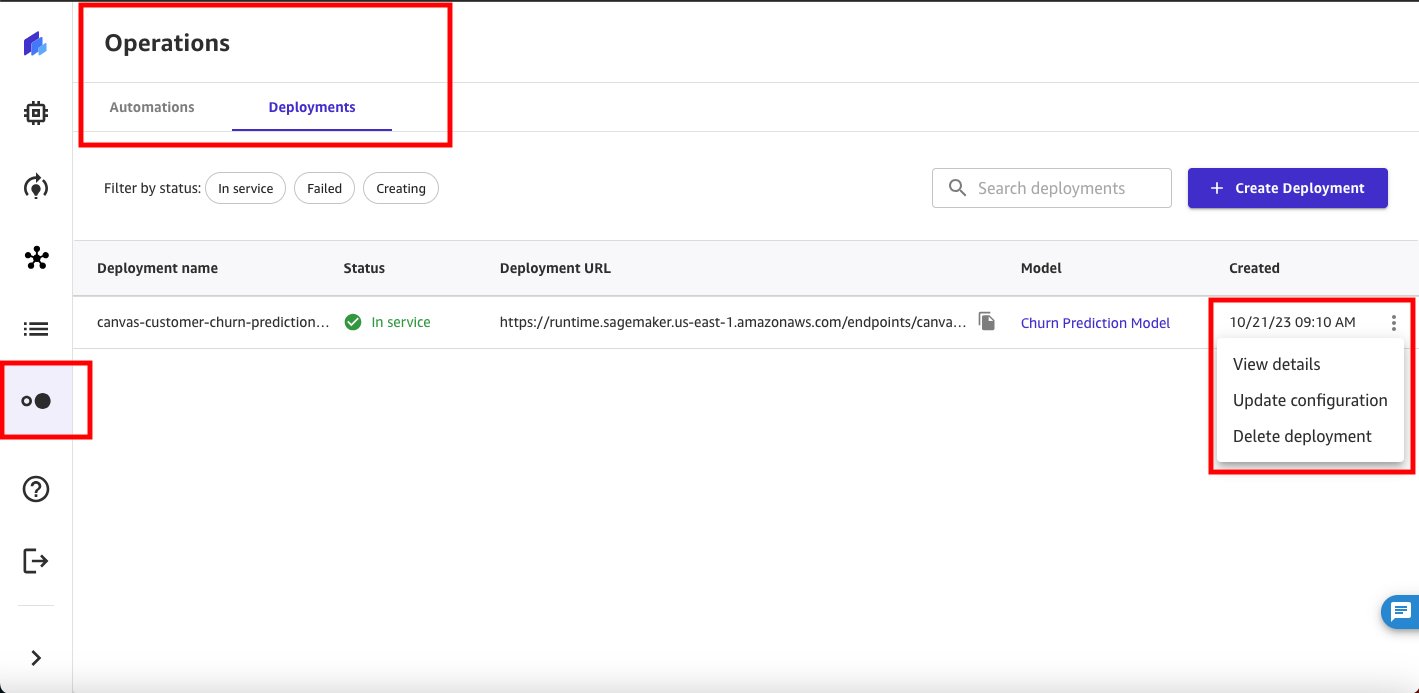

Teraz przejdźmy do Studio Amazon SageMaker i sprawdź wdrożony punkt końcowy.

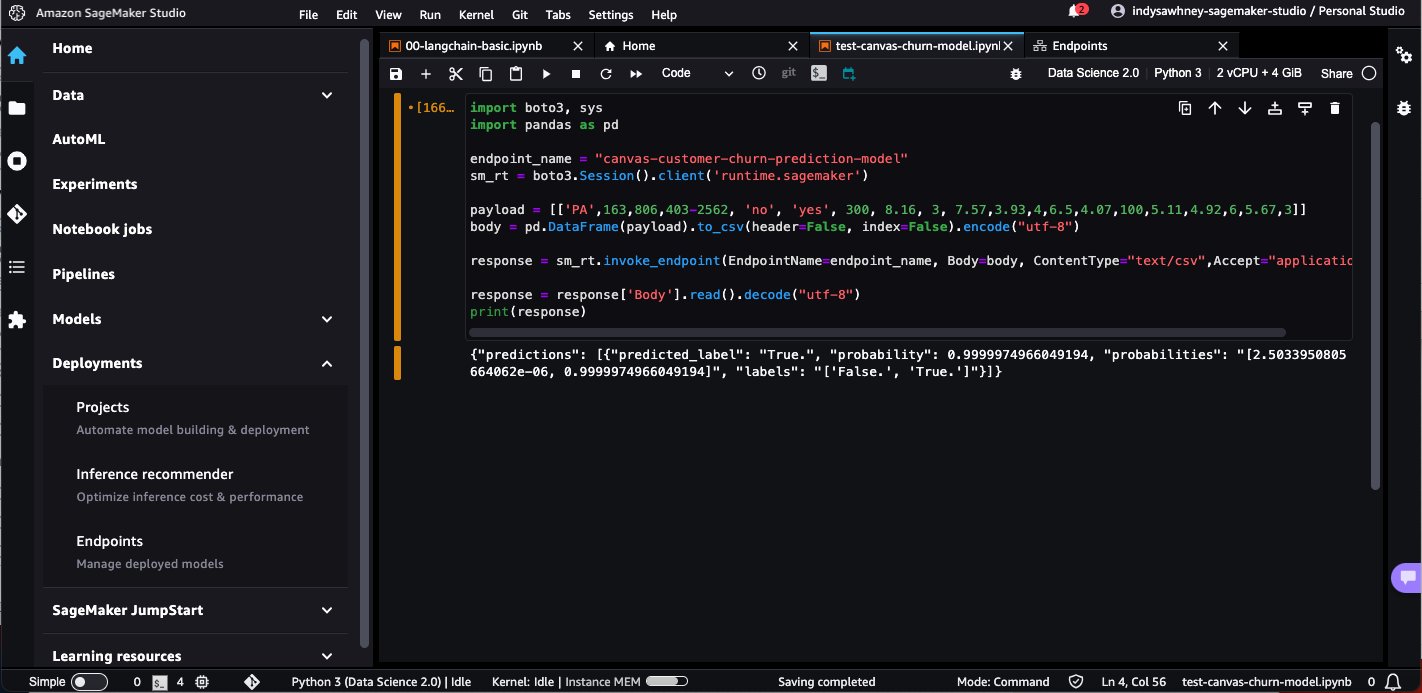

Otwórz notatnik w SageMaker Studio i uruchom następujący kod, aby wywnioskować punkt końcowy wdrożonego modelu. Zastąp nazwę punktu końcowego modelu własną nazwą punktu końcowego modelu.

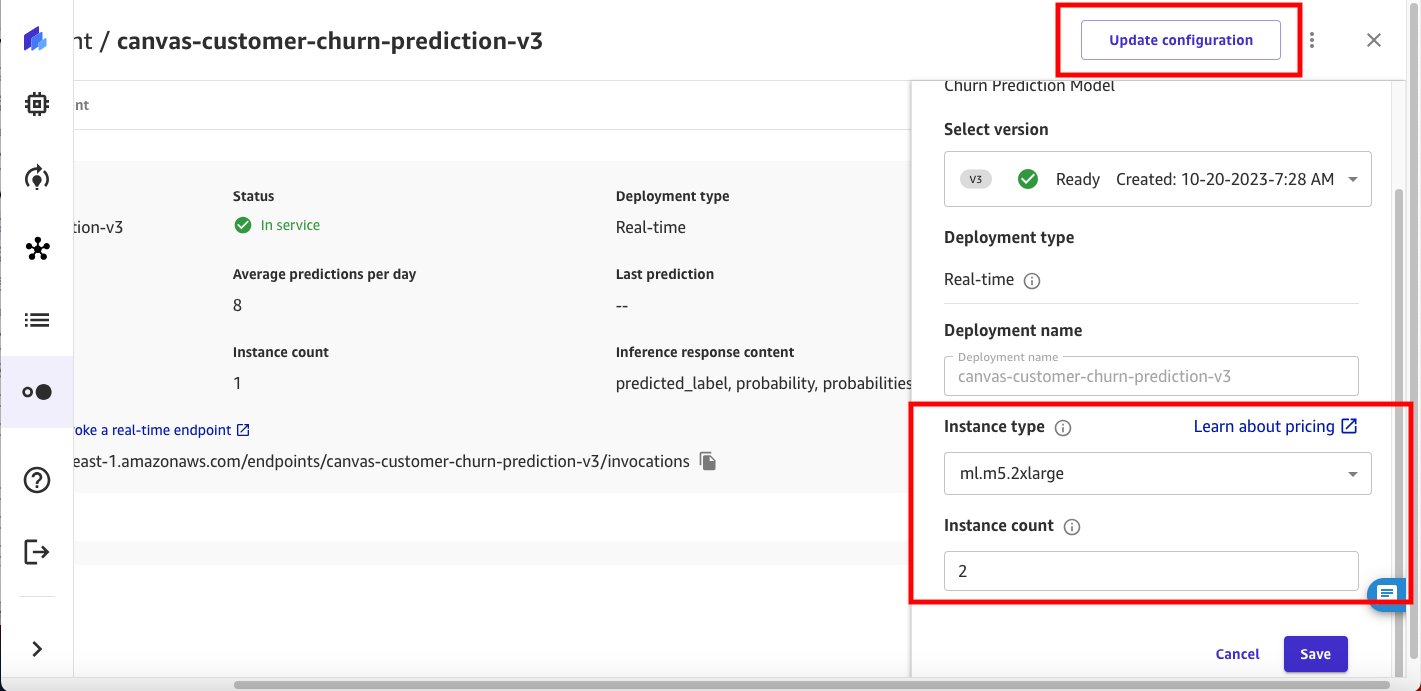

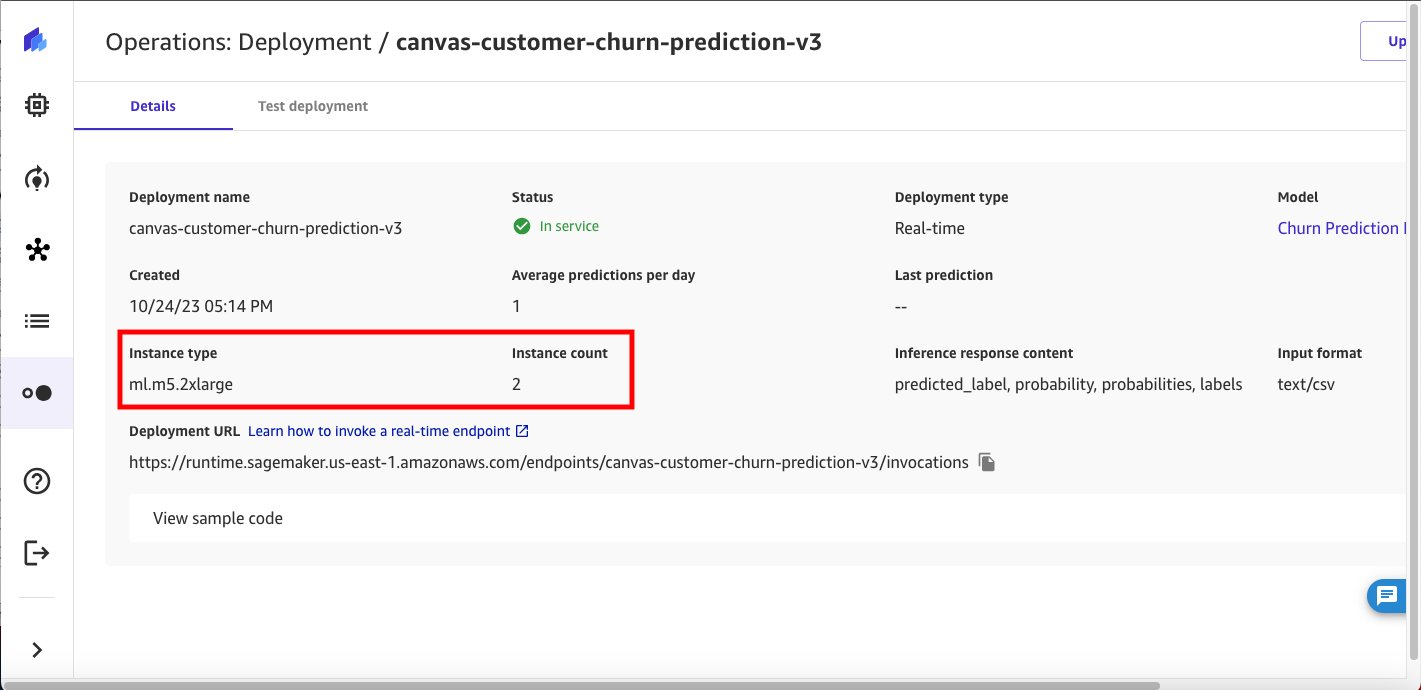

Nasz oryginalny punkt końcowy modelu używa instancji ml.m5.xlarge i 1 liczby instancji. Załóżmy teraz, że spodziewasz się wzrostu liczby użytkowników końcowych korzystających z punktu końcowego modelu i chcesz zapewnić większą moc obliczeniową. Możesz to zrobić bezpośrednio z poziomu SageMaker Canvas, wybierając Zaktualizuj konfigurację.

Sprzątać

Aby uniknąć przyszłych opłat, usuń zasoby utworzone podczas śledzenia tego wpisu. Obejmuje to wylogowanie się z SageMaker Canvas i usunięcie wdrożonego punktu końcowego SageMaker. SageMaker Canvas wystawia Ci rachunek za czas trwania sesji i zalecamy wylogowanie się z SageMaker Canvas, jeśli z niego nie korzystasz. Odnosić się do Wylogowanie z Amazon SageMaker Canvas by uzyskać więcej szczegółów.

Wnioski

W tym poście omówiliśmy, w jaki sposób SageMaker Canvas może wdrażać modele ML w punktach końcowych wnioskowania w czasie rzeczywistym, umożliwiając przeniesienie modeli ML do środowiska produkcyjnego i kierowanie działaniami w oparciu o spostrzeżenia oparte na ML. W naszym przykładzie pokazaliśmy, jak analityk może szybko zbudować bardzo dokładny model predykcyjny ML bez pisania żadnego kodu, wdrożyć go w SageMaker jako punkt końcowy i przetestować punkt końcowy modelu z SageMaker Canvas, a także z notatnika SageMaker Studio.

Aby rozpocząć swoją przygodę z ML z niskim kodem/bez kodu, zobacz Płótno Amazon SageMaker.

Specjalne podziękowania dla wszystkich, którzy przyczynili się do premiery: Prashanth Kurumaddali, Abishek Kumar, Allen Liu, Sean Lester, Richa Sundrani i Alicia Qi.

O autorach

Janisza Anand jest starszym menedżerem produktu w zespole Amazon SageMaker Low/No Code ML, który obejmuje SageMaker Canvas i SageMaker Autopilot. Lubi kawę, aktywnie spędzać czas i spędzać czas z rodziną.

Janisza Anand jest starszym menedżerem produktu w zespole Amazon SageMaker Low/No Code ML, który obejmuje SageMaker Canvas i SageMaker Autopilot. Lubi kawę, aktywnie spędzać czas i spędzać czas z rodziną.

Indy’ego Sawhney’a jest starszym liderem rozwiązań dla klientów w Amazon Web Services. Zawsze analizując problemy klientów, Indy doradza kierownictwu klientów korporacyjnych AWS na ich wyjątkowej drodze do transformacji chmury. Ma ponad 25-letnie doświadczenie w pomaganiu organizacjom korporacyjnym we wdrażaniu nowych technologii i rozwiązań biznesowych. Indy to specjalista w obszarze Technical Field Community AWS ds. sztucznej inteligencji/ML, specjalizujący się w generatywnej sztucznej inteligencji oraz rozwiązaniach Amazon SageMaker z małą ilością kodu/bez kodu.

Indy’ego Sawhney’a jest starszym liderem rozwiązań dla klientów w Amazon Web Services. Zawsze analizując problemy klientów, Indy doradza kierownictwu klientów korporacyjnych AWS na ich wyjątkowej drodze do transformacji chmury. Ma ponad 25-letnie doświadczenie w pomaganiu organizacjom korporacyjnym we wdrażaniu nowych technologii i rozwiązań biznesowych. Indy to specjalista w obszarze Technical Field Community AWS ds. sztucznej inteligencji/ML, specjalizujący się w generatywnej sztucznej inteligencji oraz rozwiązaniach Amazon SageMaker z małą ilością kodu/bez kodu.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/deploy-ml-models-built-in-amazon-sagemaker-canvas-to-amazon-sagemaker-real-time-endpoints/

- :ma

- :Jest

- :nie

- 07

- 1

- 100

- 11

- 16

- 19

- 25

- 67

- 7

- 8

- 97

- a

- zdolność

- dostępny

- wykonać

- precyzja

- dokładny

- Działania

- działania

- aktywny

- Dodatkowy

- Admin

- przyjąć

- zaawansowany

- AI

- AI / ML

- Wszystkie kategorie

- Allen

- Pozwalać

- również

- zawsze

- Amazonka

- Amazon Sage Maker

- Płótno Amazon SageMaker

- Amazon Web Services

- an

- analizuje

- analityk

- analitycy

- w czasie rzeczywistym sprawiają,

- i

- każdy

- Zastosowanie

- zatwierdzony

- SĄ

- POWIERZCHNIA

- AS

- powiązany

- założyć

- automatycznie

- uniknąć

- AWS

- na podstawie

- BE

- BEST

- Banknoty

- ciało

- budować

- wybudowany

- biznes

- ale

- by

- CAN

- brezentowy

- Pojemność

- walizka

- zmiana

- Opłaty

- ZOBACZ

- Wybierając

- obywatel

- Chmura

- kod

- Kawa

- społeczność

- kompleksowość

- obliczać

- systemu

- konsumować

- przyczyniły

- stworzony

- Aktualny

- zwyczaj

- klient

- Rozwiązania dla klientów

- Klientów

- dane

- Departament

- rozwijać

- wdrażane

- wdrażanie

- Wdrożenie

- głębokość

- detale

- oprogramowania

- bezpośrednio

- omówione

- domena

- napęd

- czas trwania

- każdy

- łatwy

- eliminuje

- eliminując

- wschodzących

- nowe technologie

- Umożliwia

- Punkt końcowy

- Enterprise

- Środowisko

- oceniać

- wszyscy

- przykład

- kierownictwo

- oczekiwać

- doświadczenie

- eksport

- członków Twojej rodziny

- Korzyści

- pole

- następujący

- następujący sposób

- W razie zamówieenia projektu

- od

- pełny

- przyszłość

- Generować

- wygenerowane

- generatywny

- generatywna sztuczna inteligencja

- Dać

- Have

- mający

- he

- pomoc

- pomaga

- jej

- wysoko

- historyczny

- gospodarze

- W jaki sposób

- HTML

- HTTPS

- zidentyfikować

- importować

- ulepszony

- in

- obejmuje

- Zwiększać

- osób

- Informacja

- wkład

- spostrzeżenia

- przykład

- instrukcje

- interaktywne

- Interfejs

- najnowszych

- IT

- JEGO

- podróż

- jpg

- Kumar

- uruchomić

- lider

- nauka

- Linia

- Lista

- zalogowaniu

- maszyna

- uczenie maszynowe

- robić

- WYKONUJE

- Dokonywanie

- zarządzanie

- i konserwacjami

- kierownik

- ręcznie

- Marketing

- wzmiankowany

- spełnione

- Metryka

- ML

- Aplikacje mobilne

- telefon komórkowy

- model

- modele

- jeszcze

- ruch

- musi

- Nazwa

- Nawigacja

- niezbędny

- Potrzebować

- wymagania

- Nowości

- Nie

- notatnik

- już dziś

- numer

- cel

- of

- on

- operator

- organizacji

- oryginalny

- ludzkiej,

- na zewnątrz

- zewnętrzne

- koniec

- własny

- strona

- pandy

- dla

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- uprawnienia

- telefon

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- populacja

- Post

- potencjał

- przepowiednia

- Przewidywania

- warunki wstępne

- problemy

- wygląda tak

- Produkt

- product manager

- Produkcja

- pod warunkiem,

- zaopatrzenie

- Qi

- Szybki

- szybko

- w czasie rzeczywistym

- polecić

- zmniejszyć

- redukcja

- odnosić się

- Usunięto

- obsługi produkcji rolnej, która zastąpiła

- Zasoby

- odpowiedź

- przeglądu

- Ryzyko

- Rola

- run

- sagemaker

- Wnioskowanie SageMakera

- oszczędność

- Naukowcy

- wynik

- Sean

- senior

- Usługi

- Sesja

- ona

- powinien

- pokazał

- pojedynczy

- So

- Rozwiązania

- Źródła

- specjalista

- Spędzanie

- standard

- początek

- Startowy

- Stan

- przebywający

- Cel

- opływowy

- studio

- Z powodzeniem

- Utrzymany

- podpory

- pewnie

- SYS

- Brać

- zespół

- Techniczny

- Technologies

- test

- Podziękowania

- że

- Połączenia

- ich

- a tym samym

- Te

- to

- trzy

- Przez

- czas

- do

- przeszkolony

- Transformacja

- rodzaj

- wyjątkowy

- posługiwać się

- przypadek użycia

- Użytkownik

- Interfejs użytkownika

- za pomocą

- Wartości

- wersja

- Wersje

- spacer

- solucja

- chcieć

- we

- sieć

- usługi internetowe

- DOBRZE

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- KIM

- będzie

- w

- w ciągu

- bez

- workflow

- pracujący

- napisać

- pisać kod

- pisanie

- lat

- tak

- You

- Twój

- zefirnet