Dane zmieniają każdą dziedzinę i każdą firmę. Jednak ze względu na to, że dane rosną szybciej, niż większość firm jest w stanie śledzić, gromadzenie danych i czerpanie z nich wartości jest trudnym zadaniem. A nowoczesna strategia danych może pomóc w osiąganiu lepszych wyników biznesowych dzięki danym. AWS zapewnia najbardziej kompletny zestaw usług dla podróż danych od końca do końca Ci pomóc odblokować wartość ze swoich danych i przekształć to w zrozumienie.

Analitycy danych mogą poświęcić do 80% swojego czasu na przygotowywanie danych do projektów uczenia maszynowego (ML). Ten proces przygotowawczy jest w dużej mierze niezróżnicowaną i żmudną pracą i może obejmować wiele programistycznych interfejsów API i niestandardowych bibliotek. Pogromca danych Amazon SageMaker pomaga naukowcom danych i inżynierom danych uprościć i przyspieszyć przygotowywanie danych tabelarycznych i szeregów czasowych oraz inżynierię funkcji za pośrednictwem interfejsu wizualnego. Możesz importować dane z wielu źródeł danych, takich jak Usługa Amazon Simple Storage (Amazonka S3), Amazonka Atena, Amazonka Przesunięcie ku czerwieni, a nawet rozwiązań innych firm, takich jak Snowflake or DataBricki przetwarzaj dane za pomocą ponad 300 wbudowanych przekształceń danych i biblioteki fragmentów kodu, dzięki czemu możesz szybko normalizować, przekształcać i łączyć funkcje bez konieczności pisania kodu. Możesz także wprowadzić własne transformacje w programach PySpark, SQL lub Pandas.

W tym poście pokazano, jak zaplanować automatyczne uruchamianie zadań przygotowywania danych. Badamy również nową funkcję Data Wrangler dotyczącą sparametryzowanych zestawów danych, która umożliwia określenie plików, które mają zostać uwzględnione w przepływie danych za pomocą sparametryzowanych identyfikatorów URI.

Omówienie rozwiązania

Data Wrangler obsługuje teraz importowanie danych przy użyciu sparametryzowanego identyfikatora URI. Pozwala to na większą elastyczność, ponieważ można teraz importować wszystkie zestawy danych pasujące do określonych parametrów, które mogą być typu String, Number, Datetime i Pattern w identyfikatorze URI. Ponadto możesz teraz uruchamiać zadania transformacji Data Wrangler zgodnie z harmonogramem.

W tym poście tworzymy przykładowy przepływ z zestawem danych Titanic, aby pokazać, jak możesz rozpocząć eksperymentowanie z tymi dwiema nowymi funkcjami Data Wranglera. Aby pobrać zestaw danych, patrz Titanic – uczenie maszynowe z katastrofy.

Wymagania wstępne

Aby uzyskać wszystkie funkcje opisane w tym poście, musisz mieć najnowszą wersję jądra Data Wranglera. Aby uzyskać więcej informacji, patrz Zaktualizuj Data Wranglera. Poza tym musisz biegać Studio Amazon SageMaker JupyterLab 3. Aby wyświetlić aktualną wersję i zaktualizować ją, patrz Wersjonowanie JupyterLab.

Struktura pliku

W tej demonstracji postępujemy zgodnie z prostą strukturą plików, którą musisz powielić, aby odtworzyć kroki opisane w tym poście.

- w studiu, utwórz nowy notatnik.

- Uruchom następujący fragment kodu, aby utworzyć używaną przez nas strukturę folderów (upewnij się, że znajdujesz się w żądanym folderze w drzewie plików):

- Skopiuj

train.csvitest.csvpliki z oryginalnego zestawu danych Titanica do folderówtitanic_dataset/trainititanic_dataset/test, Odpowiednio. - Uruchom następujący fragment kodu, aby wypełnić foldery niezbędnymi plikami:

Podzieliliśmy się train.csv plik zestawu danych Titanica na dziewięć różnych plików o nazwach part_x, gdzie x to numer części. Część 0 zawiera 100 pierwszych rekordów, część 1 kolejnych 100 i tak dalej, aż do części 8. Każdy folder węzła drzewa plików zawiera kopię dziewięciu części danych uczących, z wyjątkiem train i test foldery, które zawierają train.csv i test.csv.

Sparametryzowane zestawy danych

Użytkownicy Data Wrangler mogą teraz określać parametry zestawów danych importowanych z Amazon S3. Parametry zestawu danych są określone w identyfikatorze URI zasobów, a jego wartość można zmieniać dynamicznie, co pozwala na większą elastyczność w wyborze plików, które chcemy zaimportować. Parametry mogą mieć cztery typy danych:

- Numer – Może przyjąć dowolną liczbę całkowitą

- sznur – Może przyjąć wartość dowolnego ciągu tekstowego

- Wzór – Może przyjąć wartość dowolnego wyrażenia regularnego

- Datetime – Może przyjąć wartość dowolnego obsługiwanego formatu daty/czasu

W tej sekcji przedstawiamy przewodnik po tej nowej funkcji. Ta opcja jest dostępna tylko po zaimportowaniu zestawu danych do bieżącego przepływu i tylko w przypadku zestawów danych zaimportowanych z usługi Amazon S3.

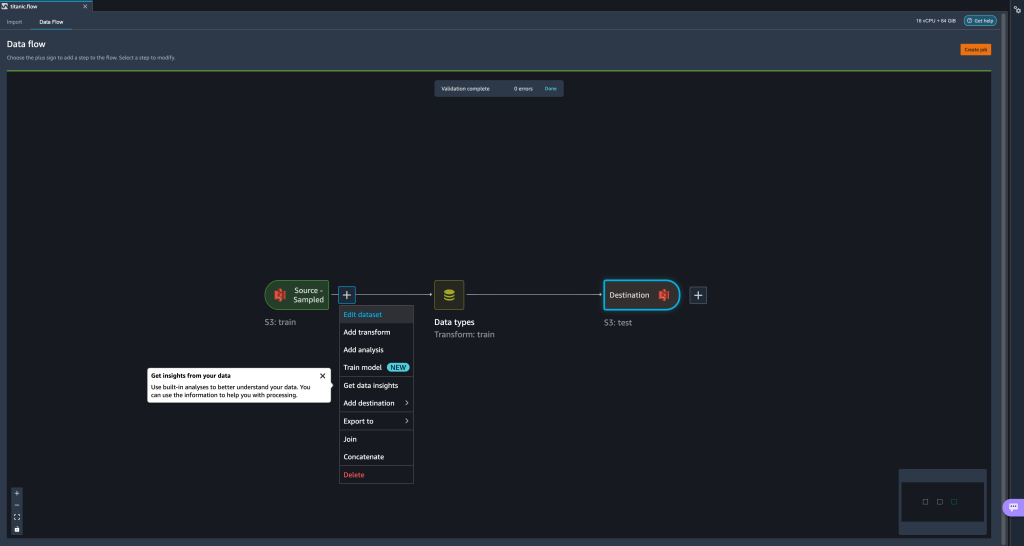

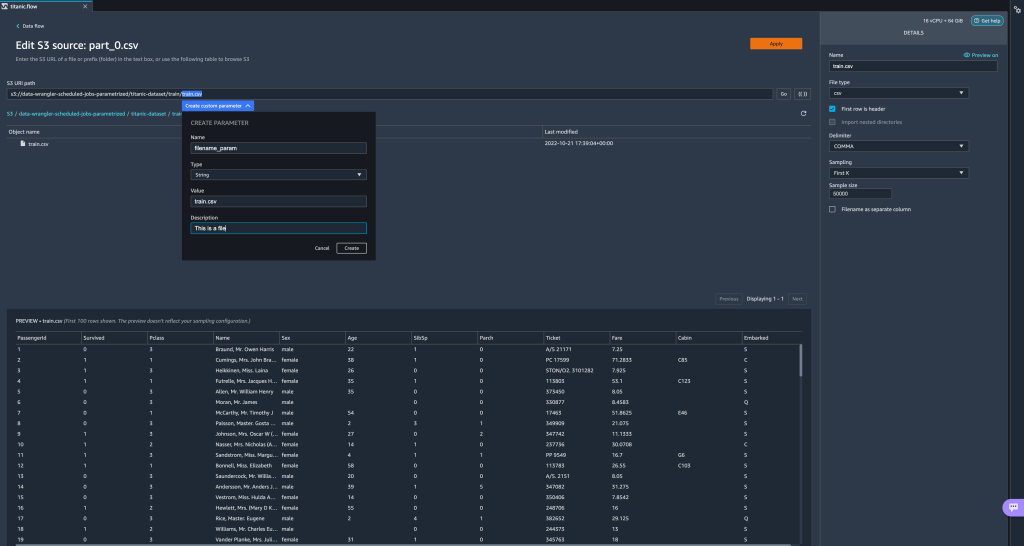

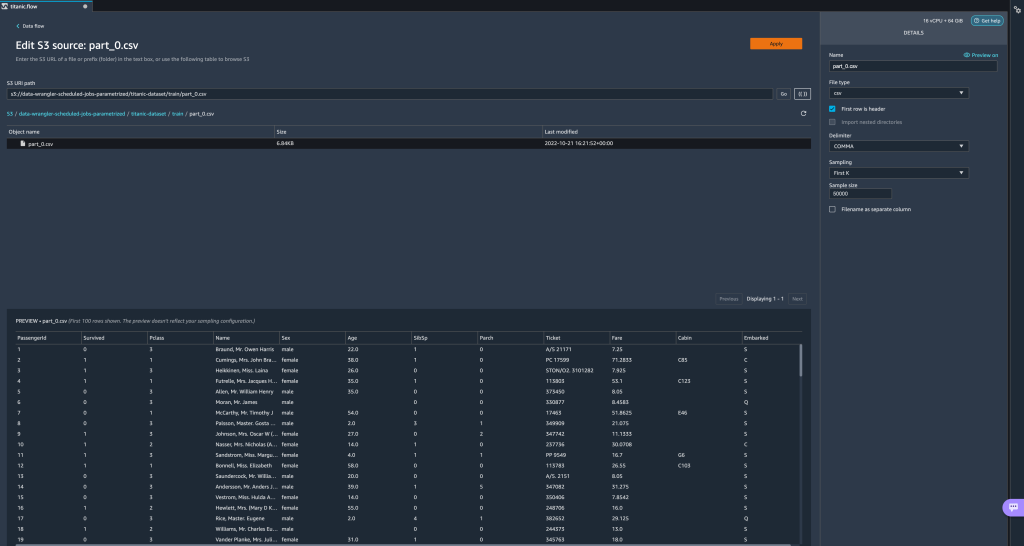

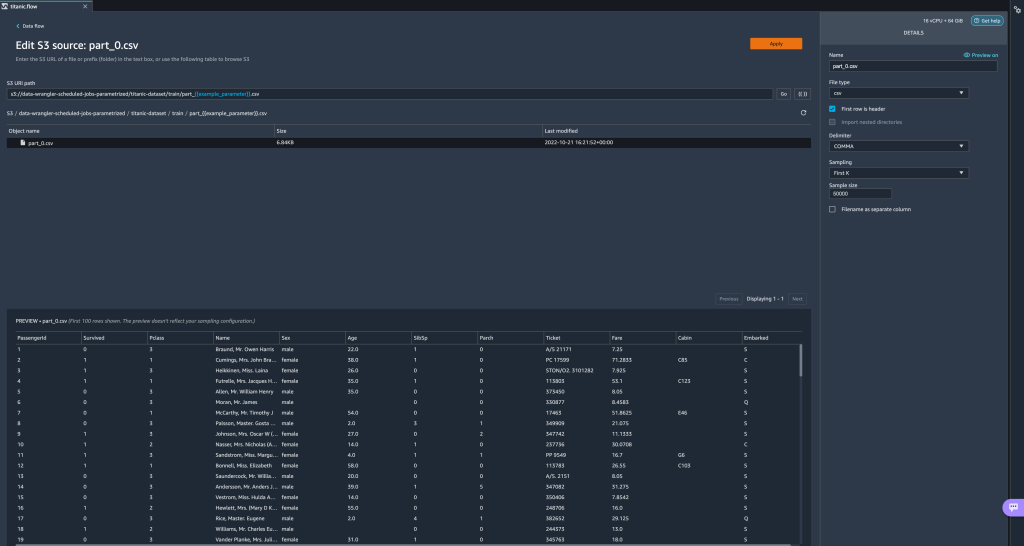

- W swoim przepływie danych wybierz znak plus (+) obok kroku importu i wybierz Edytuj zbiór danych.

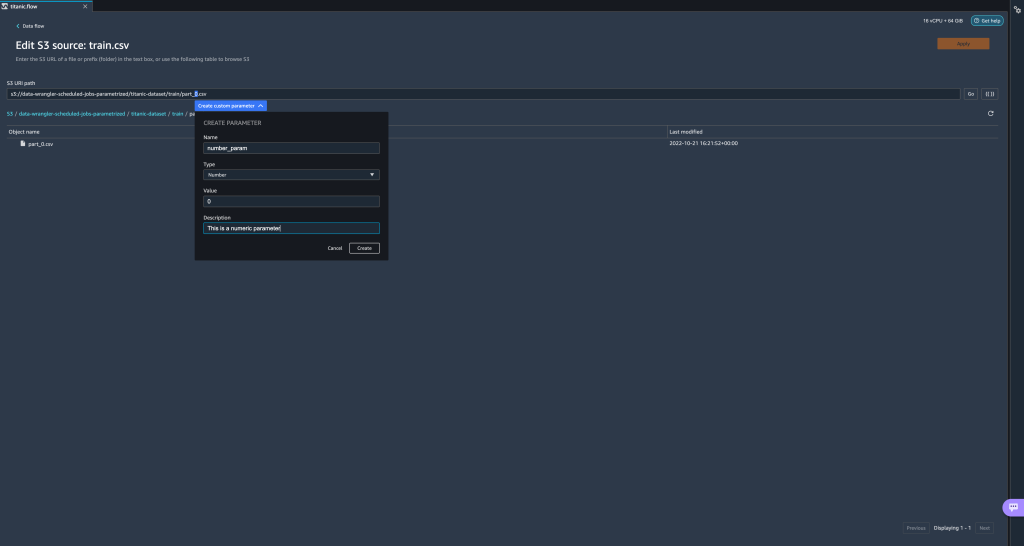

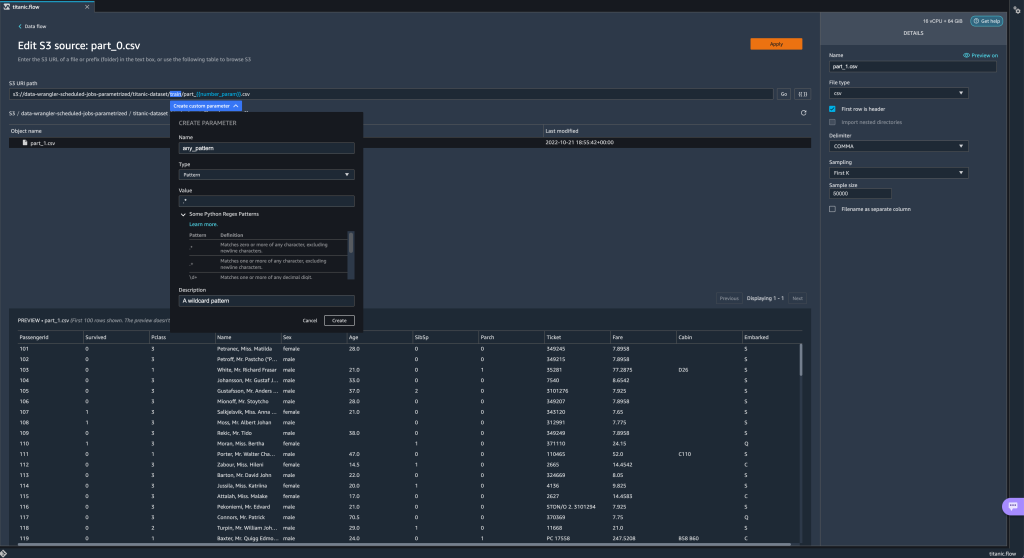

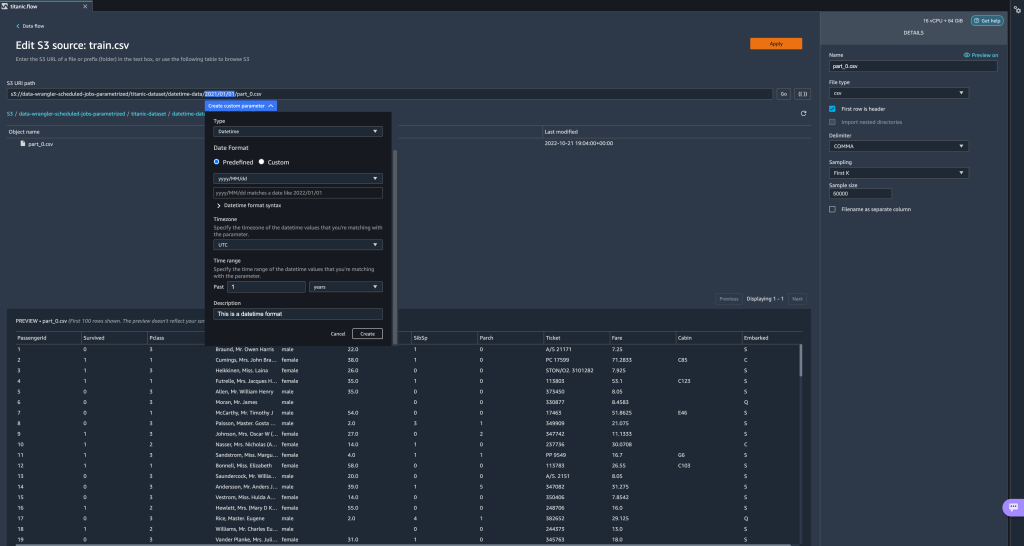

- Preferowaną (i najłatwiejszą) metodą tworzenia nowych parametrów jest zaznaczenie sekcji URI i wybranie Utwórz parametr niestandardowy w rozwijanym menu. Musisz określić cztery rzeczy dla każdego parametru, który chcesz utworzyć:

- Imię

- Rodzaj Nieruchomości

- Domyślna wartość

- Opis

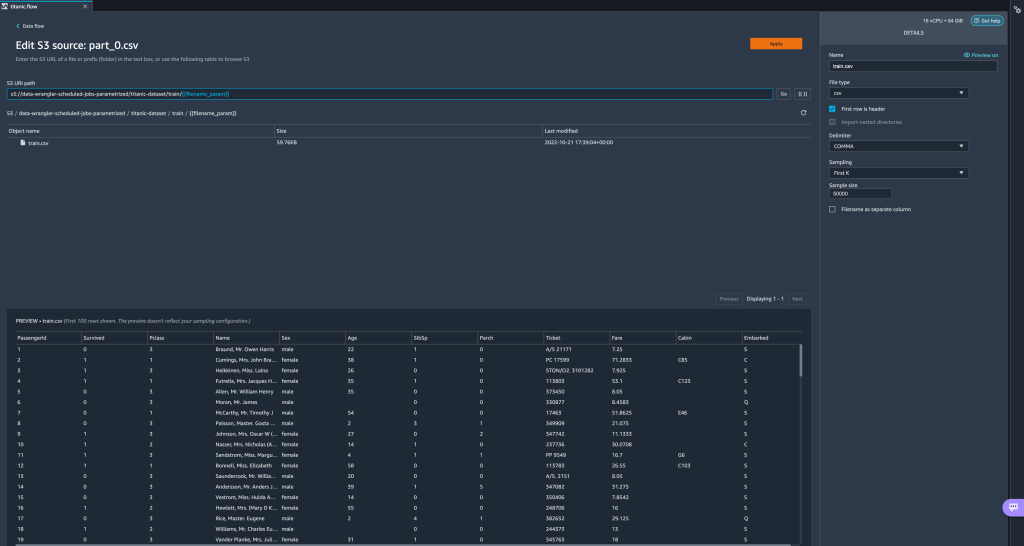

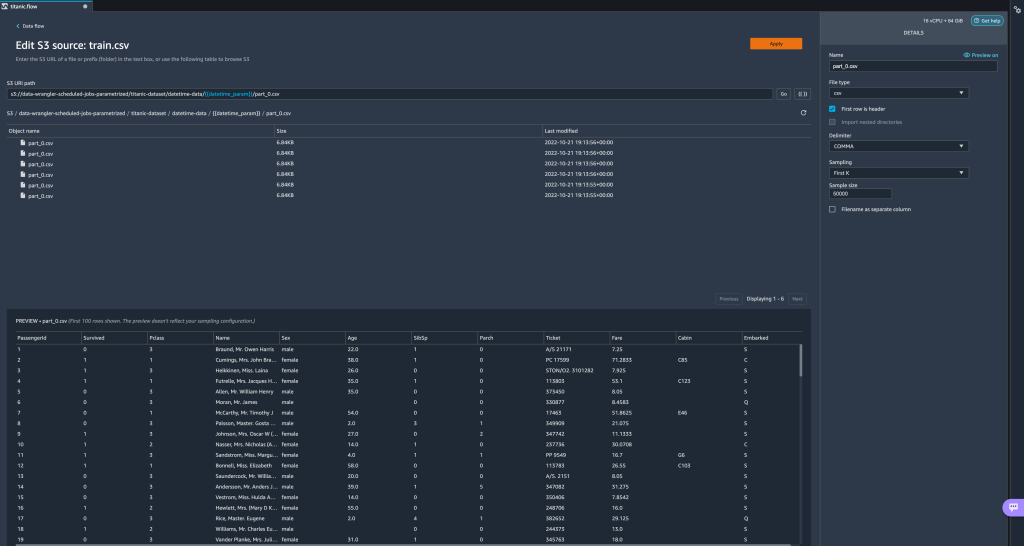

Tutaj stworzyliśmy parametr typu String o nazwiefilename_paramz domyślną wartościątrain.csv. Teraz możesz zobaczyć nazwę parametru ujętą w podwójne nawiasy kwadratowe, zastępując część identyfikatora URI, którą wcześniej wyróżniliśmy. Ponieważ zdefiniowana wartość dla tego parametru byłatrain.csv, teraz widzimy pliktrain.csvwymienione w tabeli importu.

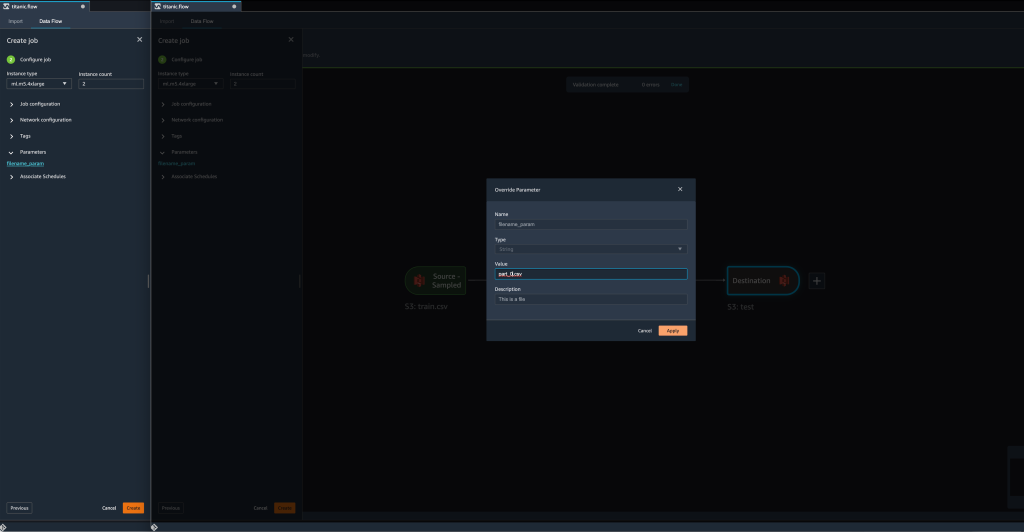

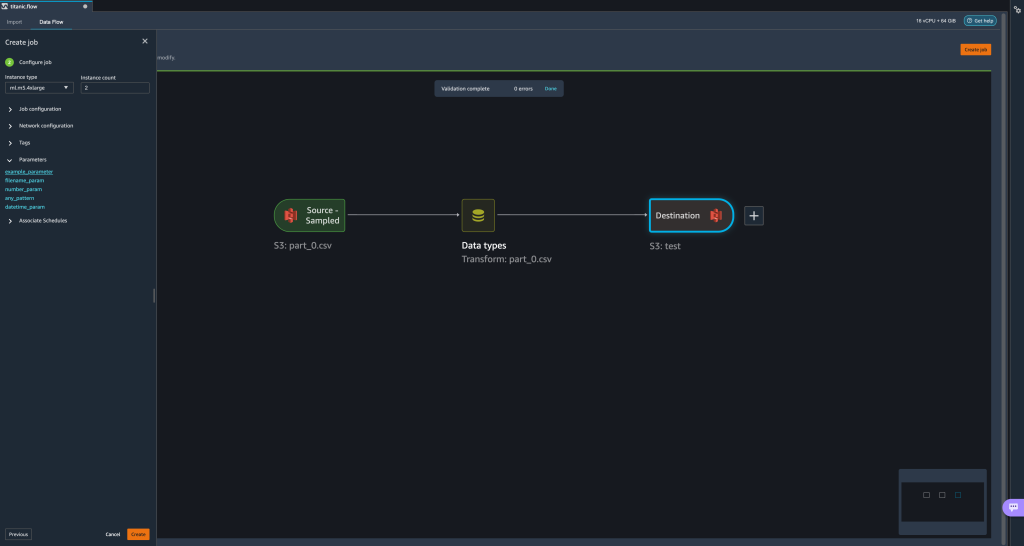

- Kiedy próbujemy utworzyć zadanie transformacji, na Skonfiguruj zadanie krok, teraz widzimy a parametry sekcji, w której możemy zobaczyć listę wszystkich zdefiniowanych przez nas parametrów.

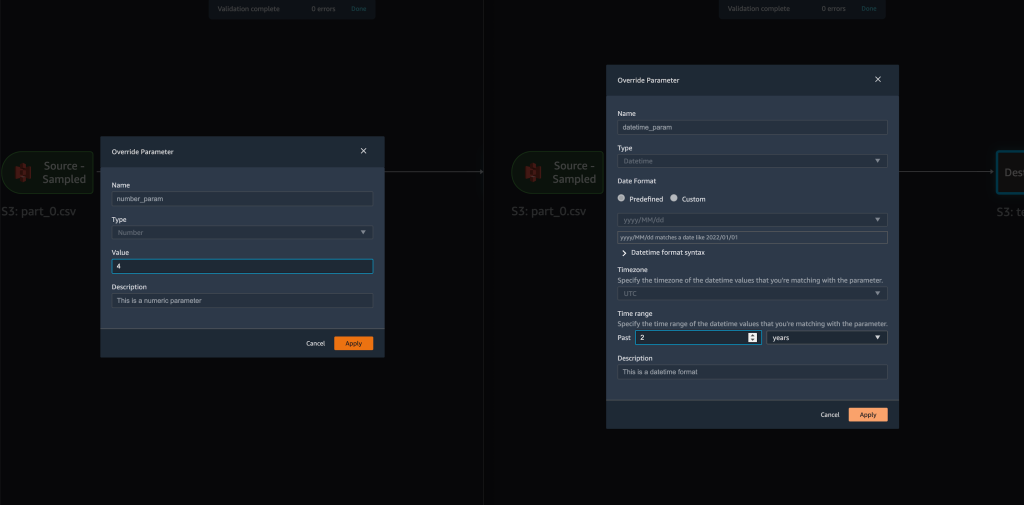

- Wybór parametru daje nam możliwość zmiany wartości parametru, w tym przypadku zmiany wejściowego zbioru danych, który ma zostać przekształcony zgodnie ze zdefiniowanym przepływem.

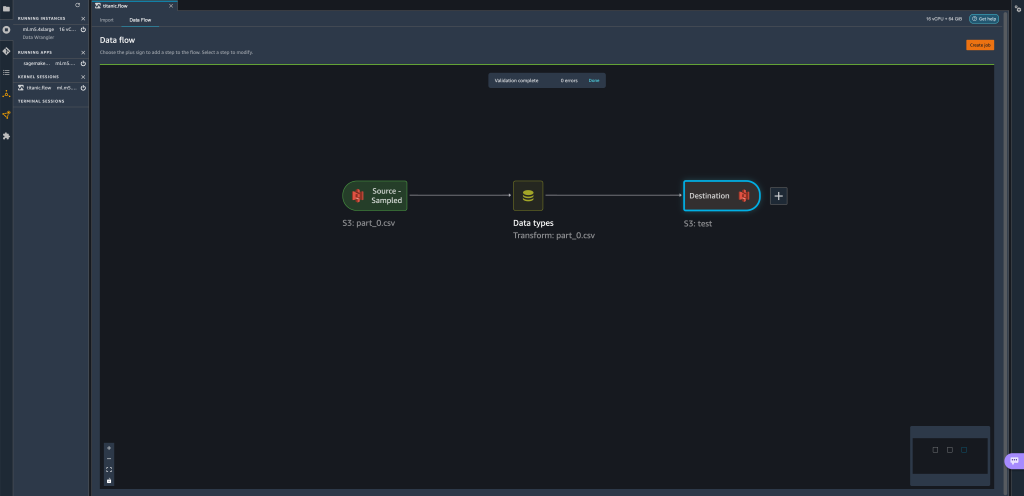

Zakładając, że zmienimy wartośćfilename_paramodtrain.csvdopart_0.csv, teraz trwa zadanie transformacjipart_0.csv(pod warunkiem, że plik o nazwiepart_0.csvistnieje w tym samym folderze) co nowe dane wejściowe.

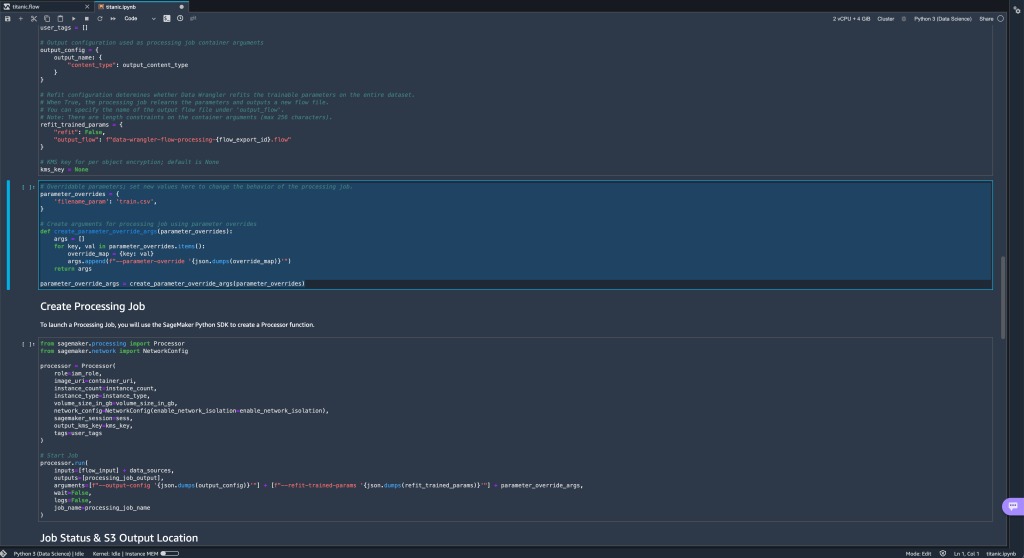

- Ponadto, jeśli spróbujesz wyeksportować swój przepływ do miejsca docelowego Amazon S3 (za pośrednictwem notatnika Jupyter), zobaczysz teraz nową komórkę zawierającą zdefiniowane parametry.

Zauważ, że parametr przyjmuje wartość domyślną, ale możesz ją zmienić, zastępując jego wartość w plikuparameter_overridessłownika (pozostawiając klucze słownika bez zmian).

Dodatkowo możesz tworzyć nowe parametry z pliku parametry UI. - Otwórz go, wybierając ikonę parametrów ({{}}) znajdujący się obok Go opcja; oba znajdują się obok wartości ścieżki URI.

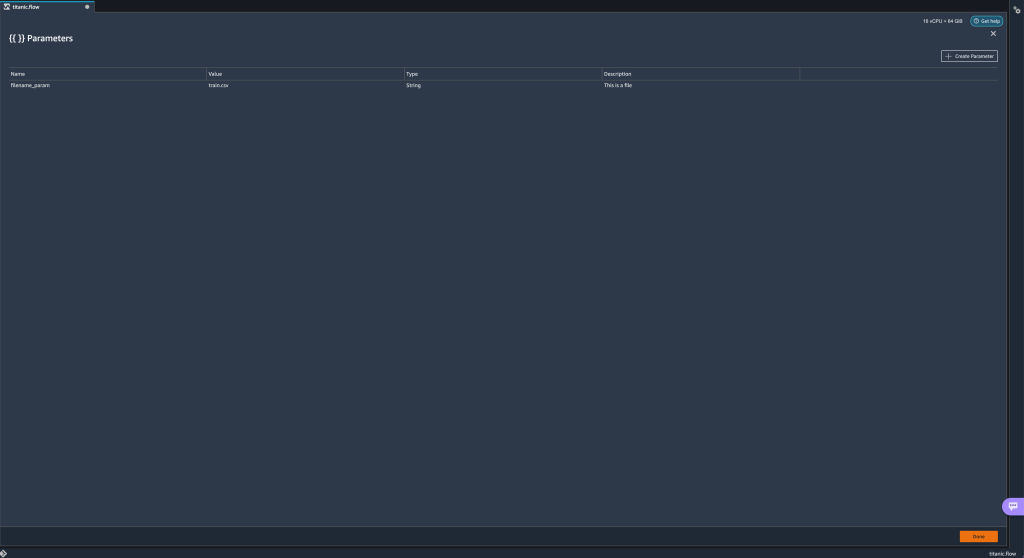

Zostanie otwarta tabela ze wszystkimi parametrami, które obecnie istnieją w pliku przepływu (

Zostanie otwarta tabela ze wszystkimi parametrami, które obecnie istnieją w pliku przepływu (filename_paramw tym momencie). - Możesz utworzyć nowe parametry dla swojego przepływu, wybierając Utwórz parametr.

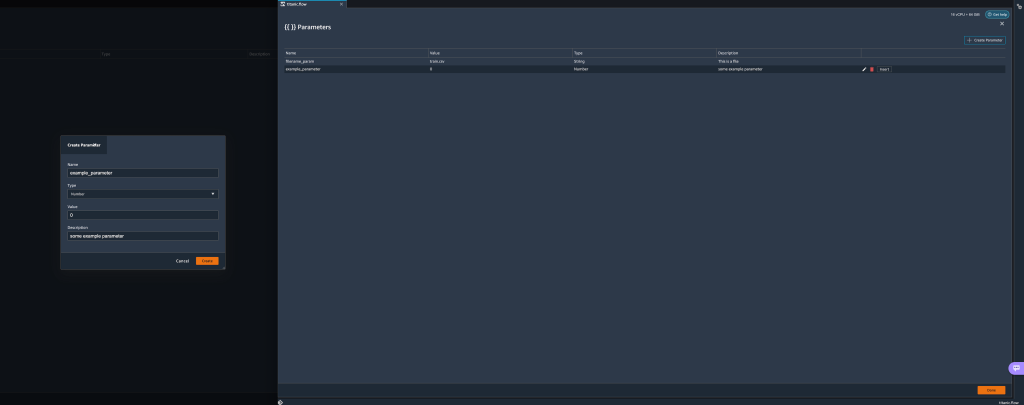

Otworzy się wyskakujące okienko, w którym możesz utworzyć nowy parametr niestandardowy. - Tutaj stworzyliśmy nowy

example_parameterjako typ liczbowy z domyślną wartością 0. Ten nowo utworzony parametr jest teraz wymieniony w parametry stół. Najechanie kursorem na parametr wyświetla opcje Edytuj, Usuń, wstawka.

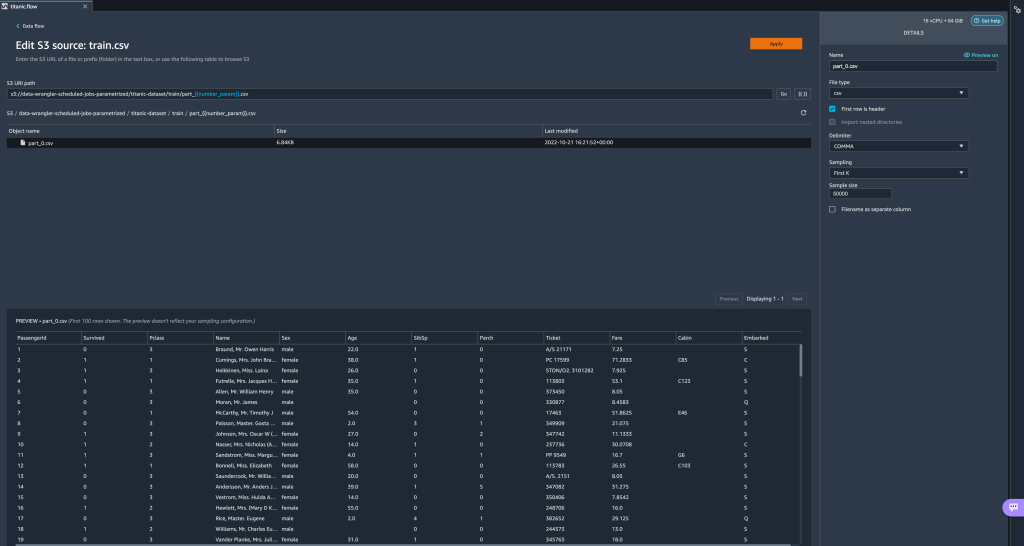

- Od wewnątrz parametry UI możesz wstawić jeden ze swoich parametrów do identyfikatora URI, wybierając żądany parametr i wybierając wstawka.

Spowoduje to dodanie parametru na końcu identyfikatora URI. Musisz przenieść go do żądanej sekcji w swoim identyfikatorze URI.

- Zmień domyślną wartość parametru, zastosuj zmianę (z modalu), wybierz Goi wybierz ikonę odświeżania, aby zaktualizować listę podglądu przy użyciu wybranego zestawu danych na podstawie wartości nowo zdefiniowanego parametru.

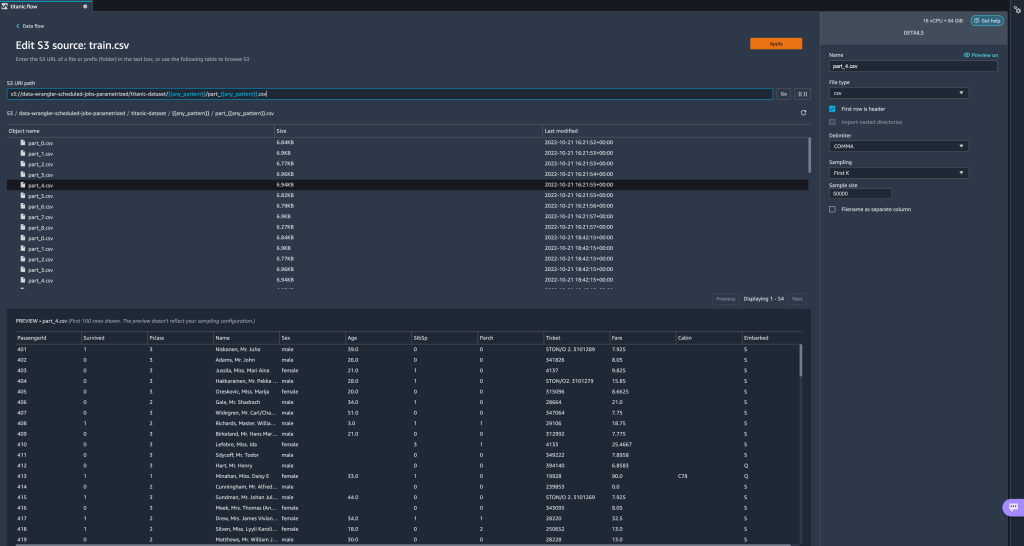

Przyjrzyjmy się teraz innym typom parametrów. Załóżmy, że mamy teraz zbiór danych podzielony na wiele części, gdzie każdy plik ma numer części.

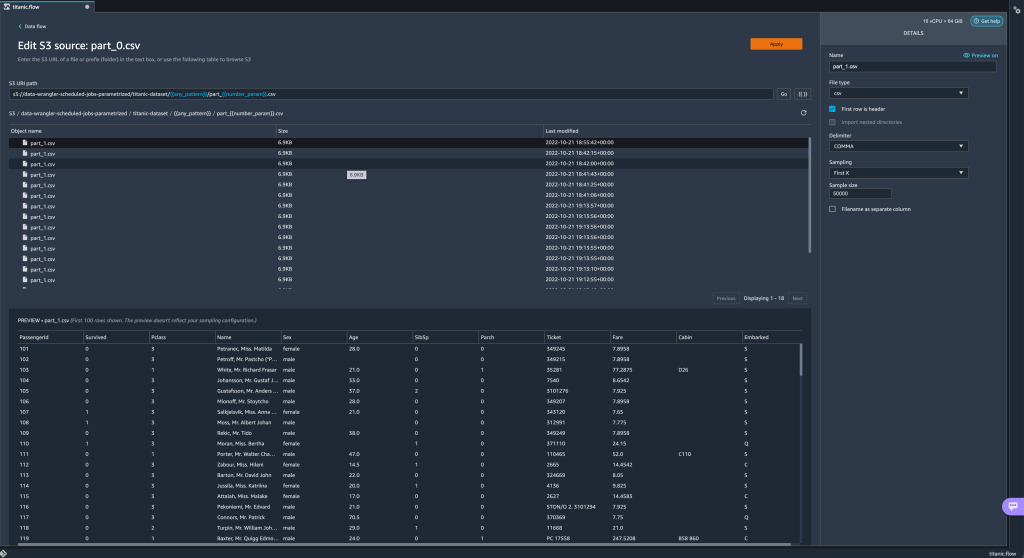

Przyjrzyjmy się teraz innym typom parametrów. Załóżmy, że mamy teraz zbiór danych podzielony na wiele części, gdzie każdy plik ma numer części. - Jeśli chcemy dynamicznie zmieniać numer pliku, możemy zdefiniować parametr Number, jak pokazano na poniższym zrzucie ekranu.

Zwróć uwagę, że wybrany plik jest tym, który odpowiada numerowi określonemu w parametrze.

Zwróć uwagę, że wybrany plik jest tym, który odpowiada numerowi określonemu w parametrze. Teraz zademonstrujmy, jak używać parametru wzorca. Załóżmy, że chcemy zaimportować wszystkie pliki

Teraz zademonstrujmy, jak używać parametru wzorca. Załóżmy, że chcemy zaimportować wszystkie pliki part_1.csvpliki we wszystkich folderach wtitanic-dataset/teczka. Parametry wzorca mogą przyjmować dowolne prawidłowe wyrażenie regularne; istnieje kilka wzorców wyrażeń regularnych pokazanych jako przykłady. - Utwórz parametr wzorca o nazwie

any_patternaby dopasować dowolny folder lub plik wtitanic-dataset/folder z wartością domyślną.*.Zauważ, że symbol wieloznaczny to nie pojedynczy * (gwiazdka), ale także kropka. - Podkreśl

titanic-dataset/część ścieżki i utworzyć parametr niestandardowy. Tym razem wybieramy tzw Wzór rodzaj. Ten wzorzec wybiera wszystkie wywoływane pliki

Ten wzorzec wybiera wszystkie wywoływane pliki part-1.csvz dowolnego folderu poniżejtitanic-dataset/. Parametr może być użyty więcej niż raz w ścieżce. W poniższym przykładzie używamy naszego nowo utworzonego parametru

Parametr może być użyty więcej niż raz w ścieżce. W poniższym przykładzie używamy naszego nowo utworzonego parametru any_patterndwukrotnie w naszym identyfikatorze URI, aby dopasować dowolny plik części w dowolnym folderze poniżejtitanic-dataset/. Na koniec utwórzmy parametr Datetime. Parametry DateTime są przydatne, gdy mamy do czynienia ze ścieżkami podzielonymi według daty i godziny, takimi jak te generowane przez Wąż strażacki Amazon Kinesis Data (Patrz Dynamiczne partycjonowanie w Kinesis Data Firehose). W tej demonstracji używamy danych z folderu datetime-data.

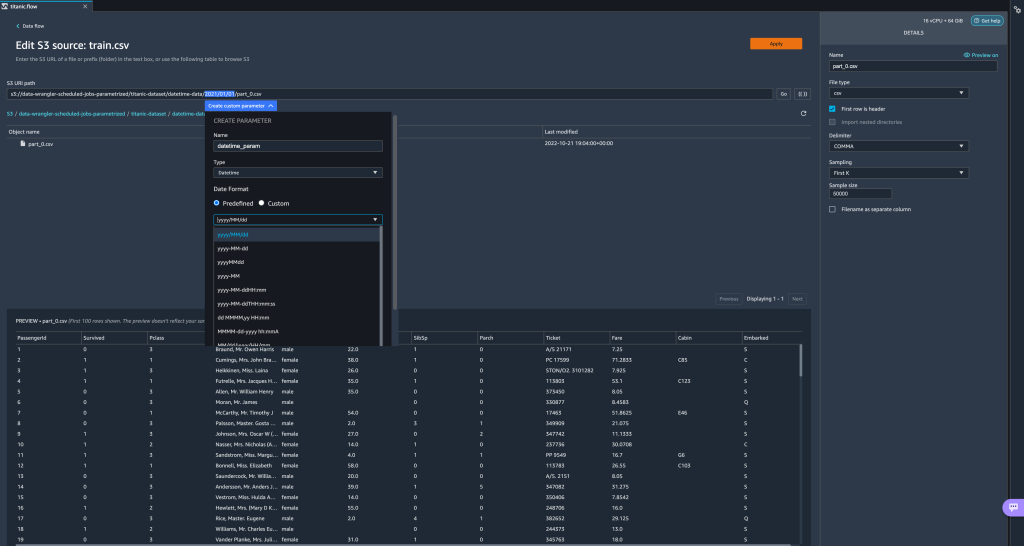

Na koniec utwórzmy parametr Datetime. Parametry DateTime są przydatne, gdy mamy do czynienia ze ścieżkami podzielonymi według daty i godziny, takimi jak te generowane przez Wąż strażacki Amazon Kinesis Data (Patrz Dynamiczne partycjonowanie w Kinesis Data Firehose). W tej demonstracji używamy danych z folderu datetime-data. - Wybierz część ścieżki, która jest datą/godziną i utwórz parametr niestandardowy. Wybierz Datetime typ parametru.

Wybierając typ danych Datetime, należy podać więcej szczegółów. - Przede wszystkim musisz podać format daty. Możesz wybrać dowolny z predefiniowanych formatów daty/godziny lub utworzyć własny.

W przypadku predefiniowanych formatów daty/godziny legenda zawiera przykład daty pasującej do wybranego formatu. Do tej demonstracji wybieramy format rrrr/MM/dd.

- Następnie określ strefę czasową dla wartości daty/godziny.

Na przykład bieżącą datą może być 1 stycznia 2022 r. w jednej strefie czasowej, ale może to być 2 stycznia 2022 r. w innej strefie czasowej. - Na koniec możesz wybrać zakres czasu, który pozwala wybrać zakres plików, które chcesz uwzględnić w przepływie danych.

Możesz określić zakres czasu w godzinach, dniach, tygodniach, miesiącach lub latach. W tym przykładzie chcemy pobrać wszystkie pliki z ostatniego roku. - Podaj opis parametru i wybierz Stwórz.

Jeśli używasz wielu zestawów danych z różnymi strefami czasowymi, czas nie jest konwertowany automatycznie; musisz wstępnie przetworzyć każdy plik lub źródło, aby przekonwertować je na jedną strefę czasową. Wybrane pliki to wszystkie pliki znajdujące się w folderach odpowiadających danym z zeszłego roku.

Wybrane pliki to wszystkie pliki znajdujące się w folderach odpowiadających danym z zeszłego roku.

- Teraz, jeśli utworzymy zadanie transformacji danych, możemy zobaczyć listę wszystkich zdefiniowanych przez nas parametrów i możemy zastąpić ich wartości domyślne, aby nasze zadania transformacji wybrały określone pliki.

Zaplanuj zadania przetwarzania

Możesz teraz zaplanować zadania przetwarzania, aby zautomatyzować uruchamianie zadań transformacji danych i eksportowanie przekształconych danych do Amazon S3 lub Sklep funkcji Amazon SageMaker. Możesz zaplanować zadania z czasem i częstotliwością, które odpowiadają Twoim potrzebom.

Wykorzystanie zaplanowanych zadań przetwarzania Most zdarzeń Amazona reguły aby zaplanować przebieg zadania. Dlatego, jako warunek wstępny, musisz upewnić się, że AWS Zarządzanie tożsamością i dostępem (IAM) rola używana przez Data Wrangler, a mianowicie Amazon Sage Maker rola wykonawcza instancji Studio ma uprawnienia do tworzenia reguł EventBridge.

Skonfiguruj uprawnienia

Kontynuuj następujące aktualizacje roli wykonawczej IAM SageMaker odpowiadającej instancji Studio, w której działa przepływ Data Wrangler:

- Dołącz AmazonEventBridgeFullAccess zarządzana polityka.

- Dołącz zasady, aby udzielić pozwolenia na utworzenie zadania przetwarzania:

- Przyznaj EventBridge uprawnienie do przyjęcia roli, dodając następujące zasady zaufania:

Alternatywnie, jeśli używasz innej roli do uruchamiania zadania przetwarzania, zastosuj zasady opisane w krokach 2 i 3 do tej roli. Aby uzyskać szczegółowe informacje na temat konfiguracji IAM, patrz Utwórz harmonogram automatycznego przetwarzania nowych danych.

Utwórz harmonogram

Aby utworzyć harmonogram, otwórz swój przepływ w edytorze przepływu Data Wrangler.

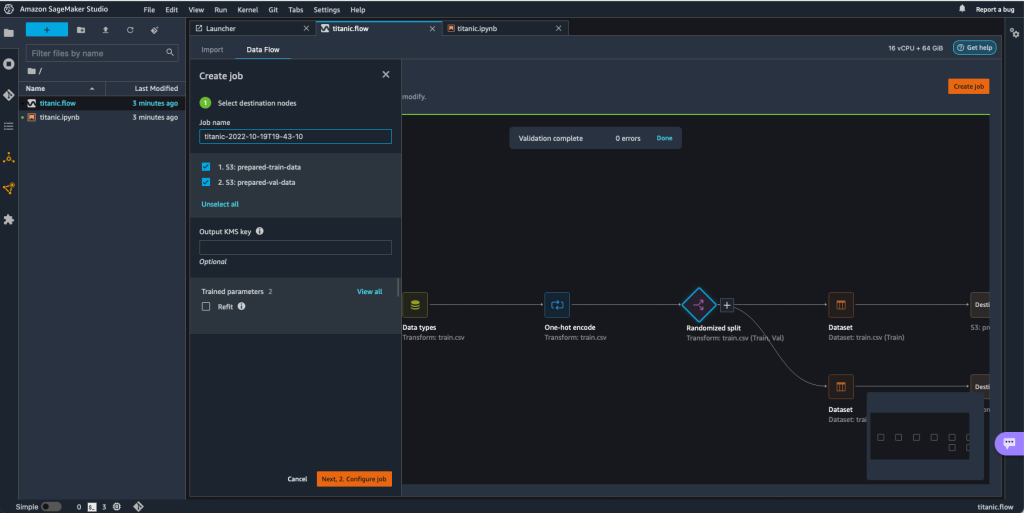

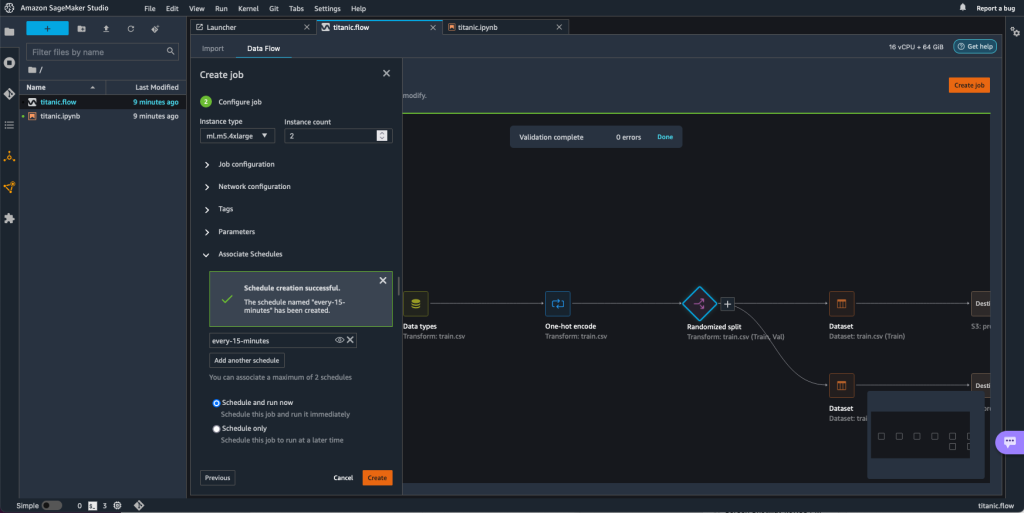

- Na Przepływ danych kartę, wybierz Utwórz pracę.

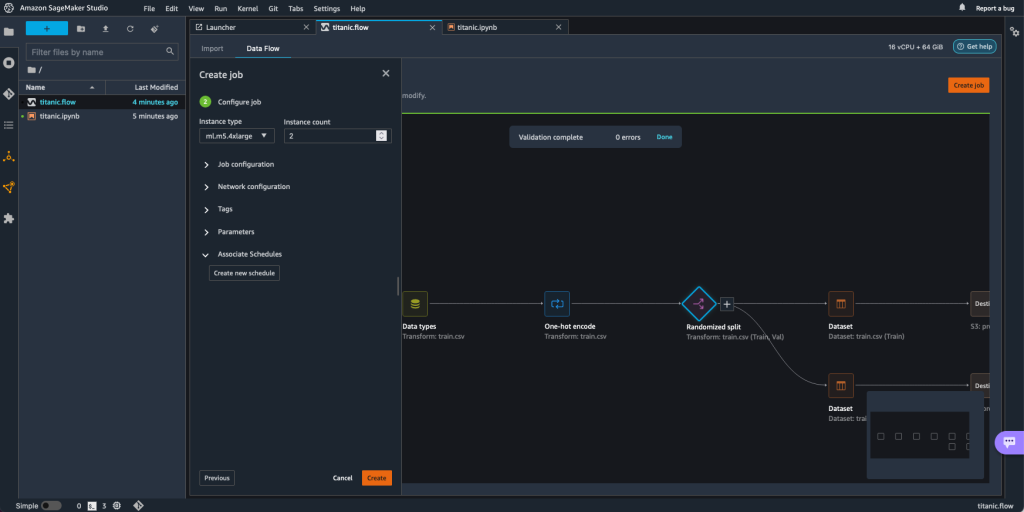

- Skonfiguruj wymagane pola i wybierz Następnie 2. Skonfiguruj zadanie.

- Rozszerzać Harmonogramy stowarzyszeń.

- Dodaj Utwórz nowy harmonogram.

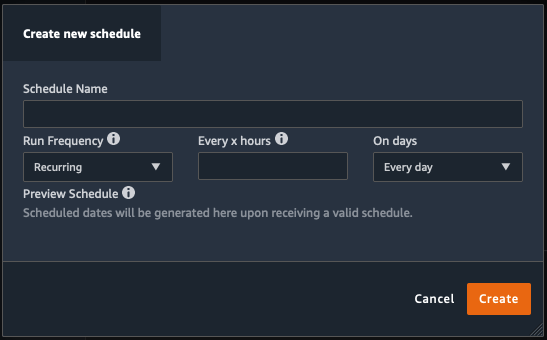

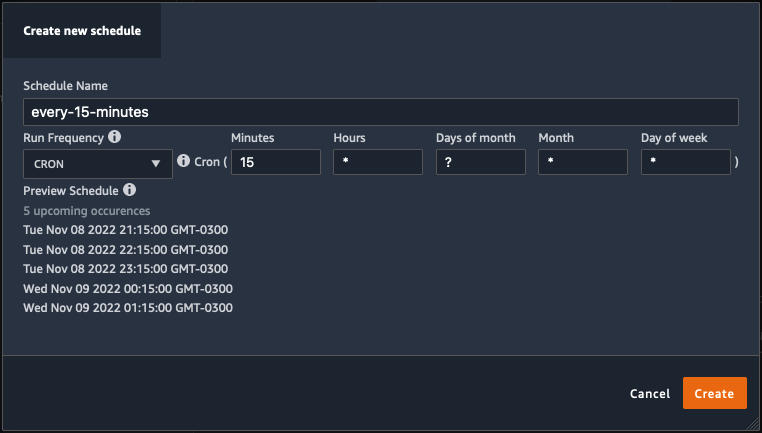

Połączenia Utwórz nowy harmonogram otworzy się okno dialogowe, w którym definiujesz szczegóły harmonogramu zadań przetwarzania.

Okno dialogowe oferuje dużą elastyczność, aby pomóc w zdefiniowaniu harmonogramu. Możesz na przykład uruchomić zadanie przetwarzania o określonej godzinie lub co X godzin w określone dni tygodnia.

Okresowość może być granularna do poziomu minut.

- Zdefiniuj nazwę harmonogramu i częstotliwość, a następnie wybierz Stwórz aby zapisać harmonogram.

- Masz możliwość natychmiastowego rozpoczęcia przetwarzania zadania wraz z planowaniem, które uwzględnia przyszłe przebiegi, lub pozostawienia zadania do wykonania tylko zgodnie z harmonogramem.

- Można również zdefiniować dodatkowy harmonogram dla tego samego zadania przetwarzania.

- Aby zakończyć harmonogram zadania przetwarzania, wybierz Stwórz.

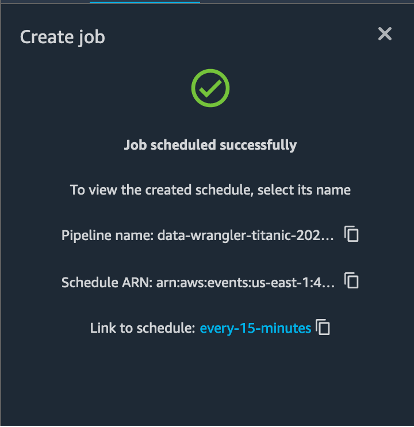

Zostanie wyświetlony komunikat „Zadanie zaplanowane pomyślnie”. Ponadto, jeśli zdecydujesz się pozostawić zadanie, aby działało tylko zgodnie z harmonogramem, zobaczysz link do właśnie utworzonej reguły EventBridge.

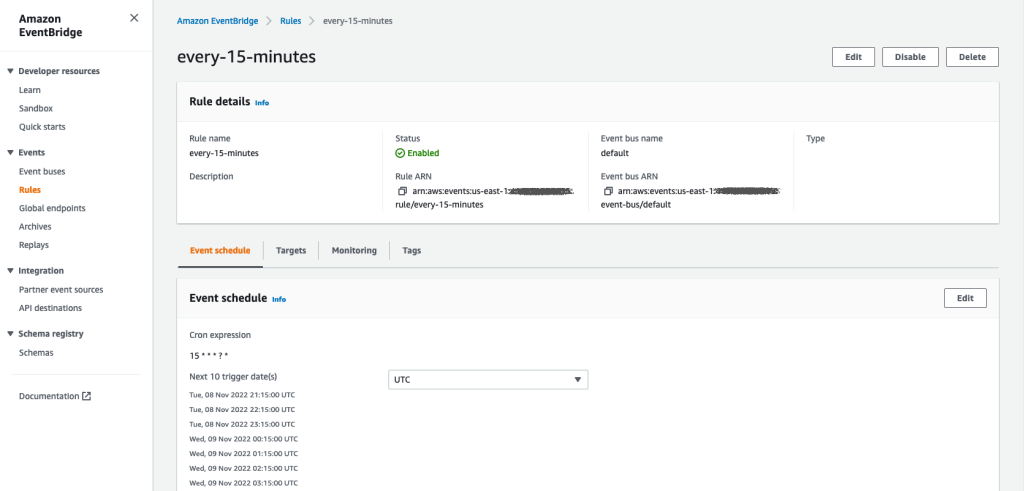

Jeśli wybierzesz link harmonogramu, otworzy się nowa karta w przeglądarce, pokazująca regułę EventBridge. Na tej stronie możesz wprowadzić dalsze modyfikacje reguły i śledzić historię jej wywołań. Aby zatrzymać uruchamianie zaplanowanego zadania przetwarzania, usuń regułę zdarzenia zawierającą nazwę harmonogramu.

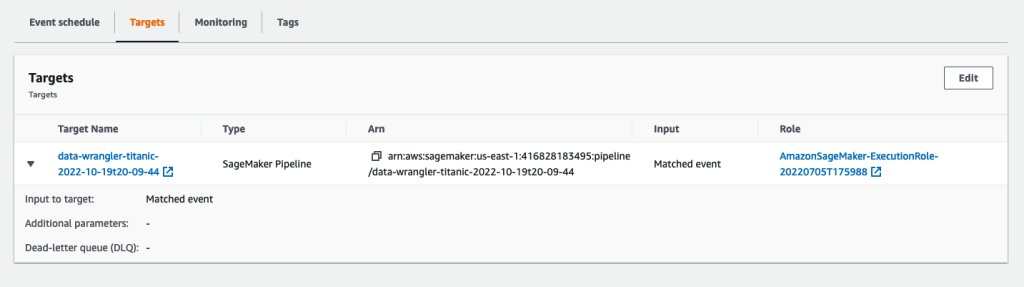

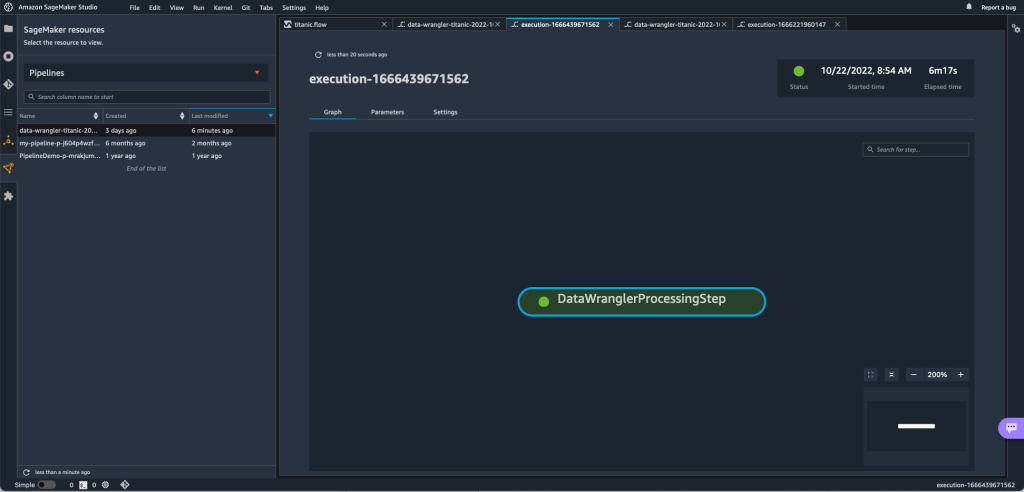

Reguła EventBridge jako swój cel wskazuje potok SageMaker, który jest uruchamiany zgodnie ze zdefiniowanym harmonogramem, a zadanie przetwarzania jest wywoływane jako część potoku.

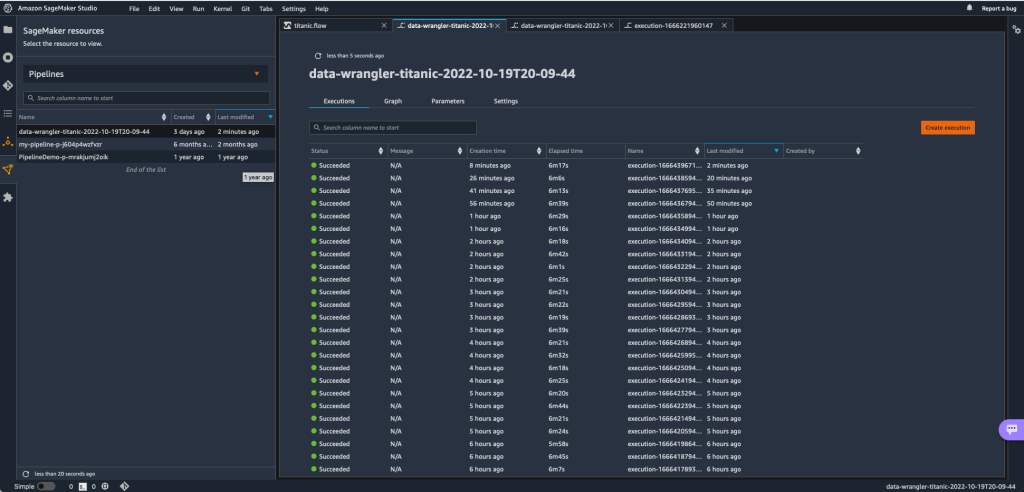

Aby śledzić przebiegi potoku SageMaker, możesz wrócić do Studio, wybrać plik Zasoby SageMaker ikona, wybierz Rurociągii wybierz nazwę potoku, który chcesz śledzić. Możesz teraz zobaczyć tabelę ze wszystkimi bieżącymi i przeszłymi uruchomieniami oraz stanem tego potoku.

Możesz zobaczyć więcej szczegółów, klikając dwukrotnie określony wpis.

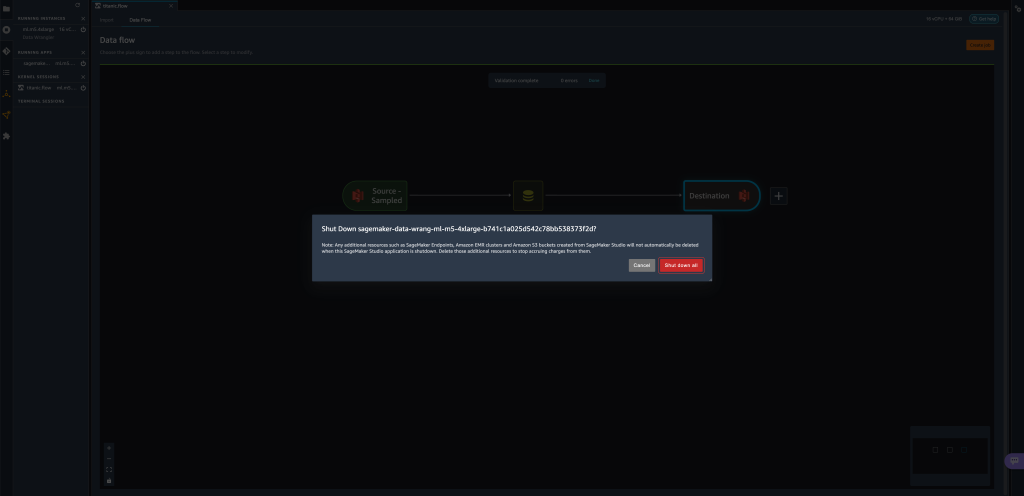

Sprzątać

Jeśli nie korzystasz z Data Wranglera, zalecamy zamknięcie instancji, na której działa, aby uniknąć ponoszenia dodatkowych opłat.

Aby uniknąć utraty pracy, zapisz przepływ danych przed wyłączeniem aplikacji Data Wrangler.

- Aby zapisać przepływ danych w Studio, wybierz filet, A następnie wybierz Zapisz przepływ danych Wranglera. Data Wrangler automatycznie zapisuje przepływ danych co 60 sekund.

- Aby zamknąć instancję Data Wrangler, w Studio wybierz Uruchomione instancje i jądra.

- Pod DZIAŁAJĄCE APLIKACJE, wybierz ikonę zamykania obok

sagemaker-data-wrangler-1.0app.

- Dodaj Wyłącz wszystko potwierdzać.

Data Wrangler działa na instancji ml.m5.4xlarge. Ta instancja znika z URUCHOMIONE INSTANCJE po zamknięciu aplikacji Data Wrangler.

Po zamknięciu aplikacji Data Wrangler musi ona zostać ponownie uruchomiona przy następnym otwarciu pliku przepływu Data Wrangler. Może to potrwać kilka minut.

Wnioski

W tym poście pokazaliśmy, jak można używać parametrów do importowania zestawów danych za pomocą przepływów Data Wrangler i tworzenia na nich zadań transformacji danych. Sparametryzowane zestawy danych zapewniają większą elastyczność używanych zestawów danych i umożliwiają ponowne użycie przepływów. Pokazaliśmy również, jak można skonfigurować zaplanowane zadania, aby zautomatyzować transformacje i eksport danych do Amazon S3 lub Feature Store, w czasie i z częstotliwością odpowiadającą Twoim potrzebom, bezpośrednio z poziomu interfejsu użytkownika Data Wrangler.

Aby dowiedzieć się więcej o korzystaniu z przepływów danych w Data Wrangler, zobacz Twórz i używaj przepływu danych Wrangler i Cennik Amazon SageMaker. Aby rozpocząć korzystanie z Data Wranglera, zobacz Przygotuj dane ML za pomocą Amazon SageMaker Data Wrangler.

O autorach

Dawid Laredo jest architektem prototypów w zespole prototypowania i inżynierii chmury w Amazon Web Services, gdzie pomógł opracować wiele prototypów uczenia maszynowego dla klientów AWS. Od 6 lat zajmuje się uczeniem maszynowym, szkoląc i dostrajając modele ML oraz wdrażając kompleksowe potoki do produkcji tych modeli. Jego obszary zainteresowań to NLP, aplikacje ML i end-to-end ML.

Dawid Laredo jest architektem prototypów w zespole prototypowania i inżynierii chmury w Amazon Web Services, gdzie pomógł opracować wiele prototypów uczenia maszynowego dla klientów AWS. Od 6 lat zajmuje się uczeniem maszynowym, szkoląc i dostrajając modele ML oraz wdrażając kompleksowe potoki do produkcji tych modeli. Jego obszary zainteresowań to NLP, aplikacje ML i end-to-end ML.

Givanildo Alvesa jest architektem prototypów w zespole prototypowania i inżynierii chmury w Amazon Web Services, pomagając klientom wprowadzać innowacje i przyspieszać, pokazując sztukę możliwości w AWS, mając już na swoim koncie kilka prototypów opartych na sztucznej inteligencji. Ma za sobą długą karierę w inżynierii oprogramowania, a wcześniej pracował jako inżynier rozwoju oprogramowania w Amazon.com.br.

Givanildo Alvesa jest architektem prototypów w zespole prototypowania i inżynierii chmury w Amazon Web Services, pomagając klientom wprowadzać innowacje i przyspieszać, pokazując sztukę możliwości w AWS, mając już na swoim koncie kilka prototypów opartych na sztucznej inteligencji. Ma za sobą długą karierę w inżynierii oprogramowania, a wcześniej pracował jako inżynier rozwoju oprogramowania w Amazon.com.br.

Adriana Fuentesa jest kierownikiem programu w zespole prototypowania i inżynierii chmury w Amazon Web Services, wprowadzając innowacje dla klientów w zakresie uczenia maszynowego, IoT i blockchain. Ma ponad 15 lat doświadczenia w zarządzaniu i wdrażaniu projektów oraz 1 rok pracy w AWS.

Adriana Fuentesa jest kierownikiem programu w zespole prototypowania i inżynierii chmury w Amazon Web Services, wprowadzając innowacje dla klientów w zakresie uczenia maszynowego, IoT i blockchain. Ma ponad 15 lat doświadczenia w zarządzaniu i wdrażaniu projektów oraz 1 rok pracy w AWS.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Uczenie maszynowe Amazon

- Pogromca danych Amazon SageMaker

- Ogłoszenia

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- analiza danych

- głęboka nauka

- google to

- Średni (200)

- uczenie maszynowe

- Sparametryzowane zestawy danych

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- Zaplanowane zadania

- składnia

- Instrukcje techniczne

- zefirnet