Amazon Sage Maker oferuje kilka sposobów uruchamiania rozproszonych zadań przetwarzania danych za pomocą Apache Spark, popularnej platformy przetwarzania rozproszonego do przetwarzania dużych zbiorów danych.

Możesz interaktywnie uruchamiać aplikacje platformy Spark Studio Amazon SageMaker przez połączenie Notatniki SageMaker Studio i interaktywne sesje AWS Glue do uruchamiania zadań platformy Spark w klastrze bezserwerowym. Dzięki interaktywnym sesjom możesz wybrać Apache Spark lub Ray, aby łatwo przetwarzać duże zestawy danych, nie martwiąc się o zarządzanie klastrami.

Alternatywnie, jeśli potrzebujesz większej kontroli nad środowiskiem, możesz użyć gotowego kontenera SageMaker Spark do uruchamiania aplikacji Spark jako zadań wsadowych we w pełni zarządzanym rozproszonym klastrze z Przetwarzanie Amazon SageMaker. Ta opcja umożliwia wybranie kilku typów wystąpień (zoptymalizowanych pod kątem obliczeń, zoptymalizowanych pod kątem pamięci i innych), liczby węzłów w klastrze i konfiguracji klastra, co zapewnia większą elastyczność przetwarzania danych i szkolenia modeli.

Wreszcie, możesz uruchamiać aplikacje Spark, łącząc notesy Studio z Amazon EMR klastrylub uruchamiając klaster Spark Elastyczna chmura obliczeniowa Amazon (Amazonka EC2).

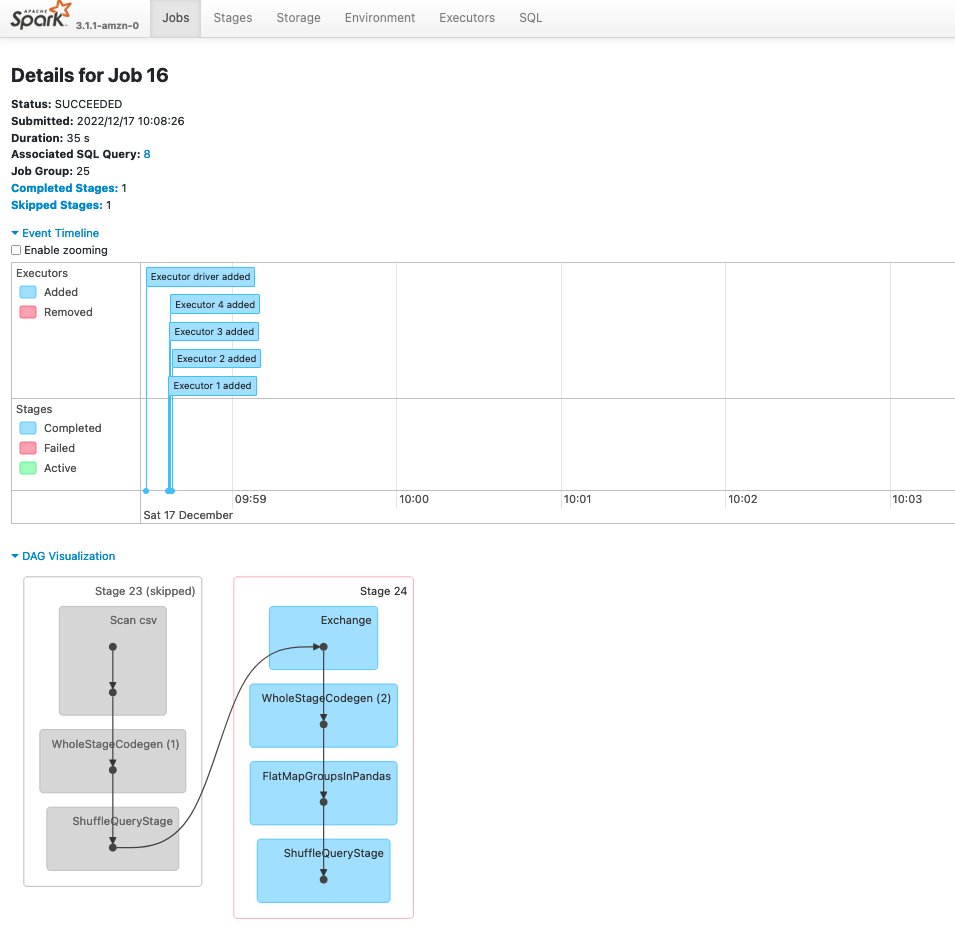

Wszystkie te opcje umożliwiają generowanie i przechowywanie dzienników zdarzeń platformy Spark w celu ich analizy za pośrednictwem internetowego interfejsu użytkownika, powszechnie zwanego Interfejs Spark, który uruchamia serwer historii Spark, aby monitorować postęp aplikacji Spark, śledzić użycie zasobów i błędy debugowania.

W tym poście udostępniamy a rozwiązanie do instalowania i uruchamiania Spark History Server w SageMaker Studio i uzyskiwania dostępu do interfejsu użytkownika Spark bezpośrednio z SageMaker Studio IDE, do analizowania dzienników Spark tworzonych przez różne usługi AWS (sesje AWS Glue Interactive, zadania SageMaker Processing i Amazon EMR) i przechowywane w Usługa Amazon Simple Storage Łyżka (Amazon S3).

Omówienie rozwiązania

Rozwiązanie integruje Spark History Server z aplikacją Jupyter Server w SageMaker Studio. Pozwala to użytkownikom na dostęp do dzienników Spark bezpośrednio z SageMaker Studio IDE. Zintegrowany serwer Spark History Server obsługuje następujące funkcje:

- Dostęp do dzienników generowanych przez zadania SageMaker Processing Spark

- Dostęp do logów generowanych przez aplikacje AWS Glue Spark

- Dostęp do dzienników generowanych przez samodzielnie zarządzane klastry Spark i Amazon EMR

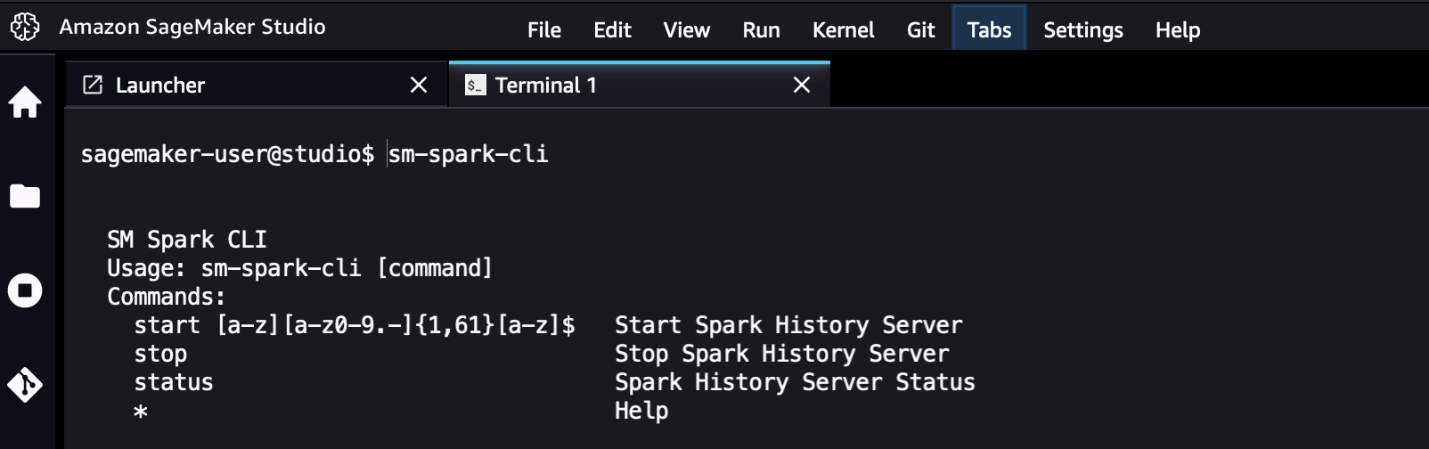

Interfejs wiersza poleceń narzędzia (CLI) o nazwie sm-spark-cli zapewnia również interakcję z interfejsem użytkownika Spark z poziomu terminala systemowego SageMaker Studio. The sm-spark-cli umożliwia zarządzanie Spark History Server bez opuszczania SageMaker Studio.

Rozwiązanie składa się ze skryptów powłoki, które wykonują następujące czynności:

- Zainstaluj Spark na serwerze Jupyter dla profili użytkowników SageMaker Studio lub dla przestrzeni współdzielonej SageMaker Studio

- Instalacja

sm-spark-clidla profilu użytkownika lub współdzielonej przestrzeni

Zainstaluj interfejs Spark ręcznie w domenie SageMaker Studio

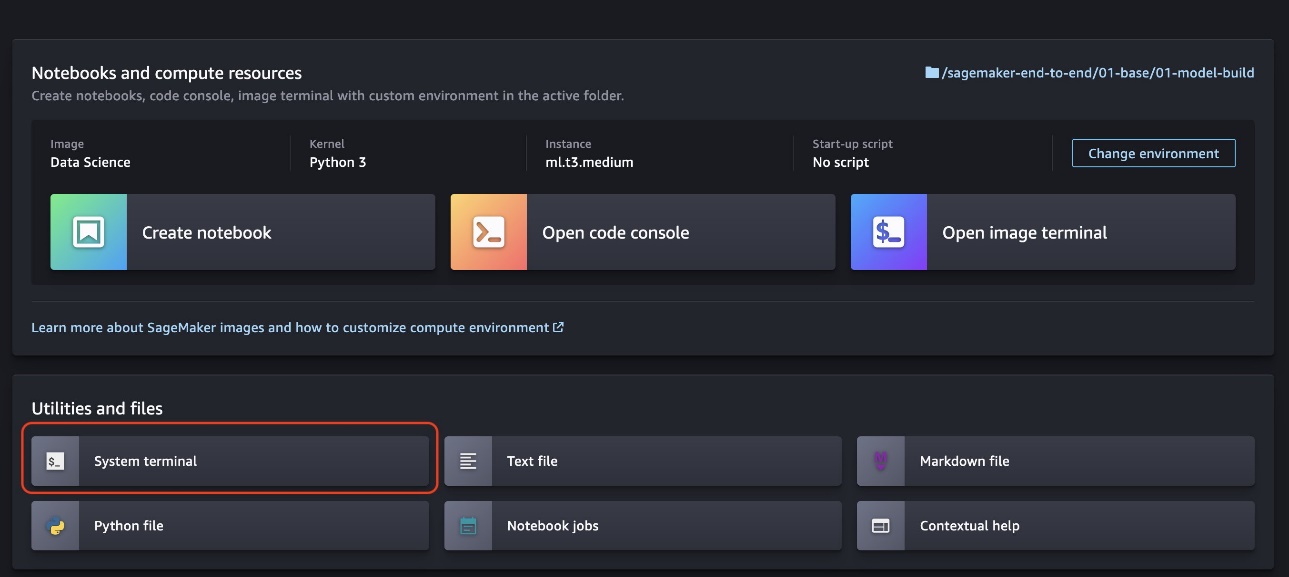

Aby hostować Spark UI w SageMaker Studio, wykonaj następujące kroki:

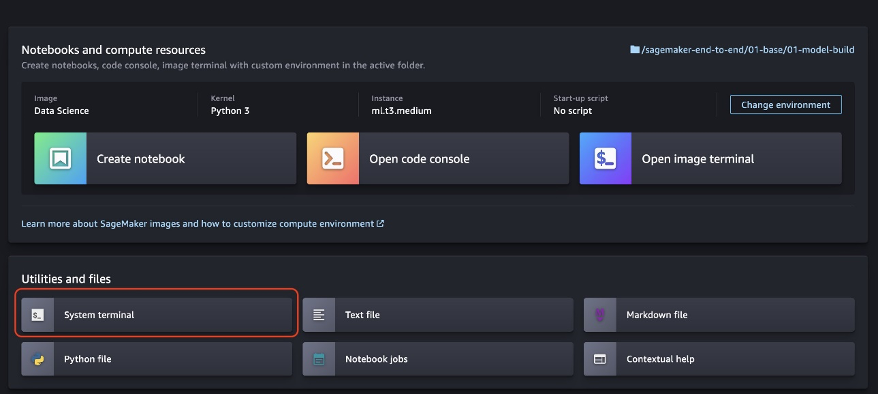

- Dodaj Terminal systemowy z programu uruchamiającego SageMaker Studio.

- Uruchom następujące polecenia w terminalu systemowym:

Wykonanie poleceń zajmie kilka sekund.

- Po zakończeniu instalacji możesz uruchomić interfejs użytkownika platformy Spark przy użyciu dostarczonego pliku

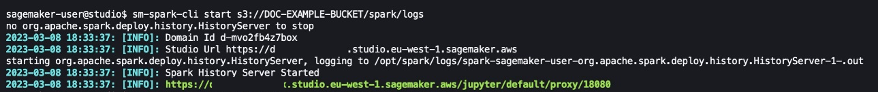

sm-spark-clii uzyskaj do niego dostęp z przeglądarki internetowej, uruchamiając następujący kod:

sm-spark-cli start s3://DOC-EXAMPLE-BUCKET/<SPARK_EVENT_LOGS_LOCATION>

Lokalizację S3, w której przechowywane są dzienniki zdarzeń generowane przez SageMaker Processing, AWS Glue lub Amazon EMR, można skonfigurować podczas uruchamiania aplikacji Spark.

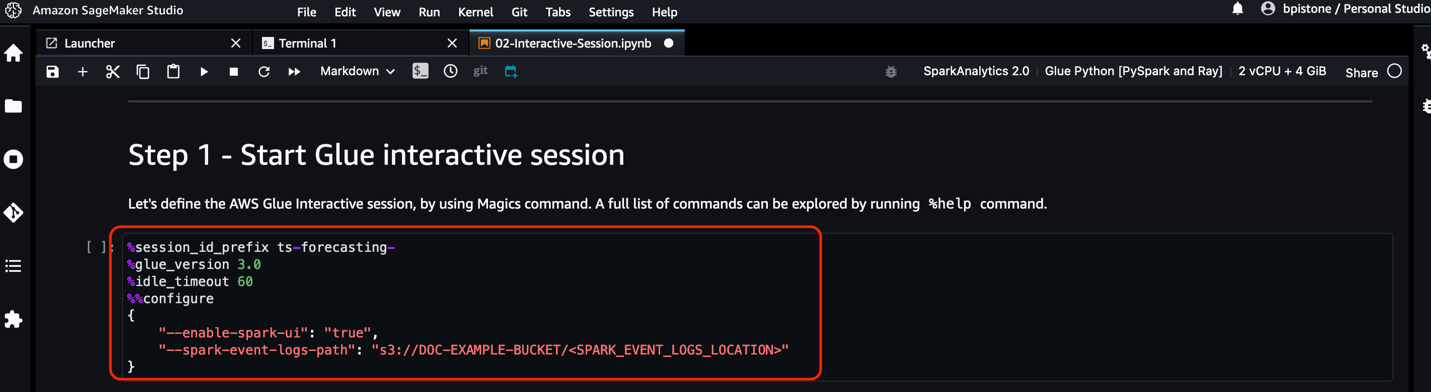

W przypadku notatników SageMaker Studio i sesji interaktywnych AWS Glue możesz skonfigurować lokalizację dziennika zdarzeń Spark bezpośrednio z notatnika za pomocą sparkmagic jądro.

Połączenia sparkmagic Jądro zawiera zestaw narzędzi do interakcji ze zdalnymi klastrami Spark za pośrednictwem notebooków. Oferuje magię (%spark, %sql) polecenia do uruchamiania kodu platformy Spark, wykonywania zapytań SQL i konfigurowania ustawień platformy Spark, takich jak pamięć wykonawcy i rdzenie.

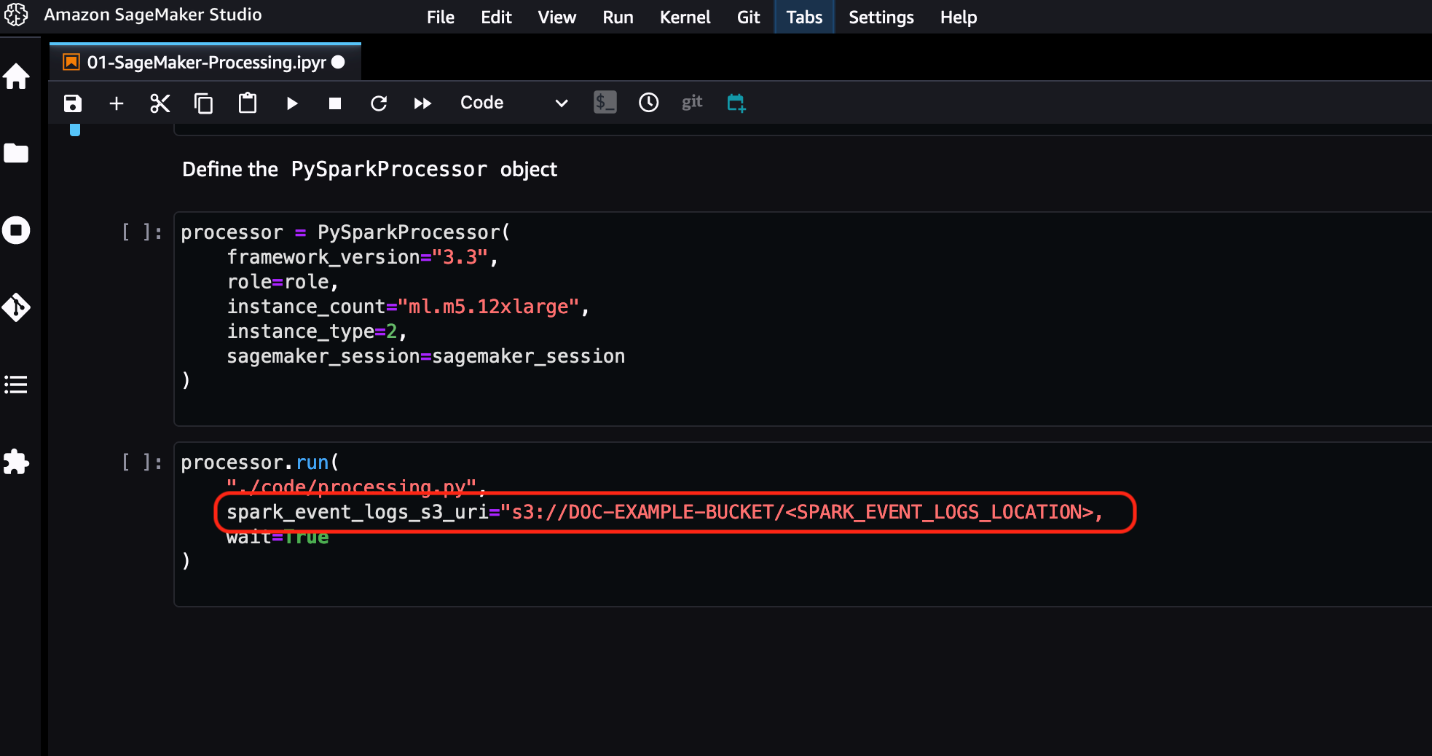

W przypadku zadania SageMaker Processing można skonfigurować lokalizację dziennika zdarzeń Spark bezpośrednio z zestawu SageMaker Python SDK.

Zapoznaj się z dokumentacją AWS, aby uzyskać dodatkowe informacje:

Możesz wybrać wygenerowany adres URL, aby uzyskać dostęp do interfejsu użytkownika platformy Spark.

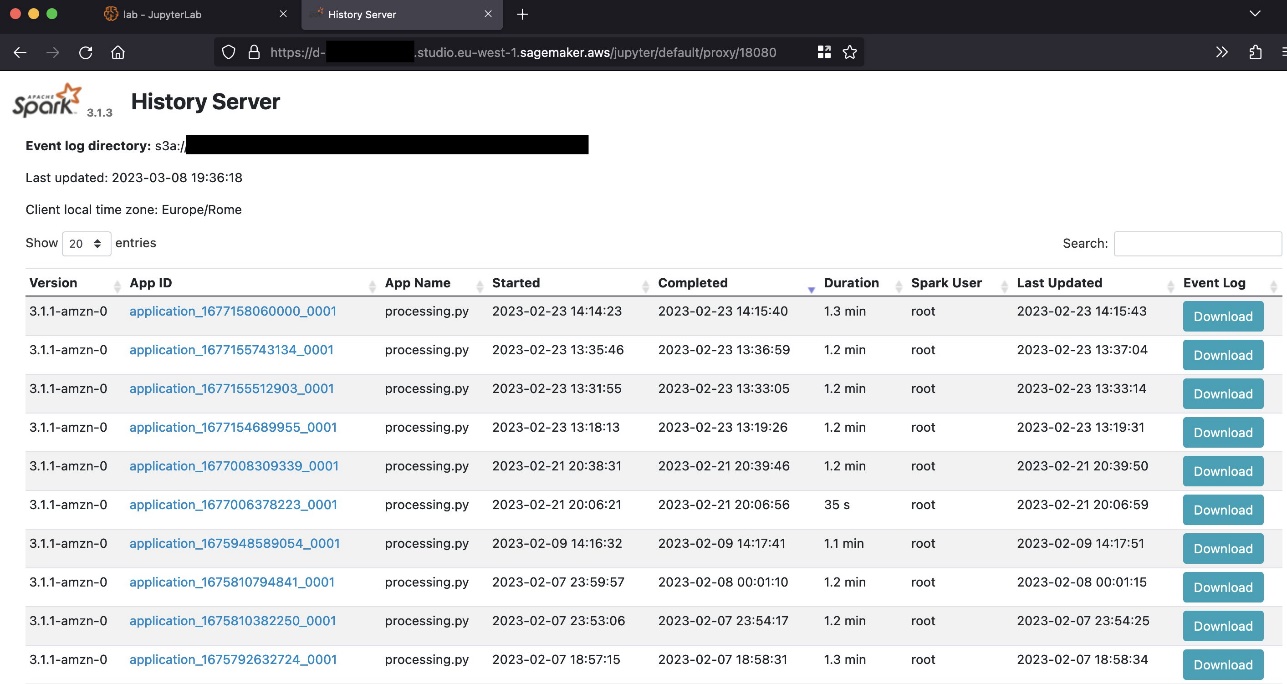

Poniższy zrzut ekranu przedstawia przykład interfejsu użytkownika platformy Spark.

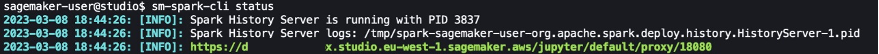

Możesz sprawdzić stan serwera historii Spark, używając sm-spark-cli status polecenie w terminalu Studio System.

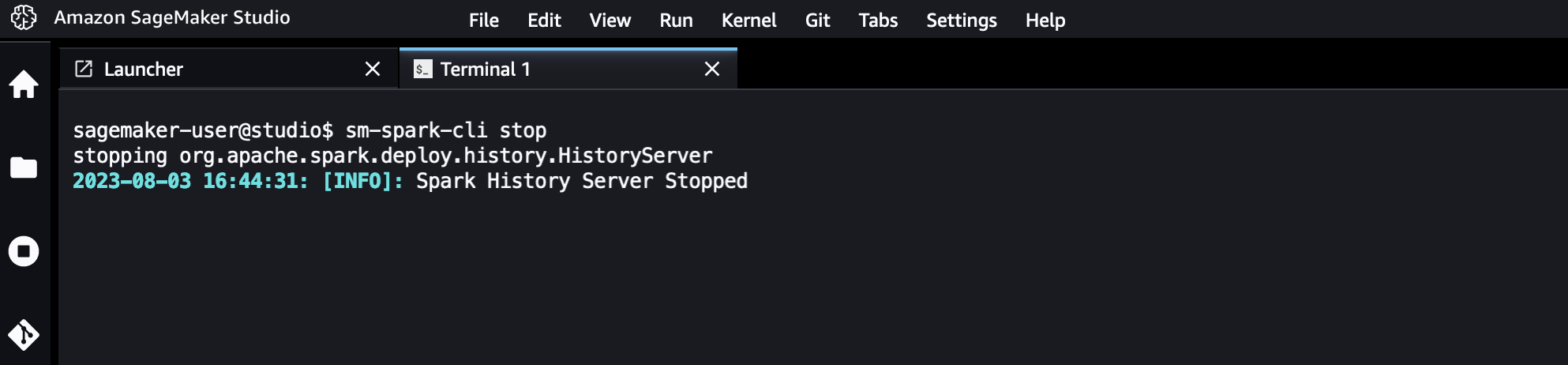

W razie potrzeby możesz także zatrzymać serwer historii Spark.

Zautomatyzuj instalację Spark UI dla użytkowników w domenie SageMaker Studio

Jako administrator IT możesz zautomatyzować instalację dla użytkowników SageMaker Studio, używając pliku konfiguracja cyklu życia. Można to zrobić dla wszystkich profili użytkowników w domenie SageMaker Studio lub dla określonych. Widzieć Dostosuj Amazon SageMaker Studio za pomocą konfiguracji cyklu życia by uzyskać więcej szczegółów.

Konfigurację cyklu życia można utworzyć z pliku install-history-server.sh script i dołącz go do istniejącej domeny SageMaker Studio. Instalacja jest uruchamiana dla wszystkich profili użytkowników w domenie.

Z terminala skonfigurowanego za pomocą Interfejs wiersza poleceń AWS (AWS CLI) i odpowiednie uprawnienia, uruchom następujące polecenia:

Po ponownym uruchomieniu serwera Jupyter interfejs użytkownika platformy Spark i sm-spark-cli będzie dostępny w Twoim środowisku SageMaker Studio.

Sprzątać

W tej sekcji pokazujemy, jak wyczyścić interfejs użytkownika Spark w domenie SageMaker Studio, ręcznie lub automatycznie.

Ręcznie odinstaluj interfejs użytkownika platformy Spark

Aby ręcznie odinstalować interfejs Spark w SageMaker Studio, wykonaj następujące kroki:

- Dodaj Terminal systemowy w programie uruchamiającym SageMaker Studio.

- Uruchom następujące polecenia w terminalu systemowym:

Automatycznie odinstaluj interfejs Spark dla wszystkich profili użytkowników SageMaker Studio

Aby automatycznie odinstalować interfejs Spark w SageMaker Studio dla wszystkich profili użytkowników, wykonaj następujące kroki:

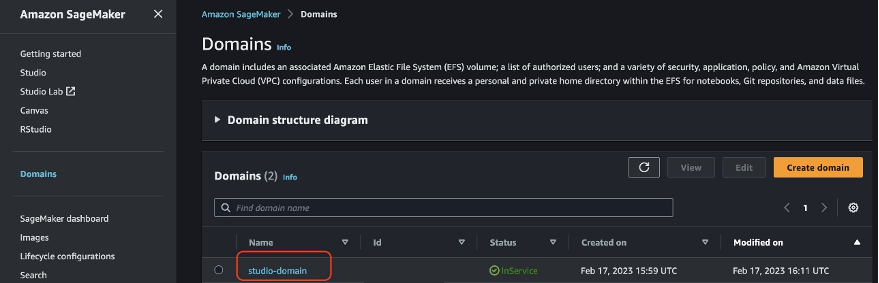

- W konsoli SageMaker wybierz domeny w panelu nawigacyjnym, a następnie wybierz domenę SageMaker Studio.

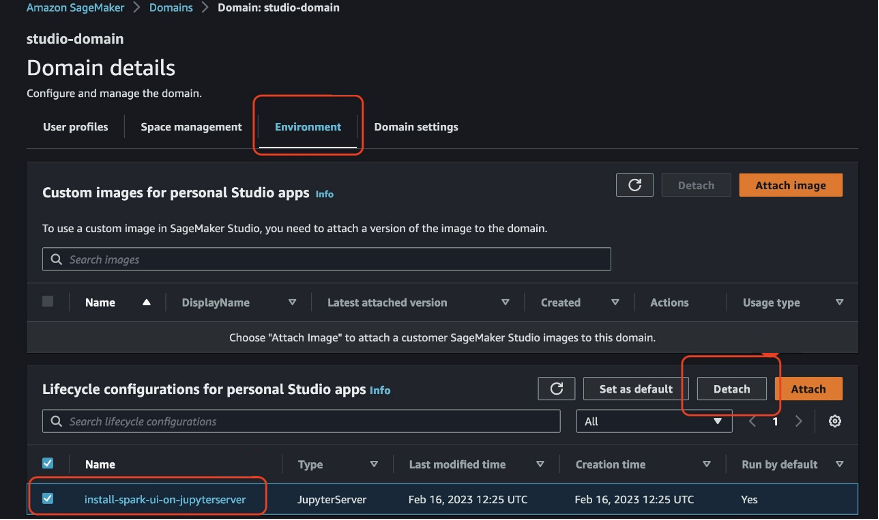

- Na stronie szczegółów domeny przejdź do Środowisko patka.

- Wybierz konfigurację cyklu życia interfejsu Spark w SageMaker Studio.

- Dodaj Odłączyć.

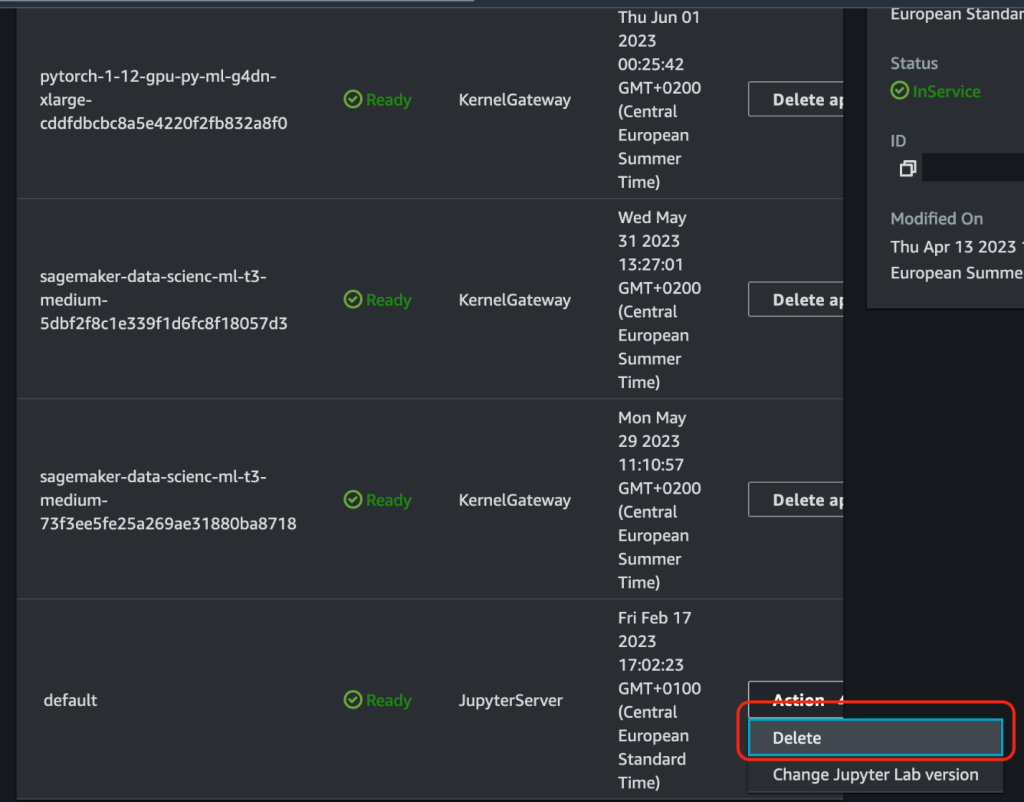

- Usuń i uruchom ponownie aplikacje Jupyter Server dla profili użytkowników SageMaker Studio.

Wnioski

W tym poście udostępniliśmy rozwiązanie, którego możesz użyć do szybkiej instalacji interfejsu Spark w SageMaker Studio. Dzięki interfejsowi użytkownika Spark hostowanemu w SageMaker, zespoły zajmujące się uczeniem maszynowym (ML) i inżynierią danych mogą korzystać ze skalowalnych obliczeń w chmurze, aby uzyskiwać dostęp do dzienników Spark i analizować je z dowolnego miejsca oraz przyspieszać realizację projektów. Administratorzy IT mogą ustandaryzować i przyspieszyć udostępnianie rozwiązania w chmurze oraz uniknąć mnożenia niestandardowych środowisk programistycznych dla projektów ML.

Cały kod pokazany jako część tego posta jest dostępny w Repozytorium GitHub.

O autorach

Giuseppe Angelo Porcellego jest głównym architektem rozwiązań specjalizujących się w uczeniu maszynowym w Amazon Web Services. Z kilkuletnim doświadczeniem w inżynierii oprogramowania i ML współpracuje z klientami dowolnej wielkości, aby zrozumieć ich potrzeby biznesowe i techniczne oraz zaprojektować rozwiązania AI i ML, które najlepiej wykorzystują AWS Cloud i stos Amazon Machine Learning. Pracował nad projektami z różnych dziedzin, w tym MLOps, wizji komputerowej i NLP, obejmujących szeroki zestaw usług AWS. W wolnym czasie Giuseppe lubi grać w piłkę nożną.

Giuseppe Angelo Porcellego jest głównym architektem rozwiązań specjalizujących się w uczeniu maszynowym w Amazon Web Services. Z kilkuletnim doświadczeniem w inżynierii oprogramowania i ML współpracuje z klientami dowolnej wielkości, aby zrozumieć ich potrzeby biznesowe i techniczne oraz zaprojektować rozwiązania AI i ML, które najlepiej wykorzystują AWS Cloud i stos Amazon Machine Learning. Pracował nad projektami z różnych dziedzin, w tym MLOps, wizji komputerowej i NLP, obejmujących szeroki zestaw usług AWS. W wolnym czasie Giuseppe lubi grać w piłkę nożną.

Bruno Piston jest Architektem Rozwiązań Specjalistycznych AI/ML dla AWS z siedzibą w Mediolanie. Pracuje z klientami dowolnej wielkości, pomagając im zrozumieć ich potrzeby techniczne i zaprojektować rozwiązania AI i ML, które najlepiej wykorzystują AWS Cloud i stos Amazon Machine Learning. Jego specjalizacja obejmuje kompleksowe uczenie maszynowe, endustrializację uczenia maszynowego i generatywną sztuczną inteligencję. Lubi spędzać czas z przyjaciółmi i odkrywać nowe miejsca, a także podróżować do nowych miejsc.

Bruno Piston jest Architektem Rozwiązań Specjalistycznych AI/ML dla AWS z siedzibą w Mediolanie. Pracuje z klientami dowolnej wielkości, pomagając im zrozumieć ich potrzeby techniczne i zaprojektować rozwiązania AI i ML, które najlepiej wykorzystują AWS Cloud i stos Amazon Machine Learning. Jego specjalizacja obejmuje kompleksowe uczenie maszynowe, endustrializację uczenia maszynowego i generatywną sztuczną inteligencję. Lubi spędzać czas z przyjaciółmi i odkrywać nowe miejsca, a także podróżować do nowych miejsc.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/host-the-spark-ui-on-amazon-sagemaker-studio/

- :ma

- :Jest

- :Gdzie

- $W GÓRĘ

- 1

- 100

- 12

- 7

- 8

- 9

- a

- O nas

- dostęp

- Dostęp

- działania

- Dodatkowy

- Dodatkowe informacje

- Admin

- AI

- AI / ML

- Wszystkie kategorie

- dopuszczać

- pozwala

- również

- Amazonka

- Amazon EC2

- Amazon EMR

- Uczenie maszynowe Amazon

- Amazon Sage Maker

- Studio Amazon SageMaker

- Amazon Web Services

- an

- w czasie rzeczywistym sprawiają,

- Analizując

- i

- każdy

- nigdzie

- Apache

- Aplikacja

- aplikacje

- właściwy

- mobilne i webowe

- SĄ

- AS

- dołączać

- zautomatyzować

- automatycznie

- dostępny

- uniknąć

- AWS

- Klej AWS

- tło

- na podstawie

- BE

- BEST

- Duży

- Big Data

- szeroki

- przeglądarka

- biznes

- by

- nazywa

- CAN

- CD

- ZOBACZ

- Dodaj

- Chmura

- Grupa

- kod

- powszechnie

- kompletny

- obliczać

- komputer

- Wizja komputerowa

- computing

- systemu

- skonfigurowany

- Podłączanie

- składa się

- Konsola

- Pojemnik

- zawiera

- kontrola

- Stwórz

- zwyczaj

- Klientów

- dane

- analiza danych

- zbiory danych

- dostawa

- Wnętrze

- Cele podróży

- detale

- oprogramowania

- różne

- bezpośrednio

- dystrybuowane

- przetwarzanie rozproszone

- dokumentacja

- domena

- domeny

- zrobić

- z łatwością

- bądź

- Umożliwia

- umożliwiając

- zakończenia

- Inżynieria

- Środowisko

- środowiska

- Błędy

- wydarzenie

- przykład

- Przede wszystkim system został opracowany

- przyśpieszyć coś

- Exploring

- kilka

- pole

- Elastyczność

- następujący

- piłka nożna

- W razie zamówieenia projektu

- Framework

- Darmowy

- przyjaciele

- od

- w pełni

- Generować

- wygenerowane

- generatywny

- generatywna sztuczna inteligencja

- większy

- he

- pomoc

- jego

- historia

- gospodarz

- hostowane

- W jaki sposób

- How To

- HTML

- http

- HTTPS

- if

- in

- obejmuje

- Włącznie z

- Informacja

- zainstalować

- instalacja

- Instalacja

- zintegrowany

- Integruje się

- interakcji

- interaktywne

- Interfejs

- najnowszych

- z udziałem

- IT

- Praca

- Oferty pracy

- jpg

- duży

- nauka

- pozostawiając

- wifecycwe

- lubić

- Linia

- lokalizacja

- log

- maszyna

- uczenie maszynowe

- magia

- robić

- zarządzane

- i konserwacjami

- zarządzający

- ręcznie

- Pamięć

- MILAN

- ML

- MLOps

- model

- monitor

- jeszcze

- O imieniu

- Nawigacja

- Nawigacja

- Potrzebować

- potrzebne

- wymagania

- Nowości

- nlp

- węzły

- notatnik

- numer

- of

- Oferty

- on

- te

- zoptymalizowane

- Option

- Opcje

- or

- koniec

- strona

- chleb

- część

- wykonać

- uprawnienia

- Miejsca

- plato

- Analiza danych Platona

- PlatoDane

- gra

- Popularny

- Post

- Główny

- wygląda tak

- przetwarzanie

- Wytworzony

- Profil

- profile

- Postęp

- projekt

- projektowanie

- pod warunkiem,

- Python

- zapytania

- szybko

- RAY

- zdalny

- Zasób

- run

- bieganie

- działa

- sagemaker

- skalowalny

- skrypty

- Sdk

- sekund

- Sekcja

- widzieć

- Bezserwerowe

- Usługi

- Sesje

- zestaw

- w panelu ustawień

- kilka

- Share

- shared

- Powłoka

- pokazać

- pokazane

- Targi

- Prosty

- Rozmiar

- Tworzenie

- Inżynieria oprogramowania

- rozwiązanie

- Rozwiązania

- Iskra

- specjalista

- specyficzny

- prędkość

- Spędzanie

- stos

- początek

- Rynek

- Cel

- Stop

- przechowywanie

- sklep

- przechowywany

- studio

- podpory

- system

- Brać

- Zespoły

- Techniczny

- terminal

- że

- Połączenia

- ich

- Im

- następnie

- a tym samym

- Te

- to

- Przez

- czas

- do

- narzędzia

- śledzić

- Trening

- Podróżowanie

- typy

- ui

- dla

- zrozumieć

- URL

- Stosowanie

- posługiwać się

- Użytkownik

- Interfejs użytkownika

- Użytkownicy

- za pomocą

- użyteczność

- wizja

- sposoby

- we

- sieć

- przeglądarka internetowa

- usługi internetowe

- Web-based

- DOBRZE

- jeśli chodzi o komunikację i motywację

- który

- będzie

- w

- bez

- pracował

- działa

- lat

- You

- Twój

- zefirnet