W coraz bardziej skoncentrowanym na danych świecie przedsiębiorstwa muszą skupić się zarówno na gromadzeniu cennych informacji fizycznych, jak i na generowaniu informacji, których potrzebują, ale nie mogą ich łatwo przechwycić. Dostęp do danych, regulacje i zgodność są coraz większym źródłem tarć dla innowacji w analityce i sztucznej inteligencji (AI).

W przypadku wysoce regulowanych sektorów, takich jak usługi finansowe, opieka zdrowotna, nauki przyrodnicze, motoryzacja, robotyka i produkcja, problem jest jeszcze większy. Powoduje bariery w projektowaniu systemów, udostępnianiu danych (wewnętrznych i zewnętrznych), zarabianiu, analityce i uczeniu maszynowym (ML).

Dane syntetyczne to narzędzie, które rozwiązuje wiele problemów związanych z danymi, w szczególności kwestie sztucznej inteligencji i analityki, takie jak ochrona prywatności, zgodność z przepisami, dostępność, niedobór danych i stronniczość. Obejmuje to również udostępnianie danych i czas udostępnienia danych (a tym samym czas wprowadzenia na rynek).

Dane syntetyczne są generowane algorytmicznie. Odzwierciedla właściwości statystyczne i wzorce z danych źródłowych. Ale co ważne, nie zawiera wrażliwych, prywatnych ani osobistych punktów danych.

Zadajesz pytania dotyczące danych syntetycznych i otrzymujesz takie same odpowiedzi, jak w przypadku rzeczywistych danych.

W naszym wcześniejszy post, pokazaliśmy, jak używać sieci kontradyktoryjnych, takich jak generatywne sieci adwersarskie (GANS), do generowania tabelarycznych zestawów danych w celu usprawnienia szkolenia w zakresie modeli oszustw kredytowych.

Aby interesariusze biznesowi przyjęli dane syntetyczne do swoich projektów ML i analitycznych, konieczne jest nie tylko upewnienie się, że wygenerowane dane syntetyczne będą pasować do celu i oczekiwanych dalszych zastosowań, ale także umożliwienie im zmierzenia i zademonstrowania jakości wygenerowane dane.

Wraz z rosnącymi zobowiązaniami prawnymi i etycznymi w zakresie ochrony prywatności, jedną z mocnych stron danych syntetycznych jest możliwość usuwania wrażliwych i oryginalnych informacji podczas ich syntezy. Dlatego oprócz jakości potrzebujemy metryk do oceny ryzyka wycieku prywatnych informacji, jeśli takie istnieją, oraz do oceny, czy proces generowania nie polega na „zapamiętywaniu” ani kopiowaniu jakichkolwiek oryginalnych danych.

Aby to wszystko osiągnąć, możemy mapować jakość danych syntetycznych na wymiary, które pomagają użytkownikom, interesariuszom i nam lepiej zrozumieć generowane dane.

Trzy wymiary oceny jakości danych syntetycznych

Wygenerowane dane syntetyczne są mierzone w trzech kluczowych wymiarach:

- Wierność

- Użyteczność

- Prywatności

Oto niektóre z pytań dotyczących wszelkich wygenerowanych danych syntetycznych, na które należy odpowiedzieć w raporcie dotyczącym jakości danych syntetycznych:

- Jak podobne są te syntetyczne dane w porównaniu z oryginalnym zbiorem uczącym?

- Jak przydatne są te syntetyczne dane dla naszych dalszych zastosowań?

- Czy jakieś informacje wyciekły z oryginalnych danych treningowych do danych syntetycznych?

- Czy jakieś dane uważane za wrażliwe w świecie rzeczywistym (z innych zestawów danych nieużywanych do uczenia modelu) zostały nieumyślnie zsyntetyzowane przez nasz model?

Metryki, które przekładają każdy z tych wymiarów na użytkowników końcowych, są dość elastyczne. W końcu dane, które mają zostać wygenerowane, mogą się różnić pod względem dystrybucji, rozmiaru i zachowań. Powinny być również łatwe do zrozumienia i interpretacji.

Ostatecznie metryki muszą być całkowicie oparte na danych i nie wymagać żadnej wcześniejszej wiedzy ani informacji specyficznych dla domeny. Jeśli jednak użytkownik chce zastosować określone reguły i ograniczenia mające zastosowanie do określonej domeny biznesowej, powinien mieć możliwość zdefiniowania ich podczas procesu syntezy, aby upewnić się, że zachowana jest wierność specyficzna dla domeny.

Przyjrzymy się każdemu z tych wskaźników bardziej szczegółowo w poniższych sekcjach.

Metryki do zrozumienia wierności

W każdym projekcie związanym z nauką o danych musimy zrozumieć, czy określona populacja ma znaczenie dla problemu, który rozwiązujemy. Podobnie dla procesu oceny istotności generowanych danych syntetycznych, musimy je ocenić pod kątem wierność w porównaniu z oryginałem.

Wizualne reprezentacje tych metryk ułatwiają ich zrozumienie. Moglibyśmy zilustrować, czy zachowano liczność i stosunek kategorii, zachowano korelacje między różnymi zmiennymi i tak dalej.

Wizualizacja danych nie tylko pomaga ocenić jakość danych syntetycznych, ale także stanowi jeden z pierwszych kroków w cyklu życia nauki o danych w celu lepszego zrozumienia danych.

Przyjrzyjmy się bardziej szczegółowo niektórym wskaźnikom wierności.

Eksploracyjne porównania statystyczne

W ramach eksploracyjnych porównań statystycznych cechy oryginalnych i syntetycznych zbiorów danych są badane przy użyciu kluczowych miar statystycznych, takich jak średnia, mediana, odchylenie standardowe, wartości odrębne, wartości brakujące, minima, maksima, przedziały kwartylowe dla cech ciągłych oraz liczba rekordów na kategorię, brakujące wartości na kategorię i większość występujących znaków dla atrybutów kategorialnych.

To porównanie powinno być przeprowadzone między oryginalnym zbiorem danych wstrzymanych a danymi syntetycznymi. Ta ocena ujawniłaby, czy porównywane zestawy danych są statystycznie podobne. Jeśli tak nie jest, zrozumiemy, które funkcje i miary są różne. Należy rozważyć ponowne uczenie i ponowne generowanie danych syntetycznych z innymi parametrami, jeśli zauważona zostanie znacząca różnica.

Ten test działa jako wstępna kontrola, aby upewnić się, że dane syntetyczne są odpowiednio wierne oryginalnemu zbiorowi danych i dlatego mogą być użytecznie poddane bardziej rygorystycznym testom.

Wynik podobieństwa histogramu

Wynik podobieństwa histogramu mierzy krańcowe rozkłady każdej cechy w syntetycznych i oryginalnych zestawach danych.

Wynik podobieństwa jest ograniczony od zera do jednego, przy czym wynik jeden wskazuje, że rozkłady danych syntetycznych doskonale pokrywają się z rozkładami danych oryginalnych.

Wynik bliski jedności dałby użytkownikom pewność, że zbiór danych wstrzymanych i zestaw danych syntetycznych są statystycznie podobne.

Wynik wzajemnej informacji

Wynik wzajemnej informacji mierzy wzajemną zależność dwóch cech, liczbową lub kategoryczną, wskazując, ile informacji można uzyskać z jednej cechy, obserwując inną.

Wzajemne informacje mogą mierzyć zależności nieliniowe, zapewniając pełniejsze zrozumienie jakości danych syntetycznych, ponieważ pozwalają nam zrozumieć stopień zachowania relacji zmiennych.

Wynik jeden wskazuje, że wzajemna zależność między cechami została doskonale ujęta w danych syntetycznych.

Wynik korelacji

Wynik korelacji mierzy, jak dobrze korelacje w oryginalnym zbiorze danych zostały przechwycone w danych syntetycznych.

Korelacje między dwiema lub więcej kolumnami są niezwykle ważne dla aplikacji ML, które pomagają odkryć relacje między funkcjami a zmienną docelową i pomagają stworzyć dobrze wyszkolony model.

Wynik korelacji jest ograniczony od zera do jednego, przy czym wynik jeden wskazuje, że korelacje zostały idealnie dopasowane.

W przeciwieństwie do ustrukturyzowanych danych tabelarycznych, z którymi często spotykamy się w problemach z danymi, niektóre typy danych ustrukturyzowanych mają określone zachowanie, w którym wcześniejsze obserwacje mają prawdopodobieństwo wpływu na następną obserwację. Są to tak zwane szeregi czasowe lub dane sekwencyjne — na przykład zestaw danych z godzinnymi pomiarami temperatury pokojowej.

To zachowanie oznacza, że istnieje wymóg zdefiniowania pewnych metryk, które mogą konkretnie mierzyć jakość tych zestawów danych szeregów czasowych

Wynik autokorelacji i częściowej autokorelacji

Chociaż jest podobna do korelacji, autokorelacja pokazuje zależność szeregów czasowych według ich wartości bieżącej w odniesieniu do poprzednich wartości. Usunięcie skutków poprzednich opóźnień czasowych daje częściową autokorelację. W związku z tym wynik autokorelacji mierzy, jak dobrze dane syntetyczne uchwyciły znaczące autokorelacje lub korelacje częściowe z oryginalnego zestawu danych.

Metryki do zrozumienia użyteczności

Teraz mogliśmy statystycznie zdać sobie sprawę, że dane syntetyczne są podobne do oryginalnego zbioru danych. Ponadto musimy również ocenić, jak dobrze zsyntetyzowany zestaw danych radzi sobie z typowymi problemami nauki o danych, gdy jest szkolony na kilku algorytmach ML.

Korzystanie z następujących użyteczność metryk, dążymy do zbudowania pewności, że faktycznie możemy osiągnąć wydajność w aplikacjach podrzędnych w odniesieniu do tego, jak zachowywały się oryginalne dane.

Wynik prognozy

Mierzenie wydajności danych syntetycznych w porównaniu z oryginalnymi danymi rzeczywistymi można przeprowadzić za pomocą modeli ML. Wynik modelu niższego szczebla przechwytuje jakość danych syntetycznych, porównując wydajność modeli ML przeszkolonych zarówno na syntetycznych, jak i oryginalnych zestawach danych oraz zweryfikowanych na podstawie wstrzymanych danych testowych z oryginalnego zestawu danych. Zapewnia to Pociąg Wynik testu syntetycznego rzeczywistego (TSTR). oraz Pociąg rzeczywisty Test rzeczywisty (TRTR) punktować odpowiednio.

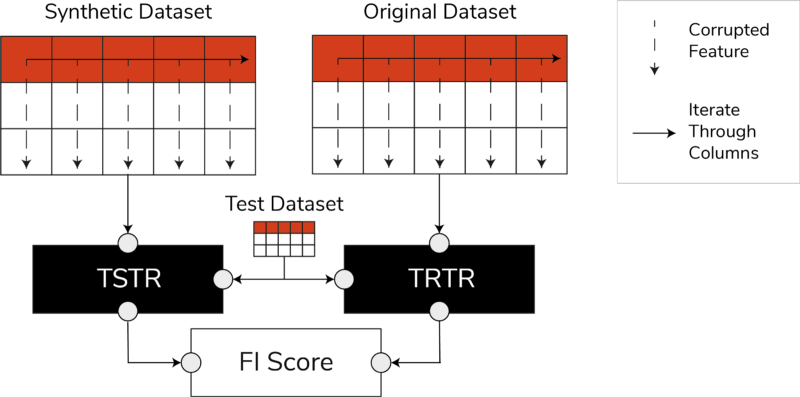

Wyniki TSTR, TRTR i wskaźnik ważności funkcji (zdjęcie autorstwa autora)

Wynik obejmuje szeroki zakres najbardziej zaufanych algorytmów ML do zadań regresji lub klasyfikacji. Użycie kilku klasyfikatorów i regresorów daje pewność, że wynik jest bardziej uogólniony w większości algorytmów, dzięki czemu dane syntetyczne można uznać za przydatne w przyszłości.

W ostatecznym rozrachunku, jeśli wynik TSTR i wynik TRTR są porównywalne, oznacza to, że dane syntetyczne mają jakość, którą można wykorzystać do trenowania skutecznych modeli ML do rzeczywistych zastosowań.

Ocena ważności funkcji

Wysoce powiązany z wynikiem predykcji, wynik ważności funkcji (FI) rozszerza go, dodając interpretowalność do wyników TSTR i TRTR.

Wynik F1 porównuje zmiany i stabilność kolejności ważności cechy otrzymanej z wynikiem predykcji. Uważa się, że syntetyczny zestaw danych ma wysoką użyteczność, jeśli daje ten sam porządek ważności cech, co oryginalne dane rzeczywiste.

Wynik Q

Aby upewnić się, że model wyszkolony na naszych nowo wygenerowanych danych będzie generował te same odpowiedzi na te same pytania, co model wyszkolony przy użyciu oryginalnych danych, używamy Qscore. Mierzy wydajność dalszych danych syntetycznych, uruchamiając wiele losowych zapytań opartych na agregacji zarówno na syntetycznych, jak i oryginalnych (i wstrzymanych) zestawach danych.

Chodzi o to, aby oba te zapytania zwracały podobne wyniki.

Wysoki wynik QScore gwarantuje, że aplikacje podrzędne, które wykorzystują operacje zapytań i agregacji, mogą zapewnić wartość zbliżoną do wartości oryginalnego zestawu danych.

Metryki do zrozumienia prywatności

Z prywatność już obowiązujących przepisów, zapewnienie ochrony poufnych informacji jest obowiązkiem etycznym i wymogiem prawnym.

Zanim te syntetyczne dane będą mogły być swobodnie udostępniane i wykorzystywane w dalszych zastosowaniach, musimy wziąć pod uwagę wskaźniki prywatności, które mogą pomóc zainteresowanym stronom zrozumieć, gdzie znajdują się wygenerowane dane syntetyczne w porównaniu z oryginalnymi danymi pod względem zakresu wycieku informacji. Ponadto musimy podejmować krytyczne decyzje dotyczące sposobu udostępniania i wykorzystywania danych syntetycznych.

Dokładny wynik meczu

Bezpośrednia i intuicyjna ocena prywatności polega na poszukiwaniu kopii prawdziwych danych wśród syntetycznych zapisów. Wynik dopasowania dokładnego określa liczbę rzeczywistych rekordów, które można znaleźć w zbiorze syntetycznym.

Wynik powinien wynosić zero, co oznacza, że w danych syntetycznych nie ma żadnych prawdziwych informacji. Ta metryka działa jako mechanizm sprawdzający, zanim ocenimy dalsze metryki prywatności.

Ocena prywatności sąsiadów

Co więcej, ocena prywatności sąsiadów mierzy odsetek zapisów syntetycznych, które mogą być zbyt bliskie podobieństwu do rzeczywistych. Oznacza to, że chociaż nie są to bezpośrednie kopie, są potencjalnymi punktami wycieku prywatności i źródłem przydatnych informacji do ataków opartych na wnioskowaniu.

Wynik jest obliczany poprzez przeprowadzenie wielowymiarowego wyszukiwania najbliższych sąsiadów na danych syntetycznych, które pokrywają się z oryginalnymi danymi.

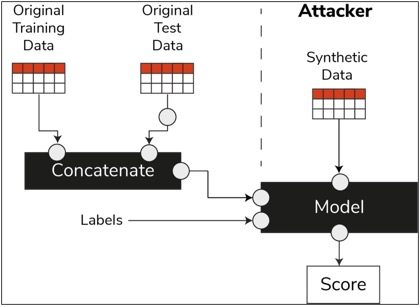

Wynik wnioskowania o członkostwie

W cyklu życia nauki o danych, po przeszkoleniu modelu, nie potrzebuje on już dostępu do próbek szkoleniowych i może dokonywać prognoz na podstawie niewidocznych danych. Podobnie w naszym przypadku, po przeszkoleniu modelu syntezatora, można wygenerować próbki danych syntetycznych bez potrzeby korzystania z oryginalnych danych.

Poprzez rodzaj ataku tzw „atak wnioskowania o członkostwo”, osoby atakujące mogą podjąć próbę ujawnienia danych, które posłużyły do utworzenia danych syntetycznych, nie mając dostępu do danych oryginalnych. Powoduje to kompromis w zakresie prywatności.

Wynik wnioskowania o członkostwie mierzy prawdopodobieństwo powodzenia ataku wnioskowania o członkostwo.

Niski wynik sugeruje wykonalność wnioskowania, że określony rekord był członkiem zbioru danych szkoleniowych, który doprowadził do utworzenia danych syntetycznych. Innymi słowy, ataki mogą wywnioskować szczegóły indywidualnego rekordu, naruszając w ten sposób prywatność.

Wysoki wynik wnioskowania o członkostwie wskazuje, że jest mało prawdopodobne, aby osoba atakująca określiła, czy określony rekord był częścią oryginalnego zestawu danych użytego do utworzenia danych syntetycznych. Oznacza to również, że informacje syntetyczne nie zostały naruszone.

Koncepcja wstrzymania

Ważną najlepszą praktyką, której musimy przestrzegać, jest upewnienie się, że dane syntetyczne są wystarczająco ogólne i nie przesadzają z oryginalnymi danymi, na których zostały przeszkolone. W typowym przepływie nauki o danych, podczas budowania modeli ML, takich jak klasyfikator losowego lasu, odkładamy dane testowe, trenujemy modele przy użyciu danych szkoleniowych i oceniamy metryki na niewidocznych danych testowych.

Podobnie w przypadku danych syntetycznych odkładamy na bok próbkę oryginalnych danych – ogólnie nazywaną wstrzymanym zbiorem danych lub niewidocznymi wstrzymanymi danymi testowymi – i oceniamy wygenerowane dane syntetyczne w porównaniu z wstrzymanym zbiorem danych.

Oczekuje się, że wstrzymany zestaw danych będzie reprezentacją oryginalnych danych, ale nie będzie widoczny podczas generowania danych syntetycznych. Dlatego ważne jest, aby mieć podobne wyniki dla wszystkich metryk podczas porównywania oryginału z zestawami danych wstrzymanych i syntetycznych.

Po uzyskaniu podobnych wyników możemy ustalić, że syntetyczne punkty danych nie są wynikiem zapamiętywania oryginalnych punktów danych, przy zachowaniu tej samej wierności i użyteczności.

Końcowe przemyślenia

Świat zaczyna rozumieć strategiczne znaczenie danych syntetycznych. Naszym obowiązkiem jako analityków danych i generatorów danych jest budowanie zaufania do generowanych przez nas danych syntetycznych i upewnianie się, że służą one celowi.

Dane syntetyczne stają się niezbędnym elementem zestawu narzędzi programistycznych do nauki o danych. Przegląd technologii MIT ma zauważyć dane syntetyczne jako jedna z przełomowych technologii 2022 roku. Nie wyobrażamy sobie budowania doskonałych modeli AI bez danych syntetycznych, twierdzi Gartner.

Zgodnie z McKinsey, syntetyczne dane minimalizują koszty i bariery, które w przeciwnym razie napotkasz podczas opracowywania algorytmów lub uzyskiwania dostępu do danych.

Generowanie danych syntetycznych polega na znajomości dalszych aplikacji i zrozumieniu kompromisów między różnymi wymiarami jakości danych syntetycznych.

Podsumowanie

Jako użytkownik danych syntetycznych niezbędne jest zdefiniowanie kontekstu przypadku użycia, dla którego każda próbka danych syntetycznych będzie używana w przyszłości. Podobnie jak w przypadku danych rzeczywistych, jakość danych syntetycznych zależy od zamierzonego przypadku użycia, a także parametrów wybranych do syntezy.

Na przykład utrzymywanie wartości odstających w danych syntetycznych, tak jak w danych oryginalnych, jest przydatne w przypadku użycia wykrywania oszustw. Jednak nie jest to przydatne w przypadku użycia w opiece zdrowotnej z obawami o prywatność, ponieważ wartości odstające mogą generalnie oznaczać wyciek informacji.

Ponadto istnieje kompromis między wiernością, użytecznością i prywatnością. Danych nie można zoptymalizować dla wszystkich trzech jednocześnie. Metryki te umożliwiają interesariuszom ustalenie priorytetów tego, co jest istotne dla każdego przypadku użycia i zarządzanie oczekiwaniami na podstawie wygenerowanych danych syntetycznych.

Ostatecznie, gdy widzimy wartości poszczególnych metryk i spełniają one oczekiwania, interesariusze mogą być pewni rozwiązań, które budują z wykorzystaniem danych syntetycznych.

Przypadki użycia ustrukturyzowanych danych syntetycznych obejmują szeroki zakres zastosowań, od danych testowych do tworzenia oprogramowania po tworzenie syntetycznych ramion kontrolnych w badaniach klinicznych.

Sięgnij po te możliwości lub zbuduj PoC, aby zademonstrować wartość.

Farisa Haddada jest kierownikiem ds. danych i spostrzeżeń w zespole AABG Strategic Pursuits. Pomaga przedsiębiorstwom z powodzeniem stać się data-driven.

Farisa Haddada jest kierownikiem ds. danych i spostrzeżeń w zespole AABG Strategic Pursuits. Pomaga przedsiębiorstwom z powodzeniem stać się data-driven.

- Zaawansowane (300)

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Uczenie maszynowe Amazon

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Instrukcje techniczne

- zefirnet