Amazon Bedrock to najlepsze miejsce do tworzenia i skalowania generatywnych aplikacji AI z dużymi modelami językowymi (LLM) i innymi modelami podstawowymi (FM). Umożliwia klientom wykorzystanie różnorodnych, wydajnych rozwiązań FM, takich jak rodzina modeli Claude firmy Anthropic, do tworzenia niestandardowych, generatywnych aplikacji AI. Patrząc wstecz na rok 2021, kiedy Anthropic po raz pierwszy zaczął budować na AWS, nikt nie mógł sobie wyobrazić, jak rewolucyjna będzie rodzina modeli Claude. Dzięki Amazon Bedrock najnowocześniejsze modele generatywnej sztucznej inteligencji są dostępne i użyteczne dla firm każdej wielkości. W ciągu zaledwie kilku miesięcy, odkąd usługa Amazon Bedrock stała się ogólnie dostępna 28 września 2023 r., ponad 10 tys. klientów korzystało z niej do realizacji dostaw, a wielu z nich korzysta z usługi Claude. Klienci tacy jak ADP, Broadridge, Cloudera, Dana-Farber Cancer Institute, Genesys, Genomics England, GoDaddy, Intuit, M1 Finance, Perplexity AI, Proto Hologram, Rocket Companies i nie tylko korzystają z modeli Claude firmy Anthropic na platformie Amazon Bedrock, aby wprowadzać innowacje w zakresie generatywnej sztucznej inteligencji i budować transformacyjne doświadczenia klientów. A dzisiaj ogłaszamy ekscytujący kamień milowy w postaci pojawienia się kolejnego pokolenia Claude’a w Amazon Bedrock: Claude 3 Opus, Claude 3 Sonnet i Claude 3 Haiku.

Przedstawiamy modele Claude 3 firmy Anthropic

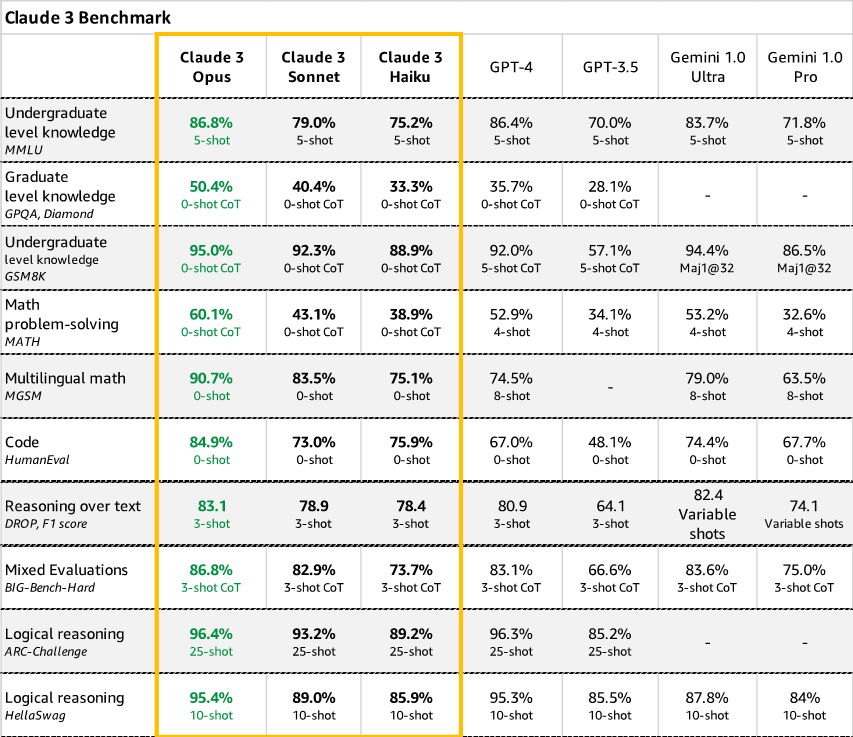

Anthropic przedstawia kolejną generację Claude z trzema zaawansowanymi modelami zoptymalizowanymi pod kątem różnych zastosowań. Haiku to najszybszy i najbardziej opłacalny model na rynku. Jest to szybki, kompaktowy model zapewniający niemal natychmiastową reakcję. W przypadku zdecydowanej większości obciążeń Sonnet jest 2 razy szybszy niż Claude 2 i Claude 2.1 przy wyższym poziomie inteligencji. Doskonale radzi sobie z inteligentnymi zadaniami wymagającymi szybkiej reakcji, takimi jak wyszukiwanie wiedzy czy automatyzacja sprzedaży. Zapewnia idealną równowagę pomiędzy inteligencją i szybkością – cechami szczególnie krytycznymi w zastosowaniach korporacyjnych. Opus to najbardziej zaawansowany, wydajny i najnowocześniejszy FM z głębokim rozumowaniem, zaawansowanymi umiejętnościami matematycznymi i kodowaniem, zapewniający najwyższą wydajność w przypadku bardzo złożonych zadań. Potrafi z niezwykłą płynnością poruszać się po otwartych podpowiedziach i nowatorskich scenariuszach, włączając automatyzację zadań, generowanie hipotez oraz analizę wykresów, diagramów i prognoz. Sonnet jest dziś po raz pierwszy dostępny na Amazon Bedrock. Aktualne oceny przeprowadzone przez Anthropic sugerują, że rodzina modeli Claude 3 przewyższa porównywalne modele w testach porównawczych rozwiązywania problemów matematycznych (MATH) i matematyki wielojęzycznej (MGSM), kluczowych punktów odniesienia używanych obecnie w programach LLM.

- Możliwości widzenia – Modele Claude 3 zostały przeszkolone w zakresie rozumienia danych ustrukturyzowanych i nieustrukturyzowanych w różnych formatach, nie tylko w języku, ale także w obrazach, wykresach, diagramach i nie tylko. Umożliwia to firmom tworzenie generatywnych aplikacji AI integrujących różnorodne źródła multimediów i rozwiązujących problemy obejmujące naprawdę wiele dziedzin. Na przykład firmy farmaceutyczne mogą przeglądać dokumenty badawcze dotyczące leków wraz ze diagramami struktury białek, aby przyspieszyć odkrycie. Organizacje medialne mogą automatycznie generować podpisy do obrazów lub skrypty wideo.

- Najlepsze w swojej klasie testy porównawcze – Claude 3 wykracza poza istniejące modele standardowych ocen, takich jak problemy matematyczne, ćwiczenia programistyczne i rozumowanie naukowe. Klienci mogą optymalizować procedury eksperymentalne specyficzne dla danej dziedziny w produkcji lub kontrolować raporty finansowe w oparciu o dane kontekstowe, w sposób zautomatyzowany i z dużą dokładnością, korzystając z odpowiedzi opartych na sztucznej inteligencji.

W szczególności Opus przewyższa swoich konkurentów w większości powszechnych kryteriów oceny systemów sztucznej inteligencji, w tym wiedzy eksperckiej na poziomie licencjackim (MMLU), rozumowania eksperckiego na poziomie magisterskim (GPQA), podstawowej matematyki (GSM8K) i nie tylko. Wykazuje wysoki poziom zrozumienia i płynności w wykonywaniu złożonych zadań, co prowadzi do granicy ogólnej inteligencji.

- Zmniejszone halucynacje – Firmy wymagają przewidywalnych, kontrolowanych wyników z systemów AI kierujących zautomatyzowanymi procesami lub interakcjami z klientami. Modele Claude 3 łagodzą halucynacje za pomocą konstytucyjnych technik sztucznej inteligencji, które zapewniają przejrzystość rozumowania modelu, a także poprawiają dokładność. Claude 3 Opus wykazuje szacunkowo 2-krotny wzrost dokładności w porównaniu z Claude 2.1 w przypadku trudnych pytań otwartych, zmniejszając prawdopodobieństwo błędnych odpowiedzi. Ponieważ klienci korporacyjni polegają na Claude w różnych branżach, takich jak opieka zdrowotna, finanse i badania prawne, ograniczenie halucynacji ma kluczowe znaczenie dla bezpieczeństwa i wydajności. Rodzina Claude 3 wyznacza nowy standard niezawodnych, generatywnych wyników AI.

Korzyści z Anthropic Claude 3 FM na Amazon Bedrock

Dzięki Amazon Bedrock klienci uzyskają łatwy dostęp do tworzenia najnowszych modeli Anthropic. Obejmuje to nie tylko modele języka naturalnego, ale także rozszerzoną gamę multimodalnych modeli sztucznej inteligencji, które umożliwiają zaawansowane rozumowanie na podstawie tekstu, obrazów, wykresów i nie tylko. Nasza współpraca pomogła już klientom przyspieszyć wdrażanie generatywnej sztucznej inteligencji i zapewniła im wartość biznesową. Oto kilka sposobów, w jakie klienci korzystają z modeli Claude firmy Anthropic na platformie Amazon Bedrock:

„Opracowujemy generatywne rozwiązanie AI na platformie AWS, aby pomóc klientom planować niesamowite podróże i tworzyć doświadczenia zmieniające życie dzięki spersonalizowanym planom podróży. Budując z Claudem na platformie Amazon Bedrock, obniżyliśmy koszty tworzenia planów podróży o prawie 80%, gdy szybko stworzyliśmy skalowalną, bezpieczną platformę AI, która może uporządkować zawartość naszych książek w ciągu kilku minut, aby zapewnić spójne, bardzo dokładne rekomendacje dotyczące podróży. Teraz możemy na różne sposoby przepakowywać i personalizować nasze treści na naszych platformach cyfrowych, w oparciu o preferencje klientów, jednocześnie podkreślając zaufane lokalne głosy – tak jak robiła to Lonely Planet od 50 lat”.

— Chris Whyde, starszy wiceprezes ds. inżynierii i analityki danych, Lonely Planet

„Współpracujemy z AWS i Anthropic, aby hostować nasz niestandardowy, dopracowany model Anthropic Claude na platformie Amazon Bedrock, aby wspierać naszą strategię szybkiego dostarczania generatywnych rozwiązań AI na dużą skalę i z najnowocześniejszym szyfrowaniem, prywatnością danych i bezpieczną technologią AI wbudowaną w wszystko co robimy. Nasza nowa technologia platformy Lexis+ AI umożliwia wyszukiwanie konwersacyjne, wnikliwe podsumowania i inteligentne możliwości sporządzania projektów dokumentów prawnych, dzięki czemu prawnicy mogą zwiększać swoją wydajność, skuteczność i produktywność”.

— Jeff Reihl, wiceprezes wykonawczy i dyrektor ds. technicznych w firmie LexisNexis Legal & Professional

„W Broadridge pracujemy nad automatyzacją zrozumienia wymogów regulacyjnych w zakresie sprawozdawczości, aby zapewnić większą przejrzystość i zwiększyć efektywność dla naszych klientów działających na krajowych i globalnych rynkach finansowych. Dzięki zastosowaniu Claude na platformie Amazon Bedrock jesteśmy podekscytowani możliwością uzyskania jeszcze większej dokładności w naszych eksperymentach z możliwościami przetwarzania i podsumowywania. Dzięki Amazon Bedrock mamy wybór w zakresie korzystania z LLM i cenimy oferowaną przez nie wydajność i możliwości integracji.

— Saumin Patel, wiceprezes ds. inżynierii generatywnej AI, Broadridge

Rodzina modeli Claude 3 zaspokaja różne potrzeby, umożliwiając klientom wybór modelu najlepiej dopasowanego do ich konkretnego przypadku użycia, co jest kluczem do opracowania udanego prototypu i późniejszych systemów produkcyjnych, które mogą wywrzeć rzeczywisty wpływ – niezależnie od tego, czy chodzi o nowy produkt, funkcję czy proces, który zwiększa zyski. Mając na uwadze potrzeby klientów, Anthropic i AWS dostarczają organizacjom każdej wielkości tam, gdzie jest to najważniejsze:

- Zwiększona wydajność – Modele Claude 3 są znacznie szybsze w przypadku interakcji w czasie rzeczywistym dzięki optymalizacji sprzętu i oprogramowania.

- Zwiększona dokładność i niezawodność – Dzięki ogromnemu skalowaniu i nowym technikom samonadzoru oczekiwany dwukrotny wzrost dokładności w przypadku złożonych pytań w długich kontekstach oznacza, że sztuczna inteligencja jest jeszcze bardziej pomocna, bezpieczna i uczciwa.

- Prostsza i bezpieczna personalizacja – Możliwości dostosowywania, takie jak generowanie wspomagane wyszukiwaniem (RAG), upraszczają modele szkoleniowe na zastrzeżonych danych i budują aplikacje oparte na różnorodnych źródłach danych, dzięki czemu klienci mogą uzyskać sztuczną inteligencję dostosowaną do ich unikalnych potrzeb. Ponadto zastrzeżone dane nigdy nie są udostępniane w publicznym Internecie, nigdy nie opuszczają sieci AWS, są bezpiecznie przesyłane przez VPC i są szyfrowane podczas przesyłania i przechowywania.

AWS i Anthropic stale potwierdzają nasze zaangażowanie w rozwój generatywnej sztucznej inteligencji w odpowiedzialny sposób. Poprzez ciągłe doskonalenie możliwości modelu, angażując się w frameworki takie jak Konstytucyjna sztuczna inteligencja albo Dobrowolne zobowiązania Białego Domu dotyczące sztucznej inteligencjimożemy przyspieszyć bezpieczny i etyczny rozwój i wdrażanie tej rewolucyjnej technologii.

Przyszłość generatywnej sztucznej inteligencji

Patrząc w przyszłość, klienci będą tworzyć zupełnie nowe kategorie generatywnych aplikacji i doświadczeń opartych na sztucznej inteligencji, korzystając z modeli najnowszej generacji. Dopiero zaczęliśmy wykorzystywać potencjał generatywnej sztucznej inteligencji do automatyzacji złożonych procesów, zwiększania wiedzy ludzkiej i przekształcania doświadczeń cyfrowych. Oczekujemy bezprecedensowego poziomu innowacji, gdy klienci będą wybierać modele Anthropic rozszerzone o umiejętności multimodalne z wykorzystaniem wszystkich narzędzi potrzebnych do tworzenia i skalowania generatywnych aplikacji AI na Amazon Bedrock. Wyobraź sobie wyrafinowanych asystentów konwersacyjnych zapewniających szybkie i kontekstowe odpowiedzi oraz spersonalizowane silniki rekomendacji obrazowych, które płynnie łączą się z odpowiednimi obrazami, diagramami i powiązaną wiedzą, aby intuicyjnie kierować decyzjami. Wyobraź sobie badania naukowe napędzane generatywną sztuczną inteligencją zdolną do odczytywania eksperymentów, syntezowania hipotez, a nawet proponowania nowych obszarów do eksploracji. Jest tak wiele możliwości, które zostaną zrealizowane dzięki pełnemu wykorzystaniu wszystkich możliwości generatywnej sztucznej inteligencji, jakie ma do zaoferowania Amazon Bedrock. Dzięki naszej współpracy przedsiębiorstwa i innowatorzy na całym świecie będą dysponować narzędziami, które pozwolą im w sposób odpowiedzialny i z korzyścią dla wszystkich osiągnąć kolejny poziom generatywnych innowacji opartych na sztucznej inteligencji.

Wnioski

To wciąż dopiero początek rozwoju generatywnej sztucznej inteligencji, ale ścisła współpraca i skupienie się na innowacjach rozpoczynają nową erę generatywnej sztucznej inteligencji w AWS. Nie możemy się doczekać, aby zobaczyć, co klienci zbudują dalej.

Zasoby

Aby dowiedzieć się więcej na temat tego ogłoszenia, zapoznaj się z następującymi zasobami:

O autorze

Swami Śiwasubramanian jest wiceprezesem ds. danych i uczenia maszynowego w AWS. W tej roli Swami nadzoruje wszystkie usługi AWS Database, Analytics oraz AI i Machine Learning. Misją jego zespołu jest pomoc organizacjom we wdrażaniu danych do pracy dzięki kompletnemu, kompleksowemu rozwiązaniu do przechowywania, uzyskiwania dostępu, analizowania, wizualizacji i przewidywania danych.

Swami Śiwasubramanian jest wiceprezesem ds. danych i uczenia maszynowego w AWS. W tej roli Swami nadzoruje wszystkie usługi AWS Database, Analytics oraz AI i Machine Learning. Misją jego zespołu jest pomoc organizacjom we wdrażaniu danych do pracy dzięki kompletnemu, kompleksowemu rozwiązaniu do przechowywania, uzyskiwania dostępu, analizowania, wizualizacji i przewidywania danych.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/unlocking-innovation-aws-and-anthropic-push-the-boundaries-of-generative-ai-together/

- :ma

- :Jest

- :nie

- :Gdzie

- 1

- 100

- 10 tysięcy

- 10K klientów

- 2021

- 2023

- 28

- 50

- 50 Lata

- 7

- 8

- a

- zdolności

- Zdolny

- O nas

- przyśpieszyć

- dostęp

- dostępny

- precyzja

- dokładny

- w poprzek

- dodatek

- Przyjęcie

- zaawansowany

- postęp

- Korzyść

- przed

- AI

- AI i uczenie maszynowe

- Modele AI

- Platforma AI

- Systemy SI

- Zasilany AI

- Wszystkie kategorie

- Pozwalać

- wzdłuż

- już

- również

- Amazonka

- Amazon Web Services

- an

- analiza

- analityka

- w czasie rzeczywistym sprawiają,

- i

- Zapowiedź

- Ogłaszając

- Antropiczny

- aplikacje

- SĄ

- obszary

- AS

- asystenci

- powiązany

- At

- Audyt

- zwiększać

- zwiększona

- zautomatyzować

- zautomatyzowane

- automatycznie

- Automatyzacja

- dostępny

- AWS

- z powrotem

- poparła

- Bilans

- na podstawie

- podstawowy

- BE

- stał

- być

- zaczął

- Benchmarki

- korzyści

- BEST

- pomiędzy

- Mieszanka

- książka

- zwiększa

- Dolny

- Granice

- Broadridge

- budować

- Budowanie

- biznes

- biznes

- ale

- by

- CAN

- Rak

- możliwości

- zdolny

- podpisy

- walizka

- Etui

- kategorie

- caters

- Wykresy

- wybór

- Dodaj

- Chris

- Chmura

- Kodowanie

- spoisty

- współpraca

- przyjście

- zobowiązanie

- zobowiązania

- zobowiązanie się

- wspólny

- kompaktowy

- Firmy

- porównywalny

- kompletny

- kompleks

- stale

- zawartość

- konteksty

- kontekstowy

- bez przerwy

- konwersacyjny

- opłacalne

- Koszty:

- mógłby

- Stwórz

- stworzony

- krytyczny

- CTO

- Aktualny

- zwyczaj

- klient

- Klientów

- dostosowywanie

- pionierski nowatorski

- dane

- prywatność danych

- nauka danych

- Baza danych

- Dni

- Decyzje

- głęboko

- dostarczyć

- dostarczona

- dostarczanie

- wymagający

- Wdrożenie

- rozwijanie

- oprogramowania

- schematy

- różne

- trudny

- cyfrowy

- kierowniczy

- odkrycie

- inny

- do

- domena

- Krajowy

- zrobić

- napęd

- lek

- Wcześnie

- łatwo

- skuteczność

- efektywność

- osadzone

- umożliwiać

- Umożliwia

- szyfrowane

- szyfrowanie

- koniec końców

- Inżynieria

- silniki

- Anglia

- zapewnia

- Enterprise

- przedsiębiorstwa

- całkowicie

- wyobrażać sobie

- przewidywane

- EPICKI

- Era

- szczególnie

- niezbędny

- szacunkowa

- etyczny

- ewaluację

- oceny

- Parzyste

- wszystko

- przekracza

- ekscytujący

- wykonawczy

- eksponaty

- Przede wszystkim system został opracowany

- rozszerzony

- oczekiwać

- spodziewany

- Doświadczenia

- eksperymentalny

- eksperymenty

- ekspert

- ekspertyza

- eksploracja

- narażony

- członków Twojej rodziny

- FAST

- szybciej

- najszybszy

- wadliwy

- Cecha

- Korzyści

- kilka

- finansować

- budżetowy

- i terminów, a

- Skupiać

- następujący

- W razie zamówieenia projektu

- Prognozy

- Fundacja

- Ramy

- od

- Granica

- pełny

- przyszłość

- Wzrost

- Zyski

- Ogólne

- ogólna inteligencja

- ogólnie

- Generować

- generacja

- generatywny

- generatywna sztuczna inteligencja

- genomika

- otrzymać

- Globalne

- globalne finanse

- absolwent

- wykresy

- większy

- poprowadzi

- sprzęt komputerowy

- Have

- opieki zdrowotnej

- pomoc

- pomógł

- pomocny

- tutaj

- Wysoki

- wydajny

- wyższy

- podświetlanie

- wysoko

- jego

- Hologram

- uczciwy

- gospodarz

- dom

- W jaki sposób

- HTTPS

- człowiek

- idealny

- obraz

- zdjęcia

- obraz

- podnieść

- poprawy

- in

- obejmuje

- Włącznie z

- Zwiększać

- przemysłowa

- Innowacja

- innowatorzy

- wnikliwy

- przykład

- Instytut

- Integracja

- integracja

- Inteligencja

- Inteligentny

- Interakcje

- Internet

- najnowszych

- Intuit

- IT

- JEGO

- właśnie

- konserwacja

- Klawisz

- wiedza

- język

- duży

- później

- firmy

- Prawnicy

- prowadzący

- UCZYĆ SIĘ

- nauka

- Regulamin

- pozwala

- poziom

- poziomy

- Dźwignia

- lewarowanie

- LexisNexis

- lubić

- prawdopodobieństwo

- Linia

- LLM

- miejscowy

- długo

- poszukuje

- maszyna

- uczenie maszynowe

- Większość

- Dokonywanie

- sposób

- produkcja

- wiele

- rynek

- rynki

- masywny

- matematyka

- matematyka

- Matters

- oznaczać

- Media

- kamień milowy

- nic

- minut

- Misja

- Złagodzić

- model

- modele

- miesięcy

- jeszcze

- większość

- multimedialny

- Naturalny

- Nawigacja

- prawie

- Potrzebować

- wymagania

- sieć

- nigdy

- Nowości

- nowy produkt

- Najnowszy

- Następny

- Nie

- powieść

- już dziś

- of

- oferta

- Oferty

- on

- ONE

- tylko

- operacyjny

- optymalizacje

- Optymalizacja

- zoptymalizowane

- or

- organizacji

- Inne

- ludzkiej,

- na zewnątrz

- Przewyższa

- wydajność

- Wyjścia

- koniec

- Papiery

- Tracker

- procent

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- personalizować

- Personalizowany

- Przemysł farmaceutyczny

- obraz

- Miejsce

- krok po kroku

- planeta

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- możliwości

- potencjał

- przewidzieć

- prezydent

- prywatność

- Problem

- problemy

- procedury

- wygląda tak

- procesów

- przetwarzanie

- Produkt

- Produkcja

- wydajność

- Programowanie

- monity

- zaproponować

- własność

- Białko

- Proto

- prototyp

- zapewniać

- że

- publiczny

- Naciskać

- położyć

- cechy

- pytanie

- pytania

- szybko

- szmata

- zasięg

- szybki

- szybko

- dosięgnąć

- Czytaj

- potwierdzając

- real

- w czasie rzeczywistym

- realizowany

- Rekomendacja

- zalecenia

- Zredukowany

- redukcja

- regulacyjne

- rzetelny

- polegać

- znakomity

- Raportowanie

- Raporty

- wymagać

- wymagania

- Badania naukowe

- przefasonować

- Zasoby

- Odpowiedzi

- odpowiedzialny

- odpowiedzialnie

- REST

- wyszukiwanie

- Rakieta

- Rola

- "bezpiecznym"

- Bezpieczeństwo

- sole

- skalowalny

- Skala

- skalowaniem

- scenariusze

- nauka

- naukowy

- skrypty

- płynnie

- Szukaj

- bezpieczne

- bezpiecznie

- widzieć

- senior

- wrzesień

- Usługi

- Zestawy

- Short

- Targi

- znacznie

- upraszczać

- ponieważ

- rozmiary

- umiejętności

- So

- Tworzenie

- rozwiązanie

- Rozwiązania

- Rozwiązywanie

- wyrafinowany

- Źródła

- specyficzny

- prędkość

- standard

- rozpoczęty

- state-of-the-art

- Nadal

- sklep

- Strategia

- Strajki

- silny

- Struktura

- zbudowany

- udany

- taki

- sugerować

- wsparcie

- syntetyzują

- systemy

- biorąc

- Stuknij

- Zadanie

- zadania

- Techniki

- Technologia

- XNUMX

- niż

- Podziękowania

- że

- Połączenia

- ich

- Im

- Tam.

- one

- to

- trzy

- wstrząśnięty

- Przez

- do

- już dziś

- razem

- narzędzia

- Top

- najwyższy poziom

- przeszkolony

- Trening

- przeniesione

- transformacyjny

- tranzyt

- Przezroczystość

- podróżować

- naprawdę

- zaufany

- tuned

- zrozumieć

- zrozumienie

- wyjątkowy

- odblokowywanie

- bez precedensu

- nieuporządkowany

- odsłonięcie

- nadający się do użytku

- posługiwać się

- przypadek użycia

- używany

- wprowadzenie

- za pomocą

- wartość

- różnorodność

- różnorodny

- Naprawiono

- wice

- Wiceprezes

- Wideo

- wyobrażać sobie

- dobrowolny

- vp

- czekać

- Droga..

- sposoby

- we

- sieć

- usługi internetowe

- DOBRZE

- Co

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- będzie

- w

- słowo

- Praca

- pracujący

- na calym swiecie

- by

- lat

- zefirnet