Amazon SageMaker Administrator danych to narzędzie do przygotowywania danych oparte na interfejsie użytkownika, które pomaga przeprowadzać analizę danych, wstępne przetwarzanie i wizualizację z funkcjami umożliwiającymi szybsze czyszczenie, przekształcanie i przygotowywanie danych. Gotowe szablony przepływów Data Wrangler przyspieszają przygotowywanie danych dla naukowców zajmujących się danymi i praktyków uczenia maszynowego (ML), pomagając przyspieszyć i zrozumieć wzorce najlepszych praktyk dla przepływów danych przy użyciu typowych zestawów danych.

Przepływów Data Wrangler można używać do wykonywania następujących zadań:

- Wizualizacja danych - Badanie właściwości statystycznych dla każdej kolumny w zbiorze danych, tworzenie histogramów, badanie wartości odstających

- Czyszczenie danych – Usuwanie duplikatów, upuszczanie lub uzupełnianie wpisów brakującymi wartościami, usuwanie odstających

- Wzbogacanie danych i inżynieria funkcji - Przetwarzanie kolumn w celu tworzenia bardziej wyrazistych funkcji, wybieranie podzbioru funkcji do szkolenia

Ten post pomoże Ci zrozumieć Data Wrangler za pomocą następujących przykładowych gotowych przepływów na GitHub. Repozytorium przedstawia transformacje danych tabelarycznych, transformacje danych szeregów czasowych i transformacje połączonych zestawów danych. Każda z nich wymaga innego rodzaju przekształceń ze względu na ich podstawowy charakter. Standardowe dane tabelaryczne lub przekrojowe są gromadzone w określonym momencie. Natomiast dane szeregów czasowych są rejestrowane wielokrotnie w czasie, a każdy kolejny punkt danych jest zależny od jego przeszłych wartości.

Spójrzmy na przykład, jak możemy użyć przykładowego przepływu danych dla danych tabelarycznych.

Wymagania wstępne

Poskramiacz danych jest Amazon Sage Maker funkcja dostępna w ciągu Studio Amazon SageMaker, więc musimy postępować zgodnie z procesem dołączania do Studio, aby uruchomić środowisko Studio i notatniki. Chociaż możesz wybrać jedną z kilku metod uwierzytelniania, najprostszym sposobem utworzenia domeny Studio jest przestrzeganie Szybki start instrukcje. Szybki start używa tych samych ustawień domyślnych, co standardowa konfiguracja studia. Możesz także wybrać opcję na pokładzie za pomocą Centrum tożsamości AWS IAM (następca AWS Single Sign-On) w celu uwierzytelnienia (patrz Włączenie do domeny Amazon SageMaker za pomocą IAM Identity Center).

Zaimportuj zbiór danych i pliki przepływu do Data Wranglera za pomocą Studio

Poniższe kroki opisują sposób importowania danych do programu SageMaker do wykorzystania przez Data Wrangler:

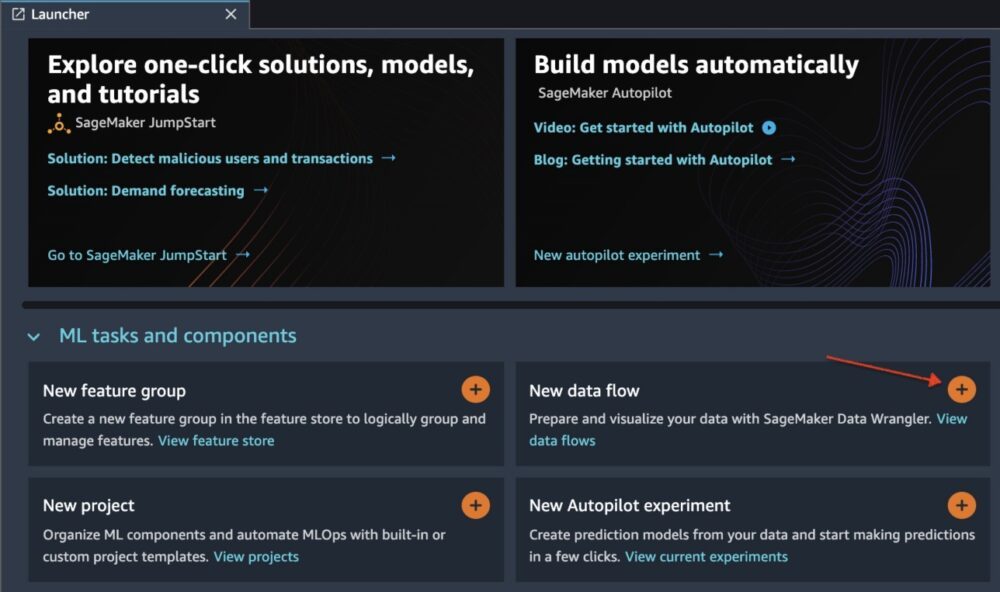

Zainicjuj Data Wranglera za pomocą interfejsu użytkownika Studio, wybierając Nowy przepływ danych.

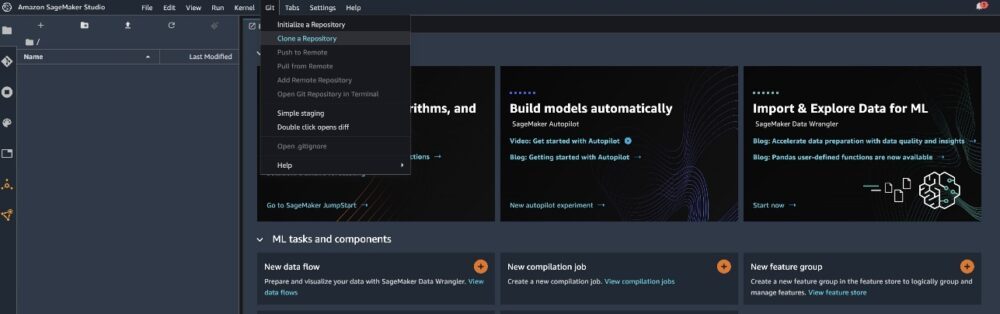

Sklonuj GitHub repo aby pobrać pliki przepływu do środowiska Studio.

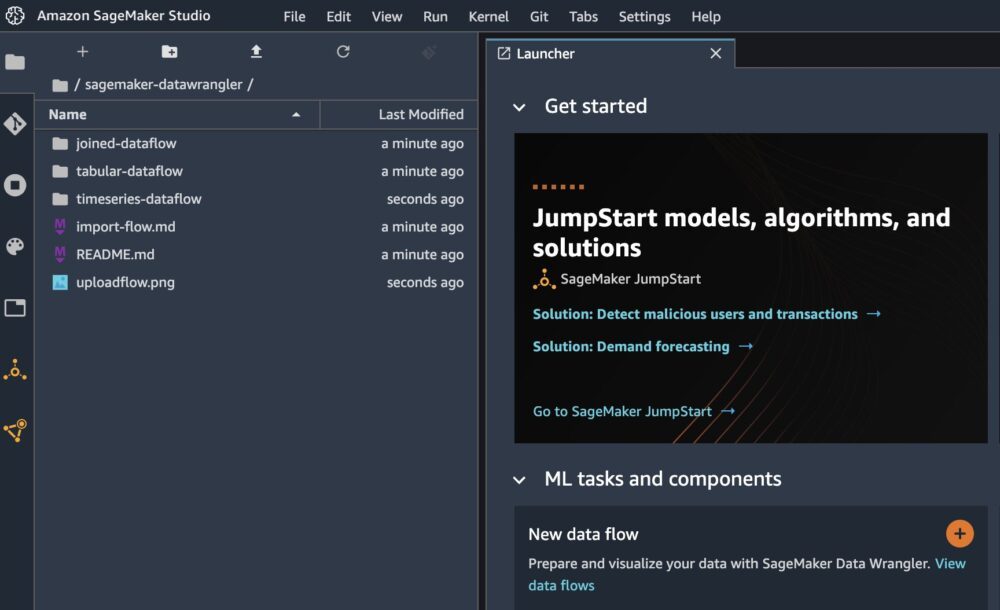

Po zakończeniu klonowania powinieneś być w stanie zobaczyć zawartość repozytorium w lewym okienku.

Wybierz plik Hotel-Rezerwacje-Klasyfikacja.flow aby zaimportować plik przepływu do Data Wrangler.

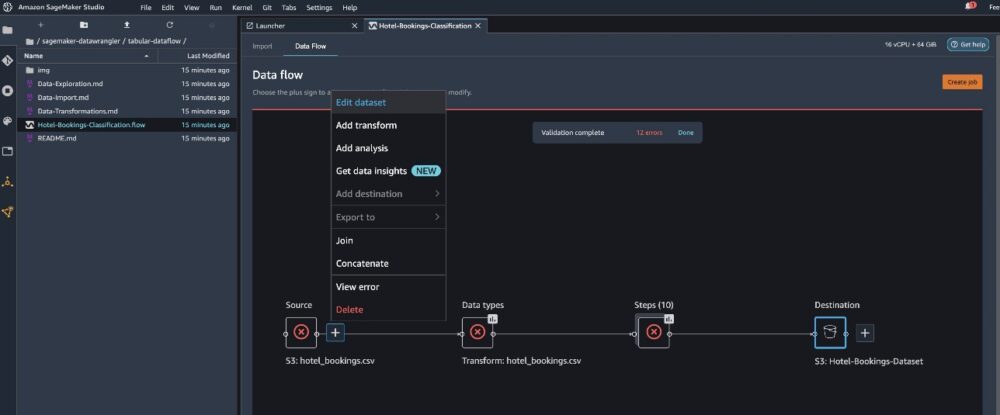

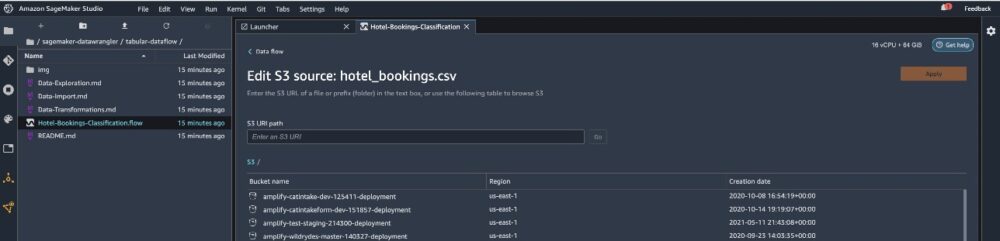

Jeśli używasz serii czasowej lub połączonego przepływu danych, przepływ będzie wyświetlany pod inną nazwą. Po zaimportowaniu przepływu powinieneś zobaczyć następujący zrzut ekranu. To pokazuje nam błędy, ponieważ musimy upewnić się, że plik przepływu wskazuje prawidłowe źródło danych w Usługa Amazon Simple Storage (Amazonka S3).

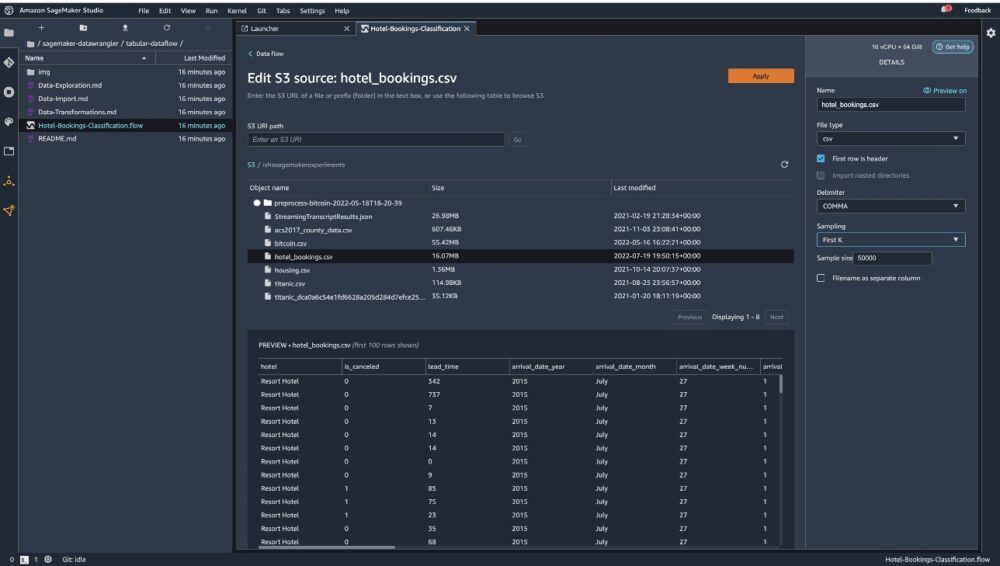

Dodaj Edytuj zbiór danych aby wyświetlić wszystkie wiadra S3. Następnie wybierz zbiór danych hotel_bookings.csv z wiadra S3 do biegania przez tabelaryczny przepływ danych.

Pamiętaj, że jeśli używasz połączony przepływ danych, może być konieczne zaimportowanie wielu zestawów danych do Data Wranglera

W prawym okienku upewnij się, że USTĘP jest wybrany jako ogranicznik i Próbowanie jest ustawione na Pierwszy K. Nasz zestaw danych jest wystarczająco mały, aby uruchomić przekształcenia Data Wrangler na pełnym zestawie danych, ale chcieliśmy podkreślić, jak można zaimportować zestaw danych. Jeśli masz duży zbiór danych, rozważ użycie próbkowania. Wybierać import aby zaimportować ten zbiór danych do Data Wrangler.

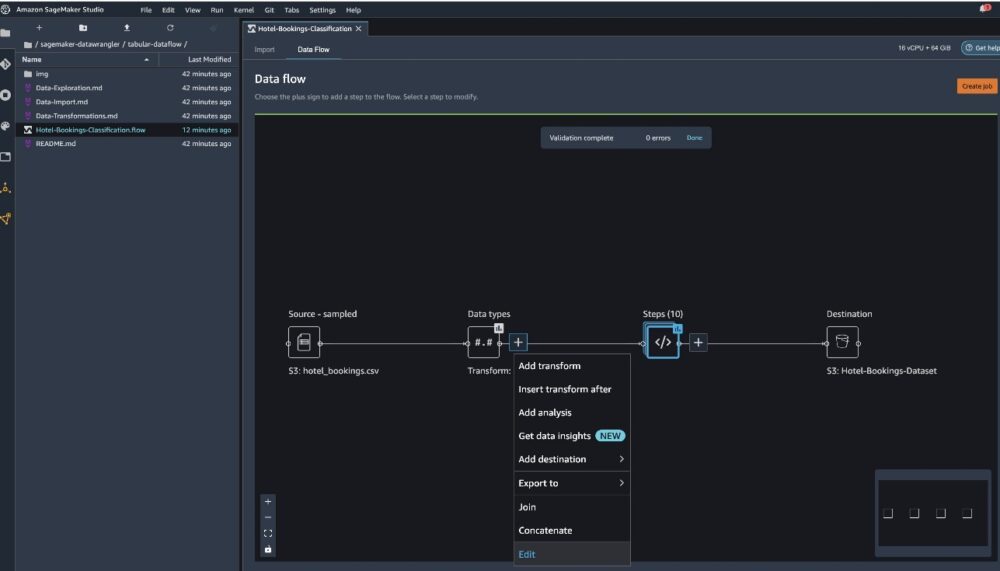

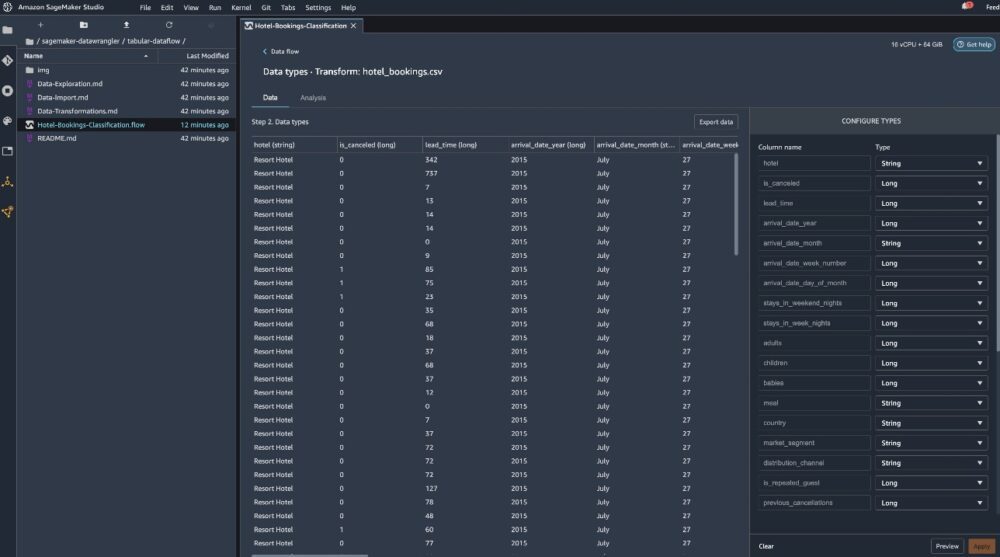

Po zaimportowaniu zestawu danych Data Wrangler automatycznie sprawdza poprawność zestawu danych i wykrywa typy danych. Widać, że błędy zniknęły, ponieważ wskazujemy poprawny zbiór danych. Edytor przepływu pokazuje teraz dwa bloki pokazujące, że dane zostały zaimportowane ze źródła i rozpoznane typy danych. W razie potrzeby możesz również edytować typy danych.

Poniższy zrzut ekranu przedstawia nasze typy danych.

Przyjrzyjmy się niektórym przekształceniom wykonanym w ramach tego przepływu tabelarycznego. Jeśli używasz szereg czasowy or Dołączył przepływy danych, sprawdź kilka typowych przekształceń na GitHub repo. Przeprowadziliśmy kilka podstawowych eksploracyjnych analiz danych przy użyciu raportów szczegółowych danych, które badały docelowe wycieki i współliniowość funkcji w zestawie danych, analizy podsumowujące tabele i możliwości szybkiego modelowania. Poznaj kroki na GitHub repo.

Teraz usuwamy kolumny na podstawie zaleceń dostarczonych przez raport analizy danych i jakości.

- W przypadku wycieku docelowego upuść stan_rezerwacji.

- W przypadku nadmiarowych kolumn upuść days_in_waiting_list, hotel, reserved_room_type, arrival_date_month, reservation_status_date, niemowlęta, i data_przybycia_dzień_miesiąca.

- Na podstawie wyników korelacji liniowej upuść kolumny data_przybycia_numer_tygodnia i data_przybycia_rok ponieważ wartości korelacji dla tych par cech (kolumn) są większe niż zalecany próg 0.90.

- Na podstawie wyników korelacji nieliniowej, spadek stan_rezerwacji. Ta kolumna została już oznaczona do usunięcia na podstawie docelowej analizy wycieku.

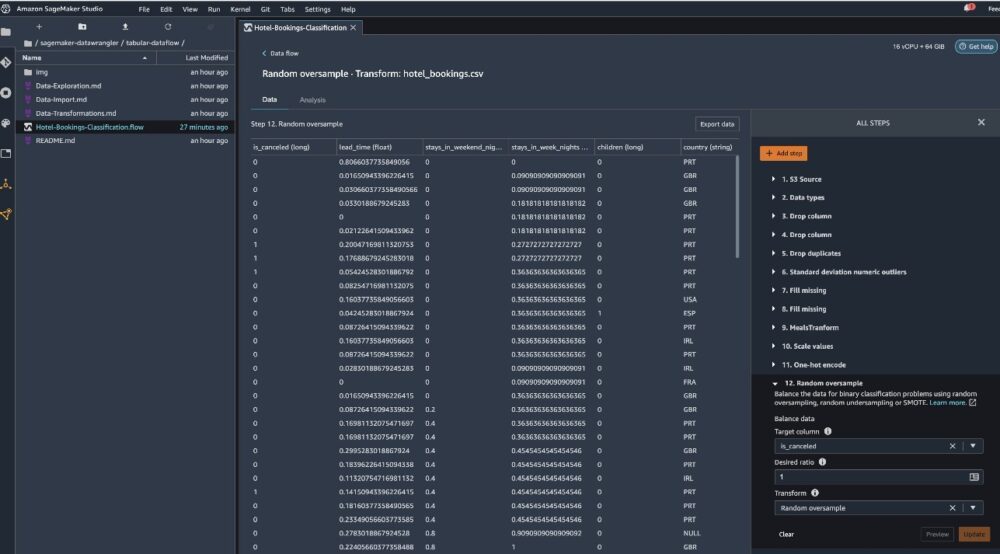

- Przetwarzaj wartości liczbowe (skalowanie min-maks) dla lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_cancelled, booking_changes, adr, total_of_specical_requests, i wymagane_miejsca_parkingowe_samochodowe.

- Jeden gorący koduje zmienne kategoryczne, takie jak posiłek, jest_powtarzanym_gościem, segmentem_rynku, przypisanym_typem_pokoju, typem_depozytu, i typ klienta.

- Zrównoważ zmienną docelową Losowe nadpróbkowanie dla braku równowagi w klasie. Użyj funkcji szybkiego modelowania, aby poradzić sobie z wartościami odstającymi i brakami danych.

Eksport do Amazon S3

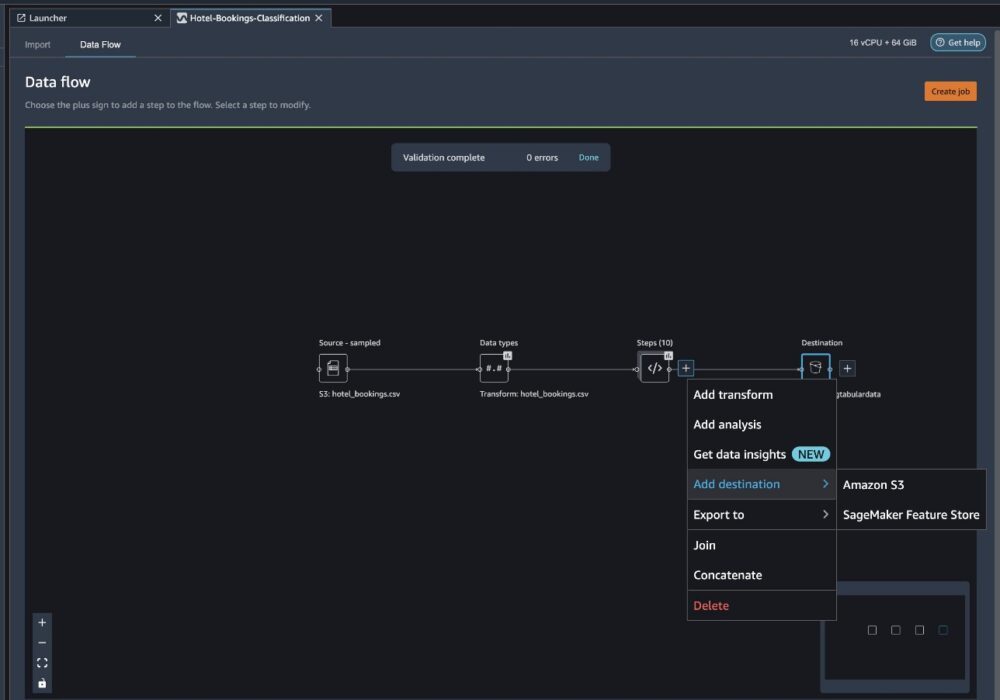

Teraz przeszliśmy przez różne transformacje i jesteśmy gotowi do wyeksportowania danych do Amazon S3. Ta opcja tworzy zadanie przetwarzania SageMaker, które uruchamia przepływ przetwarzania Data Wrangler i zapisuje wynikowy zestaw danych w określonym zasobniku S3. Wykonaj następujące kroki, aby skonfigurować eksport do Amazon S3:

Wybierz znak plus obok kolekcji elementów transformacji i wybierz Dodaj miejsce docelowe, następnie Amazon S3.

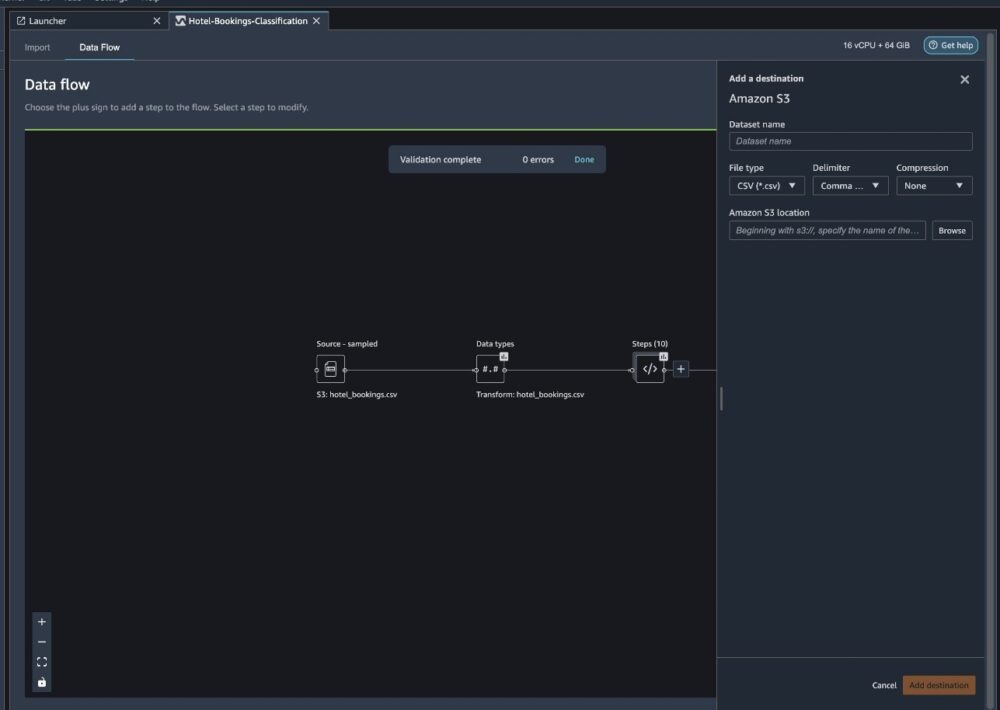

- W razie zamówieenia projektu Nazwa zestawu danych, wprowadź nazwę nowego zbioru danych, na przykład

NYC_export. - W razie zamówieenia projektu Typ plikuwybierz CSV.

- W razie zamówieenia projektu Ogranicznikwybierz Przecinek.

- W razie zamówieenia projektu Kompresjawybierz żaden.

- W razie zamówieenia projektu Lokalizacja Amazon S3, użyj tej samej nazwy zasobnika, którą utworzyliśmy wcześniej.

- Dodaj Dodaj miejsce docelowe.

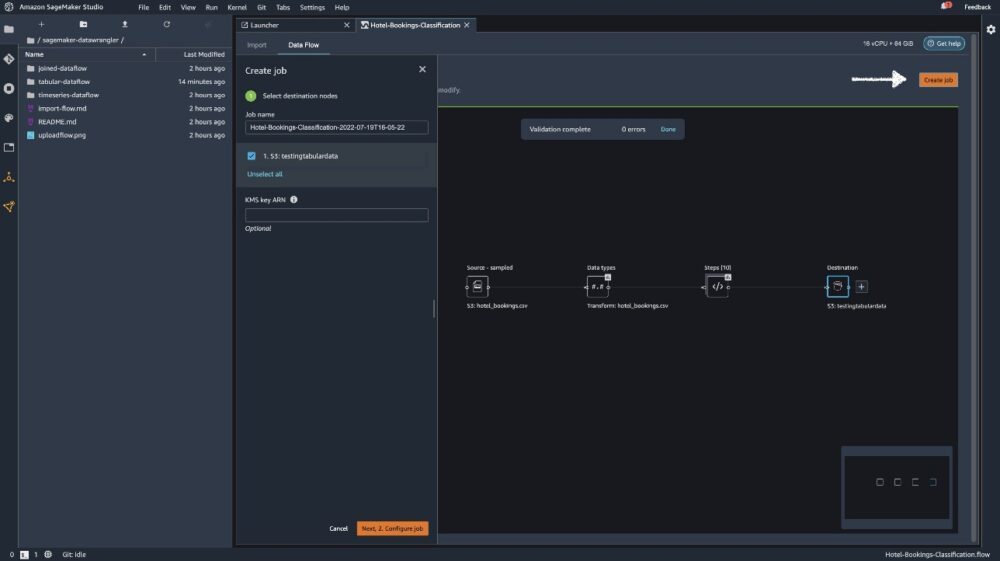

Dodaj Utwórz pracę.

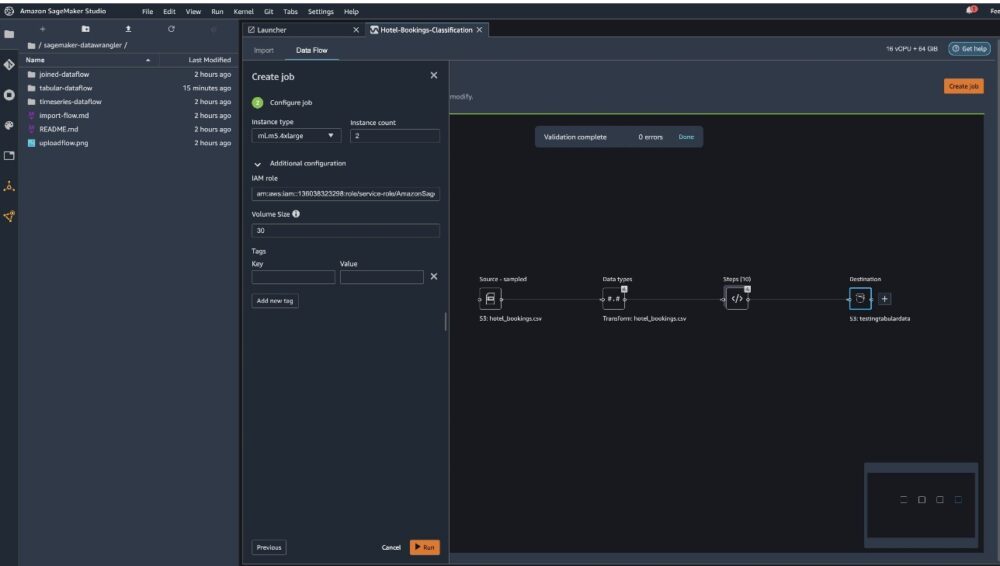

W razie zamówieenia projektu Nazwa pracy, wpisz nazwę lub zachowaj opcję generowaną automatycznie i wybierz miejsce przeznaczenia. Mamy tylko jeden cel, S3:testingtabulardata, ale możesz mieć wiele miejsc docelowych z różnych etapów przepływu pracy. Zostawić Klucz KMS ARN pole puste i wybierz Następna.

Teraz musisz skonfigurować moc obliczeniową zadania. W tym przykładzie możesz zachować wszystkie wartości domyślne.

- W razie zamówieenia projektu Typ instancji, użyj ml.m5.4xduże.

- W razie zamówieenia projektu Liczba instancji, użyj 2.

- Możesz odkrywać Dodatkowa konfiguracja, ale zachowaj ustawienia domyślne.

- Dodaj run.

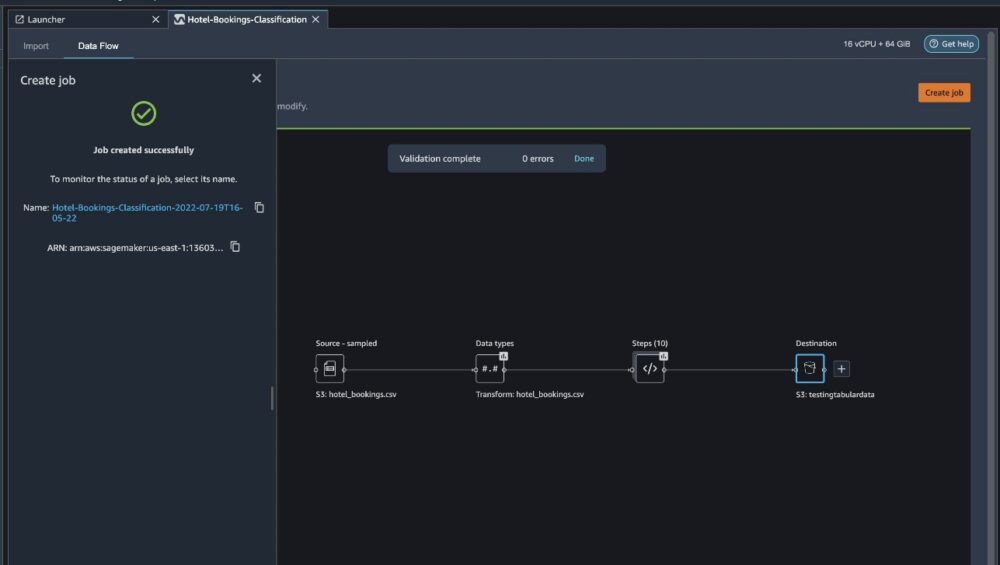

Teraz Twoja praca się rozpoczęła, a przetworzenie 6 GB danych zgodnie z naszym przepływem przetwarzania Data Wrangler zajmuje trochę czasu. Koszt tej pracy wyniesie około 2 USD, ponieważ ml.m5.4xlarge kosztuje 0.922 USD za godzinę i używamy dwóch z nich.

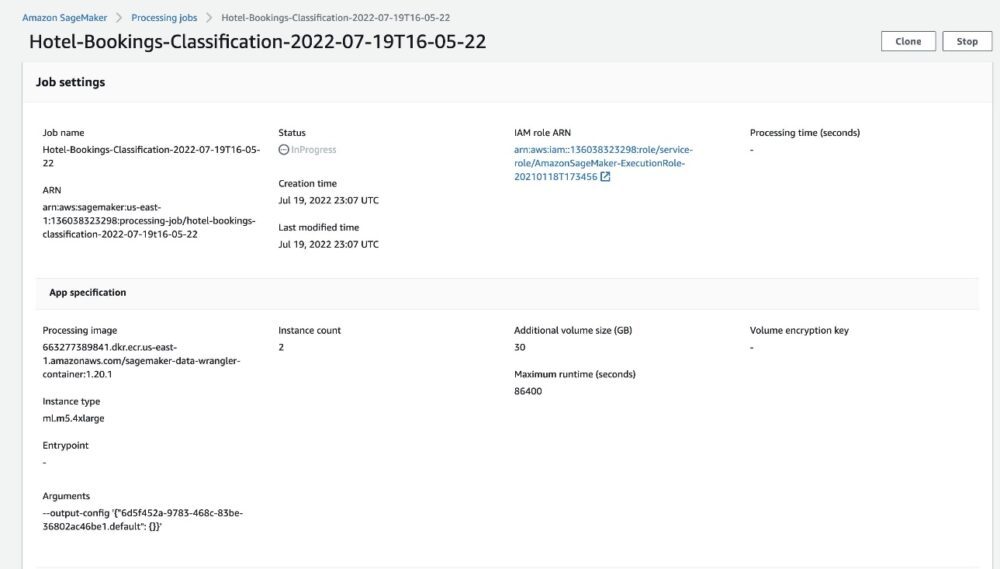

Jeśli wybierzesz nazwę pracy, zostaniesz przekierowany do nowego okna ze szczegółami pracy.

Na stronie szczegółów zadania możesz zobaczyć wszystkie parametry z poprzednich kroków.

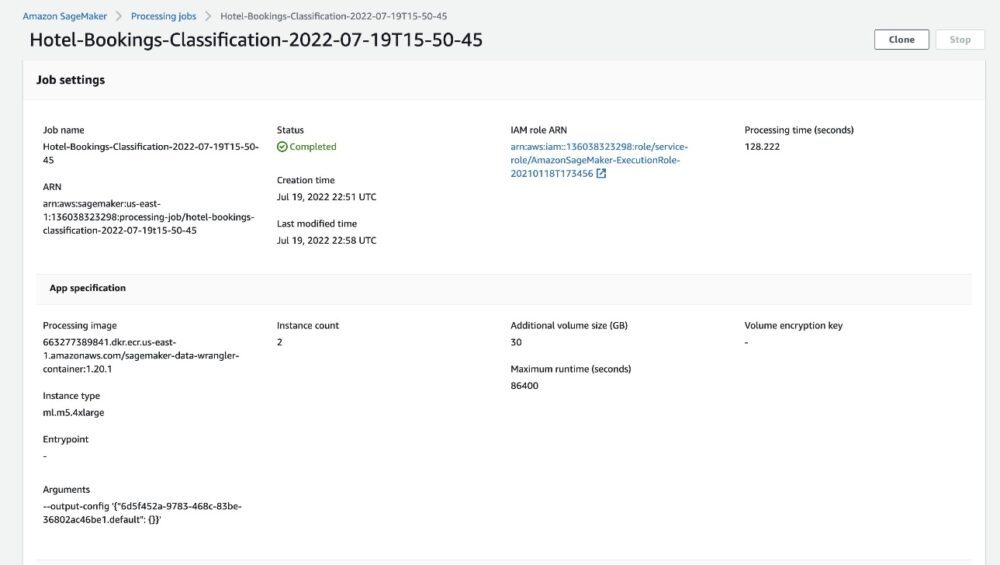

Gdy status zadania zmieni się na Ukończone, możesz również sprawdzić Czas przetwarzania (sekundy) wartość. To zadanie przetwarzania zajmuje około 5–10 minut.

Po zakończeniu zadania pliki wyjściowe szkolenia i testowania są dostępne w odpowiednich folderach wyjściowych S3. Lokalizację wyjściową można znaleźć w konfiguracjach zadań przetwarzania.

Po zakończeniu zadania przetwarzania Data Wrangler możemy sprawdzić wyniki zapisane w naszym kubełku S3. Nie zapomnij zaktualizować job_name zmienna z nazwą Twojej pracy.

Możesz teraz używać tych wyeksportowanych danych do uruchamiania modeli ML.

Sprzątać

Usuń swoje zasobniki S3 I twój Przepływ danych Wranglera w celu usunięcia podstawowych zasobów i uniknięcia niepożądanych kosztów po zakończeniu eksperymentu.

Wnioski

W tym poście pokazaliśmy, jak zaimportować wstępnie zbudowany przepływ danych tabelarycznych do Data Wrangler, podłączyć go do naszego zestawu danych i wyeksportować wyniki do Amazon S3. Jeśli Twoje przypadki użycia wymagają manipulowania danymi szeregów czasowych lub łączenia wielu zestawów danych, możesz przejrzeć inne wstępnie utworzone przepływy próbek w GitHub repo.

Po zaimportowaniu gotowego przepływu pracy przygotowania danych możesz zintegrować go z Amazon SageMaker Processing, Rurociągi Amazon SageMaker, Sklep funkcji Amazon SageMaker uprościć zadanie przetwarzania, udostępniania i przechowywania danych szkoleniowych ML. Możesz również wyeksportować ten przykładowy przepływ danych do skryptu języka Python i utworzyć niestandardowy potok przygotowania danych ML, przyspieszając w ten sposób szybkość wydawania.

Zachęcamy do zapoznania się z naszymi Repozytorium GitHub aby zdobyć praktyczną praktykę i znaleźć nowe sposoby na poprawę dokładności modelu! Aby dowiedzieć się więcej o SageMakerze, odwiedź Przewodnik dla programistów Amazon SageMaker.

O autorach

Isza Dua jest starszym architektem rozwiązań z siedzibą w San Francisco Bay Area. Pomaga klientom AWS Enterprise rozwijać się, rozumiejąc ich cele i wyzwania, a także prowadzi ich, jak mogą zaprojektować swoje aplikacje w sposób natywny dla chmury, jednocześnie upewniając się, że są odporne i skalowalne. Jej pasją są technologie uczenia maszynowego i zrównoważony rozwój środowiska.

Isza Dua jest starszym architektem rozwiązań z siedzibą w San Francisco Bay Area. Pomaga klientom AWS Enterprise rozwijać się, rozumiejąc ich cele i wyzwania, a także prowadzi ich, jak mogą zaprojektować swoje aplikacje w sposób natywny dla chmury, jednocześnie upewniając się, że są odporne i skalowalne. Jej pasją są technologie uczenia maszynowego i zrównoważony rozwój środowiska.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Amazon Sage Maker

- Pogromca danych Amazon SageMaker

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- zefirnet