Hoje, temos o prazer de anunciar que o modelo de base Falcon 180B desenvolvido pelo Technology Innovation Institute (TII) e treinado no Amazon SageMaker está disponível para clientes por meio de JumpStart do Amazon SageMaker para implantar com um clique para executar inferência. Com um tamanho de 180 bilhões de parâmetros e treinado em um enorme conjunto de dados de 3.5 trilhões de tokens, o Falcon 180B é o maior e um dos modelos de maior desempenho com pesos abertamente acessíveis. Você pode experimentar este modelo com o SageMaker JumpStart, um hub de aprendizado de máquina (ML) que fornece acesso a algoritmos, modelos e soluções de ML para que você possa começar a usar o ML rapidamente. Nesta postagem, explicamos como descobrir e implantar o modelo Falcon 180B por meio do SageMaker JumpStart.

O que é o Falcão 180B

Falcon 180B é um modelo lançado pela IIT que segue os lançamentos anteriores da família Falcon. É uma versão ampliada do Falcon 40B e usa atenção de múltiplas consultas para melhor escalabilidade. É um modelo de linguagem auto-regressivo que usa uma arquitetura de transformador otimizada. Ele foi treinado em 3.5 trilhões de tokens de dados, consistindo principalmente de dados da web de RefinadoWeb (aproximadamente 85%). O modelo possui duas versões: 180B e 180B-Chat. 180B é um modelo bruto e pré-treinado, que deve ser ainda mais ajustado para a maioria dos casos de uso. O 180B-Chat é mais adequado para receber instruções genéricas. O modelo de bate-papo foi ajustado em conjuntos de dados de bate-papo e instruções, juntamente com vários conjuntos de dados de conversação em grande escala.

O modelo é disponibilizado sob o Licença Falcon-180B TII e Política de Utilização Aceitável.

O Falcon 180B foi treinado pela TII em Amazon Sage Maker, em um cluster de aproximadamente GPUs A4 de 100K. Ele usou uma base de código de treinamento distribuída personalizada chamada Gigatron, que usa paralelismo 3D com ZeRO e kernels Triton personalizados e de alto desempenho. A arquitetura de treinamento distribuída usada Serviço de armazenamento simples da Amazon (Amazon S3) como o único serviço unificado para carregamento de dados e gravação e leitura de pontos de verificação, o que contribuiu particularmente para a confiabilidade da carga de trabalho e simplicidade operacional.

O que é o SageMaker JumpStart

Com o SageMaker JumpStart, os profissionais de ML podem escolher entre uma lista crescente de modelos básicos de melhor desempenho. Os profissionais de ML podem implantar modelos básicos em instâncias dedicadas do SageMaker em um ambiente isolado de rede e personalizar modelos usando o Amazon SageMaker para treinamento e implantação de modelos.

Agora você pode descobrir e implantar o Falcon 180B com apenas alguns cliques Estúdio Amazon SageMaker ou programaticamente por meio do SageMaker Python SDK, permitindo derivar o desempenho do modelo e controles MLOps com recursos do SageMaker, como Pipelines Amazon SageMaker, Depurador do Amazon SageMakerou registros de contêiner. O modelo é implantado em um ambiente seguro da AWS e sob seus controles de VPC, ajudando a garantir a segurança dos dados. O Falcon 180B pode ser descoberto e implantado em regiões onde as instâncias necessárias estão disponíveis. Atualmente, as instâncias ml.p4de estão disponíveis no Leste dos EUA (Norte da Virgínia) e no Oeste dos EUA (Oregon).

Descubra modelos

Você pode acessar os modelos básicos por meio do SageMaker JumpStart na interface do SageMaker Studio e do SageMaker Python SDK. Nesta seção, veremos como descobrir os modelos no SageMaker Studio.

SageMaker Studio é um ambiente de desenvolvimento integrado (IDE) que fornece uma única interface visual baseada na web onde você pode acessar ferramentas específicas para executar todas as etapas de desenvolvimento de ML, desde a preparação de dados até a construção, treinamento e implantação de seus modelos de ML. Para obter mais detalhes sobre como começar e configurar o SageMaker Studio, consulte Estúdio Amazon SageMaker.

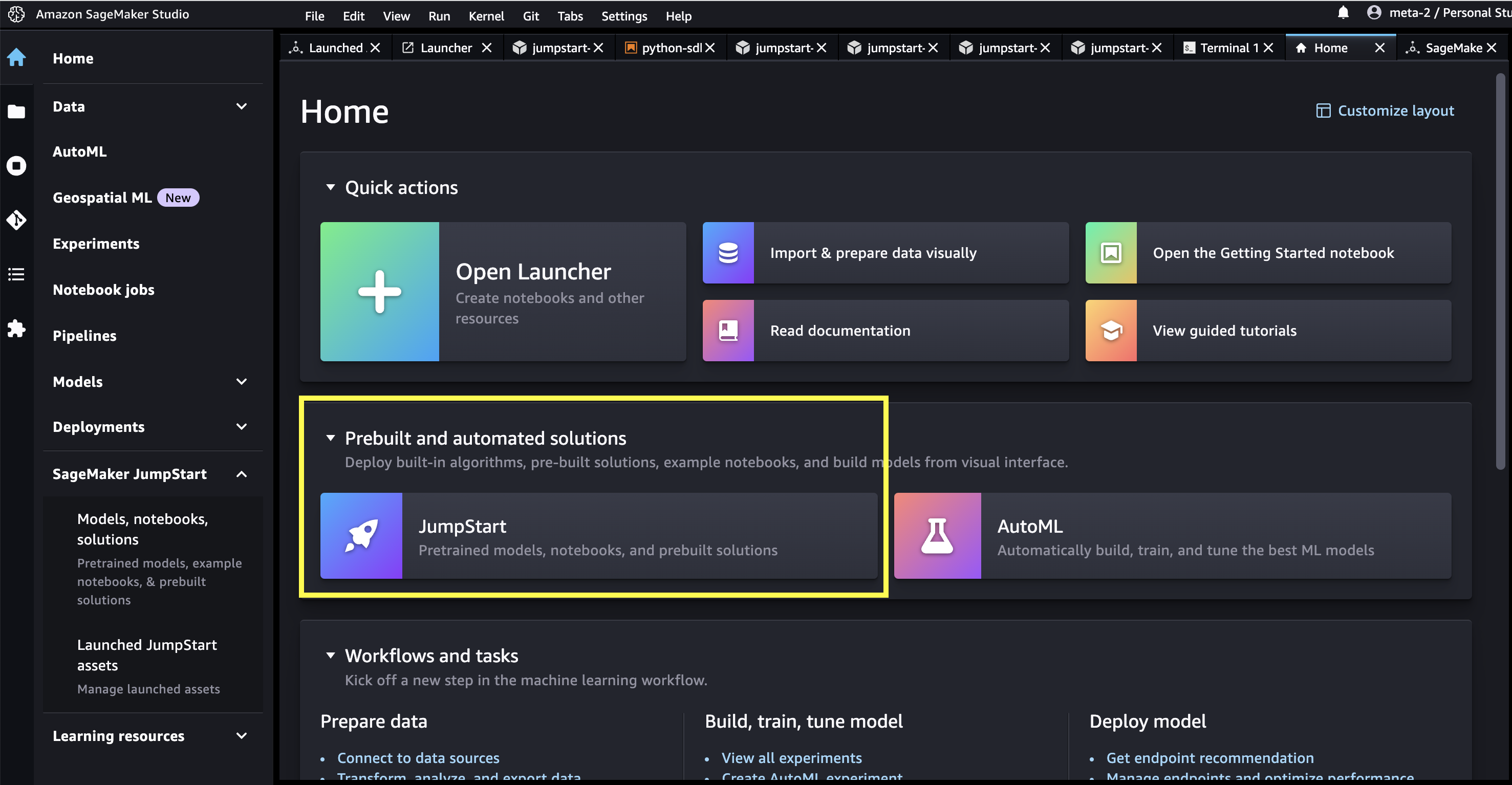

No SageMaker Studio, você pode acessar o SageMaker JumpStart, que contém modelos pré-treinados, notebooks e soluções pré-construídas, em Soluções pré-construídas e automatizadas.

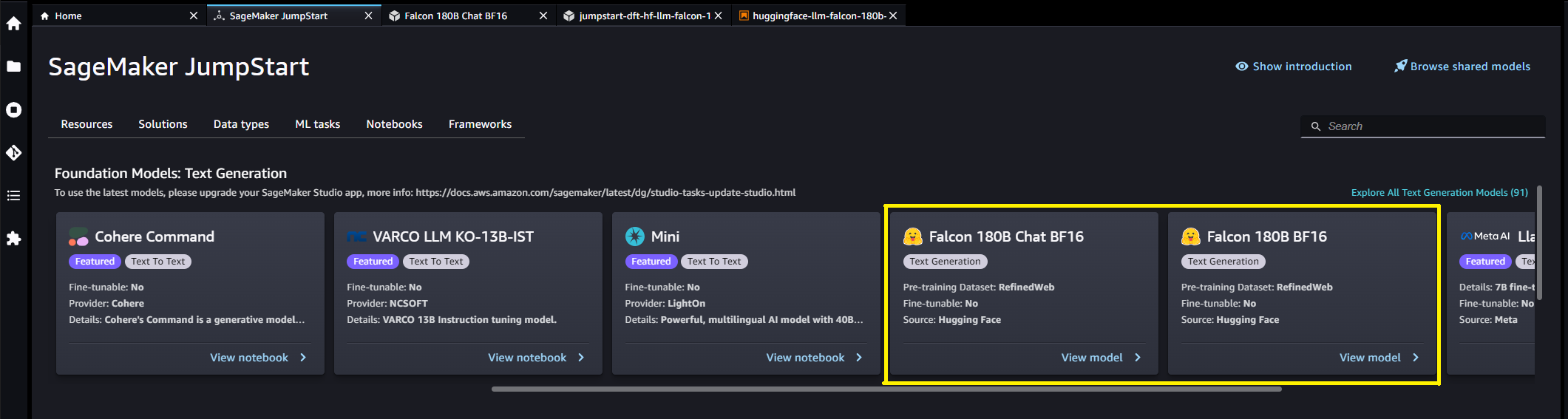

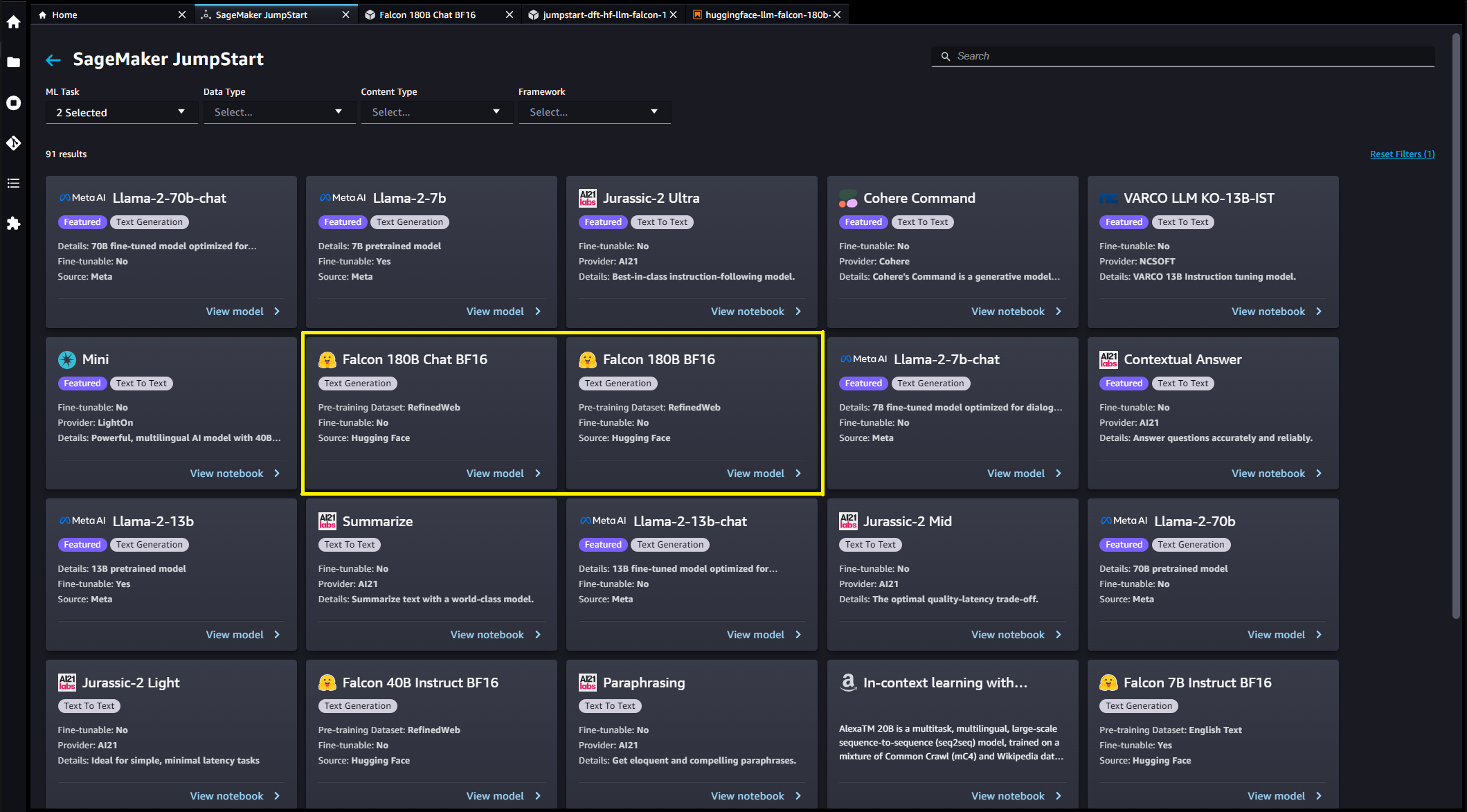

Na página inicial do SageMaker JumpStart, você pode procurar soluções, modelos, notebooks e outros recursos. Você pode encontrar o Falcon 180B no Modelos básicos: geração de texto carrossel.

Você também pode encontrar outras variantes de modelo escolhendo Explore todos os modelos de geração de texto ou procurando por Falcon.

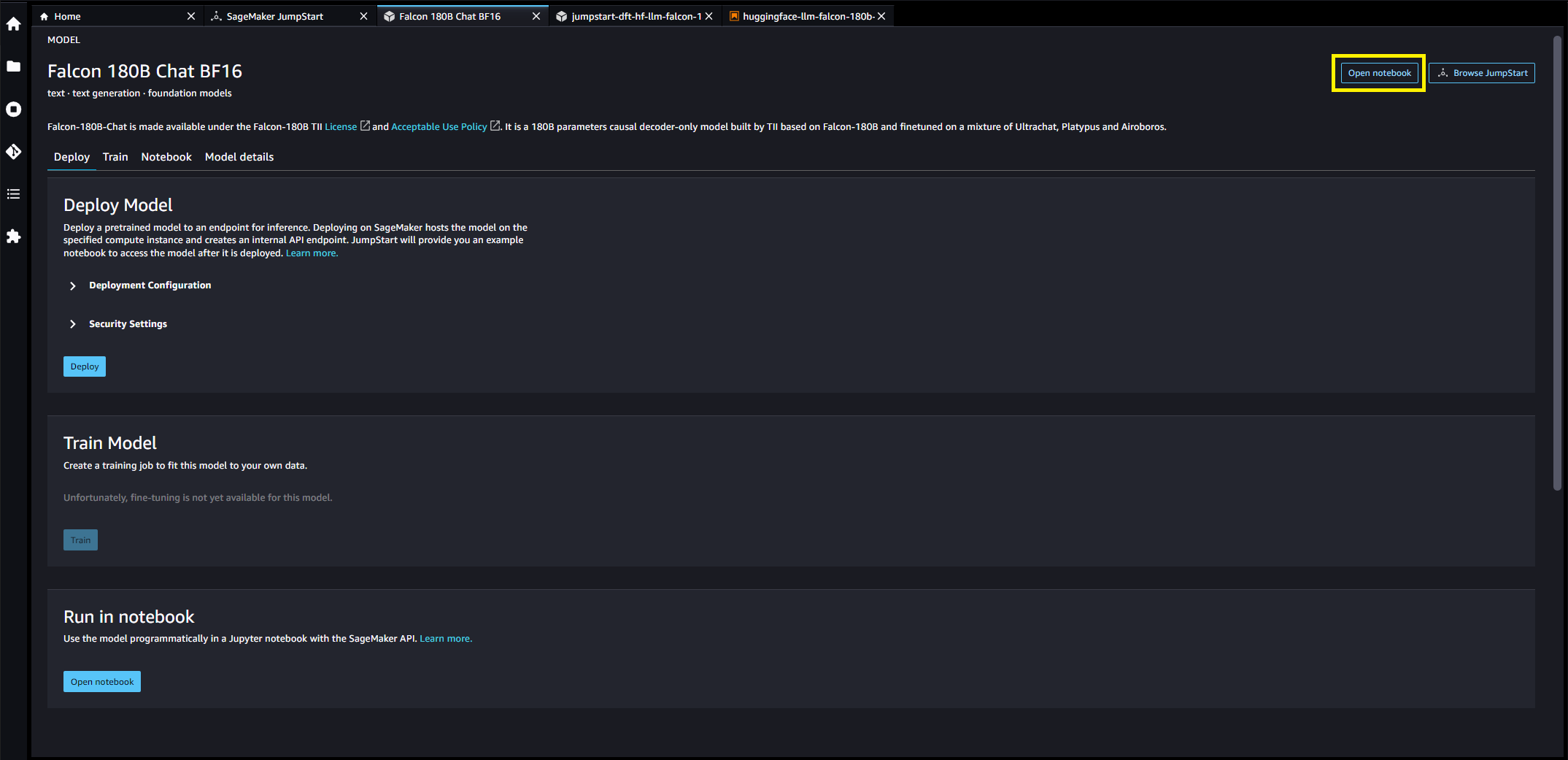

Você pode escolher o cartão do modelo para visualizar detalhes sobre o modelo, como licença, dados usados para treinar e como usar. Você também encontrará dois botões, Implantação e Abra o Notebook, que o ajudará a usar o modelo (a captura de tela a seguir mostra o Implantação opção).

Implantar modelos

Quando você escolhe Implantação, a implantação do modelo será iniciada. Como alternativa, você pode implantar por meio do notebook de exemplo exibido escolhendo Abra o Notebook. O caderno de exemplo fornece orientação completa sobre como implantar o modelo para inferência e limpeza de recursos.

Para implantar usando um notebook, começamos selecionando um modelo apropriado, especificado pelo model_id. Você pode implantar qualquer um dos modelos selecionados no SageMaker com o seguinte código:

Isso implanta o modelo no SageMaker com configurações padrão, incluindo o tipo de instância padrão e as configurações de VPC padrão. Você pode alterar essas configurações especificando valores não padrão em JumpStartModel. Para saber mais, consulte o Documentação da API. Após a implantação, você pode executar inferência no endpoint implantado por meio de um preditor SageMaker. Veja o seguinte código:

Os parâmetros de inferência controlam o processo de geração de texto no terminal. O controle máximo de novos tokens refere-se ao tamanho da saída gerada pelo modelo. Observe que isso não é igual ao número de palavras porque o vocabulário do modelo não é igual ao vocabulário do idioma inglês e cada token pode não ser uma palavra do idioma inglês. A temperatura controla a aleatoriedade na saída. Temperaturas mais altas resultam em resultados mais criativos e alucinados. Todos os parâmetros de inferência são opcionais.

Este modelo de parâmetro de 180B tem 335 GB e requer ainda mais memória de GPU para realizar inferências suficientes com precisão de 16 bits. Atualmente, o JumpStart oferece suporte apenas a este modelo em instâncias ml.p4de.24xlarge. É possível implantar um modelo quantizado de 8 bits em uma instância ml.p4d.24xlarge fornecendo o env={"HF_MODEL_QUANTIZE": "bitsandbytes"} argumento de palavra-chave para o JumpStartModel construtor e especificando instance_type="ml.p4d.24xlarge" para o método de implantação. No entanto, observe que a latência por token é aproximadamente 5x mais lenta para esta configuração quantizada.

A tabela a seguir lista todos os modelos Falcon disponíveis no SageMaker JumpStart junto com os IDs do modelo, tipos de instância padrão, número máximo de tokens totais (soma do número de tokens de entrada e número de tokens gerados) suportados e a latência de resposta típica por token para cada um desses modelos.

| Nome do modelo | ID do modelo | Tipo de instância padrão | Total máximo de tokens | Latência por token* |

| Falcão 7B | huggingface-llm-falcon-7b-bf16 |

ml.g5.2xgrande | 2048 | 34 ms |

| Instrução do Falcon 7B | huggingface-llm-falcon-7b-instruct-bf16 |

ml.g5.2xgrande | 2048 | 34 ms |

| Falcão 40B | huggingface-llm-falcon-40b-bf16 |

ml.g5.12xgrande | 2048 | 57 ms |

| Instrução do Falcon 40B | huggingface-llm-falcon-40b-instruct-bf16 |

ml.g5.12xgrande | 2048 | 57 ms |

| Falcão 180B | huggingface-llm-falcon-180b-bf16 |

ml.p4de.24xgrande | 2048 | 45 ms |

| Bate-papo do Falcão 180B | huggingface-llm-falcon-180b-chat-bf16 |

ml.p4de.24xgrande | 2048 | 45 ms |

*a latência por token é fornecida para o tempo médio de resposta dos prompts de exemplo fornecidos neste blog; esse valor variará com base no comprimento das sequências de entrada e saída.

Inferência e exemplos de prompts para Falcon 180B

Os modelos Falcon podem ser usados para completar texto para qualquer parte do texto. Por meio da geração de texto, você pode realizar diversas tarefas, como responder perguntas, traduzir idiomas, analisar sentimentos e muito mais. O endpoint aceita o seguinte esquema de carga útil de entrada:

Você pode explorar a definição destes parâmetros do cliente e seus valores padrão no repositório de inferência de geração de texto.

A seguir estão alguns exemplos de prompts e o texto gerado pelo modelo. Todas as saídas aqui são geradas com parâmetros de inferência {"max_new_tokens": 768, "stop": ["<|endoftext|>", "###"]}.

Construir um site pode ser feito em 10 etapas simples:

Você pode notar que esse modelo pré-treinado gera sequências de texto longas que não são necessariamente ideais para casos de uso de diálogo. Antes de mostrarmos o desempenho do modelo de bate-papo ajustado para um conjunto maior de prompts baseados em diálogo, os próximos dois exemplos ilustram como usar modelos Falcon com aprendizado contextual de poucas tentativas, onde fornecemos exemplos de treinamento disponíveis para o modelo. Observe que o “aprendizado rápido” não ajusta os pesos do modelo - apenas realizamos inferências no modelo implantado durante esse processo, enquanto fornecemos alguns exemplos dentro do contexto de entrada para ajudar na saída do modelo da guilda.

Inferência e exemplos de prompts para Falcon 180B-Chat

Com os modelos Falcon 180B-Chat, otimizados para casos de uso de diálogo, a entrada para os terminais do modelo de chat pode conter histórico anterior entre o assistente de chat e o usuário. Você pode fazer perguntas contextuais à conversa que aconteceu até agora. Você também pode fornecer a configuração do sistema, como personas, que definem o comportamento do assistente de chat. A carga útil de entrada para o endpoint é a mesma do modelo Falcon 180B, exceto o inputs O valor da string deve usar o seguinte formato:

A seguir estão alguns exemplos de prompts e o texto gerado pelo modelo. Todas as saídas são geradas com parâmetros de inferência {"max_new_tokens":256, "stop": ["nUser:", "<|endoftext|>", " User:", "###"]}.

No exemplo a seguir, o usuário conversou com o assistente sobre pontos turísticos de Paris. A seguir, o usuário pergunta sobre a primeira opção recomendada pelo assistente de chat.

limpar

Depois de terminar de executar o notebook, exclua todos os recursos que você criou no processo para que seu faturamento seja interrompido. Use o seguinte código:

Conclusão

Nesta postagem, mostramos como começar a usar o Falcon 180B no SageMaker Studio e implantar o modelo para inferência. Como os modelos básicos são pré-treinados, eles podem ajudar a reduzir os custos de treinamento e infraestrutura e permitir a personalização para seu caso de uso. Visite o SageMaker JumpStart no SageMaker Studio agora para começar.

Recursos

Sobre os autores

Dr. é cientista aplicado da equipe Amazon SageMaker JumpStart. Seus interesses de pesquisa incluem algoritmos escaláveis de aprendizado de máquina, visão computacional, séries temporais, não paramétricos bayesianos e processos gaussianos. Seu doutorado é pela Duke University e publicou artigos em NeurIPS, Cell e Neuron.

Dr. é cientista aplicado da equipe Amazon SageMaker JumpStart. Seus interesses de pesquisa incluem algoritmos escaláveis de aprendizado de máquina, visão computacional, séries temporais, não paramétricos bayesianos e processos gaussianos. Seu doutorado é pela Duke University e publicou artigos em NeurIPS, Cell e Neuron.

Dr. é cientista aplicado sênior do Amazon SageMaker JumpStart e ajuda a desenvolver algoritmos de aprendizado de máquina. Ele obteve seu PhD pela Universidade de Illinois Urbana-Champaign. Ele é um pesquisador ativo em aprendizado de máquina e inferência estatística e publicou muitos artigos em conferências NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dr. é cientista aplicado sênior do Amazon SageMaker JumpStart e ajuda a desenvolver algoritmos de aprendizado de máquina. Ele obteve seu PhD pela Universidade de Illinois Urbana-Champaign. Ele é um pesquisador ativo em aprendizado de máquina e inferência estatística e publicou muitos artigos em conferências NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Olivier Cruchant é arquiteto principal de soluções especialista em aprendizado de máquina na AWS, com sede na França. Olivier ajuda os clientes da AWS, desde pequenas startups até grandes empresas, a desenvolver e implantar aplicativos de machine learning de nível de produção. Em seu tempo livre, ele gosta de ler artigos de pesquisa e explorar a natureza com amigos e familiares.

Olivier Cruchant é arquiteto principal de soluções especialista em aprendizado de máquina na AWS, com sede na França. Olivier ajuda os clientes da AWS, desde pequenas startups até grandes empresas, a desenvolver e implantar aplicativos de machine learning de nível de produção. Em seu tempo livre, ele gosta de ler artigos de pesquisa e explorar a natureza com amigos e familiares.

Carlos Albertsen lidera o hub do modelo básico, algoritmos e equipes de parcerias do Amazon SageMaker.

Carlos Albertsen lidera o hub do modelo básico, algoritmos e equipes de parcerias do Amazon SageMaker.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- ChartPrime. Eleve seu jogo de negociação com ChartPrime. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/falcon-180b-foundation-model-from-tii-is-now-available-via-amazon-sagemaker-jumpstart/

- :tem

- :é

- :não

- :onde

- $UP

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 150

- 20

- 25

- 26%

- 3d

- 4k

- 7

- 8

- 9

- a

- Sobre

- Aceita

- Acesso

- acessível

- Alcançar

- ativo

- adicionar

- Adicionalmente

- endereço

- Depois de

- contra

- algoritmos

- Todos os Produtos

- permite

- juntamente

- tb

- sempre

- am

- Amazon

- Amazon Sage Maker

- JumpStart do Amazon SageMaker

- Amazon Web Services

- an

- análise

- e

- e infra-estrutura

- Anunciar

- Outro

- responder

- qualquer

- qualquer um

- atraente

- aplicações

- aplicado

- apropriado

- aproximadamente

- arquitetura

- SOMOS

- argumento

- Arte

- artigo

- AS

- perguntar

- Assistente

- At

- por WhatsApp.

- atrair

- atração

- Automatizado

- disponível

- avenidas

- AWS

- baseado

- bateria

- Bayesiano

- BE

- bonita

- Porque

- sido

- antes

- comportamento

- Melhor

- entre

- morada

- Blog

- ostenta

- navegador

- construtor

- construtores

- Prédio

- negócio

- mas a

- by

- cafés

- CAN

- capacidade

- cartão

- carrossel

- casas

- casos

- alterar

- verificar

- Escolha

- escolha

- escolhido

- Cidades

- classificar

- Agrupar

- cms

- código

- Codebase

- coleção

- colunas

- COM

- combinado

- comum

- Empresa

- completar

- realização

- computador

- Visão de Computador

- conferências

- Configuração

- Consistindo

- Contacto

- não contenho

- Recipiente

- contém

- conteúdo

- contexto

- contextual

- continuamente

- contribuiu

- ao controle

- controles

- Conversa

- conversação

- custos

- crio

- criado

- Criar

- Criatividade

- copo

- Atual

- Atualmente

- personalizadas

- cliente

- Suporte ao cliente

- Clientes

- personalização

- personalizar

- dados,

- segurança dos dados

- conjuntos de dados

- dia

- decisão

- dedicado

- Padrão

- definir

- definição

- demonstrar

- Dependendo

- implantar

- implantado

- Implantação

- desenvolvimento

- implanta

- Design

- destino

- detalhes

- Determinar

- desenvolver

- desenvolvido

- Desenvolvimento

- diálogo

- Diálogo

- diferente

- descobrir

- distribuído

- treinamento distribuído

- do

- parece

- domínio

- Nome de domínio

- NOMES DE DOMÍNIO

- feito

- sonhos

- Duque

- Universidade Duke

- durante

- cada

- facilidade

- facilmente

- Leste

- fácil

- permitir

- permitindo

- end-to-end

- Ponto final

- energia

- Engenharia

- Inglês

- garantir

- empresas

- Meio Ambiente

- especialmente

- Mesmo

- exemplo

- exemplos

- Exceto

- animado

- experiência

- explorar

- Explorando

- expressa

- extensão

- extensões

- extenso

- família

- famoso

- longe

- fascinante

- Funcionalidades

- poucos

- Encontre

- Primeiro nome

- Flutuador

- seguinte

- segue

- Escolha

- formato

- Antigo

- Foundation

- quatro

- QUADRO

- França

- Francês

- amigos

- da

- funcionamento

- mais distante

- Jardins

- Gema

- gerar

- gerado

- gera

- geração

- ter

- vidro

- Go

- meta

- Objetivos

- vai

- Bom estado, com sinais de uso

- tem

- GPU

- GPUs

- ótimo

- Crescente

- orientações

- corporação

- tinha

- aconteceu

- odiar

- Ter

- ter

- he

- Coração

- ajudar

- útil

- ajuda

- ajuda

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- oculto

- joia escondida

- alta performance

- superior

- sua

- história

- Início

- hospedeiro

- hospedagem

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTML

- HTTPS

- Hub

- i

- icônico

- ID

- ideal

- ids

- if

- Illinois

- imagem

- imagens

- importar

- impressionante

- in

- incluir

- Incluindo

- incrível

- INFORMAÇÕES

- Infraestrutura

- Inovação

- entrada

- inputs

- instância

- Instituto

- instruções

- integrado

- interessado

- interesses

- Interface

- para dentro

- isolado

- IT

- ESTÁ

- jpg

- conhecido

- kyle

- aterrissagem

- língua

- grande

- Grandes empresas

- em grande escala

- Maior

- maior

- Latência

- mais recente

- lançamento

- Leis

- traçado

- Leads

- APRENDER

- aprendizagem

- Comprimento

- Licença

- leve

- forrado

- LINK

- Links

- Lista

- listas

- carregamento

- longo

- diminuir

- Luxemburgo

- máquina

- aprendizado de máquina

- moldadas

- fazer

- Fazendo

- de grupos

- gestão

- muitos

- maravilha

- Massa

- maciço

- max

- máximo

- Posso..

- significado

- significa

- Mídia

- medieval

- Memória

- mensagem

- método

- poder

- Misturando

- mistura

- ML

- MLOps

- modelo

- modelos

- mais

- a maioria

- movimento

- museu

- Música

- my

- nome

- Nomeado

- nomes

- Navegar

- Navegação

- necessariamente

- você merece...

- negativo

- líquido

- rede

- Neutro

- Novo

- Próximo

- noite

- não

- caderno

- Perceber..

- agora

- número

- observadores

- of

- Oferece

- AZEITE E AZEITE EVO

- oliva

- on

- uma vez

- ONE

- só

- abertamente

- operacional

- otimizado

- Opção

- Opções

- or

- Oregon

- Outros

- Fora

- delineado

- saída

- Acima de

- página

- páginas

- Palácio

- papéis

- parâmetro

- parâmetros

- Paris

- Park

- particularmente

- parcerias

- pagamento

- método de pagamento

- Pessoas

- para

- perfeita

- Realizar

- atuação

- executa

- phd

- telefone

- Física

- peça

- plano

- platão

- Inteligência de Dados Platão

- PlatãoData

- por favor

- positivo

- possível

- Publique

- POSTAGENS

- Precisão

- Predictor

- preparação

- presente

- anterior

- principalmente

- Diretor

- problemas

- processo

- processos

- Produto

- a promover

- devidamente

- fornecer

- fornecido

- provedor

- fornece

- fornecendo

- publicado

- propósito

- colocar

- Python

- Frequentes

- rapidamente

- aleatoriedade

- Cru

- Leitura

- receita

- Recomenda

- referir

- refere-se

- Independentemente

- regiões

- cadastre-se

- registro

- escrivão

- Registo

- relativo

- relatividade

- liberado

- Releases

- relevante

- confiabilidade

- confiável

- lembrar

- repositório

- representa

- exige

- necessário

- pesquisa

- investigador

- Recursos

- resposta

- Resultados

- Rico

- Viajar

- realeza

- Execute

- corrida

- s

- sábio

- sal

- mesmo

- AMPLIAR

- escalável

- Escala

- Cientista

- Sdk

- SEA

- Pesquisar

- pesquisar

- Épocas

- Segundo

- Seção

- seguro

- segurança

- Vejo

- semente

- selecionado

- selecionando

- senior

- sentimento

- Série

- serviço

- Serviços

- conjunto

- Configurações

- vários

- Partilhar

- lojas

- Baixo

- rede de apoio social

- mostrar

- mostrou

- Shows

- assinar

- simples

- simplicidade

- simplesmente

- solteiro

- Locais

- Tamanho

- Lentamente

- pequeno

- So

- até aqui

- Redes Sociais

- meios de comunicação social

- Publicações nas redes sociais

- Soluções

- alguns

- algo

- fonte

- Espaço

- especialista

- especificada

- velocidade

- começo

- começado

- Startups

- Unidos

- estação

- estatístico

- Passos

- Dê um basta

- parou

- armazenamento

- loja

- rua

- Tanga

- estudo

- Assombroso

- tal

- ajuda

- Suportado

- suportes

- certo

- símbolo

- .

- mesa

- Tire

- tomar

- tarefas

- gosto

- Profissionais

- equipes

- Tecnologia

- Inovação Tecnológica

- modelo

- teste

- texto

- que

- A

- o mundo

- deles

- Eles

- tema

- então

- teoria

- Lá.

- Este

- deles

- Terceiro

- isto

- Através da

- tempo

- Séries temporais

- para

- juntos

- token

- Tokens

- ferramenta

- ferramentas

- Total

- Torre

- Trem

- treinado

- Training

- transformador

- traduzir

- Tradução

- Trilhão

- viagem

- Tritão

- tentar

- Tweet

- dois

- tipo

- tipos

- típico

- ui

- para

- unificado

- único

- universidade

- até

- Upload

- us

- usar

- caso de uso

- usava

- Utilizador

- usuários

- usos

- utilização

- Vácuo

- valor

- Valores

- variedade

- vário

- versão

- versões

- via

- Vibe

- Vídeo

- VÍDEOS

- Ver

- visualizações

- Virgínia

- visão

- Visite a

- visitantes

- visualmente

- andar

- queremos

- foi

- marca d'água

- we

- web

- serviços web

- Web-Based

- Site

- semana

- semanas

- BEM

- Ocidente

- O Quê

- O que é a

- quando

- qual

- enquanto

- precisarão

- Windows

- de

- dentro

- sem

- Word

- palavras

- mundo

- escrita

- sim

- Vocês

- investimentos

- zefirnet

- zero