Introdução

No aprendizado de máquina, a compensação de viés-variância é um conceito fundamental que afeta o desempenho de qualquer modelo preditivo. Refere-se ao delicado equilíbrio entre o erro de viés e o erro de variância de um modelo, pois é impossível minimizar ambos simultaneamente. Encontrar o equilíbrio certo é crucial para alcançar o desempenho ideal do modelo.

Neste breve artigo, definiremos viés e variância, explicaremos como eles afetam um modelo de aprendizado de máquina e forneceremos alguns conselhos práticos sobre como lidar com eles na prática.

Compreendendo o viés e a variância

Antes de mergulhar na relação entre viés e variância, vamos definir o que esses termos representam no aprendizado de máquina.

O erro de viés refere-se à diferença entre a previsão de um modelo e os valores corretos que ele tenta prever (verdade básica). Em outras palavras, viés é o erro que um modelo comete devido a suas suposições incorretas sobre a distribuição de dados subjacente. Os modelos de alto viés costumam ser muito simplistas, falhando em capturar a complexidade dos dados, levando ao underfitting.

O erro de variância, por outro lado, refere-se à sensibilidade do modelo a pequenas flutuações nos dados de treinamento. Os modelos de alta variância são excessivamente complexos e tendem a ajustar o ruído nos dados, em vez do padrão subjacente, levando ao overfitting. Isso resulta em baixo desempenho em dados novos e não vistos.

O viés alto pode levar ao underfitting, onde o modelo é muito simples para capturar a complexidade dos dados. Ele faz fortes suposições sobre os dados e falha em capturar a verdadeira relação entre as variáveis de entrada e saída. Por outro lado, a alta variância pode levar ao overfitting, em que o modelo é muito complexo e aprende o ruído nos dados, em vez da relação subjacente entre as variáveis de entrada e saída. Assim, os modelos de overfitting tendem a ajustar os dados de treinamento muito de perto e não generalizarão bem para novos dados, enquanto os modelos de underfitting nem mesmo são capazes de ajustar os dados de treinamento com precisão.

Conforme mencionado anteriormente, o viés e a variância estão relacionados, e um bom modelo equilibra entre o erro de viés e o erro de variância. O trade-off viés-variância é o processo de encontrar o equilíbrio ideal entre essas duas fontes de erro. Um modelo com baixo viés e baixa variância provavelmente terá um bom desempenho tanto no treinamento quanto nos novos dados, minimizando o erro total.

O trade-off de viés-variância

Alcançar um equilíbrio entre a complexidade do modelo e sua capacidade de generalizar para dados desconhecidos é o cerne da troca de viés-variância. Em geral, um modelo mais complexo terá um viés menor, mas uma variância maior, enquanto um modelo mais simples terá um viés maior, mas uma variância menor.

Como é impossível minimizar simultaneamente o viés e a variância, encontrar o equilíbrio ideal entre eles é crucial na construção de um modelo robusto de aprendizado de máquina. Por exemplo, conforme aumentamos a complexidade de um modelo, também aumentamos a variância. Isso ocorre porque um modelo mais complexo tem maior probabilidade de ajustar o ruído nos dados de treinamento, o que levará ao overfitting.

Por outro lado, se mantivermos o modelo muito simples, aumentaremos o viés. Isso ocorre porque um modelo mais simples não será capaz de capturar as relações subjacentes nos dados, o que levará ao underfitting.

O objetivo é treinar um modelo que seja complexo o suficiente para capturar os relacionamentos subjacentes nos dados de treinamento, mas não tão complexo que se encaixe no ruído dos dados de treinamento.

Compensação de viés-variância na prática

Para diagnosticar o desempenho do modelo, normalmente calculamos e comparamos os erros de treinamento e validação. Uma ferramenta útil para visualizar isso é um gráfico das curvas de aprendizado, que exibe o desempenho do modelo nos dados de treinamento e validação ao longo do processo de treinamento. Ao examinar essas curvas, podemos determinar se um modelo está superajustado (alta variação), subajustado (alta tendência) ou bem ajustado (equilíbrio ideal entre tendência e variação).

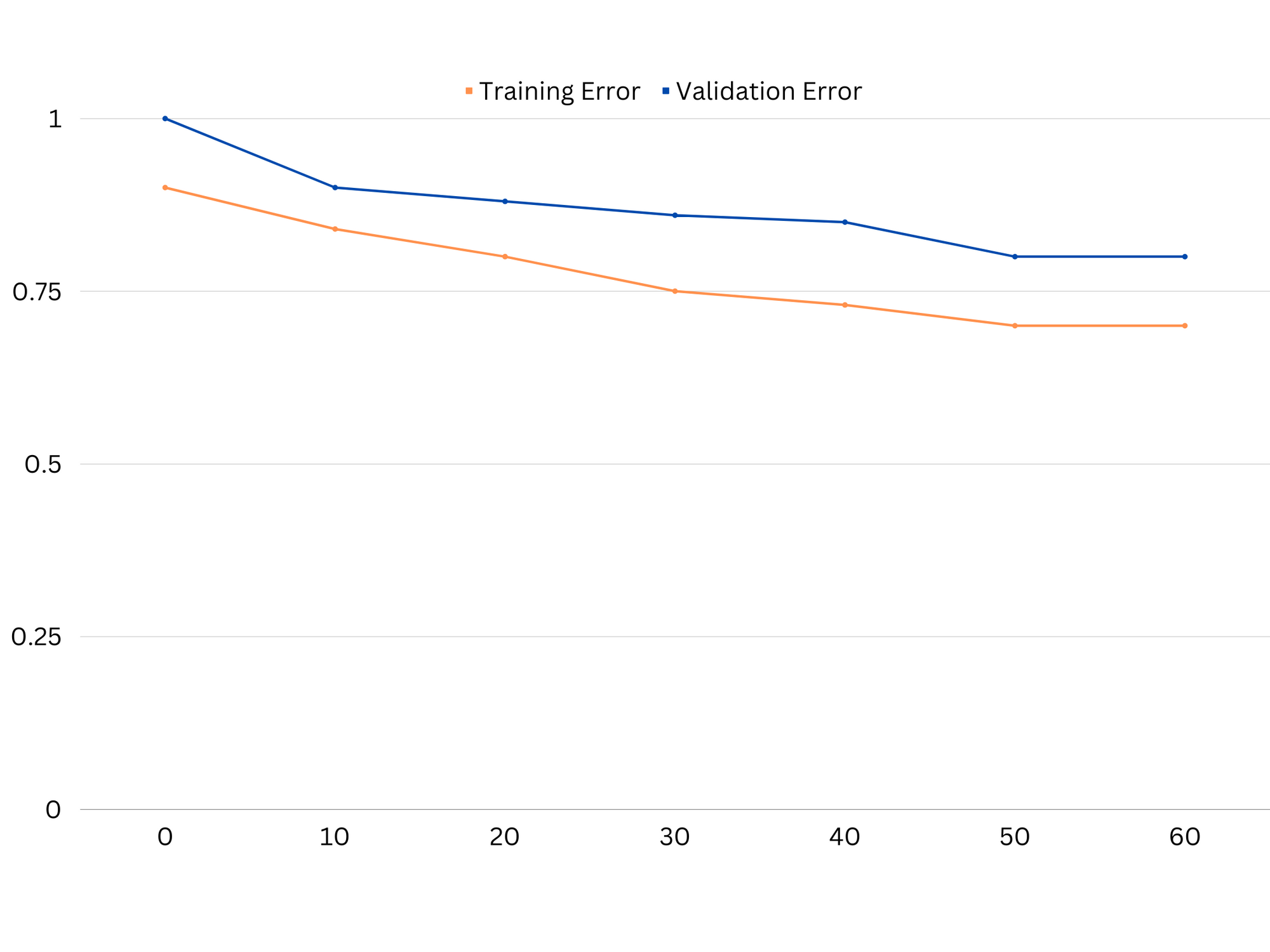

Exemplo de curvas de aprendizado de um modelo de underfitting. Tanto o erro de trem quanto o erro de validação são altos.

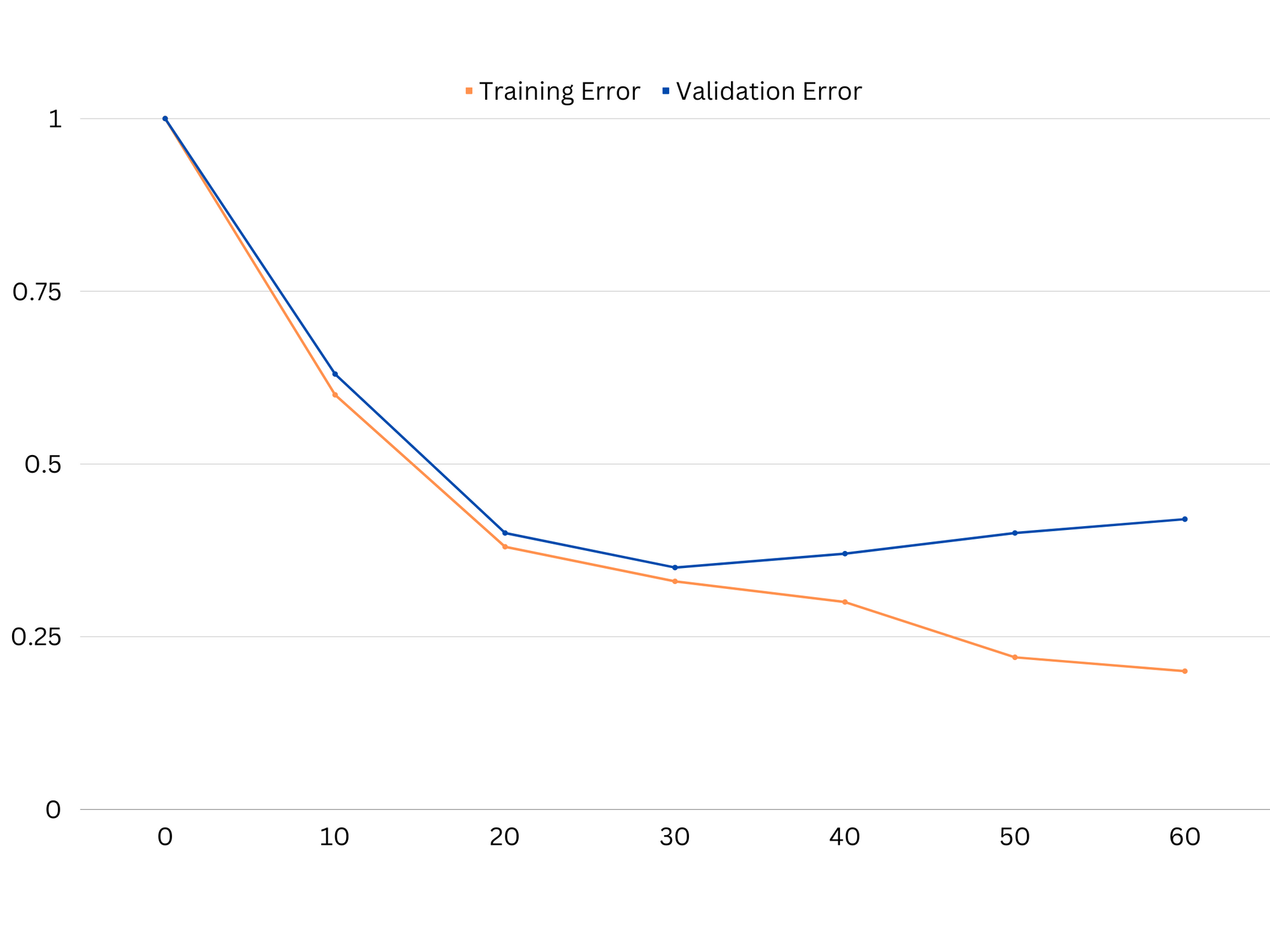

Na prática, o baixo desempenho nos dados de treinamento e validação sugere que o modelo é muito simples, levando ao underfitting. Por outro lado, se o modelo tiver um desempenho muito bom nos dados de treinamento, mas ruim nos dados de teste, a complexidade do modelo provavelmente será muito alta, resultando em overfitting. Para lidar com o underfitting, podemos tentar aumentar a complexidade do modelo adicionando mais recursos, alterando o algoritmo de aprendizado ou escolhendo diferentes hiperparâmetros. No caso de overfitting, devemos considerar regularizar o modelo ou usar técnicas como validação cruzada para melhorar suas capacidades de generalização.

Exemplo de curvas de aprendizado de um modelo de overfitting. O erro de trem diminui enquanto o erro de validação começa a aumentar. O modelo é incapaz de generalizar.

A regularização é uma técnica que pode ser usada para reduzir o erro de variância em modelos de aprendizado de máquina, ajudando a resolver o trade-off viés-variância. Existem várias técnicas de regularização diferentes, cada uma com suas próprias vantagens e desvantagens. Algumas técnicas populares de regularização incluem regressão de crista, regressão de laço e regularização de rede elástica. Todas essas técnicas ajudam a evitar o overfitting adicionando um termo de penalidade à função objetivo do modelo, o que desencoraja valores de parâmetros extremos e encoraja modelos mais simples.

Regressão do cume, também conhecida como regularização L2, adiciona um termo de penalidade proporcional ao quadrado dos parâmetros do modelo. Essa técnica tende a resultar em modelos com valores de parâmetros menores, o que pode levar a uma variância reduzida e melhor generalização. No entanto, ele não realiza a seleção de recursos, portanto, todos os recursos permanecem no modelo.

Confira nosso guia prático e prático para aprender Git, com práticas recomendadas, padrões aceitos pelo setor e folha de dicas incluída. Pare de pesquisar comandos Git no Google e realmente aprender -lo!

Regressão do laço, ou regularização L1, adiciona um termo de penalidade proporcional ao valor absoluto dos parâmetros do modelo. Essa técnica pode levar a modelos com valores de parâmetros esparsos, realizando efetivamente a seleção de recursos definindo alguns parâmetros como zero. Isso pode resultar em modelos mais simples que são mais fáceis de interpretar.

Regularização líquida elástica é uma combinação de regularização L1 e L2, permitindo um equilíbrio entre regressão de cume e laço. Ao controlar a razão entre os dois termos de penalidade, a rede elástica pode obter os benefícios de ambas as técnicas, como generalização aprimorada e seleção de recursos.

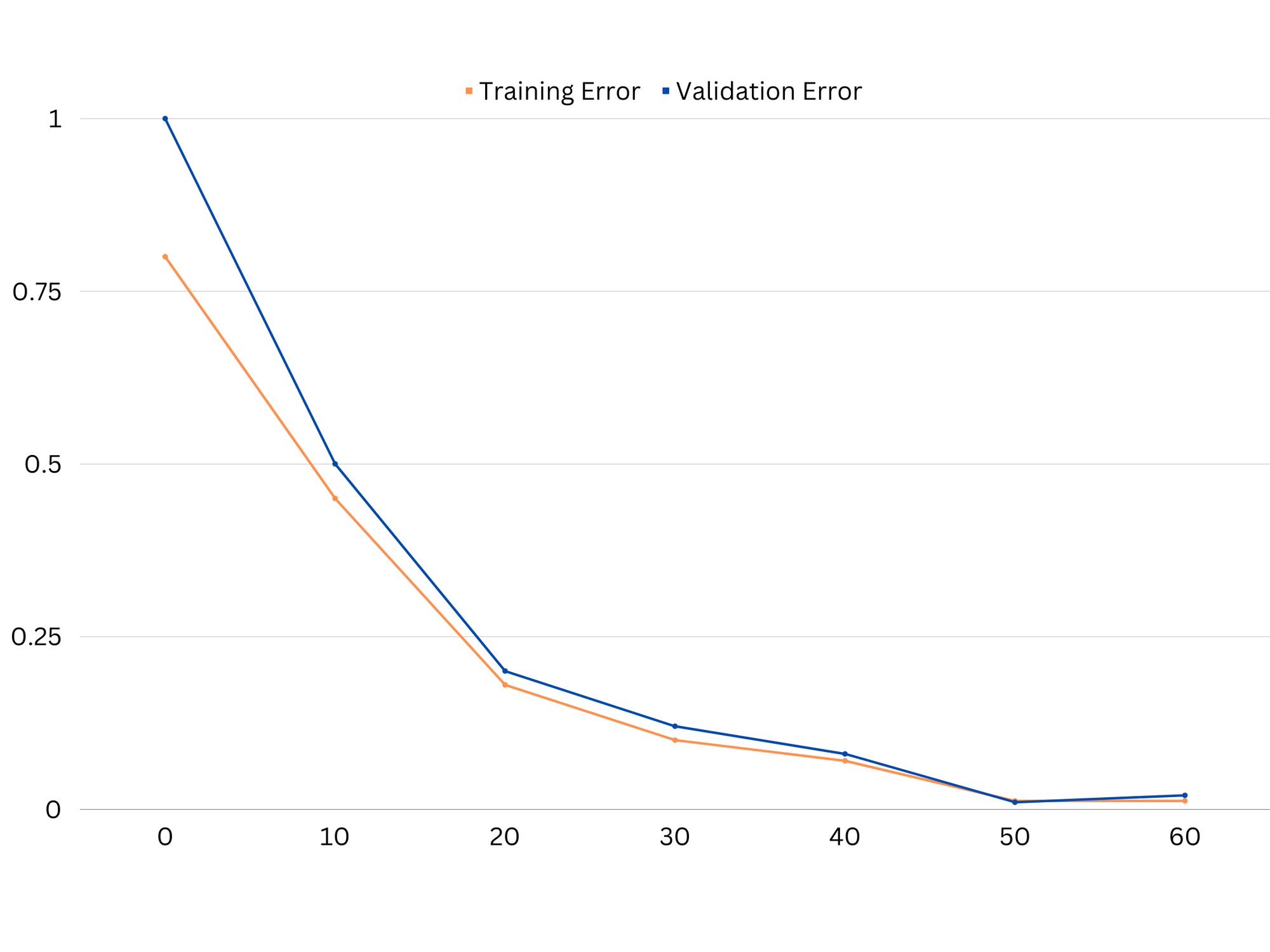

Exemplo de curvas de aprendizado de modelo de bom ajuste.

Conclusões

O trade-off viés-variância é um conceito crucial no aprendizado de máquina que determina a eficácia e qualidade de um modelo. Embora o viés alto leve ao subajuste e a alta variância leve ao superajuste, é necessário encontrar o equilíbrio ideal entre os dois para construir modelos robustos que generalizem bem para novos dados.

Com o auxílio de curvas de aprendizado é possível identificar problemas de overfitting ou underfitting e, ajustando a complexidade do modelo ou implementando técnicas de regularização, é possível melhorar o desempenho tanto dos dados de treinamento e validação quanto dos dados de teste.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoAiStream. Inteligência de Dados Web3. Conhecimento Amplificado. Acesse aqui.

- Cunhando o Futuro com Adryenn Ashley. Acesse aqui.

- Compre e venda ações em empresas PRE-IPO com PREIPO®. Acesse aqui.

- Fonte: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :é

- :não

- :onde

- 1

- 12

- 20

- 8

- a

- habilidade

- Capaz

- Sobre

- absoluto

- exatamente

- Alcançar

- alcançar

- acrescentando

- endereço

- Adiciona

- vantagens

- conselho

- afetar

- afetando

- algoritmo

- Todos os Produtos

- Permitindo

- tb

- an

- e

- qualquer

- SOMOS

- artigo

- AS

- Equilíbrio

- saldos

- BE

- Porque

- Benefícios

- entre

- viés

- fronteira

- ambos

- Prédio

- mas a

- by

- calcular

- CAN

- capacidades

- capturar

- casas

- mudança

- escolha

- de perto

- combinação

- comparar

- integrações

- complexidade

- conceito

- Considerar

- controle

- núcleo

- correta

- crucial

- dados,

- acordo

- diminui

- Determinar

- determina

- diferença

- diferente

- monitores

- distribuição

- parece

- dois

- cada

- Mais cedo

- mais fácil

- efetivamente

- eficácia

- encorajar

- suficiente

- erro

- erros

- Mesmo

- Examinando

- exemplo

- Explicação

- extremo

- falta

- falha

- Característica

- Funcionalidades

- descoberta

- caber

- apropriado

- flutuações

- Foco

- Escolha

- função

- fundamental

- Geral

- Git

- meta

- Bom estado, com sinais de uso

- Solo

- guia

- mão

- mãos em

- Ter

- ajudar

- ajuda

- Alta

- superior

- pairar

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTTPS

- identificar

- if

- implementação

- impossível

- melhorar

- melhorado

- in

- Em outra

- incluir

- incluído

- Crescimento

- aumentando

- entrada

- para dentro

- Introdução

- IT

- ESTÁ

- Guarda

- conhecido

- L1

- l2

- conduzir

- principal

- Leads

- aprendizagem

- deixar

- LG

- como

- Provável

- ll

- Baixo

- diminuir

- máquina

- aprendizado de máquina

- FAZ

- mencionado

- minimizando

- modelo

- modelos

- mais

- necessário

- líquido

- Novo

- Ruído

- número

- objetivo

- of

- frequentemente

- on

- ideal

- or

- Outros

- A Nossa

- Fora

- saída

- próprio

- parâmetro

- parâmetros

- padrão

- Realizar

- atuação

- realização

- executa

- platão

- Inteligência de Dados Platão

- PlatãoData

- pobre

- Popular

- possível

- Prática

- prática

- predizer

- predição

- evitar

- problemas

- processo

- fornecer

- em vez

- relação

- reduzir

- Reduzido

- refere-se

- relacionado

- relacionamento

- Relacionamentos

- permanecem

- representar

- resultar

- resultando

- Resultados

- certo

- Anel

- uma conta de despesas robusta

- s

- doadores,

- Sensibilidade

- contexto

- Shadow

- folha

- Baixo

- rede de apoio social

- simples

- simultaneamente

- pequeno

- menor

- So

- alguns

- Fontes

- quadrado

- Abuso de pilha

- padrões

- Dê um basta

- mais forte,

- tal

- Sugere

- técnicas

- prazo

- condições

- teste

- do que

- que

- A

- deles

- Eles

- Lá.

- Este

- deles

- isto

- todo

- para

- também

- ferramenta

- Total

- Trem

- Training

- transição

- verdadeiro

- Verdade

- tentar

- dois

- tipicamente

- incapaz

- subjacente

- desconhecido

- usava

- utilização

- validação

- valor

- Valores

- muito

- we

- BEM

- O Quê

- se

- qual

- enquanto

- precisarão

- de

- palavras

- zefirnet

- zero