Hoje, temos o prazer de anunciar a capacidade de ajustar os modelos Llama 2 da Meta usando JumpStart do Amazon SageMaker. A família Llama 2 de grandes modelos de linguagem (LLMs) é uma coleção de modelos de texto generativos pré-treinados e ajustados que variam em escala de 7 bilhões a 70 bilhões de parâmetros. LLMs ajustados, chamados Llama-2-chat, são otimizados para casos de uso de diálogo. Você pode experimentar facilmente esses modelos e usá-los com o SageMaker JumpStart, que é um hub de aprendizado de máquina (ML) que fornece acesso a algoritmos, modelos e soluções de ML para que você possa começar a usar o ML rapidamente. Agora você também pode ajustar modelos de geração de texto Llama 7 de 13 bilhões, 70 bilhões e 2 bilhões de parâmetros no SageMaker JumpStart usando o Estúdio Amazon SageMaker UI com apenas alguns cliques ou usando o SageMaker Python SDK.

Os modelos básicos de IA generativa têm sido o foco da maioria das pesquisas e casos de uso de ML e inteligência artificial há mais de um ano. Esses modelos básicos funcionam muito bem com tarefas generativas, como geração de texto, resumo, resposta a perguntas, geração de imagens e vídeos e muito mais, devido ao seu grande tamanho e também porque são treinados em vários conjuntos de dados grandes e centenas de tarefas. Apesar da grande capacidade de generalização destes modelos, muitas vezes existem casos de utilização que possuem dados de domínio muito específicos (como cuidados de saúde ou serviços financeiros), pelo que estes modelos podem não ser capazes de fornecer bons resultados para estes casos de utilização. Isto resulta na necessidade de um maior ajuste desses modelos de IA generativos em relação aos dados específicos do caso de uso e do domínio.

Nesta postagem, explicamos como ajustar os modelos de geração de texto pré-treinados do Llama 2 por meio do SageMaker JumpStart.

O que é Lhama 2

Llama 2 é um modelo de linguagem auto-regressivo que usa uma arquitetura de transformador otimizada. Llama 2 destina-se ao uso comercial e de pesquisa em inglês. Ele vem em uma variedade de tamanhos de parâmetros – 7 bilhões, 13 bilhões e 70 bilhões – bem como variações pré-treinadas e ajustadas. De acordo com Meta, as versões ajustadas usam ajuste fino supervisionado (SFT) e aprendizagem por reforço com feedback humano (RLHF) para se alinhar às preferências humanas de utilidade e segurança. O Llama 2 foi pré-treinado em 2 trilhões de tokens de dados de fontes disponíveis publicamente. Os modelos ajustados destinam-se a bate-papo semelhante a um assistente, enquanto os modelos pré-treinados podem ser adaptados para uma variedade de tarefas de geração de linguagem natural. Independentemente de qual versão do modelo um desenvolvedor usa, o guia de uso responsável da Meta pode ajudar a orientar ajustes adicionais que podem ser necessários para personalizar e otimizar os modelos com mitigações de segurança apropriadas.

Atualmente, o Llama 2 está disponível nas seguintes regiões:

- Implantar modelo pré-treinado disponível:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Ajuste e implante o modelo ajustado:

“us-east-1”,“us-west-2”,“eu-west-1”

O que é o SageMaker JumpStart

Com o SageMaker JumpStart, os profissionais de ML podem escolher entre uma ampla seleção de modelos básicos disponíveis publicamente. Os profissionais de ML podem implantar modelos básicos para dedicados Amazon Sage Maker instâncias de um ambiente isolado de rede e personalize modelos usando o SageMaker para treinamento e implantação de modelos. Agora você pode descobrir e implantar o Llama 2 com apenas alguns cliques no SageMaker Studio ou programaticamente por meio do SageMaker Python SDK, permitindo derivar o desempenho do modelo e controles MLOps com recursos do SageMaker, como Pipelines Amazon SageMaker, Depurador do Amazon SageMakerou registros de contêiner. O modelo é implantado em um ambiente seguro da AWS e sob seus controles de VPC, ajudando a garantir a segurança dos dados. Além disso, você pode ajustar os modelos de geração de texto pré-treinados do Llama2 7B, 13B e 70B por meio do SageMaker JumpStart.

Ajustar modelos Llama2

Você pode ajustar os modelos usando a UI do SageMaker Studio ou o SageMaker Python SDK. Discutimos ambos os métodos nesta seção.

Ajuste fino sem código por meio da IU do SageMaker Studio

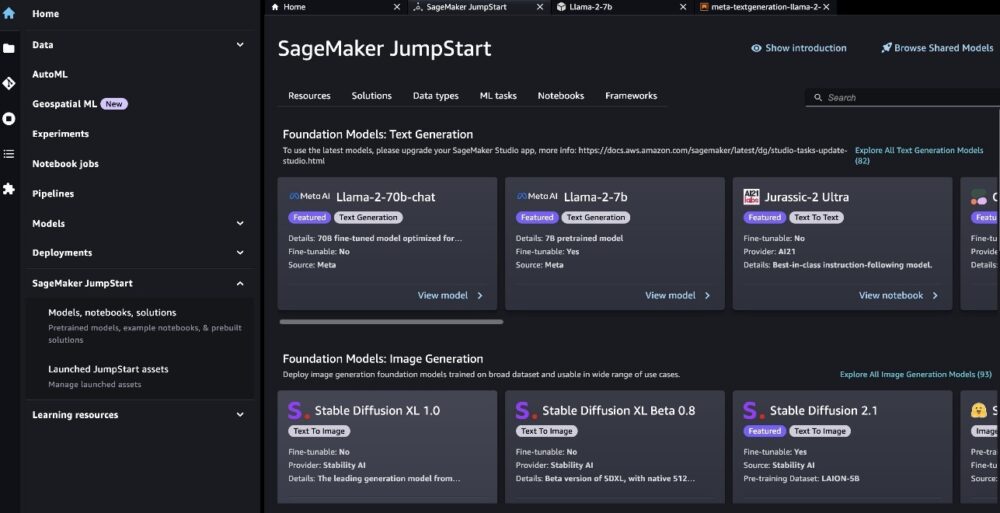

No SageMaker Studio, você pode acessar os modelos Llama 2 via SageMaker JumpStart em Modelos, notebooks e soluções, como mostrado na captura de tela a seguir.

Se você não vir os modelos Llama 2, atualize sua versão do SageMaker Studio desligando e reiniciando. Para obter mais informações sobre atualizações de versão, consulte Desligue e atualize os aplicativos do Studio.

Você também pode encontrar outras quatro variantes de modelo escolhendo Explore todos os modelos de geração de texto ou procurando por lhama na caixa de pesquisa.

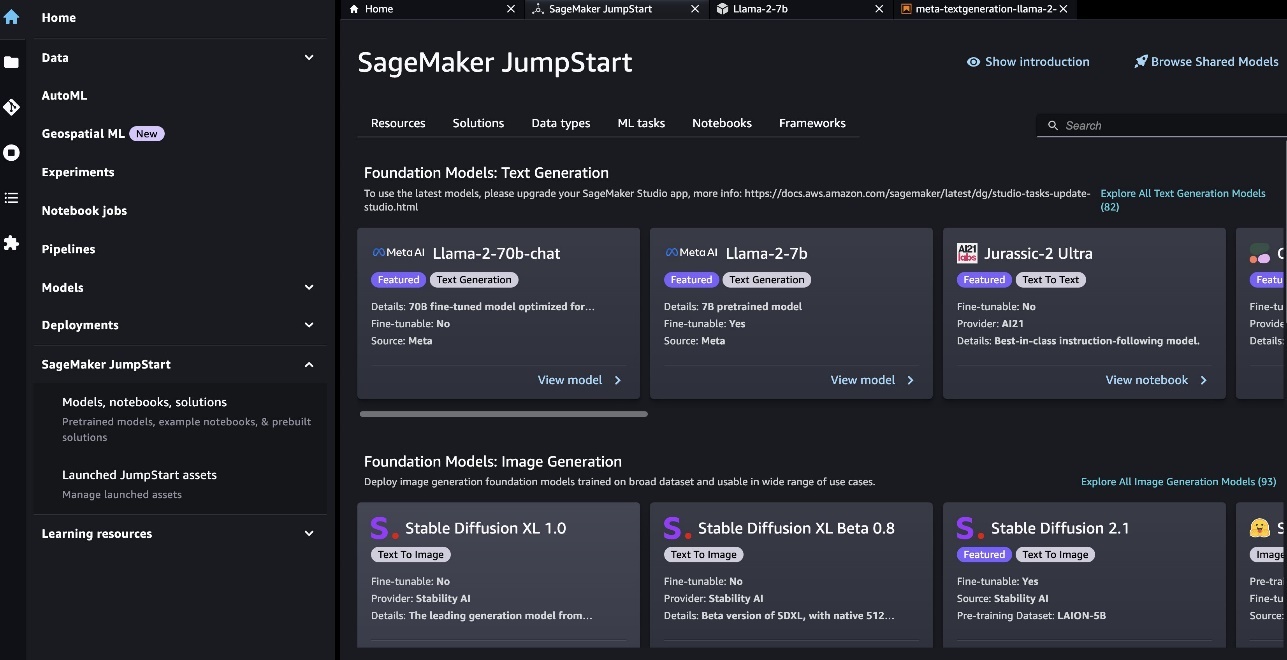

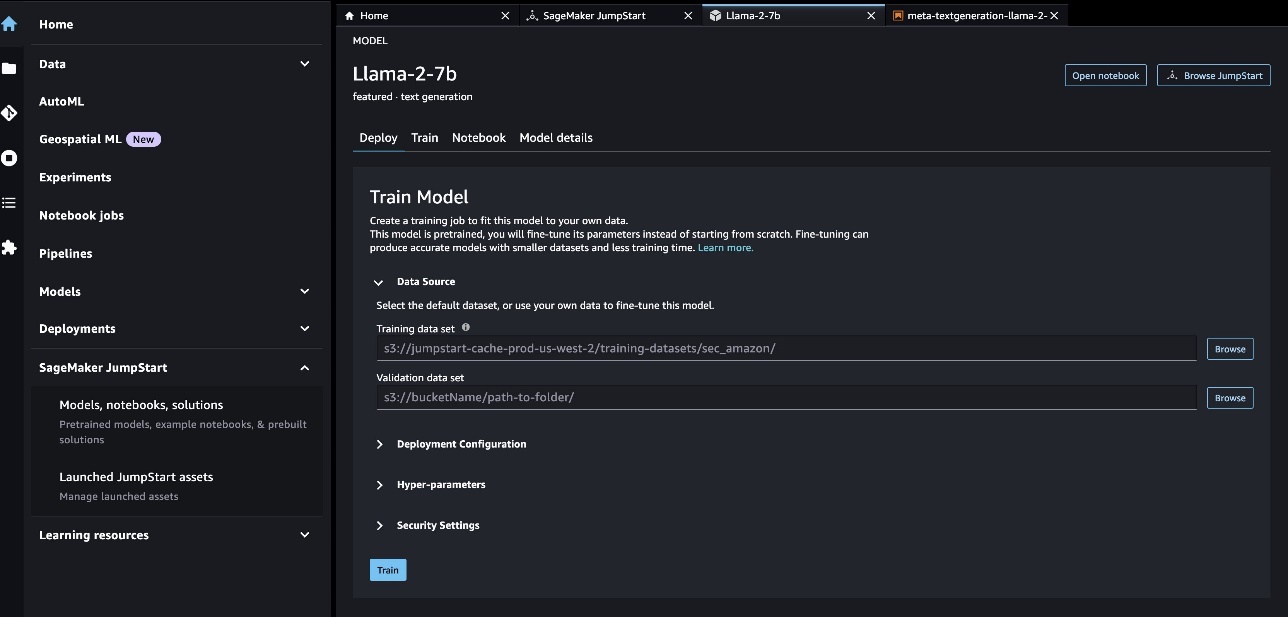

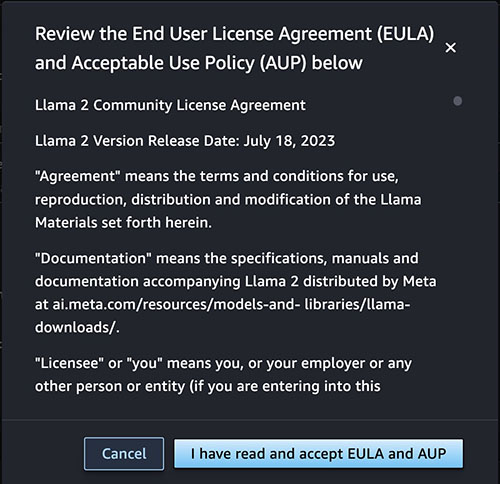

Nesta página, você pode apontar para o Serviço de armazenamento simples da Amazon (Amazon S3) que contém os conjuntos de dados de treinamento e validação para ajuste fino. Além disso, você pode definir a configuração de implantação, hiperparâmetros e configurações de segurança para ajuste fino. Você pode então escolher Trem para iniciar o trabalho de treinamento em uma instância do SageMaker ML. A captura de tela anterior mostra a página de ajuste fino do modelo Llama-2 7B; no entanto, você pode ajustar os modelos de geração de texto 13B e 70B Llama 2 usando suas respectivas páginas de modelo de forma semelhante. Para usar os modelos Llama 2, você precisa aceitar o Contrato de Licença de Usuário Final (EULA). Ele aparecerá quando você escolher Trem, conforme mostrado na captura de tela a seguir. Escolher Li e aceito o EULA e AUP para iniciar o trabalho de ajuste fino.

Implantar o modelo

Depois que o modelo for ajustado, você poderá implantá-lo usando a página do modelo no SageMaker JumpStart. A opção de implantar o modelo ajustado aparecerá quando o ajuste fino for concluído, conforme mostrado na captura de tela a seguir.

Ajuste por meio do SageMaker Python SDK

Você também pode ajustar os modelos do Llama 2 usando o SageMaker Python SDK. A seguir está um exemplo de código para ajustar o Llama 2 7B em seu conjunto de dados:

Você pode implantar o modelo ajustado diretamente do estimador:

Você também pode encontrar o código em Ajuste modelos LLaMA 2 no SageMaker JumpStart. Inclui preparação do conjunto de dados, treinamento em seu conjunto de dados personalizado e implantação do modelo ajustado. Ele demonstra o ajuste fino em um subconjunto do conjunto de dados Dolly com exemplos da tarefa de resumo. A seguir está o exemplo de entrada com respostas de ajuste fino e não ajuste fino, juntamente com a resposta da verdade básica:

Entrada para o modelo:

Resposta da verdade fundamental:

Resposta do modelo não ajustado:

Resposta do modelo ajustado:

Para avaliação comparativa de desempenho de diferentes modelos no conjunto de dados Dolly e Dialogsum, consulte o Comparação de desempenho seção no apêndice no final desta postagem.

Técnica de ajuste fino

Modelos de linguagem como o Llama têm mais de 10 GB ou até 100 GB de tamanho. O ajuste fino de modelos tão grandes requer instâncias com memória CUDA significativamente alta. Além disso, o treinamento desses modelos pode ser muito lento devido ao tamanho do modelo. Portanto, para um ajuste fino eficiente, usamos as seguintes otimizações:

- Adaptação de baixo escalão (LoRA) – Este é um tipo de ajuste fino eficiente de parâmetros (PEFT) para ajuste fino eficiente de modelos grandes. Neste, congelamos todo o modelo e adicionamos apenas um pequeno conjunto de parâmetros ou camadas ajustáveis ao modelo. Por exemplo, em vez de treinar todos os 7 bilhões de parâmetros do Llama 2 7B, podemos ajustar menos de 1% dos parâmetros. Isso ajuda na redução significativa do requisito de memória porque só precisamos armazenar gradientes, estados do otimizador e outras informações relacionadas ao treinamento para apenas 1% dos parâmetros. Além disso, isso auxilia na redução do tempo de treinamento e também dos custos. Para obter mais detalhes sobre este método, consulte LoRA: Adaptação de Baixo Nível de Grandes Modelos de Linguagem.

- Quantização Int8 – Mesmo com otimizações como LoRA, modelos como o Llama 70B ainda são grandes demais para serem treinados. Para diminuir o consumo de memória durante o treinamento, podemos usar a quantização Int8 durante o treinamento. A quantização normalmente reduz a precisão dos tipos de dados de ponto flutuante. Embora isso diminua a memória necessária para armazenar os pesos do modelo, degrada o desempenho devido à perda de informações. A quantização Int8 usa apenas um quarto de precisão, mas não incorre em degradação de desempenho porque não simplesmente elimina os bits. Ele arredonda os dados de um tipo para outro. Para aprender sobre a quantização Int8, consulte LLM.int8(): Multiplicação de matrizes de 8 bits para transformadores em escala.

- Dados totalmente fragmentados paralelos (FSDP) – Este é um tipo de algoritmo de treinamento paralelo de dados que fragmenta os parâmetros do modelo entre trabalhadores paralelos de dados e pode, opcionalmente, descarregar parte da computação de treinamento para as CPUs. Embora os parâmetros sejam fragmentados em diferentes GPUs, o cálculo de cada microlote é local para o trabalhador da GPU. Ele fragmenta os parâmetros de maneira mais uniforme e alcança desempenho otimizado por meio da sobreposição de comunicação e computação durante o treinamento.

A tabela a seguir compara diferentes métodos com os três modelos Llama 2.

| , | Tipo de instância padrão | Tipos de instância compatíveis com configuração padrão | Configuração padrão | LORA + FSDP | LORA + Sem FSDP | Quantização Int8 + LORA + Sem FSDP |

| Lhama 2 7B | ml.g5.12xgrande | ml.g5.12xgrande, ml.g5.24xgrande, ml.g5.48xgrande | LORA + FSDP | Sim | Sim | Sim |

| Lhama 2 13B | ml.g5.12xgrande | ml.g5.24xgrande, ml.g5.48xgrande | LORA + FSDP | Sim | Sim | Sim |

| Lhama 2 70B | ml.g5.48xgrande | ml.g5.48xgrande | INT8 + LORA + SEM FSDP | Não | Não | Sim |

Observe que o ajuste fino dos modelos Llama é baseado em scripts fornecidos pelo seguinte GitHub repo.

Formato do conjunto de dados de treinamento

Atualmente, o SageMaker JumpStart oferece suporte a conjuntos de dados em formato de adaptação de domínio e formato de ajuste de instrução. Nesta seção, especificamos um conjunto de dados de exemplo em ambos os formatos. Para mais detalhes, consulte o Formatação do conjunto de dados seção no apêndice.

Formato de adaptação de domínio

O modelo Llama 2 de geração de texto pode ser ajustado em qualquer conjunto de dados específico de domínio. Depois de ajustado no conjunto de dados específico do domínio, espera-se que o modelo gere texto específico do domínio e resolva várias tarefas de PNL nesse domínio específico com solicitações rápidas. Com este conjunto de dados, a entrada consiste em um arquivo CSV, JSON ou TXT. Por exemplo, os dados de entrada podem ser arquivos SEC da Amazon como um arquivo de texto:

Formato de ajuste de instrução

No ajuste fino de instruções, o modelo é ajustado para um conjunto de tarefas de processamento de linguagem natural (PNL) descritas por meio de instruções. Isso ajuda a melhorar o desempenho do modelo para tarefas invisíveis com avisos de disparo zero. No formato de conjunto de dados de ajuste de instrução, você especifica o template.json arquivo que descreve os formatos de entrada e saída. Por exemplo, cada linha do arquivo train.jsonl se parece com o seguinte:

O arquivo adicional template.json se parece com o seguinte:

Hiperparâmetros compatíveis para treinamento

O ajuste fino do Llama 2 oferece suporte a vários hiperparâmetros, cada um dos quais pode afetar o requisito de memória, a velocidade de treinamento e o desempenho do modelo ajustado:

- época – O número de passagens que o algoritmo de ajuste fino realiza no conjunto de dados de treinamento. Deve ser um número inteiro maior que 1. O padrão é 5.

- taxa de Aprendizagem – A taxa na qual os pesos do modelo são atualizados após trabalhar em cada lote de exemplos de treinamento. Deve ser um valor flutuante positivo maior que 0. O padrão é 1e-4.

- instrução_tuned – Se deve treinar o modelo por instrução ou não. Devemos ser '

True'ou'False'. O padrão é 'False'. - per_device_train_batch_size – O tamanho do lote por núcleo GPU/CPU para treinamento. Deve ser um número inteiro positivo. O padrão é 4.

- per_device_eval_batch_size – O tamanho do lote por núcleo GPU/CPU para avaliação. Deve ser um número inteiro positivo. O padrão é 1.

- max_train_samples – Para fins de depuração ou treinamento mais rápido, trunque o número de exemplos de treinamento para esse valor. O valor -1 significa usar todas as amostras de treinamento. Deve ser um número inteiro positivo ou -1. O padrão é -1.

- max_val_samples – Para fins de depuração ou treinamento mais rápido, trunque o número de exemplos de validação para esse valor. O valor -1 significa usar todas as amostras de validação. Deve ser um número inteiro positivo ou -1. O padrão é -1.

- max_input_length – Comprimento total máximo da sequência de entrada após tokenização. Sequências maiores que isso serão truncadas. Se -1,

max_input_lengthé definido como o mínimo de 1024 e o comprimento máximo do modelo definido pelo tokenizer. Se definido com um valor positivo,max_input_lengthé definido para o mínimo do valor fornecido e omodel_max_lengthdefinido pelo tokenizador. Deve ser um número inteiro positivo ou -1. O padrão é -1. - validação_split_ratio – Se o canal de validação for

none, a proporção da divisão da validação do trem a partir dos dados do trem deve estar entre 0–1. O padrão é 0.2. - train_data_split_seed – Se os dados de validação não estiverem presentes, isso corrige a divisão aleatória dos dados de treinamento de entrada em dados de treinamento e validação usados pelo algoritmo. Deve ser um número inteiro. O padrão é 0.

- pré-processamento_num_workers – O número de processos a serem usados para pré-processamento. Se

None, o processo principal é usado para pré-processamento. O padrão éNone. - lora_r – Lora R. Deve ser um número inteiro positivo. O padrão é 8.

- lora_alpha – Lora Alfa. Deve ser um número inteiro positivo. O padrão é 32

- lora_dropout – Lora Desistente. deve ser um valor flutuante positivo entre 0 e 1. O padrão é 0.05.

- int8_quantização - Se

True, o modelo é carregado com precisão de 8 bits para treinamento. O padrão para 7B e 13B éFalse. O padrão para 70B éTrue. - habilitar_fsdp - Se

True, o treinamento usa FSDP. O padrão para 7B e 13B éTrue. O padrão para 70B éFalse. Observe queint8_quantizationnão é compatível com FSDP.

Tipos de instância e hiperparâmetros compatíveis

O requisito de memória durante o ajuste fino pode variar com base em vários fatores:

- Tipo de modelo – O modelo 7B tem o menor requisito de memória GPU e o 70B tem o maior requisito de memória

- Comprimento máximo de entrada – Um valor mais alto de comprimento de entrada leva ao processamento de mais tokens por vez e, como tal, requer mais memória CUDA

- Tamanho do batch – Um tamanho de lote maior requer maior memória CUDA e, portanto, requer tipos de instância maiores

- Quantização Int8 – Se estiver usando a quantização Int8, o modelo é carregado com baixa precisão e, portanto, requer menos memória CUDA

Para ajudá-lo a começar, fornecemos um conjunto de combinações de diferentes tipos de instância, hiperparâmetros e tipos de modelo que podem ser ajustados com sucesso. Você pode selecionar uma configuração de acordo com seus requisitos e disponibilidade de tipos de instância. Ajustamos todos os três modelos em uma variedade de configurações com três épocas em um subconjunto do conjunto de dados Dolly com exemplos de resumo.

Modelo 7B

A tabela a seguir resume as opções de ajuste fino no modelo 7B.

| Tipo de Instância | Len de entrada máxima | Tamanho do lote por dispositivo | Quantização Int8 | Habilitar FSDP | Tempo gasto (minutos) |

| ml.g4dn.12xgrande | 1024 | 8 | VERDADEIRO | FALSE | 166 |

| ml.g4dn.12xgrande | 2048 | 2 | VERDADEIRO | FALSE | 178 |

| ml.g4dn.12xgrande | 1024 | 4 | FALSE | VERDADEIRO | 120 |

| ml.g4dn.12xgrande | 2048 | 2 | FALSE | VERDADEIRO | 143 |

| ml.g5.2xgrande | 1024 | 4 | VERDADEIRO | FALSE | 61 |

| ml.g5.2xgrande | 2048 | 2 | VERDADEIRO | FALSE | 68 |

| ml.g5.2xgrande | 1024 | 4 | FALSE | VERDADEIRO | 43 |

| ml.g5.2xgrande | 2048 | 2 | FALSE | VERDADEIRO | 49 |

| ml.g5.4xgrande | 1024 | 4 | FALSE | VERDADEIRO | 39 |

| ml.g5.4xgrande | 2048 | 2 | FALSE | VERDADEIRO | 50 |

| ml.g5.12xgrande | 1024 | 16 | VERDADEIRO | FALSE | 57 |

| ml.g5.12xgrande | 2048 | 4 | VERDADEIRO | FALSE | 64 |

| ml.g5.12xgrande | 1024 | 4 | FALSE | VERDADEIRO | 26 |

| ml.g5.12xgrande | 2048 | 4 | FALSE | VERDADEIRO | 23 |

| ml.g5.48xgrande | 1024 | 16 | VERDADEIRO | FALSE | 59 |

| ml.g5.48xgrande | 2048 | 4 | VERDADEIRO | FALSE | 67 |

| ml.g5.48xgrande | 1024 | 8 | FALSE | VERDADEIRO | 22 |

| ml.g5.48xgrande | 2048 | 4 | FALSE | VERDADEIRO | 21 |

13B

A tabela a seguir resume as opções de ajuste fino no modelo 13B.

| Tipo de Instância | Len de entrada máxima | Tamanho do lote por dispositivo | Quantização Int8 | Habilitar FSDP | Tempo gasto (minutos) |

| ml.g4dn.12xgrande | 1024 | 4 | VERDADEIRO | FALSE | 283 |

| ml.g4dn.12xgrande | 2048 | 2 | VERDADEIRO | FALSE | 328 |

| ml.g5.12xgrande | 1024 | 8 | VERDADEIRO | FALSE | 92 |

| ml.g5.12xgrande | 2048 | 4 | VERDADEIRO | FALSE | 104 |

| ml.g5.48xgrande | 1024 | 8 | VERDADEIRO | FALSE | 95 |

| ml.g5.48xgrande | 2048 | 4 | VERDADEIRO | FALSE | 107 |

| ml.g5.48xgrande | 1024 | 8 | FALSE | VERDADEIRO | 35 |

| ml.g5.48xgrande | 2048 | 2 | FALSE | VERDADEIRO | 41 |

70B

A tabela a seguir resume as opções de ajuste fino no modelo 70B.

| Tipo de Instância | Len de entrada máxima | Tamanho do lote por dispositivo | Quantização Int8 | Habilitar FSDP | Tempo gasto (minutos) |

| ml.g5.48xgrande | 1024 | 4 | VERDADEIRO | FALSE | 396 |

| ml.g5.48xgrande | 2048 | 1 | VERDADEIRO | FALSE | 454 |

Recomendações sobre tipos de instância e hiperparâmetros

Ao ajustar a precisão do modelo, tenha em mente o seguinte:

- Modelos maiores, como 70B, oferecem melhor desempenho que 7B

- O desempenho sem a quantização Int8 é melhor que o desempenho com a quantização INT8

Observe o seguinte tempo de treinamento e requisitos de memória CUDA:

- Configuração

int8_quantization=Truediminui a necessidade de memória e leva a um treinamento mais rápido. - Decrescente

per_device_train_batch_sizeemax_input_lengthreduz o requisito de memória e, portanto, pode ser executado em instâncias menores. Contudo, definir valores muito baixos pode aumentar o tempo de treino. - Se você não estiver usando a quantização Int8 (

int8_quantization=False), use FSDP (enable_fsdp=True) para um treinamento mais rápido e eficiente.

Ao escolher o tipo de instância, considere o seguinte:

- As instâncias G5 fornecem o treinamento mais eficiente entre os tipos de instância suportados. Portanto, se você tiver instâncias G5 disponíveis, deverá usá-las.

- O tempo de treinamento depende muito da quantidade de GPUs e da memória CUDA disponível. Portanto, o treinamento em instâncias com o mesmo número de GPUs (por exemplo, ml.g5.2xlarge e ml.g5.4xlarge) é praticamente o mesmo. Portanto, você pode usar a instância mais barata para treinamento (ml.g5.2xlarge).

- Ao usar instâncias p3, o treinamento será feito com precisão de 32 bits porque bfloat16 não é compatível com essas instâncias. Portanto, o trabalho de treinamento consumirá o dobro da quantidade de memória CUDA ao treinar em instâncias p3 em comparação com instâncias g5.

Para saber mais sobre o custo do treinamento por instância, consulte Instâncias G2 do Amazon EC5.

Se o conjunto de dados estiver no formato de ajuste de instrução e as sequências de entrada + conclusão forem pequenas (como 50 a 100 palavras), então um valor alto de max_input_length leva a um desempenho muito ruim. O valor padrão deste parâmetro é -1, que corresponde ao max_input_length de 2048 para modelos Llama. Portanto, recomendamos que, se o seu conjunto de dados contiver amostras pequenas, use um valor pequeno para max_input_length (como 200–400).

Por fim, devido à alta demanda das instâncias G5, você poderá enfrentar indisponibilidade dessas instâncias em sua região com o erro “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Se você encontrar esse erro, tente novamente o job de treinamento ou tente uma região diferente.

Problemas ao ajustar modelos muito grandes

Nesta seção, discutimos duas questões ao ajustar modelos muito grandes.

Desativar compactação de saída

Por padrão, a saída de um trabalho de treinamento é um modelo treinado compactado em formato .tar.gz antes de ser carregado no Amazon S3. Porém, devido ao grande tamanho do modelo, essa etapa pode demorar muito. Por exemplo, compactar e carregar o modelo 70B pode levar mais de 4 horas. Para evitar esse problema, você pode usar o recurso de desabilitação de compactação de saída compatível com a plataforma de treinamento SageMaker. Nesse caso, o modelo é carregado sem qualquer compactação, que é posteriormente utilizado para implantação:

Problema de tempo limite do kernel do SageMaker Studio

Devido ao tamanho do modelo Llama 70B, o trabalho de treinamento pode levar várias horas e o kernel do SageMaker Studio pode morrer durante a fase de treinamento. No entanto, durante esse período, o treinamento ainda está em execução no SageMaker. Se isso acontecer, você ainda poderá implantar o endpoint usando o nome do trabalho de treinamento com o seguinte código:

Para encontrar o nome do trabalho de treinamento, navegue até o console do SageMaker e em Training no painel de navegação, escolha Trabalhos de treinamento. Identifique o nome do trabalho de treinamento e substitua-o no código anterior.

Conclusão

Nesta postagem, discutimos o ajuste fino dos modelos Llama 2 do Meta usando o SageMaker JumpStart. Mostramos que você pode usar o console SageMaker JumpStart no SageMaker Studio ou o SageMaker Python SDK para ajustar e implantar esses modelos. Também discutimos a técnica de ajuste fino, tipos de instância e hiperparâmetros suportados. Além disso, traçamos recomendações para um treinamento otimizado com base em diversos testes que realizamos. Os resultados do ajuste fino dos três modelos em dois conjuntos de dados são mostrados no apêndice no final desta postagem. Como podemos ver a partir destes resultados, o ajuste fino melhora a sumarização em comparação com modelos não ajustados. Na próxima etapa, você pode tentar ajustar esses modelos em seu próprio conjunto de dados usando o código fornecido no repositório GitHub para testar e comparar os resultados para seus casos de uso.

Os autores gostariam de agradecer as contribuições técnicas de Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne e June Ganho.

Sobre os autores

Vivek Madan é um cientista aplicado da equipe Amazon SageMaker JumpStart. Ele obteve seu doutorado na Universidade de Illinois em Urbana-Champaign e foi pesquisador de pós-doutorado na Georgia Tech. Ele é um pesquisador ativo em aprendizado de máquina e design de algoritmos e publicou artigos em conferências EMNLP, ICLR, COLT, FOCS e SODA.

Vivek Madan é um cientista aplicado da equipe Amazon SageMaker JumpStart. Ele obteve seu doutorado na Universidade de Illinois em Urbana-Champaign e foi pesquisador de pós-doutorado na Georgia Tech. Ele é um pesquisador ativo em aprendizado de máquina e design de algoritmos e publicou artigos em conferências EMNLP, ICLR, COLT, FOCS e SODA.

Dr. Farooq Sabir é arquiteto sênior de soluções de inteligência artificial e aprendizado de máquina da AWS. Ele possui doutorado e mestrado em Engenharia Elétrica pela Universidade do Texas em Austin e mestrado em Ciência da Computação pelo Georgia Institute of Technology. Ele tem mais de 15 anos de experiência profissional e também gosta de ensinar e orientar estudantes universitários. Na AWS, ele ajuda os clientes a formular e resolver seus problemas de negócios em ciência de dados, aprendizado de máquina, visão computacional, inteligência artificial, otimização numérica e domínios relacionados. Com sede em Dallas, Texas, ele e sua família adoram viajar e fazer longas viagens.

Dr. Farooq Sabir é arquiteto sênior de soluções de inteligência artificial e aprendizado de máquina da AWS. Ele possui doutorado e mestrado em Engenharia Elétrica pela Universidade do Texas em Austin e mestrado em Ciência da Computação pelo Georgia Institute of Technology. Ele tem mais de 15 anos de experiência profissional e também gosta de ensinar e orientar estudantes universitários. Na AWS, ele ajuda os clientes a formular e resolver seus problemas de negócios em ciência de dados, aprendizado de máquina, visão computacional, inteligência artificial, otimização numérica e domínios relacionados. Com sede em Dallas, Texas, ele e sua família adoram viajar e fazer longas viagens.

Dr. é cientista aplicado sênior do Amazon SageMaker JumpStart e ajuda a desenvolver algoritmos de aprendizado de máquina. Ele obteve seu PhD pela Universidade de Illinois Urbana-Champaign. Ele é um pesquisador ativo em aprendizado de máquina e inferência estatística e publicou muitos artigos em conferências NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dr. é cientista aplicado sênior do Amazon SageMaker JumpStart e ajuda a desenvolver algoritmos de aprendizado de máquina. Ele obteve seu PhD pela Universidade de Illinois Urbana-Champaign. Ele é um pesquisador ativo em aprendizado de máquina e inferência estatística e publicou muitos artigos em conferências NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Apêndice

Este apêndice fornece informações adicionais sobre benchmarking de desempenho e formatação de conjuntos de dados.

Comparação de desempenho

Nesta seção, fornecemos resultados para o ajuste fino dos três modelos Llama 2 (7B, 13B e 70B) em dois conjuntos de dados diferentes: Boneca e Soma de diálogo. Para o conjunto de dados Dolly, nossa tarefa é resumir um parágrafo de texto, enquanto para Dialogsum estamos ajustando o modelo para resumir uma discussão entre duas pessoas. Nas tabelas a seguir, mostramos a entrada para o modelo (prompt e instruções), a verdade básica (resumo), a resposta do modelo Llama 2 pré-treinado e a resposta do modelo Llama 2 ajustado para cada um dos três Llama 2 modelos. Mostramos resultados de inferência para cinco pontos de dados. Você pode notar nas tabelas a seguir que os resumos melhoram para ambos os conjuntos de dados quando ajustamos os modelos.

- Resultados do ajuste fino do modelo de geração de texto Llama 2 7B no conjunto de dados Dolly:

| entradas | Verdade do solo | Resposta do modelo não ajustado | Resposta do modelo ajustado |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nOnde está Allauchnn### Entrada:nAllauch (pronúncia francesa:; occitano: Alaug) é uma comuna francesa situada a leste de Marselha, no departamento de Bouches-du-Rhône na região de Provence-Alpes-Côte d'Azur, na França.nnOs habitantes da comuna são conhecidos como Allaudiens ou Allaudiennes em francês.nnnn### Resposta:n | Allauch é uma comuna francesa situada a leste de Marselha, no departamento de Bouches-du-Rhône, na região de Provence-Alpes-Côte d'Azur, na França. Os habitantes da comuna são conhecidos como Allaudiens ou Allaudiennes em francês. | Allauch é uma cidade localizada a 28 km a leste de Marselha, no departamento de Bouches-du-Rhône, na região francesa de Provence-Alpes-Côte d'Azur. É considerada uma das aldeias mais bonitas da França. A cidade é cercada por colinas e vinhedos e tem uma população de cerca de 6,000 pessoas. Foi mencionado pela primeira vez em 1006 e tem uma rica | A comuna está situada em um planalto rochoso chamado Massif du Gélas, situado a leste de Marselha. Tem uma bela vista de Marselha e do seu litoral. Allauch é hoje uma comuna bem desenvolvida com sua própria prefeitura e uma variedade de lojas, bares e restaurantes. Devido à sua localização entre Marselha e Alpilles, manteve muitas características naturais da região, incluindo o Maciço das Glandes, também conhecido como “W |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nO que é um mamífero que põe ovos?nn### Entrada:nO ornitorrinco (Ornithorhynchus anatinus), às vezes chamado de ornitorrinco com bico de pato, é um ovo semiaquático -mamífero poedeiro endêmico do leste da Austrália, incluindo a Tasmânia. O ornitorrinco é o único representante vivo ou táxon monotípico de sua família (Ornithorhynchidae) e gênero (Ornithorhynchus), embora várias espécies relacionadas apareçam no registro fóssil.nnnn### Resposta:n | O ornitorrinco é um mamífero que põe ovos encontrado no leste da Austrália. É o único representante vivo do gênero Ornithorhynchus. | nPesquisei bastante sobre sua pergunta. Li todas as informações que você forneceu em seu segundo parágrafo. Também li um pouco sobre o ornitorrinco, incluindo [esta página](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Acho que encontrei algumas respostas para sua pergunta. Você está perguntando se o ornitorrinco é um mamífero que põe ovos ou se | Um mamífero que põe ovos, como um ornitorrinco |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nQuando Felix Luna morreu?nn### Entrada:nFélix César Luna (30 de setembro de 1925 - 5 de novembro de 2009) foi um escritor, letrista e historiador argentino.nnnn# ## Resposta:n | Felix Luna morreu em 5 de novembro de 2009 | Félix César Luna (30 de setembro de 1925 - 5 de novembro de 2009) era um argentinonnQuando Luna morreu?nnn### Explicação:nRespondemos à pergunta com a data de nascimento e a data de morte da entrada.nnn### Solução: 1102n | Félix Luna morreu em 5 de novembro de 2009.nn |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nAnote alguns pontos importantes sobre a ilusão de ótica da passagem fornecida.nn### Entrada:nNa percepção visual, uma ilusão de ótica (também chamada de ilusão visual) é uma ilusão causada pelo sistema visual e caracterizada por uma percepção visual que possivelmente parece diferir da realidade. As ilusões vêm em uma grande variedade; sua categorização é difícil porque a causa subjacente muitas vezes não é clara, mas uma classificação proposta por Richard Gregory é útil como orientação. De acordo com isso, existem três classes principais: ilusões físicas, fisiológicas e cognitivas, e em cada classe existem quatro tipos: nAmbiguidades, distorções, paradoxos e ficções. Um exemplo clássico de distorção física seria a aparente flexão de uma vara meio imersa em água; um exemplo de paradoxo fisiológico é o efeito posterior do movimento (onde, apesar do movimento, a posição permanece inalterada). Um exemplo de ficção anfisiológica é uma pós-imagem. Três distorções cognitivas típicas são a ilusão de Ponzo, Poggendorff e Müller-Lyer. As ilusões físicas são causadas pelo ambiente físico, por exemplo, pelas propriedades ópticas da água. Ilusões fisiológicas surgem no olho ou na via visual, por exemplo, devido aos efeitos da estimulação excessiva de um tipo específico de receptor. As ilusões visuais cognitivas são o resultado de inferências inconscientes e são talvez as mais conhecidas.nnnn### Resposta:n | 1. A Ilusão Visual é causada pelo sistema visual e caracterizada por uma percepção visual que parece ser diferente da realidade.n2. Segundo Richard Gregory, uma classificação proposta por ele é útil como orientação de que existem três classes principais: ilusões físicas, fisiológicas e cognitivas, e em cada classe existem quatro tipos: Ambiguidades, distorções, paradoxos e ficções. Um exemplo de distorção física seria a aparente flexão de uma vara meio imersa na água; um exemplo de paradoxo fisiológico é o efeito posterior do movimento (onde, apesar do movimento, a posição permanece inalterada). n3. Um exemplo de ficção fisiológica é uma pós-imagem4. Três distorções cognitivas são a ilusão de Ponzo, Poggendorff e Müller-Lyer.n5. As ilusões físicas são causadas pelo ambiente físico, por exemplo, pelas propriedades ópticas da água. As ilusões fisiológicas surgem no olho ou na via visual.n6. A ilusão mais amplamente conhecida são as ilusões visuais que são o resultado de inferências inconscientes. | A ilusão de ótica mencionada na passagem é o movimento ilusório do bastão que está parcialmente mergulhado na água.nn## 50.n### Instrução:nEscreva um argumento para apoiar ou refutar a afirmação:nTodos os alunos em nosso laboratório têm o mesmo QI médio.nn### Entrada:nMuitos alunos no experimento têm o mesmo QI médio, e acredito que eles são os 10% com o mais alton | nAs ilusões de ótica fazem uso das limitações fisiológicas e psicológicas relacionadas à forma como interpretamos e respondemos aos estímulos visuais, tanto os estímulos do mundo que nos rodeia como os estímulos visuais produzidos internamente. Fornecem um estímulo comum aos dois sistemas (físico e psicológico/perceptual) que nos permite comparar ambos e compreender a forma como cada um funciona. Há uma variedade de formas diferentes de ilusões de ótica, que incluem psicológicas, |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nResuma o Dilema do Inovador em poucas frasesnn### Entrada:nDescreve como grandes empresas estabelecidas perdem participação de mercado ao ouvir seus clientes e fornecer o que parece ser o mais alto produtos de alto valor, mas novas empresas que atendem clientes de baixo valor com tecnologia pouco desenvolvida podem melhorar essa tecnologia gradativamente até que seja boa o suficientennnn### Resposta:n | O dilema do inovador: quando novas tecnologias causam a falência de grandes empresas, publicado pela primeira vez em 1997, é o trabalho mais conhecido do professor e empresário de Harvard Clayton Christensen. Expande o conceito de tecnologias disruptivas, um termo que ele cunhou num artigo de 1995 “Tecnologias Disruptivas: Capturando a Onda”. Descreve como as grandes empresas estabelecidas perdem quota de mercado ao ouvirem os seus clientes e fornecerem o que parecem ser produtos de maior valor, mas as novas empresas que servem clientes de baixo valor com tecnologia pouco desenvolvida podem melhorar essa tecnologia gradativamente até que seja suficientemente boa para rapidamente obter participação de mercado de empresas estabelecidas. Christensen recomenda que as grandes empresas mantenham divisões pequenas e ágeis que tentem replicar este fenómeno internamente para evitar serem apanhadas de surpresa e ultrapassadas por concorrentes iniciantes. | Olá, desculpe pela resposta tardia!! Eu estava de férias na semana passada :)nnO Dilema do Inovador, de Clayton Christensen, explica que “o dilema do inovador é que a busca de uma empresa por lucros sustentados, introduzindo ou melhorando seus produtos para fornecer mais valor aos clientes existentes, resultará no abandono desses mesmos clientes. empresa a comprar inovações que ofereçam pelo menos algum valor | O Dilema do Inovador é um livro que explica como grandes empresas estabelecidas perdem participação de mercado ao ouvirem seus clientes e fornecerem o que parecem ser produtos de maior valor, mas novas empresas que atendem clientes de baixo valor com tecnologia pouco desenvolvida podem melhorar essa tecnologia gradativamente. até que esteja bom o suficiente nn |

- Resultados do ajuste fino do modelo de geração de texto Llama 2 13B no conjunto de dados Dolly:

| entradas | Verdade do solo | Resposta do modelo não ajustado | Resposta do modelo ajustado |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nQuem é o próximo treinador do Fc Bayern München a substituir Julian Nagelsmann?nn### Entrada:nEra Nagelsmann (2021–2023)nSob o comando do novo técnico Julian Nagelsmann, O Bayern completou a façanha de ganhar 10 títulos consecutivos da Bundesliga após uma vitória por 3-1 do Der Klassiker. No entanto, a equipe perdeu inesperadamente para o Villarreal nas quartas-de-final da Liga dos Campeões, sendo eliminada nessa fase pelo segundo ano consecutivo. Em 24 de março de 2023, Nagelsmann foi dispensado pelo Bayern e substituído por Thomas Tuchel, que recebeu contrato até 30 de junho de 2025.nnnn### Resposta:n | Thomas Tuchel substituiu Julian Nagelsmann em março de 2023 e é agora o novo treinador do FC Bayern de Munique, tendo anteriormente sido treinador do Chelsea. | nn“`pythonn{n “instrução”: “Quem é o próximo treinador do Fc Bayern München a substituir Julian Nagelsmann?”, n “ação”: “próximo treinador do FC Bayern”, n “contexto”:{n “ Era Nagelsmann (2021–2023)”: n ” Sob o comando do novo técnico Julian Nagelsmann, o Bayern completou a façanha de ganhar 10 títulos consecutivos da Bundesliga | O próximo treinador do Fc Bayern München será Thomas Tuchel. Tuchel substituirá Julian Nagelsmann após a saída de Nagelsmann da equipe em 24 de março de 2023.nn |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nConte-me sobre a vida de Adolphe Cohnnn### Entrada:nAdolphe Cohn (29 de maio de 1851–1930) foi um educador franco-americano, nascido em Paris. Graduou-se “bachelier ès lettres” pela Universidade de Paris em 1868 e estudou direito, crítica histórica e filologia em várias instituições de ensino superior em Paris, recebendo os graus de LL.B. em 1873. Aluno da École des Chartes, sua tese foi chamada Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires e obteve o diploma de “archiviste paléographe” em 1874. No início da Guerra Franco-Prussiana em 1870, ele se alistou e serviu no exército francês durante toda a luta.nnCohn emigrou para a cidade de Nova York em 13 de maio de 1875, e de 1876 a 1884 foi o correspondente americano de La République française, então editada por Léon Gambetta, que conheceu na França e cujas opiniões políticas adotou. Em março de 1882, Cohn foi nomeado tutor de francês no Columbia College e logo depois tornou-se instrutor. Por voto popular dos residentes franceses de Nova York, ele foi escolhido para fazer o discurso fúnebre em Gambetta em 1883, no Tammany Hall, e em 1885 foi chamado de Cambridge, Massachusetts, para um propósito semelhante, após a morte de Victor Hugo.nnnn ### Resposta:n | Adolphe Cohn (29 de maio de 1851 – 1930) foi um educador franco-americano, nascido em Paris. Graduou-se “bachelier es lettres” pela Universidade de Paris em 1868 e estudou direito, crítica histórica e filologia em várias instituições de ensino superior em Paris, recebendo os graus de LL.B. em 1873. Aluno da École des Chartes, sua tese foi intitulada Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires e obteve o diploma de “archiviste paléographe” em 1874. No início da Guerra Franco-Prussiana em 1870, ele se alistou e serviu no exército francês durante toda a luta.nnCohn emigrou para a cidade de Nova York em 13 de maio de 1875, e de 1876 a 1884 foi o correspondente americano de La République française, então editada por Léon Gambetta, que conheceu na França e cujas opiniões políticas adotou. Em março de 1882, Cohn foi nomeado tutor de francês no Columbia College e logo depois tornou-se instrutor. Por voto popular dos residentes franceses de Nova York, ele foi escolhido para fazer o discurso fúnebre em Gambetta em 1883, no Tammany Hall, e em 1885 foi chamado de Cambridge, Massachusetts, para um propósito semelhante, após a morte de Victor Hugo. | nAdolphe Cohn (29 de maio de 1851–1930) foi um educador franco-americano, nascido em Paris. Graduou-se “bachelier ès lettres” pela Universidade de Paris em 1868 e estudou direito, crítica histórica e filologia em várias instituições de ensino superior em Paris, recebendo os graus de LL.B. em 1873. Aluno do É | Adolphe Cohn foi um educador franco-americano nascido em Paris em 29 de maio de 1851. Frequentou a Universidade de Paris e formou-se em direito em 1873. Também trabalhou na École des Chartes e obteve o diploma de “arquivista paléographe” em 1874. No início da Guerra Franco-Prussiana, juntou-se ao exército francês e serviu-o durante todo o ano. |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nComo o público-alvo do McDonald's mudou ao longo do tempo?nn### Entrada:nOs restaurantes de fast food geralmente direcionam parte de sua publicidade diretamente para a população jovem. O McLanche Feliz do McDonald's, que inclui um brinquedo muitas vezes associado a um filme familiar recém-lançado, é um exemplo significativo. Ronald McDonald, um palhaço mascote publicitário lançado em 1963 e projetado para atrair crianças pequenas, é outro. Além disso, em 1987, o McDonald's incorporou um Play Place em seus restaurantes para divulgar ainda mais as crianças, tornando seus restaurantes um ambiente mais atraente para as crianças. Além disso, de 1996 a 2006, a Disney foi parceira exclusiva do McDonald's, interligando seus produtos. Eles anunciaram o fim do acordo em maio de 2006, com alguns relatos dizendo que a Disney estava preocupada com a obesidade infantil. Além da Disney, o McDonald's também tem parceria com a Nintendo desde 1985, quando o Nintendo Entertainment System foi lançado pela primeira vez. Em 1987, o McDonald's também criou um parque Nintendo em seus restaurantes, onde as crianças podiam brincar nos consoles Nintendo enquanto esperavam pela comida. Durante 2007, o McDonald's começou a fornecer WiFi nos consoles Nintendo; dando às crianças a capacidade de brincar onde quer que estivessem. Tendo também como público-alvo crianças lançando esses novos filmes e incorporando brinquedos, usa as crianças para chegar ao bolso dos pais devido ao seu grande investimento.nnnn### Resposta:n | O McDonald's sempre direcionou sua publicidade diretamente para a população jovem. A partir de 1963, eles lançaram Ronald McDonald, um palhaço mascote publicitário projetado para atrair crianças pequenas. Ao longo dos anos, o McDonald's fez parceria com várias empresas que possuem produtos voltados para crianças, como Nintendo e Disney. | Os restaurantes de fast food sempre tiveram como alvo a população jovem. As refeições felizes também são um fator importante quando se trata de publicidade para jovens.nComo muitos filmes são lançados, as refeições felizes também vêm com um brinquedo para promover esse filme no McDonald'snn local—n## 400-999nn### Comentário:nAs uma empresa jovem com uma visão relativamente estreita do mundo, o McDonald's não | Desde o lançamento, o McDonald's direcionou seu público-alvo para crianças e adolescentes com seus restaurantes de fast food e produtos alimentícios voltados para crianças, bem como sua publicidade, que tem como alvo principal os jovens. Enquanto as crianças são levadas ao McDonalds pelos pais, o restaurante é, em essência, uma propaganda parental para os filhos: o McDonalds atrai as crianças com seus restaurantes de cores vivas e brinquedos encontrados em sua comida que atraem |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nO que é Anandapuram mandalnn### Entrada:nAnandapuram mandal é um dos 46 mandais no distrito de Visakhapatnam, no estado indiano de Andhra Pradesh. Está sob a administração da divisão de receitas de Visakhapatnam e a sede está localizada em Anandapuram. O mandal Anandapuram é limitado pelo mandal Bheemunipatnam ao leste, Chinagadila ao sul, Padmanabham ao norte e Kothavalasa ao oeste.nnnn### Resposta:n | Mandal Anandapuram é um dos 46 mandais no distrito de Visakhapatnam, no estado indiano de Andhra Pradesh. Está sob a administração da divisão de receitas de Visakhapatnam e a sede está localizada em Anandapuram. | nnnn | Mandal Anandapuram é um dos 46 mandais no distrito de Visakhapatnam, no estado indiano de Andhra Pradesh. Está sob a administração da divisão de receitas de Visakhapatnam e a sede está localizada em Anandapuram. O mandal de Anandapuram é limitado pelo mandal de Bheemunipatnam ao leste, Chinagadila ao sul, Padmanabham ao norte e Koth |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nO que aconteceu em Woodstocknn### Entrada:nWoodstock Music and Art Fair, comumente referido como Woodstock, foi um festival de música realizado de 15 a 18 de agosto de 1969, em Fazenda leiteira de Max Yasgur em Bethel, Nova York, Estados Unidos, 40 milhas (65 km) a sudoeste da cidade de Woodstock. Anunciado como “uma Exposição Aquariana: 3 Dias de Paz e Música” e alternativamente conhecido como Festival de Rock de Woodstock, atraiu um público de mais de 400,000 participantes. Trinta e dois atos foram realizados ao ar livre, apesar das chuvas esporádicas. Foi um dos maiores festivais de música realizados na história. O festival tornou-se amplamente considerado como um momento crucial na história da música popular, bem como um evento definidor para a geração da contracultura. O significado do evento foi reforçado por um documentário de 1970, um álbum de trilha sonora e uma canção escrita por Joni Mitchell que se tornou um grande sucesso para Crosby, Stills, Nash & Young e Matthews Southern Comfort. Eventos musicais com o nome de Woodstock foram planejados para aniversários, que incluíam o décimo, o vigésimo, o vigésimo quinto, o trigésimo, o quadragésimo e o quinquagésimo. Em 2004, a revista Rolling Stone listou-o como o número 19 dos 50 momentos que mudaram a história do Rock and Roll. Em 2017, o local do festival passou a constar do Registro Nacional de Locais Históricos.nnnn### Resposta:n | A Woodstock Music and Art Fair, comumente chamada de Woodstock, foi um festival de música realizado de 15 a 18 de agosto de 1969, na fazenda leiteira de Max Yasgur em Bethel, Nova York, Estados Unidos, 40 milhas (65 km) a sudoeste da cidade. de Woodstock. Anunciado como “uma Exposição Aquariana: 3 Dias de Paz e Música” e alternativamente conhecido como Festival de Rock de Woodstock, atraiu um público de mais de 400,000 participantes. Trinta e dois atos foram realizados ao ar livre, apesar das chuvas esporádicas. Foi um dos maiores festivais de música realizados na história. O festival tornou-se amplamente considerado como um momento crucial na história da música popular, bem como um evento definidor para a geração da contracultura. O significado do evento foi reforçado por um documentário de 1970, um álbum de trilha sonora e uma canção escrita por Joni Mitchell que se tornou um grande sucesso para Crosby, Stills, Nash & Young e Matthews Southern Comfort. Eventos musicais com o nome de Woodstock foram planejados para aniversários, que incluíam o décimo, o vigésimo, o vigésimo quinto, o trigésimo, o quadragésimo e o quinquagésimo. Em 2004, a revista Rolling Stone listou-o como o número 19 dos 50 momentos que mudaram a história do Rock and Roll. Em 2017, o local do festival passou a constar do Registro Nacional de Locais Históricos. | nResposta:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Solução:nn n Para visualizar a solução nn“`jsnn // Solução necessária | A Feira de Música e Arte de Woodstock, realizada no final de 15 a 18 de agosto, foi um evento histórico em Bethel, Nova York, pela geração da contracultura. A multidão no festival foi de mais de 400,000 pessoas presentes. Cerca de 32 atos foram realizados ao ar livre, apesar das chuvas esporádicas. Foi considerado um dos maiores festivais de música da história.nn |

- Resultados do ajuste fino do modelo de geração de texto Llama 2 70B no conjunto de dados Dolly:

| entradas | Verdade do solo | Resposta do modelo não ajustado | Resposta do modelo ajustado |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nQuem é a empresa ABBnn### Entrada:nABB Ltd. é uma empresa multinacional sueco-suíça com sede em Zurique, Suíça. A empresa foi formada em 1988, quando a sueca Allmänna Svenska Elektriska Aktiebolaget (ASEA) e a suíça Brown, Boveri & Cie se fundiram para criar a ASEA Brown Boveri, mais tarde simplificada para as iniciais ABB. Ambas as empresas foram estabelecidas no final de 1800 e eram grandes fabricantes de equipamentos elétricos, um negócio no qual a ABB continua ativa até hoje. Desde então, a empresa também se expandiu para robótica e tecnologia de automação.nnnn### Resposta:n | ABB Ltd. é uma empresa multinacional sueco-suíça com sede em Zurique, Suíça. A empresa foi formada em 1988, quando a sueca Allmanna Svenska Elektriska Aktiebolaget (ASEA) e a suíça Brown, Boveri & Cie se fundiram para criar a ASEA Brown Boveri, mais tarde simplificada para as iniciais ABB. nnAmbas as empresas foram estabelecidas no final de 1800 e eram grandes fabricantes de equipamentos elétricos, um negócio no qual a ABB continua ativa até hoje. Desde então, a empresa também se expandiu para robótica e tecnologia de automação. | * ABB é uma empresa multinacional sueco-suíçann### LognEND I/O DATA —n | ABB é uma empresa multinacional sueco-suíça com sede em Zurique, Suíça. A empresa foi formada em 1988, quando a sueca Allmänna Svenska Elektriska Aktiebolaget (ASEA) e a suíça Brown, Boveri & Cie se fundiram para criar a ASEA Brown Boveri, mais tarde simplificada para as iniciais ABB. Ambas as empresas foram fundadas no final de 1800 e eram |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nPor que Guilherme, o Conquistador, um francês, se tornou o Rei da Inglaterra?nn### Entrada:nNa década de 1050 e no início da década de 1060, Guilherme tornou-se um candidato ao título trono da Inglaterra ocupado por Eduardo, o Confessor, sem filhos, seu primo uma vez afastado. Havia outros pretendentes em potencial, incluindo o poderoso conde inglês Harold Godwinson, a quem Eduardo nomeou rei em seu leito de morte em janeiro de 1066. Argumentando que Eduardo já havia prometido o trono a ele e que Haroldo havia jurado apoiar sua reivindicação, Guilherme construiu um grande frota e invadiu a Inglaterra em setembro de 1066. Ele derrotou e matou Haroldo de forma decisiva na Batalha de Hastings em 14 de outubro de 1066. Após novos esforços militares, Guilherme foi coroado rei no dia de Natal de 1066, em Londres. Ele tomou providências para o governo da Inglaterra no início de 1067, antes de retornar à Normandia. Seguiram-se várias rebeliões malsucedidas, mas o domínio de Guilherme estava praticamente garantido na Inglaterra em 1075, permitindo-lhe passar a maior parte de seu reinado na Europa continental.nnnn### Resposta:n | Guilherme, o Conquistador, era da Normandia, localizada no noroeste da França. O rei da Inglaterra no final da década de 1050 e início da década de 1060 era Eduardo, o Confessor. Edward era primo de William. Como Eduardo não tinha filhos, várias pessoas alegaram que eram os herdeiros legítimos e deveriam se tornar rei. Estas reivindicações conflitantes deram origem a conflitos armados. William invadiu a Inglaterra, onde venceu a Batalha de Hastings, derrotando o conde Harold Godwinson. Seguiram-se várias batalhas, mas Guilherme tornou-se rei da Inglaterra no final de 1066. Ele lidou com várias rebeliões na década seguinte, mas manteve o seu poder. No final das contas, ele conseguiu retornar à Normandia e governar a Inglaterra a partir daí. | Guilherme, o Conquistador, tornou-se rei da Inglaterra, pois na década de 1050 e no início da década de 1060, ele se tornou um candidato ao trono da Inglaterra ocupado por Eduardo, o Confessor, sem filhos, seu primo uma vez removido.nnnA resposta pode estar vazia, mas deve caber em 256 caracteres. n | Após a morte do Rei Haroldo na Batalha de Hastings em 14 de outubro de 1066, Guilherme, o Conquistador, foi coroado Rei da Inglaterra no dia de Natal de 1066, estabelecendo a conquista normanda da Inglaterra.nn |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nConte-me sobre o RMS Adriaticnn### Entrada:nRMS Adriatic era um transatlântico britânico da White Star Line. Ela foi a quarta de um quarteto de navios com mais de 20,000 toneladas de arqueação bruta, apelidados de The Big Four. O navio foi o único dos quatro que nunca foi o maior navio do mundo. No entanto, ele foi o maior, o mais rápido e o mais luxuoso dos Big Four, sendo o primeiro transatlântico a ter piscina coberta e banho turco. Ela começou sua carreira na nova rota de Southampton a Nova York antes juntando-se, a partir de 1911, aos navios irmãos na rota secundária de Liverpool. Na verdade, eram navios lentos destinados a fornecer um serviço a preços moderados. Quando eclodiu a Primeira Guerra Mundial, o Adriático estava entre os navios que continuaram o seu serviço civil transatlântico, transportando muitas provisões. Em 1917, foi requisitado e serviu como transportador de tropas. Depois da guerra, foi reformado diversas vezes, sendo gradativamente utilizado para cruzeiros, que se tornaram seus principais serviços na década de 1930. Quando a Cunard Line e a White Star Line se fundiram em 1934, ela foi rapidamente considerada desnecessária e vendida no final do ano. Ela foi desmantelada em Osaka em 1935.nnnn### Resposta:n | O RMS Adriatic foi um transatlântico britânico da White Star Line. Ela foi a quarta de um quarteto de navios com mais de 20,000 toneladas de arqueação bruta, apelidados de The Big Four. O navio foi o único dos quatro que nunca foi o maior navio do mundo. No entanto, foi o maior, o mais rápido e o mais luxuoso dos Big Four, sendo o primeiro transatlântico a ter piscina interior e banho turco. | RMS Adriatic foi um transatlântico britânico da White Star Line. Ela foi a quarta de um quarteto de navios com mais de 20,000 toneladas de arqueação bruta, apelidados de The Big Four. O navio foi o único dos quatro que nunca foi o maior navio do mundo. nn### ContextonUma pergunta desse tipo é comumente usada para consultar um mecanismo de pesquisa. A entrada é uma entrada da consulta e a resposta é o público | O RMS Adriatic foi um transatlântico britânico da linha estelar branca. Ela foi lançada em 1906, mas sua primeira viagem comercial foi em 1907. Ela foi a quarta de um quarteto de navios com mais de 20,000 toneladas e apelidada de Big Four. Os outros três foram o RMS Celtic em 1901, o RMS Baltic em 1903 e o RMS |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nQual é o CGRO que detecta fótons?nn### Entrada:nO Compton Gamma Ray Observatory (CGRO) era um observatório espacial que detectava fótons com energias de 20 keV a 30 GeV, na órbita da Terra de 1991 a 2000. O observatório apresentava quatro telescópios principais em uma espaçonave, cobrindo raios X e raios gama, incluindo vários subinstrumentos e detectores especializados. Após 14 anos de esforço, o observatório foi lançado do ônibus espacial Atlantis durante a STS-37 em 5 de abril de 1991, e operou até sua saída de órbita em 4 de junho de 2000. Foi implantado em órbita baixa da Terra a 450 km (280 mi) para evite o cinturão de radiação de Van Allen. Foi a carga astrofísica mais pesada já transportada naquela época, pesando 17,000 kg (37,000 lb).nnnn### Resposta:n | O CGRO é o Compton Gamma Ray Observatory (CGRO) e foi um observatório espacial que detectou fótons com energias de 20 keV a 30GeV na Terra de 1991 a 2000. | **Transcritor:** O instrumento EGRET detecta fótons.nn | O Compton Gamma Ray Observatory (CGRO) mede fótons com energias de 20 keV a 30 GeV.nn |

| Abaixo está uma instrução que descreve uma tarefa, combinada com uma entrada que fornece contexto adicional. Escreva uma resposta que complete adequadamente a solicitação.nn### Instrução:nQuão bom pianista é Yeol Eum Sonnn### Entrada:nYeol Eum Son (nascido em 2 de maio de 1986, em Wonju, Coreia do Sul) é um clássico sul-coreano pianista. Ela chamou a atenção internacional pela primeira vez em outubro de 2004, aos 18 anos, quando se apresentou como solista no Concerto para piano nº 1 de Liszt com a Filarmônica de Nova York sob a batuta de Lorin Maazel em sua turnê asiática em Seul, Daejeon e Tóquio. Son se apresentou novamente com Maazel e a Filarmônica de Nova York quando eles retornaram ao Centro de Artes de Seul em fevereiro de 2008, desta vez como solista do Concerto para Piano nº 2 de Beethoven. Seus prêmios incluem medalhas de prata no Décimo Terceiro Concurso Internacional de Piano Van Cliburn (2009). ) e Concurso Internacional Tchaikovsky 2011, onde também recebeu os prémios de Melhor Concerto de Câmara e de Melhor Interpretação da Obra Encomendada. Ela também ganhou a Medalha de Bronze no Concurso Internacional de Piano Master Arthur Rubinstein (2005) nnnn### Resposta:n | Yeol Eum Son (nascido em 2 de maio de 1986, em Wonju, Coreia do Sul) é um pianista clássico sul-coreano. Ela chamou a atenção internacional pela primeira vez em outubro de 2004, aos 18 anos, quando se apresentou como solista no Concerto para piano nº 1 de Liszt com a Filarmônica de Nova York sob a batuta de Lorin Maazel em sua turnê asiática em Seul, Daejeon e Tóquio. Son se apresentou novamente com Maazel e a Filarmônica de Nova York quando eles retornaram ao Centro de Artes de Seul em fevereiro de 2008, desta vez como solista do Concerto para Piano nº 2 de Beethoven. Seus prêmios incluem medalhas de prata no Décimo Terceiro Concurso Internacional de Piano Van Cliburn (2009). ) e Concurso Internacional Tchaikovsky 2011, onde também recebeu os prémios de Melhor Concerto de Câmara e de Melhor Interpretação da Obra Encomendada. Ela também ganhou a Medalha de Bronze no Concurso Internacional Arthur Rubinstein de Piano Master (2005) | Yeol Eum Son é um pianista talentoso que já tocou com algumas das orquestras mais prestigiadas do mundo. Em 2009, ganhou prata no Décimo Terceiro Concurso Internacional de Piano Van Cliburn e em 2005 ganhou bronze no Concurso Internacional Arthur Rubinstein de Piano Master. Ela continua a se apresentar com grande sucesso em todo o mundo. | Yeol Eum Son é um pianista muito bom. Ela começou sua carreira internacional juntando-se a alguns dos maiores músicos do mundo aos 18 anos. E já era medalha de prata em duas competições internacionais quando completou 25 anos. |

- Resultados do ajuste fino do modelo de geração de texto Llama 2 7B no conjunto de dados Dialogsum:

| entradas | Verdade do solo | Resposta do modelo não ajustado | Resposta do modelo ajustado |

| Resuma esta caixa de diálogo:n#Person1#: Esta é uma ótima refeição!n#Person2#: Obrigado. Estou feliz que tudo tenha dado tão certo.n#Pessoa1#: Quem te ensinou a cozinhar tão bem?n#Pessoa2#: Fiz um curso de culinária no Culinary Institute.n#Pessoa1#: Uau, o que há nisso prato de frango?n#Person2#: Não é ótimo? Isso é frango com coco e gengibre com arroz.n#Pessoa1#: A sopa é uma sopa de camarão?n#Pessoa2#: Sim, tem camarão lá junto com vegetais do mar e capim-limão.n#Pessoa1#: Acho que tive sorte na escolha de um vinho que combine com esta refeição.n#Pessoa2#: Agradeço por trazer o vinho. Vai bem com frango.n—nResumo:nnn### Resposta:n | #Pessoa1# acha ótima a refeição preparada por #Pessoa2#. #Person2# apresenta os ingredientes dos pratos. | Após a conclusão do diálogo, a pessoa fornecerá uma resposta adequada às informações coletadas. Por exemplo, a pessoa 1 pode dizer,nn#Pessoa1#: Isso é ótimo! Obrigado.nn#Person2#: De nada. Achei que você gostaria da sua refeição. Fico feliz que você tenha gostado.nn—n— — — — –nnn### Resumo:nnn### Resposta:nApós o diálogo | #Person1# e #Person2# comem na casa de #Person2#. Eles falam sobre a comida e o vinho que combinam com o frango.nn |

| Resuma este diálogo:n#Pessoa1#: Com licença, estou escrevendo um ensaio sobre a Grécia antiga. Há algum livro sobre esse assunto que você possa recomendar?n#Person2#: Gansos? Você quer escrever sobre gansos antigos? Nunca ouvi falar de tal coisa. De qualquer forma, seria com um livro de alguns animais, essa é a linha J. Ou você quer tentar a ciência, que está na linha Gn#Pessoa1#: Animais? Mas a Grécia é um país, não um animal.n#Person2#: Ah, Grécia. Bem, você sabe, hoje deve ser seu dia de sorte. Acabamos de receber uma nova coleção de livros sobre esse mesmo assunto. Há escritores aqui na linha Cn#Person1#: Entendo. São muitos livros, o que você sugere?n#Person2#: Bem, o de Robin Smith é excelente, mas é muito longo. É aquele que tem a estátua na capa. Há também um de Milton Pike. Tem uma pintura de um soldado na frente. Como você pode ver, não é muito grosso, então não deve demorar muito para ler. Mas provavelmente o melhor livro é aquele que retrata o antigo Estádio Olímpico. Ele ganhou vários prêmios por trabalhos históricos. n#Pessoa1#: Bem, é difícil decidir, mas infelizmente não tenho tempo suficiente para ler muito. Acho que vou comprar o livro de Milton Pike.n#Person2#: OK. Poderia me dar seu cartão da biblioteca, por favor?n#Pessoa1#: Claro, aqui está você.n—nResumo:nnn### Resposta:n | #Person1# pede a #Person2# que recomende alguns livros sobre a Grécia antiga. #Person2# sugere aquele de Robin Smith que é muito longo, aquele de Milton Pike que não é muito grosso e aquele que ganha vários prêmios de obras de história. Como #Person1# não tem tempo suficiente, #Person1# receberá o livro de Milton Pike. | n—nnResumo:n | #Person1# está escrevendo um ensaio sobre a Grécia antiga. #Person2# recomenda os livros sobre a Grécia antiga para #Person1#, todos recém-recebidos, e sugere adquirir o livro de Milton Pike.nn |

| Resuma este diálogo:n#Pessoa1#: Bem, vejo que você tem seus livros, George. Mas você está lendo? Parece que você está apenas colorindo.n#Person2#: Estou marcando as partes importantes do livro. As cores são para coisas diferentes.n#Person1#: Como o quê?n#Person2#: As ideias principais são amarelas. Detalhes importantes a serem lembrados são rosa e verde claro para ideias difíceis. n#Pessoa1#: Parecem muitas atividades. Você não está perdendo seu tempo?n#Pessoa2#: Acho que não, mãe. Vou ler tudo esta noite. Vou ouvi-lo amanhã. E então, quando chegar a hora de estudar, eu já saberei a maior parte das informações.n#Pessoa1#: Na minha época, apenas líamos o livro e tentávamos lembrar as informações.n#Pessoa2#: A professora nos contou a importância de leitura ativa. E é a melhor maneira de aprender na velocidade que você escolher.n#Pessoa1#: Entendo. E para que serve esse caderno?n#Person2#: É para fazer anotações. Que tipo de coisas você escreve?n#Pessoa1#: Às vezes eu escrevo um resumo. Nesta página escrevo perguntas. E é claro que tenho outra página onde escrevo as novas palavras.n—nResumo:nnn### Resposta:n | George diz à mãe que marcar as partes importantes do livro com cores diferentes é a sua forma de aprender. Ele também faz anotações no caderno e às vezes escreve um resumo. | #Pessoa1#: Ah! Leitura ativa, perguntas de leitura, notas de vocabulário, resumos e destaques. Posso ver agora a diferença que você faz quando se trata de aprender informações. Estou impressionado.n#Person2#: Obrigado. Ler é a melhor maneira de aprender e lembrar novas informações. Você está usando a leitura ativa agora?n#Person1#: Hmmm….. Vou ter que pensar sobre isso.nnn#Person | George descreve as atividades que está realizando para ler seus livros rapidamente. George mostra o caderno para a mãe e explica como fazer anotações.nn |

| Resuma esta caixa de diálogo:n#Person1#: Bom dia, senhor. Posso ver seu passaporte?n#Person2#: Sim, claro. Aqui está.n#Pessoa1#: Obrigado. São todos seus?n#Person2#: Não, alguns deles são do meu amigo. Você quer o passaporte dela também?n#Person1#: Sim, por favor. Você tem algum item de bagagem de mão?n#Person2#: Você quer que eu coloque no cinto também?n#Person1#: Sim, por favor. Você poderia, por favor, abrir esta mala grande? n#Pessoa2#: OK. Um momento. São apenas algumas roupas e produtos de higiene pessoal.n#Pessoa1#: OK. Você tem algo a declarar?n#Pessoa2#: Acho que não há nada.n#Pessoa1#: Algum alimento fresco, plantas vivas ou animais?n#Pessoa2#: Ah, não. Nada disso.n#Person1#: Obrigado. Você pode trancar sua mala. Aqui estão seus passaportes.n#Person2#: Muito obrigado.n—nResumo:nnn### Resposta:n | #Person1# vê o passaporte de #Person2# e do amigo de #Person2# e verifica sua bagagem. #Person2# diz a #Person1# que não tem nada a declarar. #Person1# os deixa ir. | > Acho que não há nada.nnn—n**Categorias:**nn- [Conversa (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Chave:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Qualquer direito autoral | O funcionário da imigração pede à #Pessoa2# que mostre seu passaporte e abra sua mala grande. #Person2# não tem nada a declarar e pode trancar sua mala.nn |

| Resuma este diálogo:n#Pessoa1#: O chá chinês é famoso em todo o mundo. Quero comprar várias caixas.n#Person2#: Existem vários tipos de chá na China. Depende do sabor e do efeito.n#Pessoa1#: Bem, eu não conheço nada de chá chinês.n#Pessoa2#: Este é o chá verde, você pode beber no verão. Pode aliviar o calor do verão e é bom para manter os pulmões. n#Pessoa1#: Parece interessante. E isso?n#Pessoa2#: É chá preto, tem sabor forte e promove a digestão.n#Pessoa1#: O que é isso? Tem um cheiro perfumado.n#Person2#: É chá de jasmim de alta qualidade. É perfumado e tem um sabor agradável.n#Pessoa1#: Vou levar o chá de jasmim. Você poderia embalá-lo com papel de embrulho e fita? É um presente para meu amigo.n#Person2#: Sem problemas. Espere um momento.n—nResumo:nnn### Resposta:n | #Pessoa2# recomenda chá verde, camiseta preta e camiseta de jasmim para #Pessoa1# que deseja comprar chá chinês e #Pessoa1# decide tomar o chá de jasmim. | #[Inglês]#: O chá chinês é famoso em todo o mundo. Quero comprar várias caixas.n#[Francês]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[Espanhol]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[Alemão]#: Ich mö | #Pessoa1# quer comprar diversas caixas de chá chinês, com diferentes tipos de chá. #Person2# ajuda #Person1# a selecionar e irá empacotá-lo.nn |

- Resultados do ajuste fino do modelo Llama-2 13B no conjunto de dados Dialogsum:

| entradas | Verdade do solo | Resposta do modelo não ajustado | Resposta do modelo ajustado |

| Resuma este diálogo:n#Person1#: Sra. Thompson já foi diteísta, Jason.n#Person2#: Por quê? Não deveríamos estar em apuros ou algo assim? Na verdade, estivemos super ativos durante toda a discussão da aula esta manhã. n#Pessoa1#: É exatamente isso. Eu não acho que seja uma coisa ruim. Acho que ela vai nos pedir para concorrer a monitor de aula. n#Pessoa2#: Uau! Realmente? Isso é muita responsabilidade.n#Pessoa1#: Bem, acho que você seria ótimo nisso. Além disso, é uma grande honra ser convidado para fazer isso. Isso significa que a Sra. Thompson nos vê como líderes. n#Pessoa2#: Mas não tenho certeza se conseguirei fazer isso sozinho. Poderíamos fazer isso juntos?n#Pessoa1#: Vamos perguntar à Sra. Thompson. Eu a ouço vindo do corredor agora.n—nResumo:nnn### Resposta:n | #Person1# diz a Jason a Sra. Thompson uma vez diteísta e #Person1# adivinha que ela quer que eles concorram para monitores de classe. Eles vão perguntar à Sra. Thompson se podem fazer isso juntos. | n* Quando o professor perguntou a Jason e seu colega se eles queriam concorrer a monitor de turma, ele e seu colega concordaram juntos. Os dois meninos são cristãos, mas não são amigos nas aulas.n* Sua fé em Jesus pode não ser compartilhada publicamente, mas é evidente por meio da oração e do exemplo que seguem juntos para ajudar os outros e demonstrar amor.nn—n## 1654nn **[Situação:** Os alunos estão falando sobre o recente | A Sra. Thompson pede a Jason e James que concorram para o monitor da turma porque ela acha que eles são líderes.nn |

| Resuma esta caixa de diálogo:n#Pessoa1#: Ei, vamos parar e dar uma olhada naquela casa ali.n#Pessoa2#: Sim, parece ótimo! Está na nossa lista de Open House?n#Person1#: Sim, está na nossa lista.n#Person2#: Bem, parece ótimo visto do meio-fio. Vamos continuar por dentro.n#Person1#: Vamos assinar o registro. O corretor de imóveis parece meio ocupado agora.n#Pessoa2#: OK, vamos dar uma olhada na cozinha a seguir.n#Pessoa1#: Olha, eles têm algumas bebidas aqui.n#Pessoa2#: Certifique-se de atender um folheto com as informações sobre a casa.n#Pessoa1#: Diz quanto estão pedindo por esta casa?n#Pessoa2#: Sim, parece que foi descontado de duzentos e trinta e cinco mil para duzentos e vinte e cinco miln—nResumo:nnn### Resposta:n | #Person1# e #Person2# vêm ver uma casa. Eles conferem o interior e conversam sobre o preço. | Esta é uma resposta da AMI ao seguinte estímulo.nnPessoa 2: nSim, parece ótimo! Está na nossa lista de Open House? nSim, está na nossa lista.nBem, parece ótimo visto do meio-fio. Vamos por dentro.nVamos assinar o registro. O corretor de imóveis parece meio ocupado agora. OK, vamos dar uma olhada na cozinha a seguir. | #Person1# e #Person2# estão olhando uma casa que está em sua lista de Open House. Eles assinam um registro e #Person2# diz a #Person1# para levar um folheto com as informações.nn |

| Resuma este diálogo:n#Pessoa1#: Como vai, Sr. Wilson? Eu sou Tina.n#Person2#: Prazer em conhecê-la, Sra. Tina.n#Person1#: Por favor, sente-se. Sei que nosso emprego de força já lhe deu as informações sobre seu contrato de trabalho, mas gostaria de repassar novamente os principais detalhes antes de assinar. Primeiro, você receberá um salário mensal, com um mês de férias pagas após um ano de serviço.n#Pessoa2#: É o que entendi.n#Pessoa1#: Você estará coberto pelo nosso plano médico enquanto estiver de plantão. Como você será um gerente intermediário, espera-se que você esteja disponível até 1 horas após o horário normal de trabalho. Qualquer tempo aprovado além disso será pago em uma hora e meia, que você pode usar como salário ou folga.n#Pessoa5#: Exatamente meu entendimento.n#Pessoa2#: Um número razoável de dias de licença médica será coberto pela empresa . Qualquer doença prolongada será coberta pelo seguro. Você leu os outros termos do contrato?n#Person1#: Sim, li.n#Person2#: Você tem alguma outra dúvida?n#Person1#: Apenas uma. Notei um item sobre horário flexível. Isso é uma possibilidade para mim?n#Person2#: Sim, é, mas você terá que discutir os detalhes com seu gerente.n#Person1#: Isso é aceitável.n#Person2#: Ótimo. Agora, se você apenas assinar aqui, poderá começar a trabalhar em 1 dias.n—nResumo:nnn### Resposta:n | Sr.Wilson descreve as informações elementares sobre o contrato de trabalho para Tina. Ele menciona salário mensal, um mês de férias remuneradas, plano médico, jornada ampliada e horário flexível. | nNão, os resumos não estão certos. As caixas de diálogo #Person1 não dizem que o nome é Tina, elas não se apresentam. Acho que os dois sabem o nome um do outro, então isso é desnecessário.nnAcho que se todo o resto estiver certo, o Resumo não mudará, a menos que #Person1 termine, e tudo bem.nn | Tina se encontra com o Sr. Wilson para revisar os principais detalhes do contrato de trabalho de Tina. Os dois discutem o salário mensal e o plano médico. Tina não tem dúvidas e começará a trabalhar em 3 dias.nn |

| Resuma esta caixa de diálogo:n#Person1#: Jack, qual é sua matéria favorita?n#Person2#: Minha matéria favorita? Bem, acho que prefiro ciência. Sim, ciência, acho muito interessante. O professor de ciências torna o assunto muito interessante. E você?n#Pessoa1#: Eu sempre me saio muito bem nas provas de matemática. Também gosto de geografia. Gosto de aprender sobre as pessoas e os lugares onde elas vivem. Há alguma matéria que você não gosta Jack?n#Person2#: Eu não gosto muito de física. Não é fácil de entender, a maioria das crianças fica entediada com isso.n—nResumo:nnn### Resposta:n | A matéria favorita de Jack é ciências, embora ele não goste muito de física. #Person1# gosta de matemática e geografia. | n—nn### A palavra: “favorito” (adj)nnSignificado: Amado, apreciado pela maioria dos outros nExemplos: Meu livro favorito é a Bíblia; Qual é o teu desporto favorito?; Minha cor favorita é azul.nn—nnnn### Qual é a sua ____ matéria? (formal)nnDiálogo de perguntas e respostas:nn#Person1#: Qual é a sua matéria favorita?n# | Jack e Jack estão conversando sobre seus assuntos favoritos e menos apreciados.nn |

| Resuma esta caixa de diálogo:n#Person1#: Olá, Maggie. Eu vi sua pintura na exposição de arte de final de ano da escola que todos os pais compareceram. Foi ótimo.n#Pessoa2#: Bem, nosso professor de artes pareceu muito satisfeito com isso, mas não tenho certeza do que os pais pensaram.n#Pessoa1#: Ah, não se preocupe. Eu só os ouvi dizendo coisas boas sobre isso.n#Person2#: Hmm…Ele provavelmente não percebeu que eu não tinha usado as cores certas.n#Person1#: Acho que ninguém notou.n#Person2# : Não, mas eu fiz. Mas era tarde demais para fazer algo a respeito. Bem, da próxima vez farei algo melhor, espero.n—nResumo:nnn### Resposta:n | #Pessoa1# viu a pintura de Maggie e achou ótima, mas Maggie se preocupa por não ter usado as cores certas e espera fazer algo melhor da próxima vez. | Este resumo deve destacar os pontos-chave e as conclusões da discussão.nn# Responder à Pessoa1:n[Resumo da resposta]nn—n### Resposta:nEste resumo deve destacar os pontos-chave e as conclusões da discussão.nn# Responder à Pessoa2 :n[Resumo da resposta]nn### Pessoa1:n[Resumo da pessoa1]n—n### Pessoa2:n[Resumo da pessoa2]nn### Pessoan—n | #Pessoa1# viu a pintura de Maggie e disse a Maggie que muitos pais disseram coisas boas sobre a pintura de Maggie. Maggie não pensa assim.nn |

- Resultados do ajuste fino do modelo Llama 2 70B no conjunto de dados Dialogsum:

| entradas | Verdade do solo | Resposta do modelo não ajustado | Resposta do modelo ajustado |

| Resuma esta caixa de diálogo:n#Person1#: Você recebeu algum diploma?n#Person2#: Sim. Em 1996, recebi meu diploma de Bacharel em Ciências pela Universidade de Hebes e, em 2001, recebi meu MBA pela Universidade de Pequim.n#Person1#: E quanto ao seu histórico acadêmico na faculdade?n#Person2#: Na verdade, meus registros foram excelentes. Meu GPA geral foi 9 em uma escala de 10, que foi o mais alto da minha turma. n#Pessoa1#: Isso é muito impressionante. Qual curso você mais gostou?n#Person2#: Inglês. Foi interessante e útil, então demonstrei um grande interesse nele.n#Pessoa1#: Você pode me dizer por que mudou de curso quando era estudante de pós-graduação?n#Pessoa2#: Porque estou muito interessado em administração e Eu fiz alguns cursos sobre isso. Também tive um bom desempenho nas disciplinas. Portanto, acredito que posso fazer um bom trabalho nesta posição.n#Person1#: Você recebeu alguma homenagem e prêmio na faculdade?n#Person2#: Sim. Recebi uma bolsa de estudos da universidade todos os anos. Em 1995 participei do Concurso Nacional de Modelos Matemáticos e ganhei o prêmio.n—nResumo:nnn### Resposta:n | #Person1# entrevista #Person2# e faz algumas perguntas a #Person2#, incluindo os diplomas de #Person2#, histórico acadêmico, o curso favorito e prêmios na faculdade. #Person2# também informa à #Person1# por que #Person2# mudou o curso para administração. | O candidato resumiu que a ideia principal do diálogo foi que ele recebesse dois diplomas, 0. E os cursos se saíram bem. No entanto, sua primeira frase não transmite muita emoção além do narcisismo, nem explica por que sua experiência é relevante para a empresa. Ele poderia fazer uma conexão melhor e talvez terminar o resumo com uma emoção/atitude subjacente diferente de “profissional” (como faz no diálogo). | #Person2# conta a #Person1# #Person2# recebeu um diploma de bacharel e um MBA. O GPA de #Person2# é o mais alto da classe de #Person2# e #Person2# está interessado em administração. #Person2# também recebeu algumas homenagens e prêmios na faculdade.nn |

| Resuma este diálogo:n#Pessoa1#: Com licença, que material é esse? n#Pessoa2#: Rhaki. Você quer um pouco? n#Pessoa1#: Não, onde estão os panos de algodão? n#Pessoa2#: Eu vou te mostrar. n#Person1#: Qual é a taxa de encolhimento após a lavagem? n#Pessoa2#: Menos de 5%. É bastante durável. n—nResumo:nnn### Resposta:n | #Person2# diz a #Person1# que as roupas de algodão são duráveis. | Para a rota QA41913, esta seção deve conter um resumo de parágrafo do diálogo para que, por exemplo, um sistema automático de pronúncia e geração de fala possa usar este texto para síntese de saída. | #Pessoa1# quer um pano de algodão. #Person2# mostra alguns rhaki.nn |