Esta postagem do blog foi escrita em co-autoria com Hwalsuk Lee do Upstage.

Hoje, temos o prazer de anunciar que o Solar modelo de base desenvolvido pela Upstage agora está disponível para clientes que usam JumpStart do Amazon SageMaker. Solar é um modelo de linguagem grande (LLM) 100% pré-treinado com Amazon Sage Maker que supera e usa seu tamanho compacto e histórico poderoso para se especializar em treinamento específico, tornando-o versátil em idiomas, domínios e tarefas.

Agora você pode usar o Mini Bate-papo Solar e Solar Mini Chat – Quant modelos pré-treinados no SageMaker JumpStart. SageMaker JumpStart é o centro de aprendizado de máquina (ML) do SageMaker que fornece acesso a modelos básicos, além de algoritmos integrados para ajudá-lo a começar a usar ML rapidamente.

Nesta postagem, explicamos como descobrir e implantar o modelo Solar por meio do SageMaker JumpStart.

Qual é o modelo Solar?

Solar é um modelo compacto e poderoso para os idiomas inglês e coreano. Ele foi ajustado especificamente para fins de bate-papo multiturno, demonstrando desempenho aprimorado em uma ampla variedade de tarefas de processamento de linguagem natural.

O modelo Solar Mini Chat é baseado em Solar 10.7B, com 32 camadas lhama 2 estrutura e inicializada com pesos pré-treinados de Mistral 7B compatível com a arquitetura Llama 2. Esse ajuste fino lhe confere a capacidade de lidar com conversas prolongadas de forma mais eficaz, tornando-o particularmente adequado para aplicações interativas. Ele emprega um método de escalonamento chamado aumento de profundidade (DUS), que consiste em escalonamento profundo e pré-treinamento contínuo. O DUS permite uma ampliação muito mais simples e eficiente de modelos menores do que outros métodos de escalonamento, como mistura de especialistas (MoE).

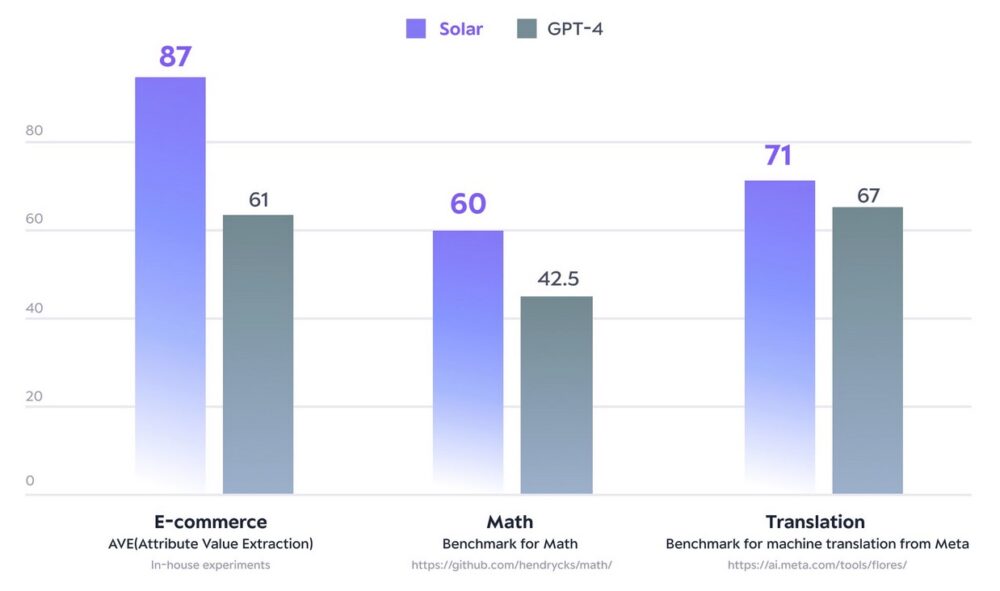

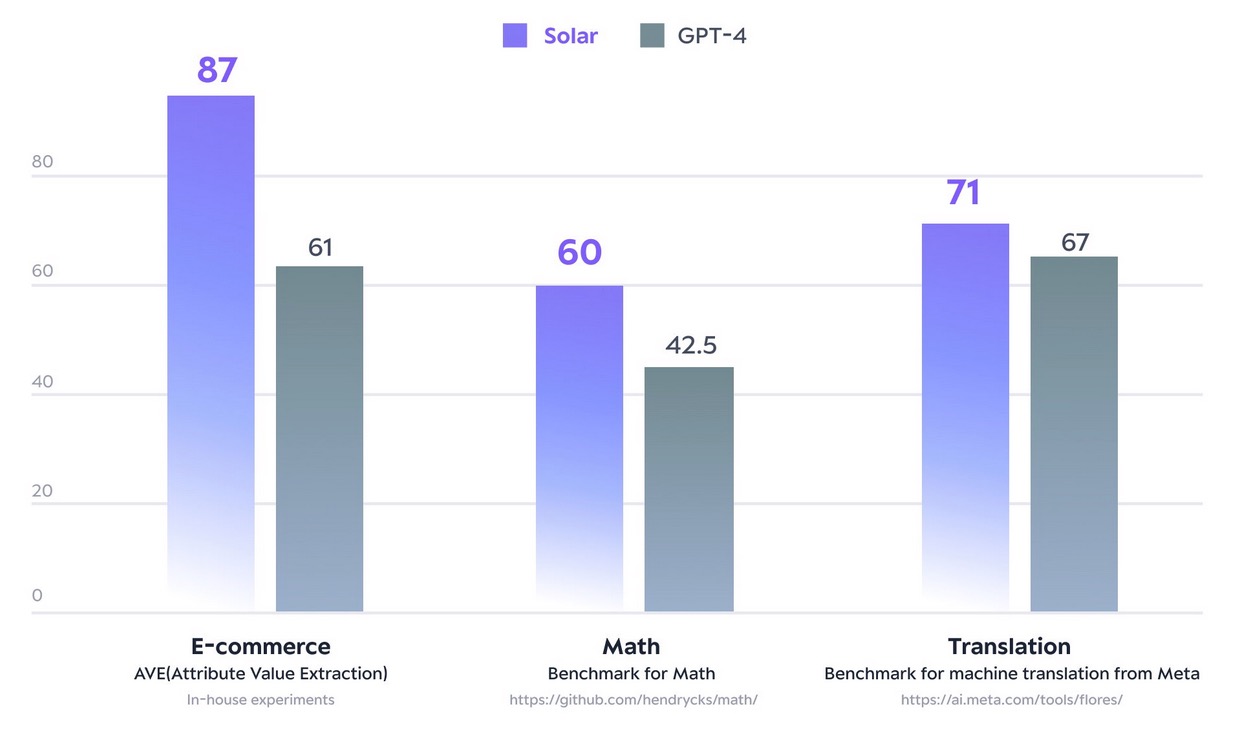

Em dezembro de 2023, o modelo Solar 10.7B fez barulho ao atingir o auge do Tabela de classificação LLM aberta de abraçar o rosto. Usando notavelmente menos parâmetros, o Solar 10.7B oferece respostas comparáveis ao GPT-3.5, mas é 2.5 vezes mais rápido. Além de liderar o Open LLM Leaderboard, o Solar 10.7B supera o GPT-4 com modelos treinados especificamente em determinados domínios e tarefas.

A figura a seguir ilustra algumas dessas métricas:

Com o SageMaker JumpStart, você pode implantar modelos pré-treinados baseados no Solar 10.7B: Solar Mini Chat e uma versão quantizada do Solar Mini Chat, otimizada para aplicativos de bate-papo em inglês e coreano. O modelo Solar Mini Chat oferece uma compreensão avançada das nuances do idioma coreano, o que eleva significativamente as interações do usuário em ambientes de chat. Ele fornece respostas precisas às entradas do usuário, garantindo uma comunicação mais clara e uma resolução de problemas mais eficiente em aplicativos de bate-papo em inglês e coreano.

Comece com modelos solares no SageMaker JumpStart

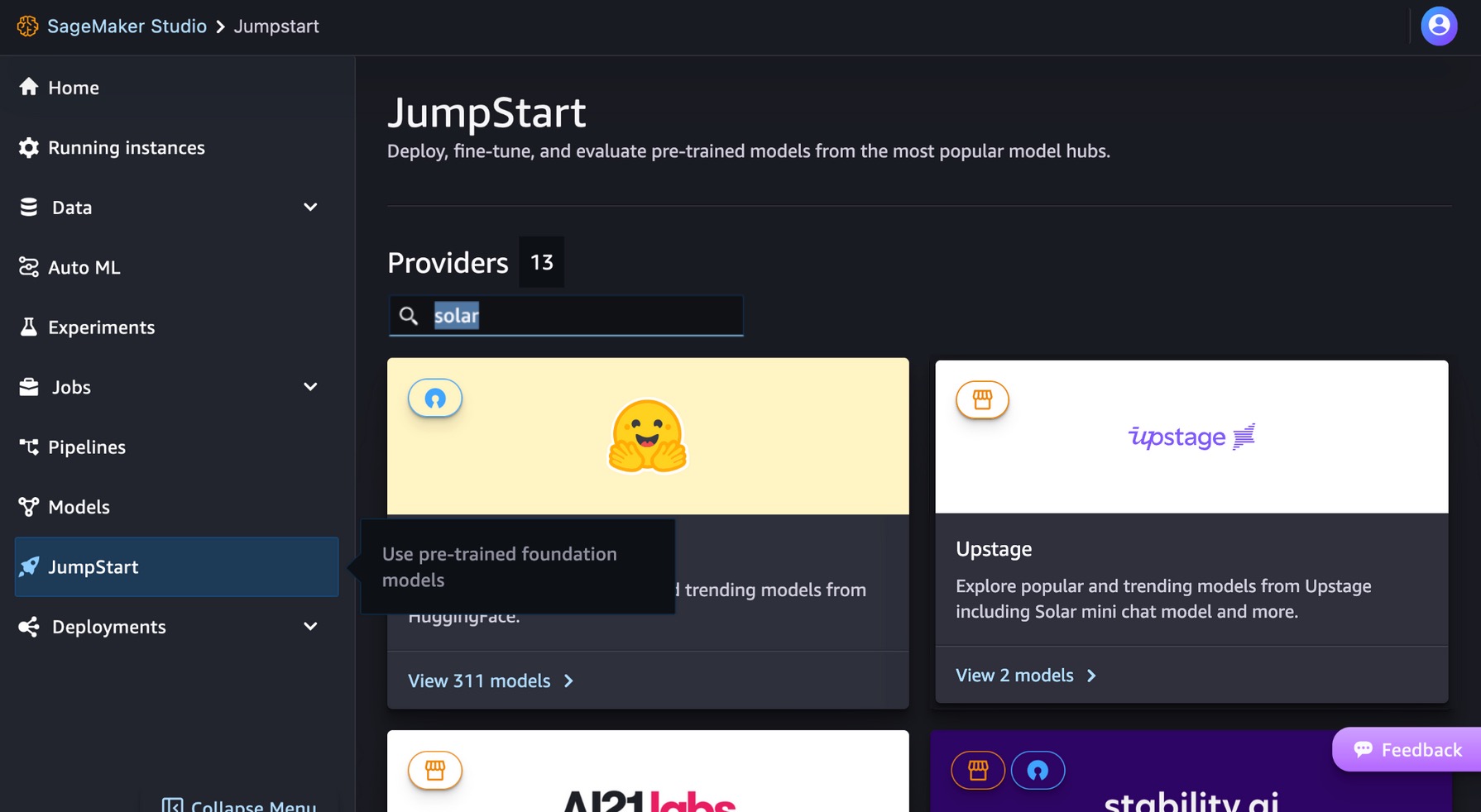

Para começar a usar modelos Solar, você pode usar o SageMaker JumpStart, um serviço de hub de ML totalmente gerenciado para implantar modelos de ML pré-construídos em um ambiente hospedado pronto para produção. Você pode acessar modelos Solar através do SageMaker JumpStart em Estúdio Amazon SageMaker, um ambiente de desenvolvimento integrado (IDE) baseado na Web onde você pode acessar ferramentas específicas para executar todas as etapas de desenvolvimento de ML, desde a preparação de dados até a construção, treinamento e implantação de seus modelos de ML.

No console do SageMaker Studio, escolha Acelerador no painel de navegação. Você pode inserir “solar” na barra de pesquisa para encontrar os modelos solares do Upstage.

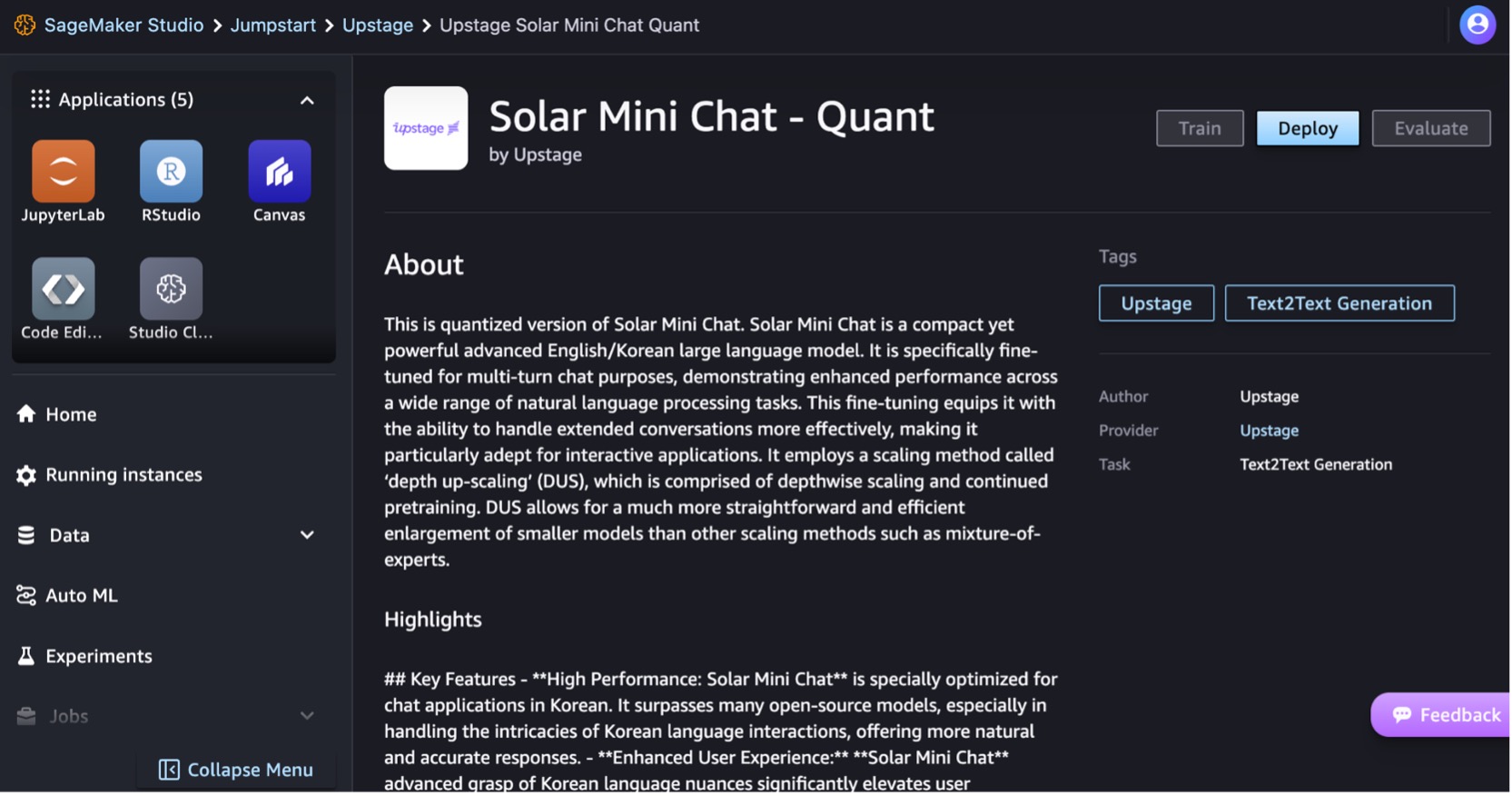

Vamos implantar o modelo Solar Mini Chat – Quant. Escolha o cartão de modelo para visualizar detalhes sobre o modelo, como licença, dados usados para treinar e como usar o modelo. Você também encontrará um Implantação opção, que leva você a uma página de destino onde você pode testar a inferência com um exemplo de carga útil.

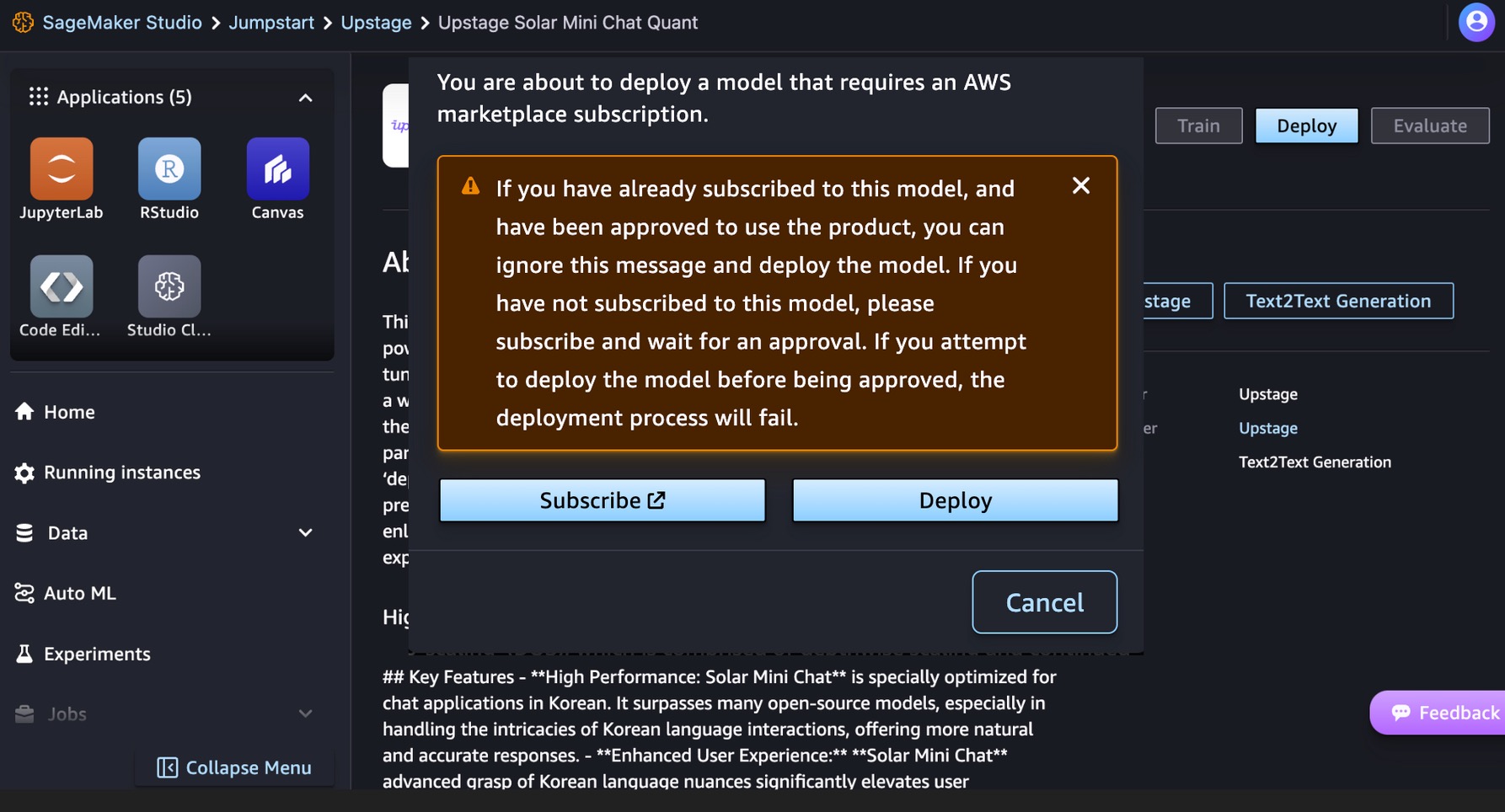

Este modelo requer uma Mercado da AWS inscrição. Se você já assinou esse modelo e foi aprovado para usar o produto, poderá implantar o modelo diretamente.

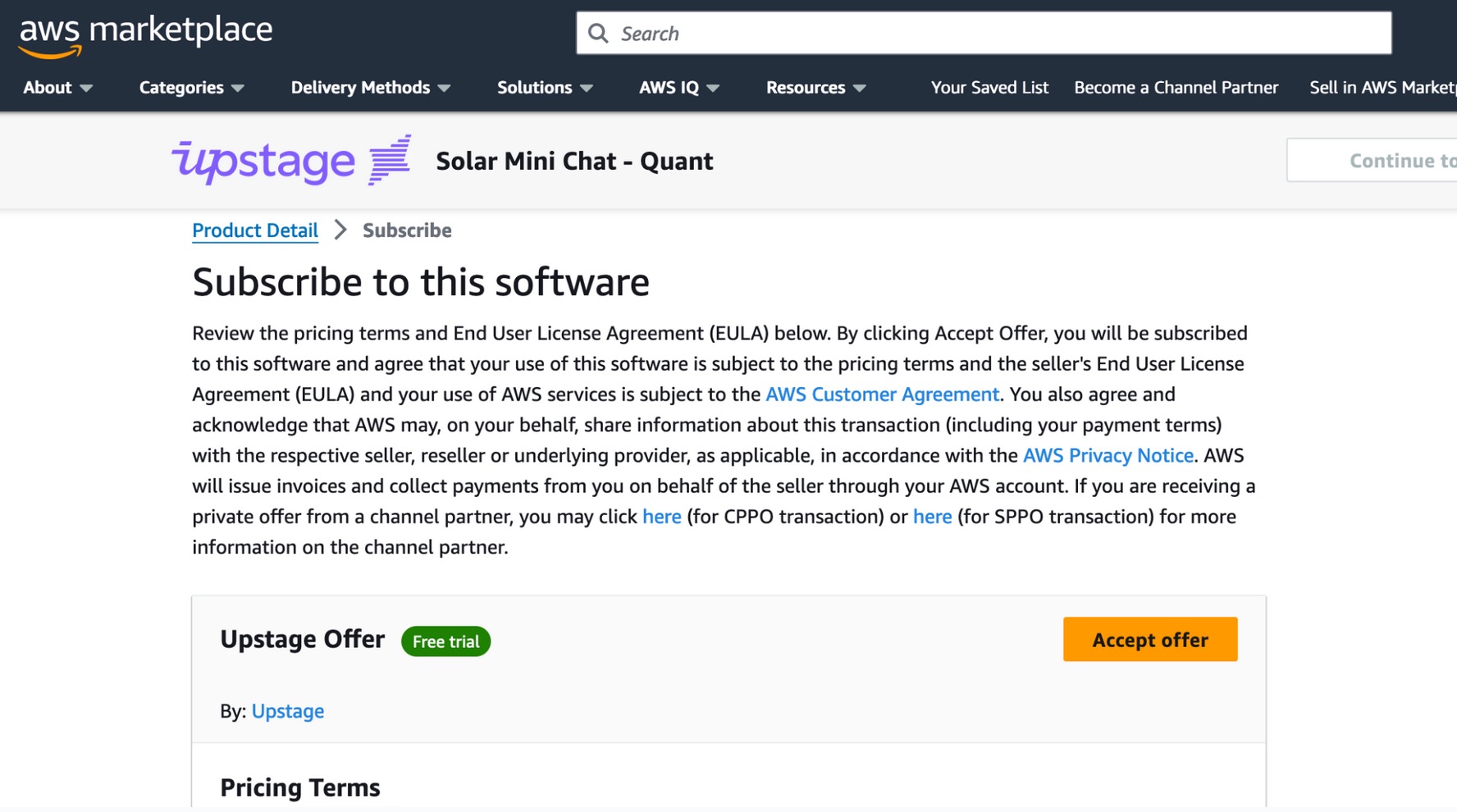

Se você ainda não assinou este modelo, escolha Subscrever, acesse o AWS Marketplace, revise os termos de preço e o Contrato de licença do usuário final (EULA) e escolha Aceitar oferta.

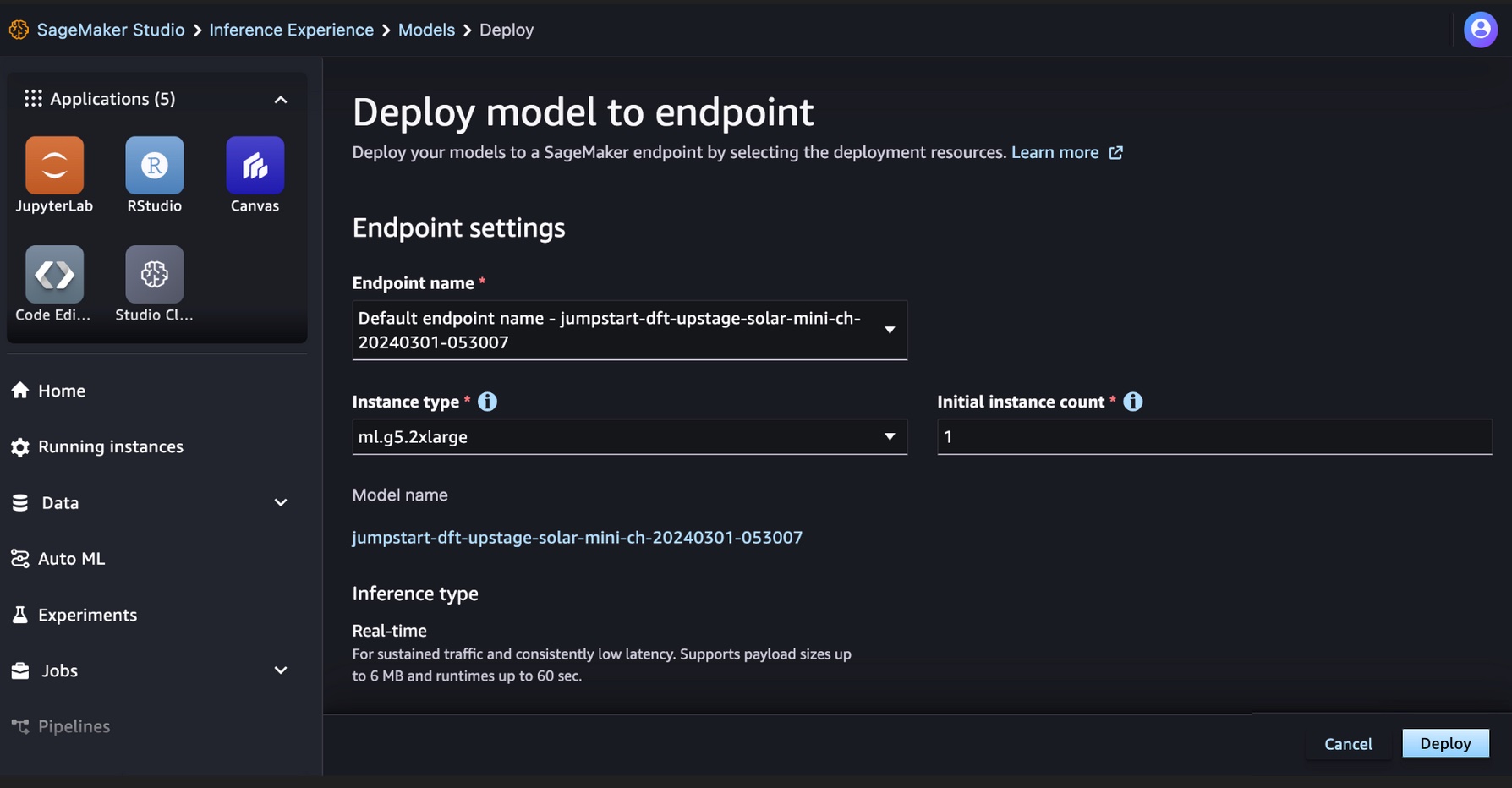

Depois de assinar o modelo, você pode implantá-lo em um endpoint do SageMaker selecionando os recursos de implantação, como tipo de instância e contagem inicial de instâncias. Escolher Implantação e aguarde a criação de um endpoint para a inferência do modelo. Você pode selecionar um ml.g5.2xlarge por exemplo, como uma opção mais barata para inferência com o modelo Solar.

Quando seu endpoint SageMaker for criado com sucesso, você poderá testá-lo por meio de vários ambientes de aplicativos SageMaker.

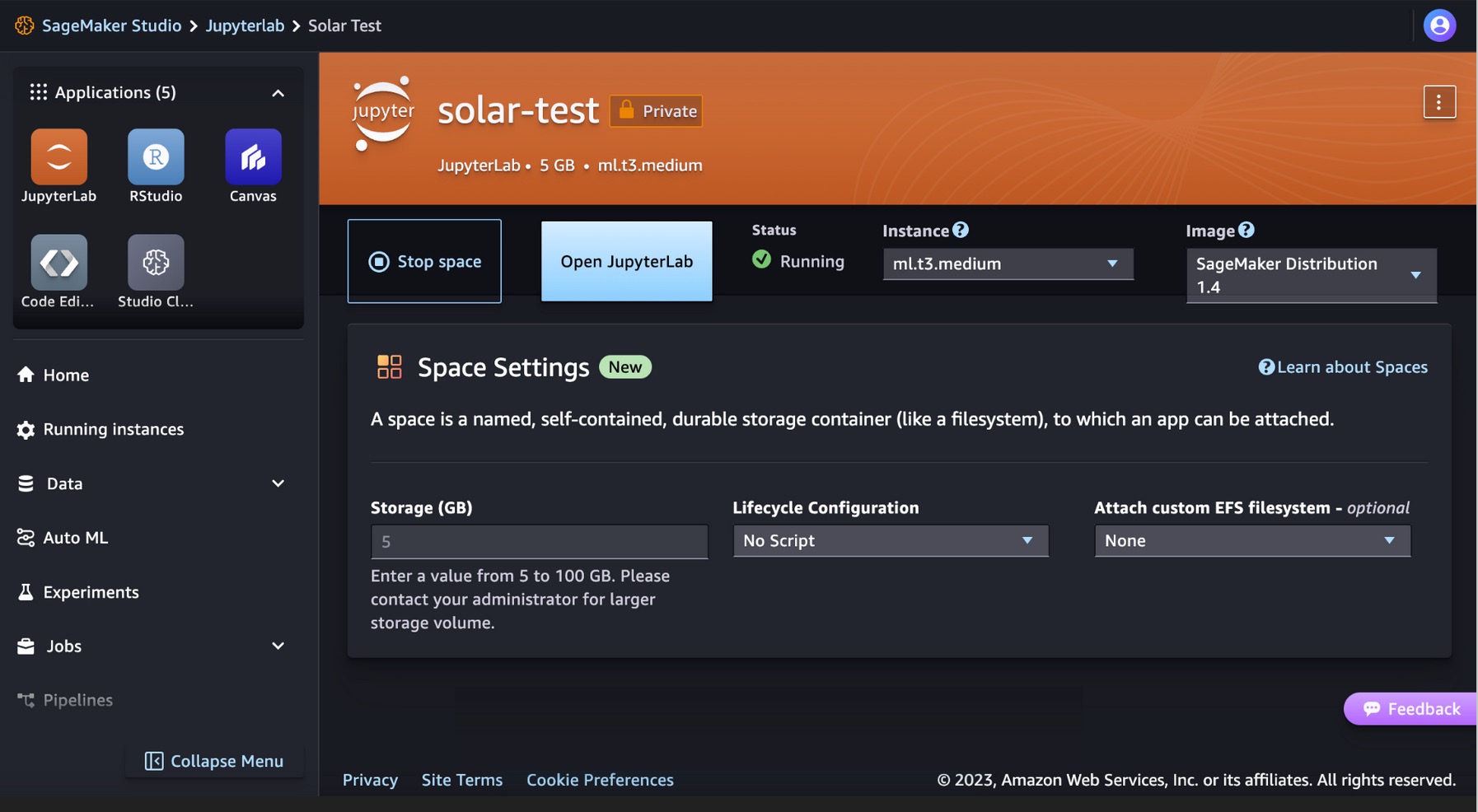

Execute seu código para modelos solares no SageMaker Studio JupyterLab

O SageMaker Studio oferece suporte a vários ambientes de desenvolvimento de aplicativos, incluindo o JupyterLab, um conjunto de recursos que amplia a oferta de notebooks totalmente gerenciados. Inclui kernels que iniciam em segundos, um tempo de execução pré-configurado com ciência de dados popular, estruturas de ML e armazenamento de blocos privados de alto desempenho. Para mais informações, veja SageMaker JupyterLab.

Crie um espaço JupyterLab no SageMaker Studio que gerencia os recursos de armazenamento e computação necessários para executar o aplicativo JupyterLab.

Você pode encontrar o código que mostra a implantação de modelos Solar no SageMaker JumpStart e um exemplo de como usar o modelo implantado no GitHub repo. Agora você pode implantar o modelo usando o SageMaker JumpStart. O código a seguir usa a instância padrão ml.g5.2xlarge para o endpoint de inferência do modelo Solar Mini Chat – Quant.

Os modelos Solar suportam uma carga útil de solicitação/resposta compatível com o endpoint de conclusão de bate-papo da OpenAI. Você pode testar exemplos de chat de turno único ou multiturno com Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultVocê executou com sucesso uma inferência em tempo real com o modelo Solar Mini Chat.

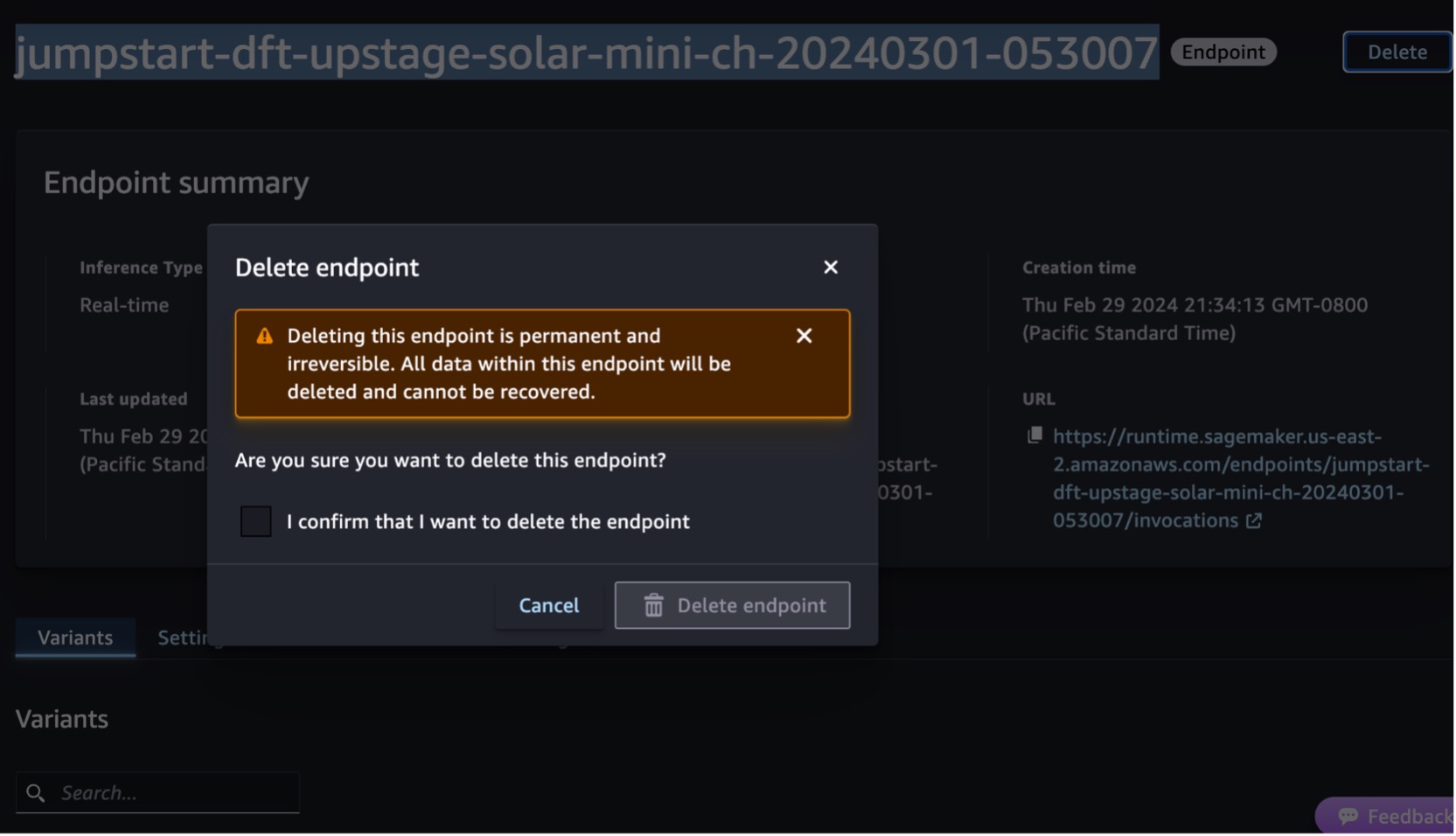

limpar

Depois de testar o endpoint, exclua o endpoint de inferência do SageMaker e exclua o modelo para evitar cobranças.

Você também pode executar o seguinte código para excluir o endpoint e o modo no notebook do SageMaker Studio JupyterLab:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()Para mais informações, consulte Excluir endpoints e recursos. Além disso, você pode desligue os recursos do SageMaker Studio que não são mais necessários.

Conclusão

Nesta postagem, mostramos como começar a usar os modelos Solar do Upstage no SageMaker Studio e implantar o modelo para inferência. Também mostramos como você pode executar seu código de amostra Python no SageMaker Studio JupyterLab.

Como os modelos Solar já são pré-treinados, eles podem ajudar a reduzir os custos de treinamento e infraestrutura e permitir a personalização de seus aplicativos generativos de IA.

Experimente no Console SageMaker JumpStart or Console do SageMaker Studio! Você também pode assistir ao seguinte vídeo, Experimente 'Solar' com Amazon SageMaker.

Esta orientação é apenas para fins informativos. Você ainda deve realizar sua própria avaliação independente e tomar medidas para garantir o cumprimento de suas próprias práticas e padrões específicos de controle de qualidade e das regras, leis, regulamentos, licenças e termos de uso locais que se aplicam a você, seu conteúdo, e o modelo de terceiros mencionado nesta orientação. A AWS não tem controle ou autoridade sobre o modelo de terceiros mencionado nesta orientação e não faz nenhuma representação ou garantia de que o modelo de terceiros seja seguro, livre de vírus, operacional ou compatível com seu ambiente e padrões de produção. A AWS não faz nenhuma representação ou garantia de que qualquer informação nesta orientação resultará em um resultado ou resultado específico.

Sobre os autores

Channy Yun é principal desenvolvedor defensor da AWS e tem paixão por ajudar os desenvolvedores a criar aplicativos modernos nos serviços mais recentes da AWS. Ele é um desenvolvedor pragmático e blogueiro de coração, e adora o aprendizado voltado para a comunidade e o compartilhamento de tecnologia.

Channy Yun é principal desenvolvedor defensor da AWS e tem paixão por ajudar os desenvolvedores a criar aplicativos modernos nos serviços mais recentes da AWS. Ele é um desenvolvedor pragmático e blogueiro de coração, e adora o aprendizado voltado para a comunidade e o compartilhamento de tecnologia.

Hwalsuk Lee é Diretor de Tecnologia (CTO) da Upstage. Ele trabalhou para Samsung Techwin, NCSOFT e Naver como pesquisador de IA. Ele está cursando seu doutorado em Engenharia Elétrica e de Computação no Instituto Avançado de Ciência e Tecnologia da Coreia (KAIST).

Hwalsuk Lee é Diretor de Tecnologia (CTO) da Upstage. Ele trabalhou para Samsung Techwin, NCSOFT e Naver como pesquisador de IA. Ele está cursando seu doutorado em Engenharia Elétrica e de Computação no Instituto Avançado de Ciência e Tecnologia da Coreia (KAIST).

Brandon Lee é arquiteto de soluções sênior na AWS e ajuda principalmente grandes clientes de tecnologia educacional no setor público. Ele tem mais de 20 anos de experiência liderando o desenvolvimento de aplicativos em empresas globais e grandes corporações.

Brandon Lee é arquiteto de soluções sênior na AWS e ajuda principalmente grandes clientes de tecnologia educacional no setor público. Ele tem mais de 20 anos de experiência liderando o desenvolvimento de aplicativos em empresas globais e grandes corporações.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- :tem

- :é

- :não

- :onde

- 10

- 120

- 152

- 20

- 20 anos

- 2023

- 7

- 990

- a

- habilidade

- Sobre

- ACEITAR

- Acesso

- em

- Adição

- Adicionalmente

- adepto

- avançado

- advogado

- Acordo

- AI

- algoritmos

- Todos os Produtos

- permite

- juntamente

- já

- tb

- Amazon

- Amazon Sage Maker

- JumpStart do Amazon SageMaker

- Amazon Web Services

- an

- e

- e infra-estrutura

- Anunciar

- qualquer

- Aplicação

- Desenvolvimento de Aplicações

- aplicações

- Aplicar

- aprovou

- arquitetura

- SOMOS

- AS

- avaliação

- Assistente

- At

- aumentar

- autoridade

- disponível

- evitar

- AWS

- Mercado da AWS

- Barra

- baseado

- BE

- sido

- Bloquear

- Blog

- corpo

- Brandon

- construir

- Prédio

- construídas em

- mas a

- by

- chamado

- CAN

- capacidades

- cartão

- certo

- acusações

- bate-papo

- mais barato

- chefe

- Chief Technology Officer

- Escolha

- mais claro

- código

- Comunicação

- Orientado para a comunidade

- compacto

- Empresas

- comparável

- compatível

- realização

- obedecer

- Composto

- Computar

- computador

- cônsul

- conteúdo

- continuou

- ao controle

- conversas

- Corporações

- custos

- contar

- crio

- criado

- CTO

- Clientes

- personalização

- dados,

- ciência de dados

- Dezembro

- Padrão

- entrega

- demonstrando

- implantar

- implantado

- Implantação

- desenvolvimento

- detalhes

- desenvolvido

- Developer

- desenvolvedores

- Desenvolvimento

- diretamente

- descobrir

- parece

- domínios

- down

- educacional

- efetivamente

- eficiente

- eleva

- emprega

- permitir

- final

- Ponto final

- Engenharia

- Inglês

- aprimorada

- garantir

- assegurando

- Entrar

- Meio Ambiente

- ambientes

- exemplo

- exemplos

- animado

- vasta experiência

- opção

- Rosto

- mais rápido

- menos

- Figura

- Encontre

- seguinte

- Escolha

- Foundation

- enquadramentos

- da

- totalmente

- função

- generativo

- IA generativa

- ter

- Global

- Go

- aperto

- garantias

- orientações

- manipular

- Ter

- he

- Coração

- ajudar

- útil

- ajuda

- ajuda

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- alta performance

- sua

- hospedado

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTML

- HTTPS

- Hub

- if

- ilustra

- in

- inclui

- Incluindo

- de treinadores em Entrevista Motivacional

- INFORMAÇÕES

- Informativa

- Infraestrutura

- do estado inicial,

- entrada

- inputs

- instância

- Instituto

- integrado

- interações

- interativo

- para dentro

- IT

- ESTÁ

- jpg

- json

- Coréia

- Coreana

- aterrissagem

- língua

- Idiomas

- grande

- mais recente

- Leis

- leaderboard

- principal

- aprendizagem

- Lee

- Licença

- licenças

- listas

- lhama

- LLM

- local

- mais

- ama

- diminuir

- máquina

- aprendizado de máquina

- moldadas

- fazer

- Fazendo

- gerenciados

- gestão

- marketplace

- medidas

- ir

- mensagens

- Meta

- método

- métodos

- Métrica

- ML

- Moda

- modelo

- modelos

- EQUIPAMENTOS

- mais

- mais eficiente

- muito

- natural

- Processamento de linguagem natural

- Naver

- Navegação

- necessário

- não

- notavelmente

- caderno

- agora

- nuances

- of

- oferecer

- oferecendo treinamento para distância

- Oficial

- on

- só

- aberto

- operacional

- otimizado

- Opção

- or

- Outros

- Fora

- Resultado

- Supera o desempenho

- Acima de

- próprio

- página

- pão

- parâmetros

- particular

- particularmente

- apaixonado

- Realizar

- atuação

- realizada

- phd

- foto

- pináculo

- platão

- Inteligência de Dados Platão

- PlatãoData

- Popular

- Publique

- poderoso

- práticas

- pragmático

- preciso

- preparação

- preços

- principalmente

- Diretor

- Impressão

- privado

- Problema

- em processamento

- Produto

- Produção

- fornecer

- fornece

- público

- fins

- Python

- qualidade

- Quant

- rapidamente

- alcance

- chegando

- reais

- em tempo real

- registros

- referenciada

- regulamentos

- requeridos

- exige

- investigador

- Resolução

- Recursos

- resposta

- respostas

- resultar

- retorno

- rever

- Tipo

- regras

- Execute

- tempo de execução

- sábio

- Inferência do SageMaker

- amostra

- Samsung

- dimensionamento

- Ciência

- Ciência e Tecnologia

- escrita

- Pesquisar

- segundo

- setor

- seguro

- Vejo

- selecionar

- selecionando

- senior

- serviço

- Serviços

- conjunto

- compartilhando

- rede de apoio social

- mostrou

- mostrando

- de forma considerável

- Tamanho

- menor

- solar

- Soluções

- alguns

- Espaço

- especializar-se

- específico

- especificamente

- padrões

- começo

- começado

- Passos

- Ainda

- armazenamento

- franco

- estrutura

- estudo

- Inscreva-se

- tudo incluso

- entraram com sucesso

- tal

- ajuda

- suportes

- certo

- .

- Tire

- toma

- tarefas

- Tecnologia

- condições

- teste

- testado

- do que

- que

- A

- Este

- deles

- De terceiros

- isto

- Através da

- tempo

- vezes

- para

- ferramentas

- pista

- Trem

- Training

- dois

- tipo

- usar

- usava

- Utilizador

- usos

- utilização

- vário

- versátil

- versão

- via

- Vídeo

- Ver

- esperar

- andar

- garantias

- Assistir

- ondas

- we

- web

- serviços web

- Web-Based

- qual

- Largo

- Ampla variedade

- precisarão

- de

- dentro

- trabalhou

- anos

- Vocês

- investimentos

- Youtube

- zefirnet