O aprendizado de máquina (ML) ajuda as organizações a aumentar a receita, impulsionar o crescimento dos negócios e reduzir custos otimizando as principais funções de negócios em vários verticais, como previsão de demanda, pontuação de crédito, preços, previsão de rotatividade de clientes, identificação das próximas melhores ofertas, previsão de remessas atrasadas e melhorando a qualidade de fabricação. Os ciclos tradicionais de desenvolvimento de ML levam meses e exigem poucas habilidades de ciência de dados e engenharia de ML. As ideias dos analistas para modelos de ML geralmente ficam em longas pendências aguardando a largura de banda da equipe de ciência de dados, enquanto os cientistas de dados se concentram em projetos de ML mais complexos que exigem todo o seu conjunto de habilidades.

Para ajudar a quebrar esse impasse, nós introduziu o Amazon SageMaker Canvas, uma solução de ML sem código que pode ajudar as empresas a acelerar a entrega de soluções de ML em horas ou dias. O SageMaker Canvas permite que os analistas usem facilmente os dados disponíveis em data lakes, data warehouses e armazenamentos de dados operacionais; construir modelos de ML; e use-os para fazer previsões interativamente e para pontuação em lotes em conjuntos de dados em massa, tudo sem escrever uma única linha de código.

Neste post, mostramos como o SageMaker Canvas permite a colaboração entre cientistas de dados e analistas de negócios, alcançando um time to market mais rápido e acelerando o desenvolvimento de soluções de ML. Os analistas obtêm seu próprio espaço de trabalho de ML sem código no SageMaker Canvas, sem precisar se tornar um especialista em ML. Os analistas podem compartilhar seus modelos do Canvas com apenas alguns cliques, com os quais os cientistas de dados poderão trabalhar em Estúdio Amazon SageMaker, um ambiente de desenvolvimento integrado (IDE) de ML de ponta a ponta. Trabalhando juntos, os analistas de negócios podem trazer seu conhecimento de domínio e os resultados da experimentação, enquanto os cientistas de dados podem efetivamente criar pipelines e agilizar o processo.

Vamos nos aprofundar em como seria o fluxo de trabalho.

Os analistas de negócios constroem um modelo e o compartilham

Para entender como o SageMaker Canvas simplifica a colaboração entre analistas de negócios e cientistas de dados (ou engenheiros de ML), primeiro abordamos o processo como analista de negócios. Antes de começar, consulte Anunciando o Amazon SageMaker Canvas – um recurso de aprendizado de máquina visual e sem código para analistas de negócios para obter instruções sobre como construir e testar o modelo com o SageMaker Canvas.

Para este post, usamos uma versão modificada do Conjunto de dados de detecção de fraude de cartão de crédito do Kaggle, um conjunto de dados bem conhecido para um problema de classificação binária. O conjunto de dados é originalmente altamente desequilibrado - tem muito poucas entradas classificadas como uma classe negativa (transações anômalas). Independentemente da distribuição de recursos de destino, ainda podemos usar esse conjunto de dados, pois o SageMaker Canvas lida com esse desequilíbrio à medida que treina e ajusta um modelo automaticamente. Este conjunto de dados consiste em cerca de 9 milhões de células. Você também pode baixar um versão reduzida deste conjunto de dados. O tamanho do conjunto de dados é muito menor, em torno de 500,000 células, porque foi sub-amostrado aleatoriamente e depois super-amostrado com a técnica SMOTE para garantir que o mínimo de informação possível seja perdido durante esse processo. A execução de um experimento inteiro com esse conjunto de dados reduzido custa US$ 0 no nível gratuito do SageMaker Canvas.

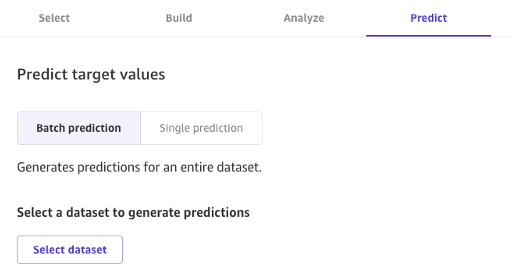

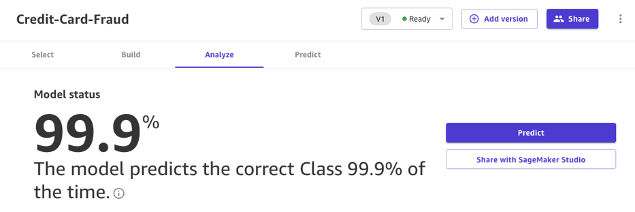

Depois que o modelo é construído, os analistas podem usá-lo para fazer previsões diretamente no Canvas para solicitações individuais ou para um conjunto de dados de entrada inteiro em massa.

Os modelos criados com o Canvas Standard Build também podem ser facilmente compartilhados com um clique de um botão com cientistas de dados e engenheiros de ML que usam o SageMaker Studio. Isso permite que um cientista de dados valide o desempenho do modelo que você criou e forneça feedback. Os engenheiros de ML podem escolher seu modelo e integrá-lo a fluxos de trabalho e produtos existentes disponíveis para sua empresa e seus clientes. Observe que, no momento da redação, não é possível compartilhar um modelo criado com o Canvas Quick Build ou um modelo de previsão de série temporal.

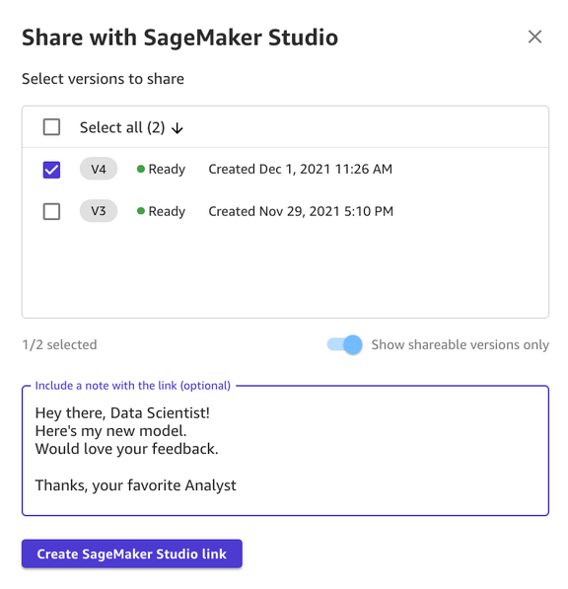

Compartilhar um modelo por meio da interface do usuário do Canvas é simples:

- Na página que mostra os modelos que você criou, escolha um modelo.

- Escolha Partilhar.

- Escolha uma ou mais versões do modelo que você deseja compartilhar.

- Opcionalmente, inclua uma nota dando mais contexto sobre o modelo ou a ajuda que você está procurando.

- Escolha Criar Link do SageMaker Studio.

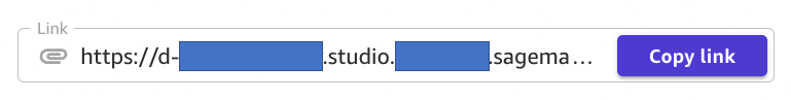

- Copie o link gerado.

E é isso! Agora você pode compartilhar o link com seus colegas via Slack, e-mail ou qualquer outro método de sua preferência. O cientista de dados precisa estar no mesmo domínio do SageMaker Studio para acessar seu modelo, portanto, verifique se esse é o caso com o administrador da sua organização.

Os cientistas de dados acessam as informações do modelo do SageMaker Studio

Agora, vamos desempenhar o papel de um cientista de dados ou engenheiro de ML e ver as coisas do ponto de vista deles usando o SageMaker Studio.

O link compartilhado pelo analista nos leva ao SageMaker Studio, o primeiro IDE baseado em nuvem para o fluxo de trabalho de ML de ponta a ponta.

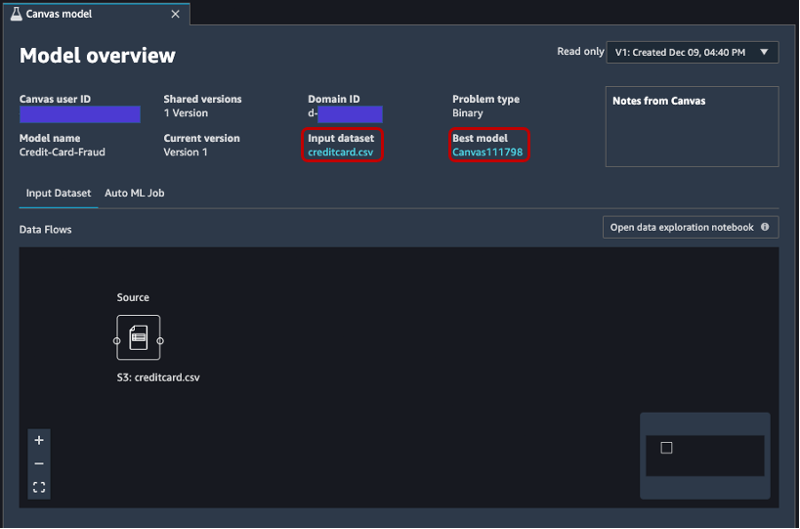

A guia é aberta automaticamente e mostra uma visão geral do modelo criado pelo analista no SageMaker Canvas. Você pode ver rapidamente o nome do modelo, o tipo de problema de ML, a versão do modelo e qual usuário criou o modelo (no campo ID do usuário do Canvas). Você também tem acesso a detalhes sobre o conjunto de dados de entrada e o melhor modelo que o SageMaker conseguiu produzir. Vamos mergulhar nisso mais adiante no post.

No Conjunto de dados de entrada guia, você também pode ver o fluxo de dados da origem para o conjunto de dados de entrada. Nesse caso, apenas uma fonte de dados é usada e nenhuma operação de junção foi aplicada, portanto, uma única fonte é mostrada. Você pode analisar estatísticas e detalhes sobre o conjunto de dados escolhendo Abra o notebook de exploração de dados. Este notebook permite explorar os dados que estavam disponíveis antes do treinamento do modelo e contém uma análise da variável de destino, uma amostra dos dados de entrada, estatísticas e descrições de colunas e linhas, além de outras informações úteis para o cientista de dados saiba mais sobre o conjunto de dados. Para saber mais sobre este relatório, consulte Relatório de exploração de dados.

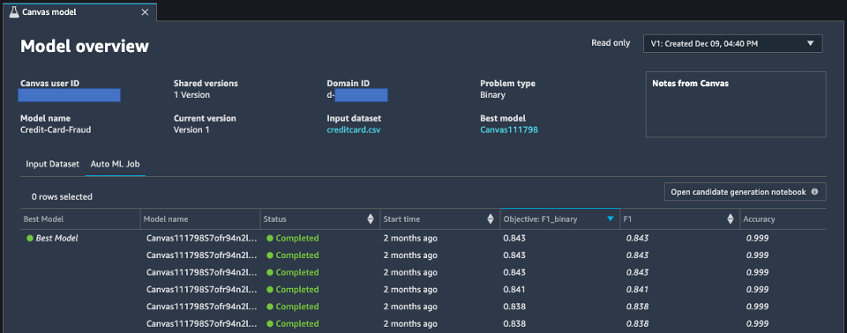

Depois de analisar o conjunto de dados de entrada, vamos para a segunda guia da visão geral do modelo, Trabalho de AutoML. Essa guia contém uma descrição do trabalho do AutoML quando você seleciona a opção Construção padrão no SageMaker Canvas.

A tecnologia AutoML sob o SageMaker Canvas elimina o trabalho pesado de construir modelos de ML. Ele cria, treina e ajusta automaticamente o melhor modelo de ML com base em seus dados usando uma abordagem automatizada, permitindo que você mantenha total controle e visibilidade. Essa visibilidade dos modelos candidatos gerados, bem como dos hiperparâmetros usados durante o processo de AutoML, está contida no caderno de geração de candidatos, que está disponível nesta guia.

A Trabalho de AutoML A guia também contém uma lista de todos os modelos criados como parte do processo AutoML, classificados pela métrica de objetivo F1. Para destacar o melhor modelo dos jobs de treinamento lançados, uma tag com um círculo verde é usada no Melhor modelo coluna. Você também pode visualizar facilmente outras métricas usadas durante a fase de treinamento e avaliação, como a pontuação de precisão e a área sob a curva (AUC). Para saber mais sobre os modelos que você pode treinar durante um trabalho do AutoML e as métricas usadas para avaliar o desempenho do modelo treinado, consulte Suporte, métricas e validação de modelos.

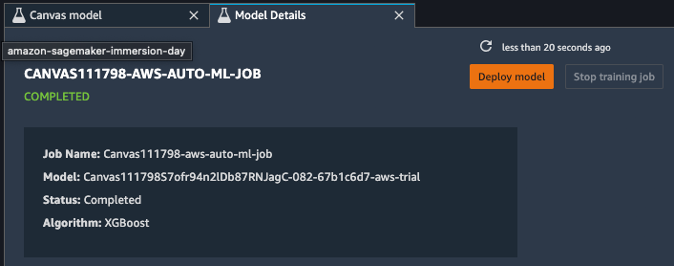

Para saber mais sobre o modelo, agora você pode clicar com o botão direito do mouse no melhor modelo e escolher Abrir nos detalhes do modelo. Alternativamente, você pode escolher o Melhor modelo link no topo do Visão geral do modelo seção que você visitou pela primeira vez.

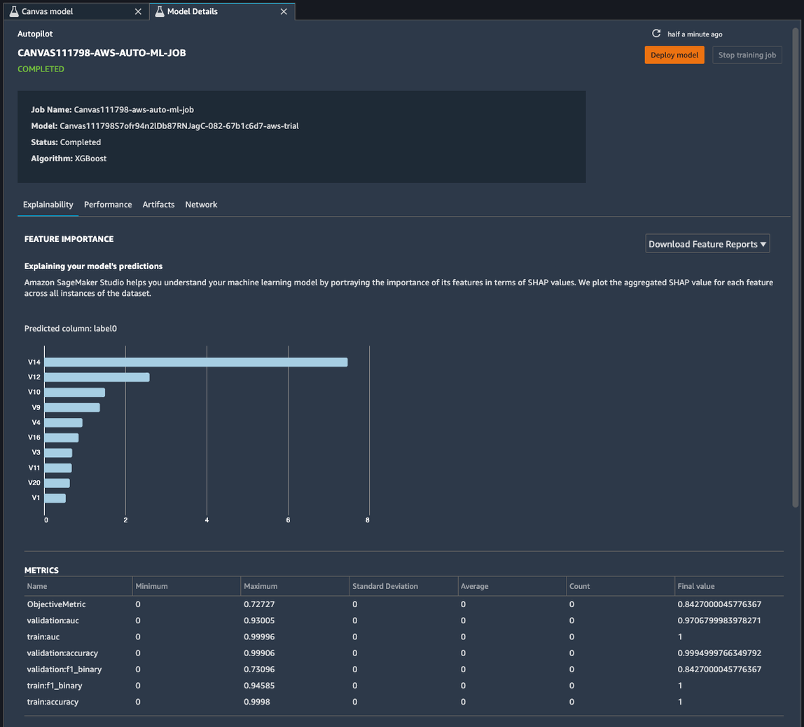

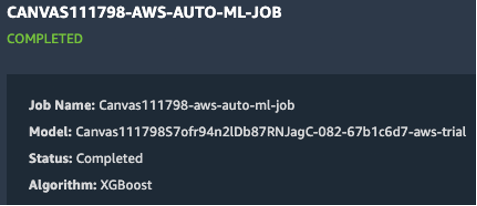

A página de detalhes do modelo contém uma infinidade de informações úteis sobre o modelo que teve o melhor desempenho com esses dados de entrada. Vamos primeiro focar no resumo na parte superior da página. A captura de tela do exemplo anterior mostra que, de centenas de execuções de treinamento de modelo, um modelo XGBoost teve o melhor desempenho no conjunto de dados de entrada. No momento da redação deste artigo, o SageMaker Canvas pode treinar três tipos de algoritmos de ML: aprendizado linear, XGBoost e um perceptron multicamada (MLP), cada um com uma ampla variedade de pipelines de pré-processamento e hiperparâmetros. Para saber mais sobre cada algoritmo, consulte página de algoritmos suportados.

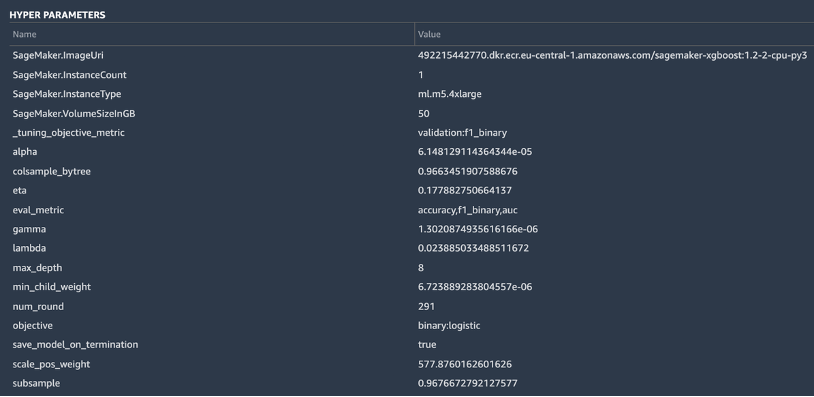

O SageMaker também inclui uma funcionalidade explicativa graças a uma implementação escalável e eficiente de KernelSHAP, baseado no conceito de um valor de Shapley do campo da teoria dos jogos cooperativos que atribui a cada recurso um valor de importância para uma determinada previsão. Isso permite transparência sobre como o modelo chegou às suas previsões e é muito útil para definir a importância do recurso. Um relatório completo de explicabilidade, incluindo a importância do recurso, pode ser baixado em formato PDF, notebook ou dados brutos. Nesse relatório, um conjunto mais amplo de métricas é mostrado, bem como uma lista completa de hiperparâmetros usados durante o trabalho do AutoML. Para saber mais sobre como o SageMaker fornece ferramentas de explicação integradas para soluções AutoML e algoritmos de ML padrão, consulte Use ferramentas de explicabilidade integradas e melhore a qualidade do modelo usando o Amazon SageMaker Autopilot.

Por fim, as outras guias nessa exibição mostram informações sobre detalhes de desempenho (matriz de confusão, curva de recuperação de precisão, curva ROC), artefatos usados para entradas e gerados durante o trabalho do AutoML e detalhes da rede.

Neste ponto, o cientista de dados tem duas opções: implantar diretamente o modelo ou criar um pipeline de treinamento que pode ser agendado ou acionado manual ou automaticamente. As seções a seguir fornecem algumas informações sobre ambas as opções.

Implante o modelo diretamente

Se o cientista de dados estiver satisfeito com os resultados obtidos pelo trabalho do AutoML, ele poderá implantar diretamente o modelo a partir do Detalhes do modelo página. É tão simples quanto escolher Implantar modelo ao lado do nome do modelo.

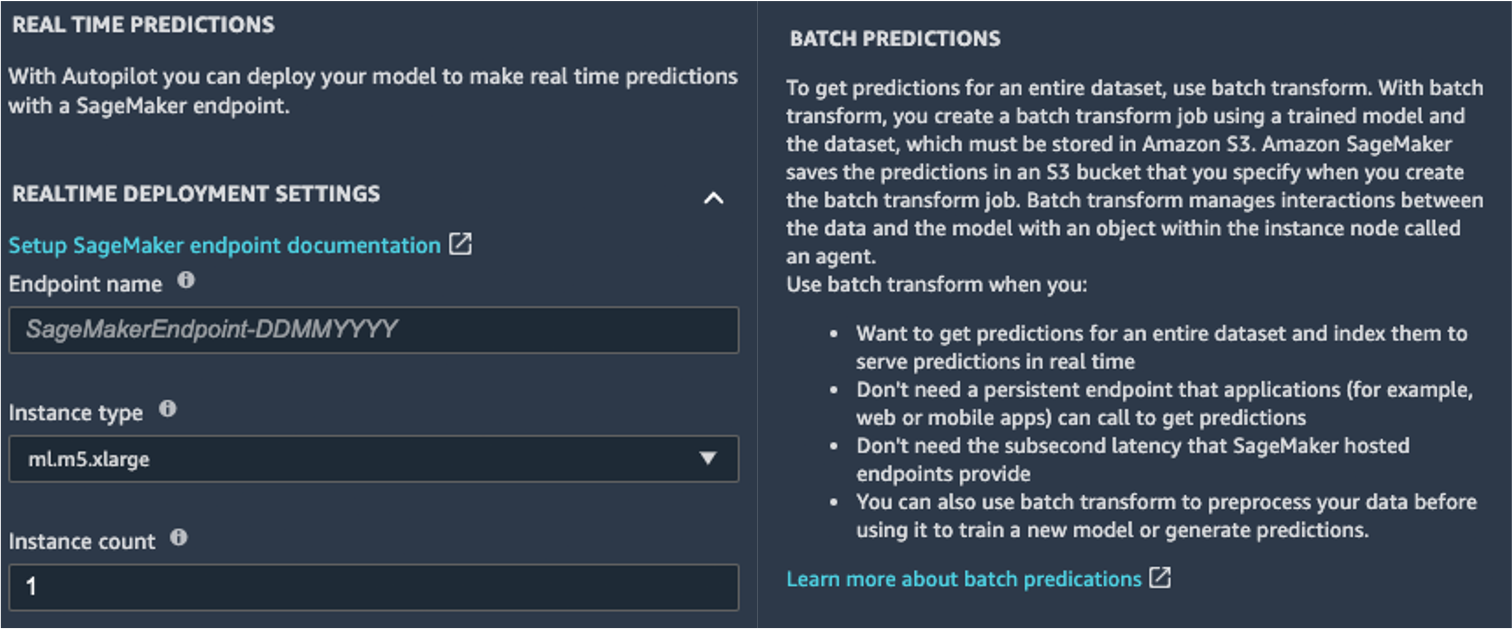

O SageMaker mostra duas opções para implantação: um endpoint em tempo real, desenvolvido por Endpoints do Amazon SageMaker, e inferência em lote, desenvolvida por Transformação em lote Amazon SageMaker.

O SageMaker também fornece outros modos de inferência. Para saber mais, consulte Implantar modelos para inferência.

Para habilitar o modo de previsão em tempo real, basta dar ao endpoint um nome, um tipo de instância e uma contagem de instâncias. Como esse modelo não requer recursos de computação pesados, você pode usar uma instância baseada em CPU com uma contagem inicial de 1. Você pode saber mais sobre os diferentes tipos de instâncias disponíveis e suas especificações na página Página de preços do Amazon SageMaker (no Preço sob demanda seção, escolha o Inferência em tempo real aba). Se você não sabe qual instância deve escolher para sua implantação, também pode pedir ao SageMaker para encontrar a melhor para você de acordo com seus KPIs usando o Recomendador de inferência do SageMaker. Você também pode fornecer parâmetros opcionais adicionais, sobre se deseja ou não capturar dados de solicitação e resposta de ou para o endpoint. Isso pode ser útil se você estiver planejando monitorando seu modelo. Você também pode escolher qual conteúdo deseja fornecer como parte de sua resposta, seja apenas a previsão ou a probabilidade de previsão, a probabilidade de todas as classes e os rótulos de destino.

Para executar um trabalho de pontuação em lote obtendo previsões para um conjunto inteiro de entradas de uma só vez, você pode iniciar o trabalho de transformação em lote a partir do Console de gerenciamento da AWS ou por meio do SDK do Python do SageMaker. Para saber mais sobre transformação em lote, consulte Usar transformação em lote e os cadernos de exemplo.

Definir um pipeline de treinamento

Os modelos de ML raramente, ou nunca, podem ser considerados estáticos e imutáveis, porque se desviam da linha de base em que foram treinados. Os dados do mundo real evoluem ao longo do tempo, e mais padrões e insights surgem deles, que podem ou não ser capturados pelo modelo original treinado em dados históricos. Para resolver esse problema, você pode configurar um pipeline de treinamento que retreina automaticamente seus modelos com os dados mais recentes disponíveis.

Ao definir esse pipeline, uma das opções do cientista de dados é usar novamente o AutoML para o pipeline de treinamento. Você pode iniciar um trabalho do AutoML programaticamente invocando a API create_auto_ml_job() do SDK do AWS Boto3. Você pode chamar esta operação de um AWS Lambda funcionar dentro de um Funções de etapa da AWS fluxo de trabalho, ou de um LambdaStep em Pipelines Amazon SageMaker.

Como alternativa, o cientista de dados pode usar o conhecimento, os artefatos e os hiperparâmetros obtidos do trabalho do AutoML para definir um pipeline de treinamento completo. Você precisa dos seguintes recursos:

- O algoritmo que funcionou melhor para o caso de uso – Você já obteve essas informações do resumo do modelo gerado pelo Canvas. Para este caso de uso, é o algoritmo integrado XGBoost. Para obter instruções sobre como usar o SageMaker Python SDK para treinar o algoritmo XGBoost com o SageMaker, consulte Use o XGBoost com o SDK do Python do SageMaker.

- Os hiperparâmetros derivados do trabalho do AutoML – Estão disponíveis no Explicação seção. Você pode usá-los como entradas ao definir o trabalho de treinamento com o SageMaker Python SDK.

- O código de engenharia de recursos fornecido na seção Artefatos – Você pode usar esse código para pré-processar os dados antes do treinamento (por exemplo, por meio do Amazon SageMaker Processing) ou antes da inferência (por exemplo, como parte de um pipeline de inferência do SageMaker).

Você pode combinar esses recursos como parte de um pipeline do SageMaker. Omitimos os detalhes de implementação nesta postagem - fique atento para mais conteúdo sobre este tópico.

Conclusão

O SageMaker Canvas permite que você use ML para gerar previsões sem precisar escrever nenhum código. Um analista de negócios pode começar a usá-lo de forma autônoma com conjuntos de dados locais, bem como dados já armazenados em Serviço de armazenamento simples da Amazon (Amazon S3), Amazon RedShift, ou floco de neve. Com apenas alguns cliques, eles podem preparar e juntar seus conjuntos de dados, analisar a precisão estimada, verificar quais colunas são impactantes, treinar o modelo de melhor desempenho e gerar novas previsões individuais ou em lote, tudo sem a necessidade de recorrer a um cientista de dados especializado. Em seguida, conforme necessário, eles podem compartilhar o modelo com uma equipe de cientistas de dados ou engenheiros de MLOps, que importam os modelos para o SageMaker Studio e trabalham junto com o analista para fornecer uma solução de produção.

Os analistas de negócios podem obter insights de seus dados de forma independente sem ter um diploma em ML e sem precisar escrever uma única linha de código. Os cientistas de dados agora podem ter mais tempo para trabalhar em projetos mais desafiadores que podem usar melhor seu amplo conhecimento de IA e ML.

Acreditamos que essa nova colaboração abre as portas para a criação de muitas soluções de ML mais poderosas para seus negócios. Agora você tem analistas produzindo insights de negócios valiosos, enquanto permite que cientistas de dados e engenheiros de ML ajudem a refinar, ajustar e ampliar conforme necessário.

Recursos adicionais

- Para saber mais sobre como o SageMaker pode ajudar ainda mais os analistas de negócios, consulte Amazon SageMaker para analistas de negócios.

- Para saber mais sobre como o SageMaker permite que cientistas de dados desenvolvam, treinem e implantem seus modelos de ML, confira Amazon SageMaker para cientistas de dados.

- Para obter mais informações sobre como o SageMaker pode ajudar os engenheiros de MLOps a otimizar o ciclo de vida de ML usando MLOps, consulte Amazon SageMaker para engenheiros de MLOps.

Sobre os autores

Davide Gallitelli é um Arquiteto de Soluções Especialista para AI/ML na região EMEA. Ele está baseado em Bruxelas e trabalha em estreita colaboração com clientes em todo o Benelux. Ele é desenvolvedor desde muito jovem, começando a codificar aos 7 anos de idade. Ele começou a aprender IA/ML na universidade e se apaixonou por isso desde então.

Davide Gallitelli é um Arquiteto de Soluções Especialista para AI/ML na região EMEA. Ele está baseado em Bruxelas e trabalha em estreita colaboração com clientes em todo o Benelux. Ele é desenvolvedor desde muito jovem, começando a codificar aos 7 anos de idade. Ele começou a aprender IA/ML na universidade e se apaixonou por isso desde então.

Marcos Roy é arquiteto de aprendizado de máquina principal da AWS, ajudando clientes a projetar e construir soluções de AI / ML. O trabalho de Mark cobre uma ampla gama de casos de uso de ML, com interesse principal em visão computacional, aprendizado profundo e escalonamento de ML em toda a empresa. Ele ajudou empresas em muitos setores, incluindo seguros, serviços financeiros, mídia e entretenimento, saúde, serviços públicos e manufatura. Mark possui seis certificações AWS, incluindo a certificação ML Specialty. Antes de ingressar na AWS, Mark foi arquiteto, desenvolvedor e líder de tecnologia por mais de 25 anos, incluindo 19 anos em serviços financeiros.

Marcos Roy é arquiteto de aprendizado de máquina principal da AWS, ajudando clientes a projetar e construir soluções de AI / ML. O trabalho de Mark cobre uma ampla gama de casos de uso de ML, com interesse principal em visão computacional, aprendizado profundo e escalonamento de ML em toda a empresa. Ele ajudou empresas em muitos setores, incluindo seguros, serviços financeiros, mídia e entretenimento, saúde, serviços públicos e manufatura. Mark possui seis certificações AWS, incluindo a certificação ML Specialty. Antes de ingressar na AWS, Mark foi arquiteto, desenvolvedor e líder de tecnologia por mais de 25 anos, incluindo 19 anos em serviços financeiros.

- Coinsmart. A melhor troca de Bitcoin e criptografia da Europa.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. ACESSO LIVRE.

- CryptoHawk. Radar Altcoin. Teste grátis.

- Fonte: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- code-ml-and-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Sobre

- acelerar

- acelerando

- Acesso

- Segundo

- em

- Adicional

- admin

- AI

- algoritmo

- algoritmos

- Todos os Produtos

- Permitindo

- já

- Amazon

- análise

- analista

- api

- abordagem

- ÁREA

- por aí

- Automatizado

- disponível

- AWS

- Linha de Base

- tornam-se

- MELHOR

- fronteira

- Bruxelas

- construir

- Prédio

- Constrói

- construídas em

- negócio

- chamada

- casos

- FDA

- escolhas

- Círculo

- classificação

- código

- colaboração

- Coluna

- vinda

- Empresas

- Empresa

- integrações

- Computar

- conceito

- confusão

- contém

- conteúdo

- ao controle

- cooperativo

- núcleo

- custos

- crédito

- curva

- Clientes

- dados,

- ciência de dados

- cientista de dados

- Entrega

- Demanda

- implantar

- desenvolvimento

- Design

- Detecção

- desenvolver

- Developer

- Desenvolvimento

- diferente

- distribuição

- Não faz

- domínio

- down

- facilmente

- eficiente

- Ponto final

- engenheiro

- Engenharia

- Engenheiros

- Empreendimento

- Entretenimento

- Meio Ambiente

- estimado

- exemplo

- experimentar

- exploração

- estender

- mais rápido

- Característica

- retornos

- financeiro

- serviços financeiros

- Primeiro nome

- fluxo

- Foco

- seguinte

- formato

- fraude

- Gratuito

- cheio

- função

- funcionalidade

- jogo

- gerar

- obtendo

- Dando

- Verde

- Growth

- ter

- saúde

- ajudar

- ajuda

- Destaques

- altamente

- histórico

- detém

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTTPS

- Centenas

- importância

- melhorar

- incluir

- Incluindo

- Crescimento

- Individual

- indústrias

- INFORMAÇÕES

- insights

- com seguro

- integrar

- integrado

- interesse

- IT

- Trabalho

- Empregos

- juntar

- Conhecimento

- Rótulos

- mais recente

- lançamento

- APRENDER

- aprendizagem

- Line

- LINK

- Lista

- pequeno

- local

- longo

- procurando

- gosta,

- máquina

- aprendizado de máquina

- de grupos

- manualmente

- fabrica

- marca

- mercado

- Matriz

- Mídia

- Métrica

- milhão

- ML

- modelo

- modelos

- mês

- mover

- rede

- caderno

- Oferece

- abre

- Operações

- Opção

- Opções

- ordem

- organização

- organizações

- Outros

- atuação

- performances

- fase

- planejamento

- Jogar

- Ponto de vista

- possível

- poderoso

- predição

- Previsões

- preços

- primário

- Diretor

- Problema

- processo

- produzir

- Produção

- Produtos

- projetos

- fornecer

- fornece

- puxando

- qualidade

- rapidamente

- alcance

- Cru

- em tempo real

- reduzir

- Denunciar

- requerer

- Recursos

- resposta

- Resultados

- receita

- Execute

- corrida

- escalável

- dimensionamento

- Ciência

- Cientista

- cientistas

- Sdk

- selecionado

- Série

- Serviços

- conjunto

- Partilhar

- compartilhado

- simples

- SIX

- Tamanho

- Habilidades

- folga

- So

- Soluções

- RESOLVER

- começo

- começado

- estatística

- armazenamento

- lojas

- estudo

- ajuda

- Target

- Profissionais

- Equipar

- ensaio

- A fonte

- todo

- tempo

- juntos

- ferramentas

- topo

- tradicional

- Training

- trens

- Transações

- Transformar

- Transparência

- ui

- compreender

- universidade

- us

- usar

- valor

- Ver

- visibilidade

- visão

- O Quê

- se

- QUEM

- dentro

- sem

- Atividades:

- trabalhou

- trabalhar

- trabalho

- escrita

- anos