Esta postagem apresenta os desafios mais comuns que os clientes enfrentam ao pesquisar documentos internos e fornece orientações concretas sobre como os serviços da AWS podem ser usados para criar um bot conversacional de IA generativo que torna as informações internas mais úteis.

Os dados não estruturados representam 80% de todos os dados encontrado nas organizações, composto por repositórios de manuais, PDFs, FAQs, e-mails e outros documentos que crescem diariamente. As empresas hoje dependem de repositórios de informações internas em constante crescimento, e surgem problemas quando a quantidade de dados não estruturados se torna incontrolável. Freqüentemente, os usuários leem e verificam muitas fontes internas diferentes para encontrar as respostas de que precisam.

Fóruns internos de perguntas e respostas podem ajudar os usuários a obter respostas altamente específicas, mas também exigem tempos de espera mais longos. No caso de perguntas frequentes internas específicas da empresa, longos tempos de espera resultam em menor produtividade dos funcionários. Os fóruns de perguntas e respostas são difíceis de escalar, pois dependem de respostas escritas manualmente. Com a IA generativa, há atualmente uma mudança de paradigma na forma como os usuários pesquisam e encontram informações. O próximo passo lógico é usar IA generativa para condensar documentos grandes em informações menores para facilitar o consumo do usuário. Em vez de gastar muito tempo lendo textos ou esperando respostas, os usuários podem gerar resumos em tempo real com base em vários repositórios existentes de informações internas.

Visão geral da solução

A solução permite que os clientes recuperem respostas selecionadas a perguntas feitas sobre documentos internos usando um modelo transformador para gerar respostas a perguntas sobre dados nos quais não foram treinados, uma técnica conhecida como prompt zero-shot. Ao adotar esta solução, os clientes podem obter os seguintes benefícios:

- Encontre respostas precisas para perguntas com base em fontes existentes de documentos internos

- Reduza o tempo que os usuários gastam procurando respostas usando Large Language Models (LLMs) para fornecer respostas quase imediatas a consultas complexas usando documentos com as informações mais atualizadas

- Pesquise perguntas respondidas anteriormente por meio de um painel centralizado

- Reduza o estresse causado por gastar tempo lendo informações manualmente em busca de respostas

Geração Aumentada de Recuperação (RAG)

A geração aumentada de recuperação (RAG) reduz algumas das deficiências das consultas baseadas em LLM, encontrando as respostas em sua base de conhecimento e usando o LLM para resumir os documentos em respostas concisas. Por favor leia isto postar aprender como implementar a abordagem RAG com Amazona Kendra. Os seguintes riscos e limitações estão associados a consultas baseadas em LLM abordadas por uma abordagem RAG com Amazon Kendra:

- Alucinações e rastreabilidade – os LLMS são treinados em grandes conjuntos de dados e geram respostas sobre probabilidades. Isso pode levar a respostas imprecisas, conhecidas como alucinações.

- Vários silos de dados – Para fazer referência a dados de múltiplas fontes em sua resposta, é necessário configurar um ecossistema de conectores para agregar os dados. O acesso a vários repositórios é manual e demorado.

- Segurança – Segurança e privacidade são considerações críticas ao implantar bots de conversação com tecnologia RAG e LLMs. Apesar de usar Amazon Comprehend para filtrar dados pessoais que podem ser fornecidos por meio de consultas de usuários, ainda existe a possibilidade de revelar involuntariamente informações pessoais ou confidenciais, dependendo dos dados ingeridos. Isto significa que controlar o acesso ao chatbot é crucial para evitar o acesso não intencional a informações confidenciais.

- Relevância dos dados – os LLMS são treinados em dados até uma determinada data, o que significa que as informações muitas vezes não são atualizadas. O custo associado aos modelos de treinamento com base em dados recentes é alto. Para garantir respostas precisas e atualizadas, as organizações têm a responsabilidade de atualizar e enriquecer regularmente o conteúdo dos documentos indexados.

- Custo – O custo associado à implantação desta solução deve ser levado em consideração pelas empresas. As empresas precisam avaliar cuidadosamente os seus requisitos orçamentários e de desempenho ao implementar esta solução. A execução de LLMs pode exigir recursos computacionais substanciais, o que pode aumentar os custos operacionais. Esses custos podem se tornar uma limitação para aplicações que precisam operar em larga escala. Contudo, um dos benefícios do AWS Cloud é a flexibilidade de pagar apenas pelo que você usa. A AWS oferece um modelo de preços simples, consistente e com pagamento conforme o uso, para que você seja cobrado apenas pelos recursos que consumir.

Uso do Amazon SageMaker JumpStart

Para modelos de linguagem baseados em transformadores, as organizações podem se beneficiar do uso Amazon Sage Maker JumpStart, que oferece uma coleção de modelos de aprendizado de máquina pré-construídos. O Amazon SageMaker JumpStart oferece uma ampla variedade de modelos básicos de geração de texto e resposta a perguntas (Q&A) que podem ser facilmente implantados e utilizados. Esta solução integra um modelo Amazon SageMaker JumpStart FLAN T5-XL, mas há diferentes aspectos a serem considerados ao escolhendo um modelo de fundação.

Integrando segurança em nosso fluxo de trabalho

Seguindo as melhores práticas do Pilar Segurança do Estrutura bem arquitetada, Amazon Cognito é usado para autenticação. Os grupos de usuários do Amazon Cognito podem ser integrados a provedores de identidade de terceiros que oferecem suporte a diversas estruturas usadas para controle de acesso, incluindo Open Authorization (OAuth), OpenID Connect (OIDC) ou Security Assertion Markup Language (SAML). A identificação dos usuários e suas ações permite que a solução mantenha a rastreabilidade. A solução também usa o Detecção de informações de identificação pessoal (PII) do Amazon Comprehend recurso para identificar e redigir PII automaticamente. As PII redigidas incluem endereços, números de segurança social, endereços de e-mail e outras informações confidenciais. Esse design garante que qualquer PII fornecida pelo usuário por meio da consulta de entrada seja editada. As PII não são armazenadas, usadas pelo Amazon Kendra ou alimentadas no LLM.

Passo a passo da solução

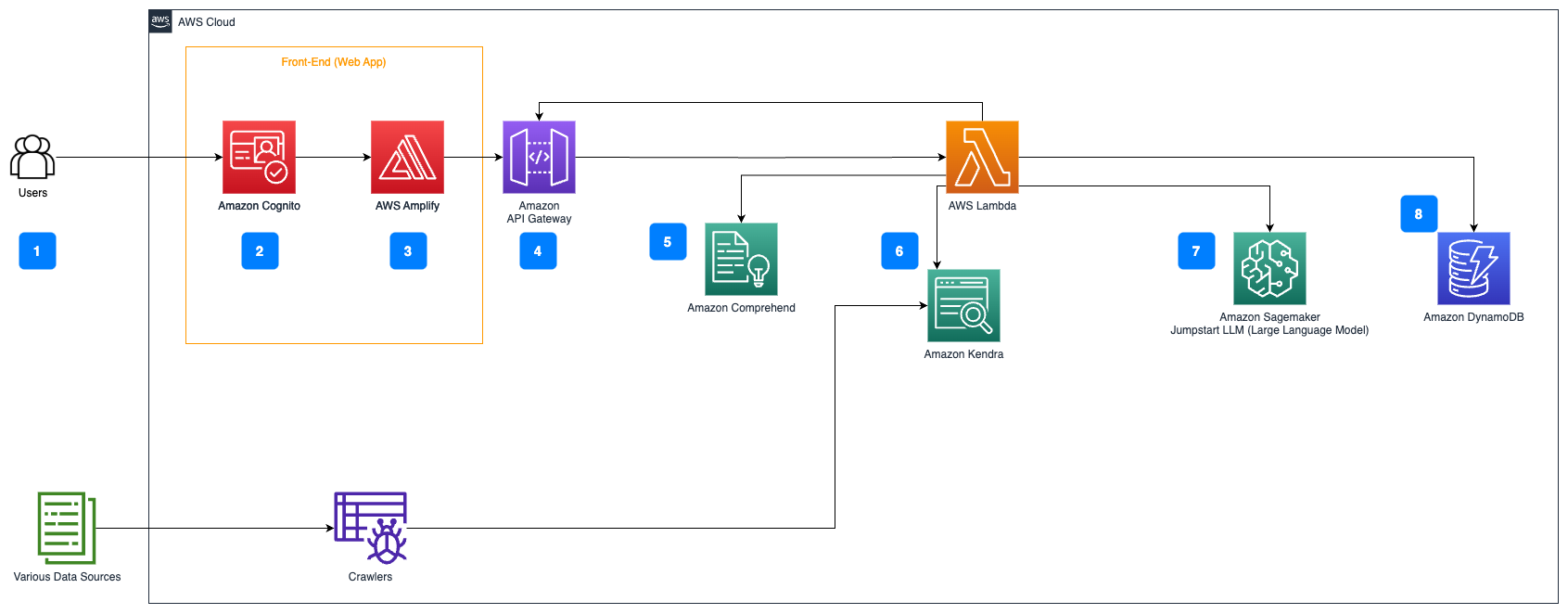

As etapas a seguir descrevem o fluxo de trabalho da resposta a perguntas sobre o fluxo de documentos:

- Os usuários enviam uma consulta por meio de uma interface web.

- Amazon Cognito é usado para autenticação, garantindo acesso seguro à aplicação web.

- O front-end do aplicativo da web está hospedado em Amplificar AWS.

- Gateway de API da Amazon hospeda uma API REST com vários endpoints para lidar com solicitações de usuários autenticadas usando o Amazon Cognito.

- Redação de PII com Amazon Comprehend:

- Processamento de consulta do usuário: quando um usuário envia uma consulta ou entrada, ela é primeiro passada pelo Amazon Comprehend. O serviço analisa o texto e identifica quaisquer entidades PII presentes na consulta.

- Extração de PII: o Amazon Comprehend extrai as entidades PII detectadas da consulta do usuário.

- Recuperação de informações relevantes com Amazona Kendra:

- Amazon Kendra é utilizado para gerenciar um índice de documentos que contém as informações utilizadas para gerar respostas às consultas do usuário.

- A Recuperação de controle de qualidade LangChain O módulo é usado para construir uma cadeia de conversação que contém informações relevantes sobre as dúvidas do usuário.

- Integração com JumpStart do Amazon SageMaker:

- A função AWS Lambda usa a biblioteca LangChain e se conecta ao endpoint Amazon SageMaker JumpStart com uma consulta preenchida com contexto. O endpoint Amazon SageMaker JumpStart serve como interface do LLM usado para inferência.

- Armazenando respostas e devolvendo-as ao usuário:

- A resposta do LLM é armazenada em Amazon DynamoDB junto com a consulta do usuário, o carimbo de data/hora, um identificador exclusivo e outros identificadores arbitrários para o item, como categoria da pergunta. Armazenar a pergunta e a resposta como itens discretos permite que a função AWS Lambda recrie facilmente o histórico de conversas de um usuário com base no horário em que as perguntas foram feitas.

- Por fim, a resposta é enviada de volta ao usuário por meio de uma solicitação HTTPs por meio da resposta de integração da API REST do Amazon API Gateway.

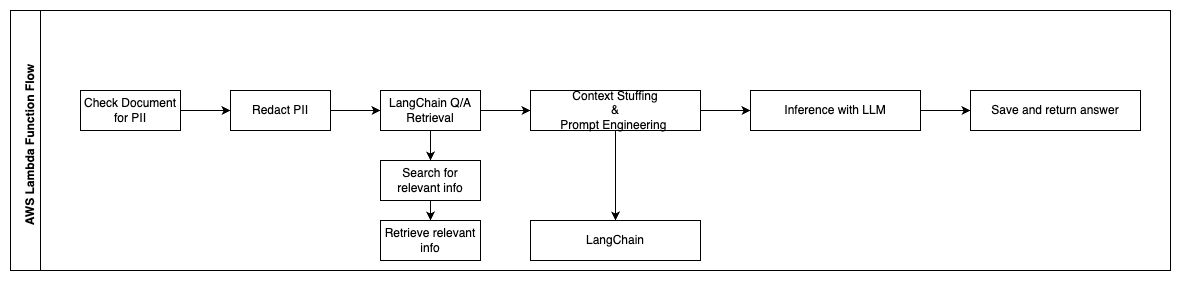

As etapas a seguir descrevem as funções do AWS Lambda e seu fluxo durante o processo:

- Verifique e edite quaisquer PII/informações confidenciais

- Cadeia de recuperação de controle de qualidade LangChain

- Pesquise e recupere informações relevantes

- Recheio de Contexto e Engenharia de Prompt

- Inferência com LLM

- Retornar resposta e salvá-la

Os casos de uso

Existem muitos casos de uso comercial em que os clientes podem usar esse fluxo de trabalho. A seção a seguir explica como o fluxo de trabalho pode ser usado em diferentes setores e verticais.

Assistência ao funcionário

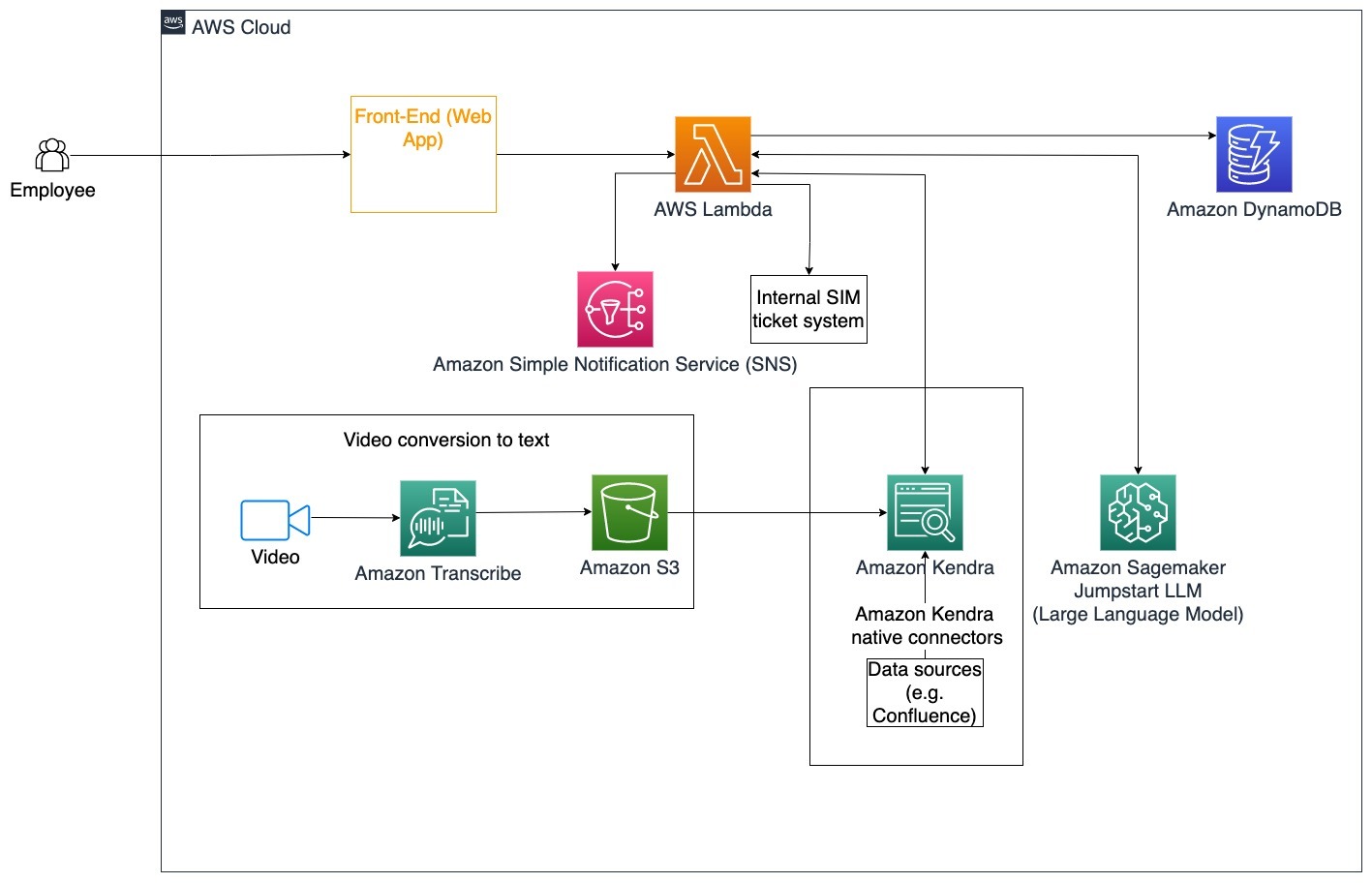

Um treinamento corporativo bem elaborado pode melhorar a satisfação dos funcionários e reduzir o tempo necessário para a integração de novos funcionários. À medida que as organizações crescem e a complexidade aumenta, os funcionários têm dificuldade em compreender as muitas fontes de documentos internos. Os documentos internos neste contexto incluem diretrizes, políticas e procedimentos operacionais padrão da empresa. Para este cenário, um funcionário tem uma dúvida sobre como proceder e editar um ticket de emissão de problema interno. O funcionário pode acessar e usar o bot conversacional generativo de inteligência artificial (IA) para perguntar e executar as próximas etapas de um ticket específico.

Caso de uso específico: Automatize a resolução de problemas para funcionários com base nas diretrizes corporativas.

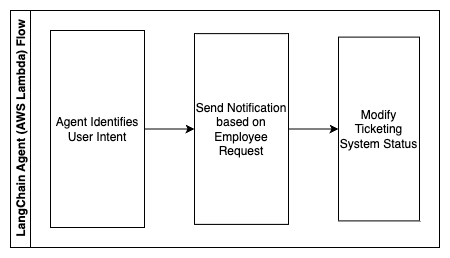

As etapas a seguir descrevem as funções do AWS Lambda e seu fluxo durante o processo:

- Agente LangChain para identificar a intenção

- Enviar notificação com base na solicitação do funcionário

- Modificar status do ticket

Neste diagrama de arquitetura, os vídeos de treinamento corporativo podem ser ingeridos por meio Amazon Transcribe para coletar um registro desses scripts de vídeo. Além disso, o conteúdo de treinamento corporativo armazenado em diversas fontes (ou seja, Confluence, Microsoft SharePoint, Google Drive, Jira etc.) pode ser usado para criar índices por meio de conectores Amazon Kendra. Leia este artigo para saber mais sobre a coleção de nativos de Saúde você pode utilizar no Amazon Kendra como ponto de origem. O rastreador Amazon Kendra poderá então usar os scripts de vídeo de treinamento corporativo e a documentação armazenada nessas outras fontes para ajudar o bot conversacional a responder perguntas específicas às diretrizes de treinamento corporativo da empresa. O agente LangChain verifica permissões, modifica o status do ticket e notifica os indivíduos corretos usando o Amazon Simple Notification Service (Amazon SNS).

Equipes de suporte ao cliente

A resolução rápida das dúvidas dos clientes melhora a experiência do cliente e incentiva a fidelidade à marca. Uma base de clientes fiéis ajuda a impulsionar as vendas, o que contribui para os resultados financeiros e aumenta o envolvimento do cliente. As equipes de suporte ao cliente gastam muita energia referenciando muitos documentos internos e software de gerenciamento de relacionamento com o cliente para responder às dúvidas dos clientes sobre produtos e serviços. Documentos internos neste contexto podem incluir scripts genéricos de chamadas de suporte ao cliente, manuais, diretrizes de escalonamento e informações comerciais. O bot conversacional de IA generativo ajuda na otimização de custos porque lida com consultas em nome da equipe de suporte ao cliente.

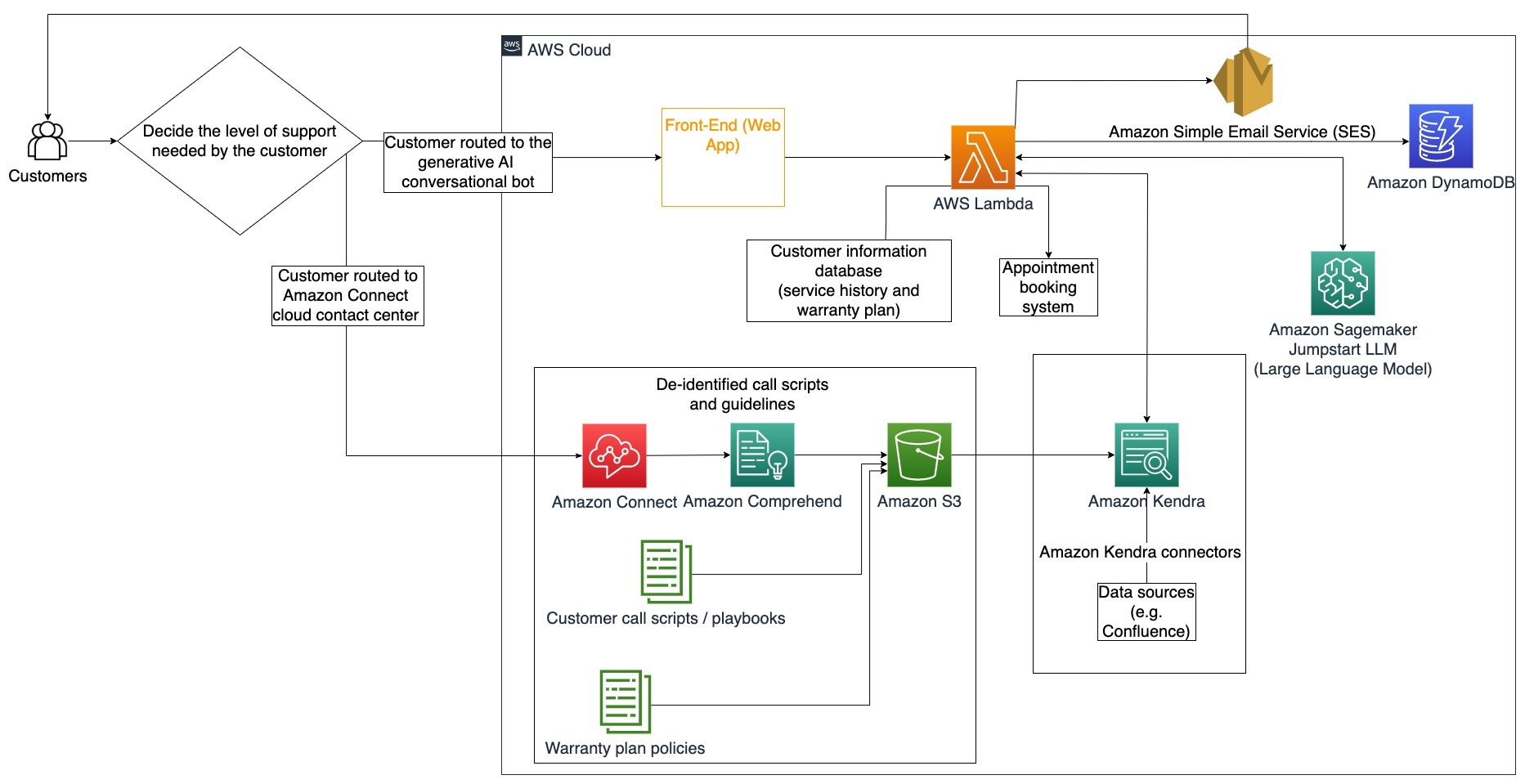

Caso de uso específico: Lidar com uma solicitação de troca de óleo com base no histórico de serviço e no plano de atendimento ao cliente adquirido.

Neste diagrama de arquitetura, o cliente é encaminhado para o bot conversacional de IA generativo ou para o Amazon Conectar Centro de contato. Esta decisão pode ser baseada no nível de suporte necessário ou na disponibilidade dos agentes de suporte ao cliente. O agente LangChain identifica a intenção do cliente e verifica a identidade. O agente LangChain também verifica o histórico de serviço e o plano de suporte adquirido.

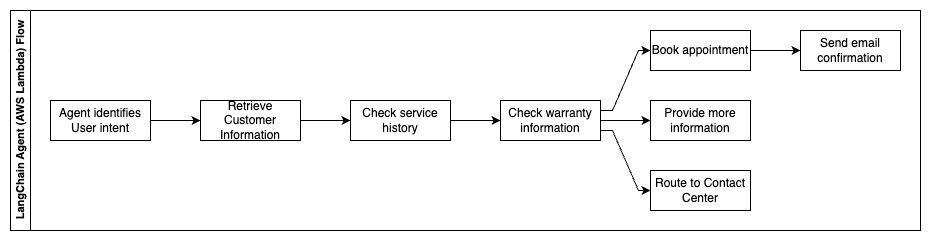

As etapas a seguir descrevem as funções do AWS Lambda e seu fluxo durante o processo:

- Agente LangChain identifica a intenção

- Recuperar informações do cliente

- Verifique o histórico de atendimento ao cliente e informações de garantia

- Marque uma consulta, forneça mais informações ou encaminhe para a central de atendimento

- Enviar confirmação por e-mail

O Amazon Connect é usado para coletar logs de voz e bate-papo, e o Amazon Comprehend é usado para remover informações de identificação pessoal (PII) desses logs. O rastreador do Amazon Kendra poderá então usar os logs de voz e bate-papo editados, os scripts de chamada do cliente e as políticas do plano de suporte de atendimento ao cliente para criar o índice. Depois que uma decisão é tomada, o bot conversacional de IA generativo decide se marca um compromisso, fornece mais informações ou encaminha o cliente ao contact center para obter mais assistência. Para otimização de custos, o agente LangChain também pode gerar respostas usando menos tokens e um modelo de linguagem grande e mais barato para consultas de clientes de menor prioridade.

Serviços Financeiros

As empresas de serviços financeiros dependem do uso oportuno de informações para permanecerem competitivas e cumprirem as regulamentações financeiras. Usando um bot conversacional de IA generativo, analistas e consultores financeiros podem interagir com informações textuais de maneira conversacional e reduzir o tempo e o esforço necessários para tomar decisões mais bem informadas. Fora do investimento e da pesquisa de mercado, um bot de conversação de IA generativo também pode aumentar as capacidades humanas ao lidar com tarefas que tradicionalmente exigiriam mais esforço e tempo humano. Por exemplo, uma instituição financeira especializada em empréstimos pessoais pode aumentar a taxa de processamento dos empréstimos e, ao mesmo tempo, proporcionar maior transparência aos clientes.

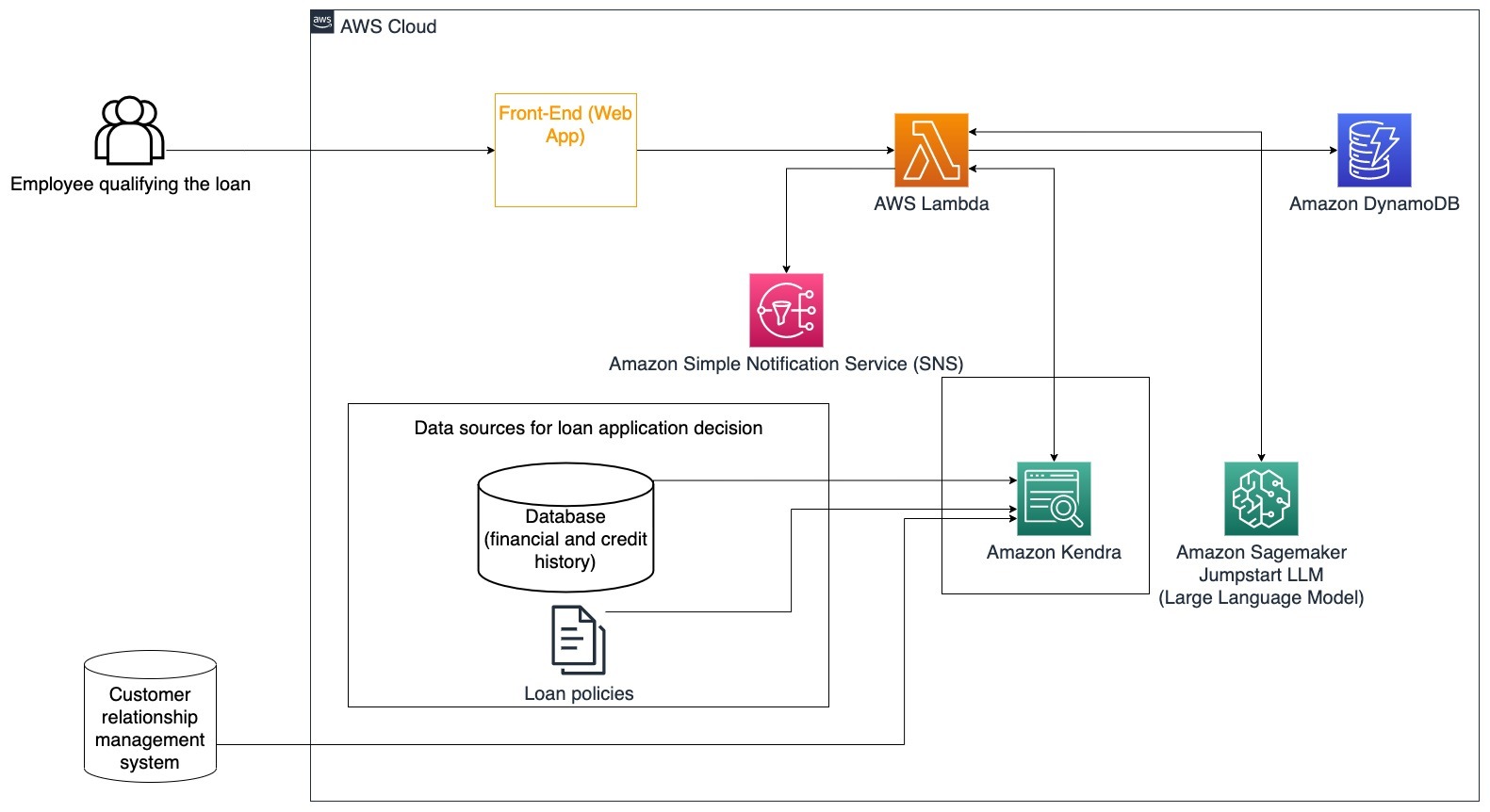

Caso de uso específico: Use o histórico financeiro do cliente e solicitações de empréstimo anteriores para decidir e explicar a decisão do empréstimo.

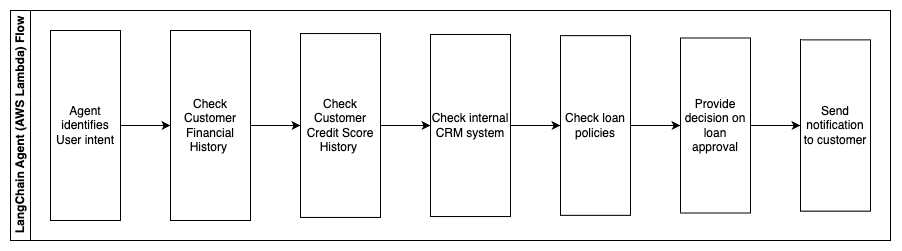

As etapas a seguir descrevem as funções do AWS Lambda e seu fluxo durante o processo:

- Agente LangChain para identificar a intenção

- Verifique o histórico financeiro e de pontuação de crédito do cliente

- Verifique o sistema interno de gerenciamento de relacionamento com o cliente

- Verifique as políticas de empréstimo padrão e sugira uma decisão para o funcionário que qualifica o empréstimo

- Enviar notificação ao cliente

Essa arquitetura incorpora dados financeiros de clientes armazenados em um banco de dados e dados armazenados em uma ferramenta de gerenciamento de relacionamento com o cliente (CRM). Esses pontos de dados são usados para informar uma decisão baseada nas políticas internas de empréstimo da empresa. O cliente pode fazer perguntas esclarecedoras para entender para quais empréstimos ele se qualifica e os termos dos empréstimos que pode aceitar. Se o bot conversacional de IA generativo não conseguir aprovar um pedido de empréstimo, o usuário ainda poderá fazer perguntas sobre como melhorar a pontuação de crédito ou opções alternativas de financiamento.

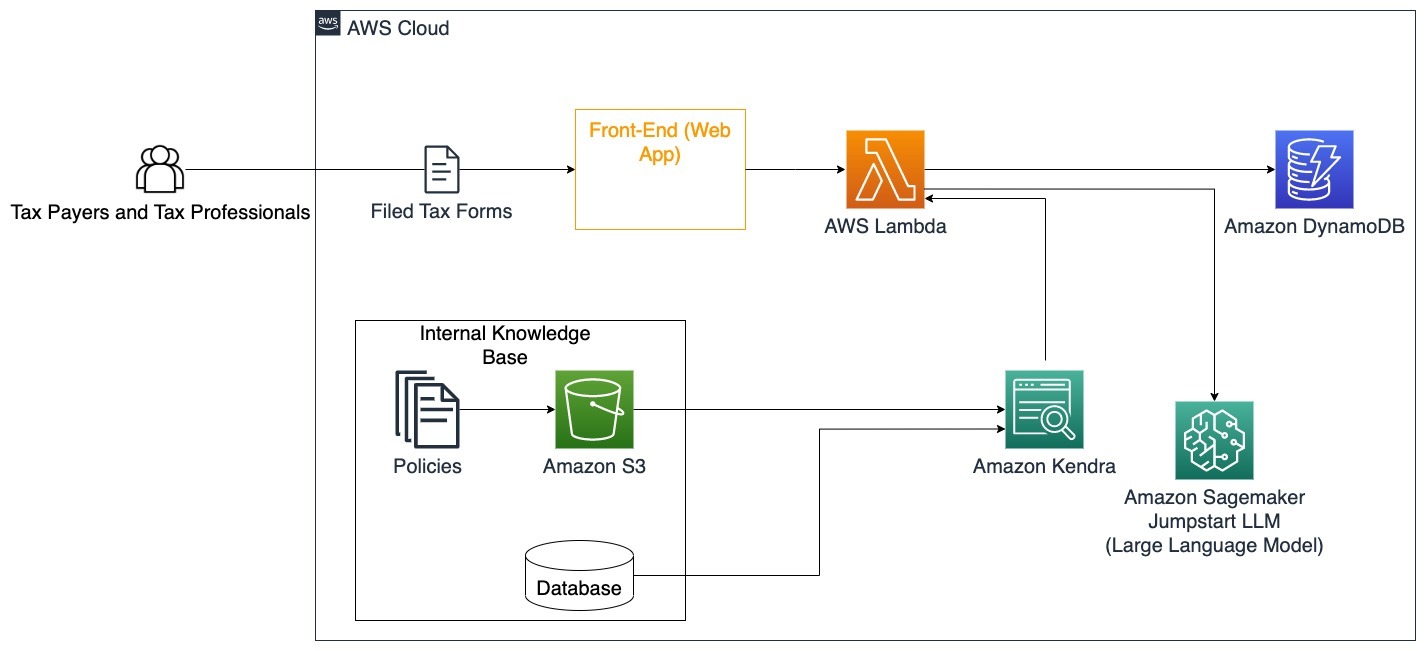

Governo

Os bots conversacionais de IA generativos podem beneficiar enormemente as instituições governamentais, acelerando a comunicação, a eficiência e os processos de tomada de decisão. Os bots conversacionais de IA generativos também podem fornecer acesso instantâneo a bases de conhecimento internas para ajudar os funcionários do governo a recuperar rapidamente informações, políticas e procedimentos (ou seja, critérios de elegibilidade, processos de aplicação e serviços e suporte aos cidadãos). Uma solução é um sistema interativo, que permite aos contribuintes e profissionais fiscais encontrar facilmente detalhes e benefícios fiscais. Ele pode ser usado para entender as dúvidas dos usuários, resumir documentos fiscais e fornecer respostas claras por meio de conversas interativas.

Os usuários podem fazer perguntas como:

- Como funciona o imposto sobre herança e quais são os limites fiscais?

- Você pode explicar o conceito de imposto de renda?

- Quais são as implicações fiscais na venda de um segundo imóvel?

Além disso, os usuários podem ter a comodidade de enviar formulários fiscais a um sistema, o que pode auxiliar na verificação da veracidade das informações fornecidas.

Esta arquitetura ilustra como os usuários podem carregar formulários fiscais preenchidos para a solução e utilizá-los para verificação interativa e orientação sobre como preencher com precisão as informações necessárias.

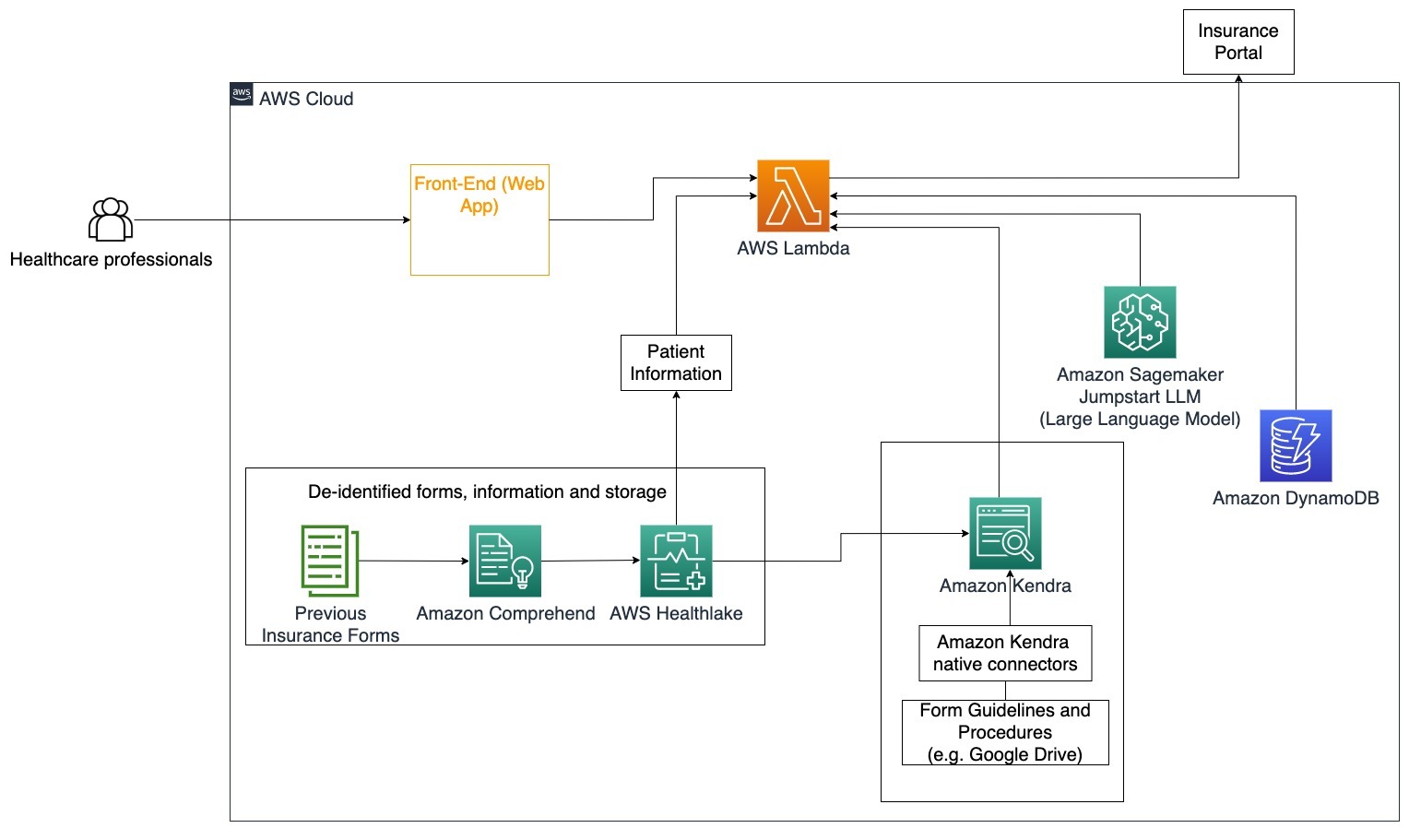

Assistência médica

As empresas de saúde têm a oportunidade de automatizar o uso de grandes quantidades de informações internas dos pacientes, ao mesmo tempo que abordam questões comuns relacionadas a casos de uso, como opções de tratamento, solicitações de seguros, ensaios clínicos e pesquisas farmacêuticas. O uso de um bot conversacional de IA generativo permite a geração rápida e precisa de respostas sobre informações de saúde a partir da base de conhecimento fornecida. Por exemplo, alguns profissionais de saúde gastam muito tempo preenchendo formulários para registrar reclamações de seguros.

Em ambientes semelhantes, os administradores e investigadores de ensaios clínicos precisam de encontrar informações sobre opções de tratamento. Um bot conversacional de IA generativo pode usar os conectores pré-construídos no Amazon Kendra para recuperar as informações mais relevantes dos milhões de documentos publicados por meio de pesquisas contínuas conduzidas por empresas farmacêuticas e universidades.

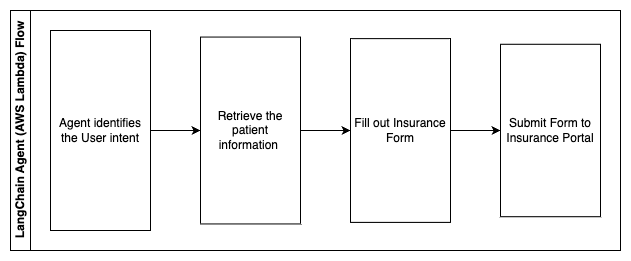

Caso de uso específico: Reduza os erros e o tempo necessário para preencher e enviar formulários de seguros.

Neste diagrama de arquitetura, um profissional de saúde é capaz de usar o bot de conversação de IA generativo para descobrir quais formulários precisam ser preenchidos para o seguro. O agente LangChain é então capaz de recuperar os formulários corretos e adicionar as informações necessárias para um paciente, bem como fornecer respostas para partes descritivas dos formulários com base em apólices de seguro e formulários anteriores. O profissional de saúde pode editar as respostas dadas pelo LLM antes de aprovar e entregar o formulário no portal de seguros.

As etapas a seguir descrevem as funções do AWS Lambda e seu fluxo durante o processo:

- Agente LangChain para identificar a intenção

- Recuperar as informações necessárias do paciente

- Preencha o formulário de seguro com base nas informações do paciente e nas diretrizes do formulário

- Envie o formulário para o portal de seguros após aprovação do usuário

AWS HealthLake é usado para armazenar com segurança os dados de saúde, incluindo formulários de seguro anteriores e informações do paciente, e o Amazon Comprehend é usado para remover informações de identificação pessoal (PII) dos formulários de seguro anteriores. O rastreador Amazon Kendra poderá então usar o conjunto de formulários e diretrizes de seguro para criar o índice. Depois que o(s) formulário(s) for(em) preenchido(s) pela IA generativa, o(s) formulário(s) revisado(s) pelo profissional médico poderá(ão) ser enviado(s) ao portal de seguros.

Estimativa de custo

O custo de implementação da solução base como prova de conceito é mostrado na tabela a seguir. Como a solução base é considerada uma prova de conceito, o Amazon Kendra Developer Edition foi usado como uma opção de baixo custo, já que a carga de trabalho não estaria em produção. Nossa suposição para o Amazon Kendra Developer Edition era de 730 horas ativas por mês.

Para o Amazon SageMaker, presumimos que o cliente usaria a instância ml.g4dn.2xlarge para inferência em tempo real, com um único endpoint de inferência por instância. Você pode encontrar mais informações sobre a definição de preço do Amazon SageMaker e os tipos de instância de inferência disponíveis SUA PARTICIPAÇÃO FAZ A DIFERENÇA.

| e eficaz | Recursos consumidos | Estimativa de custo por mês em dólares americanos |

| Amplificar AWS | 150 minutos de construção 1 GB de dados servidos 500,000 pedidos |

15.71 |

| Gateway de API da Amazon | 1 milhão de chamadas de API REST | 3.5 |

| AWS Lambda | 1 milhão de solicitações 5 segundos de duração por solicitação 2 GB de memória alocada |

160.23 |

| Amazon DynamoDB | 1 milhões de leituras 1 milhão de gravações Armazenamento 100 GB |

26.38 |

| Amazon Sábio | Inferência em tempo real com ml.g4dn.2xlarge | 676.8 |

| Amazona Kendra | Developer Edition com 730 horas/mês 10,000 documentos digitalizados 5,000 consultas/dia |

821.25 |

| . | . | Custo Total: 1703.87 |

* O Amazon Cognito tem um nível gratuito de 50,000 usuários ativos mensais que usam grupos de usuários do Cognito ou 50 usuários ativos mensais que usam provedores de identidade SAML 2.0

Clean Up

Para economizar custos, exclua todos os recursos implementados como parte do tutorial. Você pode excluir quaisquer endpoints do SageMaker que possa ter criado por meio do console do SageMaker. Lembre-se de que excluir um índice do Amazon Kendra não remove os documentos originais do armazenamento.

Conclusão

Neste post, mostramos como simplificar o acesso às informações internas resumindo vários repositórios em tempo real. Após os recentes desenvolvimentos de LLMs disponíveis comercialmente, as possibilidades da IA generativa tornaram-se mais aparentes. Nesta postagem, apresentamos maneiras de usar os serviços da AWS para criar um chatbot sem servidor que usa IA generativa para responder perguntas. Essa abordagem incorpora uma camada de autenticação e detecção de PII do Amazon Comprehend para filtrar quaisquer informações confidenciais fornecidas na consulta do usuário. Quer se trate de indivíduos na área da saúde que entendem as nuances para registrar reclamações de seguros ou de RH que entendem regulamentações específicas de toda a empresa, há vários setores e verticais que podem se beneficiar dessa abordagem. Um modelo básico do Amazon SageMaker JumpStart é o mecanismo por trás do chatbot, enquanto uma abordagem de preenchimento de contexto usando a técnica RAG é usada para garantir que as respostas façam referência a documentos internos com mais precisão.

Para saber mais sobre como trabalhar com IA generativa na AWS, consulte Anunciando novas ferramentas para criar com IA generativa na AWS. Para obter orientações mais detalhadas sobre como usar a técnica RAG com serviços da AWS, consulte Crie rapidamente aplicativos de IA generativa de alta precisão em dados corporativos usando Amazon Kendra, LangChain e modelos de linguagem grandes. Como a abordagem neste blog é independente do LLM, qualquer LLM pode ser usado para inferência. Em nossa próxima postagem, descreveremos maneiras de implementar essa solução usando Amazon Bedrock e Amazon Titan LLM.

Sobre os autores

Abhishek Maligehalli Shivalingaiah é arquiteto sênior de soluções de serviços de IA na AWS. Ele é apaixonado por criar aplicativos usando IA generativa, Amazon Kendra e PNL. Ele tem cerca de 10 anos de experiência na construção de soluções de dados e IA para criar valor para clientes e empresas. Ele até construiu um chatbot (pessoal) para se divertir, para responder perguntas sobre sua carreira e trajetória profissional. Fora do trabalho, ele gosta de fazer retratos de familiares e amigos e adora criar obras de arte.

Abhishek Maligehalli Shivalingaiah é arquiteto sênior de soluções de serviços de IA na AWS. Ele é apaixonado por criar aplicativos usando IA generativa, Amazon Kendra e PNL. Ele tem cerca de 10 anos de experiência na construção de soluções de dados e IA para criar valor para clientes e empresas. Ele até construiu um chatbot (pessoal) para se divertir, para responder perguntas sobre sua carreira e trajetória profissional. Fora do trabalho, ele gosta de fazer retratos de familiares e amigos e adora criar obras de arte.

Medha Aiyah é arquiteto de soluções associado na AWS, baseado em Austin, Texas. Ela se formou recentemente na Universidade do Texas em Dallas em dezembro de 2022 com seu mestrado em Ciência da Computação com especialização em Sistemas Inteligentes com foco em IA/ML. Ela está interessada em aprender mais sobre IA/ML e como utilizar os serviços da AWS para descobrir soluções das quais os clientes podem se beneficiar.

Medha Aiyah é arquiteto de soluções associado na AWS, baseado em Austin, Texas. Ela se formou recentemente na Universidade do Texas em Dallas em dezembro de 2022 com seu mestrado em Ciência da Computação com especialização em Sistemas Inteligentes com foco em IA/ML. Ela está interessada em aprender mais sobre IA/ML e como utilizar os serviços da AWS para descobrir soluções das quais os clientes podem se beneficiar.

Hugo Tsé é arquiteto de soluções associado na AWS e mora em Seattle, Washington. Ele possui mestrado em Tecnologia da Informação pela Arizona State University e bacharelado em Economia pela Universidade de Chicago. É membro da Associação de Auditoria e Controle de Sistemas de Informação (ISACA) e do Consórcio Internacional de Certificação de Segurança de Sistemas de Informação (ISC)2. Ele gosta de ajudar os clientes a se beneficiarem da tecnologia.

Hugo Tsé é arquiteto de soluções associado na AWS e mora em Seattle, Washington. Ele possui mestrado em Tecnologia da Informação pela Arizona State University e bacharelado em Economia pela Universidade de Chicago. É membro da Associação de Auditoria e Controle de Sistemas de Informação (ISACA) e do Consórcio Internacional de Certificação de Segurança de Sistemas de Informação (ISC)2. Ele gosta de ajudar os clientes a se beneficiarem da tecnologia.

Ayman Ishimwe é arquiteto de soluções associado na AWS e mora em Seattle, Washington. Ele possui mestrado em Engenharia de Software e TI pela Oakland University. Ele tem experiência anterior em desenvolvimento de software, especificamente na construção de microsserviços para aplicações web distribuídas. Ele é apaixonado por ajudar os clientes a criar soluções robustas e escaláveis em serviços de nuvem AWS seguindo as melhores práticas.

Ayman Ishimwe é arquiteto de soluções associado na AWS e mora em Seattle, Washington. Ele possui mestrado em Engenharia de Software e TI pela Oakland University. Ele tem experiência anterior em desenvolvimento de software, especificamente na construção de microsserviços para aplicações web distribuídas. Ele é apaixonado por ajudar os clientes a criar soluções robustas e escaláveis em serviços de nuvem AWS seguindo as melhores práticas.

Shervin Suresh é arquiteto de soluções associado na AWS e mora em Austin, Texas. Ele se formou com mestrado em Engenharia de Software com concentração em Computação em Nuvem e Virtualização e bacharelado em Engenharia da Computação pela San Jose State University. Ele é apaixonado por aproveitar a tecnologia para ajudar a melhorar a vida de pessoas de todas as origens.

Shervin Suresh é arquiteto de soluções associado na AWS e mora em Austin, Texas. Ele se formou com mestrado em Engenharia de Software com concentração em Computação em Nuvem e Virtualização e bacharelado em Engenharia da Computação pela San Jose State University. Ele é apaixonado por aproveitar a tecnologia para ajudar a melhorar a vida de pessoas de todas as origens.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- ChartPrime. Eleve seu jogo de negociação com ChartPrime. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :tem

- :é

- :não

- :onde

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Capaz

- Sobre

- ACEITAR

- Acesso

- acessando

- Contas

- preciso

- exatamente

- ações

- ativo

- adicionar

- Adicionalmente

- endereços

- endereçando

- administradores

- Adotando

- conselheiros

- Depois de

- Agente

- agentes

- agregar

- AI

- Serviços de IA

- AI / ML

- Todos os Produtos

- permite

- juntamente

- tb

- alternativa

- Amazon

- Gateway de API da Amazon

- Amazon Cognito

- Amazon Comprehend

- Amazona Kendra

- Amazon Sage Maker

- JumpStart do Amazon SageMaker

- Amazon Web Services

- quantidade

- quantidades

- an

- Analistas

- análises

- e

- responder

- respostas

- qualquer

- api

- aparente

- Aplicação

- aplicações

- nomeação

- abordagem

- aprovar

- arquitetura

- SOMOS

- surgir

- arizona

- por aí

- artigo

- artificial

- inteligência artificial

- Inteligência artificial (AI)

- obras de arte

- AS

- perguntar

- aspectos

- avaliar

- auxiliar

- Assistência

- Jurídico

- associado

- Associação

- suposição

- At

- auditor

- aumentado

- austin

- autenticado

- Autenticação

- autorização

- automatizar

- automaticamente

- disponibilidade

- disponível

- AWS

- AWS Lambda

- em caminho duplo

- fundos

- base

- baseado

- BE

- Tenha

- Porque

- tornam-se

- torna-se

- sido

- antes

- lado

- atrás

- beneficiar

- Benefícios

- MELHOR

- melhores práticas

- Melhor

- Blog

- livro

- Bot

- ambos

- bots

- Inferior

- interesse?

- orçamento

- construir

- Prédio

- construído

- negócio

- negócios

- mas a

- by

- chamada

- CAN

- capacidades

- Oportunidades

- cuidadosamente

- casas

- casos

- Categoria

- causado

- Centralização de

- centralizada

- certo

- FDA

- cadeia

- desafios

- alterar

- carregada

- chatbot

- a verificação

- Cheques

- Chicago

- reivindicações

- remover filtragem

- Clínico

- ensaios clínicos

- Na nuvem

- computação em nuvem

- serviços na nuvem

- coletar

- coleção

- comercialmente

- comum

- Comunicação

- Empresas

- Empresa

- Empresa

- competitivo

- Efetuado

- completando

- integrações

- complexidade

- obedecer

- compreender

- computador

- Engenharia computacional

- Ciência da Computação

- computação

- concentração

- conceito

- conciso

- conduzido

- confluência

- Contato

- conecta

- consideração

- Considerações

- considerado

- consistente

- Consistindo

- cônsul

- consórcio

- consumir

- consumo

- Contacto

- contact center

- contém

- conteúdo

- contexto

- continuamente

- contribui

- ao controle

- controle

- facilidade

- Conversa

- conversação

- conversas

- Responsabilidade

- correta

- Custo

- custos

- rastreador

- crio

- Criar valor

- criado

- Criar

- crédito

- critérios

- crítico

- CRM

- crucial

- comissariada

- Atual

- Atualmente

- cliente

- O envolvimento do cliente é aprimorado em uma relação direta e personalizada.

- experiência do cliente

- Atendimento ao Cliente

- Suporte ao cliente

- Clientes

- diariamente

- Dallas

- dados,

- Os pontos de dados

- conjuntos de dados

- banco de dados

- Data

- Dezembro

- decidir

- decisão

- Tomada de Decisão

- decisões

- Grau

- entregue

- Dependendo

- implantado

- Implantação

- descreve

- Design

- Apesar de

- detalhes

- detectou

- Detecção

- Developer

- Desenvolvimento

- desenvolvimentos

- diferente

- difícil

- descobrir

- distribuído

- documentação

- INSTITUCIONAIS

- parece

- Não faz

- distância

- duração

- e

- mais fácil

- facilmente

- Economia

- ecossistema

- edição

- eficiência

- esforço

- ou

- elegibilidade

- e-mails

- Empregado

- colaboradores

- permite

- encorajar

- Ponto final

- energia

- COMPROMETIMENTO

- Motor

- Engenharia

- enriquecedor

- garantir

- garante

- assegurando

- Empreendimento

- empresas

- entidades

- erros

- escalada

- estimativa

- etc.

- Mesmo

- exemplo

- executar

- existente

- caro

- vasta experiência

- Explicação

- Explica

- Extração

- Extractos

- Rosto

- família

- Característica

- Alimentado

- menos

- Figura

- Envie o

- preencher

- preenchida

- o preenchimento

- filtro

- financeiro

- dados financeiros

- história financeira

- instituição financeira

- financiamento

- Encontre

- descoberta

- Primeiro nome

- Flexibilidade

- fluxo

- focando

- seguinte

- Escolha

- formulário

- formas

- fóruns

- encontrado

- Foundation

- enquadramentos

- Gratuito

- amigos

- da

- Diversão

- função

- funções

- mais distante

- Ganho

- porta de entrada

- gerar

- geração

- generativo

- IA generativa

- ter

- dado

- dá

- Dando

- Governo

- grandemente

- Cresça:

- Crescente

- Cresce

- orientações

- orientações

- manipular

- Alças

- Manipulação

- Ter

- ter

- he

- Saúde

- informação de saúde

- saúde

- ajudar

- ajuda

- ajuda

- sua experiência

- Alta

- altamente

- sua

- história

- detém

- hospedado

- anfitriões

- HORÁRIO

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- hr

- HTML

- HTTPS

- humano

- i

- identificador

- Identificadores

- identifica

- identificar

- identificar

- Identidade

- if

- ilustra

- executar

- implementação

- implicações

- melhorar

- melhora

- melhorar

- in

- em profundidade

- impreciso

- incluir

- inclui

- Incluindo

- Passiva

- imposto de Renda

- Crescimento

- Aumenta

- índice

- indexado

- índices

- indivíduos

- indústrias

- informar

- INFORMAÇÕES

- Sistemas de Informação

- tecnologia da informação

- informado

- herança

- entrada

- instância

- instantâneos

- em vez disso

- Instituição

- instituições

- com seguro

- integrado

- Integra-se

- integração

- Inteligência

- Inteligente

- intenção

- interagir

- interativo

- interessado

- Interface

- interno

- Internacionais

- para dentro

- investimento

- emitem

- IT

- Unid

- viagem

- jpg

- Guarda

- Conhecimento

- conhecido

- língua

- grande

- camada

- conduzir

- APRENDER

- aprendizagem

- menos

- Nível

- aproveitando

- Biblioteca

- limitação

- limitações

- Line

- Vidas

- LLM

- empréstimo

- Empréstimos

- log

- lógico

- longo

- muito tempo

- mais

- olhar

- lote

- ama

- baixo custo

- diminuir

- fiel

- Lealdade

- máquina

- aprendizado de máquina

- moldadas

- a manter

- fazer

- FAZ

- Fazendo

- gerencia

- de grupos

- maneira

- manual

- manualmente

- muitos

- mercado

- pesquisa de mercado

- mestre

- Posso..

- significa

- médico

- membro

- Memória

- microsserviços

- Microsoft

- milhão

- milhões

- mente

- ML

- modelo

- modelos

- Módulo

- Mês

- mensal

- mais

- a maioria

- múltiplo

- nativo

- necessário

- você merece...

- necessário

- Cria

- Novo

- Próximo

- PNL

- notificação

- números

- Oakland

- juramento

- of

- Oferece

- frequentemente

- AZEITE E AZEITE EVO

- on

- Onboarding

- uma vez

- ONE

- contínuo

- só

- aberto

- operar

- operando

- operacional

- Oportunidade

- otimização

- Opção

- Opções

- or

- ordem

- organizações

- original

- Outros

- A Nossa

- Fora

- esboço

- lado de fora

- Acima de

- paradigma

- parte

- peças

- passou

- apaixonado

- paciente

- Pagar

- Pessoas

- para

- atuação

- permissões

- pessoal

- dados pessoais

- Pessoalmente

- Farmacêutica

- Pilar

- plano

- platão

- Inteligência de Dados Platão

- PlatãoData

- por favor

- ponto

- pontos

- políticas

- Piscinas

- Portal

- retratos

- possibilidades

- possibilidade

- Publique

- alimentado

- práticas

- presente

- evitar

- anterior

- anteriormente

- preços

- modelo de precificação

- Prévio

- prioridade

- política de privacidade

- problemas

- procedimentos

- prosseguir

- processo

- Processado

- processos

- em processamento

- Produção

- produtividade

- Produtos

- profissional

- propriedade

- fornecer

- fornecido

- fornecedores

- fornecendo

- publicado

- comprado

- Dúvidas

- qualificar

- de qualificação

- consultas

- questão

- Frequentes

- Links

- rapidamente

- alcance

- Taxa

- Leia

- Leitura

- em tempo real

- recentemente

- recentemente

- reduzir

- reduz

- referir

- referência

- em relação a

- regularmente

- regulamentos

- relacionamento

- relevância

- relevante

- depender

- permanece

- lembrar

- remover

- solicitar

- pedidos

- requerer

- requeridos

- Requisitos

- pesquisa

- pesquisadores

- Resolução

- resolver

- Recursos

- resposta

- respostas

- responsabilidade

- DESCANSO

- resultar

- voltar

- Comentários

- certo

- riscos

- uma conta de despesas robusta

- Rota

- corrida

- s

- sábio

- vendas

- San

- San Jose

- satisfação

- Salvar

- escalável

- Escala

- cenário

- Ciência

- Ponto

- Scripts

- Pesquisar

- pesquisar

- Seattle

- Segundo

- segundo

- Seção

- seguro

- firmemente

- segurança

- Vender

- enviar

- senior

- sensível

- enviei

- Serverless

- serve

- serviço

- Serviços

- conjunto

- Conjuntos

- Configurações

- vários

- ela

- mudança

- falhas

- rede de apoio social

- mostrada

- mostrou

- mostrando

- silos

- semelhante

- simples

- simplificar

- desde

- solteiro

- de tamanho

- menor

- So

- Redes Sociais

- Software

- desenvolvimento de software

- Engenharia de software

- solução

- Soluções

- alguns

- fonte

- Fontes

- especializando

- específico

- especificamente

- gastar

- Passar

- padrão

- Estado

- Status

- ficar

- Passo

- Passos

- Ainda

- armazenamento

- loja

- armazenadas

- armazenar

- estresse

- recheio

- substancial

- tal

- sugerir

- resumir

- ajuda

- .

- sistemas

- mesa

- toma

- tarefas

- imposto

- Profissionais

- equipes

- Tecnologia

- condições

- texas

- texto

- textual

- que

- A

- as informações

- deles

- si mesmos

- então

- Lá.

- Este

- deles

- De terceiros

- isto

- Através da

- bilhete

- ticketing

- camada

- tempo

- demorado

- oportuno

- vezes

- timestamp

- titã

- para

- hoje

- Tokens

- ferramenta

- ferramentas

- Rastreabilidade

- tradicionalmente

- treinado

- Training

- transformador

- Transparência

- tratamento

- julgamento

- ensaios

- tutorial

- tipos

- incapaz

- compreender

- compreensão

- único

- Universidades

- universidade

- Universidade de Chicago

- que vai mais à frente

- Atualizada

- atualização

- usar

- caso de uso

- usava

- Utilizador

- usuários

- usos

- utilização

- utilizar

- utilizado

- Utilizando

- valor

- vário

- Verificação

- verificar

- Verticais

- via

- Vídeo

- VÍDEOS

- voz

- esperar

- Esperando

- foi

- Washington

- maneiras

- we

- web

- Aplicativo da Web

- Aplicativos da web

- serviços web

- BEM

- foram

- O Quê

- quando

- se

- qual

- enquanto

- QUEM

- Largo

- Ampla variedade

- de

- dentro

- Atividades:

- de gestão de documentos

- trabalhar

- seria

- escrito

- anos

- Vocês

- investimentos

- zefirnet