Detectarea părtinirii în datele și rezultatele modelului este o cerință fundamentală pentru construirea de modele responsabile de inteligență artificială (AI) și învățare automată (ML). Din păcate, detectarea părtinirii nu este o sarcină ușoară pentru marea majoritate a practicienilor din cauza numărului mare de moduri în care poate fi măsurată și a diferiților factori care pot contribui la un rezultat părtinitor. De exemplu, o eșantionare dezechilibrată a datelor de antrenament poate duce la un model care este mai puțin precis pentru anumite subseturi de date. Prejudecățile pot fi, de asemenea, introduse de algoritmul ML în sine - chiar și cu un set de date de antrenament bine echilibrat, rezultatele ar putea favoriza anumite subseturi de date în comparație cu celelalte.

Pentru a detecta părtinirea, trebuie să aveți o înțelegere aprofundată a diferitelor tipuri de părtinire și a celor corespunzătoare metrica de părtinire. De exemplu, la momentul scrierii acestui articol, Amazon SageMaker Clarify oferă 21 de valori diferite din care să alegeți.

În această postare, folosim un caz de utilizare pentru predicția veniturilor (predicția veniturilor utilizatorilor din funcții de intrare, cum ar fi educația și numărul de ore lucrate pe săptămână) pentru a demonstra diferite tipuri de părtiniri și valorile corespunzătoare în SageMaker Clarify. De asemenea, dezvoltăm un cadru care să vă ajute să decideți ce valori contează pentru aplicația dvs.

Introducere în SageMaker Clarify

Modelele ML sunt din ce în ce mai folosite pentru a ajuta la luarea deciziilor într-o varietate de domenii, cum ar fi serviciile financiare, sănătatea, educația și resursele umane. În multe situații, este important să înțelegem de ce modelul ML a făcut o anumită predicție și, de asemenea, dacă predicțiile au fost afectate de părtinire.

SageMaker Clarify oferă instrumente pentru ambele nevoi, dar în această postare ne concentrăm doar pe funcționalitatea de detectare a părtinirii. Pentru a afla mai multe despre explicabilitate, consultați Explicarea faptelor meciului Bundesliga xGoals folosind Amazon SageMaker Clarify.

SageMaker Clarify face parte din Amazon SageMaker, care este un serviciu complet gestionat pentru a construi, antrena și implementa modele ML.

Exemple de întrebări despre părtinire

Pentru a fundamenta discuția, următoarele sunt câteva exemple de întrebări pe care constructorii ML și părțile interesate le pot avea cu privire la părtinire. Lista constă din câteva întrebări generale care pot fi relevante pentru mai multe aplicații ML, precum și întrebări despre aplicații specifice, cum ar fi regăsirea documentelor.

Ați putea să întrebați, având în vedere grupurile de interes din datele de antrenament (de exemplu, bărbați vs. femei) ce valori ar trebui să folosesc pentru a răspunde la următoarele întrebări:

- Reprezentarea grupului în datele de instruire reflectă lumea reală?

- Etichetele țintă din datele de instruire favorizează un grup față de celălalt, atribuindu-i etichete mai pozitive?

- Modelul are o precizie diferită pentru diferite grupuri?

- Într-un model al cărui scop este identificarea candidaților calificați pentru angajare, are modelul aceeași precizie pentru diferite grupuri?

- Într-un model al cărui scop este de a prelua documente relevante pentru o interogare de intrare, modelul preia documente relevante din grupuri diferite în aceeași proporție?

În restul acestei postări, dezvoltăm un cadru pentru cum să luați în considerare răspunsul la aceste întrebări și la altele prin valorile disponibile în SageMaker Clarify.

Caz de utilizare și context

Această postare folosește un exemplu existent al unui job SageMaker Clarify din Corectitudine și explicabilitate cu notebook-ul SageMaker Clarify și explică valorile metrice de părtinire generate. Notebook-ul antrenează un model XGBoost pe Set de date UCI pentru adulți (Dua, D. și Graff, C. (2019). Depozitul UCI Machine Learning. Irvine, CA: Universitatea din California, Scoala de Informatii si Informatica).

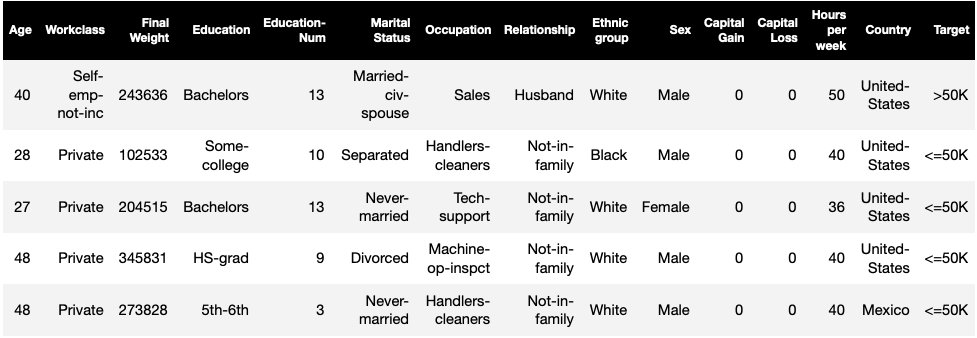

Sarcina ML din acest set de date este de a prezice dacă o persoană are un venit anual mai mare sau mai mic de 50,000 USD. Următorul tabel prezintă câteva cazuri împreună cu caracteristicile acestora. Măsurarea părtinirii în predicția veniturilor este importantă, deoarece am putea folosi aceste predicții pentru a informa decizii precum ofertele de reduceri și marketingul direcționat.

Terminologia de părtinire

Înainte de a ne scufunda mai adânc, să trecem în revistă câteva terminologii esențiale. Pentru o listă completă de termeni, vezi Amazon SageMaker clarifică termenii pentru părtinire și corectitudine.

- Etichetă – Caracteristica țintă pe care modelul ML este antrenat să o prezică. Un eticheta observata se referă la valoarea etichetei observată în datele utilizate pentru antrenarea sau testarea modelului. A eticheta prezisă este valoarea prezisă de modelul ML. Etichetele pot fi binare și sunt adesea codificate ca 0 și 1. Presupunem că 1 reprezintă o etichetă favorabilă sau pozitivă (de exemplu, venit mai mare sau egal cu 50,000 USD) și 0 reprezintă o etichetă nefavorabilă sau negativă. Etichetele pot consta, de asemenea, din mai mult de două valori. Chiar și în aceste cazuri, una sau mai multe dintre valori constituie etichete favorabile. De dragul simplității, această postare ia în considerare doar etichetele binare. Pentru detalii despre manipularea etichetelor cu mai mult de două valori și a etichetelor cu valori continue (de exemplu, în regresie), consultați Cartea albă privind corectitudinea și explicabilitatea Amazon AI.

- Faţetă – O coloană sau o caracteristică în raport cu care se măsoară părtinirea. În exemplul nostru, fațeta este

sexși ia două valori:womanșiman, codificat cafemaleșimaleîn date (aceste date sunt extrase din recensământul din 1994 și impun o opțiune binară). Deși postarea ia în considerare o singură fațetă cu doar două valori, pentru cazuri mai complexe care implică mai multe fațete sau fațete cu mai mult de două valori, consultați Cartea albă privind corectitudinea și explicabilitatea Amazon AI. - Părtinire – Un dezechilibru semnificativ în datele de intrare sau predicțiile modelului în diferite valori ale fațetelor. Ceea ce constituie „semnificativ” depinde de aplicația dvs. Pentru majoritatea valorilor, o valoare de 0 implică nici un dezechilibru. Valorile de părtinire din SageMaker Clarify sunt împărțite în două categorii:

- Preantrenamentul – Atunci când este prezentă, prejudecarea de preantrenament indică dezechilibre numai în date.

- Post formare – Prejudecățile după antrenament ia în considerare în plus predicțiile modelelor.

Să examinăm fiecare categorie separat.

Prejudecata la antrenament

Măsurile de părtinire de preantrenare în SageMaker Clarify răspund la următoarea întrebare: Toate valorile fațetei au reprezentare egală (sau similară) în date? Este important să inspectați datele pentru prejudecățile dinainte de antrenament, deoarece se pot traduce în părtiniri postantrenamente în predicțiile modelului. De exemplu, un model antrenat pe date dezechilibrate în care o valoare a fațetei apare foarte rar poate prezenta o acuratețe substanțial mai slabă pentru acea valoare a fațetei. Reprezentarea egală poate fi calculată pentru următoarele:

- Toate datele de antrenament, indiferent de etichete

- Subsetul de date de antrenament numai cu etichete pozitive

- Fiecare etichetă separat

Figura următoare oferă un rezumat al modului în care fiecare măsurătoare se încadrează în fiecare dintre cele trei categorii.

Unele categorii constau din mai multe valori. Valorile de bază (casetele gri) răspund la întrebarea despre părtinire în acea categorie în cea mai simplă formă. Valorile din casetele albe acoperă în plus cazuri speciale (de exemplu, paradoxul lui Simpson) și preferințele utilizatorilor (de exemplu, concentrarea asupra anumitor părți ale populației atunci când calculează performanța predictivă).

Reprezentarea valorii fațete, indiferent de etichete

Singura valoare din această categorie este Dezechilibrul de clasă (CI). Scopul acestei metrici este de a măsura dacă toate valorile fațetelor au reprezentare egală în date.

CI este diferența dintre fracția de date constituită de cele două valori fațete. În setul nostru de date exemplu, pentru fațetă sex, defalcarea (prezentată în graficul circular) arată că femeile constituie 32.4% din datele de formare, în timp ce bărbații constituie 67.6%. Ca urmare:

CI = 0.676 - 0.324 = 0.352

Un dezechilibru sever înalt de clasă ar putea duce la o performanță predictivă mai proastă pentru valoarea fațetei cu o reprezentare mai mică.

Reprezentarea valorii fațete numai la nivelul etichetelor pozitive

O altă modalitate de a măsura reprezentarea egală este de a verifica dacă toate valorile fațetelor conțin o fracțiune similară de eșantioane cu etichete observate pozitive. Etichetele pozitive constau în rezultate favorabile (de exemplu, împrumut acordat, selectat pentru job), astfel încât analizarea separată a etichetelor pozitive ajută la evaluarea dacă deciziile favorabile sunt distribuite uniform.

În setul nostru de date exemplu, etichetele observate se împart în valori pozitive și negative, așa cum se arată în figura următoare.

11.4% din toate femeile și 31.4% dintre toți bărbații au eticheta pozitivă (regiune umbrită întunecată în barele din stânga și din dreapta). Diferența în proporții pozitive în etichete (DPL) măsoară această diferență.

DPL = 0.314 - 0.114 = 0.20

Valoarea avansată din această categorie, Disparitatea demografică condiționată în etichete (CDDL), măsoară diferențele dintre etichetele pozitive, dar le stratifică în raport cu o altă variabilă. Această măsurătoare ajută la controlul pentru Paradoxul lui Simpson, un caz în care un calcul asupra tuturor datelor arată părtinire, dar părtinirea dispare la gruparea datelor cu privire la unele informații secundare.

1973 Studiu de admitere UC Berkeley oferă un exemplu. Potrivit datelor, bărbații au fost internați cu o rată mai mare decât femeile. Cu toate acestea, atunci când au fost examinate la nivelul departamentelor universitare individuale, femeile au fost admise cu o rată similară sau mai mare la fiecare departament. Această observație poate fi explicată prin paradoxul lui Simpson, care a apărut aici deoarece femeile aplicau la școli care erau mai competitive. Ca urmare, mai puține femei au fost admise în general în comparație cu bărbații, chiar dacă școală după școală au fost admise la o rată similară sau mai mare.

Pentru mai multe detalii despre modul în care este calculat CDDL, consultați Cartea albă privind corectitudinea și explicabilitatea Amazon AI.

Reprezentarea valorii fațete la nivelul fiecărei etichete separat

Egalitatea în reprezentare poate fi măsurată și pentru fiecare etichetă individuală, nu doar pentru eticheta pozitivă.

Valorile din această categorie calculează diferența în distribuția etichetelor diferitelor valori ale fațetelor. Distribuția etichetei pentru o valoare a fațetei conține toate valorile etichetei observate, împreună cu fracția de mostre cu valoarea etichetei respective. De exemplu, în figura care arată distribuția etichetelor, 88.6% dintre femei au o etichetă observată negativă și 11.4% au o etichetă observată pozitivă. Deci, distribuția etichetei pentru femei este [0.886, 0.114] și pentru bărbați este [0.686, 0.314].

Valoarea de bază din această categorie, divergența Kullback-Leibler (KL), măsoară această diferență ca:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Metricile avansate din această categorie, divergența Jensen-Shannon (JS), Lp-norm (LP), Total Variation Distance (TVD) și Kolmogorov-Smirnov (KS), măsoară și diferența dintre distribuții, dar au proprietăți matematice diferite. Cu excepția cazurilor speciale, ei vor oferi informații similare cu KL. De exemplu, deși valoarea KL poate fi infinită atunci când o valoare a fațetei nu conține mostre cu o anumită etichetă (de exemplu, niciun bărbat cu o etichetă negativă), JS evită aceste valori infinite. Pentru mai multe detalii despre aceste diferențe, vezi Cartea albă privind corectitudinea și explicabilitatea Amazon AI.

Relația dintre DPL (Categoria 2) și valorile bazate pe distribuție ale KL/JS/LP/TVD/KS (Categoria 3)

Valorile bazate pe distribuție sunt aplicabile în mod mai natural etichetelor non-binare. Pentru etichetele binare, datorită faptului că dezechilibrul în eticheta pozitivă poate fi utilizat pentru a calcula dezechilibrul în eticheta negativă, valorile de distribuție oferă aceleași informații ca și DPL. Prin urmare, puteți utiliza doar DPL în astfel de cazuri.

Prejudecata postantrenament

Valorile de părtinire după antrenament din SageMaker Clarify ne ajută să răspundem la două întrebări cheie:

- Sunt toate valorile fațetelor reprezentate la o rată similară în predicțiile pozitive (favorabile) ale modelului?

- Are modelul performanțe predictive similare pentru toate valorile fațetelor?

Următoarea figură arată modul în care valorile se mapează la fiecare dintre aceste întrebări. A doua întrebare poate fi defalcată în funcție de eticheta cu care este măsurată performanța.

Reprezentare egală în predicțiile model pozitive

Valorile din această categorie verifică dacă toate valorile fațetelor conțin o fracțiune similară de eșantioane cu etichetă estimată pozitivă de către model. Această clasă de valori este foarte asemănătoare cu valorile de preformare ale DPL și CDDL - singura diferență este că această categorie ia în considerare etichetele prezise în loc de etichetele observate.

În setul nostru de date exemplu, 4.5% dintre toate femeile primesc eticheta pozitivă de către model, iar 13.7% dintre toți bărbații au eticheta pozitivă.

Valoarea de bază din această categorie, Diferența în proporții pozitive în etichetele prezise (DPPL), măsoară diferența dintre alocațiile de clasă pozitive.

DPPL = 0.137 - 0.045 = 0.092

Observați cum în datele de antrenament, o fracțiune mai mare de bărbați avea o etichetă observată pozitiv. În mod similar, unei fracțiuni mai mari de bărbați i se atribuie o etichetă de predicție pozitivă.

Trecând la valorile avansate din această categorie, Disparate Impact (DI) măsoară aceeași diferență în temele de clasă pozitive, dar în loc de diferență, calculează raportul:

DI = 0.045 / 0.137 = 0.328

Atât DI, cât și DPPL transmit perspective calitativ similare, dar diferă în unele cazuri. De exemplu, rapoartele tind să explodeze la numere foarte mari dacă numitorul este mic. Luați un exemplu de numere 0.1 și 0.0001. Raportul este 0.1/0.0001 = 10,000, în timp ce diferența este 0.1 – 0.0001 ≈ 0.1. Spre deosebire de celelalte valori în care o valoare de 0 nu implică nicio părtinire, pentru DI, nicio părtinire nu corespunde unei valori de 1.

Disparitatea demografică condiționată în etichetele prezise (CDDPL) măsoară disparitatea în reprezentarea valorii fațete în eticheta pozitivă, dar, la fel ca metrica de preformare a CDDL, controlează și paradoxul lui Simpson.

Counterfactual Fliptest (FT) măsoară dacă eșantioane similare din cele două valori fațete primesc decizii similare de la model. Un model care atribuie decizii diferite la două eșantioane care sunt similare unul cu celălalt, dar diferă în ceea ce privește valorile fațetei ar putea fi considerat părtinitor față de valoarea fațetei căreia i-a fost atribuită eticheta nefavorabilă (negativă). Având în vedere prima valoare a fațetei (femei), evaluează dacă membrii similari cu cealaltă valoare a fațetei (bărbați) au un model de predicție diferit. Membrii similari sunt aleși pe baza algoritmului k-cel mai apropiat vecin.

Performanță egală

Predicțiile modelului ar putea avea o reprezentare similară în etichete pozitive din diferite valori ale fațetelor, dar performanța modelului pe aceste grupuri ar putea diferi semnificativ. În multe aplicații, poate fi de dorit să aibă o performanță predictivă similară în diferite valori ale fațetelor. Valorile din această categorie măsoară diferența de performanță predictivă între valorile fațete.

Deoarece datele pot fi împărțite în multe moduri diferite pe baza etichetelor observate sau prezise, există multe moduri diferite de a măsura performanța predictivă.

Performanță predictivă egală, indiferent de etichete

Puteți lua în considerare performanța modelului pe toate datele, indiferent de etichetele observate sau prezise - adică acuratețea generală.

Următoarele figuri arată modul în care modelul clasifică intrările din cele două valori ale fațetelor din setul nostru de date exemplu. Adevărații negative (TN) sunt cazuri în care atât eticheta observată, cât și cea prezisă au fost 0. Fals pozitive (FP) sunt clasificări greșite în care eticheta observată a fost 0, dar eticheta prezisă a fost 1. Adevăratele pozitive (TP) și false negative (FN) sunt definite în mod similar.

|

|

Pentru fiecare valoare a fațetei, performanța generală a modelului, adică acuratețea pentru acea valoare a fațetei, este:

Acuratete = (TN + TP🇧🇷TN + FP + FN + TP)

Cu această formulă, precizia pentru femei este de 0.930, iar pentru bărbați este de 0.815. Aceasta duce la singura valoare din această categorie, Diferența de precizie (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 înseamnă că acuratețea pentru ambele grupuri este aceeași. Valorile mai mari (pozitive sau negative) indică diferențe mai mari de precizie.

Performanță egală numai pe etichetele pozitive

Puteți restricționa analiza performanței modelului numai la etichete pozitive. De exemplu, dacă aplicația se referă la detectarea defectelor pe o linie de asamblare, poate fi de dorit să se verifice dacă piesele nedefecte (etichetă pozitivă) de diferite tipuri (valori fațete) sunt clasificate ca nedefectuoase la aceeași rată. Această cantitate este denumită rechemare sau rata pozitivă adevărată:

Rechemare = TP / (TP + FN)

În setul nostru de date exemplu, reamintirea pentru femei este 0.389, iar reamintirea pentru bărbați este 0.425. Aceasta duce la valoarea de bază din această categorie, Diferența de reamintire (RD):

RD = 0.425 - 0.389 = 0.036

Acum să luăm în considerare cele trei valori avansate din această categorie, să vedem ce preferințe de utilizator le codifică și cum diferă de măsura de bază a RD.

În primul rând, în loc să măsurați performanța pe etichetele observate pozitive, ați putea să o măsurați pe etichetele estimate pozitive. Având în vedere o valoare a fațetei, cum ar fi femeile, și toate eșantioanele cu acea valoare a fațetei care sunt prezise a fi pozitive de către model, câte sunt de fapt clasificate corect drept pozitive? Această cantitate este denumită rata de acceptare (AR) sau precizie:

AR = TP / (TP + FP)

În exemplul nostru, RA pentru femei este 0.977, iar RA pentru bărbați este 0.970. Acest lucru duce la diferența în rata de acceptare (DAR):

DAR = 0.970 - 0.977 = -0.007

O altă modalitate de a măsura părtinirea este prin combinarea celor două valori anterioare și măsurarea câte predicții pozitive mai multe modelele atribuie unei valori fațete în comparație cu etichetele pozitive observate. SageMaker Clarify măsoară acest avantaj de către model ca raport între numărul de etichete pozitive observate pentru acea valoare a fațetei și numărul de etichete pozitive prezise și se referă la acesta ca acceptare condiționată (CA):

CA = (TP + FN🇧🇷TP + FP)

În exemplul nostru, CA pentru femei este 2.510 și pentru bărbați este 2.283. Diferența de CA duce la valoarea finală din această categorie, Diferența de acceptare condiționată (DCA):

DCA = 2.283 - 2.510 = -0.227

Performanță egală numai pe etichetele negative

Într-un mod similar cu etichetele pozitive, părtinirea poate fi calculată și ca diferență de performanță pe etichetele negative. Considerarea separată a etichetelor negative poate fi importantă în anumite aplicații. De exemplu, în exemplul nostru de detectare a defectelor, am putea dori să detectăm părți defecte (etichetă negativă) de diferite tipuri (valoare fațetă) la aceeași rată.

Valoarea de bază din această categorie, specificitatea, este analogă cu metrica de reamintire (rata adevărată pozitivă). Specificitatea calculează acuratețea modelului pe eșantioane cu această valoare a fațetei care au o etichetă negativă observată:

specificitate = TN / (TN + FP)

În exemplul nostru (vezi tabelele de confuzie), specificitatea pentru femei și bărbați este 0.999 și, respectiv, 0.994. În consecință, cel Diferența de specificitate (SD) este:

SD = 0.994 - 0.999 = -0.005

Mergând mai departe, la fel ca măsurarea ratei de acceptare, cantitatea analogă pentru etichetele negative - rata de respingere (RR) - este:

RR = TN / (TN + FN)

RR pentru femei este de 0.927, iar pentru bărbați este de 0.791, ceea ce duce la măsurarea Diferenței în Rata de Respingere (DRR):

DRR = 0.927 - 0.791 = -0.136

În cele din urmă, analogul etichetei negative al acceptării condiționate, respingerea condiționată (CR), este raportul dintre numărul de etichete negative observate pentru acea valoare a fațetei și numărul de etichete negative prezise:

CR = (TN + FP🇧🇷TN + FN)

CR pentru femei este de 0.928, iar pentru bărbați este de 0.796. Valoarea finală din această categorie este Diferența de respingere condiționată (DCR):

DCR = 0.796 - 0.928 = 0.132

Performanță egală pe etichetele pozitive față de cele negative

SageMaker Clarify combină cele două categorii anterioare luând în considerare raportul de performanță al modelului pe etichetele pozitive și negative. Mai exact, pentru fiecare valoare a fațetei, SageMaker Clarify calculează raportul dintre false negative (FN) și false pozitive (FP). În exemplul nostru, raportul FN/FP pentru femei este 679/10 = 67.9 și pentru bărbați este 3678/84 = 43.786. Acest lucru duce la măsurarea egalității de tratament (TE), care măsoară diferența dintre raportul FP/FN:

TE = 67.9 - 43.786 = 24.114

Următoarea captură de ecran arată cum puteți utiliza SageMaker Clarify cu Amazon SageMaker Studio pentru a afișa valorile, precum și intervalele și scurte descrieri ale diferitelor valori de părtinire.

Întrebări despre părtinire: cu ce valori să începem?

Amintiți-vă exemplele de întrebări despre părtinire de la începutul acestei postări. După ce ați trecut prin valorile din diferite categorii, luați în considerare întrebările din nou. Pentru a răspunde la prima întrebare, care se referă la reprezentările diferitelor grupuri în datele de antrenament, ați putea începe cu metrica dezechilibru de clasă (CI). În mod similar, pentru întrebările rămase, puteți începe prin a analiza Diferența în proporțiile pozitive în etichete (DPL), Diferența de precizie (AD), Diferența în rata de acceptare (DAR) și, respectiv, Diferența de reamintire (RD).

Prejudecăți fără valori fațete

Pentru ușurința expunerii, această descriere a metricilor postantrenament a exclus metrica Indexului de entropie generalizată (GE). Această măsurătoare măsoară părtinirea fără a lua în considerare valoarea fațetei și poate fi utilă în evaluarea modului în care sunt distribuite erorile de model. Pentru detalii, consultați Entropia generalizată (GE).

Concluzie

În această postare, ați văzut cum cele 21 de valori diferite din SageMaker Clarify măsoară părtinirea în diferite etape ale conductei ML. Ați învățat despre diverse valori printr-un caz de utilizare pentru predicția veniturilor, cum să alegeți valori pentru cazul dvs. de utilizare și cu care ați putea începe.

Începeți cu călătoria dvs. responsabilă în domeniul inteligenței artificiale, evaluând părtinirea modelelor dvs. de ML utilizând notebook-ul demonstrativ Corectitudine și explicabilitate cu SageMaker Clarify. Puteți găsi documentația detaliată pentru SageMaker Clarify, inclusiv definiția formală a valorilor, la Ce este corectitudinea și explicabilitatea modelului pentru predicțiile de învățare automată. Pentru implementarea open-source a parametrilor de părtinire, consultați aws-sagemaker-clarify depozitul GitHub. Pentru o discuție detaliată, inclusiv limitări, consultați Cartea albă privind corectitudinea și explicabilitatea Amazon AI.

Despre autori

Bilal Zafar este un om de știință aplicat la AWS, care lucrează la corectitudine, explicabilitate și securitate în învățarea automată.

Bilal Zafar este un om de știință aplicat la AWS, care lucrează la corectitudine, explicabilitate și securitate în învățarea automată.

Denis V. Batalov este arhitect de soluții pentru AWS, specializat în învățare automată. Este la Amazon din 2005. Denis are un doctorat în domeniul AI. Urmărește-l pe Twitter: @dbatalov.

Michele Donini este om de știință aplicat la AWS. El conduce o echipă de oameni de știință care lucrează la IA responsabilă, iar interesele sale de cercetare sunt corectitudinea algoritmică și învățarea automată explicabilă.

Michele Donini este om de știință aplicat la AWS. El conduce o echipă de oameni de știință care lucrează la IA responsabilă, iar interesele sale de cercetare sunt corectitudinea algoritmică și învățarea automată explicabilă.

- AI

- ai art

- ai art generator

- ai robot

- Amazon SageMaker

- inteligență artificială

- certificare de inteligență artificială

- inteligența artificială în domeniul bancar

- robot cu inteligență artificială

- roboți cu inteligență artificială

- software de inteligență artificială

- Învățare automată AWS

- blockchain

- conferință blockchain ai

- coingenius

- inteligența artificială conversațională

- criptoconferință ai

- dall-e

- învățare profundă

- google ai

- masina de învățare

- Plato

- platoul ai

- Informații despre date Platon

- Jocul lui Platon

- PlatoData

- platogaming

- scara ai

- sintaxă

- zephyrnet