Rapoartele radiologice sunt documente cuprinzătoare și lungi care descriu și interpretează rezultatele unui examen imagistic radiologic. Într-un flux de lucru tipic, radiologul supraveghează, citește și interpretează imaginile, apoi rezumă concis constatările cheie. Rezumatul (sau impresii) este cea mai importantă parte a raportului, deoarece ajută clinicienii și pacienții să se concentreze asupra conținutului critic al raportului care conține informații pentru luarea deciziilor clinice. Crearea unei impresii clare și de impact implică mult mai mult efort decât simpla reafirmare a constatărilor. Întregul proces este, prin urmare, laborios, consumator de timp și predispus la erori. Adesea durează ani de zile pregătire pentru ca medicii să acumuleze suficientă experiență în scrierea unor rezumate concise și informative ale rapoartelor de radiologie, subliniind și mai mult importanța automatizării procesului. În plus, generarea automată a rezumatului constatărilor raportului este critic pentru raportarea radiologiei. Permite traducerea rapoartelor într-un limbaj care poate fi citit de om, ușurând astfel povara pacienților de a citi prin rapoarte lungi și obscure.

Pentru a rezolva această problemă, propunem utilizarea AI generativă, un tip de IA care poate crea conținut și idei noi, inclusiv conversații, povești, imagini, videoclipuri și muzică. AI generativ este alimentat de modele de învățare automată (ML) – modele foarte mari care sunt pre-antrenate pe cantități mari de date și denumite în mod obișnuit modele de bază (FM). Progresele recente în ML (în special invenția arhitecturii rețelei neuronale bazate pe transformatoare) au condus la creșterea modelelor care conțin miliarde de parametri sau variabile. Soluția propusă în această postare folosește reglarea fină a modelelor de limbaj mari (LLM) pre-antrenate pentru a ajuta la generarea de rezumate bazate pe constatările din rapoartele de radiologie.

Această postare demonstrează o strategie pentru reglarea fină a LLM-urilor disponibile public pentru sarcina de rezumare a rapoartelor radiologice folosind serviciile AWS. LLM-urile au demonstrat capacități remarcabile în înțelegerea și generarea limbajului natural, servind drept modele de bază care pot fi adaptate la diferite domenii și sarcini. Există beneficii semnificative în utilizarea unui model pre-antrenat. Reduce costurile de calcul, reduce amprenta de carbon și vă permite să utilizați modele de ultimă generație fără a fi nevoie să antrenați unul de la zero.

Soluția noastră folosește FLAN-T5 XL FM, folosind Amazon SageMaker JumpStart, care este un hub ML care oferă algoritmi, modele și soluții ML. Demonstrăm cum să realizați acest lucru folosind un notebook în Amazon SageMaker Studio. Reglarea fină a unui model pre-antrenat implică instruire suplimentară pe date specifice pentru a îmbunătăți performanța la o sarcină diferită, dar conexă. Această soluție implică reglarea fină a modelului FLAN-T5 XL, care este o versiune îmbunătățită a T5 (Transformator de transfer text la text) LLM-uri cu scop general. T5 reîncadrează sarcinile de procesare a limbajului natural (NLP) într-un format unificat text-to-text, spre deosebire de OARET-modele de stil care pot scoate doar fie o etichetă de clasă, fie un interval de intrare. Este ajustat pentru o sarcină de rezumat pe 91,544 rapoarte de radiologie în text liber obținute de la Setul de date MIMIC-CXR.

Prezentare generală a soluției

În această secțiune, discutăm componentele cheie ale soluției noastre: alegerea strategiei pentru sarcină, reglarea fină a unui LLM și evaluarea rezultatelor. De asemenea, ilustrăm arhitectura soluției și pașii de implementare a soluției.

Identificați strategia pentru sarcină

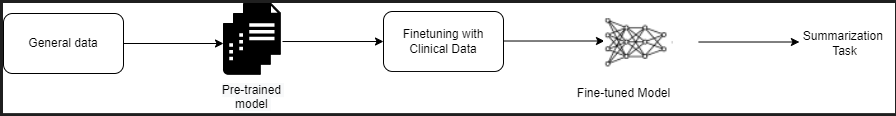

Există diverse strategii de abordare a sarcinii de automatizare a rezumarii rapoartelor clinice. De exemplu, am putea folosi un model de limbaj specializat pre-instruit pe rapoarte clinice de la zero. Alternativ, am putea ajusta direct un model de limbaj cu scop general disponibil public pentru a îndeplini sarcina clinică. Utilizarea unui model ajustat independent de domeniu poate fi necesară în setările în care instruirea a model de limbaj de la zero este prea costisitoare. În această soluție, demonstrăm această ultimă abordare a utilizării unui model FLAN -T5 XL, pe care îl reglam fin pentru sarcina clinică de rezumare a rapoartelor radiologice. Următoarea diagramă ilustrează fluxul de lucru al modelului.

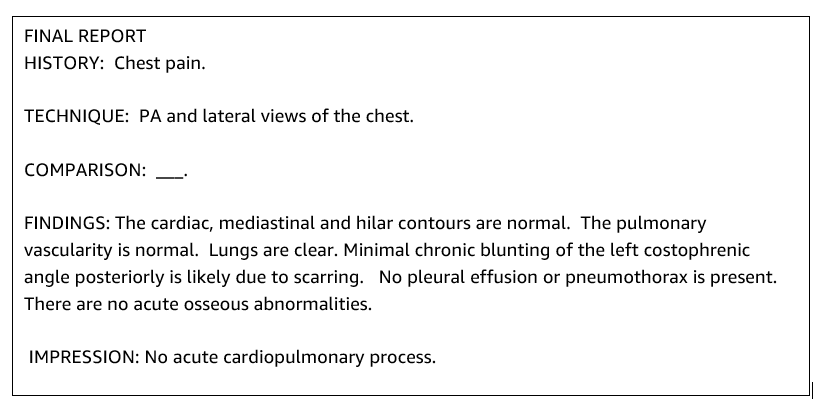

Un raport tipic de radiologie este bine organizat și succint. Astfel de rapoarte au adesea trei secțiuni cheie:

- Context – Oferă informații generale despre datele demografice ale pacientului cu informații esențiale despre pacient, istoricul clinic și istoricul medical relevant și detaliile procedurilor de examen

- Constatări – Prezintă diagnostic și rezultate detaliate ale examenului

- tipărire – Rezumă concis cele mai importante constatări sau interpretări ale constatărilor cu o evaluare a semnificației și a potențialului diagnostic pe baza anomaliilor observate

Folosind secțiunea de constatări din rapoartele de radiologie, soluția generează secțiunea de amprentare, care corespunde rezumatului medicilor. Următoarea figură este un exemplu de raport radiologic.

Ajustați un LLM cu scop general pentru o sarcină clinică

În această soluție, reglam fin un model FLAN-T5 XL (ajustând toți parametrii modelului și optimizându-i pentru sarcină). Ajustăm modelul utilizând setul de date din domeniul clinic MIMIC-CXR, care este un set de date disponibil public de radiografii toracice. Pentru a ajusta acest model prin SageMaker Jumpstart, exemplele etichetate trebuie furnizate sub formă de perechi {prompt, completion}. În acest caz, folosim perechi de {Findings, Impression} din rapoartele originale din setul de date MIMIC-CXR. Pentru deducere, folosim un prompt așa cum se arată în exemplul următor:

![]()

Modelul este reglat fin pe un calcul accelerat ml.p3.16xmare instanță cu 64 de procesoare virtuale și 488 GiB de memorie. Pentru validare, 5% din setul de date a fost selectat aleatoriu. Timpul scurs al lucrării de antrenament SageMaker cu reglaj fin a fost de 38,468 de secunde (aproximativ 11 ore).

Evaluează rezultatele

Când antrenamentul este complet, este esențial să evaluați rezultatele. Pentru o analiză cantitativă a impresiei generate, folosim ROȘU (Recall-Oriented Understudy for Gisting Evaluation), cea mai utilizată măsurătoare pentru evaluarea rezumatului. Această valoare compară un rezumat produs automat cu o referință sau un set de referințe (produse de oameni) sau traducere. ROUGE1 se referă la suprapunerea unigrame (fiecare cuvânt) între candidat (ieșirea modelului) și rezumatele de referință. ROUGE2 se referă la suprapunerea bigramele (două cuvinte) între candidat și rezumatele de referință. ROUGEL este o metrică la nivel de propoziție și se referă la cea mai lungă subsecvență comună (LCS) dintre două bucăți de text. Ignoră liniile noi din text. ROUGELsum este o valoare la nivel de rezumat. Pentru această măsură, liniile noi din text nu sunt ignorate, ci sunt interpretate ca limite ale propoziției. LCS este apoi calculat între fiecare pereche de propoziții de referință și candidat, apoi este calculat uniunea-LCS. Pentru agregarea acestor scoruri pe un set dat de propoziții de referință și candidat, se calculează media.

Tutorial și arhitectură

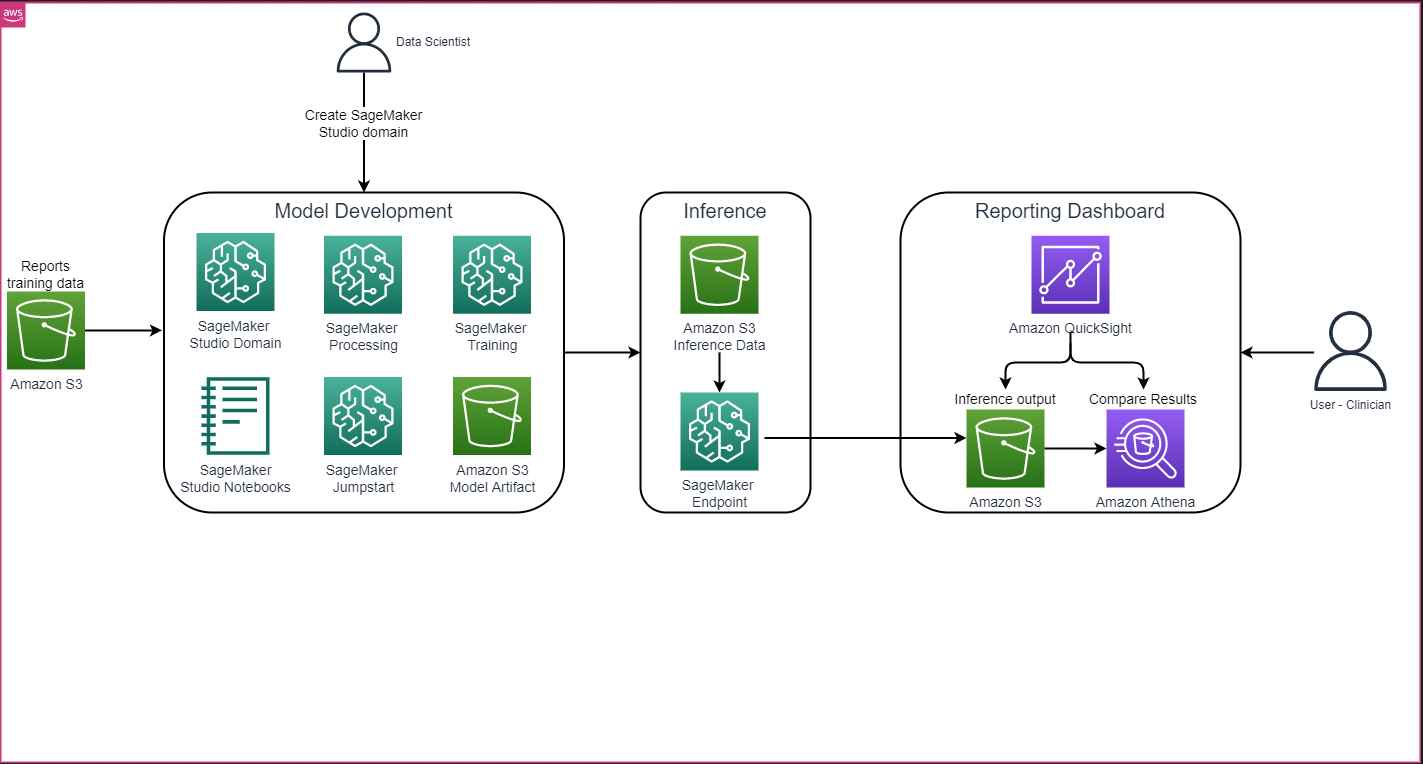

Arhitectura globală a soluției, așa cum se arată în figura următoare, constă în principal dintr-un mediu de dezvoltare a modelului care utilizează SageMaker Studio, implementarea modelului cu un punct final SageMaker și un tablou de bord de raportare care utilizează Amazon QuickSight.

În secțiunile următoare, demonstrăm reglarea fină a unui LLM disponibil pe SageMaker JumpStart pentru rezumarea unei sarcini specifice unui domeniu prin intermediul SDK-ului SageMaker Python. În special, discutăm următoarele subiecte:

- Pași pentru configurarea mediului de dezvoltare

- O privire de ansamblu asupra seturilor de date ale rapoartelor radiologice pe care modelul este ajustat și evaluat

- O demonstrație de reglare fină a modelului FLAN-T5 XL utilizând SageMaker JumpStart în mod programatic cu SageMaker Python SDK

- Deducerea și evaluarea modelelor pre-antrenate și ajustate

- Compararea rezultatelor de la modelul pre-antrenat și modelele reglate fin

Soluția este disponibilă în Generarea de impresii de raport radiologic folosind IA generativă cu model de limbaj mare pe AWS GitHub repo.

Cerințe preliminare

Pentru a începe, aveți nevoie de un Cont AWS în care puteți utiliza SageMaker Studio. Va trebui să creați un profil de utilizator pentru SageMaker Studio dacă nu aveți deja unul.

Tipul de instanță de antrenament folosit în această postare este ml.p3.16xlarge. Rețineți că tipul instanței p3 necesită o creștere a limitei cotei de servicii.

Setul de date MIMIC CXR poate fi accesat printr-un acord de utilizare a datelor, care necesită înregistrarea utilizatorului și finalizarea unui proces de acreditare.

Configurați mediul de dezvoltare

Pentru a vă configura mediul de dezvoltare, creați un bucket S3, configurați un notebook, creați puncte finale și implementați modelele și creați un tablou de bord QuickSight.

Creați o găleată S3

Creați o găleată S3 denumit llm-radiology-bucket pentru a găzdui seturile de date de instruire și evaluare. Acesta va fi folosit și pentru a stoca artefactul modelului în timpul dezvoltării modelului.

Configurați un notebook

Urmați pașii următori:

- Lansați SageMaker Studio fie din consola SageMaker, fie din Interfața liniei de comandă AWS (CLI AWS).

Pentru mai multe informații despre integrarea la un domeniu, consultați Integrat la domeniul Amazon SageMaker.

- Creaza un nou Notebook SageMaker Studio pentru curățarea datelor raportului și reglarea fină a modelului. Folosim o instanță de notebook ml.t3.medium 2vCPU+4GiB cu un nucleu Python 3.

- În interiorul notebook-ului, instalați pachetele relevante, cum ar fi

nest-asyncio,IPyWidgets(pentru widget-uri interactive pentru notebook-ul Jupyter) și SDK-ul SageMaker Python:

Pentru deducerea modelelor pre-antrenate și reglate fin, creați un punct final și implementați fiecare model în caiet, după cum urmează:

- Creați un obiect model din clasa Model care poate fi implementat la un punct final HTTPS.

- Creați un punct final HTTPS cu obiectul model pre-construit

deploy()metodă:

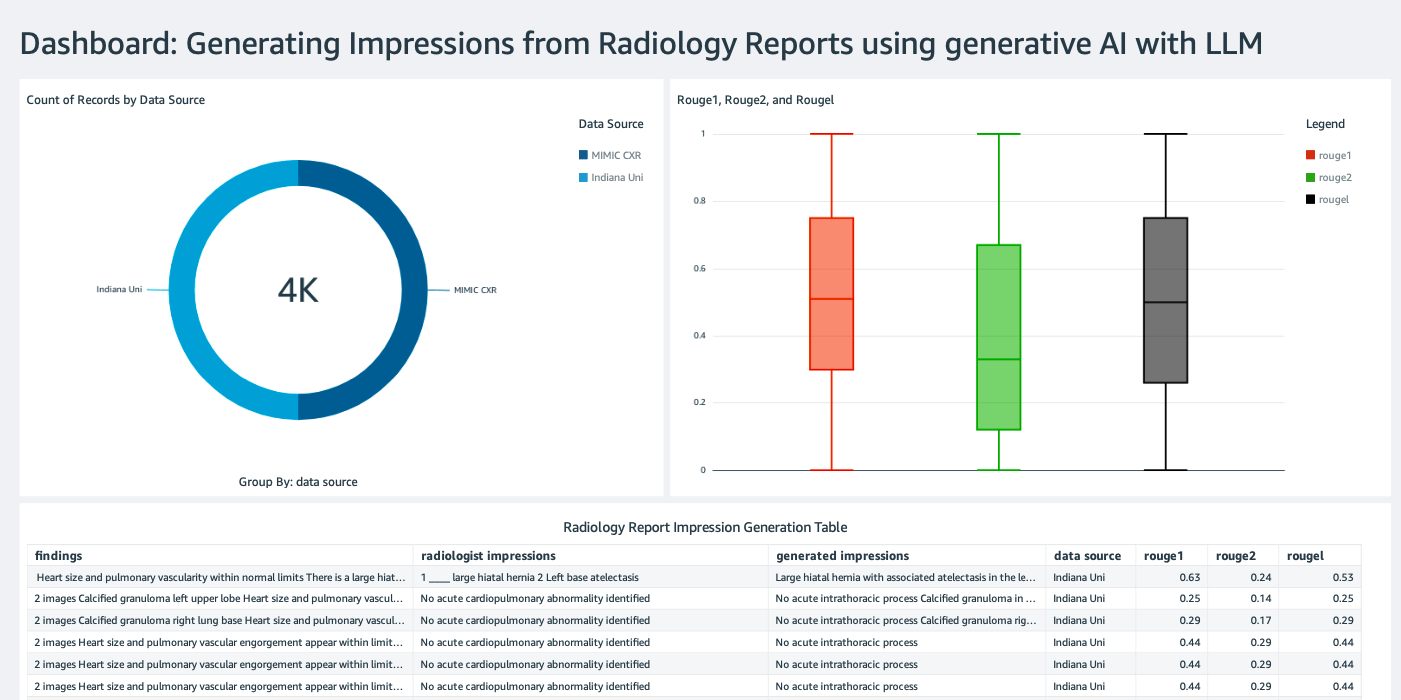

Creați un tablou de bord QuickSight

Crearea unei Tabloul de bord QuickSight cu o sursă de date Athena cu inferența rezultă în Serviciul Amazon de stocare simplă (Amazon S3) pentru a compara rezultatele inferenței cu adevărul de bază. Următoarea captură de ecran arată exemplul nostru de tablou de bord.

Seturi de date pentru rapoarte de radiologie

Modelul este acum reglat fin, toți parametrii modelului sunt reglați pe 91,544 de rapoarte descărcate de pe Setul de date MIMIC-CXR v2.0. Deoarece am folosit doar datele text ale raportului de radiologie, am descărcat doar un fișier de raport comprimat (mimic-cxr-reports.zip) de pe site-ul web MIMIC-CXR. Acum evaluăm modelul reglat fin pe 2,000 de rapoarte (denumite dev1 setul de date) din separat a prezentat subset al acestui set de date. Folosim alte 2,000 de rapoarte radiologice (denumite ca dev2) pentru evaluarea modelului reglat fin din colecția de radiografie toracică din Rețeaua de spitale a Universității din Indiana. Toate seturile de date sunt citite ca fișiere JSON și încărcate în compartimentul S3 nou creat llm-radiology-bucket. Rețineți că toate seturile de date în mod implicit nu conțin informații de sănătate protejate (PHI); toate informațiile sensibile sunt înlocuite cu trei caractere de subliniere consecutive (___) de către furnizori.

Reglați fin cu SDK-ul SageMaker Python

Pentru reglaj fin, model_id este specificat ca huggingface-text2text-flan-t5-xl din lista de modele SageMaker JumpStart. The training_instance_type este setat ca ml.p3.16xlarge iar cel inference_instance_type ca ml.g5.2xlarge. Datele de antrenament în format JSON sunt citite din bucket-ul S3. Următorul pas este să utilizați modelul_id selectat pentru a extrage URI-urile de resurse SageMaker JumpStart, inclusiv image_uri ( Registrul Amazon de containere elastice (Amazon ECR) URI pentru imaginea Docker), model_uri (artifactul model pre-antrenat Amazon S3 URI) și script_uri (scriptul de antrenament):

De asemenea, o locație de ieșire este configurată ca folder în compartimentul S3.

Doar un hiperparametru, epochs, este schimbat la 3, iar restul sunt setate ca implicit:

Măsurile de formare precum eval_loss (pentru pierderea de validare), loss (pentru pierderea antrenamentului) și epoch de urmărit sunt definite și listate:

Folosim URI-urile de resurse SageMaker JumpStart (image_uri, model_uri, script_uri) identificate mai devreme pentru a crea un estimator și a-l ajusta pe setul de date de antrenament prin specificarea căii S3 a setului de date. Clasa Estimator necesită un entry_point parametru. În acest caz, JumpStart folosește transfer_learning.py. Lucrarea de antrenament nu poate rula dacă această valoare nu este setată.

Acest job de formare poate dura ore pentru a finaliza; prin urmare, este recomandat să setați parametrul așteptare la Fals și să monitorizați starea jobului de antrenament pe consola SageMaker. Folosește TrainingJobAnalytics funcție de urmărire a valorilor de antrenament la diferite marcaje temporale:

Implementați puncte finale de inferență

Pentru a face comparații, implementăm puncte finale de inferență atât pentru modelele pre-antrenate, cât și pentru cele ajustate.

Mai întâi, recuperați URI-ul imaginii Docker de inferență folosind model_id, și utilizați acest URI pentru a crea o instanță de model SageMaker a modelului pre-antrenat. Implementați modelul pre-antrenat prin crearea unui punct final HTTPS cu obiectul model pre-construit deploy() metodă. Pentru a rula inferența prin SageMaker API, asigurați-vă că treceți clasa Predictor.

Repetați pasul precedent pentru a crea o instanță de model SageMaker a modelului reglat și pentru a crea un punct final pentru implementarea modelului.

Evaluați modelele

Mai întâi, setați lungimea textului rezumat, numărul de ieșiri ale modelului (ar trebui să fie mai mare de 1 dacă trebuie generate mai multe rezumate) și numărul de fascicule pentru căutarea fasciculului.

Construiți cererea de inferență ca sarcină utilă JSON și utilizați-o pentru a interoga punctele finale pentru modelele pre-antrenate și ajustate.

Calculați agregatul ROUGE înscrie (ROUGE1, ROUGE2, ROUGEL, ROUGELsum) așa cum este descris mai devreme.

Comparați rezultatele

Următorul tabel prezintă rezultatele evaluării pentru dev1 și dev2 seturi de date. Rezultatul evaluării pe dev1 (2,000 de constatări din Raportul de radiologie MIMIC CXR) arată o îmbunătățire cu aproximativ 38 de puncte procentuale a mediei agregate ROUGE1 și ROUGE2 scoruri comparativ cu modelul pre-antrenat. Pentru dev2, se observă o îmbunătățire de 31 de puncte procentuale și 25 de puncte procentuale în scorurile ROUGE1 și ROUGE2. În general, reglarea fină a dus la o îmbunătățire de 38.2 puncte procentuale și 31.3 puncte procentuale a scorurilor ROUGELsum pentru dev1 și dev2 seturi de date, respectiv.

|

Evaluare Setul de date |

Model pre-antrenat | Model reglat fin | ||||||

| ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

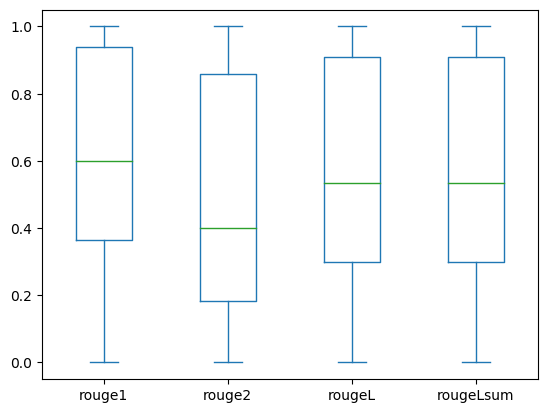

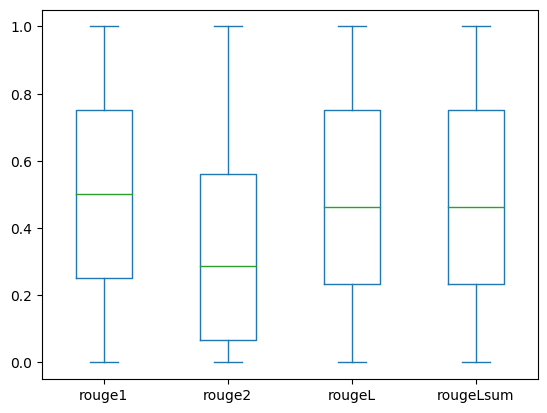

Următoarele casete prezintă distribuția scorurilor ROUGE pentru dev1 și dev2 seturi de date evaluate folosind modelul reglat fin.

|

|

(A): dev1 |

(b): dev2 |

Următorul tabel arată că scorurile ROUGE pentru seturile de date de evaluare au aproximativ aceeași medie și medie și, prin urmare, sunt distribuite simetric.

| Datasets | Partitură | Conta | medie | Abatere standard | Minim | 25% percentilă | 50% percentilă | 75% percentilă | Maxim |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

A curăța

Pentru a evita costurile viitoare, ștergeți resursele pe care le-ați creat cu următorul cod:

Concluzie

În această postare, am demonstrat cum să reglam fin un model FLAN-T5 XL pentru o sarcină de rezumare specifică domeniului clinic folosind SageMaker Studio. Pentru a crește încrederea, am comparat predicțiile cu adevărul de la sol și am evaluat rezultatele utilizând metrica ROUGE. Am demonstrat că un model reglat fin pentru o anumită sarcină oferă rezultate mai bune decât un model pre-antrenat pe o sarcină NLP generică. Am dori să subliniem că reglarea fină a unui LLM cu scop general elimină cu totul costul pregătirii preliminare.

Deși munca prezentată aici se concentrează pe rapoartele cu raze X toracice, are potențialul de a fi extins la seturi de date mai mari, cu anatomii și modalități variate, cum ar fi RMN și CT, pentru care rapoartele radiologice ar putea fi mai complexe, cu constatări multiple. În astfel de cazuri, radiologii ar putea genera amprente în ordinea criticității și pot include recomandări de urmărire. Mai mult, crearea unei bucle de feedback pentru această aplicație ar permite radiologilor să îmbunătățească performanța modelului în timp.

După cum am arătat în această postare, modelul ajustat generează impresii pentru rapoartele de radiologie cu scoruri ROUGE ridicate. Puteți încerca să ajustați LLM-urile pe alte rapoarte medicale specifice domeniului din diferite departamente.

Despre autori

Dr. Adewale Akinfaderin este cercetător senior în domeniul asistenței medicale și științelor vieții la AWS. Experiența sa este în metode reproductibile și end-to-end AI/ML, implementări practice și ajută clienții globali din domeniul sănătății să formuleze și să dezvolte soluții scalabile pentru probleme interdisciplinare. Are două diplome de licență în Fizică și un doctorat în Inginerie.

Dr. Adewale Akinfaderin este cercetător senior în domeniul asistenței medicale și științelor vieții la AWS. Experiența sa este în metode reproductibile și end-to-end AI/ML, implementări practice și ajută clienții globali din domeniul sănătății să formuleze și să dezvolte soluții scalabile pentru probleme interdisciplinare. Are două diplome de licență în Fizică și un doctorat în Inginerie.

Priya Padate este un Senior Partner Solutions Architect cu o experiență vastă în domeniul sănătății și științe ale vieții la AWS. Priya conduce strategii de lansare pe piață cu partenerii și conduce dezvoltarea de soluții pentru a accelera dezvoltarea bazată pe AI/ML. Este pasionată de utilizarea tehnologiei pentru a transforma industria sănătății pentru a obține rezultate mai bune în îngrijirea pacienților.

Priya Padate este un Senior Partner Solutions Architect cu o experiență vastă în domeniul sănătății și științe ale vieții la AWS. Priya conduce strategii de lansare pe piață cu partenerii și conduce dezvoltarea de soluții pentru a accelera dezvoltarea bazată pe AI/ML. Este pasionată de utilizarea tehnologiei pentru a transforma industria sănătății pentru a obține rezultate mai bune în îngrijirea pacienților.

Ekta Walia Bhullar, PhD, este consultant senior AI/ML cu unitatea de afaceri de servicii profesionale AWS Healthcare and Life Sciences (HCLS). Are o vastă experiență în aplicarea AI/ML în domeniul sănătății, în special în radiologie. În afara serviciului, când nu discută despre IA în radiologie, îi place să alerge și să facă drumeții.

Ekta Walia Bhullar, PhD, este consultant senior AI/ML cu unitatea de afaceri de servicii profesionale AWS Healthcare and Life Sciences (HCLS). Are o vastă experiență în aplicarea AI/ML în domeniul sănătății, în special în radiologie. În afara serviciului, când nu discută despre IA în radiologie, îi place să alerge și să facă drumeții.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- ChartPrime. Crește-ți jocul de tranzacționare cu ChartPrime. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :are

- :este

- :nu

- :Unde

- $UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Capabil

- Despre Noi

- accelera

- accelerat

- accesate

- realiza

- Acumula

- În plus,

- progresele

- împotriva

- agregare

- Acord

- AI

- AI / ML

- algoritmi

- TOATE

- permite

- deja

- de asemenea

- întru totul

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Sume

- an

- analiză

- și

- O alta

- Orice

- api

- aplicație

- abordare

- aproximativ

- arhitectură

- SUNT

- argument

- AS

- evaluare

- At

- Automat

- în mod automat

- automatizarea

- disponibil

- in medie

- evita

- AWS

- de bază

- bazat

- BE

- deoarece

- înainte

- fiind

- Beneficiile

- Mai bine

- între

- mai mare

- miliarde

- atât

- limitele

- Cutie

- povară

- afaceri

- dar

- by

- denumit

- CAN

- candidat

- capacități

- carbon

- pasă

- caz

- cazuri

- si-a schimbat hainele;

- taxe

- alegere

- clasă

- Curățenie

- clar

- clinic

- clinicienii

- cod

- colectare

- Comun

- în mod obișnuit

- comparaţie

- comparație

- Completă

- completare

- complex

- componente

- cuprinzător

- calcul

- tehnica de calcul

- concis

- încredere

- consecutiv

- constă

- Consoleze

- consultant

- conţine

- Recipient

- conţinut

- conținut

- contrast

- conversații

- corespunde

- A costat

- costisitor

- Cheltuieli

- ar putea

- Cuplu

- crea

- a creat

- Crearea

- critic

- criticitate

- personalizat

- clienţii care

- tablou de bord

- de date

- om de știință de date

- seturi de date

- Luarea deciziilor

- Mod implicit

- definit

- Grad

- Criterii demografice

- demonstra

- demonstrat

- demonstrează

- departamente

- implementa

- dislocate

- desfășurarea

- descrie

- descris

- detaliat

- detalii

- dezvolta

- Dezvoltare

- diferit

- direct

- discuta

- discutarea

- distribuite

- distribuire

- Docher

- Medici

- documente

- domeniu

- domenii

- Dont

- a desena

- conduce

- unități

- în timpul

- fiecare

- Mai devreme

- efort

- oricare

- elimină

- altfel

- permite

- permite

- un capăt la altul

- Punct final

- Inginerie

- sporită

- suficient de

- Întreg

- Mediu inconjurator

- epocă

- epoci

- eroare

- mai ales

- esenţial

- evalua

- evaluat

- evaluarea

- evaluare

- examen

- exemplu

- exemple

- a executa

- extins

- experienţă

- expertiză

- extensiv

- Experiență vastă

- extrage

- eșuează

- fals

- feedback-ul

- Figura

- Fișier

- Fişiere

- constatările

- Concentra

- se concentrează

- următor

- urmează

- Pentru

- formă

- format

- Fundație

- din

- funcţie

- mai mult

- În plus

- viitor

- General

- scop general

- genera

- generată

- generează

- generaţie

- generativ

- AI generativă

- obține

- dat

- Caritate

- Mergi pe piață

- absolvent

- mai mare

- Teren

- Avea

- având în

- he

- Sănătate

- informație despre sănătate

- de asistență medicală

- industria sănătății

- ajutor

- ajutor

- ajută

- aici

- Înalt

- subliniind

- Excursie pe jos

- lui

- istorie

- gazdă

- ORE

- Cum

- Cum Pentru a

- HTML

- http

- HTTPS

- Butuc

- Față îmbrățișată

- uman

- ID

- idei

- identificat

- if

- ilustrează

- imagine

- imagini

- Imaging

- impactant

- punerea în aplicare a

- implementările

- import

- important

- îmbunătăţi

- îmbunătățire

- in

- include

- Inclusiv

- Crește

- industrie

- informații

- informativ

- intrare

- instala

- instanță

- interactiv

- interpretare

- în

- Invenţie

- IT

- Loc de munca

- Locuri de munca

- JSON

- doar

- doar unul

- A pastra

- Cheie

- Etichetă

- limbă

- mare

- lansa

- învăţare

- Led

- Lungime

- Viaţă

- Life Sciences

- ca

- îi place

- LIMITĂ

- Linie

- Listă

- listat

- LLM

- situat

- locaţie

- de pe

- maşină

- masina de învățare

- face

- Mai..

- însemna

- medical

- mediu

- Memorie

- metodă

- Metode

- metric

- Metrici

- ar putea

- minute

- ML

- model

- Modele

- monitor

- mai mult

- cele mai multe

- RMN

- mult

- multiplu

- Muzică

- trebuie sa

- nume

- Natural

- Procesarea limbajului natural

- necesar

- Nevoie

- reţea

- rețele neuronale

- Nou

- recent

- următor

- nlp

- caiet

- acum

- număr

- obiect

- obținut

- of

- oferind

- de multe ori

- on

- La imbarcare

- ONE

- afară

- optimizarea

- or

- comandă

- original

- Altele

- al nostru

- afară

- rezultate

- producție

- exterior

- peste

- global

- trece peste

- Prezentare generală

- ofertele

- pereche

- perechi

- parametru

- parametrii

- parte

- special

- partener

- parteneri

- trece

- pasionat

- cale

- pacient

- pacientes

- procent

- Efectua

- performanță

- PhD

- Fizică

- piese

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- puncte

- Post

- potenţial

- alimentat

- Practic

- Predictii

- Predictor

- prezentat

- cadouri

- în primul rând

- Problemă

- probleme

- proces

- prelucrare

- Produs

- profesional

- Profil

- propune

- propus

- protejat

- prevăzut

- furnizori

- furnizează

- public

- Piton

- cantitativ

- Citeste

- Citind

- recent

- Recomandări

- recomandat

- reduce

- referințe

- menționat

- se referă

- regex

- Înscriere

- legate de

- remarcabil

- înlocuiește

- raportează

- Raportarea

- Rapoarte

- solicita

- necesar

- Necesită

- resursă

- Resurse

- respectiv

- REST

- rezultat

- REZULTATE

- Returnează

- Ridica

- Alerga

- funcţionare

- sagemaker

- acelaşi

- scalabil

- ȘTIINȚE

- Om de stiinta

- zgâria

- sdk

- Caută

- secunde

- Secțiune

- secțiuni

- vedea

- selectate

- senior

- sensibil

- propoziție

- distinct

- serviciu

- Servicii

- servire

- set

- instalare

- setări

- ea

- să

- a arătat

- indicat

- Emisiuni

- semnificație

- semnificativ

- simplu

- pur şi simplu

- mic

- So

- soluţie

- soluţii

- REZOLVAREA

- unele

- deschidere

- de specialitate

- specific

- specific

- specificată

- Începe

- început

- de ultimă oră

- Stare

- Pas

- paşi

- Încă

- depozitare

- stoca

- Istorii

- strategii

- Strategie

- studio

- astfel de

- REZUMAT

- sigur

- tabel

- Lua

- ia

- Sarcină

- sarcini

- Tehnologia

- decât

- acea

- Lor

- apoi

- Acolo.

- astfel

- prin urmare

- Acestea

- acest

- aceste

- trei

- Prin

- timp

- la

- de asemenea

- subiecte

- urmări

- Tren

- Pregătire

- transfer

- Transforma

- transformator

- Traducere

- Adevăr

- încerca

- Două

- tip

- tipic

- subliniere

- înţelegere

- unificat

- unitate

- universitate

- încărcat

- utilizare

- utilizat

- Utilizator

- utilizări

- folosind

- validare

- valoare

- Valori

- diverse

- Fixă

- versiune

- de

- Video

- Virtual

- aștepta

- a fost

- we

- web

- servicii web

- website

- cand

- care

- în timp ce

- lățime

- voi

- cu

- în

- fără

- Cuvânt

- cuvinte

- Apartamente

- flux de lucru

- ar

- scris

- radiografie

- ani

- Tu

- Ta

- zephyrnet